唯一《可解釋機器學習》中文書來了:復旦研究生翻譯,原作者點贊

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

新冠疫情的出現,讓許多AI醫療技術浮出水面。

但是AI一直黑箱問題存在,如果AI對過程都不能做到可解釋,又怎么能放心讓它來診斷病患呢。而關于機器學習可解釋問題的書籍少之又少。

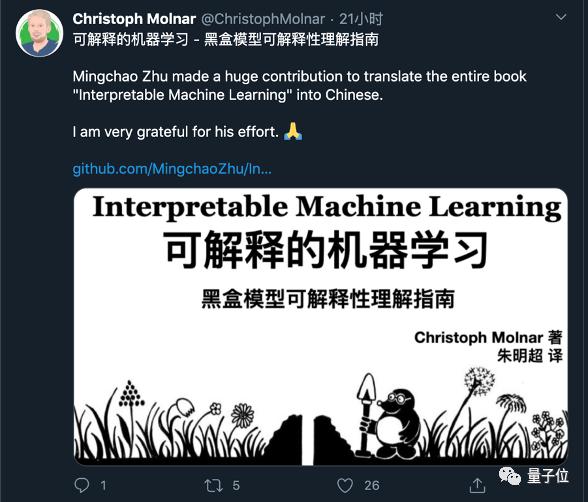

最近,一位來自復旦大學的研究生朱明超,將一本少有的書《Interpretable Machine Learning》(可解釋機器學習)翻譯成了中文。

這本書最初是由德國慕尼黑大學博士Christoph Molnar耗時兩年完成的,長達250頁,是僅有的一本系統介紹可解釋性機器學習的書籍。

朱明超近期完成了這本書的翻譯和校對工作,目前已經開源放到GitHub網頁上。朱同學在翻譯過程中還和原作者進行了多次討論,中文版還得到了Christoph Molnar本人在Twiter上的推薦。

“可解釋”是這本書的核心論題。作者認為,可解釋性在機器學習甚至日常生活中都是相當重要的一個問題。建議機器學習從業者、數據科學家、統計學家和任何對使機器學習模型可解釋的人閱讀本書。

《可解釋的機器學習》該書總共包含 7 章內容:

- 第一章:前言

- 第二章:可解釋性

- 第三章:數據集

- 第四章:可解釋的模型

- 第五章:模型無關方法

- 第六章:基于樣本的解釋

- 第七章:水晶球

Molnar表示,雖然數據集與黑盒機器學習解決了很多問題,但這不是最好的使用姿勢,現在模型本身代替了數據成為了信息的來源,但可解釋性可以提取模型捕捉到的額外信息。

當我們的日常生活中全都是機器和算法時,也需要可解釋性來增加社會的接受度。畢竟要是連科學家都研究不透“黑盒”,怎樣讓普通人完全信任模型做出的決策呢?

這本書的重點是機器學習的可解釋性。你可以從這本書中學習簡單的、可解釋的模型,如線性回歸、決策樹和決策規則等。

后面幾章重點介紹了解釋黑盒模型的模型無關的一般方法,如特征重要性和累積局部效應,以及用 Shapley 值和 LIME 解釋單個實例預測。

對各種解釋方法進行了深入的解釋和批判性的討論。它們是如何工作的?優點和缺點是什么?如何解釋它們的輸出?本書使你能夠選擇并正確應用最適合你的機器學習項目的解釋方法。

這本書結合了各類現實生活中的例子來介紹相關的概念,同時搭配參考鏈接幫助讀者進一步學習了解。

另外朱同學的GitHub上還一直在堅持翻譯Goodfellow的《機器學習》,還在翻譯中配上了自己編寫的Python代碼供參考。有興趣的同學也可以順帶去參考學習。

最后附上《可解釋機器學習》一書的項目地址:https://github.com/MingchaoZhu/InterpretableMLBook