論機器學習模型的可解釋性

在2019年2月,波蘭政府增加了一項銀行法修正案,該修正案賦予了客戶在遇到負面信用決策時可獲得解釋的權利。這是GDPR在歐盟實施的直接影響之一。這意味著如果決策過程是自動的,銀行需要能夠解釋為什么不批準貸款。

在2018年10月,“亞馬遜人工智能招聘工具偏向男性”的報道登上了全球的頭條新聞。亞馬遜的模型是基于有偏見的數(shù)據(jù)進行訓練的,這些數(shù)據(jù)偏向于男性應聘者。該模型構(gòu)建了不利于含有“Women's”一詞的簡歷的規(guī)則。

“不理解模型預測”產(chǎn)生的影響

上述兩個例子的共同之處在于,銀行業(yè)中的模型和亞馬遜構(gòu)建的模型都是非常復雜的工具,即所謂的黑盒分類器,它們不提供簡單且可解釋的決策規(guī)則。

如果金融機構(gòu)想要繼續(xù)使用基于機器學習的解決方案,就必須投資于模型可解釋性的研究。這些機構(gòu)可能確實會這么做,因為這樣的算法在預測信用風險方面會更準確。另一方面,如果模型經(jīng)過適當?shù)尿炞C和理解,亞馬遜本可以節(jié)省大量資金并避免負面報道。

為什么是現(xiàn)在?數(shù)據(jù)建模的趨勢

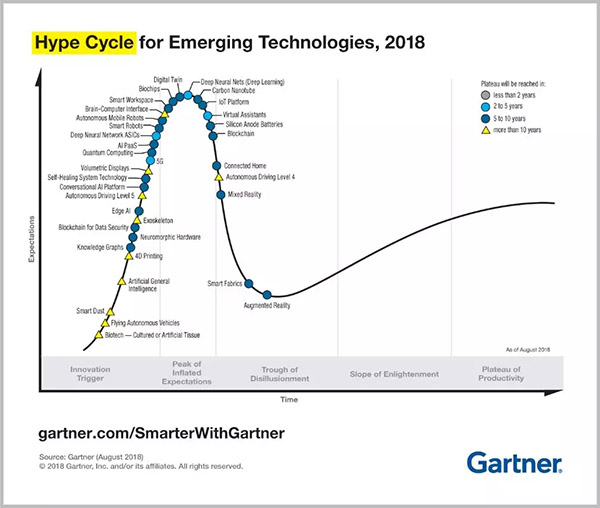

自2014年以來,機器學習一直保持在Gartner的Hype Cycle(技術成熟度曲線)的最頂端,直至2018年被深度學習(機器學習的一種形式)所取代,這表明其普及尚未達到峰值。

來源:https://www.gartner.com/smarterwithgartner/5-trends-emerge-in-gartner-hype-cycle-for-emerging-technologies-2018/

機器學習增長預計將進一步加速。根據(jù)Univa的調(diào)查報告,96%的公司預計在未來兩年內(nèi)將機器學習用于生產(chǎn)。

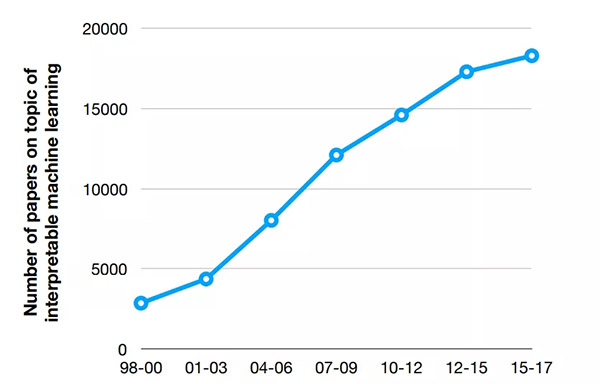

其背后的原因是:廣泛的數(shù)據(jù)收集、大量計算資源的可獲得性以及活躍的開源社區(qū)。機器學習采用的增長伴隨著解釋性研究的增加,而研究的增加是由像GDPR這樣的法規(guī)、歐盟的“解釋權”、對(醫(yī)療、自動駕駛汽車)安全性以及可重現(xiàn)性和偏見的擔憂,或者最終用戶的期望(調(diào)試優(yōu)化模型或者學習一些關于研究對象的新知識)所驅(qū)動的。

來源:http://people.csail.mit.edu/beenkim/papers/BeenK_FinaleDV_ICML2017_tutorial.pdf

黑盒算法可解釋性的可能性

作為數(shù)據(jù)科學家,我們應該能夠向最終用戶提供有關模型如何工作的解釋。但是,這并不一定意味著理解模型的每個部分或需要根據(jù)模型生成一組決策規(guī)則。

同時,如下情況也不需要解釋模型:

- 問題被完美研究

- 模型結(jié)果沒有后果

- 最終用戶理解模型可能會給系統(tǒng)帶來博弈風險

如果我們看看2018年Kaggle所做的機器學習和數(shù)據(jù)科學調(diào)查結(jié)果,大約60%的受訪者認為他們可以解釋大多數(shù)機器學習模型(有些模型仍難以解釋)。用于機器學習理解的最常用方法,是通過查看特征重要性和特征相關性來分析模型特征。

特征重要性分析提供了對模型學習內(nèi)容以及哪些因素可能重要的初步的良好洞察。但是,如果特征之間是相關的則該方法會不太可靠。只有模型變量可解釋時,它才能提供良好的洞察。對于許多GBMs庫(Gradient Boosting Machine),繪制關于特征重要性的圖表非常容易。

對于深度學習來說,情況要復雜得多。使用神經(jīng)網(wǎng)絡時,可以查看權重,因為它們包含關于輸入的信息,但信息是壓縮的。此外,你只能分析第一層的連接,因為在更深的層次上它太復雜了。

難怪2016年LIME(局部可解釋的模型-可解釋的說明)論文在NIPS會議上發(fā)表時,它產(chǎn)生了巨大的影響。LIME的模式是在可解釋的輸入數(shù)據(jù)上構(gòu)建一個易于理解的白盒模型去局部模擬一個黑盒模型。已經(jīng)證明它在為圖像分類和文本提供解釋方面獲得很棒的結(jié)果。但是,對于列表數(shù)據(jù),很難找到可解釋的特征,其局部解釋可能會產(chǎn)生誤導。

LIME通過Python(lime和Skater)和R(lime包和iml包、live包)實現(xiàn),并非常容易使用。

另一個有前景的想法是SHAP(Shapley Additive Explanations)。它基于博弈論。它將特征當做玩家、將模型當做聯(lián)盟,用Shapley值說明各特征分別帶來了怎樣的“影響(Payout)”。該方法公平地衡量(各特征的)作用,易于使用并提供吸引人的可視化實現(xiàn)。

以R提供的DALEX軟件包(描述性機器學習說明)提供了一組工具,可幫助了解復雜模型的工作原理。使用DALEX,可以創(chuàng)建模型解釋器并通過可視化進行檢查,例如分解繪圖。你可能也會對DrWhy.Ai感興趣,它和DALEX是由同一組研究人員開發(fā)的。

實際用例

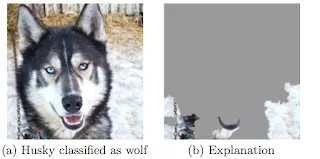

1、檢測圖片上的對象

圖像識別已被廣泛使用,其中在自動駕駛汽車中用于檢測汽車、交通信號燈等,在野生動物保護中用于檢測圖像中的某種動物,或在保險中用于檢測毀于洪澇的農(nóng)作物。

我們將使用原始LIME論文中的“哈士奇 vs 狼的例子”來說明模型解釋的重要性。該分類器的任務是識別圖片上是否有狼,但它錯誤地將西伯利亞哈士奇分類為狼。感謝LIME的研究人員能夠識別圖片上的哪些區(qū)域?qū)δP捅容^重要,最終發(fā)現(xiàn)如果圖片包含雪就會被歸類為狼。

該算法使用了圖片的背景并完全忽略了動物的特征。模型原本應該關注動物的眼睛。由于這一發(fā)現(xiàn),就可以修復模型并擴展訓練樣本以防止推理為雪=狼。

2、將分類作為決策支持系統(tǒng)

阿姆斯特丹UMC的重癥監(jiān)護室希望預測出院時患者再入院和/或死亡的可能性。目標是幫助醫(yī)生選擇將病人移出ICU的合適時機。如果醫(yī)生了解模型正在做什么,就更有可能在做最終判斷時使用它的建議。

為了展示如何使用LIME解釋這種模型,我們可以看另一個旨在早期預測ICU死亡率的研究。其使用了隨機森林模型(黑盒模型)預測死亡率情況,使用LIME局部解釋每個患者的預測分數(shù)。

來源:https://www.researchgate.net/publication/309551203_Machine_Learning_Model_Interpretability_for_Precision_Medicine

來自所選樣本中的一個患者被預測具有高死亡概率(78%)。導致死亡的模型特征為更高的房顫次數(shù)和更高的乳酸水平,這與當前的醫(yī)學理解是一致的。

人類和機器 - 完美搭配

為了在構(gòu)建可解釋的AI方面取得成功,我們需要將數(shù)據(jù)科學知識、算法和最終用戶的專業(yè)知識結(jié)合起來。創(chuàng)建模型之后,數(shù)據(jù)科學的工作還沒有結(jié)束。這是一個可迭代的、經(jīng)由專家提供反饋閉環(huán)的通常很漫長的過程,以確保結(jié)果是可靠的并且可被人類所理解。

我們堅信,通過結(jié)合人類的專業(yè)知識與機器的性能,我們可以獲得最佳結(jié)論:改進機器結(jié)果并克服人類直覺的偏差。

參考資料:

- On-line and web-based: Analytics, Data Mining, Data Science, Machine Learning education:https://www.kdnuggets.com/education/online.html

- Software for Analytics, Data Science, Data Mining, and Machine Learning:https://www.kdnuggets.com/software/index.html

相關信息:

- Are BERT Features InterBERTible:https://www.kdnuggets.com/2019/02/bert-features-interbertible.html

- Artificial Intelligence and Data Science Advances in 2018 and Trends for 2019:https://www.kdnuggets.com/2019/02/ai-data-science-advances-trends.html

- The year in AI/Machine Learning advances: Xavier Amatriain 2018 Roundup:https://www.kdnuggets.com/2019/01/xamat-ai-machine-learning-roundup.html