原作者帶隊,LSTM真殺回來了!

20 世紀 90 年代,長短時記憶(LSTM)方法引入了恒定誤差選擇輪盤和門控的核心思想。三十多年來,LSTM 經受住了時間的考驗,并為眾多深度學習的成功案例做出了貢獻。然而,以可并行自注意力為核心 Transformer 橫空出世之后,LSTM 自身所存在的局限性使其風光不再。

當人們都以為 Transformer 在語言模型領域穩坐江山的時候,LSTM 又殺回來了 —— 這次,是以 xLSTM 的身份。

5 月 8 日,LSTM 提出者和奠基者 Sepp Hochreiter 在 arXiv 上傳了 xLSTM 的預印本論文。

論文的所屬機構中還出現了一家叫做「NXAI」的公司,Sepp Hochreiter 表示:「借助 xLSTM,我們縮小了與現有最先進 LLM 的差距。借助 NXAI,我們已開始構建自己的歐洲 LLM。」

- 論文標題:xLSTM: Extended Long Short-Term Memory

- 論文鏈接:https://arxiv.org/pdf/2405.04517

具體來說,xLSTM 從三個層面解決了 LSTM 以往所存在的局限性:

(i) 無法修改存儲決策。

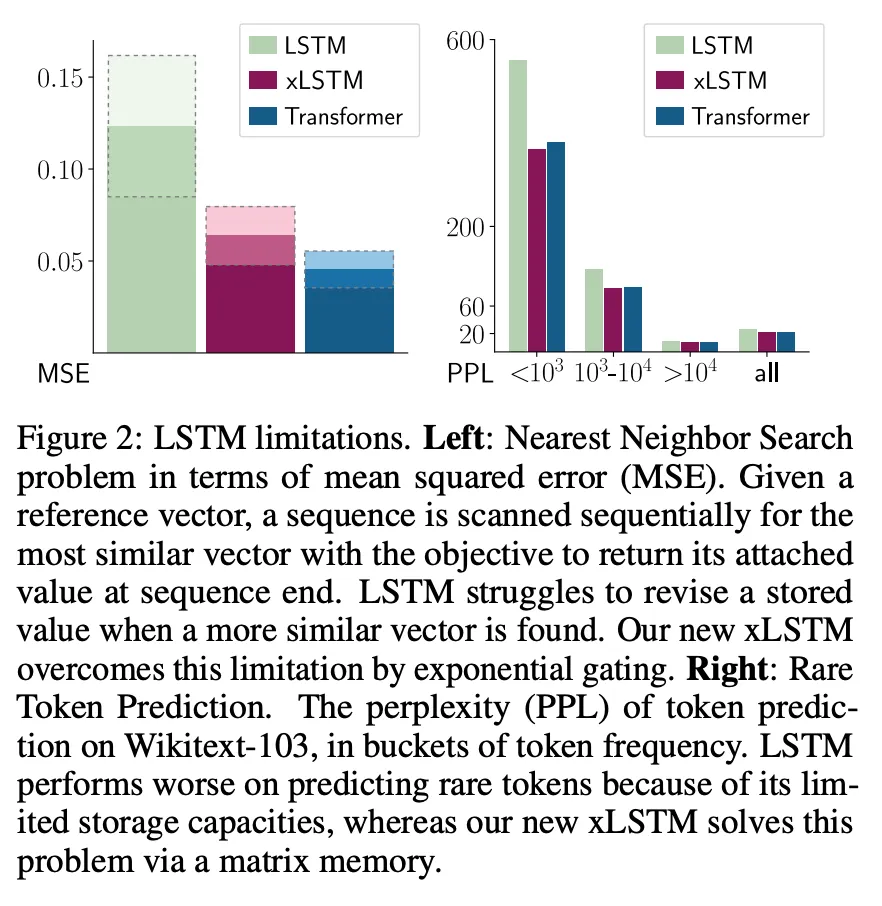

可以通過「最近鄰搜索」(Nearest Neighbor Search)問題來舉例說明這一局限性:在給定參考向量的情況下,必須按順序掃描序列,尋找最相似的向量,以便在序列末端提供其附加值。圖 2 左側顯示了這項任務的均方誤差。當發現更相似的向量時,LSTM 難以修改存儲的值,而新的 xLSTM 通過指數門控彌補了這一限制。

(ii) 存儲容量有限,即信息必須壓縮成標量單元狀態。

圖 2 右側給出了 Wikitext103 上不同 token 頻率的 token 預測困惑度。由于 LSTM 的存儲容量有限,它在不常見 token 上的表現較差。xLSTM 通過矩陣內存解決了這一問題。

(iii) 由于內存混合而缺乏可并行性,需要進行順序處理。例如,從一個時間步到下一個時間步的隱藏狀態之間的隱藏 - 隱藏連接。

與此同時,Sepp Hochreiter 和團隊在這篇新論文中回答了一個關鍵問題:如果克服這些局限性并將 LSTM 擴展到當前大語言模型的規模時,能實現怎樣的性能?

將 LSTM 擴展到數十億參數

為了克服 LSTM 的局限性,xLSTM 對等式(1)中的 LSTM 理念進行了兩項主要修改。

在原來的 LSTM 中,恒定誤差選擇輪盤是由單元輸入 z_t 對單元狀態 c_(t-1)(綠色)進行的加法更新,并由 sigmoid 門(藍色)進行調節。輸入門 i_t 和遺忘門 f_t 控制這一更新,而輸出門 o_t 控制存儲單元的輸出,即隱藏狀態 h_t。存儲單元的狀態被 ψ 歸一化或壓縮,然后輸出門控得到隱藏狀態。

xLSTM 的修改包括指數門控和新穎的內存結構,因此豐富了 LSTM 家族的兩個成員:

(i) sLSTM(第 2.2 節),具有標量內存、標量更新和內存混合功能;

(ii) mLSTM(第 2.3 節),具有矩陣內存和協方差(外積)更新規則,完全可并行處理。

sLSTM 和 mLSTM 都通過指數門控增強了 LSTM。為了實現并行化,mLSTM 放棄了內存混合,即隱藏 - 隱藏遞歸連接。mLSTM 和 sLSTM 都可以擴展到多個存儲單元,其中 sLSTM 具有跨單元內存混合的特點。此外,sLSTM 可以有多個頭,但不存在跨頭的內存混合,而只存在每個頭內單元間的內存混合。通過引入 sLSTM 頭和指數門控,研究者建立了一種新的內存混合方式。對于 mLSTM 而言,多頭和多單元是等價的。

將這些新的 LSTM 變體集成到殘差塊模塊中,就得到了 xLSTM 塊。將這些 xLSTM 塊剩余堆疊到架構中,就形成了 xLSTM 架構。xLSTM 架構及其組件見圖 1。

xLSTM 塊應在高維空間中對過去進行非線性總結,以便更好地分離不同的歷史或上下文。分離歷史是正確預測下一個序列元素(如下一個 token)的先決條件。研究者在此采用了 Cover 定理,該定理指出,在高維空間中,非線性嵌入模式比在原始空間中更有可能被線性分離。

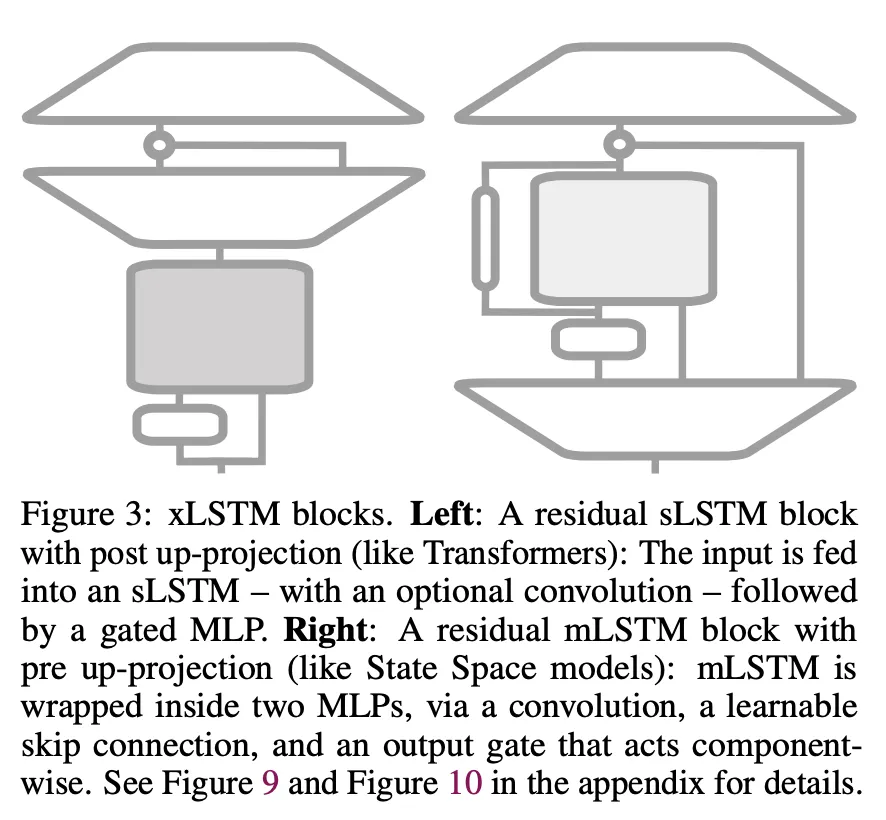

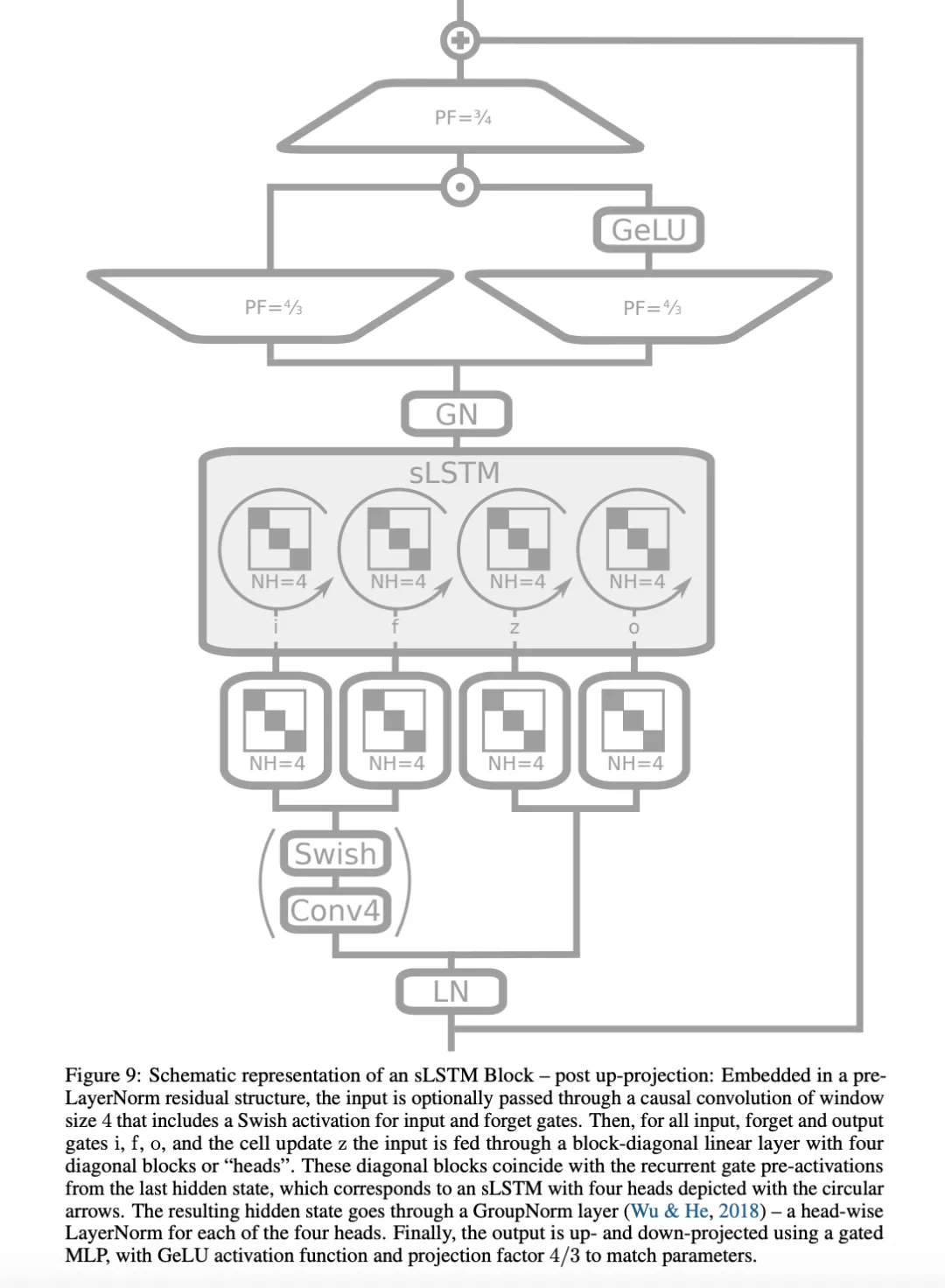

他們考慮了兩種殘差塊結構:(i) post up-projection 的殘差塊(如 Transformer),它非線性地概括了原始空間中的歷史,然后線性地映射到高維空間,應用非線性激活函數,再線性地映射回原始空間(圖 3 左側和圖 1 第三欄,更詳細的版本見圖 9)。(ii) pre up-projection 的殘差塊(如狀態空間模型),它線性地映射到高維空間,在高維空間中非線性地總結歷史,然后線性地映射回原始空間。對于包含 sLSTM 的 xLSTM 塊,研究者主要使用了 post up-projection 塊。對于包含 mLSTM 的 xLSTM 塊,使用 pre up-projection 塊,因為在高維空間中內存容量會變大。

實驗

隨后,研究者對 xLSTM 進行了實驗評估,并將其與現有的語言建模方法進行了比較。

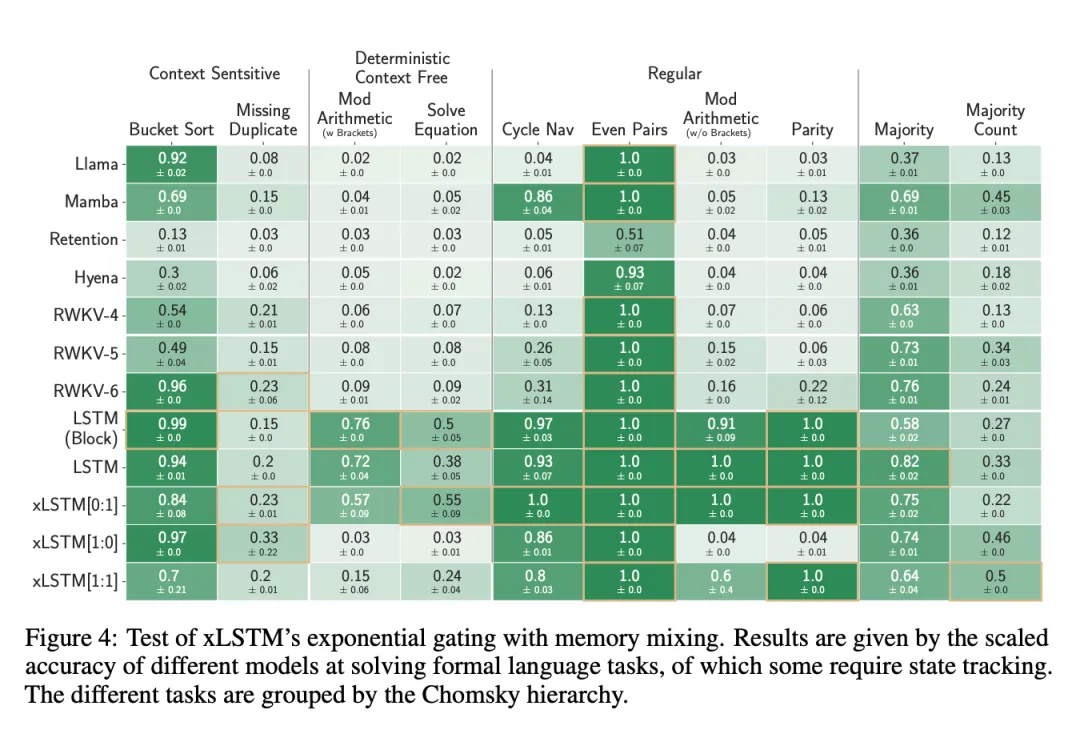

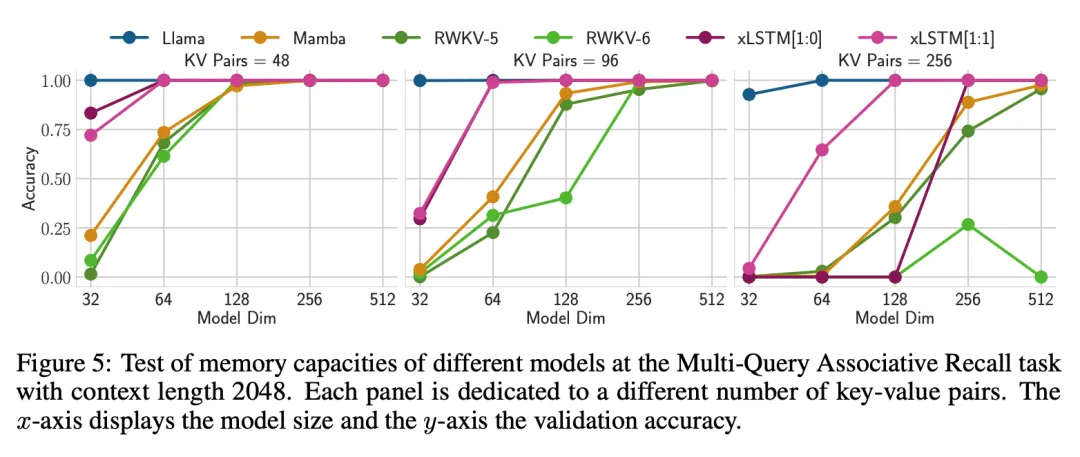

第 4.1 節討論了 xLSTM 在合成任務中的具體能力。首先,研究者測試了 xLSTM 的新指數門控與內存混合在形式化語言上的有效性。然后,他們評估了 xLSTM 的新矩陣內存在多次查詢聯想記憶任務(Multi-Query Associative Recall,MQAR)中的有效性。最后,研究者評估了 xLSTM 在 Long Range Arena(LRA)中處理長序列的性能。

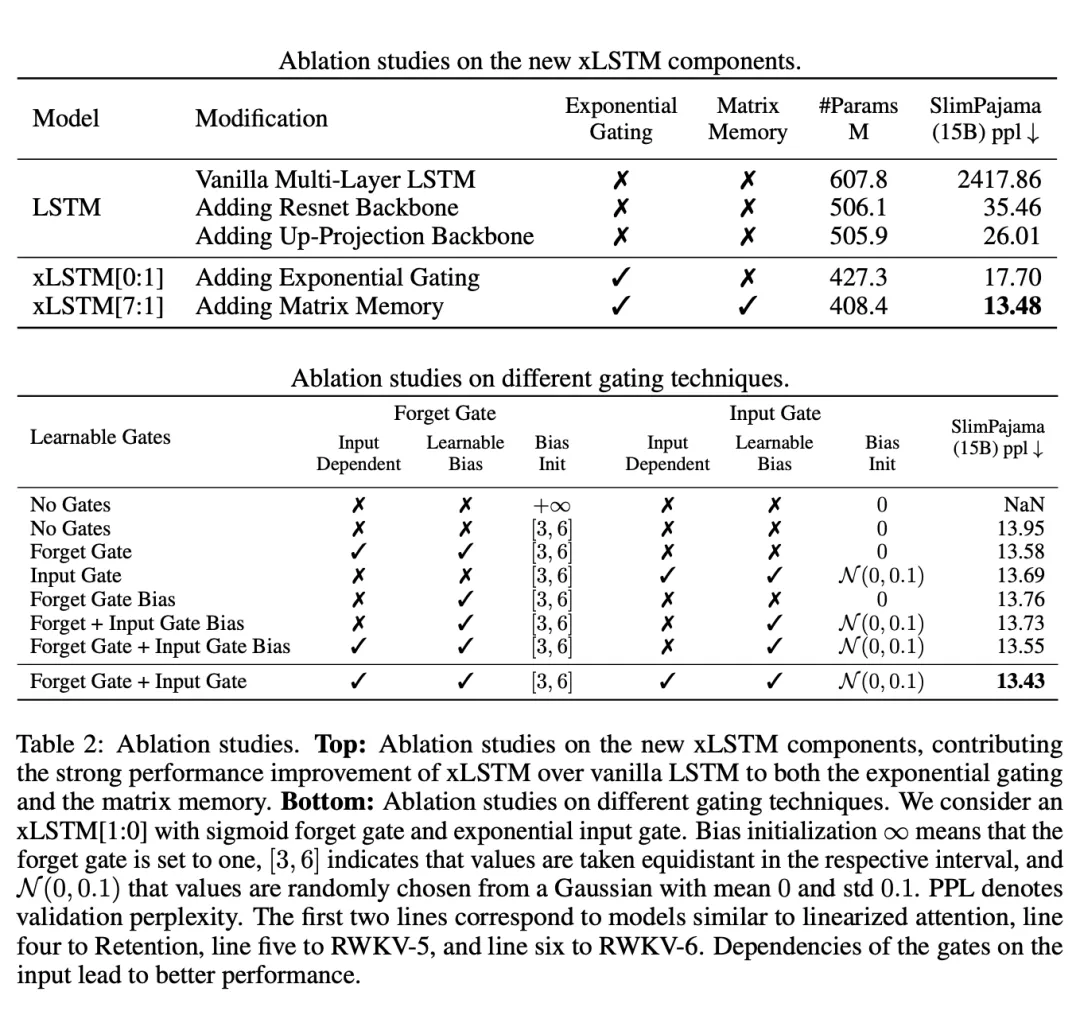

第 4.2 節比較了當前各種語言建模方法的驗證集復雜度,包括在同一數據集上對 xLSTM 進行消融研究,然后對不同方法的縮放行為進行評估。

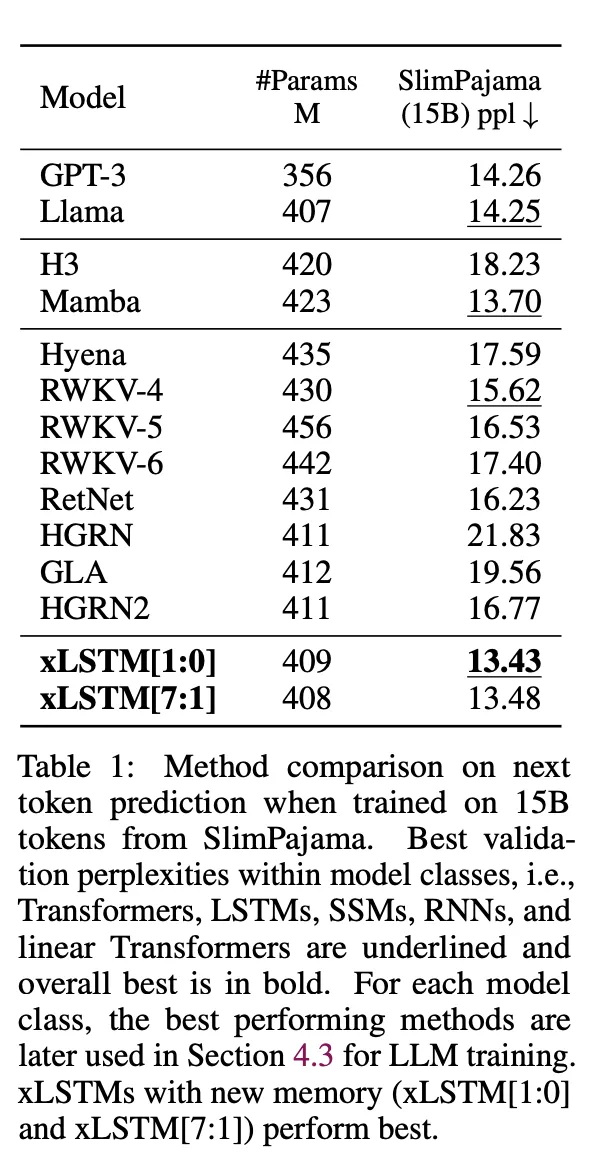

研究者在自回歸語言建模設置中使用 SlimPajama 的 15B token 訓練了 xLSTM、Transformers、狀態空間模型(SSM)等模型。表 1 中的結果顯示,xLSTM 在驗證復雜度方面優于所有現有方法。

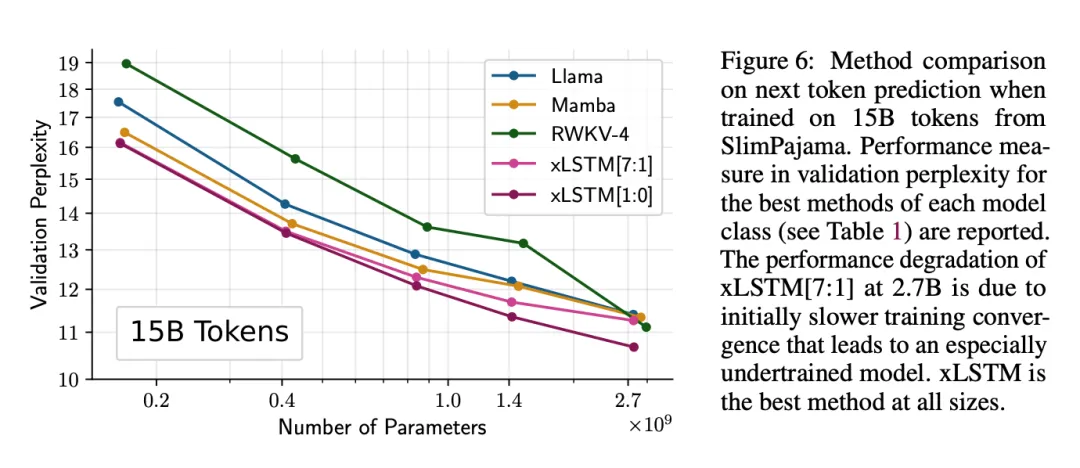

圖 6 顯示了該實驗的擴展結果,表明 xLSTM 對于更大規模的模型也有良好的表現。

消融研究則表明,性能改進源于指數門控和矩陣內存。

第 4.3 節進行了更深入的語言建模實驗。

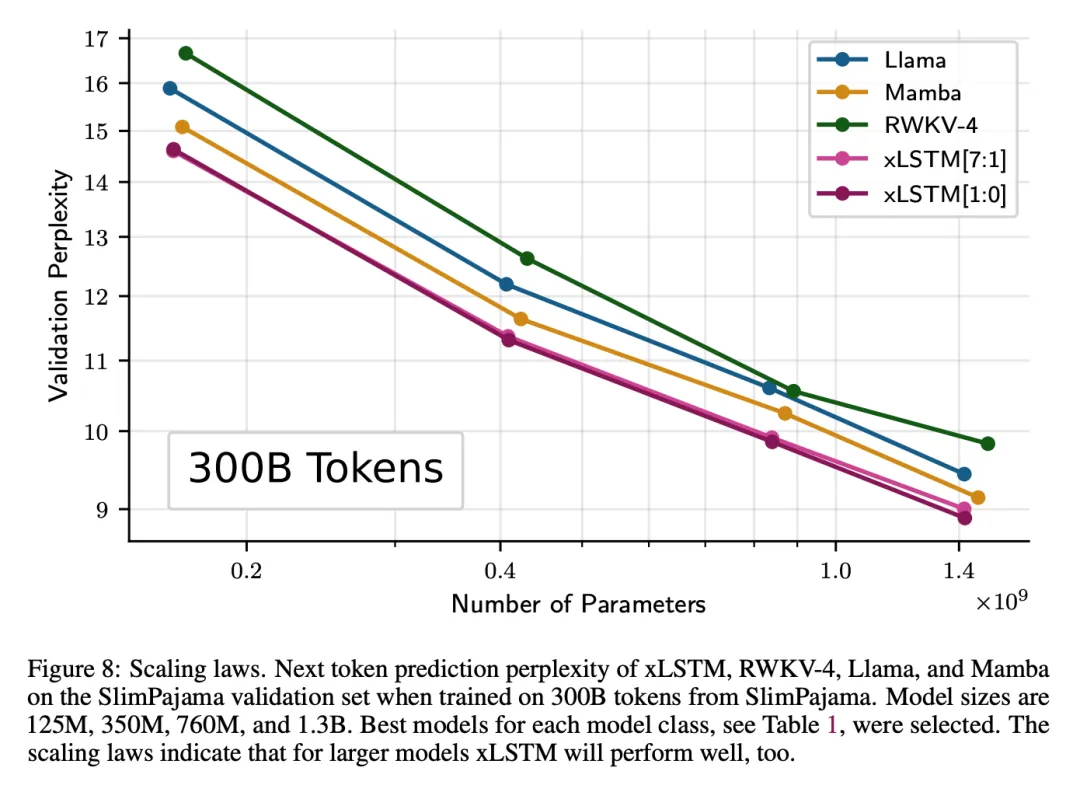

研究者增加了訓練數據量,對來自 SlimPajama 的 300B 個 token 進行了訓練,并比較了 xLSTM、RWKV-4、Llama 和 Mamba。他們訓練了不同大小的模型(125M、350M、760M 和 1.3B),進行了深入的評估。首先,評估這些方法在推斷較長語境時的表現;其次,通過驗證易混度和下游任務的表現來測試這些方法;此外,在 PALOMA 語言基準數據集的 571 個文本域上評估了這些方法;最后,評估了不同方法的擴展行為,但使用的訓練數據多了 20 倍。

可以看出,xLSTM 在性能和擴展性上都更勝一籌。

更多研究細節,可參考原論文。