真機數據白采了?銀河通用具身VLA大模型已充分泛化,預訓練基于仿真合成大數據!

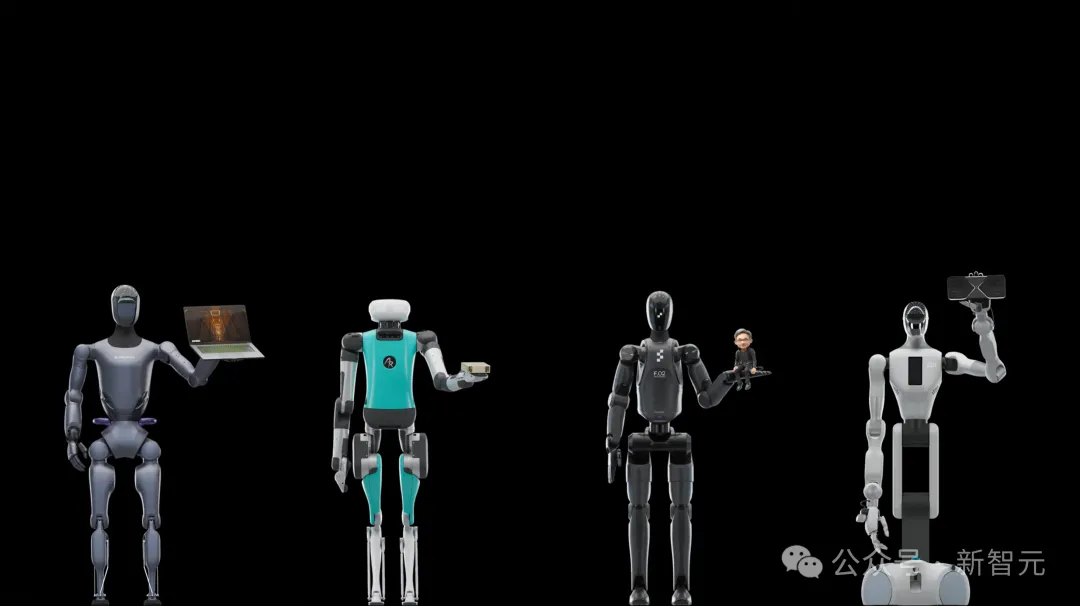

近日,英偉達CEO黃仁勛在今年CES的演講無疑讓整個科技圈為之沸騰。

他先是向全世界展示了搭載Blackwell新架構的新一代卡皇RTX 5090,然后介紹了英偉達對于人形機器人發展的期盼和投入,并以令人印象深刻的畫面結尾——

「來自銀河通用的全場唯一一臺輪式具身大模型機器人Galbot G1將RTX 5090緩緩托起。」

發布會結束后,黃仁勛更是第一時間親自來到銀河通用所在的展區,與Galbot機器人進行真機互動。

一時間,數字智能和物理智能的融會貫通、AI基建和AI模型及硬件的協同發展、科技巨頭與超級創投的攜手比肩,迸發出了前所未有的科技生命力。

全球的目光隨之聚焦,究竟是什么讓這位「AI教父」如此執著?為何唯獨這家公司承載了萬億巨頭的厚望?

具身智能無疑在今天的科技變革中扮演著核心角色,深刻著影響人類社會的發展變遷。

對于具身智能而言,「數據瓶頸」是業界公認亟待解決的最大挑戰。有的團隊認為具身和自動駕駛一樣主要依賴真機數據,有的團隊則認為需要采用大規模視頻數據學習的策略,來自全球的研究團隊各持己見。

直至今日,國內外已有多個研發團隊發布百萬級真機數據,但真機數據要采到什么規模、達到怎樣的多樣性、機器人硬件迭代后數據如何跟進等問題尚沒有明確答案。

今天,銀河通用聯合北京大學、北京智源人工智能研究院(BAAI)、香港大學研究人員正式發布全球首個端到端具身抓取基礎大模型GraspVLA。

作為全球首個完全基于仿真合成大數據進行預訓練的具身大模型,GraspVLA展現出比OpenVLA、π0、RT-2、RDT等模型更強大的泛化能力和在真實場景中的實用潛力。

作為全球首個完全基于仿真合成大數據進行預訓練的具身大模型,GraspVLA展現出比OpenVLA、π0、RT-2、RDT等模型更強大的泛化能力和在真實場景中的實用潛力。

伴隨著GraspVLA一同發布的,還有GraspVLA團隊總結的具身基礎模型七大泛化「金標準」,按照Vision、Language、Action進行不同分層,這些標準包括:光照泛化、干擾物泛化、平面位置泛化、高度泛化、背景泛化、物體類別泛化、閉環能力。

在此前各家發布的模型中,RDT初步展示了背景和類內物體泛化的能力,OpenVLA、π0、GR-2等進一步展示了干擾物、平面位置泛化的能力。

如今,GraspVLA率先實現了在多種能力的泛化,開創了以仿真合成大數據為核心的具身大模型發展新范式。

VLA預訓練到底能否泛化?GraspVLA團隊給出七大金標準

GraspVLA團隊表示,盡管近年來井噴式發展的具身VLA大模型在泛化性上取得了一定進展,但遲遲未有產品落地,其原因在于從實驗室到真實工作場景,模型難以通過各種環境因素動態變化的重重考驗。團隊認為不僅要關心任務能否被成功完成,更需關注任務在什么條件下可以成功完成。

銀河通用的研發團隊向我們展示了對GraspVLA模型以下泛化能力的全面評測:

1. 光照泛化

在銀河通用帶來的GraspVLA大模型工作展示中,我們看到在明亮、極暗甚至劇烈變化的光照條件下,模型都能精準執行抓取任務:

(2倍速)

更極端的情況下,團隊讓模型經歷從明到暗,甚至是幾近完全黑暗的情況下對目標物體進行移動,在實時觀測到目標物體移動后,大模型驅動機器人立即朝移動后的位置進行抓取,展現了GraspVLA大模型在極端光照條件下的強大適應能力與執行力。

(2倍速)

2. 背景泛化

銀河通用還展示了GraspVLA大模型在不同背景環境下的適應性,包括紅色桌布、星空圖案等多種場景。

(桌面泛化,3倍速)

銀河通用發布的視頻中還指出,GraspVLA采用雙視角作為輸入,我們看到的視頻畫面對應機器人正前方攝像頭視角。

當背景快速動態變化時,模型仍穩定執行任務,絲毫不受干擾,展現了GraspVLA大模型在動態環境中對變化背景的強大適應能力。

(背景墻泛化,3倍速)

3. 平面位置泛化

銀河通用團隊展示了GraspVLA在平面上抓取任意位置目標物體的能力,不論是在一堆物體中間,還是餐盤上,GraspVLA都能輕松抓取。

(3倍速)

4. 高度泛化

在展示模型對高度的泛化能力時,銀河通用團隊讓GraspVLA抓取擺放在不同高度的球,GraspVLA穩穩抓取:

(3倍速)

5. 動態干擾泛化

在GraspVLA工作時,往工作空間隨意丟物體進行干擾,即使撞到目標物體,也不影響它成功完成指令。

我們可以看到,在左上角視頻中,抓取目標在桌面上劇烈旋轉時,GraspVLA也能定位到;在左下角視頻中,目標物體胡桃夾子被撞走了至少三次,每次GraspVLA都明顯立即進行了調整。

6. 閉環動作輸出,不同姿態不同抓法

進行抓取時,即使目標物體被人為移動位置、甚至從立著改為倒下,GraspVLA都能實時調整動作完成抓取:

7. 零樣本Sim2Real抓取新物體

機器人領域公認使用仿真合成數據訓練模型具有Sim2Real Gap問題,然而,銀河通用強調,GraspVLA進行上述測試的所有物體、環境均未參與任何訓練。

此外,即使是從未出現在合成動作數據中的類別,僅經過互聯網圖文數據聯合預訓練,GraspVLA也能準確識別并把抓取能力泛化遷移:

快速對齊產品新需求?GraspVLA展現基座大模型屬性

經過以上七大金標準的檢驗,研究團隊充分論證了GraspVLA作為全球首個端到端抓取大模型的零樣本泛化能力。

眾所周知,基座大模型的另一個重要屬性是,能夠通過少樣本迅速對齊用戶新需求。

研究團隊表示,機器人模型落地過程中,不同場景會有不同的特殊需求,因此借助商超、工廠、家庭三個場景中的典型情形,進一步檢驗GraspVLA的快速適應及遷移能力。

1. 迅速服從指定規范并「舉一反三」

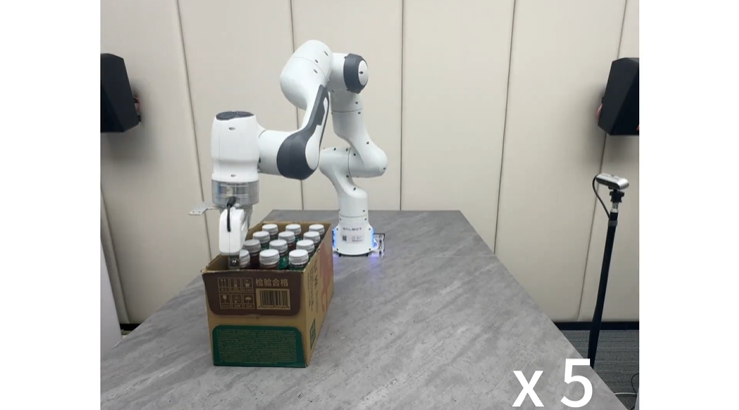

團隊以商超場景中按序取出箱中商品為例:雖然GraspVLA可以輕松抓起指定商品,但由于工作區有多個相同商品,模型不知道應該先取哪個:

(未按照順序抓取指定商品,2倍速)

為此,研究團隊采集了少量(少于一個人遙操一天)的按序抓取數據,GraspVLA就輕松理解了「順序」這一要求,充分展現基座模型的快速學習能力:

研究團隊進一步檢驗了這一能力對后訓練分布外情形(OOD)的泛化性。

盡管只采集了怡寶的數據,但GraspVLA將按序抓取這種行為自動遷移到其他品牌的飲品(東方樹葉、農夫山泉),按擺放順序分別抓取了瓶身顏色不同、瓶蓋大小不一的同類商品,充分驗證了GraspVLA作為基礎大模型的泛化能力。

2. 迅速掌握新詞匯,拓展新類別

具身大模型落地工業場景時,一大挑戰是認識這些行業專用的特殊零件,即,根據這些罕見詞匯找到對應物體。

銀河通用的研發團隊發現,盡管預訓練的模型可以輕松抓起任意零件,但是常常會「抓錯」,比如,指定「抓取車窗控制器」,模型卻抓起了接線座:

團隊進一步采集了少量軌跡進行快速后訓練,讓GraspVLA快速掌握了諸如接線座(wiring base)、三角板(triangular panel)、黑色軟管(black hose)等特殊工業名詞。

再結合其預訓練期間對于物體平面位置擺放的泛化性,模型迅速學會了從任意擺放的密集場景中精準找出對應零件:

(3倍速)

3. 迅速對齊人類偏好

家庭場景中,用戶對機器人的行為會有特定的偏好,比如盡管經過預訓練的GraspVLA可以根據指令抓起放著牙膏牙刷的杯子,但會碰到內壁。

同樣通過采集少量帶用戶偏好的抓取軌跡,GraspVLA就「聽懂了」抓取洗漱杯時,不能接觸杯子內壁:

(對齊后 3倍速)

從上面的三種典型應用場景來看,GraspVLA不僅「能力強」,還「懂人話」。

在新的場景中,直接部署預訓練的GraspVLA,就能輕松實現物體抓取。而針對用戶的新需求,也僅需少量數據即可讓它快速調整。憑借這一能力,無論需要在何時何地部署,僅需人類簡單的「指導」,機器人即可迅速「上崗干活」。

這充分展現了銀河通用團隊提出的「大規模合成數據預訓練」這種范式在商業落地中的潛力。

合成大數據驅動的 VLA 預訓練新范式

英偉達期望看到能夠托舉起未來世界的人形機器人,讓這些機器人在各類復雜任務中能夠自主執行,擁有泛化的能力。然而,這一宏偉目標在過去主流數據采集范式下面臨著兩大瓶頸。

瓶頸一:數據昂貴且稀缺。機器人技術的核心問題之一是大規模高質量數據的獲取。現有的訓練數據采集方式人工成本高、資金開銷大、采集周期長。此外,目前機器人硬件還在快速迭代,即使在現有硬件上高成本采集大規模數據,也可能迅速過時、與最新硬件不匹配,形成數據短板與沉沒成本。

瓶頸二:技能泛化性與通用性不足。受限于物理條件,真機數據采集往往無法覆蓋所有可能的實際應用場景,導致訓練出的模型難以泛化,因此目前的很多機器人只能在特定的環境條件和特定的物體下完成任務,缺乏對新環境的適應能力。

銀河通用表示,GraspVLA能達到如今的驚艷效果,離不開團隊多年研究合成仿真數據的經驗和對使用合成仿真數據的堅持。

為了突破上述兩大瓶頸,銀河通用的團隊開創性地研發出一套針對端到端VLA模型預訓練的全仿真合成數據生產管線,并在NVIDIA Isaac平臺的基礎上,進一步提高數據的物理真實性和物理渲染的并行度。

這套數據生產管線在短短一周內就能生成全球規模最大的十億級機器人操作數據集。不僅極大降低了數據生產的時間成本、人力成本、資金成本,還廣泛提高了數據對各種場景的覆蓋率。如此規模和質量的數據,是GraspVLA強大的抓取泛化能力的前提。

此次發布中,GraspVLA展現出的強大泛化與高效對齊能力引發我們深思:這一路線所展現出的全方位優越性,是否將一改業界對仿真合成路線的看法,開創合成大數據驅動的VLA預訓練新范式?這是否意味著大規模仿真合成數據預訓練將取代現有的高成本人工采集方案,帶領具身大模型的發展進入新的時代?

銀河通用還透露,聯合研發團隊在過去一年里也在導航VLA模型(NaVid系列模型)的研究上取得了重大突破,將陸續展示和介紹該系列導航VLA模型的泛化能力和涌現現象。

團隊表示,他們后續將不斷融合團隊多年積累,推出全面融合抓放、關節類物體操作、柔性物體操作等各類技能的全能大模型,繼續走以仿真合成數據為唯一預訓練來源的道路,確保所有大模型能夠以最小成本迅速進化,邁向具身智能領域的下一個高峰。