深度學習也能不玩大數據?小企業訓練大模型有新解

據外媒報道,AI領域專家吳恩達向IEEE表示深度學習未來的發展路徑應當從用大數據訓練模型向用優質數據轉變,為無法獲得大數據集的產業提供應用深度學習模型的機會。吳恩達曾任斯坦福人工智能實驗室主任,此前主導谷歌的Google Brain項目。

吳恩達認為,對深度模型的訓練應當從調整代碼轉向調整數據,通過調整影響訓練結果的噪聲數據(無意義數據),僅用少量優質的數據集即可完成模型更新,相較調整代碼或直接提供海量數據的方式,這種方法更具針對性。

吳恩達2017年成立的Landing AI公司目前在為制造業產品檢測方面提供計算機視覺工具,該工具能夠對噪聲數據進行快速標記,使客戶通過更改數據標簽自主完成模型的更新,不需要再對模型本身進行調整。

一、深度學習潛力強大,大數據訓練集成主流

人工智能的目標是讓機器像人類一樣“思考”和“行動”,機器學習是是實現這一愿景的重要方法,深度學習則是機器學習的重要分支,隨著2012年Hinton教授用機器學習方法在ImageNet圖像識別比賽中一舉奪魁,深度學習逐漸受到廣泛關注,在許多領域替代了傳統的機器學習方法,成為人工智能中的熱門研究領域。

過去十年里,深度學習實現了飛速發展,深度學習模型向著越來越大的方向發展,以OpenAI的自然語言處理模型GPT系列模型為例,2018年,GPT-1的參數規模突破1億,到2020年GPT-3問世時時,參數規模已經突破百億,超大模型的不斷涌現,顯示了深度學習的發展潛力。

但是,吳恩達認為,雖然目前深度學習方法在許多面向消費者的公司里實現了廣泛應用,但是這些公司往往擁有龐大的用戶基礎,能獲得大型數據集進行模型訓練,但對于許多不能獲得大型數據集的行業,則需要將重點從提供大量數據轉向提供優質數據。

二、從代碼轉向數據,用少量數據訓練優質模型

過去十年中,訓練深度學習模型的主流方法是下載數據集,然后專注于改進代碼,但如果一個機器學習模型對于大多數數據集來說是正常的,僅在其中一個數據集中出現偏差,為了適應這個數據集改變整個模型架構的方法是低效的。

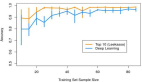

還有一種方法是從數據下手,這類方法被稱為“Data-centric AI”(以數據為中心的人工智能),一般的方法是通過補充更多數據提升模型的準確性。對此,吳恩達表示,如果試圖為所有情況收集更多數據,這個工作量將會很大,因此他致力開發出標記噪聲數據(無意義數據)的工具,提供一種針對性的方法,為模型訓練提供少量但優質的數據。

吳恩達說他一般采用的方法是數據增強或提高數據標簽的一致性等,比如對一個存有一萬張圖片的數據集,其中30張同類圖片有不同的數據標記時,他希望能夠構建識別標記不一致的圖片的工具,使研究人員能快速對其重新標記,而不是再搜集海量數據進行模型訓練。

三、Landing AI提供數據標記工具,用戶自主實現模型更新

2017年,吳恩達成立了Landing AI公司,為制造業公司提供產品檢測的計算機視覺工具,為生產商的產品進行視覺檢測。吳恩達在該公司的首頁介紹道,用人眼發現電路板劃痕超出了人眼觀測能力的極限,但用AI進行識別的準確率就高得多。

Landing AI重點在于讓客戶能夠自己訓練機器學習模型,該公司主要為其提供相關工具,能在數據出現異常時進行數據標記,讓公司自己就能實現模型的快速更新。

? ?

吳恩達表示,這不僅僅是制造業的問題,以醫療健康領域為例,每家醫院的電子版健康記錄都有自己的格式,期望每家醫院的程序員開發不同的模型是不現實的,唯一的方法就是為客戶提供工具,讓他們能夠構建適配的模型,Landing AI目前在計算機視覺領域推廣這樣的工具,其他AI領域業需要做這樣的工作。

結語:深度學習方法或轉向,數據求精不求多

長期以來,深度學習模型的更新與優化主要依賴對模型的調整,或直接補充更多數據,反復訓練模型,提升模型的準確度。吳恩達則更推薦對少量噪聲數據進行數據標記和更新,實現更有針對性的模型優化。

此前,吳恩達在推特上發起了“Data-centric AI”競賽,使更多從業人員注意到通過數據進行模型優化的方法,越來越多的研究人員使用數據增強(data augmentation)、合成數據(synthetic data)等方法,實現更高效的模型訓練。未來,數據優化是否會成為實現模型迭代的主流方法,值得期待。