ChatGPT參數(shù)規(guī)模被扒:只有7B

ChatGPT慘遭攻擊,參數(shù)規(guī)模終于被扒出來(lái)了——

很可能只有7B(70億)。

消息來(lái)自南加州大學(xué)最新研究,他們使用一種攻擊方法,花費(fèi)不到1000美元就把最新版gpt-3.5-turbo模型的機(jī)密給挖了出來(lái)。

果然,OpenAI不Open,自有別人幫他們Open。

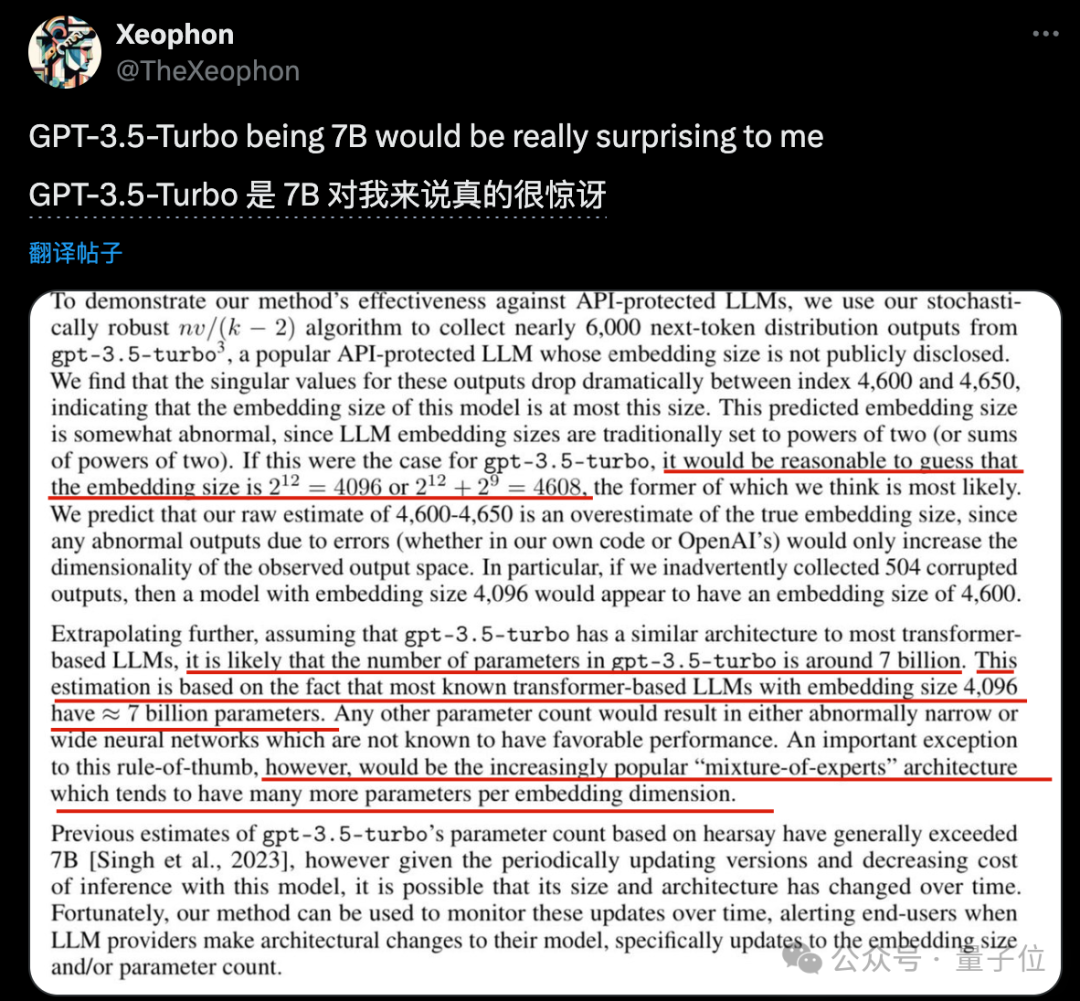

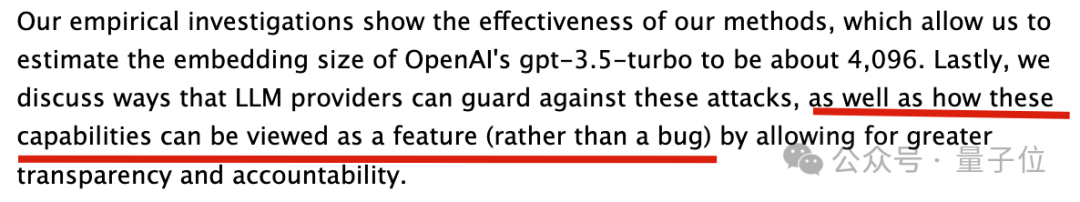

具體來(lái)說(shuō),南加大團(tuán)隊(duì)三位作者破解出了未公布的gpt-3.5-turbo嵌入向量維度(embedding size)為4096或4608。

而幾乎所有已知的開(kāi)源大模型如Llama和Mistral,嵌入向量維度4096的時(shí)候都是約7B參數(shù)規(guī)模。

其它比例的話,就會(huì)造成網(wǎng)絡(luò)過(guò)寬或過(guò)窄,已被證明對(duì)模型性能不利。

因此南加大團(tuán)隊(duì)指出,可以推測(cè)gpt-3.5-turbo的參數(shù)規(guī)模也在7B左右,除非是MoE架構(gòu)可能不同。

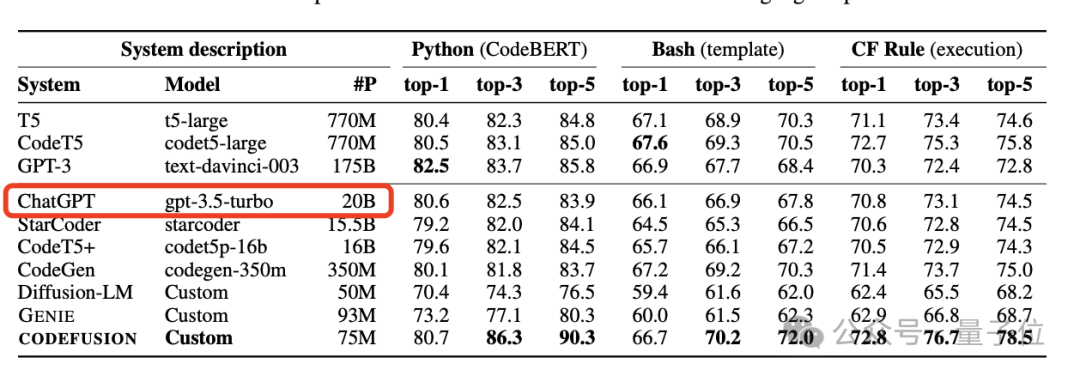

數(shù)月前,曾有微軟CODEFUSION論文意外泄露當(dāng)時(shí)GPT-3.5模型參數(shù)為20B,在后續(xù)論文版本中又刪除了這一信息。

當(dāng)時(shí)引起了一陣軒然大波,業(yè)界很多人分析并非不可能,先訓(xùn)練一個(gè)真正的千億參數(shù)大模型,再通過(guò)種種手段壓縮、蒸餾出小模型,并保留大模型的能力。

而現(xiàn)在的7B,不知道是從一開(kāi)始20B的消息就不準(zhǔn)確,還是后來(lái)又再次壓縮了。

但無(wú)論是哪一種,都證明OpenAI有很恐怖的模型優(yōu)化能力。

撬開(kāi)ChatGPT的保護(hù)殼

那么,南加大團(tuán)隊(duì)是怎么扒出ChatGPT未公開(kāi)配置的呢?

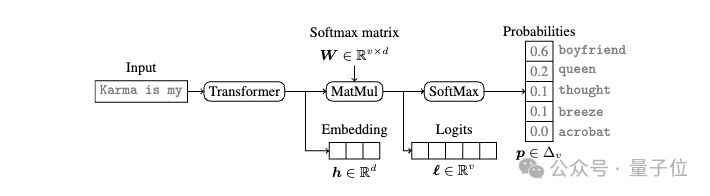

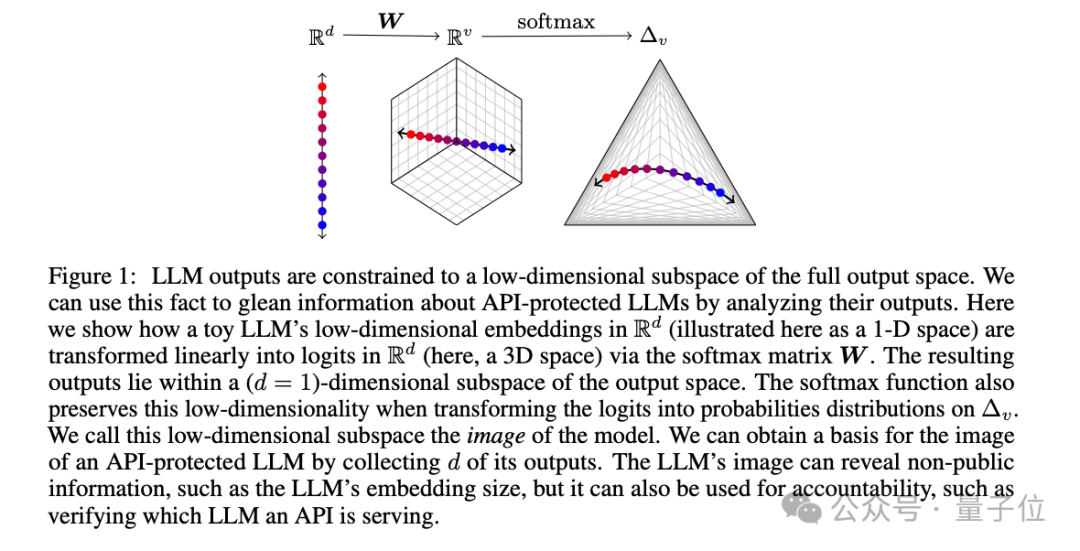

還要說(shuō)到現(xiàn)代語(yǔ)言模型中普遍存在的“Softmax瓶頸”。

當(dāng)Transformer網(wǎng)絡(luò)處理完輸入,會(huì)得到一個(gè)低維的特征向量,也就是Embedding。這個(gè)特征向量再經(jīng)過(guò)Softmax變換,就得到了最后的概率分布輸出。

問(wèn)題就出在Softmax這里,因?yàn)榫仃嚨闹仁芟抻谔卣飨蛄康木S度,所以大模型的輸出空間事實(shí)上被限制在了一個(gè)低維的線性子空間里。

這就像是無(wú)論你的衣柜里有多少件衣服,最后能穿出去的搭配,其實(shí)是有限的。這個(gè)”衣柜”的大小,就取決于你的“特征向量維度”有多大。

南加大團(tuán)隊(duì)抓住了這一點(diǎn),他們發(fā)現(xiàn),只要從API調(diào)用中獲取到足夠多的輸出樣本,就足以拼湊出這個(gè)大模型的特征向量維度。

有了這個(gè)特征向量維度,可以進(jìn)一步推斷大模型的參數(shù)規(guī)模、還原出完整的概率輸出,在API悄悄更新時(shí)也能發(fā)現(xiàn)變化,甚至根據(jù)單個(gè)輸出判斷來(lái)自哪個(gè)大模型。

更狠的是,推測(cè)特征向量維度并不需要太多的樣本。

以O(shè)penAI的gpt-3.5-turbo為例,采集到4000多個(gè)樣本就綽綽有余了,花費(fèi)還不到1000美元。

在論文的最后,團(tuán)隊(duì)還探討了目前的幾個(gè)應(yīng)對(duì)這種攻擊的方法,認(rèn)為這些方法要么消除了大模型的實(shí)用性,要么實(shí)施起來(lái)成本高昂。

不過(guò)他們倒也不認(rèn)為這種攻擊不能有效防護(hù)是個(gè)壞事,

一方面無(wú)法用此方法完整竊取模型參數(shù),破壞性有限。

另一方面允許大模型API用戶自己檢測(cè)模型何時(shí)發(fā)生變更,有助于大模型供應(yīng)商和客戶之間建立信任,并促使大模型公司提供更高的透明度。

這是一個(gè)feature,不是一個(gè)bug。

論文:

https://arxiv.org/abs/2403.09539。

參考鏈接:

https://x.com/TheXeophon/status/1768659520627097648。