照片也能時間旅行?「穿越時空的人臉」新模型化身AI時光機

?目前,人工智能和深度學習技術(shù)正成為文本-圖像生成、超分辨率等應(yīng)用的重要基礎(chǔ)。

現(xiàn)在,人們可以輸入圖像的高細節(jié)描述,從而獲得與給定文本相對應(yīng)的逼真圖像。

也可以將一幅圖像從低分辨率轉(zhuǎn)為高分辨率,為圖片生成一系列生動細節(jié)。

神經(jīng)網(wǎng)絡(luò)似乎有無窮的能力。那么,這些方法是否能用于時光穿梭呢?

例如,你有沒有想過,如果你自己的照片是在五十年或一百年前拍攝的,會是什么樣子?如果你最喜歡的男演員或女演員出生在一個與他們完全不同的時代,他們會是什么樣子?

時光穿梭第一步:解決數(shù)據(jù)集難題

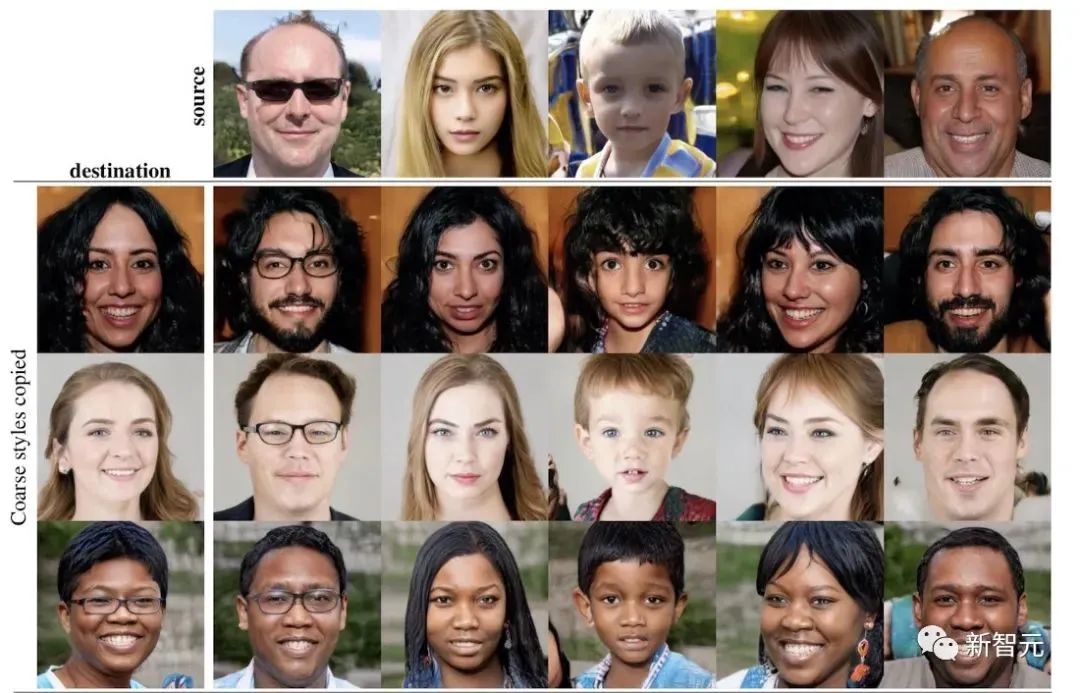

鑒于最近StyleGAN在高質(zhì)量人臉合成和編輯方面的成功,許多工作都集中在使用預先訓練好的StyleGAN模型進行人像編輯。

然而,現(xiàn)有的技術(shù)通常會處理定義明確的語義屬性。例如,添加或刪除一個微笑或修改圖片中人像的年齡。

這項工作背后的邏輯是保持這些構(gòu)成一個人身份的屬性不變,與此同時,用這輛人工智能的馬車送他們回到過去或去往未來。

在這種情況下,人們面對的主要問題是缺乏合適的數(shù)據(jù)集。眾所周知,即使有完美的神經(jīng)網(wǎng)絡(luò)模型,數(shù)據(jù)集仍然是每個人工智能研究者的噩夢。

數(shù)據(jù)不平衡、不充分或不可用是深度學習領(lǐng)域常見的問題,會導致數(shù)據(jù)偏見或結(jié)果不準確。

為了克服這個問題,來自康奈爾大學的華裔科學家Eric Ming Chen(左2)主導的研究團隊創(chuàng)建了FTT(穿越時光的人臉)數(shù)據(jù)集。

Chen與來自佐治亞大學的華人科學家Jin Sun等人共同發(fā)刊,詳細解釋了「穿越時光的人臉」數(shù)據(jù)集的運作原理。

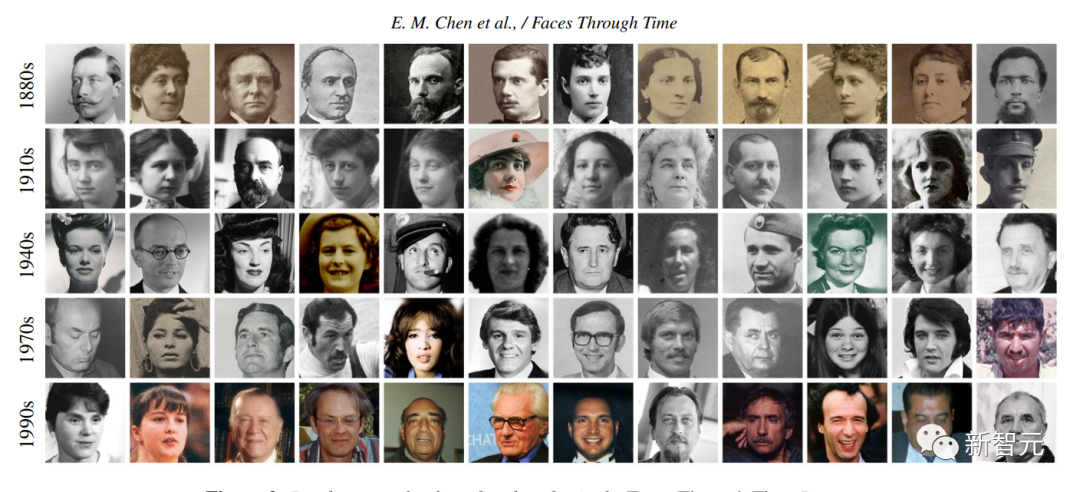

該數(shù)據(jù)集中的圖片來自維基共享資源(Wikimedia Commons)。該平臺擁有眾包和開放許可的五千萬張圖片。FTT分析了26,247張19至21世紀的肖像,平均每十年大約有1,900張圖片。

GANs父子層次結(jié)構(gòu),化身AI「時光機」

這些變化是如何實現(xiàn)的呢?

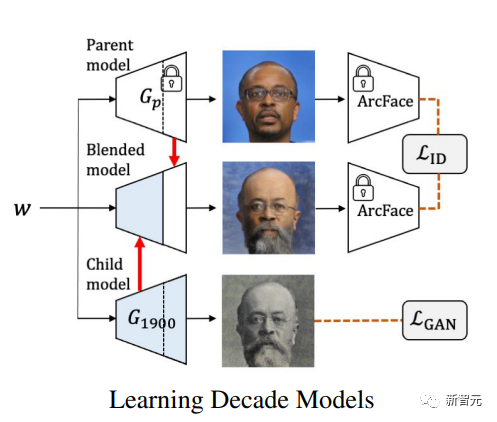

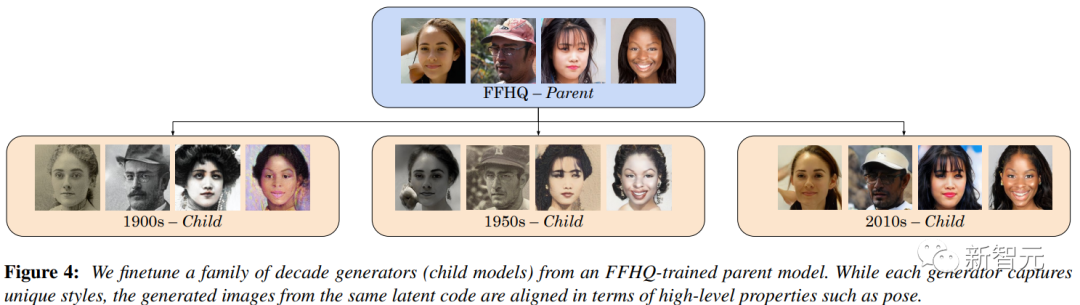

研究團隊借助了StyleGAN(生成對抗網(wǎng)絡(luò))父子層次結(jié)構(gòu)。特殊之處在于,他們沒有選擇訓練一個涵蓋所有年代的單一模型,而是為每十年的圖像集添加一個子模型,通過訓練模型集更好地綜合每個時期的數(shù)據(jù)分布。

同時,為了保留被描述者的身份和姿勢,研究團隊采用一個父模型,將這些信息映射到隱空間向量中。

首先,訓練一個StyleGAN模型集,每個年代各設(shè)置一個,使用對抗性損失和身份損失來訓練一張混合人臉圖。這張人臉圖是子模型的輸出,經(jīng)過修改后,該混合圖與父模型的顏色相似。

研究團隊提示,在此過程中,有必要避免由于ArcFace(一種流行的面部識別模型)中的特征計算導致的身份損失的不一致性。由于ArcFace模型只在現(xiàn)代圖像上訓練,研究人員發(fā)現(xiàn)它在歷史圖像上的表現(xiàn)很差。

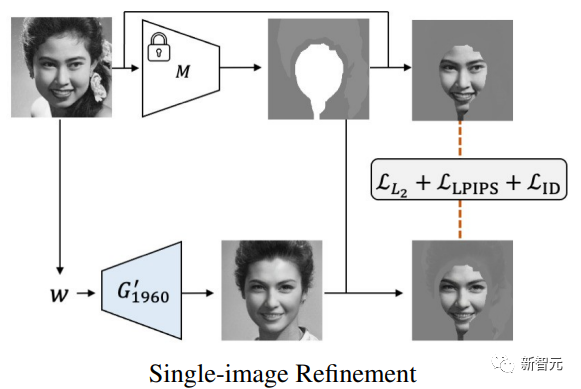

之后,每張真實圖像被投射到十年流形上的一個向量w上(下圖中的1960)。在該向量上,生成器G′t被訓練來將精細化細節(jié)轉(zhuǎn)移到所有的子模型上。最后,在輸入圖像上應(yīng)用一個掩碼,以鼓勵模型保留人像的面部細節(jié)。

在微調(diào)全部子模型后,研究團隊發(fā)現(xiàn),F(xiàn)TT的不同年代的子模型(下圖橙色)在發(fā)型、妝容發(fā)生改變的同時,都成功捕捉到父模型中(下圖藍色)每張圖片的人像特征。

這項全新的合成圖像框架有兩大亮點:首先,它使人像穿越時光的愿望成真;其次,在對人臉進行時光轉(zhuǎn)換時,該技術(shù)還能保留人像的大部分細節(jié)。

盡管它在數(shù)據(jù)集中還存在微小偏差(例如,在20世紀初的圖像中出現(xiàn)了幾個短發(fā)的女性),導致輸出圖像的不一致,但與以前的工作相比,這個模型在真實性上有了很大改善。

「穿越時光的人臉」開啟了時光穿梭的第一步。如此高的準確度讓人不禁遐想:這次跨越時光的是人像,那么下次呢?

參考資料:

https://www.marktechpost.com/2022/11/09/latest-artificial-intelligence-ai-research-proposes-a-method-to-transform-faces-through-time/

https://facesthroughtime.github.io/