《美國憲法》和《圣經》都是AI生成?AI檢測器不靠譜,人類數據有限會限制AI發展

AI生成的內容到底能不能被有效地識別出來?

讓我們來看幾個例子:

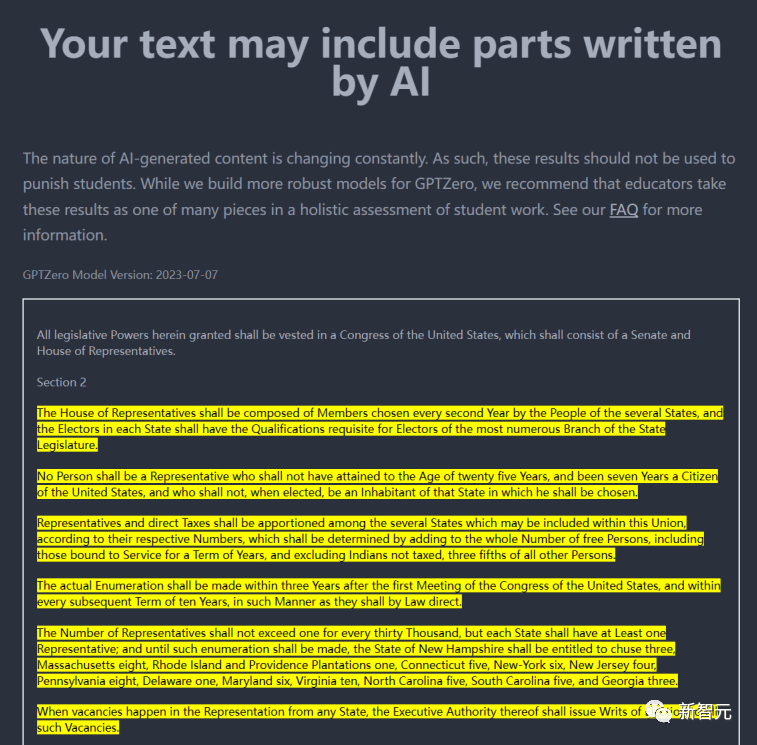

如果把美國憲法輸入到GPTZero這類用來檢測文本是否是AI模型生成的工具中,它會告訴你這份文件幾乎肯定是由AI生成的。

圖片

圖片

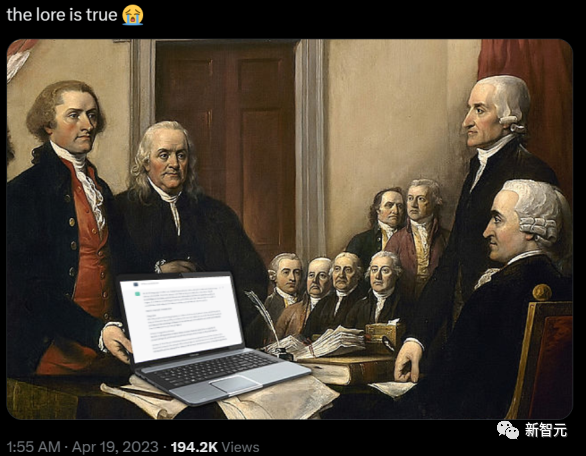

這一情況引發很多美國網友對于他們國父真實身份的猜疑。

圖片

圖片

他們都是時空行者,這張圖就是石錘!

圖片

圖片

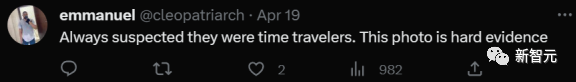

同樣的,對于《圣經》中的內容,檢測工具也是持同樣的態度。

圖片

圖片

而國外一個大學教授由于懷疑學生使用AI寫論文,他把學生的論文放到了像上文這樣的AI檢測工具中,用檢測工具的結果直接掛掉了大部分學生。

但結果是大部分的學生其實都是自己寫的論文,把教授和學校都搞得焦頭爛額。

圖片

圖片

那么,為什么AI檢測工具為什么會有這么離譜的檢測結果。

國外媒體詢問了幾位業內專家,以及AI寫作檢測器GPTZero的創始人,希望能找到其中的原因。

利用語言的困惑度來鑒定AI不太靠譜

不同的AI寫作檢測器使用略有不同的檢測方法,但是原理相似:

用一個AI模型,它經過了大量的文本(包含數百萬篇寫作例子)訓練,并建立了一套推測規則,用來判斷這篇寫作更是人類寫的還是AI生成的。

以GPTZero為例,它的核心是一個神經網絡,這個網絡是基于「大量、多樣的人類寫作和AI生成的文本訓練的,但是訓練數據的重點是英文散文。

然后,這個系統使用像「困惑度」(Perplexity)和「突發性」(Burstiness)這樣的特性來評估文本并進行分類。

在機器學習中,困惑度是衡量一個文本偏離AI模型在訓練期間學到的內容的程度的指標。

正如AI公司Hugging Face的瑪格麗特·米切爾博士說到的,「困惑度是這種語言基于我所看到的內容有多令我驚訝?'的一個函數」。

所以,測量困惑度的原理就是,當AI模型,比如ChatGPT生成文本時,它們自然會選擇它們最擅長的內容。

而這些內容就來自它們的訓練數據。

輸出的內容離訓練數據越近,困惑度就越低。

但是人類是更混亂的寫作者,或者至少這是理論上的。

但是人類也可以寫出低困惑度的文字,特別是當按照法律或某些類型的學術寫作的正式風格時。

此外,人類使用的許多短語其實出奇的常見,或者說可預測。

比如說作為人類,猜測在「I'd like a cup of _____.」這句話中的下一個詞。

大多數人可能會在這個空格中填上「水」、「咖啡」或「茶」。

一個接受了大量英語文本訓練的語言模型也會這樣做,因為這些短語在英文寫作中經常出現。

所以任何這三個結果的困惑度都會非常低,因為預測相當準確。

現在如果出現一個不太常見的填空答案:「我想要一杯蜘蛛」。

人類和一個訓練有素的語言模型都會感到相當驚訝(或者說「困惑」),所以它的困惑度會很高。

如果一篇文本中的語言基于模型的訓練并不令人驚訝,那么困惑度就會很低,所以AI檢測器更有可能將這段文本分類為AI生成。

這就是為什么「美國憲法」的例子背后的原因。

本質上,憲法的語言在這些模型中已經非常根深蒂固了,以至于AI檢測器將其分類為AI生成,從而做出了錯誤的判斷。

GPTZero的創建者Edward Tian說,「《美國憲法》是一個反復輸入到許多大型語言模型訓練數據中的文本。

因此,這些大型語言模型訓練的結果就是能夠很容易地生成與憲法和其他常用訓練文本相似的文本。

GPTZero預測出可能由大型語言模型生成的文本,因此就出現了這種令人著迷的現象。」

問題在于,人類也完全有可能創作出困惑度很低的內容(例如,如果他們主要使用常見的短語,如「我想要一杯咖啡」)。

這就讓AI檢測器的結果變得很不靠譜了。

突發性也解決不了問題

GPTZero衡量的文本的另一個屬性是「突發性」,指的是某些詞或短語在文本中快速連續或「突發」出現的現象。

本質上,突發性評估了文本全程的句子長度和結構的變化性。

人類往往會有比較動態的寫作風格,產生的句子長度和結構會是比較多樣的。

例如,我們可能會寫一句長而復雜的句子,接著是一句短而簡單的句子,或者我們可能在一句話中使用一連串的形容詞,然后在下一句中一個形容詞也不用。

這種變化性是人類創造性和自發性的自然產物。

另一方面,AI生成的文本傾向于更加一致和規整——至少目前為止是這樣的。

處于初期階段的語言模型,生成的句子長度和結構更規則。

這種缺乏變化性可能導致突發性分數低,表明文本可能是AI生成的。

然而,突發性也不是檢測AI生成內容的萬全之策。

但就像困惑度一樣,人類也可能以一種高度結構化、一致的風格寫作,導致突發性分數低。

反過來,一個AI模型可能被訓練來模仿更人性化的句子長度和結構的變化性,提高其突發性分數。

實際上,隨著AI語言模型的改進,研究表明,它們的生成結果越來越像人類的寫作。

最終,可能不會存在一個非常簡單而且巧妙地區分人類寫的文本和機器寫的文本的方法。

AI寫作檢測器可以做猜測性的判斷,但誤差邊際太大,無法依賴它們給出準確的結果。

檢測AI生成內容在未來越來越重要

而對AI生成的內容,特別是文字內容的檢測,在未來會越來越重要!

因為,在未來要想訓練ChatGPT這樣規模的語言模型,可能現有的人類數據已經快不夠用了!

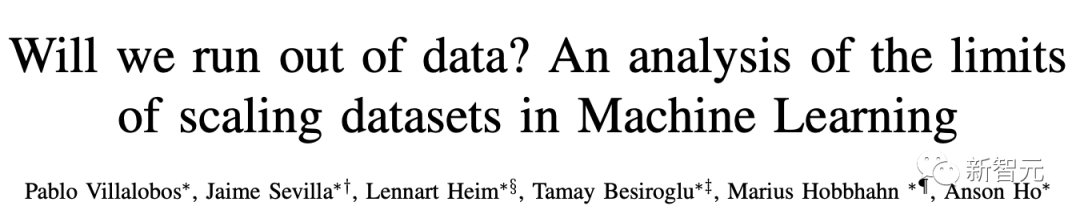

去年11月,MIT等研究人員進行的一項研究估計,機器學習數據集可能會在2026年之前耗盡所有「高質量語言數據」。

圖片

圖片

論文地址:https://arxiv.org/pdf/2211.04325.pdf

于是很多大佬們都表示,未來可能會用AI生成的數據來訓練AI。

但是這個美好的愿望可能會面臨一個非常現實的問題。

因為至少目前看來,AI生成的數據對于訓練AI來說,可能是有毒的。

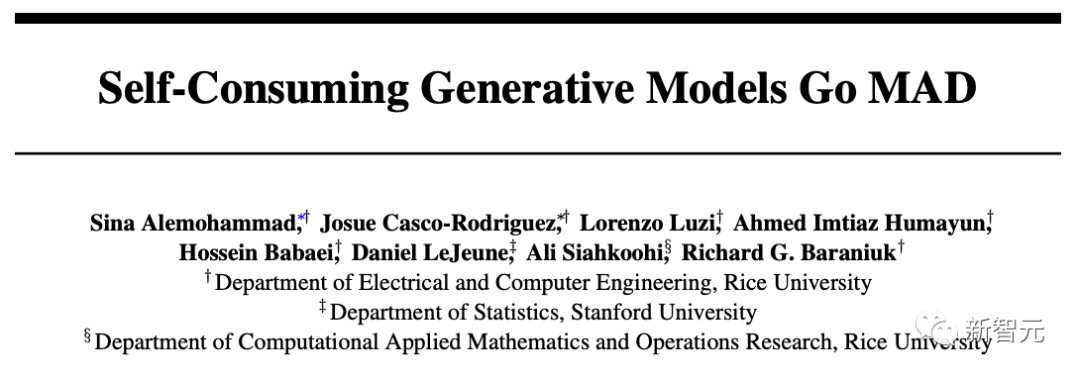

近日,萊斯大學和斯坦福團隊發現,將AI生成的內容喂給模型,只會導致性能下降。

研究人員對此給出一種解釋,叫做「模型自噬障礙」(MAD)。

圖片

圖片

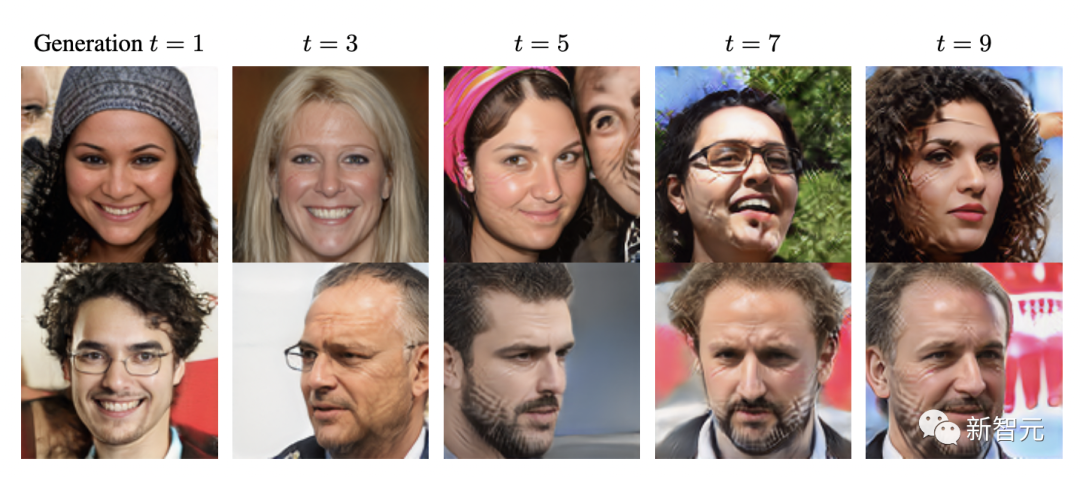

研究發現在使用AI數據,經過第5次迭代訓練后,模型就會患上MAD。

圖片

圖片

在合成數據上訓練AI模型會逐漸放大偽影

換句話說,如果不能給模型提供「新鮮的數據」,即由人類標注的數據,其輸出質量將會受到嚴重影響。

一方面,研究者們在研究如何方便地給AI生成的數據打水印,讓新生成的AI數據能夠方便地被識別出來,從而避免被拿來進行AI訓練。

另一方面,面對未來可能大量出現的沒有水印的AI生成數據,把它們和人類數據區別開就是非常重要的事情。

這不但關乎學生們會不會被老師冤枉導致掛科,更嚴重的是會因為數據重復訓練的問題導致AI發展受阻。

希望像ZeroGPT這樣的平臺能夠盡快克服現有的技術限制,保證未來訓練AI的數據盡可能是原生的人類數據。