聊聊人工智能安全現狀

隨著人工智能技術的興起對該領域的研究也日益加深,其應用也早已融入到很多領域并成為其不可分割的一部分。目前來講,人工智能已經涵蓋數學、計算機科學等多個學科的知識,并且對每個方向都有詳細的技術探討過程。已呈現星星之火、燎原之勢。但是人工智能技術是一把“雙刃劍”,在給我們生活帶來便利之時,也會帶來相關的問題。目前安全方面的問題最受關注,本文從其基本概念和內涵出發,主要結合一些案例來分析目前人工智能技術存在的安全風險并在最后提出相關建議。

人工智能基本概念

1956年,美國達特茅斯會議上,科學家約翰麥卡錫首次提出“人工智能”(Artificial Intelligence, AI)一詞。人工智能是讓機器的行為看起來像人所表現出的智能行為一樣的技術。在人工智能概念提出時,科學家主要確定了智能的判別標準和研究目標,而沒有回答智能的具體內涵。之后,諸多知名學者都對人工智能內涵提出了自己的見解,反映人工智能的基本思想和基本內容:研究如何應用計算機模擬人類智能行為的基本理論、方法和技術。但是,由于人工智能概念不斷演進,目前未形成統一定義。

人工智能安全內涵

人工智能安全的內涵一方面包括人工智能在安全領域的應用,如人工智能在越來越多的行業輔助或替代人類。另一方面是人工智能自身的安全問題,是本文的著眼點。如何促進人工智能的應用更加安全和道德一直是人類長期思考和不斷深化的命題。現階段的人工智能技術不成熟性會導致諸多安全風險。例如:一輛自動駕駛汽車必須在撞一個老人和撞一個孩子之間做出抉擇時,它會怎么選擇?其背后的原因何在?它在做出選擇時會更看重哪些因素?它能夠自圓其說嗎?這只是數學運算的結果,在人類看來是不可解釋的。除此之外,數據的強依賴性和人為的惡意應用都屬于技術不成熟性帶來的安全風險;再者,不光人工智能系統需要安全性,其他的系統也需要安全性。利用人工智能去攻擊其他系統,探測其他系統的漏洞,這種行為可能會給網絡空間和國家社會帶來安全風險[1]。因此,人工智能安全內涵包含[2]:降低人工智能技術不成熟性帶來的安全風險,同時利用人工智能構建安全防護系統,減少人為惡意應用帶來的危害。

人工智能安全風險分析

在分析之前,我們首先來簡單的介紹一下人工智能的應用。由于人工智能具有突出的數據分析、知識提取、自主學習等優點,被廣泛應用在網絡防護、數據管理、信息審查、智能安防、金融風控以及輿情監測等方面。在這些方面,往往存在若干安全風險,常見風險如下:

1.框架安全風險

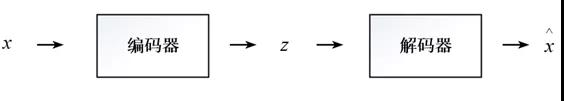

近些年來,我們熟知的深度學習框架TensorFlow、Caffe等,及其依賴庫被多次發現存在安全漏洞,這些漏洞可被攻擊者利用,引發系統安全問題。以生成模型(Generative Models)舉例[3],其原本的工作原理為:輸入x經過編碼器映射到低維表示z,再經過解碼器映射回高維重建x,用表示。如下圖所示:

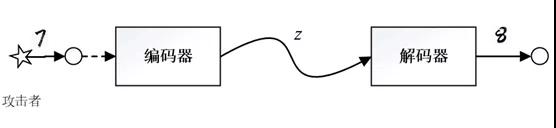

被攻擊后就可能出現以下情況:假設輸入為7,經過攻擊者攻擊過的網絡,輸出就可能是8。如下圖所示:

除此之外,人工智能可能被利用來編寫計算機病毒、木馬,原來的惡意腳本都是通過人手工編寫,人工智能技術可以使這些流程自動化,并通過插入對抗性樣本,繞過安全檢測[4];同樣,人工智能技術還可以自動化地生成智能僵尸網絡[5],這些網絡可以規模化、自動化地對其他系統進行攻擊,而不需要等待僵尸網絡控制者的命令,大大加劇了網絡攻擊的破壞程度。

2.數據安全風險

攻擊者可以通過網絡的內部參數逆向獲取網絡訓練的數據集[6];人工智能技術還會加強數據挖掘的能力,這加大了隱私泄露的風險,例如2018年3月的Facebook數據泄露事件。

3.算法安全風險

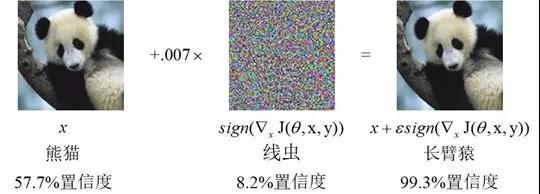

對于深度學習網絡目標函數定義的不準確、不合理或者不正確也可能會導致錯誤甚至傷害性的結果。錯誤的目標函數、計算成本太高的目標函數、表達能力有限的網絡都可能使網絡產生錯誤的結果。例如,2018年3月,Uber自動駕駛汽車因機器視覺系統未及時識別路上突然出現的行人,導致與行人相撞,導致行人死亡的事故。算法存在偏見與人工智能的不可解釋性也是一個重大的問題。之前美國利用人工智能算法預測犯罪的人,名單暴露,其中許多無辜的人被冤枉,并且被冤枉的人中大多數為黑人,并且對于決策算法中系統為什么做出這樣的決策,即使它的開發者也無法給出合理的解釋。對抗性樣本的出現也會使算法出現誤判的情況,如下圖中加入少量的噪聲,AI便將熊貓以很高的置信度識別成長臂猿。

4.信息安全風險

只要有足夠的訓練數據,人工智能就可以制作虛假的信息,用于不法活動。例如AI換臉技術DeepFakes,還有前段時間出現的DeepNude。一些不法分子利用虛假的語音與視頻來實施詐騙。目前谷歌發明的聊天機器人在與人進行電話聊天時,已經完全能騙過人類。

5.社會安全風險

這也是目前最熱、最有爭議的一個方面。首先,人工智能在不久的將來會取代很多崗位上的工人,這點從目前發展趨勢來看是正確的,如果相關崗位人員不學習新技能,就會面臨失業,從而導致嚴重的社會問題。其次,人工智能系統可能會危及到人類安全,由于技術的不成熟性,自動汽車、無人機等的一些行為可能會導致人類自身的安全風險。2016年特斯拉汽車無法識別藍天背景下的白色貨車導致車禍;2018年Uber自動汽車因機器視覺系統未及時識別路上突然出現的行人,與行人相撞導致行人死亡;近些年來,我國出現多起無人機干擾導致航班緊急迫降事件。另外,人工智能產品可能會對現有社會道德倫理產生沖擊[7]:1)AI算法存在偏見會影響社會的公平正義,例如,為何黑人的犯罪率就大大高于白人?2)AI算法缺乏道德規范約束,只知道達到自己的目的,而不會考慮別人的權益。例如,一些APP會利用人工智能系統根據用戶最近的一些活動自動向用戶發送短信推銷產品、做廣告,它無法保證其內容的真實性以及它的行為是否侵犯了用戶的某些權益。3) 假如人與人工智能出現類夫妻、父女等情感,將考問現代倫理規范。

6.國家安全風險

人工智能可用于影響公眾意識形態。例如美國大選時,對候選人通過點對點的虛假新聞推送,影響公眾意識形態來影響大選結果。人工智能還可用于構建新型軍事力量,如2018年8月委內瑞拉總統在公開活動中受到了無人機炸彈的轟炸,這是全球利用人工智能產品進行恐怖活動的首例。

人工智能作為引領未來的戰略性技術,已然成為了驅動社會各領域發展的重要引擎。然而,人工智能是一把“雙刃劍”,需要加強對安全風險的研究和預防,推動其在安全領域的應用,力圖在下一輪的人工智能發展浪潮中占得先機,贏得主動。為此,對于人工智能安全的發展有以下幾點建議:

1.加強技術應用研究,提升網絡空間安全防御能力

2.立法和技術研究并重,促進個人隱私安全管理

3.強化人工智能應用安全,規避人身安全風險

4.優化學科專業設置和在線培訓,降低社會失業風險

5.加強國際交流,共同應對安全風險。

參考文獻:

[1] Henry A. Kissinger. TheMetamorphosis.Technology[J],2019年8月刊.

[2]中國信息通信研究院.人工智能安全白皮書(2018年)[R].2018.

[3] Microsoft Research FacultySummit 2017 AI and Security[R].2017.

[4]Malwarebytes.當人工智能誤入歧途:將科幻小說與現實分離[R].2019.

[5] Ben Dickson.The securitythreats of neural networks and deep learning algorithms[C].2018.

[6] Chiyuan Zhang.Understandingdeep learning requires rethinking generalization[C].2017.

[7]劉詩瑤.人工智能或許對法律規范、道德倫理等產生沖擊[N].人民日報,2017-07-10.

【本文為51CTO專欄作者“中國保密協會科學技術分會”原創稿件,轉載請聯系原作者】