OpenAI前CTO Ilya推薦的30篇文章,認真讀完將理解當下90%的AI技術(12-27)

近日,網上流傳一份ilya推薦給John Carmack的閱讀清單,該清單包含了當今與AI相關27篇頂級文章,并稱如果真的將它們讀完,就能理解當下90%的AI技術。

下面剩余的文章速覽。

12)Deep Residual Learning for Image Recognition(深度殘差學習的圖像識別)

何凱明的大作,2016年CVPR最佳論文,深入淺出地描述了深度殘差學習框架,大幅降低了訓練更深層次神經網絡的難度,也使準確率得到顯著提升。

訓練更深層的神經網絡通常會面臨更多挑戰。為了解決這一難題,作者提出了一種殘差學習框架,目的在于簡化比以往使用的網絡深度更大的網絡的訓練過程。作者將每個層轉化為學習相對于其輸入的殘差函數,而非學習沒有參考基準的函數。作者提供了充分的實驗證據證明,這些殘差網絡更易于優化,并能從顯著增加的深度中獲得準確度的提升。作者在ImageNet數據集上評估了最高達152層深的殘差網絡——比VGG網絡深8倍,但復雜度卻更低。一組這樣的殘差網絡在ImageNet測試數據集上實現了3.57%的錯誤率,并憑借此成績獲得了ILSVRC 2015分類任務的冠軍。作者也對CIFAR-10進行了100層和1000層的殘差網絡分析。在許多視覺識別任務中,深度的表示至關重要。正是由于作者極其深入的表示方法,作者在COCO物體檢測數據集上實現了28%的相對性能提升。這些深層的殘差網絡構成了作者參加ILSVRC & COCO 2015比賽方案的基礎,作者在ImageNet檢測、ImageNet定位、COCO檢測和COCO分割等項目上均獲得了第一名。

地址:https://arxiv.org/pdf/1512.03385

13)MULTI-SCALE CONTEXT AGGREGATION BY DILATED CONVOLUTIONS(通過膨脹卷積進行多層次的上下文聚合)

最先進的語義分割模型是基于卷積網絡的適應性,而卷積網絡最初是為圖像分類而設計的。但是,語義分割這類密集預測問題的結構與圖像分類有顯著差異。在本項研究中,我們開發了一種全新的卷積網絡模塊,這個模塊是為密集預測任務量身打造的。這一模塊采用擴張卷積,能夠在不降低圖像分辨率的情況下,有效地整合多尺度的上下文信息。這種架構利用擴張卷積在保持原有分辨率和覆蓋范圍的同時,實現感受野的快速擴展。論文的結果證明了引入的上下文模塊提升了現有語義分割系統的準確度。此外,我們還探討了圖像分類網絡向密集預測任務的轉變,并發現簡化這些調整后的網絡能進一步提高其準確度。

地址:https://arxiv.org/pdf/1511.07122

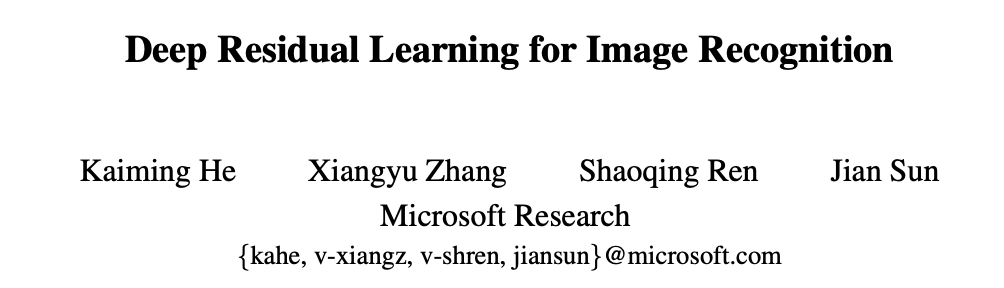

14)Neural Message Passing for Quantum Chemistry(量子化學中的神經消息傳遞)

論文總結整理了現有的幾種作者認為最具前景的適用于圖結構數據的神經網絡模型。提出一種針對圖數據結構的監督學習的通用框架,稱為消息傳遞的神經網絡(Message Passing Neural Networks ,MPNNs)。

地址:https://arxiv.org/pdf/1704.01212

15)NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE(神經機器翻譯的對齊與翻譯聯合學習)

這篇論文由 Bahdanau et al. 在 2014 年發表在國際會議 ICLR 上,是神經機器翻譯領域的開創性工作之一,提出了一種新穎的模型結構和訓練方法,使得神經網絡可以在翻譯過程中自動搜索和選擇源語言句子中與目標語言單詞相關的部分,并生成對齊結果。這種方法不僅提高了翻譯質量,而且產生了符合直覺的對齊結果。

地址:https://arxiv.org/pdf/1409.0473

16)Identity Mappings in Deep Residual Networks(深度殘差網絡中的恒等映射)

作者為殘差網絡的發明者何凱明博士,這一篇文章于同年投于2016 ECCV,深度殘差網絡已經嶄露頭角,成為一個深度架構家族,這個家族以其準確性和收斂性能吸引了人們的眼球。在這篇文章中,作者分析了構成殘差塊背后的傳播機制,這些分析表明,當使用恒等映射作為跳連(skip connetions ),并且在加法后加入激活函數時,前向和反向的信息傳遞可以直接從一個塊到達任何其他的塊。一系列的對比實驗證明了這些身份映射的重要性。這促使提出一個新的殘差單元,這個單元使得訓練過程更簡單,并且改善了模型的泛化能力。使用 1001 層的殘差網絡 (ResNet) 在 CIFAR-10 數據集(錯誤率為 4.62%)和 CIFAR-100 數據集上取得了更好的效果,同時作者也在 ImageNet 數據集上使用 200 層的 ResNet 模型獲得了改善的結果。

地址:https://arxiv.org/pdf/1603.05027

17)A simple neural network module for relational reasoning(一種用于關系推理的簡單神經網絡模塊)

為了更深入地探索關系推理的思想,并測試這種能力能否輕松加入目前已有的系統,DeepMind 的研究者們開發了一種簡單、即插即用的 RN 模塊,它可以加載到目前已有的神經網絡架構中。具備 RN 模塊的神經網絡具有處理非結構化輸入的能力(如一張圖片或一組語句),同時推理出事物其后隱藏的關系。

關系推理是通常智能行為的中心環節,但神經網絡要掌握這一能力歷來面臨挑戰。在本文中,作者展示了如何利用關系網絡 (RNs) 作為一種簡便的模塊,針對根本上需要關系推理的難題實現解決方案。作者將增強了 RN 的網絡應用于三大任務:第一個是使用一個挑戰性的數據集 CLEVR 來進行視覺問題解答,在哪里作者達到了超過人類表現的最先進水平;第二個是利用 bAbI 任務組合來進行文本問題解答;第三個任務是對動態物理系統進行復雜的推理分析。接著,作者用一個叫 Sort-of-CLEVR 的專門數據集來展示,盡管傳統的卷積網絡在解決關系型問題上并不擅長,但通過與 RN 的結合就能夠解鎖這項能力。作者的研究說明,一個自帶 RN 模塊的深度學習框架能如何隱式地識別并學習對實體及其關系進行推理。

地址:https://arxiv.org/pdf/1706.01427

18)VARIATIONAL LOSSY AUTOENCODER(變分有損自編碼器)

這篇論文成功地將自回歸模型和VAE模型結合起來,實現了生成任務。自回歸模型由于其強大的遞歸能力,能夠學習到數據的全局特征,擬合復雜的潛在分布。但是,VAE的訓練目標是高精度的密度估計(最大似然),這會導致VAE在訓練時為了有效擬合而忽略了一些潛在的表示(解碼時沒有用到全部編碼器給出的潛在表示)。論文從比特反轉編碼的角度分析了VAE網絡在面對復雜數據分布和靈活先驗分布時,容易出現潛在編碼z沒有被完全用于解碼的情況(也就是條件分布大多數直接被正則化項搞成接近先驗分布,只有少數被用于解碼,輸出數據和原始數據差異卻不大),并在此基礎上提出了VLAE網絡。

地址:https://arxiv.org/pdf/1611.02731

19)Relational recurrent neural networks(關系性循環神經網絡)

DeepMind和倫敦大學學院的這篇論文提出關系推理模塊RMC,能夠在序列信息中執行關系推理,在WikiText-103, Project Gutenberg 和 GigaWord 數據集上達到了當前最佳性能。

基于記憶的神經網絡模型利用其長時間保存信息的功能來處理時間序列數據。但是,目前還不明確這些網絡是否具備利用記憶執行復雜關系推理的能力。首先,驗證了一個觀點:標準的記憶結構在需要深刻理解實體間連接方式的任務上,也就是涉及關系推理的任務,可能會面臨挑戰。為了克服這些缺陷,引入了一種新型的記憶模塊——關系記憶核心(Relational Memory Core, RMC),該模塊使用多頭點積注意力機制使得不同記憶間能夠進行互動。最后,作者在一系列能夠從更加精細的關系推理中獲益的任務上測試了RMC,包括RL領域(如 Mini PacMan)、程序評估和語言模型等任務,并獲得顯著提升,在WikiText-103、Project Gutenberg 和 GigaWord 數據集上取得了前所未有的成果。

地址:https://arxiv.org/pdf/1806.01822

20)Quantifying the Rise and Fall of Complexity in Closed Systems: The Coffee Automaton(量化封閉系統中復雜性的升降:咖啡自動機)

與單調遞增的熵不同,封閉系統的“復雜性”或“興趣度”直觀上呈現先增加后減少的趨勢,特別是當系統接近平衡狀態時。舉個例子,在大爆炸期間我們的宇宙缺乏復雜結構,當黑洞蒸發和粒子分散之后也是如此。本篇論文首次嘗試對這一模式進行度量。作者選用了一個簡單的二維細胞自動機模型來模擬兩種液體(“咖啡”與“奶油”)的混合過程。然后,作為一個合理的復雜性衡量方法,我們據此提出了自動機狀態的粗糙度近似的“Kolmogorov復雜度”,命名為“結構復雜性”。我們研究了這種復雜性衡量方法,并通過分析展示,如果液體粒子不相互作用,其復雜性將不會顯著增加。相反,如果粒子相互作用,我們通過數值證據展示,復雜性會達到一個最大值,與“咖啡杯”的橫向尺寸大致相當。作者提出了一個挑戰,即解析性證明這種行為的存在。

地址:https://arxiv.org/pdf/1405.6903

延伸閱讀:美與結構的復雜性(https://zhuanlan.zhihu.com/p/87743946)

21)Neural Turing Machines(神經圖靈機)

神經圖靈機(Neural Turing Machines)是一種結合了神經網絡和圖靈機概念的深度學習算法。論文中作者增強了神經網絡的能力,使其能與外部存儲資源結合,通過注意力機制進行互動。這樣的系統與圖靈機或馮·諾伊曼架構有類似之處,但整個系統可進行端到端的微分,這意味著可以用梯度下降法有效訓練。初步研究結果顯示,神經圖靈機能夠根據給定的輸入輸出樣例推導出一些簡單的算法,比如復制、排序和關聯記憶。

地址:https://arxiv.org/pdf/1410.5401

22)Deep Speech 2: End-to-End Speech Recognition in English and Mandarin( 英語與普通話的端到端語音識別)

該論文由百度研究院硅谷人工智能實驗室發表,作者展示了一個端到端的深度學習方法能夠識別英語和普通話——兩種迥然不同的語言。通過用神經網絡取代了之前需要人工搭建的復雜組件,端到端學習使作者得以處理各種各樣的語音場景,包括噪聲環境、不同的口音,以及多種語言。關鍵在于采用了高性能計算 (HPC) 技術,讓系統速度比之前快了7倍 。得益于這種效率,原本需要幾周才能完成的實驗現在幾天內就能搞定。這使得能夠更迅速地試驗,并找到更優秀的架構和算法。因此,系統在多種情況下可以在標準數據集基準上達到能與人類轉錄員媲美的水平。最后,通過在數據中心的 GPU 上使用一種叫做的 Batch Dispatch 的技術,這表明其系統可以并不昂貴地部署在網絡上,并且能在為用戶提供大規模服務時實現較低的延遲。

地址:https://arxiv.org/pdf/1512.02595.pdf

23)Scaling Laws for Neural Language Model(神經大語言模型的規模化定律)

OpenAI大模型經典論文,我們探究了影響語言模型在交叉熵損失方面性能的規律。根據我們的發現,模型的大小、所用數據集的范圍以及訓練所需的計算資源會影響損失情況,并且這種影響能在很大程度上(超過七個數量級)變動。而模型的網絡寬度或深度等其他構造細節在較大的范圍內的影響卻微乎其微。作者還發現簡單的公式可以描述模型或數據量大小如何影響過擬合程度,以及模型大小如何影響訓練速度。借助這些關系,我們可以為有限的計算資源做出最優分配。更大的模型能夠更有效地利用樣本,因此,在有限的數據量上訓練大型模型,并在模型完全擬合前提前停止,將是一種高效的計算方法。

其提出了兩個核心結論:

1.LLM模型的性能主要與計算量C,模型參數量N和數據大小D三者相關,而與模型的具體結構 (層數/深度/寬度) 基本無關。三者滿足: C ≈ 6ND

2.為了提升模型性能,模型參數量N和數據大小D需要同步放大,但模型和數據分別放大的比例還存在爭議。

地址:https://arxiv.org/pdf/2001.08361

24)A Tutorial Introduction to the Minimum Description Length Principle(最小描述長度原則介紹)

該論文提供了最小描述長度(MDL)原則的教程介紹,MDL是一種用于模型選擇和數據壓縮的原則。

地址:https://arxiv.org/pdf/math/0406077

25)Machine Super Intelligence(機器超級智能)

DeepMind 聯合創始人、首席科學家。他在 2008 年發表的博士論文,被認為是最早系統探討機器超級智能(AGI)的學術文章之一,該論文為后續相關研究奠定了基礎。他在對 80 種不同文化中的對“智能( Intelligence)”的研究基礎上, 將“智能”總結為“能夠在廣泛的問題中表現優異的能力”,并給出了一套可工程化的量化標準。基于他的研究至少有了一個如何將人類智能總結、轉化為算法結構的假設,智能成為了一個可被解決的問題。

地址:https://www.vetta.org/documents/Machine_Super_Intelligence.pdf

26)Kolmogorov Complexity and Algorithmic Randomness(Kolmogorov復雜性與算法隨機性)

本書由American Mathematical Society出版,作者是A. Shen,V. A. Uspenskii,N. K. Vereshchagin。該書介紹了 Kolmogorov 復雜性理論及其在算法隨機性中的應用,提供了對計算復雜性和隨機性深入理解的理論基礎。為了進行無監督學習,在OpenAI成立早期,他們認為通過壓縮可以通向這一路徑。隨后,他們發現“預測下一個詞元(token)”正是無監督學習可以追求的目標,并且意識到,預測就是壓縮。這也正是后來ChatGPT成功的關鍵思想之一。

地址:https://www.lirmm.fr/~ashen/kolmbook-eng-scan.pdf

27)CS231n Convolutional Neural Networks for Visual Recognition(用于視覺識別的卷積神經網絡)

地址:https://cs231n.github.io/

本文轉載自 ??AI工程化??,作者: ully