快手12篇論文入選CVPR 2025!

CVPR(IEEE Conference on Computer Vision and Pattern Recognition)是國際計算機視覺和模式識別領域的頂級學術會議之一。CVPR 2025 將于 6 月 11 日至 6 月 15 日在美國田納西州納什維爾舉辦,本屆共收到了 13,008 篇有效論文提交,最終有 2,878 篇被接收,整體錄用率約為 22.1%。其中,快手共有 12 篇論文入選 CVPR2025,涵蓋視頻質量評估、多模態數據集構建與基準測試、動態 3D 頭像重建、動態 4D 場景模擬、視頻生成與增強技術、可控視頻生成與編輯等多個方向(排名不分先后)。

美國當地時間 6 月 11 日,快手可靈 AI 事業部,視覺生成與互動中心負責人萬鵬飛受邀到《From Video Generation to World Models》分享快手可靈大模型在視頻生成技術領域的最新突破與前沿進展!

論文精選

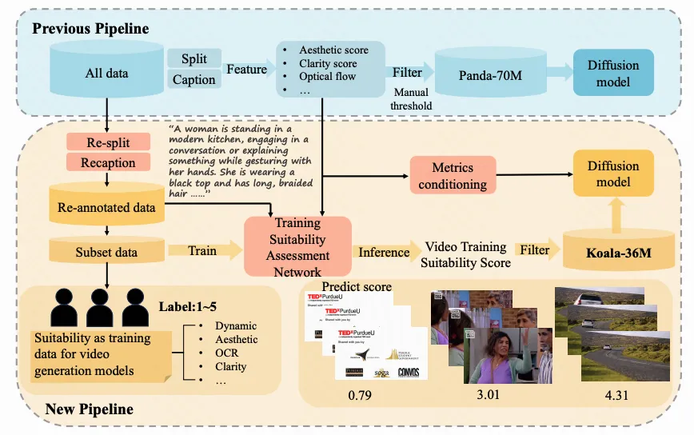

論文 01:Koala-36M: A Large-scale Video Dataset Improving Consistency between Fine-grained Conditions and Video Content

| 項目地址:??https://koala36m.github.io/??

| 論文地址:??https://arxiv.org/pdf/2410.08260??

| 論文簡介:

隨著視覺生成技術的不斷進步,視頻數據集的規模呈指數級增長,而這些數據集的質量對視頻生成模型的性能至關重要。我們認為,時間分割、詳細字幕和視頻質量過濾是決定數據集質量的三個關鍵因素。然而,現有數據集在這些方面存在諸多不足。為了解決這些問題,我們推出了 Koala-36M,這是一個大規模且高質量的視頻數據集,具備準確的時間分割、詳細的字幕和卓越的視頻質量。我們的核心方法在于提高細粒度條件與視頻內容之間的一致性。具體而言,我們使用線性分類器對概率分布進行分析,以提高過渡檢測的準確性,從而確保更好的時間一致性。接著,我們為分割后的視頻提供結構化的字幕,平均長度為 200 字,以改善文本與視頻的對齊。此外,我們開發了視頻訓練適用性評分(VTSS),整合多個子指標,幫助我們從原始語料庫中篩選出高質量視頻。最后,我們在生成模型的訓練過程中引入多個指標,進一步優化細粒度條件。實驗結果表明,我們的數據處理流程有效提升了數據集的質量,證明了 Koala-36M 數據集的優越性。

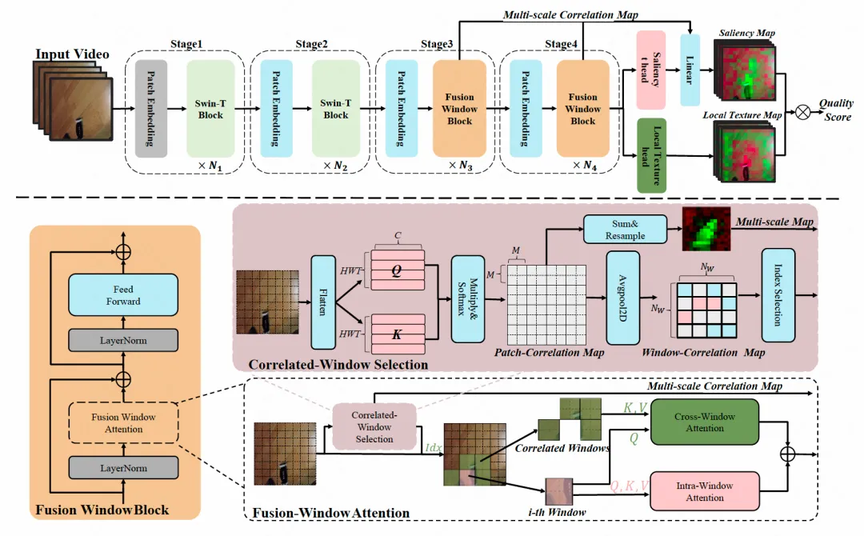

論文 02:KVQ: Boosting Video Quality Assessment via Saliency-guided Local Perception

| 論文地址:??https://arxiv.org/abs/2503.10259??

| 論文簡介:

視頻質量評價旨在預測視頻的感知質量,隨著流媒體平臺的發展,近年來受到了越來越多的關注。由于運動模糊、特定失真等因素的影響,視頻中不同區域的質量存在差異。識別視頻中各區域的局部質量,不僅有助于整體質量的評估,還能為精細化的視頻增強或編碼呀策略提供指導。然而,區域級質量的標注成本較高,并且相關數據集中缺乏真實標簽,這進一步增加了局部感知在實際應用中的難度。受人類視覺系統啟發,我們提出了一種針對多樣視頻的質量評價算法 KVQ(Kuaishou Visual Quality)。該框架旨在有效評估顯著性和局部紋理,從而更好地輔助整體質量的判斷。KVQ 框架通過融合窗口注意力機制提取視覺顯著性并分配注意力,同時引入局部感知約束,以減少區域紋理感知對鄰域信息的依賴。在五個主流 VQA 基準數據集上的多種評估場景中,KVQ 在性能上均顯著優于當前最先進的方法。此外,為了更好地評估局部感知能力,我們還構建了一個具有區域級標注的新數據集 LPVQ。實驗結果表明,KVQ 在識別局部失真方面表現出色。

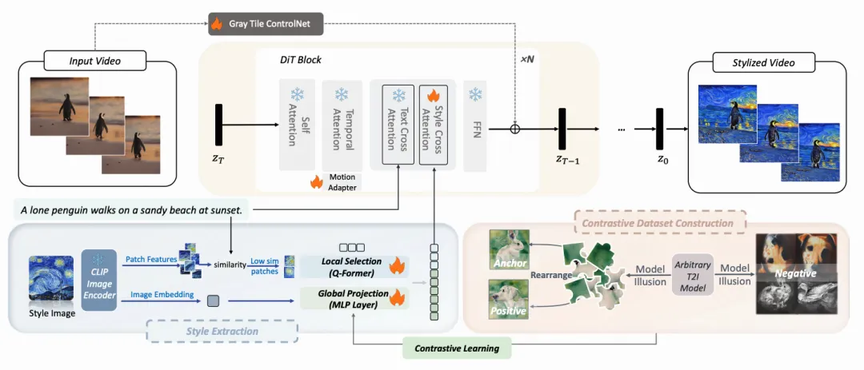

論文 03:StyleMaster: Stylize Your Video with Artistic Generation and Translation

| 論文地址:??https://arxiv.org/pdf/2412.07744??

| 論文簡介:

在視頻生成模型中,風格控制一直備受關注。然而,現有方法常常生成與給定風格相去甚遠的視頻,導致內容泄漏,并且在將一個視頻轉換為所需風格時表現不佳。我們的首要觀察是,風格提取階段至關重要,而現有方法往往強調全局風格卻忽視了局部紋理。為了在引入紋理特征的同時防止內容泄漏,我們基于提示詞-圖像塊的相似性過濾掉與內容相關的圖像塊,同時保留風格相關的塊;在全局風格提取方面,我們通過模型幻覺生成配對風格數據集,并用對比學習的方式增強了提取風格的一致性。此外,為了彌合圖像到視頻的差距,我們在靜態視頻上訓練了一個輕量級運動適配器,這在隱式上增強了風格化程度,并使我們用圖像訓練的模型能夠無縫的應用于生成視頻。得益于這些改進,我們的方法 StyleMaster 不僅在風格相似性和時間一致性方面取得了顯著提升,還可以通過 ControlNet 推廣應用到視頻風格遷移。大量實驗和可視化結果表明,StyleMaster 顯著優于競爭對手,能夠有效生成與文本內容一致且與參考圖像風格高度相似的高質量風格化視頻。

論文 04:Towards Precise Scaling Laws for Video Diffusion Transformers

| 論文地址:??https://arxiv.org/pdf/2411.17470??

| 論文簡介:

鑒于視頻擴散 Transformer 的訓練成本極為高昂,在有限的數據和計算預算下實現最優性能尤為關鍵。為此,我們需要在大規模訓練開始前,精確確定最佳的模型規模與訓練超參數配置。盡管規模定律(scaling laws)已應用于語言模型的性能預測,但其在視覺生成模型中的存在性與準確推導仍待探索。本文系統分析了視頻擴散 Transformer 的規模定律并證實其存在性。更重要的是,我們發現:與語言模型不同,視頻擴散模型對學習率和批量大小這兩個通常未被精確建模的超參數更為敏感。為此,我們提出新型規模定律,可預測任意模型規模與計算預算下的最優超參數配置。實驗表明,在 1e10 TFlops 的計算約束下,采用本方法優化的模型在保持同等性能水平的同時,推理成本較傳統方法降低 40.1%。更重要的是,我們建立了驗證損失、任意模型規模與計算預算三者間更廣義且精確的數學關系,這使得針對實際推理成本約束下可能采用的次優模型規模也能進行性能預測,從而實現更優的權衡取舍。

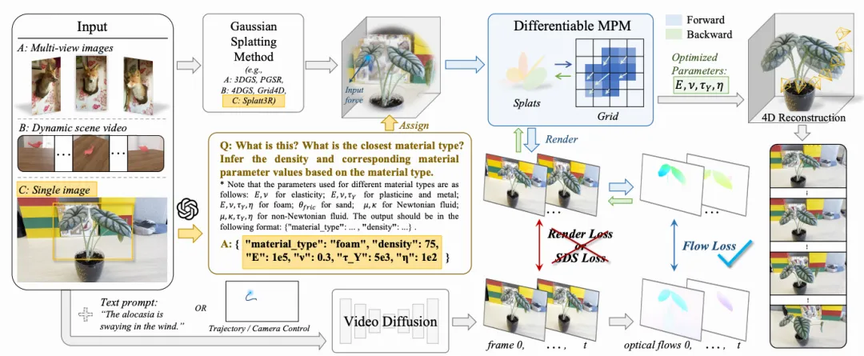

論文 05:Unleashing the Potential of Multi-modal Foundation Models and Video Diffusion for 4D Dynamic Physical Scene Simulation

| 論文地址:??https://arxiv.org/pdf/2411.14423??

| 論文簡介:

要實現動態場景的真實模擬,必須準確捕捉多樣化的材質屬性,并基于物理原理對復雜物體交互進行精確建模。然而,現有方法通常局限于少數基礎材質類型,其可預測參數有限,難以真實反映現實世界中材質的復雜性。為此,我們提出了一種創新方法——PhysFlow,它通過融合多模態基礎模型與視頻擴散技術,實現了更強大的 4D 動態場景模擬能力。該方法利用多模態模型識別材質類型并通過圖像查詢初始化材質參數,同時推斷 3D 高斯潑濺點以構建精細場景表征。我們進一步采用基于可微分物質點法(MPM)和光流引導的視頻擴散技術優化材質參數,而非依賴渲染損失或分數蒸餾采樣(SDS)損失。這一融合框架能夠精準預測真實場景中的動態交互并實現逼真模擬,從而在基于物理的仿真中提高了準確性與靈活性。

論文 06:CoMM: A Coherent Interleaved Image-Text Dataset for Multimodal Understanding and Generation

| 論文地址:??https://arxiv.org/abs/2406.10462??

| 論文簡介:

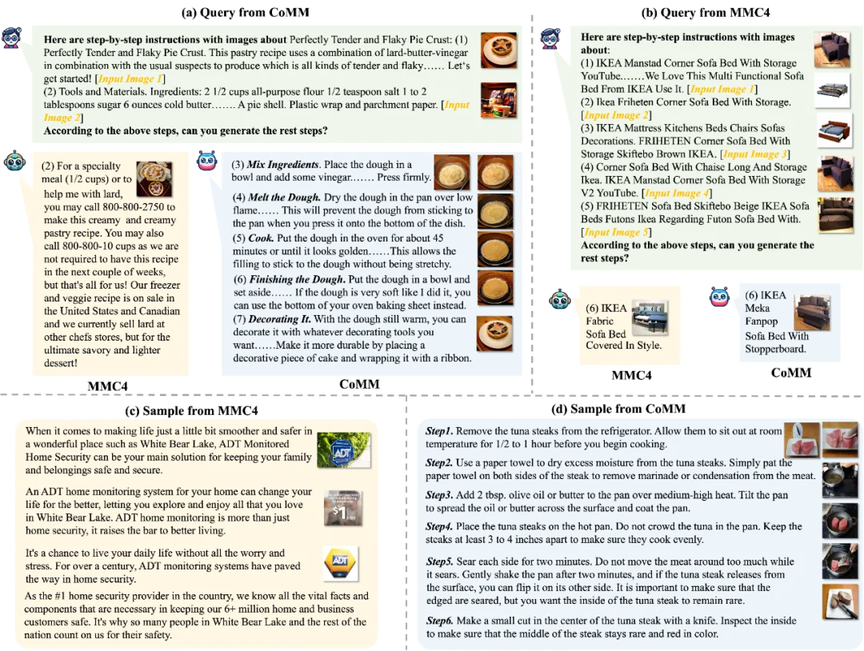

交錯圖文生成已成為一項關鍵的多模態任務,其目標是根據用戶問題生成視覺與文本內容交織的序列。近年來,多模態大語言模型(MLLMs)取得了顯著進展,但由于訓練數據質量不足,生成具有敘事連貫性、實體與風格一致性的圖文交織序列仍存在挑戰。圍繞這一方向,我們提出了 CoMM——一種高質量的交錯圖文多模態數據集,旨在提升生成內容在連貫性、一致性及圖文對齊性上的表現。CoMM 最初從多樣化的來源獲取原始數據,重點關注教學內容和視覺敘事,為連貫一致的內容奠定基礎。為進一步提高數據質量,我們設計了一種多視角過濾策略,利用先進的預訓練模型來確保文本發展性、插入圖像的一致性以及它們之間的語義匹配。各種質量評估指標被設計用來證明經過過濾的數據集的高質量。同時,在各種下游任務上的廣泛少樣本實驗表明,CoMM 在顯著增強 MLLMs 的上下文學習能力方面效果顯著。此外,我們提出了四項新任務以支持全面評估 MLLMs 的交錯生成能力。

論文 07:Libra-Merging: Importance-redundancy and Pruning-merging Trade-off for Acceleration Plug-in in Large Vision-Language Model

| 論文地址:??https://cvpr.thecvf.com/virtual/2025/poster/34817??

| 論文簡介:

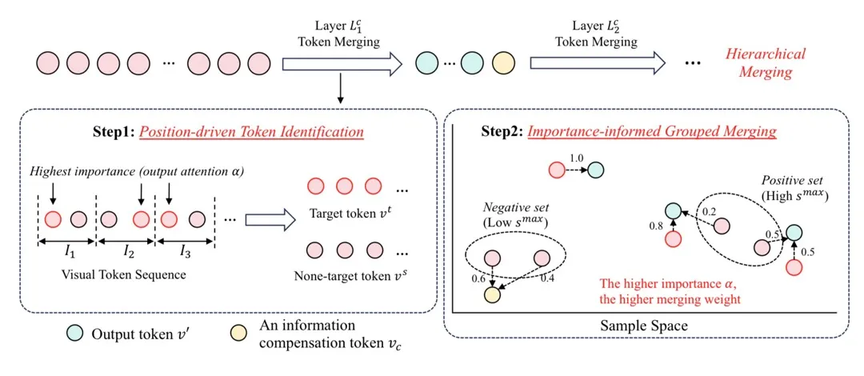

隨著大型視覺語言模型(LVLM)的迅猛發展,其高昂的計算成本已成為制約實際應用的關鍵瓶頸。現有的視覺標記壓縮方法主要面臨兩大核心挑戰:如何在目標標記識別中平衡重要性和冗余性,以及如何權衡標記壓縮過程中剪枝與合并。為應對這些挑戰,我們提出了一種創新性的視覺標記壓縮方案——Libra-Merging。該方案的創新點體現在以下兩個方面:

- 引入了一種位置驅動的標記識別機制,能夠在重要性和冗余性之間實現更優的權衡;

- 采用了一種基于重要性引導的分組合并策略,能夠在保留關鍵信息的同時有效避免目標標記的失真,從而平衡壓縮過程中的剪枝與合并。

實驗結果表明,在 LLaVA 系列模型上,該方法可將推理計算量(Flops)降低至原量的 37%,且性能無明顯下降。此外,在視頻理解任務中,在保持性能穩定的同時,減少了 57%GPU 訓練時間。值得一提的是,作為即插即用模塊,Libra-Merging 不僅適用于多種 LVLM 模型,而且在所有測試模型中均展現出顯著的加速效果。

論文 08:GPAvatar: High-fidelity Head Avatars by Learning Efficient Gaussian Projections

| 論文簡介:

現有的基于輻射場的頭像方法通常依賴于預先計算的顯式先驗(例如網格、點)或神經隱式表示,這使得在實現高保真度的同時兼顧計算效率和低內存消耗變得具有挑戰性。為了解決這一問題,我們提出了 GPAvatar,這是一種新穎且高效的基于高斯點繪制的方法,用于從單目視頻中重建高保真的動態 3D 頭像。我們將 3D 空間中的高斯擴展到一個高維嵌入空間,該空間包含高斯的空間位置和頭像表情,從而能夠表示具有任意姿勢和表情的頭像。為了實現基于點繪制的光柵化,我們學習了一種線性變換,將每個高維高斯投影回 3D 空間,這足以捕捉表情變化,而無需使用復雜的神經網絡。此外,我們提出了一種自適應加密策略,動態地將高斯分配到表情變化較大的區域,從而改善面部細節的表示。實驗結果表明,在三個數據集上,我們的方法在渲染質量和速度上優于現有的最先進方法,同時減少了訓練和渲染中的內存使用。

論文 09:PatchVSR: Breaking Video Diffusion Resolution Limits with Patch-wise Video Super-Resolution

| 論文地址:

| 論文簡介:

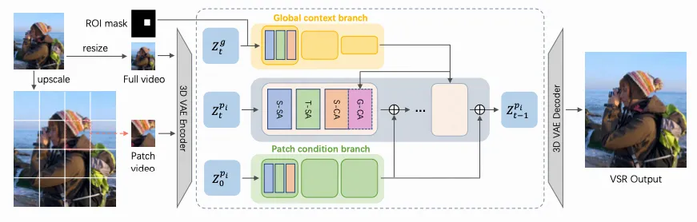

預訓練的視頻生成模型在視頻超分辨率(VSR)任務中展現出巨大潛力,但現有方法在應用于全尺寸 VSR 時仍面臨兩大關鍵限制:一是密集全注意力計算帶來的過高計算開銷,二是固定輸出分辨率導致的靈活性不足。為了突破這些限制,我們首次探索了基于視頻擴散先驗的逐塊超分辨率方法。然而,這一探索面臨顯著挑戰——預訓練的視頻擴散模型并不天然具備塊級細節生成能力。為此,我們提出了一種創新解決方案 PatchVSR,其核心是雙流適配器架構。該架構通過兩個并行的特征提取分支實現條件引導:塊分支專注于從輸入塊中提取局部特征以保持內容保真度,而全局分支則通過處理調整尺寸后的完整視頻來捕獲上下文語義信息,從而有效彌補由塊邊界導致的語義不完整性。我們還創新性地引入了塊位置編碼機制,將每個塊的空間位置信息顯式注入模型,使塊合成過程能夠更好地融入全局視頻幀的上下文環境。實驗驗證表明,PatchVSR 能夠高效生成塊級的高保真細節。為確保多塊增強后的視覺一致性,我們專門設計了多塊聯合調制策略。得益于塊式處理的靈活性,我們的方法能夠基于 512×512 分辨率的基礎模型實現極具競爭力的 4K 超分辨率效果,同時保持顯著的計算效率優勢。這一突破為高分辨率視頻增強提供了新的技術路徑。

論文 10:SeriesBench: A Benchmark for Narrative-Driven Drama Series Understanding

| 論文地址:??https://stan-lei.github.io/KwaiMM-Dialogue/paper2-seriesbench.html??

| 論文簡介:

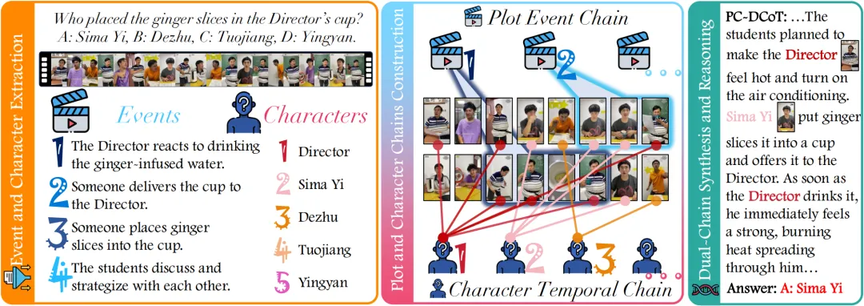

隨著多模態大語言模型(MLLMs)的快速發展,VideoQA 能力得到大幅度提升。然而,現有任務主要關注獨立視頻片段的 VideoQA 任務,且側重于評估"視覺元素"如人類行為和物體狀態。事實上,現代視頻、直播往往包含復雜連續的敘事結構,通常以系列劇集形式呈現。為應對這一挑戰,我們圍繞多視頻 VideoQA 任務場景提出了 SeriesBench 基準測試——由 105 個精心策劃的敘事驅動系列視頻組成,涵蓋 28 個需要深度敘事理解的專業任務。我們圍繞多視頻 VideoQA 任務提出了創新的敘事推理框架 PC-DCoT。在 SeriesBench 上的大量實驗結果表明,PC-DCoT 能帶來顯著效果提升。

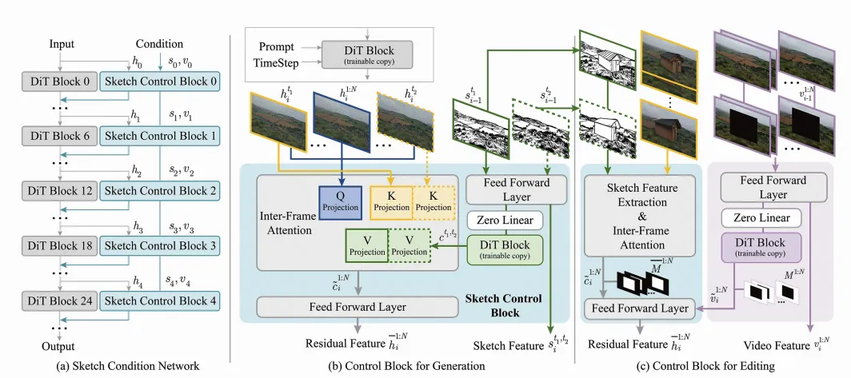

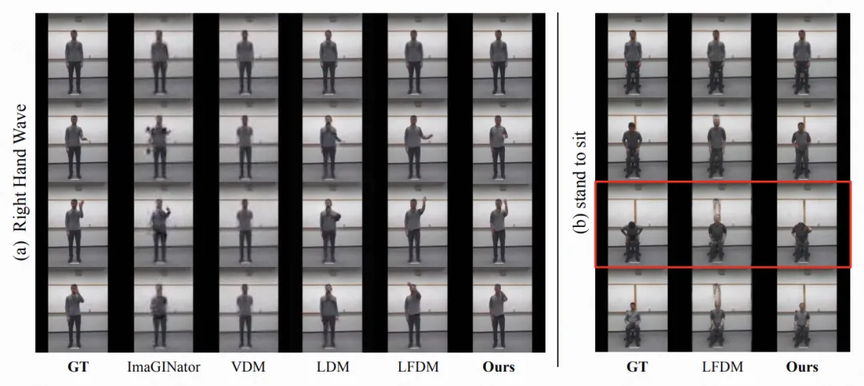

論文 11:SketchVideo: Sketch-based Video Generation and Editing

| 項目地址:??http://geometrylearning.com/SketchVideo/??

| 論文地址:??https://arxiv.org/pdf/2503.23284??

| 論文簡介:

基于文本提示或圖像的視頻生成與編輯技術已取得顯著進展,然而僅通過文本精確控制全局布局與幾何細節仍存在挑戰,同時通過圖像實現運動控制與局部修改也有待突破。本文旨在實現基于草圖的空間與運動控制視頻生成,并支持對真實或合成視頻的細粒度編輯。我們在 DiT 視頻生成模型基礎上,提出了一種內存高效的控制結構,通過草圖控制模塊預測跳躍式 DiT 塊的殘差特征。用戶可在任意時間點的一至兩幀關鍵幀上進行草圖繪制以簡化交互。為將此類時間稀疏的草圖條件傳播至所有幀,我們提出跨幀注意力機制來分析關鍵幀與各視頻幀的關聯。針對基于草圖的視頻編輯,我們額外設計了視頻插入模塊,確保新編輯內容與原始視頻的空間特征及動態運動保持連貫。推理階段采用潛在融合技術以實現未編輯區域的精準保留。大量實驗表明,本研究的 SketchVideo 系統在可控視頻生成與編輯方面展現出卓越性能。

論文 12:STDD: Spatio-Temporal Dual Diffusion for Video Generation

| 論文地址:??https://cvpr.thecvf.com/virtual/2025/poster/35022??

| 論文簡介:

擴散概率模型正逐漸成為數據生成的基石,尤其在高質量圖像生成領域表現突出。作為其擴展,視頻擴散生成亟需一種具有原則性的時間序列擴散方法,而現有視頻擴散方法主要聚焦于空間域擴散。本研究提出一種顯式的時空雙重擴散方法(STDD),通過將標準擴散模型擴展為時空聯合擴散模型,實現空間域與時間序列的聯合信息傳播與消減。從數學角度推導出具有可解析特性的雙擴散過程,該過程能夠在時序累積信息的同時兼顧空間域特征。相應地,我們理論推導了時空概率反向擴散過程,并提出加速采樣策略以降低推理成本。該時空雙重擴散機制使前一幀信息能夠傳遞至當前幀,從而有效提升視頻內容的時序一致性。大量實驗表明,所提出的 STDD 方法在視頻生成/預測以及文本到視頻生成任務中展現出優于現有最優方法的性能。

結語

作為一家以人工智能為核心驅動力和技術依托的科技公司,快手致力于持續深化研發投入,將技術打造為驅動業務增長的強勁引擎。同時,公司將在人工智能領域不斷探索,積極推動前沿技術在業務場景中的落地應用。欲獲取相關論文的詳盡內容與深度解讀,敬請關注快手技術公眾號的后續更新。