深入探索個性化推薦新境界:AI通過語言理解你的喜好,效率提升131%

深入探索個性化推薦新境界 ——《Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation》論文解讀

在個性化推薦系統的構建中,如何快速準確地識別用戶偏好始終是一個挑戰。特別是在冷啟動情境下,缺乏用戶歷史數據使得這一任務更為艱巨。《Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation》這篇論文為我們提供了一種新穎的解決方案,通過結合貝葉斯優化和大型語言模型(LLM),在自然語言處理(NLP)的框架下進行有效的用戶偏好激發(PE)。David Eric Austin與Anton Korikov等研究者們提出的PEBOL算法,利用自然語言推理(NLI)技術來維持對用戶偏好的信念,并采用決策理論策略,如湯普森采樣(TS)和置信上界(UCB),來指導語言模型查詢的生成。這一方法在冷啟動自然語言偏好激發對話中展現出顯著的性能提升,相較于傳統的單一大型語言模型,PEBOL在10輪對話后實現了高達131%的準確率提升。 通過這篇文章,您將獲得:

- 前沿技術:了解如何利用最新的貝葉斯優化和LLM技術來提升推薦系統的個性化水平。

- 實際應用:探索PEBOL算法如何在沒有用戶歷史數據的情況下,通過自然語言對話快速識別用戶偏好。

- 性能對比:見證PEBOL與傳統方法在偏好激發任務中的性能差異,以及它是如何在對話中動態平衡探索與利用的。加入我們,一起揭開個性化推薦系統新篇章的序幕,探索如何通過技術創新提升用戶體驗。

引言:探索自然語言偏好獲取的新方法

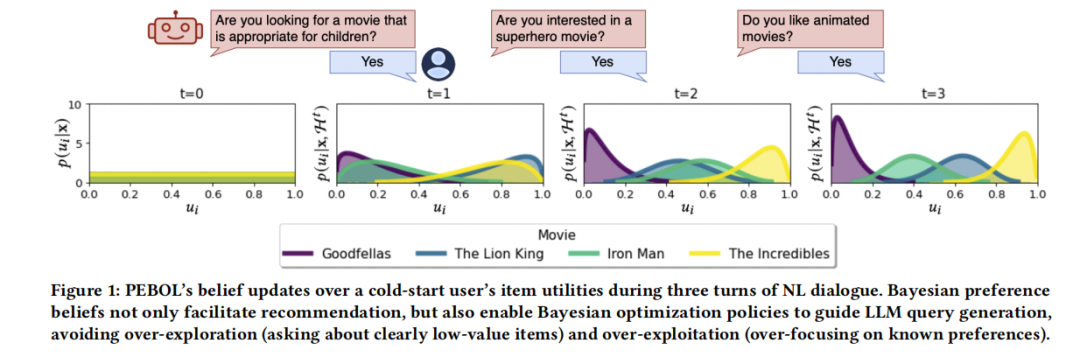

在個性化推薦系統中,如何高效地從用戶的自然語言(NL)描述中獲取其偏好,是一個長期而復雜的問題。傳統的偏好獲取(PE)方法,如貝葉斯優化和多臂老虎機,通常依賴于用戶對項目的直接評分或比較,這在用戶對大多數項目不熟悉的情況下顯得尤為困難。隨著大型語言模型(LLM)的發展,我們有了通過自然語言對話進行偏好獲取的技術基礎,但這些模型在進行策略性的多輪對話查詢時往往能力有限,難以有效平衡探索與利用,可能導致過度關注已揭示的偏好或低效探索低價值項目。

本文介紹了一種新的自然語言偏好獲取方法——PEBOL(偏好獲取與貝葉斯優化增強的LLM),它通過自然語言推理(NLI)來推斷項目偏好,并利用基于決策理論的獲取函數來指導查詢生成,從而在自然語言對話中有效地學習用戶的首選項目。這一方法不僅提高了偏好獲取的效率,還通過貝葉斯優化形式化地處理了未知的用戶偏好,為自然語言偏好獲取領域提供了新的研究框架和方向。

論文標題:Bayesian Optimization with LLM-Based Acquisition Functions for Natural Language Preference Elicitation

機構:University of Toronto, Ontario, Canada; University of Waterloo, Ontario, Canada

論文鏈接:https://arxiv.org/pdf/2405.00981.pdf

PEBOL算法介紹:結合貝葉斯優化與大語言模型

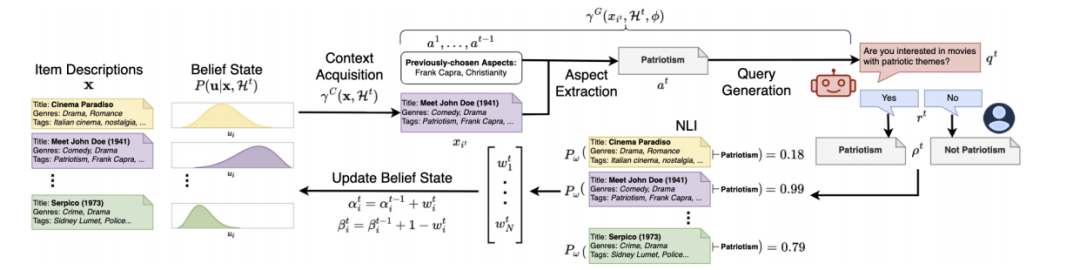

PEBOL(Preference Elicitation with Bayesian Optimization augmented LLMs)是一種新穎的自然語言偏好詢問(NL-PE)算法,它通過結合貝葉斯優化和大型語言模型(LLM)來推斷用戶的物品偏好。這種方法首先利用自然語言推理(NLI)在對話話語和物品描述之間進行推斷,以維護貝葉斯偏好信念;其次,引入基于LLM的獲取函數,其中自然語言(NL)查詢生成由決策理論策略如湯普森采樣(Thompson Sampling, TS)和置信上界(Upper Confidence Bound, UCB)指導,以平衡探索和利用偏好信念。

1. 貝葉斯優化與決策理論的結合

PEBOL算法將貝葉斯優化的原理應用于NL-PE場景中,通過維護對用戶偏好的概率信念來指導查詢的生成。這種方法不僅考慮了用戶的直接反饋,還通過NLI模型解析用戶在自然語言交互中的隱含偏好。

2. LLM的應用與優化

在PEBOL中,LLM用于生成針對特定物品描述的查詢,這些查詢旨在通過詢問用戶對某些特征的偏好來揭示用戶的興趣。例如,系統可能會詢問用戶是否喜歡具有“愛國主義”主題的電影。此外,LLM在每一輪對話中都會根據當前的貝葉斯信念狀態,選擇性地引入新的物品描述,以優化查詢的相關性和效率。

實驗設計與方法

為了評估PEBOL算法的有效性,我們設計了一系列控制實驗,通過模擬的NL-PE對話在多個自然語言物品數據集上測試算法的表現,并與單體GPT-3.5 NL-PE方法進行比較。

1. 實驗設置

實驗通過模擬用戶與系統的交互來進行,其中用戶的偏好被系統未知,系統需要通過連續的對話輪次來逐步學習和推斷這些偏好。每個實驗模擬100個用戶,每個用戶偏好一個特定物品,系統的目標是在對話中盡可能準確地識別出這些物品。

2. 數據集與模擬用戶

我們使用三個真實世界的數據集:MovieLens 25M、Yelp和Recipe-MPR。這些數據集提供了豐富的物品描述,包括電影標題、餐廳描述和食譜信息,適合用于測試NL-PE系統的性能。

3. 性能評估

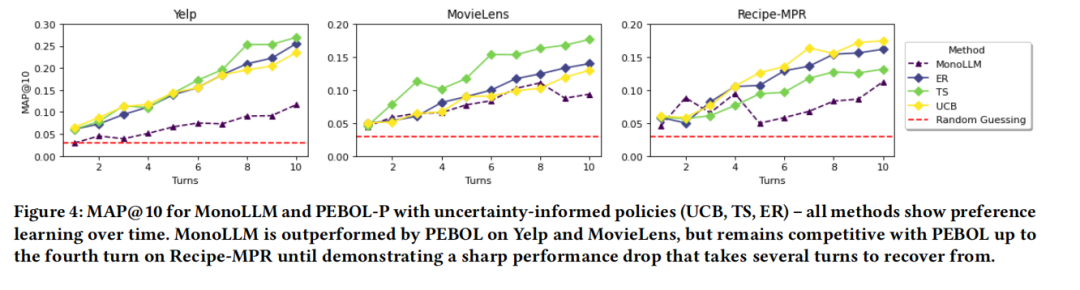

系統的性能通過多種指標評估,包括在10輪對話后的平均精確率(MAP@10)。此外,我們還考察了系統在不同用戶噪聲水平下的表現,以及不同獲取策略(如TS、UCB和熵減)對性能的影響。

通過這些實驗,我們能夠詳細了解PEBOL算法在實際NL-PE場景中的應用效果,以及與現有技術相比的優勢和潛在的改進方向。

實驗結果與分析

在對PEBOL(使用貝葉斯優化增強的LLM進行偏好詢問)與傳統的單體GPT-3.5 NL-PE方法的比較中,我們通過控制的NL-PE對話實驗,對多個NL項目數據集和用戶噪聲水平進行了數值評估。實驗結果顯示,在10輪對話后,PEBOL在MAP@10(最大平均精度@10)指標上相比GPT-3.5實現了高達131%的提升,盡管PEBOL使用的是一個較小的400M NLI模型進行偏好推斷。

通過實驗,我們觀察到PEBOL在不同數據集上的表現均優于MonoLLM。在Yelp數據集上,PEBOL的MAP@10提升了131%,在MovieLens上提升了88%,在RecipeMPR上提升了55%。這一結果表明,PEBOL的增量貝葉斯更新機制可能使其不太容易犯下災難性的錯誤。

此外,我們還研究了二元響應與概率響應的PEBOL表現(PEBOL-B與PEBOL-P)。總體來看,PEBOL-P的表現更佳,這可能是因為PEBOL-B丟棄了來自蘊含概率的寶貴信息。特別是在MovieLens數據集上,從第二輪開始,概率蘊含的MAP提升至少為34%,盡管在Yelp上,使用二元更新的TS與最佳概率方法表現相當。

討論PEBOL的優勢與局限

優勢:

- 效率提升:PEBOL在多輪對話中顯著提高了推薦的準確性,特別是在處理大量數據集時,與傳統的單體LLM方法相比,顯示出更快的學習和適應用戶偏好的能力。

- 探索與利用的平衡:通過貝葉斯優化策略,PEBOL能夠有效地平衡探索和利用,減少了在已知偏好上的過度聚焦(過度利用)和在低價值項目上的資源浪費(過度探索)。

- 對話歷史的有效利用:PEBOL通過跟蹤對話歷史來避免重復或無信息的查詢,從而提高了系統的整體性能和用戶體驗。

局限:

- 模型復雜性:PEBOL的實現比單體LLM方法更為復雜,需要整合貝葉斯優化和自然語言推理(NLI)模型,這可能增加了系統的開發和維護難度。

- 對NLI模型的依賴:PEBOL的性能在很大程度上依賴于NLI模型的準確性。如果NLI模型的性能不佳,可能會直接影響PEBOL的推薦效果。

- 計算資源需求:盡管PEBOL減少了每輪所需的上下文量,但其仍然需要顯著的計算資源來執行貝葉斯更新和查詢生成,這可能限制了其在資源受限環境下的應用。

總體而言,PEBOL通過結合貝葉斯優化和LLM,為自然語言偏好詢問提供了一個有效的解決方案,尤其適用于需要從冷啟動場景快速學習用戶偏好的應用。未來的研究可以探索如何進一步優化PEBOL的計算效率和準確性,以及如何將這種方法擴展到更廣泛的對話推薦系統中。

未來研究方向與PEBOL的潛在改進

1. 多項和集合上下文選擇的LLM基礎獲取功能:目前PEBOL系統在查詢生成策略上主要采用單點選擇策略,即每次只選擇一個項目描述作為LLM查詢生成的基礎。未來的研究可以探索基于LLM的獲取功能,使用成對比較或集合選擇的上下文。這種多項上下文選擇能夠生成對比性查詢,可能更有效地區分項目偏好。

2. 會話推薦系統中的NL-PE方法整合:將NL-PE方法如PEBOL整合到會話推薦系統架構中是另一個研究方向。這類系統需要在處理多種任務(如推薦、解釋和個性化問題回答)的同時,獲取用戶在任意系統-用戶話語對上的偏好。因此,算法需要能夠在不僅僅是查詢和響應的基礎上,而是在更廣泛的對話上下文中進行偏好獲取。

3. 增強模型的解釋性和控制性:盡管PEBOL通過貝葉斯優化增強了LLM的決策理論推理能力,但模型的解釋性和控制性仍有待提高。未來的工作可以探索如何通過改進模型架構或調整訓練過程來增強這些方面。

4. 響應噪聲對性能的影響:用戶響應的噪聲是現實世界應用中常見的問題。研究PEBOL在不同噪聲水平下的表現,并探索如何優化算法以適應高噪聲環境,將是提高系統魯棒性的關鍵。

總結:PEBOL在自然語言偏好獲取中的創新應用及其意義

PEBOL(偏好獲取與貝葉斯優化增強的大型語言模型)代表了在自然語言偏好獲取領域的一項重要創新。它通過結合貝葉斯優化和大型語言模型(LLM)的優勢,有效地解決了傳統偏好獲取方法在處理自然語言對話時的局限性。PEBOL不僅提高了偏好獲取的效率和準確性,還通過其決策理論驅動的查詢生成策略,優化了用戶交互的質量。

PEBOL的核心創新在于其能夠在完全冷啟動的設置中,通過自然語言對話快速準確地識別用戶的最高偏好項。這一點通過與傳統的單體GPT-3.5方法的對比實驗得到了驗證,其中PEBOL在多個數據集和用戶噪聲水平上顯示出顯著的性能提升。

此外,PEBOL的設計充分考慮了探索與利用之間的平衡,通過動態調整查詢策略來避免過度探索低價值項或過度利用已知偏好。這種策略的有效性不僅體現在提高推薦準確性上,也在于提升了用戶的交互體驗,避免了重復或無信息量的查詢。

總之,PEBOL的開發和應用展示了利用先進的機器學習技術來改進自然語言處理任務的巨大潛力。未來的研究將進一步擴展這一框架的功能和應用范圍,特別是在會話推薦系統中的整合使用,以及在更廣泛的自然語言交互場景中的應用。

本文轉載自?? AI論文解讀??,作者: 柏企