FineMedLM-o1: 基于監督微調與測試時訓練的醫學推理增強型大語言模型 精華

一、研究背景與意義

近年來,大語言模型(LLMs)在醫療領域的應用展現出巨大潛力,特別是在疾病診斷和治療規劃等方面。然而,現有的醫學大語言模型在處理復雜臨床場景時,往往難以進行深度推理,尤其是在差異化診斷和個性化治療建議等方面存在明顯短板。本研究提出的FineMedLM-o1模型,通過創新性地結合高質量合成醫學數據和長格式推理數據,采用監督微調(SFT)和直接偏好優化(DPO)技術,顯著提升了模型的醫學推理能力。

二、技術創新與方法

2.1 整體架構

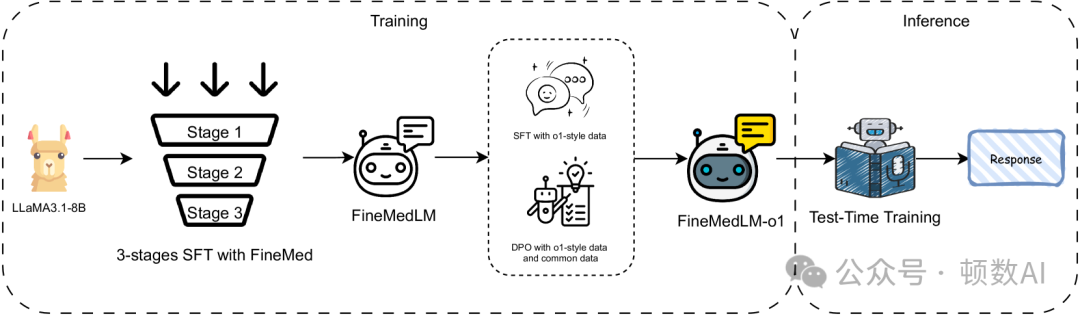

FineMedLM-o1的訓練流程包含三個主要階段:

- 基于合成醫學對話數據的細粒度三階段SFT

- 基于復雜指令和o1風格響應的進一步微調

- 使用普通響應和o1風格響應進行DPO訓練

2.2 數據合成與處理

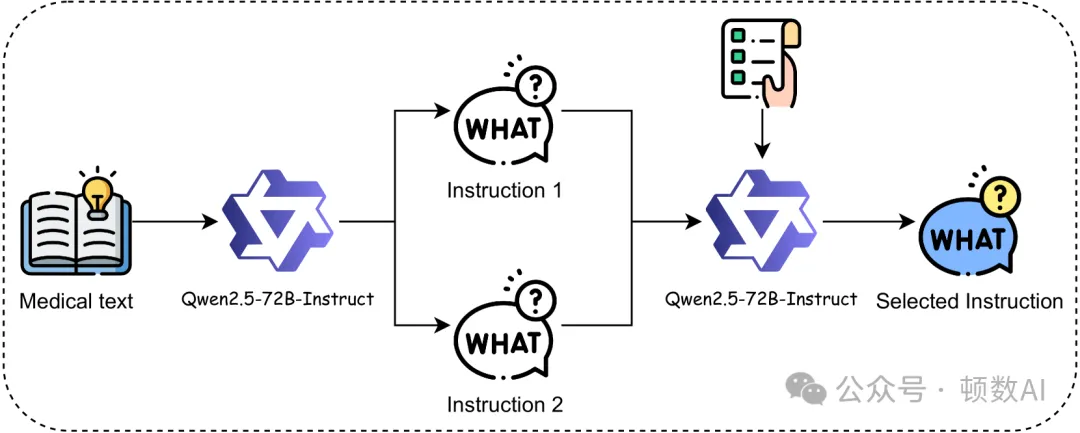

研究團隊開發了一套創新的數據合成方法,主要包括四個步驟:

- 指令生成:使用Qwen模型為每個醫學文本生成兩個不同的指令

- 指令評分:基于預定義標準對指令進行1-10分的質量和復雜度評分

- 指令過濾:通過多步驟過濾確保指令質量

- 響應生成:針對不同復雜度的指令采用不同的響應生成策略

2.3 創新點

- 測試時訓練(TTT)技術

- 首次在醫學領域引入TTT技術

- 通過動態適應領域知識提升推理可靠性

- 實驗證明可帶來額外14%的性能提升

- 三階段SFT策略

- 第一階段:使用20萬個全醫學領域樣本進行訓練

- 第二階段:從內科子集選取3.6萬個樣本進行訓練

- 第三階段:從內分泌科選取1.1萬個樣本進行精細訓練

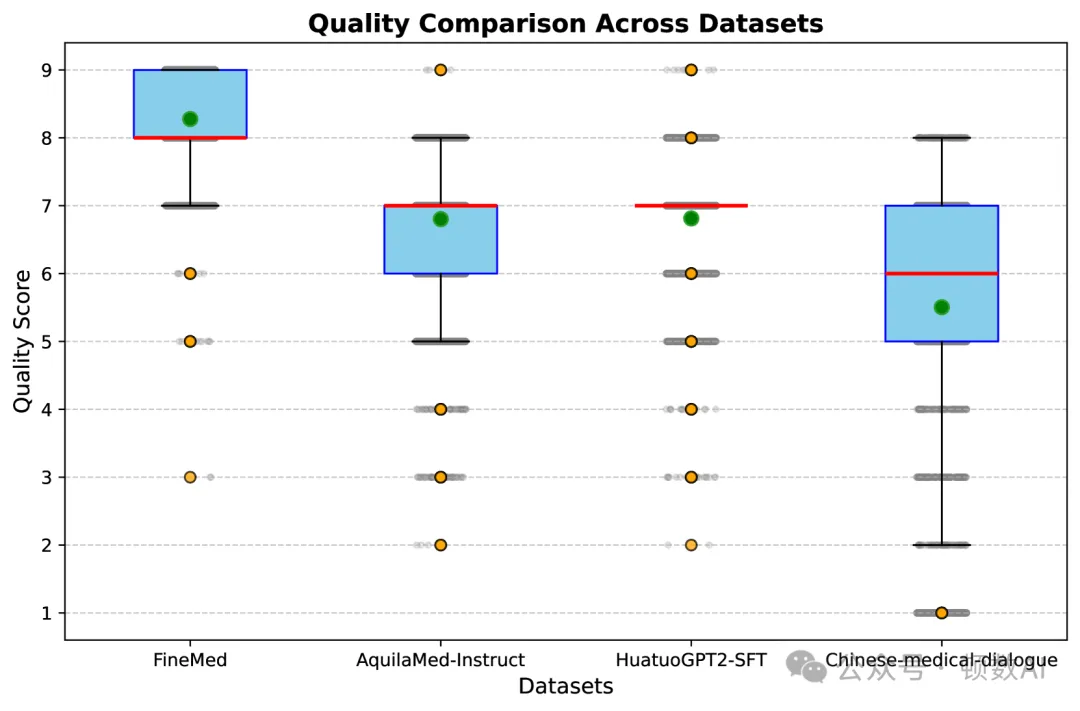

- 高質量數據集構建

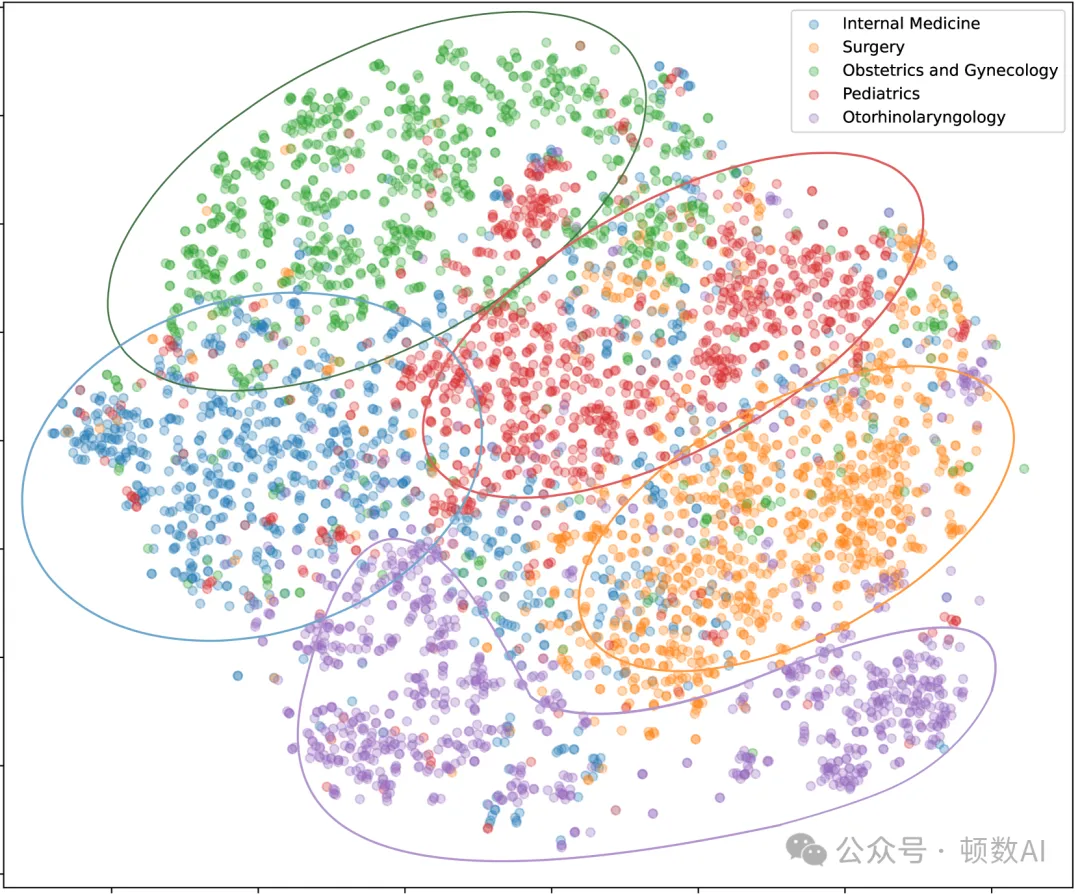

- 開發了FineMed數據集,包含5個主要醫學類別和29個二級類別

- 通過嚴格的質量控制確保數據的專業性和復雜性

- 在質量和復雜度評估中優于現有開源醫學數據集

三、實驗結果與分析

3.1 基準測試性能

在標準醫學基準測試中:

- 相比基礎模型LLaMA3.1-8B平均提升12%

- 在MMLU-Pro醫學子集上比FineMedLM提升27個百分點

- 引入TTT后,性能可與GPT-4o-mini相媲美

3.2 三階段SFT效果驗證

通過對比實驗證明三階段SFT的優勢:

- 相比直接訓練方法最高提升15%

- 證實了從通用到專科的漸進式訓練策略的有效性

四、應用價值與局限性

4.1 應用價值

- 臨床決策支持

- 提供更準確的鑒別診斷建議

- 支持個性化治療方案制定

- 提升復雜醫療場景的處理能力

- 醫學教育培訓

- 可用于醫學生培訓

- 提供標準化的臨床推理訓練

- 支持醫學知識的深度學習

- 研究與開發

- 開源數據集促進醫學AI研究

- 提供醫學LLM評估基準

- 推動醫學AI技術創新

4.2 局限性

- 數據限制

- 原始醫學文本選擇未經質量預評估

- 樣本數量相對有限

- 需要更大規模高質量數據支持

- 技術瓶頸

- 計算資源限制影響模型規模

- DPO階段仍有優化空間

- 需要開發更適合醫學域的強化學習算法

五、未來展望

- 數據質量提升

- 擴大高質量醫學數據規模

- 優化數據篩選和評估機制

- 增強數據的多樣性和代表性

- 算法優化

- 開發專門的醫學域強化學習算法

- 改進TTT技術的效率

- 探索新的模型架構

- 應用拓展

- 深化臨床實踐集成

- 擴展多語言支持

- 開發專科化模型

六、總結

FineMedLM-o1通過創新的數據合成方法、三階段SFT策略和首創的醫學域TTT技術,顯著提升了醫學大語言模型的推理能力。該研究不僅推動了醫學AI技術的發展,也為后續研究提供了寶貴的經驗和資源。盡管仍存在一些限制,但其展現的潛力和創新性使其成為醫學AI領域的重要里程碑。

論文地址:???https://arxiv.org/abs/2501.09213????

項目地址:????https://github.com/hongzhouyu/FineMed???

贊

收藏

回復

分享

微博

QQ

微信

舉報

回復

相關推薦