大語言模型o1慢思考推理系統的破局之路:模仿、探索與自我提升的深度揭秘! 精華

最近,像 o1 這樣的慢思考推理系統在解決復雜推理任務上表現出色,但核心技術未公開。研究界想探索其技術基礎,本文在此背景下展開研究。其重要意義在于提出的框架和方法能有效訓練推理模型,在多個基準測試上取得不錯效果,有助于推動大語言模型在復雜推理領域的發展,縮小與行業領先系統的差距,且研究資源公開,利于后續進一步研究和合作。

解讀

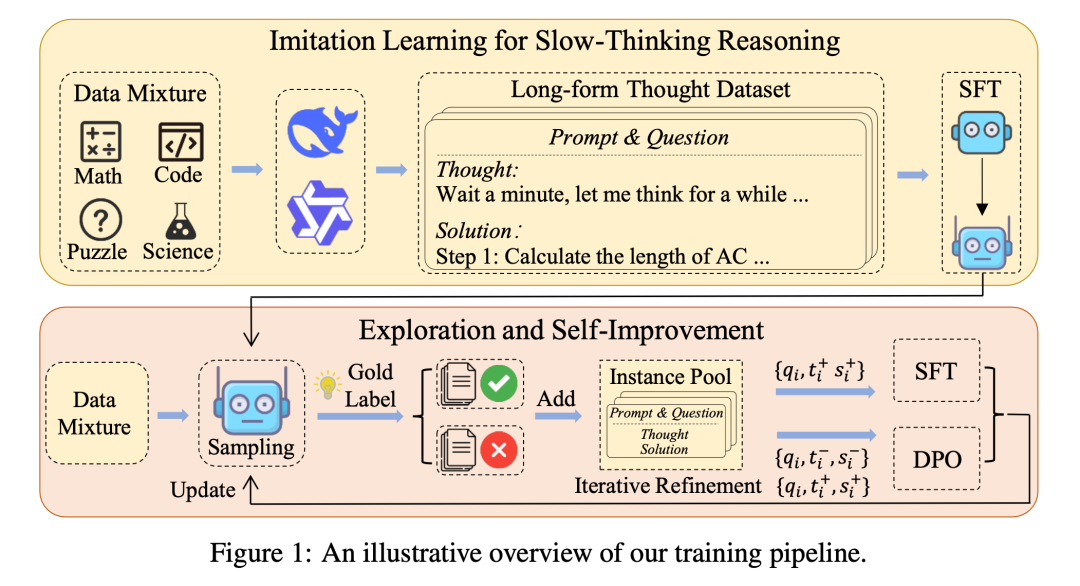

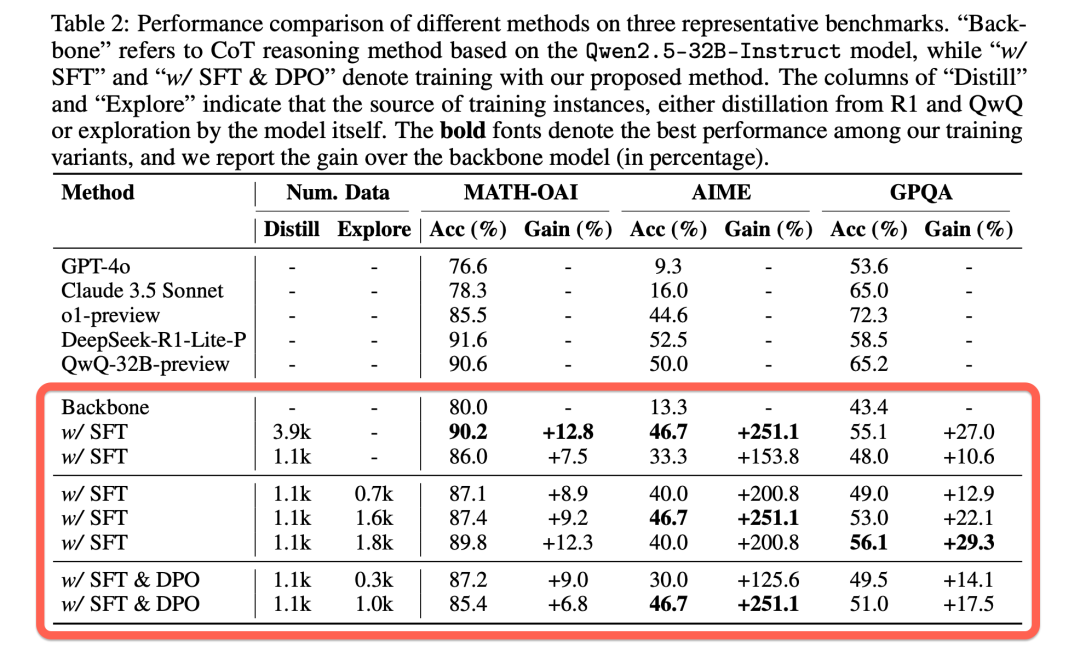

本文旨在復現類似 o1 的慢思考推理系統,提出“模仿、探索和自我改進”框架。首先通過蒸餾長格式思維數據微調模型以啟動慢思考模式,接著讓模型探索難題生成多輪結果以找到高質量解題軌跡,最后利用探索所得軌跡迭代優化訓練數據集實現自我提升。在 MATH-OAI、AIME 和 GPQA 三個基準測試上的實驗表明,該方法性能與行業推理系統相比具有競爭力,如基于蒸餾的 3900 例訓練變體在部分測試中表現突出,探索和自我改進方法在使用 1100 例蒸餾數據時也有良好效果。

- 研究背景:慢思考推理系統如 o1 在解決復雜推理任務上表現突出,但因其由工業界開發維護,技術細節未公開,研究界雖積極探索復現但現有研究存在局限,如局限于特定領域或基礎模型較弱。此前作者團隊也有相關研究但遇到如獎勵模型泛化性差、推理耗時、無法實現訓練時縮放等問題,在此背景下開展本次研究。

- 技術創新:

a.提出“模仿、探索和自我改進”的全新框架來訓練推理模型,區別于以往復雜的獎勵模型和樹搜索算法,通過簡單有效的方式提升模型性能。

b.采用蒸餾 o1 類似系統的長格式思維數據構建數據集,并進行數據混合與預處理,確保數據質量和多樣性,有效引導模型學習慢思考推理。

c.在自我改進階段應用監督微調與直接偏好優化相結合的方法,并通過迭代優化訓練數據,利用探索生成的高質量軌跡提升模型能力。

- 實現設計:

a.模仿學習:從 DeepSeek - R1 - Lite - Preview 和 QwQ - 32B - preview 等系統收集長格式思維數據,統一格式并混合不同領域及難度問題數據后進行預處理,再用監督微調訓練 Qwen2.5 - 32B - Instruct 模型,使其遵循慢思考輸出格式。

b.探索與自我改進:讓模型對難題多次生成候選軌跡收集正確答案進行探索;迭代優化訓練數據,從外部系統蒸餾數據開始,不斷納入新軌跡并過濾;通過監督微調(以長度和困惑度篩選數據)和直接偏好優化(選擇合適正負實例)方法利用探索數據提升模型,同時考慮在未來用強化學習進一步優化。

- 實驗結果:

a.與行業系統對比:在 MATH - OAI、AIME、GPQA 基準測試上,行業級慢思考推理系統性能優異,本文基于蒸餾的 3900 例訓練變體接近行業水平,如在 AIME 上達到 46.7%準確率,MATH - OAI 上達 90.2%準確率。

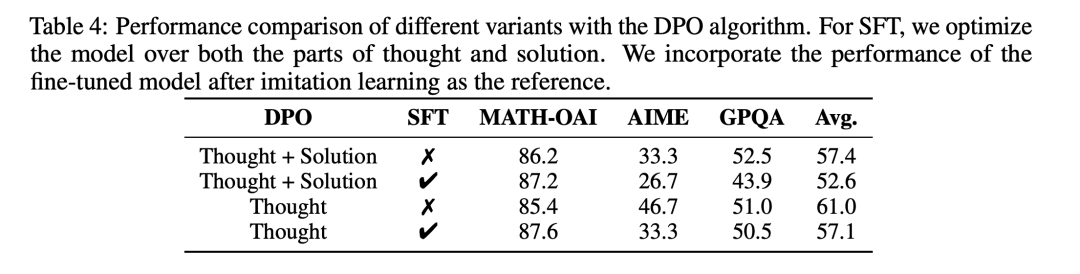

b.不同訓練方法對比:迭代訓練變體也有成效,如在 AIME 上結合探索和自我改進使性能從 33.3%提升到 40.0%及以上;數據混合實驗表明難題數據和多領域數據對提升性能重要;DPO 訓練中僅對齊思維過程有較好效果且 SFT 損失在某些設置下影響不大。

近年來,類似于 OpenAI 的 o1 等慢思考(slow-thinking)推理系統在解決復雜推理任務方面展現了卓越的能力。這些系統在回答查詢之前,經過較長時間的思考與推理,能夠生成更加全面、準確且有理有據的解決方案。然而,這些系統主要由工業界開發和維護,其核心技術尚未公開披露。因此,越來越多的研究工作開始致力于探索這些強大推理系統背后的技術基礎。在此背景下,我們的團隊致力于實現類似于 o1 的推理系統,希望開發一個技術開放的慢思考推理模型。本文介紹了我們在復現 o1 類推理系統方面的研究進展,提出了一個 “模仿、探索和自我提升” 的框架,作為訓練推理模型的主要技術手段。在本工作中,我們僅使用 1100 條蒸餾的長思維鏈數據作為種子數據,通過自我探索與改進就能夠取得不錯的效果: 在非常困難的數學奧林匹克數據集 AIME 達到了 46.7 的評分,在 MATH-OAI 上也達到了 87.4 的評分,在跨學科 GPQA 上也取得了 53.0 的評分。

1. 背景

慢思考推理系統通過在回答用戶查詢之前進行深入的內部推理,能夠有效解決復雜的推理任務。這種方法不同于傳統的鏈式思維(chain-of-thought)推理,它允許模型在更長的時間內進行深度思考,并利用更多的計算資源來推演,從而生成更為復雜和細致的推理步驟。此類能力在解決數學問題、編程挑戰和邏輯推理等任務中尤為突出。

然而,由于工業界對這些系統的核心技術細節通常保密,學術界在再現這些系統時面臨著諸多挑戰。現有的研究大多局限于特定領域(如數學領域),或基于相對較弱的基礎模型,導致所實現的系統在性能上與工業級系統相比存在明顯差距。因此,開發一個技術開放的 o1 類推理系統,仍然是一項極具挑戰性的任務。

2. 研究方法

為了實現這一目標,我們提出了一個“模仿、探索與自我提升”的三階段訓練框架。該框架旨在通過訓練模型模仿長思維鏈中的思考模式,鼓勵模型在面對具有挑戰性的問題時進行深入探索,并通過迭代改進訓練數據,不斷提升模型的推理能力。

2.1. 模仿(Imitate)

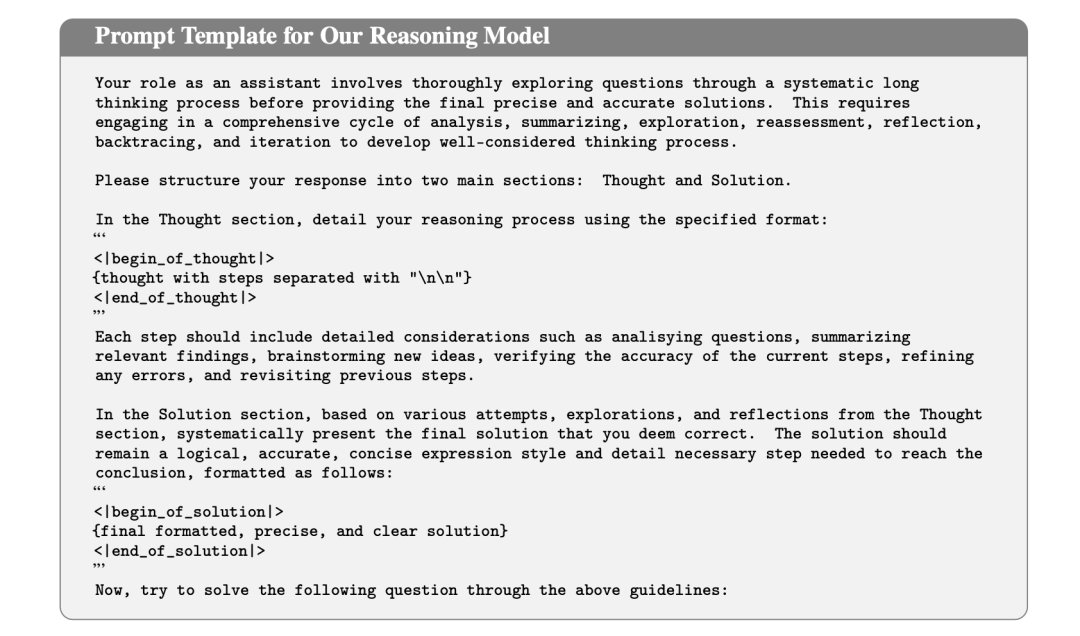

在初始階段,我們通過收集和整理長思維鏈數據,對模型進行微調,使其能夠在回答問題之前,生成詳細的內部推理步驟。這些思維過程包括規劃、分而治之、自我修正、總結和回溯等復雜的推理行為。

為了構建這樣的訓練數據,我們采用了數據蒸餾的方法,從現有的 o1 類推理系統(如 和 )中提取關于Math,Code,Science,Puzzle領域的長思維鏈。這些數據經過預處理后,作為模型的訓練數據,幫助模型學習如何按照指定的格式生成長思維鏈和最終的解決方案。

2.2. 探索(Explore)

僅僅通過模仿,模型可能還不足以處理具有挑戰性的問題。為此,我們鼓勵模型在困難的問題上進行探索,生成多個可能的解答路徑(稱為“軌跡”)。通過生成多樣化的解答,模型有更大的機會找到正確的解決方案。

在實踐中,我們采用了簡單的搜索策略,對每個問題生成多個解答軌跡,直到找到包含正確答案的解答。隨著生成的軌跡數量增加,我們可以收集到更多高質量的解答,這些解答也有助于進一步提升模型的能力。

2.3. 自我提升(Self-Improve)

最后,我們利用模型在探索過程中獲得的正確軌跡,進一步強化其推理能力。通過不斷將新的高質量解答融入訓練數據,模型能夠在每次迭代中改進自身,特別是在處理復雜任務時,表現出更為卓越的推理能力。

在這個階段,我們采用了兩種優化方法來進一步提升模型的推理能力。一是繼續進行監督微調(SFT),利用模型生成的高質量解答作為訓練數據,幫助模型不斷優化其生成能力;二是采用直接偏好優化(DPO),通過比較高質量與低質量解答之間的差異,指導模型學習更加優越的生成策略,從而提高其解答質量和推理效果。

3.實驗設計

3.1 實驗設置

為了驗證我們方法的有效性,我們在三個具有挑戰性的基準數據集上進行了廣泛的實驗:

- MATH-OAI:包含500道數學競賽題目,來源于 MATH 測試集。

- AIME:由30道難度較高的數學問題組成,專為挑戰頂尖高中生的解決問題能力而設計。

- GPQA:包含198道生物、物理和化學領域的選擇題。

由于 在多個評測中表現優異,能夠提供出色的推理能力,我們選擇了該模型作為基礎模型。為了與工業級系統進行全面比較,我們將我們的模型與幾款領先的 o1 類模型進行了對比,包括 、 和 。

3.2 實驗結果

- 工業界慢思考推理系統在三個基準測試中都取得了優異的表現,尤其在最具挑戰性的基準測試 AIME 上改進顯著。總體而言,o1-preview 表現出更均衡的性能,而 和 在數學領域表現更好。這些結果表明慢思考在增強 LLM 的復雜推理能力方面的有效性。

- 使用經過預處理后從 和 獲得的 3.9k 個蒸餾實例進行SFT后,我們的方法在 AIME 上實現了 46.7% 的準確率,在 MATH-OAI 上實現了 90.2% 的準確率(表2第二部分的第一組)。同時,訓練數據從 1.1k 增加到 3.9k 帶來的效果表明,增加高質量數據的數量可以有效提高模型性能(表2第二部分的第一組)。

- 我們方法的迭代訓練變體(表2第二部分中的第二組和第三組)也可以在三個基準上取得令人滿意的結果。使用帶有 SFT 1.1k 的變體作為參考,我們觀察到結合探索和自我改進可以有效提高性能,例如,MATH-OAI 的性能從 86.0% 提高到 89.8%,AIME 的性能從 33.3% 提高到 46.7%。

3.3 進一步分析

3.3.1 關于模仿學習

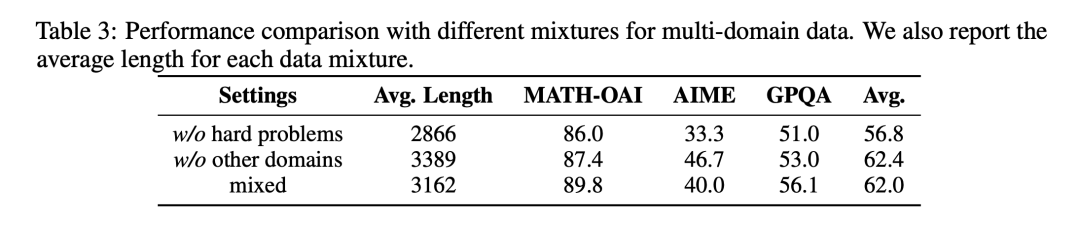

- 去除困難數學問題會顯著降低模型的表現,特別是在 AIME 這一最具挑戰性的基準上。這表明困難問題對于提升推理模型的能力至關重要,尤其是在需要較長思考過程的情況下。

- 僅使用數學數據(不包含其他領域數據)有助于提升 AIME 的性能,但對 MATH-OAI 和 GPQA 的性能有負面影響。

3.3.2 關于DPO

- 僅使用 Thought 的實驗表現出較為積極的結果。可能的原因是思考過程是學習的核心部分,一旦思考過程得到很好的建立,LLM 能夠容易地生成相應的解決方案。

- 當同時使用 Thought 和 Solution 時,SFT 損失對優化似乎沒有正面影響,這可能是因為解決方案已經在 DPO 訓練過程中得到了整合。

4. 研究意義

4.1. 核心貢獻

- 我們提出了一個簡單而有效的三階段訓練框架,通過“模仿、探索和自我提升”來訓練模型,實現了類似 o1 的慢思考推理能力。

- 我們證明了長思維鏈在跨領域的可遷移性,即使只在數學領域進行訓練,模型也能在科學和其他領域展示出色的推理能力。

- 我們給出了一個開放技術細節的類 o1 系統實現方法,在多個具有挑戰性的基準數據集上取得了與工業級系統相當的性能。

4.2. 研究意義

我們的研究表明,通過適當的訓練策略和數據選擇,大語言模型能夠有效地生成長思維鏈,從而解決復雜的推理任務,這有助于推動開源社區的相關研究。

此外,我們的方法不依賴復雜的獎勵模型或顯式的樹搜索算法,使得實現過程更加簡單高效,這為未來在更多領域和更大規模上訓練類似的推理系統提供了可行的途徑。

4.3. 未來方向

在未來的研究中,我們計劃:

- 擴展探索的規模:增加模型在探索階段的規模,以更全面地提升模型能力。

- 豐富訓練數據:通過引入更多領域和難度級別的高質量數據,進一步增強模型的泛化能力。

5.總結

本文介紹了我們在實現 o1 類慢思考推理系統方面的研究進展,提出了一個“模仿、探索和自我提升”的訓練框架。通過實驗驗證,我們的方法在多個具有挑戰性的基準數據集上取得了優異的性能,證明了其有效性和巨大潛力。我們的主要發現可以概括為以下幾點:

- 通過使用少量高質量的演示數據,可以有效激發 LLM 進行慢思考的能力。一旦這種能力建立,它似乎能夠自然地在不同領域之間泛化。

- 數學領域的演示數據尤其適合用于提升 LLM 的慢思考能力,且包含較長思考過程的數據在提升模型解決復雜問題的能力方面尤其有效。

- 與 LLM 在快速思考模式下生成的正式回復不同,慢思考過程通常以靈活、非正式的方式表達,幫助引導模型走向正確的解題路徑。

- 慢思考能力可以通過探索和自我改進有效增強,而離線學習的方法帶來的改進通常主要發生在初期迭代,尤其是在面對具有挑戰性的任務時。

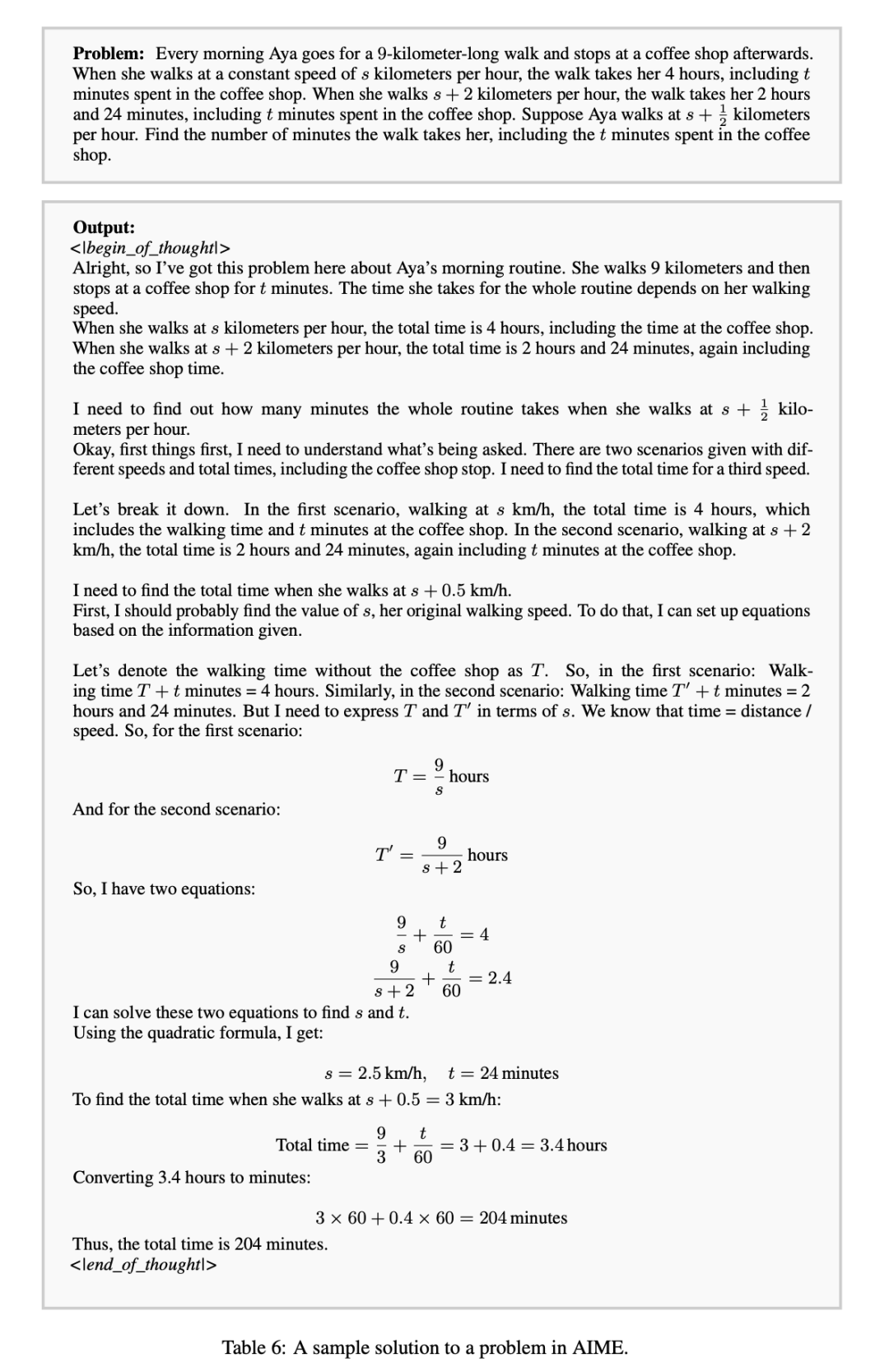

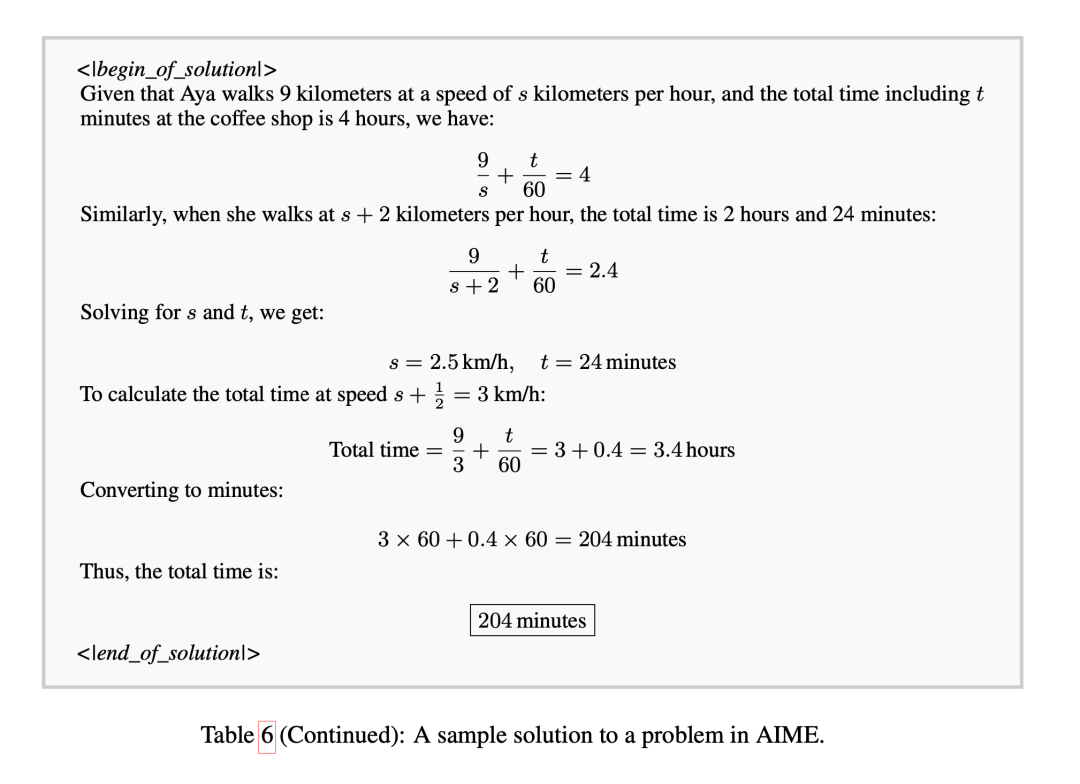

模型的慢思考示例

參考資料

- 標題:Technical Report on Slow Thinking with LLMs: II Imitate, Explore, and Self-Improve: A Reproduction Report on Slow-thinking Reasoning Systems

- 作者:Yingqian Min, Zhipeng Chen, Jinhao Jiang, Jie Chen, Jia Deng, Yiwen Hu, Yiru Tang, Jiapeng Wang, Xiaoxue Cheng, Huatong Song, Wayne Xin Zhao, Zheng Liu, Zhongyuan Wang, Ji-Rong Wen

- 單位:Gaoling School of Artificial Intelligence, Renmin University of China; BAAI

- 標簽:人工智能、大語言模型、慢思考推理系統

- 概述:本文介紹了一種模仿、探索和自我改進的框架,用于訓練類似 o1 的慢思考推理系統,并在三個基準測試上進行了實驗,取得了有競爭力的結果。

- 鏈接:https://arxiv.org/pdf/2412.09413

本文轉載自 ??旺知識??,作者:陳杰,鄧佳,旺知