TextCoT:放大增強型多模態(tài)富文本圖像理解 原創(chuàng)

摘要:大型多模態(tài)模型(Large Multimodal Models, LMMs)的出現(xiàn)引發(fā)了旨在利用其卓越推理能力的研究熱潮。然而,在理解富含文本的圖像方面,要充分發(fā)揮LMMs的潛力仍然存在挑戰(zhàn),現(xiàn)有的方法在有效處理高分辨率圖像方面面臨困難。為此,我們提出了TextCoT,這是一種針對富含文本圖像理解的新穎連鎖思維(Chain-of-Thought)框架。TextCoT利用LMMs的圖片標(biāo)注能力來把握圖像的整體情境,并利用其定位能力來檢查局部文本區(qū)域,從而實現(xiàn)全局和局部視覺信息的提取,促進了更精確的問題回答。技術(shù)上,TextCoT包含三個階段:圖像概覽、粗略定位和精細觀察。圖像概覽階段提供了對全局場景信息的全面理解,粗略定位階段則根據(jù)所提問題大致估算出含有答案的圖像區(qū)域。隨后,結(jié)合獲取的全局圖像描述,最終階段進一步審視特定區(qū)域以提供準(zhǔn)確答案。我們的方法無需額外訓(xùn)練,即插即用。在多個先進的LMMs上,針對一系列富含文本的圖像問答基準(zhǔn)進行了廣泛實驗,結(jié)果顯示了我們方法的有效性和強大的泛化能力。代碼可于??https://github.com/bzluan/TextCoT??獲取。

1. 引言

近年來,大型語言模型(LLMs)領(lǐng)域的突破性進展以驚人的性能徹底改變了自然語言處理(NLP)領(lǐng)域,橫跨廣泛的任務(wù)。在基礎(chǔ)LLMs的基礎(chǔ)上,通過將視覺信息整合進LLMs,發(fā)展出了大型多模態(tài)模型(LMMs),使模型能夠從圖像和文本中同時獲取信息。關(guān)于LMMs的研究不斷改進模型架構(gòu)、訓(xùn)練數(shù)據(jù)和訓(xùn)練策略等,從而在多種場景中提高了性能。在多模態(tài)理解領(lǐng)域中,富含文本的圖像研究代表了一個關(guān)鍵方向。與一般圖像理解相區(qū)別,此任務(wù)的挑戰(zhàn)在于模型需要同時理解圖像中交織的視覺和文本內(nèi)容。此外,由于文本的存在,這類圖像通常具有更高的分辨率,比如文檔圖像[29]就是例子。

在富含文本的圖像理解領(lǐng)域,通用的大型多模態(tài)模型[32, 33, 63]往往表現(xiàn)不佳。這是因為此類任務(wù)的問題答案通常是文本形式的,且常位于圖像的局部區(qū)域,如在高分辨率圖像中識別汽車的車牌號。然而,現(xiàn)有LMMs的輸入分辨率通常被限制在448像素以下,這限制了它們有效處理這類查詢的能力。為了解決這個問題,一些方法選擇開發(fā)高分辨率的視覺編碼器[15]或?qū)D像分割成多個塊[30, 62]進行單獨的視覺特征編碼。然而,這些解決方案需要額外的訓(xùn)練,并要求大量資源來收集和構(gòu)建高分辨率的圖像-文本問答數(shù)據(jù)集。

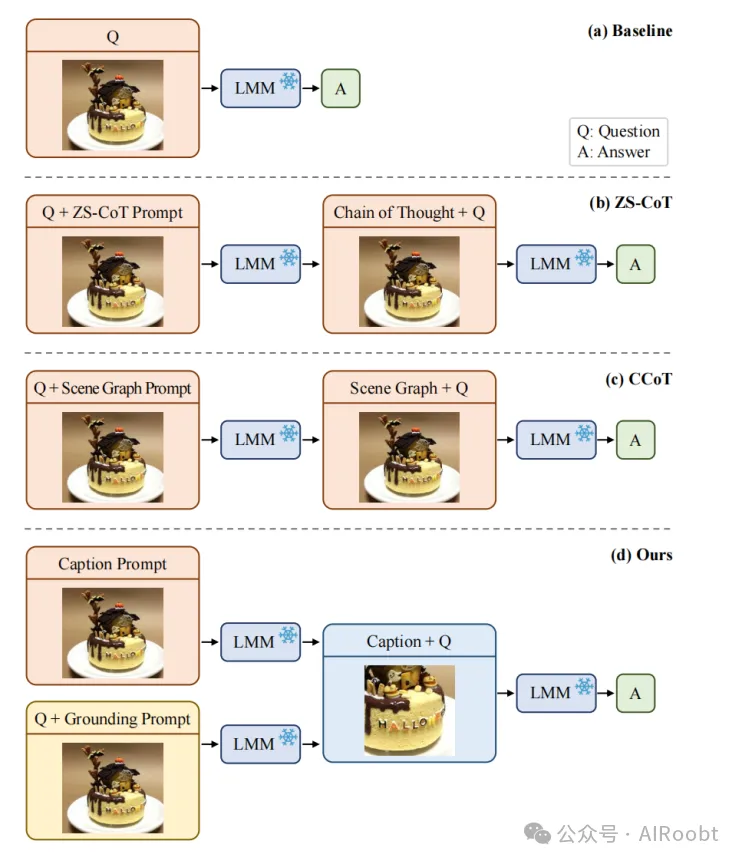

在大型語言模型領(lǐng)域,基于連鎖思維(CoT)技術(shù)的研究旨在通過無需額外模型訓(xùn)練的刻意推理步驟來克服問題,并已取得了顯著的性能提升。這些技術(shù)可以直接應(yīng)用于我們富含文本的圖像理解領(lǐng)域。如圖1(b)所示,代表性方法ZS-CoT[22]將逐步推理的過程作為模型的新輸入,從而獲得更準(zhǔn)確的響應(yīng)。然而,ZS-CoT[22]并未實質(zhì)上解決該任務(wù)需要仔細檢查局部區(qū)域的問題。此外,CCoT[40]是一種針對LMMs優(yōu)化的先進CoT方法,通過構(gòu)建模擬物體間關(guān)系的場景圖(如圖1(c)所示)來增強一般場景下的問答能力。但是,CCoT[40]在富含文本的圖像上的表現(xiàn)欠佳,這歸因于構(gòu)建文本實例的場景圖面臨的挑戰(zhàn)。

圖1展示了(a)基線LMM、(b)零樣本CoT [22]、(c)CCoT [40]以及(d)我們提出的TextCoT的流程對比。為了更好地理解富含文本的圖像,TextCoT利用LMMs的圖片描述能力和定位能力,分別把握圖像的整體情境和局部文本區(qū)域。

為了解決上述問題,本工作中我們提出了TextCoT,一種針對富含文本圖像理解的新穎連鎖思維框架。我們的想法靈感來源于人類的認(rèn)知模式。具體而言,在富含文本且無法記住所有細節(jié)的情境下,人們很少主動預(yù)測要記憶哪個部分以備后續(xù)提問。相反,一種更直觀的策略是根據(jù)問題引導(dǎo)來掃描文本,鎖定可能包含答案的區(qū)域,然后詳細檢查這些細節(jié)以形成回答。為了模仿這種多模態(tài)思維過程,我們開發(fā)了TextCoT。技術(shù)上,我們的TextCoT包括三個階段:圖像概覽、粗略定位和精細觀察。圖像概覽的初始階段有助于全面掌握整體場景信息,隨后的粗略定位階段則根據(jù)提出的問題估計包含答案的圖像部分。接著,通過整合前期獲得的圖像全局描述,最后階段深入特定區(qū)域以提供精確答案。

為了驗證我們的TextCoT,我們在基于幾種先進LMMs的一系列富含文本的圖像問答基準(zhǔn)數(shù)據(jù)集上進行了廣泛的實驗。定量和定性的結(jié)果均展現(xiàn)了我們方法的有效性和強大的泛化能力。我們的貢獻總結(jié)如下:

? 我們提出了TextCoT,一種針對富含文本圖像理解的新穎連鎖思維框架。TextCoT利用LMMs的定位能力來檢查特定答案區(qū)域,從而促進更準(zhǔn)確和細致的問答。

? 我們嘗試從連鎖思維的角度解決富含文本圖像理解任務(wù)中的高分辨率視覺輸入問題。我們的方法無需額外訓(xùn)練,即插即用。

? 我們基于幾種先進的LMMs,在一系列富含文本的圖像問答基準(zhǔn)數(shù)據(jù)集上進行了廣泛的實驗,以驗證我們的方法。

2. 相關(guān)工作

我們的TextCoT是一種多模態(tài)連鎖思維方法,旨在通過有效利用大型多模態(tài)模型(LMMs)的能力來增強其在富含文本場景中的性能。接下來,我們首先回顧大型語言模型(LLMs)和LMMs的研究,然后討論針對LLMs和LMMs的連鎖思維(CoT)文獻。

大型語言模型(LLMs)。隨著Transformer架構(gòu)強大潛力的展示,大型語言模型徹底改變了自然語言處理(NLP)領(lǐng)域。諸如BERT [14]和T5 [45]這樣的模型,采用編碼器-解碼器架構(gòu),為深入理解語言細微差別打下了基礎(chǔ)。GPT3 [7]以其解碼器為中心的設(shè)計,在少量樣本和零樣本學(xué)習(xí)場景中展現(xiàn)出卓越性能,證明了其在廣泛NLP任務(wù)上的適應(yīng)性。PaLM [12]模型通過擴展模型參數(shù)和數(shù)據(jù)集范圍,推動了理解和生成能力的極限。InstructGPT [42]和ChatGPT [41]引入了基于人類反饋的微調(diào)和強化學(xué)習(xí),顯著提高了交互質(zhì)量。此后,像LLaMA [48]和Vicuna [11]這樣的開源模型繼續(xù)推進NLP的前沿基準(zhǔn),為未來研究開辟了新路徑。

大型多模態(tài)模型(LMMs)。為了將視覺知識融入大型語言模型,通過集成現(xiàn)有視覺-語言模型的視覺編碼器和LLMs的推理能力,開發(fā)出了大型多模態(tài)模型。通過改進預(yù)訓(xùn)練對齊和指令微調(diào),MiniGPT-4 [69]、LLaVA [32, 33]、InstructBLIP [13]和mPLUG-Owl [63]等眾多研究在各種視覺-語言任務(wù)上展示了顯著進步。一些研究 [9, 18, 43, 52]利用物體檢測和文本檢測數(shù)據(jù)增強了LMMs的定位能力并減少了幻覺。ShareGPT4V [10]通過提高模型標(biāo)題數(shù)據(jù)質(zhì)量,改善了圖像和文本模態(tài)之間的對齊。Vary [54]、V* [57]和DualFocus [8]通過改進模型架構(gòu)和訓(xùn)練框架進一步提升了LMMs的基準(zhǔn)。

許多LMMs在富含文本的場景中表現(xiàn)不佳,這是由于密集的細粒度信息和高圖像分辨率。為了解決這一問題,UniDoc [16]和mPLUG-DocOwl [61]等研究利用文本相關(guān)視覺任務(wù)數(shù)據(jù)集來增強模型在文本豐富場景中的能力。Vary-toy [55]和Qwen-VL [4]通過訓(xùn)練更大的視覺編碼器增強了對高分辨率圖像理解的能力。UReader [62]、Monkey [30, 35]采用了堆疊多個視覺編碼器的方法來增加模型的輸入分辨率。DocPedia [15]建議使用頻域視覺信息來擴展輸入分辨率同時減少令牌使用。這些方法顯著提高了模型的輸入分辨率,極大地增強了理解文本等細粒度細節(jié)的能力。盡管這些方法通過訓(xùn)練更復(fù)雜的模型架構(gòu)和視覺任務(wù)顯示出了出色的結(jié)果,但高質(zhì)量視覺指令訓(xùn)練數(shù)據(jù)的依賴仍然是一個重大挑戰(zhàn)。

思維鏈提示。一系列專注于連鎖思維(CoT)提示方法的研究揭示了大型語言模型的巨大潛力,同時也發(fā)現(xiàn)它們的性能由于不足的提示技術(shù)并未完全發(fā)揮。CoT方法在推理階段通過提示控制LLMs和LMMs,無需訓(xùn)練或微調(diào)就能激發(fā)模型的推理潛能。CoT [56]、零樣本CoT [22]、CoT-SC [51]、TOT [60]和GOT [5]等研究揭示了LLMs推理能力的重大提升,奠定了連鎖思維提示的基礎(chǔ)。許多研究 [17, 26, 65]致力于精確操縱提示和訓(xùn)練過程以增強視覺語言模型的推理能力。隨著LMMs的出現(xiàn),許多研究聚焦于LMMs的CoT方法,以增強其推理能力。VidIL [53]、DDCoT [68]和Multimodal-CoT [67]利用LMMs的標(biāo)注和推理能力取得了有希望的結(jié)果。CCoT [40]提出使用JSON格式生成場景圖,極大增強了LMMs對圖像中對象關(guān)系的理解。CoCoT [66]通過觀察多張圖像間的對比信息增強了LMMs的推理能力。一些研究 [27, 58]通過在圖像上添加網(wǎng)格和點矩陣來增強LMMs的檢測能力。

盡管這些工作在不同方面表現(xiàn)出色,它們各自都有缺點。常規(guī)的LMMs受限于低分辨率,在文本場景中表現(xiàn)不佳,因為它們無法捕捉到細部細節(jié)。高分辨率模型的設(shè)計、訓(xùn)練和微調(diào)需要大量資源,并且經(jīng)常導(dǎo)致在長文本對話和定位任務(wù)上的性能下降。當(dāng)前的多模態(tài)CoT方法未能解決富含文本場景的關(guān)鍵問題,跨模態(tài)提示的探索也不足。這突顯了一個當(dāng)前的研究空白:開發(fā)一種能夠跨視覺和文本模態(tài)進行推理的多模態(tài)CoT方法。

3. 方法

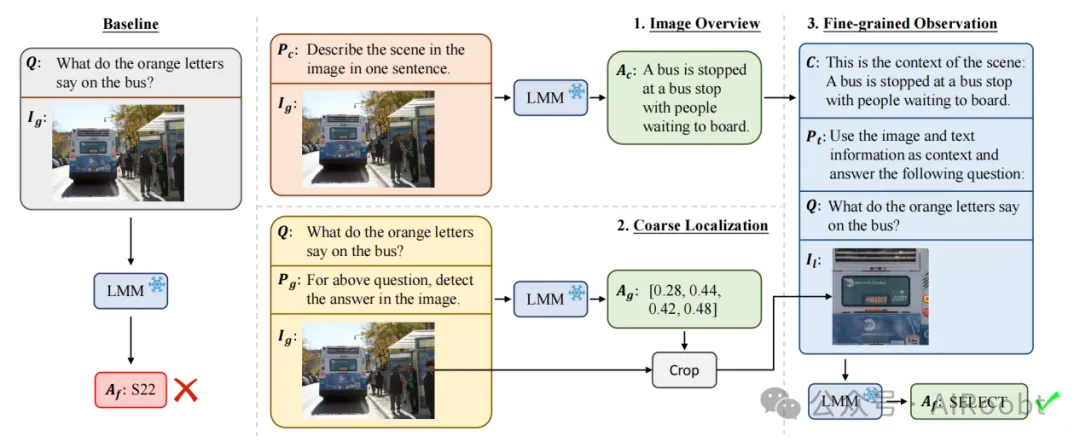

如圖2(左)所示,給定一個全局富含文本的圖像I_g和一個問題Q,一種直接的方法是指導(dǎo)LMMs生成答案A_f。然而,受視覺輸入粒度的限制,LMMs往往難以提供準(zhǔn)確的回答。在這項工作中,我們提議利用LMMs檢查特定區(qū)域,從而促進更精確的問題回答。我們提出了TextCoT,一個針對富含文本圖像理解的新穎連鎖思維框架。圖2(右)展示了TextCoT的概覽。接下來,我們將介紹其三個階段,包括(1)圖像總覽、(2)粗略定位和(3)細粒度觀察。

3.1. 圖像總覽

我們的第一步旨在利用LMMs的圖像描述能力,生成一個既簡潔又全面的圖像描述,以此保留圖像中的整體信息。具體而言,如圖2所示,我們使用全局圖像I_g和描述提示P_c來指導(dǎo)LMM,從而獲得描述性答案A_c。這個A_c隨后將在細粒度觀察階段轉(zhuǎn)換成描述C,為回答給定問題提供全局上下文支持。

近期研究表明[[49, 64]],大型多模態(tài)模型產(chǎn)生的較長輸出往往會表現(xiàn)出更多的虛構(gòu)現(xiàn)象,同時較長的輸入提示也會降低性能。因此,如圖2所示,我們在提示P_c中融入了“一句話內(nèi)”的短語來控制描述的長度。通過這種方式,我們鼓勵生成的描述簡潔、準(zhǔn)確,并能概括圖像中描繪的場景。這樣一來,不僅能夠減少不實信息的產(chǎn)生,還能保持模型對輸入的高效處理能力,確保了描述內(nèi)容的高質(zhì)量和相關(guān)性。

圖2. 標(biāo)準(zhǔn)單階段LMM(左圖)和我們的TextCoT(右圖)的概述。TextCoT包括三個階段:(1) 圖像概覽,(2) 粗定位,和 (3) 細粒度觀察。前兩個階段分別生成圖像Ig的全局上下文描述Ac和問題Q的答案區(qū)域Ag,從而促進產(chǎn)生更準(zhǔn)確的響應(yīng)Af。

3.2. 粗略定位

我們的第二步目標(biāo)是利用LMMs的定位能力,在圖像I_g中對答案進行定位。具體來說,如圖2所示,我們使用問題Q、定位提示P_g以及全局圖像I_g來指導(dǎo)LMM,從而生成一個定位答案A_g。這個定位答案包含了答案區(qū)域的邊界框坐標(biāo)。接著,我們根據(jù)這個邊界框裁剪圖像,得到局部圖像I_l。局部圖像I_l在第三階段被用來讓LMM仔細檢查這一特定區(qū)域,從而生成問題Q的正確答案。接下來我們將介紹我們的裁剪策略。

如圖2所示,針對一個全局圖像I_g和定位答案A_g,我們以其邊界框中心點為焦點,延長較短邊以匹配較長邊,這樣得到一個正方形的邊界框,避免了CLIP-ViT[[44, 50]]在調(diào)整尺寸操作中可能引起的形變。隨后,我們引入了一個超參數(shù):擴展比率alpha,用于擴大裁剪后的正方形區(qū)域,經(jīng)驗上設(shè)置為1.5。同時,由于LMMs的標(biāo)準(zhǔn)輸入分辨率為336×336或448×448,我們設(shè)定最小圖像尺寸為448×448,以防止擴展操作后出現(xiàn)非常小的邊界框。經(jīng)過上述步驟,我們得到了包含答案的局部區(qū)域圖像I_l,確保它包含足夠的信息以便在后續(xù)階段給出正確回答。如果正方形裁剪超出了圖像邊界,則將其平移以保持在圖像范圍內(nèi)。

許多現(xiàn)有的LMMs并未使用專為文本檢測設(shè)計的數(shù)據(jù)集進行訓(xùn)練。它們的定位能力通常是通過在如RefCOCO[[21, 36]]這樣的物體檢測數(shù)據(jù)集上的訓(xùn)練習(xí)得的。因此,當(dāng)LMMs被要求在圖像中定位文本時,常常會出現(xiàn)定位不準(zhǔn)確的情況。然而,這一局限性并不妨礙我們的方法。我們的TextCoT不需要精確的位置輸出,一個大致的定位就已經(jīng)足夠。

3.3. 細致觀察

最后階段聚焦于獲取的答案區(qū)域I_l,以生成對問題的準(zhǔn)確響應(yīng)。具體而言,如圖2所述,我們首先在答案描述Ac前添加提示“這是場景的上下文:”,形成描述C。問題Q與第二階段保持一致。任務(wù)提示Pt進一步促使模型關(guān)注上述上下文C和問題Q。我們的最終文本提示由C、Pt和Q組成。然后,我們用這個文本提示和圖像I_l指導(dǎo)LMM。最終,LMM通過整合圖像I_G中的全局上下文信息及局部圖像I_l中的細致視覺細節(jié),針對提出的問題Q給出精確答案。

4. 實驗

本節(jié)基于幾項先進的LMMs,在一系列富含文本的圖像問答基準(zhǔn)數(shù)據(jù)集上進行了廣泛實驗。下面,我們首先介紹涉及的LMMs和基準(zhǔn)數(shù)據(jù)集,并進一步展示和討論實驗結(jié)果及消融研究。

4.1. 基線LMMs

在我們的實驗中,基于五種知名的LMMs評估了TextCoT,包括LLaVA-1.5-7B [[32]]、LLaVA-1.5-13B [[32]]、SPHINX [[31]]、ShareGPT4V [[10]]和Qwen-VL-Chat [[4]]。我們使用官方實現(xiàn)為這些LMMs執(zhí)行推理。鑒于我們的方法是一種鏈?zhǔn)剿伎挤椒ǎ瑹o需對模型架構(gòu)或推理過程做任何調(diào)整。在推理過程中,為了模型輸出的最佳性能和穩(wěn)定性,所有實驗中我們將溫度參數(shù)設(shè)為0,除CoT-SC [[51]]實驗外,該實驗根據(jù)其原始實現(xiàn)設(shè)為0.7。下面,我們簡要回顧這些LMMs。

LLaVA-1.5。LLaVA-1.5 [[32]]的模型架構(gòu)用MLP替換了線性投影,以將視覺特征映射到與LLM共享的嵌入空間。LLaVA-1.5 [[32]]在336×336分辨率下使用CLIP-ViT-L [[44]]作為視覺編碼器,Vicuna [[11]]作為語言解碼器。LLaVA-1.5 [[32]]利用區(qū)域級VQA數(shù)據(jù)集(Visual Genome [[24]]、RefCOCO [[21, 36]])增強模型定位精細視覺實例的能力。我們工作中采用LLaVA-1.5-7B [[32]]和LLaVA-1.5-13B [[32]]模型進行評估,以驗證我們的TextCoT。我們采用準(zhǔn)確性 [[34]] 作為度量標(biāo)準(zhǔn),即模型生成的響應(yīng)如果包含地面真值中的字符串,則視為正確。

SPHINX。SPHINX [[31]]引入了權(quán)重混合策略,以高效結(jié)合領(lǐng)域特定知識,并在指令微調(diào)期間解凍其LLM權(quán)重。SPHINX [[31]]具有更廣泛的多模態(tài)問答任務(wù),包括區(qū)域級理解、字幕定位和文檔布局檢測。我們在實驗中采用了與LLaVA-1.5 [[32]]相同的度量標(biāo)準(zhǔn)。

ShareGPT4V。ShareGPT4V-7B [[10]]模型遵循LLaVA-1.5 [[32]]的設(shè)計。它在預(yù)訓(xùn)練和SFT階段均納入了ShareGPT4V數(shù)據(jù)集。盡管競爭對手使用更大的訓(xùn)練數(shù)據(jù)集或更多參數(shù),ShareGPT4V-7B [[10]]憑借70億參數(shù)在大多數(shù)多模態(tài)基準(zhǔn)測試中表現(xiàn)出色。我們采用了與LLaVA-1.5 [[32]]相同的評估指標(biāo)。

Qwen-VL-Chat。Qwen-VL-7B [[4]]和Qwen-VL-Chat-7B [[4]]是一系列基于Qwen-7B [[3]]大型語言模型的高度性能和多功能的視覺-語言基礎(chǔ)模型。LLM基礎(chǔ)通過引入新的視覺受體(包括與語言對齊的視覺編碼器和位置感知適配器)增強了視覺能力。對于此模型,我們同樣選擇上述準(zhǔn)確性指標(biāo)[[34]]。

GPT-4V。與之前的模型不同,GPT-4V [[1]]的架構(gòu)和預(yù)訓(xùn)練細節(jié)未公開。一些技術(shù)報告 [[59]] 揭示了GPT-4V [[1]]的卓越性能,包括字幕生成、對象定位和計數(shù)。GPT-4V [[1]]展示了直接以文本格式生成邊界框坐標(biāo)的能效,無需單獨的文本化框令牌。

Claude。Claude 3 [[2]]的架構(gòu)和預(yù)訓(xùn)練細節(jié)未公開。Claude 3 [[2]]具有以文本格式生成邊界框坐標(biāo)的能力。我們?yōu)槎ㄐ詫嶒灢捎昧薈laude 3 Opus [[2]]模型,這是最強大的版本。

4.2. 數(shù)據(jù)集

為了說明TextCoT的強大泛化能力,我們選擇了幾個涵蓋廣泛場景的評估數(shù)據(jù)集,包括以場景文本為中心的視覺問答、面向文檔的VQA和關(guān)鍵信息提取數(shù)據(jù)集。下面,我們簡要介紹這些數(shù)據(jù)集。

以場景文本為中心的VQA。TextVQA [[46]]和STVQA [[6]]是場景文本為中心的VQA領(lǐng)域最常用的基準(zhǔn)數(shù)據(jù)集。TextVQA [[46]]基準(zhǔn)數(shù)據(jù)集包含超過45,000個問題,涉及28,000張圖像,這些圖像來自O(shè)penImages [[23]]數(shù)據(jù)集的不同類別。STVQA [[6]]基準(zhǔn)數(shù)據(jù)集包含超過31,000個問題,涉及從各種公共數(shù)據(jù)集中收集的23,000張圖像。

面向文檔的VQA。DocVQA [[38]]、InfographicVQA [[39]]和ChartQA [[37]]是三個廣泛使用的面向文檔的VQA任務(wù)基準(zhǔn)數(shù)據(jù)集。DocVQA [[38]]數(shù)據(jù)集包含12,767張不同類型和內(nèi)容的文檔圖像,以及超過50,000個相關(guān)問題和答案。InfographicVQA [[39]]數(shù)據(jù)集包含5,485張信息圖表圖像的多樣集合,總計有30,035個問題。ChartQA [[37]]數(shù)據(jù)集包括9,608個手工制作的問題,針對4,804個圖表,以及從17,141個圖表的人類書面摘要生成的23,111個問題。

關(guān)鍵信息提取(KIE)。我們進一步使用了KIE領(lǐng)域常見的三個數(shù)據(jù)集:SROIE [[19]]、FUNSD [[20]]和POIE [[25]]。SROIE [[19]]數(shù)據(jù)集包含1,000張掃描收據(jù)圖像,專門用于OCR和關(guān)鍵信息提取競賽,參與者需識別公司名稱、發(fā)行日期、地址和總支出等重要細節(jié)。FUNSD [[20]]數(shù)據(jù)集提供了199份真實、完全注釋的掃描表格,可能存在噪聲,因其實際應(yīng)用中的變化性和潛在模糊性而構(gòu)成獨特挑戰(zhàn)。POIE [[25]]數(shù)據(jù)集專注于英文產(chǎn)品營養(yǎng)成分標(biāo)簽,積累了包含111,155個文本實例的3,000張圖像,主要目標(biāo)是從這些標(biāo)簽中提取相關(guān)信息。

4.3. 結(jié)果

我們首先在上述問答數(shù)據(jù)集上將我們的方法與基線LMM進行比較,然后與先前的鏈?zhǔn)剿伎迹–oT)方法進行對比。

定量與基線LMM的比較

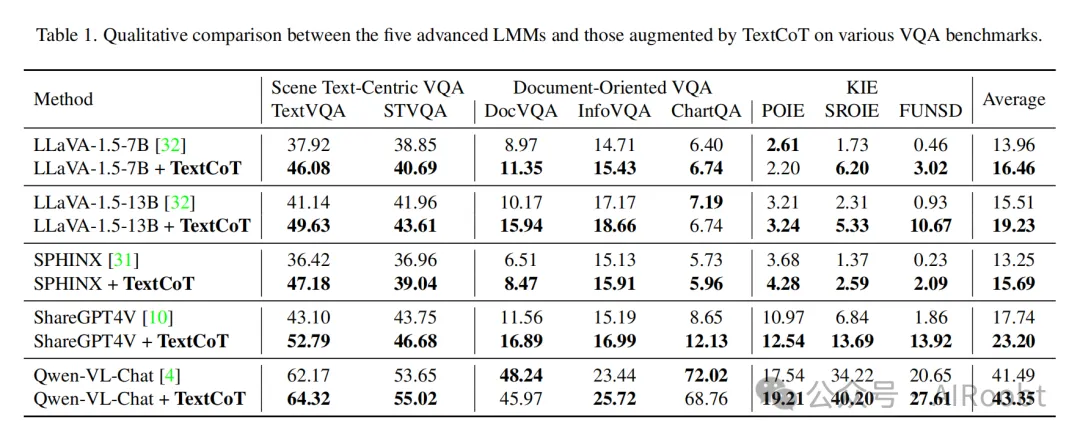

在表1中,我們評估了五種基線LMM的性能以及集成我們的TextCoT后的性能。評估的LMM涉及不同的模型規(guī)模、訓(xùn)練數(shù)據(jù)和架構(gòu)。

- 首先,我們的TextCoT顯著提高了幾乎所有八個數(shù)據(jù)集上五種先進LMM的性能。這一結(jié)果驗證了我們逐步審查局部細節(jié)以提供更準(zhǔn)確回答的想法。

- 其次,比較架構(gòu)相同但模型規(guī)模不同的LLaVA-1.5-7B [[32]]和LLaVA-1.5-13B [[32]],我們的TextCoT分別實現(xiàn)了平均精度提升2.51%和3.72%。值得注意的是,更大模型從我們的TextCoT中獲益更多。一個可能的解釋是,較大的模型具有更強的認(rèn)知和推理能力,從而帶來更大的效益。這一結(jié)論也在LLM領(lǐng)域內(nèi)得到證實[[56]]。

- 第三,將LLaVA-1.5-7B [[32]]與使用高質(zhì)量帶字幕數(shù)據(jù)但模型規(guī)模和架構(gòu)相同的ShareGPT4V [[10]]進行對比,我們的TextCoT分別產(chǎn)生了平均2.5%和5.46%的精度提升。這表明隨著模型中更好的圖文對齊和更高品質(zhì)的訓(xùn)練數(shù)據(jù),TextCoT的有效性增加。

- 最后,當(dāng)將TextCoT應(yīng)用于架構(gòu)和訓(xùn)練數(shù)據(jù)與上述LMM不同的Qwen-VL-Chat [[4]]時,大多數(shù)數(shù)據(jù)集上的性能有所改善。然而,在DocVQA [[38]]和ChartQA [[37]]數(shù)據(jù)集上觀察到了性能下降。這可歸因于Qwen-VL-Chat [[4]]在這些數(shù)據(jù)集上進行過訓(xùn)練,導(dǎo)致其對該提問風(fēng)格和圖像特征過分熟悉。因此,嘗試通過應(yīng)用TextCoT改變提問風(fēng)格時,觀察到了性能下滑。

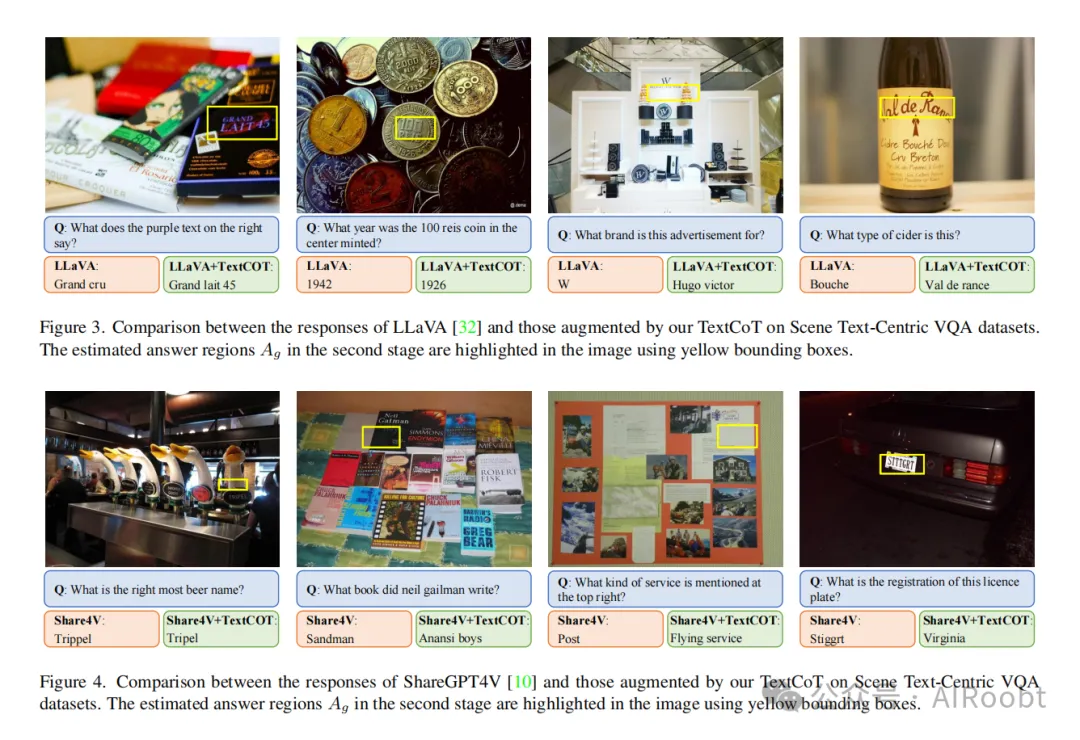

定性與基線LMM的比較

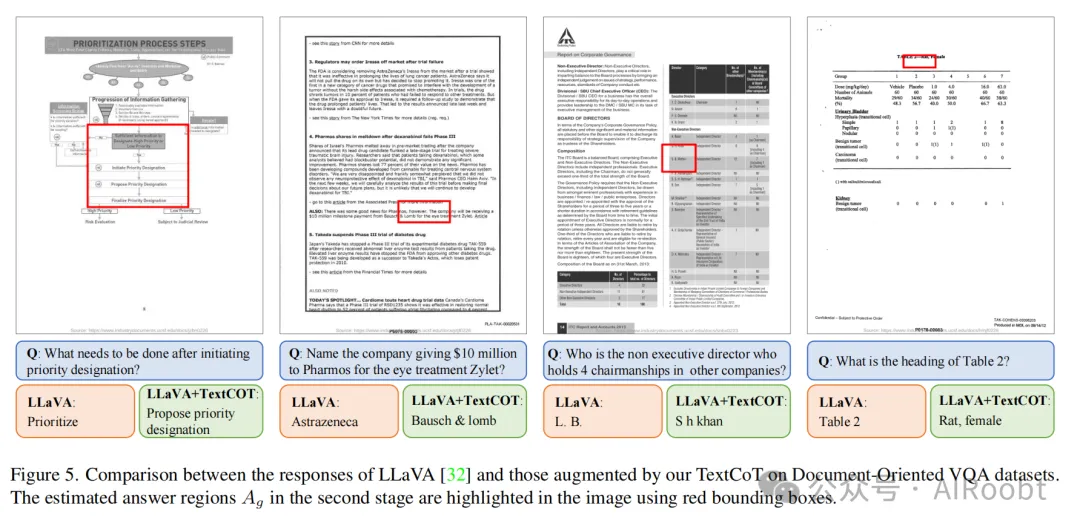

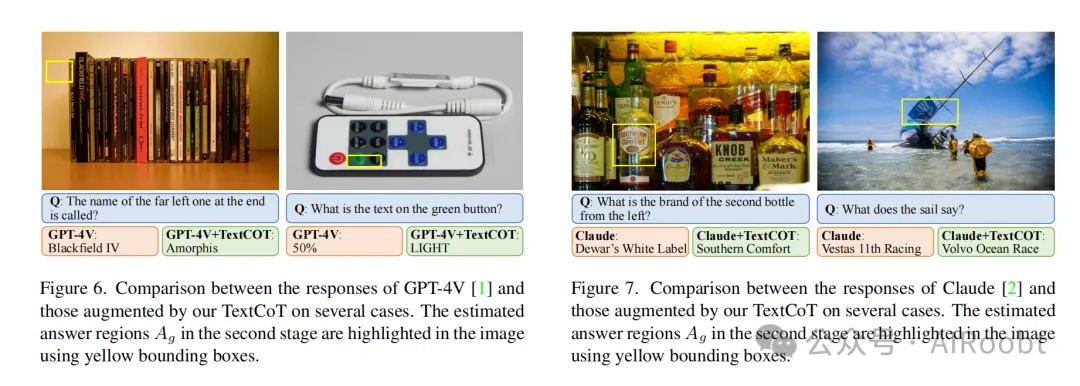

我們進一步進行了一系列定性對比。如圖3、圖4和圖5所示,我們展示了兩種基線LMM [[10, 32]] 的響應(yīng)以及集成TextCoT后的增強響應(yīng)。可以看出,我們的方法成功地逼近了圖像中的答案區(qū)域,并在場景文本和文檔場景中糾正了基線LMM的不準(zhǔn)確回答。此外,我們還在先進的GPT-4V [[1]] 和Claude 3 Opus [[2]] 模型上進行了實驗。如圖6和圖7所示,我們的TextCoT增強了這兩個模型的響應(yīng)準(zhǔn)確性。即使LMM提供的邊界框位置不準(zhǔn)確,我們的TextCoT方法也不受這種差異的影響。

與先前CoT方法的比較

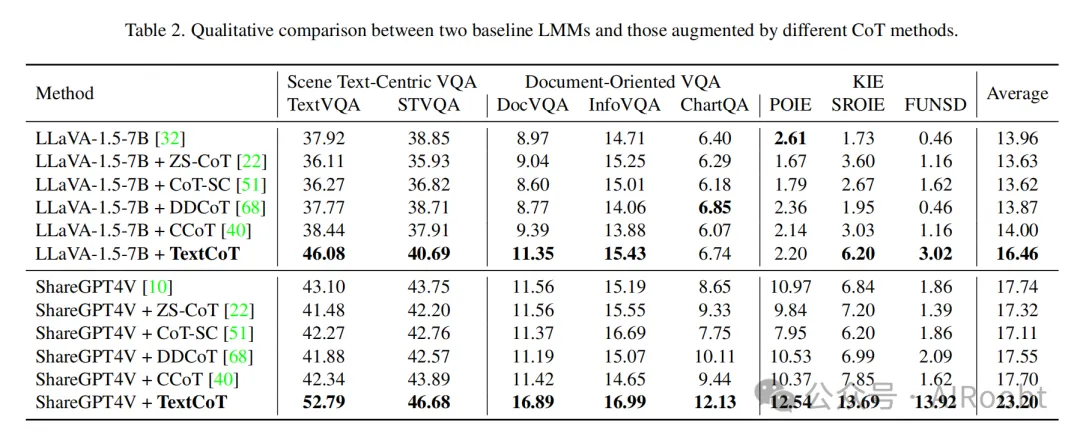

我們還基于LLAVA-1.5-7B [[32]]和ShareGPT4V [[10]]進行了現(xiàn)有CoT方法的性能比較。比較方法包括針對LLMs的ZS-CoT [[22]]和CoT-SC [[51]],以及針對LMMs的DDCoT [[68]]和CCoT [[40]]。ZS-CoT [[22]]、DDCoT [[68]]和CCoT [[40]]都包括兩個階段,其中ZS-CoT [[22]] 使用“讓我們一步一步思考”的方式。對于CoT-SC [[51]],我們采樣了5條鏈?zhǔn)剿伎纪评砺窂健?/p>

表2的結(jié)果表明,我們的方法顯著優(yōu)于這些方法。在富含文本的圖像場景中,這些方法未能提高性能,原因在于它們沒有解決對局部和細粒度視覺輸入的需求。相比之下,我們的方法有效地利用了大型多模態(tài)模型(LMMs)的字幕和定位能力,提取全局和局部信息以進行準(zhǔn)確回答。

消融研究

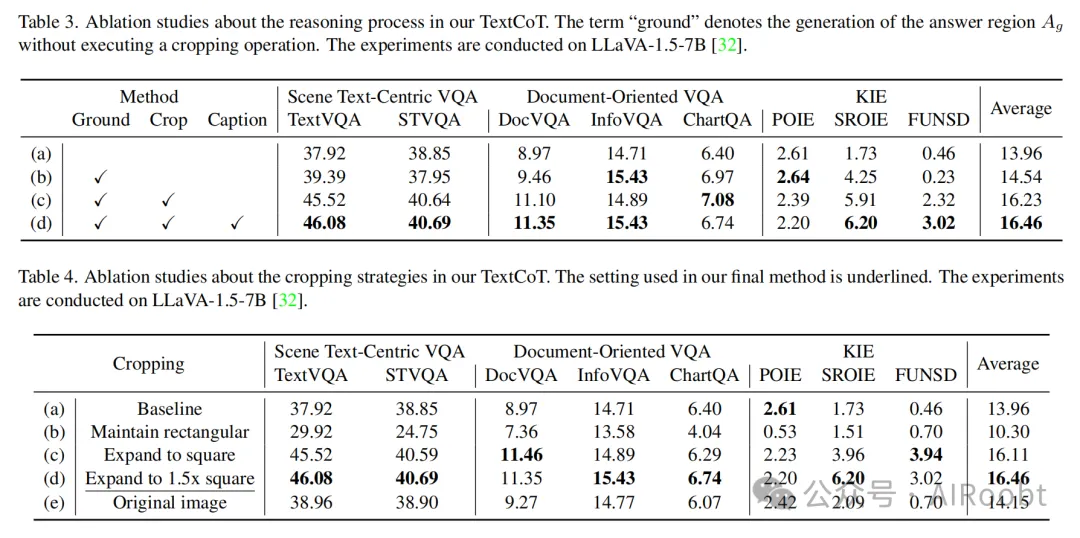

為了驗證我們提出的TextCoT三個階段的有效性,我們在表3和表4中進行了深入的消融實驗。所有消融實驗均基于經(jīng)典的LLaVA-1.5-7B [[32]]進行,并在八個問答數(shù)據(jù)集上評估性能。接下來討論結(jié)果。

粗定位的影響

我們首先評估了TextCoT的兩階段變體(表3(b)),第一階段預(yù)測一個定位答案\(A_g\),第二階段直接將\(A_g\)輸入LMM。與將圖像\(I_g\)和問題\(Q\)作為輸入的一階段基線方法(表3(a))相比,此變體表現(xiàn)更好。結(jié)果突顯了答案區(qū)域線索的重要性。然而,該變體并未充分利用答案區(qū)域提示,模型仍缺乏局部細粒度視覺輸入。

裁剪過程的影響

基于這個兩階段變體(表3(b)),我們進一步引入了圖像裁剪操作,使LMM能夠獲得詳細的局部信息。如表3所示,包含裁剪操作的方法(表3(c))表現(xiàn)更優(yōu)。在與文本相關(guān)的VQA任務(wù)中的顯著改進表明放大答案區(qū)域顯著增強了對局部細節(jié)的理解。

圖像概覽的影響

由于執(zhí)行裁剪操作后模型失去了全局上下文信息,只能從裁剪圖像\(I_l\)中提取局部信息。為了解決這個問題,我們加入了全局圖像的字幕,即我們的圖像概覽階段。如表3(d)所示,全球信息的補充進一步提升了性能。這種方法通過文字描述提供全局信息,同時利用局部圖像進行詳細局部信息的提取。這構(gòu)成了我們的最終TextCoT。

特定裁剪方法的影響

我們進一步對我們的裁剪策略進行了一系列消融研究。如表4所示,我們試驗了嚴(yán)格依據(jù)定位區(qū)域\(A_g\)裁剪(表4(b)),將邊界框按較長邊對齊擴展為正方形(表4(c)),將邊界框擴展為邊長為較長邊1.5倍的正方形(表4(d)),以及完全不裁剪(表4(e))。

實驗結(jié)果表明,我們的TextCoT配置(表4(d))展現(xiàn)出優(yōu)越的性能。這可以歸因于與其它裁剪設(shè)置相比,我們的配置保留了足夠的細粒度視覺信息,同時也避免了因裁剪不足而遺漏答案區(qū)域。這一結(jié)果也與我們的理念相符。

5. 局限性

我們進一步討論了TextCoT的局限性。首先,盡管我們的方法對模型定位能力中的錯誤顯示出一定的容忍度,但它并不適用于那些缺乏檢測能力的LMM。其次,在某些復(fù)雜的表格圖像中,答案經(jīng)常跨越多個不同的區(qū)域,這對模型的定位能力提出了更高的要求。探索如何為這類模型精確提取局部和細粒度的視覺特征是一個有意義的研究課題。第三,我們目前的評估局限于文本領(lǐng)域,從而限制了我們的發(fā)現(xiàn)向其他模態(tài)或領(lǐng)域的普遍適用性。雖然我們當(dāng)前的研究側(cè)重于文本相關(guān)任務(wù),未來的努力將旨在開發(fā)能在超越文本領(lǐng)域、適用于多種場景并提升性能的CoT方法。

6. 結(jié)論

本文介紹了TextCoT,這是一種針對增強LMM理解富含文本圖像能力而定制的新型鏈?zhǔn)剿伎伎蚣堋N覀兊姆椒ㄍㄟ^利用LMM的字幕生成和定位能力來提高富含文本圖像的問答準(zhǔn)確性,從而允許提取全局和局部的視覺信息。TextCoT與現(xiàn)有LMM架構(gòu)無縫集成,無需額外訓(xùn)練即可實現(xiàn)即插即用的功能。基于幾種先進LMM的多樣化富含文本圖像問答基準(zhǔn)測試的廣泛實驗,持續(xù)證明了我們TextCoT的有效性和強健的泛化能力。我們的工作朝著釋放LMM理解富含文本視覺數(shù)據(jù)的全部潛力邁出了重要的一步。未來,我們將專注于為甚至不具備定位能力的LMM開發(fā)方法,并增強它們理解更復(fù)雜場景的能力。

Luan B, Feng H, Chen H, et al. TextCoT: Zoom In for Enhanced Multimodal Text-Rich Image Understanding[J]. arXiv preprint arXiv:2404.09797, 2024.

University of Science and Technology of China, Merchants Union Consumer Finance Company Limited

本文轉(zhuǎn)載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/v-cT7pF8TC8_aQuEyWew5w??