大模型的訓練與調優,SFT(監督微調)和RLHF(基于人類反饋的強化學習)到底是什么? 原創

“ 大模型設計,訓練,微調,強化是一個系統性的過程”

大模型的訓練和調優是一個系統性的,復雜性的過程;為此,研究人員為大模型的訓練和微調設計了詳細的方案。

今天就是介紹一下大模型優化的兩個方法論,SFT——監督微調和RLHF——基于人類反饋的強化學習。

什么是SFT和RLHF?

下面是關于這兩個概念的簡單釋義:

SFT中文釋義為:一種通過監督學習進行模型微調的方法。

RLHF的釋義為:一種利用人類反饋進行強化學習的方法,該方法通過收集人類對模型輸出的反饋;然后使用這些反饋來優化模型的行為。說白了,不論是SFT還是RLHF的目的只有一個,那就是讓模型變得更好。

SFT——監督微調

監督微調的原理很簡單,就類似于學生上學,不論題目做的是對是錯,老是都會告訴你一個正確的結果,也就是答案。

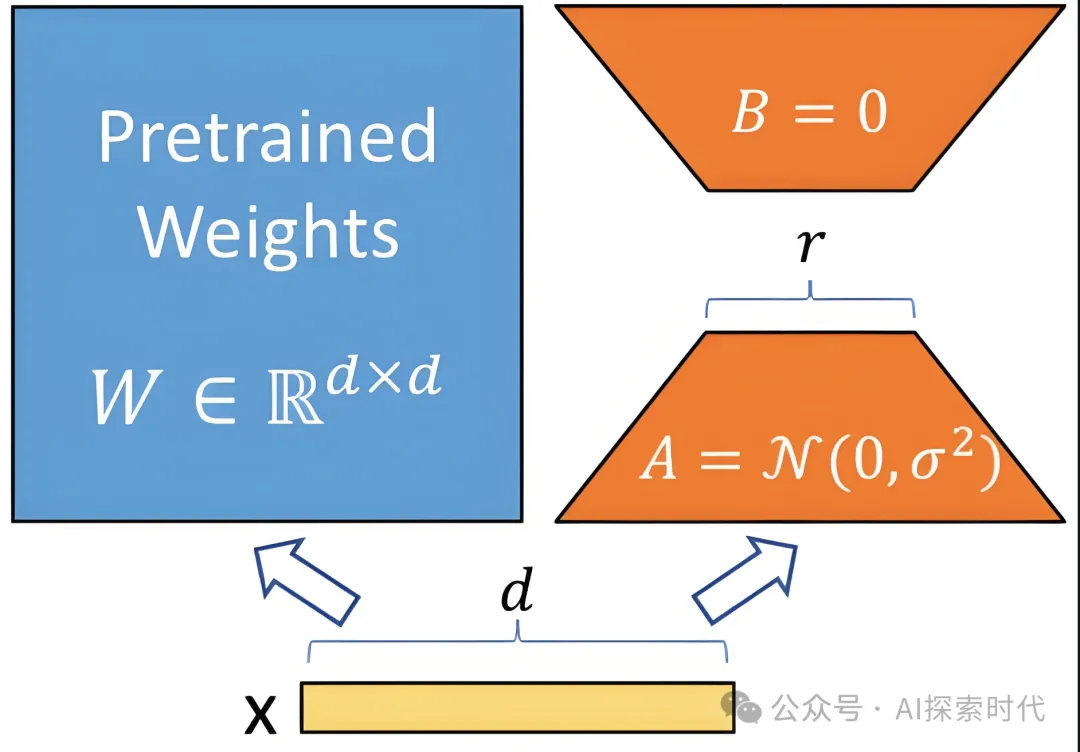

監督微調的做法就是,在大模型訓練或微調的過程中,把一部分數據打上“標簽”;也就是告訴大模型這些數據是什么東西。

比如,在CV(計算機視覺)領域,圖像識別的大模型在訓練的時候,會告訴大模型哪些圖片是人,哪些圖片是貓,哪些圖片是狗;而人,貓,狗就是數據的標注。

數據標注的展現形式很多,比如文件/文件夾名稱,數據與標注的對應關系等。

有了監督微調,大模型就知道自己在干什么,能干什么;還拿圖像識別舉例,監督微調之后大模型能夠識別,人類,貓和狗,但它識別不出來汽車和飛機。

如果想讓它識別汽車和飛機,那么就要在訓練或微調的數據中加入標注的汽車和飛機的圖片。

監督微調的應用領域比較廣泛,目前主流的大模型基本上都是采用的監督微調的方式,具體的領域包括文本分類,情感分析等。

SFT適用于有明確任務目標和大量標注數據的任務。

RLHF——基于人類反饋的強化學習

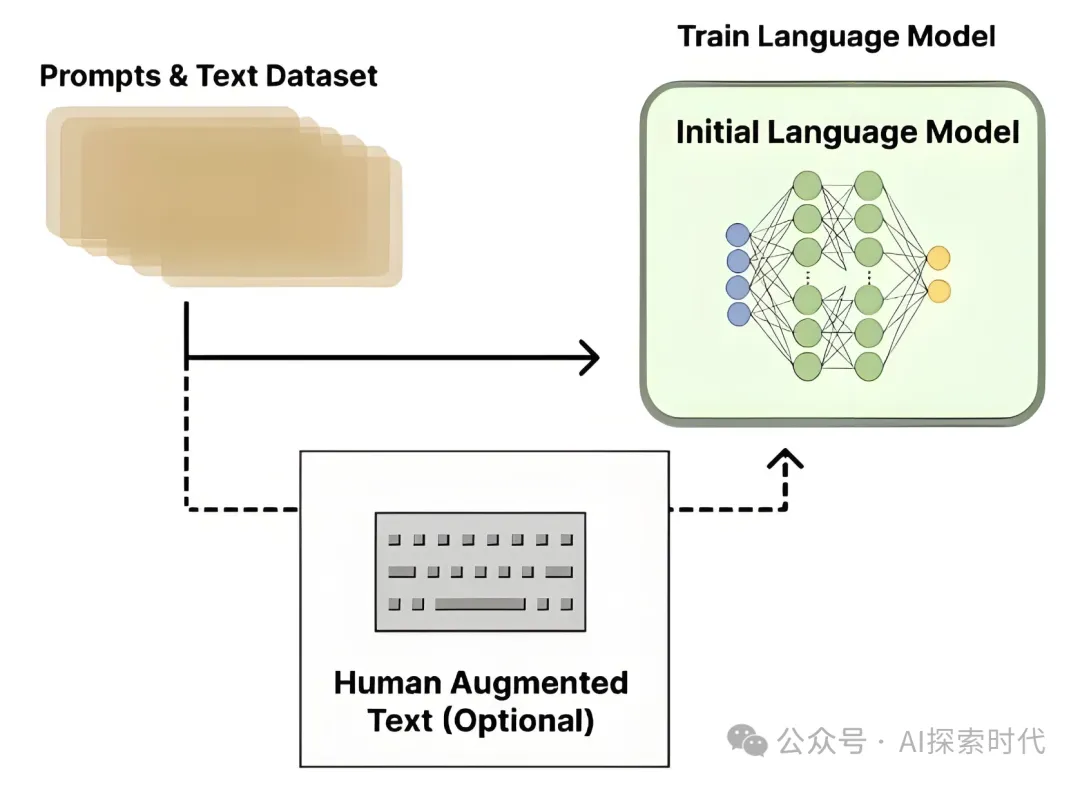

RLHF應該算是兩種東西的結合,RL(強化學習)和HF(人類反饋);強化學習是機器學習中的一種方法,強化學習有多種方式,而基于人類反饋的方式就叫做RLHF。

其實RLHF屬于模仿人類行為學的一種方式,比如我們不論在工作或生活中做一件事總喜歡得到夸獎或贊美,這樣我們就會想辦法把事情做的更好。

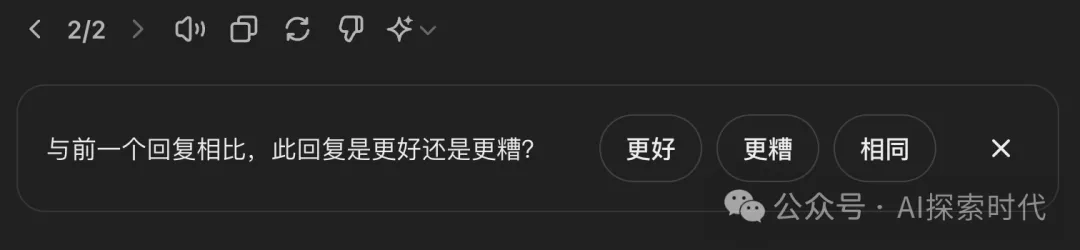

從技術角度來說,RLHF需要不斷收集用戶反饋,比如好與壞,評分等;然后根據這些反饋訓練一個獎勵模型,該模型用來評價模型等輸出質量。

然后使用強化學習算法,如PPO優化語言模型,使其輸出能夠最大化獎勵模型。

而從應用的角度來說,RLHF主要應用于對話,內容生成等領域;比較典型的就是我們在使用一些第三方模型時,會彈出讓我們評價的按鈕,比如chatGPT。

目前chatGPT的能力不斷加強,除了其技術架構方面的原因之外,還有一部分是基于強化學習的方式來優化其模型。

SFT與RLHF的異同點

說起SFT和RLHF的共同點,那它們的共同點很簡單,那就是通過不同的方式讓模型變得更好。

還有就是兩者都是基于數據驅動,或者說大模型都屬于數據驅動;SFT需要標注的數據,而RLHF需要人類反饋的數據。

至于不同點,最明顯的特征有兩個,第一個就是兩者的實現原理不同,SFT使用的是監督學習算法,而RLHF使用的是強化學習算法。小程序

其次,就是兩者的應用場景不太相同;SFT適用那種有著明確任務目標的任務,比如說分類;而RLHF適用于那種需要不斷升級優化的系統,比如客服系統,問答系統等。

從兩者的應用角度來說,選擇SFT方法的企業較多,使用RLHF的企業相對較少。

并不是說RLHF技術比SFT的差,而是目前的人工智能生態還無法大規模使用RLHF,一是因為應用場景較少,二是技術要求和成本較高。

本文轉載自公眾號AI探索時代 作者:DFires