檢索增強型多模態思維鏈推理用于大型語言模型 原創 精華

?摘要:大型語言模型(LLMs)的進步使得思維鏈(Chain of Thought,CoT)方法受到了極大的關注,主要是因為它能夠增強LLMs在復雜推理任務上的能力。此外,CoT方法的重要性還擴展到了將LLMs應用于多模態任務。然而,由于多模態樣本固有的復雜性,為多模態推理選擇最優CoT示例的問題在LLMs中尚未得到充分探索。在本文中,我們介紹了一種新穎的方法,通過使用檢索機制來動態且自動地根據跨模態和內模態相似性選擇示例,從而解決這一挑戰。此外,我們采用了分層抽樣方法,將示例根據類型分類成不同組,然后分別從不同組中檢索示例,以促進示例的多樣性。通過在兩個流行的基準數據集上進行一系列實驗:ScienceQA和MathVista,我們證明了我們的方法顯著提高了GPT-4在ScienceQA上的性能6%,在MathVista上的性能12.9%,并且在兩個數據集上提高了GPT-4V的性能2.7%,大幅提高了最先進LLMs和LMMs在復雜多模態推理任務上的性能。

1. 引言

自然語言處理(NLP)領域由于大型語言模型(LLMs)的出現而經歷了顯著的進步,這些模型憑借其廣泛的能力重塑了許多任務的格局。一個對LLMs成功貢獻很大的關鍵技術是鏈式思維(CoT)技術,這在先前的研究中已有記載(Wei et al., 2022a; Kojima et al., 2022)。這種技術在應用于多模態任務時尤其重要。其最突出的應用之一是多模態問答,這涉及文本和圖像的推理(Zhang et al., 2023c; Lu et al., 2023b; Lyu et al., 2023; Li et al., 2023e)。然而,隨著研究人員進一步探索CoT與LLMs的整合(Wang et al., 2022; Zhou et al., 2022; Zhang et al., 2022),選擇合適的示例來指導多模態推理成為一個反復出現的挑戰。由于多模態示例通常結合了文本和視覺數據的復雜性,識別最相關和最有信息量的示例是一項艱巨的任務(Bar et al., 2022; Li et al., 2023b,a)。

為了解決這個問題,我們的論文提出了一種新方法,利用檢索機制動態且自動地選擇示例。如圖1所示,我們的方法檢索到的相關且有信息量的示例可以激發LLMs的推理能力,進而得出正確答案。圖3展示了我們提出的方法概覽。我們的方法主要利用了跨模態相似性和模態內相似性。我們利用這些相似性來檢索示例,以期通過更相關的示例增強CoT在多模態任務上的推理過程(Zhang et al., 2023a; Sun et al., 2023)。為了確保選擇的示例更全面和多樣化,我們創新性地使用了分層抽樣(Liberty et al., 2016)。這種簡單但有效的方法按順序根據檢索樣本所屬的組進行抽樣。通過從不同組中抽樣,我們旨在為LLMs提供多樣化的示例,從而提高多模態推理的整體質量。

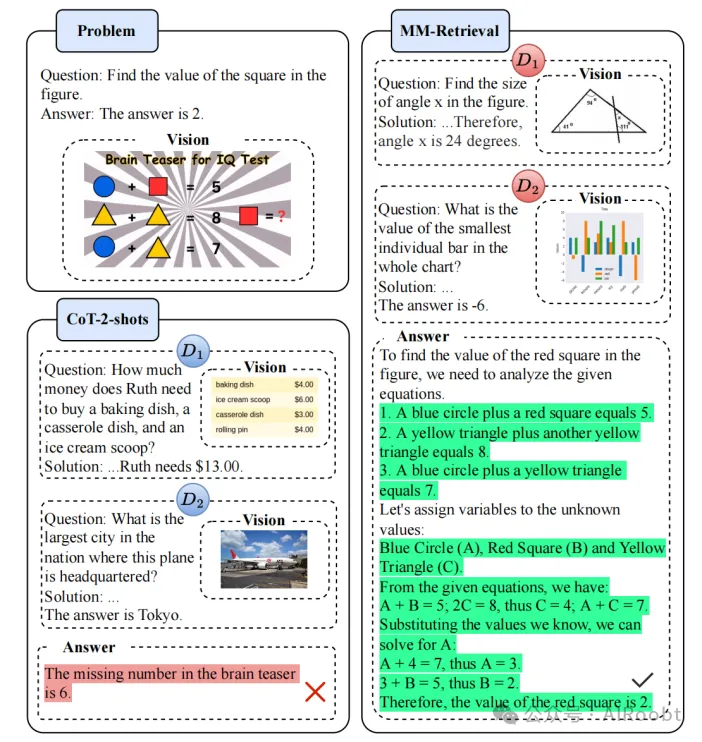

圖1:我們的MM-Retrieval方法根據問題動態檢索示例。與CoT相比,它具有更好的適應性,能夠激發LLMs的推理能力。紅色的D1、D2表示根據問題檢索到的示例,而藍色的D1、D2表示不考慮問題的固定示例。

(圖片說明:- 左上角(Problem):提出了一個問題,要求找出圖中正方形的值,答案是2。

- 左下角(CoT-2-shots):展示了傳統的鏈式思維(CoT)方法,使用了兩個固定的示例(D1和D2),無論問題是什么,這些示例都不會變化。圖中紅色的D1和D2分別代表了固定的示例:

- D1示例:計算購買烤盤、冰激凌勺和砂鍋盤所需的錢數。

- D2示例:找出國家中飛機總部所在城市的最大城市,答案是東京。

- 右側(MM-Retrieval):展示了我們的方法如何動態地基于問題檢索示例:

- D1示例:計算圖中角度x的大小。

- D2示例:找出圖表中最小的獨立條的值。

在MM-Retrieval方法中,這些檢索到的示例被整合到提示和測試問題中,作為LLMs的輸入。圖中綠色高亮部分顯示了解決問題的詳細過程,包括將圖中的形狀賦值并通過方程求解,最終得出答案為2。

圖例說明:

- 紅色的D1、D2表示根據問題動態檢索到的示例。

- 藍色的D1、D2表示無論問題如何變化都固定的示例。

圖1的文字說明強調了MM-Retrieval方法的動態適應性和對LLMs推理能力的刺激效果,優于傳統的固定示例方法。)

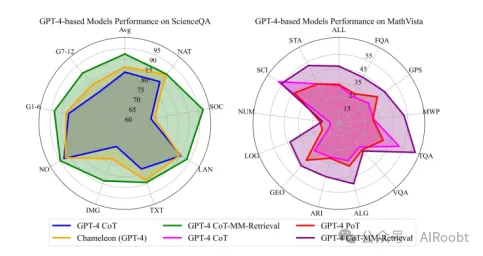

為了評估我們提出的方法的有效性,我們在兩個基準多模態問答數據集ScienceQA(Lu et al., 2022)和MathVista(Lu et al., 2023a)上進行了廣泛的實驗。這些實驗表明,我們的方法大大提高了LLMs的性能,在多模態推理任務上建立了新的最先進水平。如圖2所示,在ScienceQA和MathVista數據集上,我們的方法顯示了顯著的改進。對于ScienceQA數據集,基于ChatGPT和GPT-4的檢索方法分別比最先進的Chameleon高出4.8%和4.4%。隨著更多示例的加入,基于ChatGPT和GPT-4的方法的最佳性能可以達到86.4%和92.5%。對于GPT-4V,我們的方法相較于零樣本設置可以實現2.7%的平均準確率提升。

圖2:在ScienceQA(Lu et al., 2022)和MathVista(Lu et al., 2023a)的不同類別上的結果。我們提出的方法在GPT-4基礎模型上相比于之前的基線模型,包括CoT(Lu et al., 2023b)、PoT(Lu et al., 2023a)和Chameleon(Lu et al., 2023b),取得了顯著的提升。

此外,我們的方法在MathVista數據集上也表現出優越的性能。基于ChatGPT和GPT-4的方法分別獲得了8.4%和13.6%的顯著提升。此外,我們的方法還可以進一步提升最先進的LLM - GPT-4V的性能,使其在MathVista上的整體準確率提高2.7%,這證明了我們方法的有效性。

我們還對我們方法的各部分貢獻進行了全面的實驗,包括視覺信息、檢索機制和分層抽樣。此外,我們還進行了詳細的分析,研究了不同數量的示例對結果的影響,提供了我們的方法在多模態任務中與LLMs協同工作的寶貴見解。

2. 相關工作

2.1 檢索增強生成(RAG)用于LLMs

檢索增強生成(RAG)代表了通過整合外部知識源來增強模型生成能力的重要進展。早期的工作如REALM(Guu et al., 2020)和RAG(Lewis et al., 2020)介紹了將外部文檔融入生成過程的基礎方法。后續研究將檢索增強范式擴展到多模態環境,如MuRAG(Chen et al., 2022)和REVEAL(Hu et al., 2022),它們利用來自外部來源的文本和視覺信息來增強語言生成。此外,最近的研究如FiD-Light(Hofst?tter et al., 2022)和REPLUG(Shi et al., 2023)則集中于提高檢索增強系統的效率和效果,以及探索上下文中的檢索增強機制(Ram et al., 2023;de Jong et al., 2023)。

2.2 上下文學習(ICL)

上下文學習(ICL)利用LLMs在嵌入上下文中的少量示例基礎上完成任務(Devlin et al., 2019;Radford et al., 2019;Brown et al., 2020;Chowdhery et al., 2022),在NLP和復雜的數學推理中顯示出效果(Wei et al., 2022b)。ICL的設置包括使用任務指導和示例生成LLMs的響應。它對提示結構、示例選擇和示例順序敏感(Zhao et al., 2021;Wang et al., 2023a;Fu et al., 2022)。ICL的應用擴展到多模態任務,包括圖像分割、合成和文本到語音合成(Bar et al., 2022;Wang et al., 2023b,c,e;Tsimpoukelli et al., 2021;Alayrac et al., 2022),并在圖結構等結構化空間中顯示出潛力(Huang et al., 2023)。

2.3 鏈式思維推理(CoT)

鏈式思維(CoT)推理指導LLMs逐步推理,提高了在算術、符號和邏輯任務上的性能(Wei et al., 2022b;Kojima et al., 2022)。方法包括采樣多個推理路徑(Wang et al., 2022),將復雜問題劃分為子問題(Zhou et al., 2022),以及動態選擇用于少樣本提示的示例(Zhang et al., 2022;Shi et al., 2022)。除了文本數據,CoT還適用于表格數據(Ziqi和Lu, 2023)。此外,其潛力在多模態環境中得到了探索,通過語言和視覺的融合展示了增強的推理能力(Zhang et al., 2023c;Lu et al., 2023b,c)。研究如(Zhang et al., 2023c)提出了一個兩階段的CoT框架,用于多模態任務,顯著提高了在ScienceQA等基準上的推理準確性。Chameleon(Lu et al., 2023b)引入了插拔式模塊,用于大型多模態模型(LMMs),通過結合不同的工具實現復雜推理。

3. 方法

我們的方法基于CoT上下文學習范式,旨在有效利用LLMs。對于每個輸入查詢,我們希望利用一組相關的CoT示例來增強LLM的推理能力。為此,我們引入了一種新方法,使用檢索機制動態且自動地選擇示例,并將視覺知識融入提示中。圖4詳細說明了我們的方法。我們方法的核心是提取跨模態相似性和模態內相似性,在測試問題q的文本上下文qt和視覺上下文qv與示例池Q={q1,...,qn}中的示例之間進行交叉比較。我們方法的另一個獨特特征是引入了分層抽樣。通過根據示例的固有屬性將其分類為不同組,我們旨在擴展所選示例的多樣性。從不同組中檢索示例確保LLMs接收到多方面的示例,從而增強多模態推理的魯棒性。

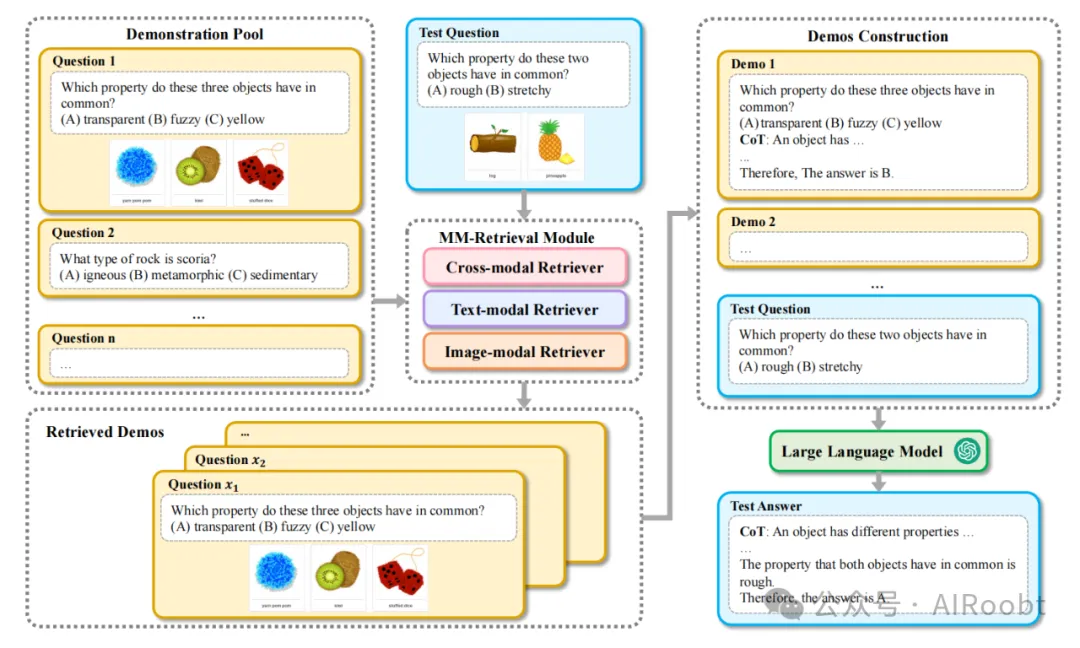

圖3:我們提出的多模態檢索方法概述。我們采用了跨模態檢索和內模態檢索(文本模態和圖像模態檢索),從示例池中獲取相關的示例作為檢索示例。然后,這些檢索到的示例與提示和測試問題集成在一起,作為LLMs的輸入。

(注釋:1. 示例池(Demonstration Pool):

- 包含多個問題及其選項和相關圖像。例如,問題1是“以下三種物體有哪些共同的屬性?”,選項包括透明、毛茸茸、黃色,并附有對應的圖像。

2. 測試問題(Test Question):

- 包含待回答的問題及其選項和相關圖像。例如,測試問題是“以下兩種物體有哪些共同的屬性?”,選項包括粗糙和有彈性,并附有對應的圖像。

3. MM-檢索模塊(MM-Retrieval Module):

- 包括三個檢索器:跨模態檢索器(Cross-modal Retriever)、文本模態檢索器(Text-modal Retriever)和圖像模態檢索器(Image-modal Retriever)。

- 這些檢索器根據測試問題從示例池中動態檢索相關的示例。

4. 示例構建(Demos Construction):

- 構建檢索到的示例集,包括從示例池中檢索到的具體問題及其答案。例如,Demo 1的問題是“以下三種物體有哪些共同的屬性?”,答案是黃色。

5. 檢索到的示例(Retrieved Demos):

- 包括檢索到的多個示例問題及其相關信息。

6. 大型語言模型(Large Language Model):

- 將測試問題、檢索到的示例和提示結合起來輸入到大型語言模型中,以生成最終答案。

7. 最終答案(Test Answer):

- 生成包含推理過程的最終答案。例如,最終答案是“兩個物體的共同屬性是粗糙的,因此答案是A”。

通過這種方法,我們能夠動態檢索和集成相關示例,從而提升LLMs在多模態任務中的推理能力。)

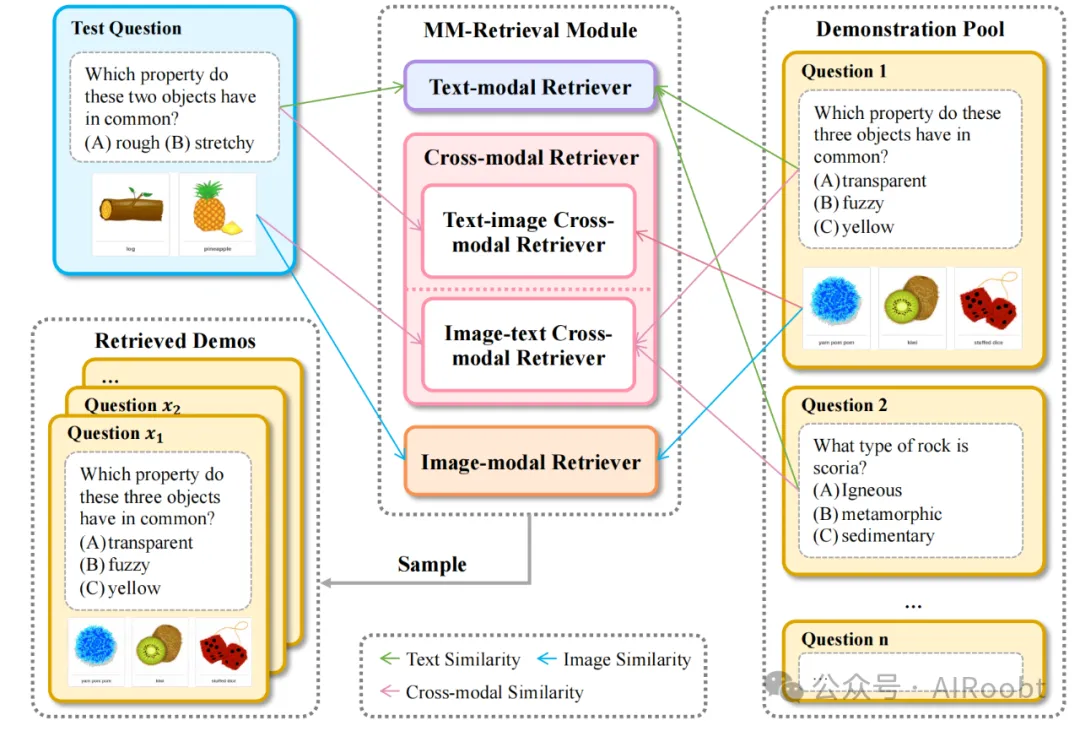

圖4:我們多模態檢索方法的詳細說明,其中我們使用模態內相似性和跨模態相似性從示例池Q中抽樣示例D。

(注釋:1. 測試問題(Test Question):

- 包含待回答的問題及其選項和相關圖像。例如,測試問題是“以下兩種物體有哪些共同的屬性?”,選項包括粗糙和有彈性,并附有對應的圖像(例如木頭和菠蘿)。

2. MM-檢索模塊(MM-Retrieval Module):

- 包括四個檢索器:

- 文本模態檢索器(Text-modal Retriever):基于文本相似性檢索相關的文本示例。

- 跨模態檢索器(Cross-modal Retriever):包括文本-圖像跨模態檢索器(Text-image Cross-modal Retriever)和圖像-文本跨模態檢索器(Image-text Cross-modal Retriever),基于跨模態相似性檢索相關示例。

- 圖像模態檢索器(Image-modal Retriever):基于圖像相似性檢索相關的圖像示例。

3. 示例池(Demonstration Pool):

- 包含多個問題及其選項和相關圖像。例如,問題1是“以下三種物體有哪些共同的屬性?”,選項包括透明、毛茸茸、黃色,并附有對應的圖像;問題2是“火山渣是哪種類型的巖石?”,選項包括火成巖、變質巖、沉積巖。

4. 檢索到的示例(Retrieved Demos):

- 包括檢索到的多個示例問題及其相關信息。例如,檢索到的問題1是“以下三種物體有哪些共同的屬性?”,選項包括透明、毛茸茸、黃色,并附有對應的圖像。

圖示中不同顏色的箭頭表示不同類型的相似性:

- 綠色箭頭表示文本相似性(Text Similarity)。

- 藍色箭頭表示圖像相似性(Image Similarity)。

- 粉色箭頭表示跨模態相似性(Cross-modal Similarity)。

通過這些檢索器,我們可以從示例池中動態地抽樣相關的示例D,這些示例將與測試問題結合,作為輸入提供給大型語言模型(LLMs),從而提升模型在多模態任務中的推理能力。)

3.1 將視覺信息納入LLMs

我們的方法適用于LLMs和LMMs,我們的任務是包含圖像和相應文本問題的多模態問答任務。對于LLMs來說,如果不通過輔助視覺專家模型將圖像模態轉換為文本模態,很難正確回答。因此,LLM通過視覺信息模型獲取問題的視覺信息非常重要。按照Chameleon和MathVista的實現,我們的視覺信息模型主要包括兩部分:

- 圖像描述:我們使用圖像描述模型獲取給定圖像的文本描述。圖像描述結果表示為{Vc},它是表示圖像主要內容的文本片段。

- 光學字符識別(OCR):除了圖像描述系統,我們還使用OCR系統識別給定圖像中的文本字符,檢測到的文本表示為{Vo}。

因此,我們使用的視覺信息表示為V={Vc, Vo},這是生成的圖像描述和OCR系統檢測到的文本的連接。

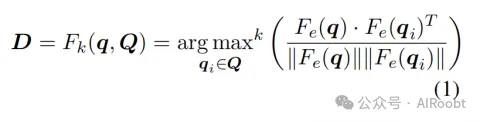

3.2 檢索機制

假設我們有一個待回答的測試示例q,它包括視覺上下文qv(通常是圖像)和文本上下文qt(通常是問題描述)。Q中的每個問題與q具有相同的組成部分,所以qi={qvi, qti},其中qi∈Q。同時,我們還有一個多模態問題集合Q={q1,...,qn},我們可以從中收集示例幫助LLM回答測試示例q。使用檢索函數,從Q中提取示例形成檢索到的示例集D。一般的檢索過程可以表示為:

其中,Fe表示用于編碼q的編碼器模型,Fe(q) ∈ R1×h 和 Fe(qi) ∈ R1×h。k表示我們從Q中采樣與q具有最大余弦相似性的前k個示例。然后,采樣的前k個示例作為示例。

具體來說,考慮到多模態設置中檢索的復雜性,我們通過分別使用qv和qt從Q中檢索示例來擴展公式1:

公式中的Fk1(qv, Qv)表示我們根據Fe(qv) R1×h和Fe(qiv) R1×h之間的余弦相似性,從 Q中檢索前k1個示例,這表示測試問題q 的視覺上下文與示例池中的示例 qi 之間的比較,其他同理。需要注意的是, k = ∑i=14 ki 。公式2右側的前兩個項表示基于模態內相似性的檢索,而后兩個項表示跨模態檢索。Fe可以是任何適當的編碼器,用于獲取qt(文本編碼器)和qv(視覺編碼器)的嵌入。

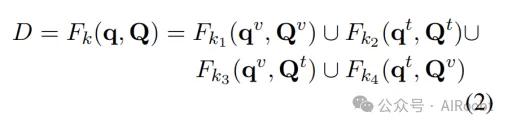

3.3 抽樣方法

此外,為了在我們的示例中保持多樣性和相關性,我們采用了分層抽樣(Liberty et al., 2016)。這種方法允許我們從基于跨模態和模態內相似性檢索到的四個組中抽樣示例。為了簡化,我們將Fk1(qv, Qv)簡化為DI2Ik1,Fk2(qt, Qt)簡化為DT2Tk2,Fk3(qv, Qt)簡化為DI2Tk3,Fk4(qt, Qv)簡化為DT2Ik4。分層抽樣過程S如下:

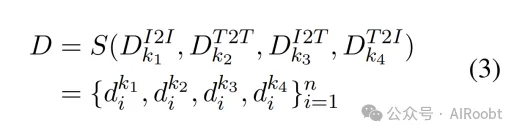

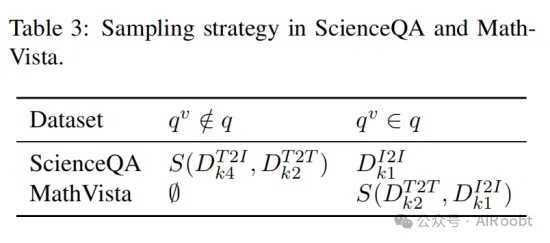

其中,dk1i ∈ DI2Ik1,dk2i ∈ DT2Tk2,dk3i∈ DI2Tk3,dk4i∈ DT2Ik4。此外,為了適應多模態數據的不同復雜特性(例如不同領域的示例具有不同的性質),我們提出在處理不同類型問題q時自適應使用分層抽樣。具體來說,我們使用經驗函數σ來決定是否采用分層抽樣(即σ可以是開發集上的性能Δ或其他啟發式方法)。詳細的抽樣策略如表3所示。

3.4 最終預測

通過檢索到的示例,我們的下一步是預測給定測試問題q的最終答案。為此,我們將測試問題q與檢索到的示例集D以及視覺信息V結合起來。目標是為LLM提供一個包含初始問題和相關示例見解的豐富上下文。問題和示例的結合可以表示為V ⊕ D ⊕ q,這是LLM的提示。當我們將這個提示輸入LLM時,我們得到最終結果:

Answer = λ(V ⊕ D ⊕ q)

在這個公式中,λ代表LLM的預測過程。這個最終預測步驟至關重要,因為它體現了我們建立的整個過程。它確保LLM考慮到原始問題和示例集中的額外信息,以生成一個信息豐富且準確的答案。

4. 實驗

4.1 實驗設置

數據集

在實驗中,我們使用了兩個用于多模態CoT推理的基準數據集:

1. ScienceQA (Lu et al., 2022):這是一個綜合性基準數據集,旨在評估大型語言模型的多模態推理能力。

2. MathVista (Lu et al., 2023a):這個數據集用于評估LLMs和LMMs在視覺上下文中的數學推理能力。

模型

在實驗中,我們通過OpenAI API使用了ChatGPT (OpenAI, 2022)、GPT-4 (OpenAI, 2023)和GPT-4V (OpenAI, 2023)。我們使用了GPT-3.5-TURBO作為ChatGPT的版本,而GPT-4用于GPT-4。對于GPT-4V的評估,我們使用了GPT-4-VISION-PREVIEW。

實現細節

用于編碼CoT示例的文本和視覺上下文的TEXT-ENCODER和VISUAL-ENCODER是預訓練在大規模語料和圖像上的模型。具體來說,對于模態內相似性,我們分別使用SentenceBERT (Reimers and Gurevych, 2019)和ViT (Dosovitskiy et al., 2021) (ViT-base-patch16-224)來編碼文本和圖像。對于跨模態相似性,我們使用CLIP (Radford et al., 2021)來編碼文本和圖像。具體而言,我們遵循了Chameleon的方法,將元數據和知識檢索結果與當前問題連接起來作為我們的基線。我們的方法基于此基礎進一步開發了基于文本的問題方法。為了整合視覺上下文,我們分別使用BLIP (Li et al., 2023c)和GPT-4V (OpenAI, 2023)為ScienceQA和MathVista獲取圖像描述。我們選擇了ScienceQA的訓練集作為示例池。至于MathVista,我們在test-mini上評估了性能。由于測試集沒有發布答案且數量較多,我們選擇使用它作為示例池。由于MathVista的測試集中沒有答案或推理過程,我們使用GPT-4V零樣本的響應作為推理的基礎。具體來說,對于GPT-4V MM-Retrieval,我們的文本提示與LLMs相同,但我們會在文本提示后添加問題的圖像。

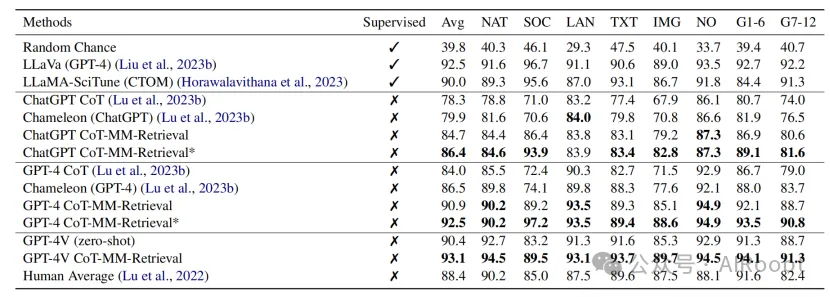

表1:ScienceQA上的實驗結果(Lu 等,2022)。我們通過與各種基線模型(包括監督和非監督模型)進行比較來評估系統的性能。結果表明,我們提出的CoT-MM-Retrieval方法在平均準確率和幾乎所有問題類別上都優于之前的最先進模型。需要注意的是,*表示我們方法的最佳結果,此時我們使用了更多的示例。

4.2 結果

在我們針對ScienceQA數據集(Lu et al., 2022)進行的實驗中,如表1所示,對各種模型在不同問題類型上的性能進行了評估。基線模型的結果取自ScienceQA排行榜2,在這里我們根據是否明確在ScienceQA訓練集上進行訓練來區分監督系統和無監督系統。我們的方法稱為CoT-MM-Retrieval,使用了兩個示例,提供了與Chameleon(Lu et al., 2023b)公平的比較,而CoT-MM-Retrieval*表示我們在更多示例情況下的最佳性能。

對于基于ChatGPT的模型:

1. Chameleon (ChatGPT)(Lu et al., 2023b)略微超過了基礎ChatGPT CoT,平均準確率為79.9%。

2. 我們的方法ChatGPT CoT-MM-Retrieval基于檢索增強的ChatGPT,平均準確率達到了84.7%,比之前的最先進Chameleon高出4.8%。

3. 其中,ChatGPT CoT-MM-Retrieval*取得了最佳性能,平均得分為86.4%。

對于基于GPT-4的模型:

1. Chameleon (GPT-4)(Lu et al., 2023b)作為之前的最先進模型,平均得分為86.5%。

2. 我們的方法GPT-4 CoT-MM-Retrieval*超過了Chameleon (GPT-4) 6%,平均得分達到了92.5%。它在SOC和NO等問題類型上設立了新的最先進水平,得分分別為97.2%和94.9%。

對于基于GPT-4V的模型:

我們的方法GPT-4V CoT-MM-Retrieval利用了問題圖像,其平均得分比零樣本的GPT-4V高出2.7%,表明我們的方法不僅適用于LLMs,也適用于LMMs。

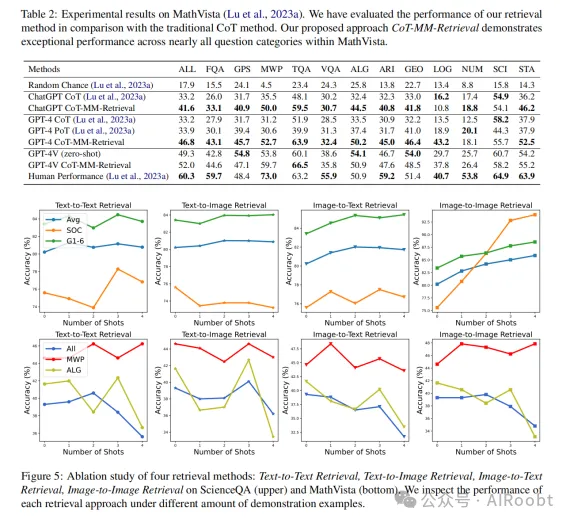

在我們針對MathVista數據集(Lu et al., 2023a)進行的實驗中,如表2所示,我們的方法稱為CoT-MM-Retrieval,使用了兩個示例,提供了與CoT和PoT公平的比較。

對于基于ChatGPT的模型:

我們的方法ChatGPT CoT-MM-Retrieval比ChatGPT CoT高出8.4%,平均得分為41.6%。

對于基于GPT-4的模型:

我們的方法GPT-4 CoT-MM-Retrieval分別比ChatGPT CoT和ChatGPT PoT高出13.6%和12.9%。

對于基于GPT-4V的模型:

我們的方法GPT-4V CoT-MM-Retrieval在零樣本的平均得分上比GPT-4V高出2.7%,在14個指標中有8個超過了零樣本。值得注意的是,在MathVista,由于數學問題的難度,目前的GPT-4V在平均得分上無法超過人類。

4.3 消融研究

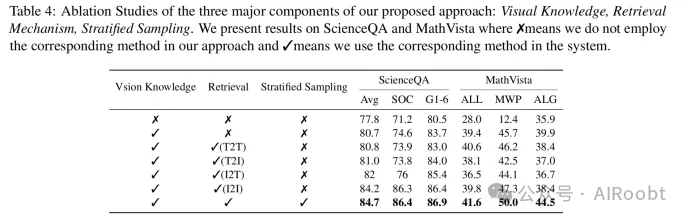

我們對不同檢索方法和示例數量(少樣本學習中的shots)在方程2中的影響進行了分析。結果如圖5所示。

我們探討了四種檢索方法:1)文本到文本(T2T),2)文本到圖像(T2I),3)圖像到文本(I2T),4)圖像到圖像(I2I),并隨著示例數量的增加(從0到4,分別為k1, k2, k3, k4)研究其對模型性能的影響。提供了不同問題類型的性能指標,使我們能夠辨別不同類別中的模式和變化。圖5的結果首先表明,在上下文中添加示例可以提高整體準確率,特別是在ScienceQA和MathVista中。從圖5中我們還可以觀察到:

1. 文本到文本檢索(T2T):隨著示例數量的增加,T2T檢索的準確率在ScienceQA上保持相對穩定,平均準確率在80.8%到81.3%之間。而在MathVista上,平均準確率在35.6%到40.6%之間。該方法的最高準確率是在ScienceQA上使用1個示例(81.3%)和在MathVista上使用2個示例(40.6%)時達到的,這表明增加更多示例并不總能保證性能提升。

2. 文本到圖像檢索(T2I):其表現與T2T類似,在ScienceQA上的平均準確率在80.4%到81%之間,在MathVista上的平均準確率在36.2%到40.1%之間。對于這種方法,最高準確率是在ScienceQA上使用2個示例(81%)和在MathVista上使用3個示例(40.1%)時達到的。

3. 圖像到文本檢索(I2T):該方法的準確率變化比前兩種略大,在ScienceQA上的準確率在81.4%到82%之間,在MathVista上的準確率在31.7%到38.8%之間。這里,2個示例在ScienceQA上提供了最佳平均表現(82%),而在MathVista上使用1個示例時(38.8%)達到了最高準確率。

4. 圖像到圖像檢索(I2I):這種方法在MathVista上的表現與文本到文本檢索相似,平均準確率在34.8%到39.8%之間。該方法的最高準確率是在使用2個示例(39.8%)時達到的。在ScienceQA上,這種檢索方法展示了最有趣的趨勢。隨著示例數量的增加,準確率顯著提高,從1個示例時的82.8%提高到4個示例時的85.9%。在ScienceQA上,G1-6類型的表現始終很好,準確率通常在84%以上。

檢索方法的選擇和示例數量在確定模型性能方面起著關鍵作用。我們的消融研究結果表明,我們提出的檢索策略在不同模態和不同示例數量上具有穩健性和適應性。值得注意的是,不同問題類型中的一致性能強調了我們方法在增強LLMs推理能力方面的有效性。

5 結論

本文提出了一種新穎的方法來應對為大語言模型(LLMs)進行多模態推理時選擇合適的示例的問題(Lu 等,2022)。通過將檢索機制與LLMs相結合并強調文本和圖像之間的模態連接,我們的方法旨在提高LLMs在多模態鏈式思維(CoT)(Wei 等,2022b;Zhang 等,2023c)推理中的效率。此外,我們的方法引入了分層抽樣,確保LLMs能夠接觸到多樣且全面的示例。在對ScienceQA數據集(Lu 等,2022)和MathVista數據集(Lu 等,2023a)的實驗中,我們的方法持續優于現有的最先進模型,如Chameleon(Lu 等,2023b)和ChatGPT PoT(Lu 等,2023a)。這些實驗證實了我們的假設,即將LLMs與我們提出的定制檢索機制相結合,可以顯著提升多模態推理性能。隨著CoT技術在自然語言處理社區中日益受到關注,我們的工作強調了有效示例選擇的重要性。

未來的研究應著重于優化檢索過程,并將本研究中開發的方法擴展到其他多模態任務中。這些任務可能包括LLMs輸出涵蓋多種模態的任務,如文本到圖像和文本到視頻生成(Liu 等,2023a;Wang 等,2023d)。此外,將其應用于如醫療領域等專業領域(Li 等,2023d),也是一個有前途的方向。同時,在開發越來越復雜的多模態LLMs,特別是那些采用CoT推理的LLMs時,解決幻覺問題也非常重要(Ji 等,2023;Zhang 等,2023b)。我們相信我們的工作為這些未來的探索奠定了堅實的基礎。

局限性

本文提出了一種通過多模態檢索增強LLMs進行CoT示例的新方法。然而,我們的工作存在一些局限性。首先,我們的方法僅在兩個數據集上進行了測試:ScienceQA和MathVista。這兩個數據集主要涉及科學和數學主題,不能廣泛覆蓋其他復雜的推理任務。因此,我們的方法還應在其他復雜推理任務上進行評估。其次,由于資源限制,我們僅在閉源系統上進行了實驗,未在開源LLMs上進行實驗,這使得我們的結果難以復制且成本高。此外,由于這些閉源LLMs的性質,我們無法完全消除數據污染的風險。因此,我們的方法還應在更多具代表性的語言上進行全面評估。

Liu B, Lyu C, Min Z, et al. Retrieval-augmented multi-modal chain-of-thoughts reasoning for large language models[J]. arXiv preprint arXiv:2312.01714, 2023.

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/bq1hQJ23DAQDJN9j2uNh6g??