谷歌調優MusicLM的秘密:用戶偏好數據 原創

何謂MusicLM?

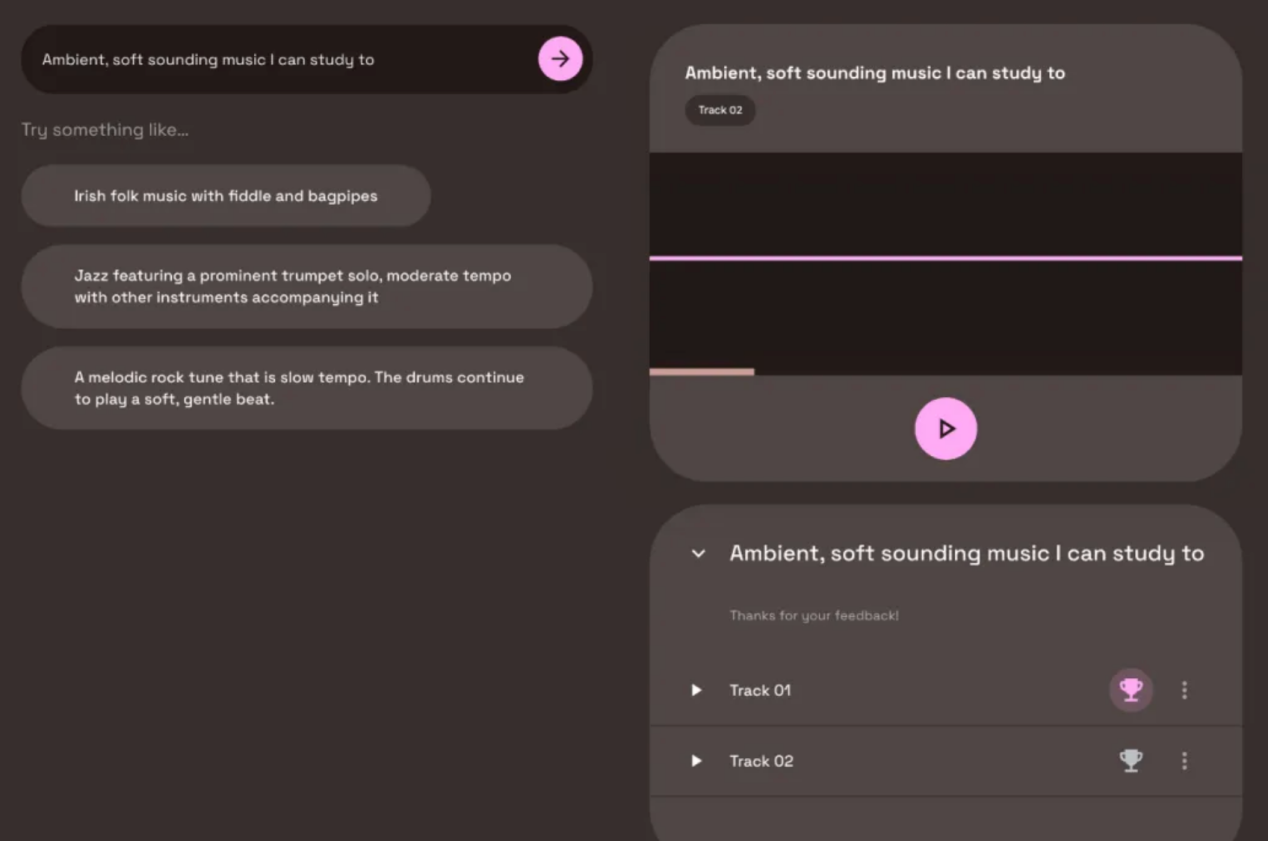

MusicLM是谷歌公司開發的文本到音樂人工智能中的旗艦產品,最初發布于2023年初。即使是在其基礎版本階段,它也代表著一個重大突破,并讓音樂行業大吃一驚。然而,幾周前,MusicLM進行了一次重要的更新。以下給出的是針對兩個挑選的提示句子的并排比較情況:

Prompt: “Dance music with a melodic synth line and arpeggiation”:

中文意思:“帶有旋律合成并伴有琶音的舞曲”:

- 老版本MusicLM:?https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-7.wav?

- 新版本MusicLM:?https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-7.wav?

Prompt: “a nostalgic tune played by accordion band”中文意思:“手風琴樂隊演奏的懷舊曲調”

- 老版本MusicLM:?https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musiclm-27.wav?

- 新版本MusicLM:?https://google-research.github.io/seanet/musiclm/rlhf/audio_samples/musicrlhf-ru-27.wav?

上述音樂質量的提高主要歸因于谷歌研究公司的一篇新論文,題為《MusicRL: Aligning Music Generation to Human Preferenc\es》。顯然,這次升級被認為意義重大;因此,他們決定重新命名該模型。然而,從底層實現來看,MusicRL在其關鍵架構上與MusicLM完全相同。唯一的區別在于:微調方式不同。

何謂微調?

當人們從頭開始構建人工智能模型時,都是從零知識開始的,本質上是進行隨機猜測。然后,該模型通過對數據進行訓練來提取有用的模式,并隨著訓練的進行開始顯示越來越智能的行為。這種方法的一個缺點是,從頭開始訓練需要大量數據。相比來說,微調則是使用現有模型并使其適應新任務,或者使其適應以不同的方式處理同一任務。因為模型已經學習了最重要的模式,所以所需的數據相對傳統方案要少得多。

例如,原則上,任何人都可以從頭開始訓練像Mistral7B這樣強大的開源LLM。即使產生非常有用的輸出,也需要大量的數據。相反,如果公司使用現有的Mistral7B模型,并向其提供少量專有數據,就可以使其解決新的任務,無論是編寫SQL查詢這樣的任務還是對于像電子郵件進行分類的任務。

關鍵是微調不會改變模型的基本結構。它只是稍微調整其內部邏輯,以便在特定任務上執行得更好。現在,讓我們利用這些知識來了解谷歌是如何在用戶數據基礎上微調MusicLM的。

谷歌如何收集用戶數據

MusicLM論文發表幾個月后,作為谷歌人工智能Test Kitchen項目的一部分,發布了一個公開演示版本。此版本中,用戶可以免費試用文本到音樂的模型。然而,你可能知道這樣一句話:如果產品是免費的,你就成為產品本身。不出所料,谷歌也不例外。在使用MusicLM的公開演示版本時,您偶爾會遇到兩個生成的輸出結果,并被要求說明您喜歡哪一個。通過這種方法,谷歌能夠在幾個月內收集到300000個用戶偏好。

MusicLM公共游樂場中捕獲的用戶偏好評級示例(圖片取自MusicRL論文:https://arxiv.org/pdf/2402.04229.pdf)

正如你從屏幕截圖中看到的,用戶沒有被明確告知他們的偏好將用于機器學習。雖然這可能感覺不公平,但重要的是要注意,我們在互聯網上的許多行為都被用于ML訓練,無論是我們的谷歌搜索歷史、我們的Instagram點贊,還是我們的私人Spotify播放列表。與這些相當私密和敏感的情況相比,MusicLM游樂場上的音樂偏好收集似乎微不足道。

Linkedin協作文章上的用戶數據收集示例

值得注意的是,機器學習的用戶數據收集一直在進行,通常不需要明確的同意。如果你在Linkedin上,你可能會被邀請為所謂的“合作文章”投稿。從本質上講,用戶被邀請就其專業領域的問題提供提示。下圖給出的是一篇關于如何寫一首成功的民歌(我不知道我需要什么)的合作文章(https://www.linkedin.com/advice/3/how-can-you-write-successful-folk-songs-skills-music-industry-w4i5e?trk=cah1)的例子。

一篇關于歌曲創作的合作文章的標題(右邊是我被要求捐款以獲得“頂級聲音”徽章)

激勵用戶投稿,為他們贏得平臺上的“頂級聲音”徽章。然而,我的印象是,沒有人真正讀過這些文章。這讓我相信,微軟(Linkedin的所有者)正在使用這數千個問答對來訓練這些數據的專家人工智能系統。如果我的懷疑是準確的,那么我會發現這個例子比谷歌向用戶詢問他們最喜歡的曲目更有問題。

廢話少講,還是回到我們討論的MusicLM!

谷歌如何利用這些用戶數據

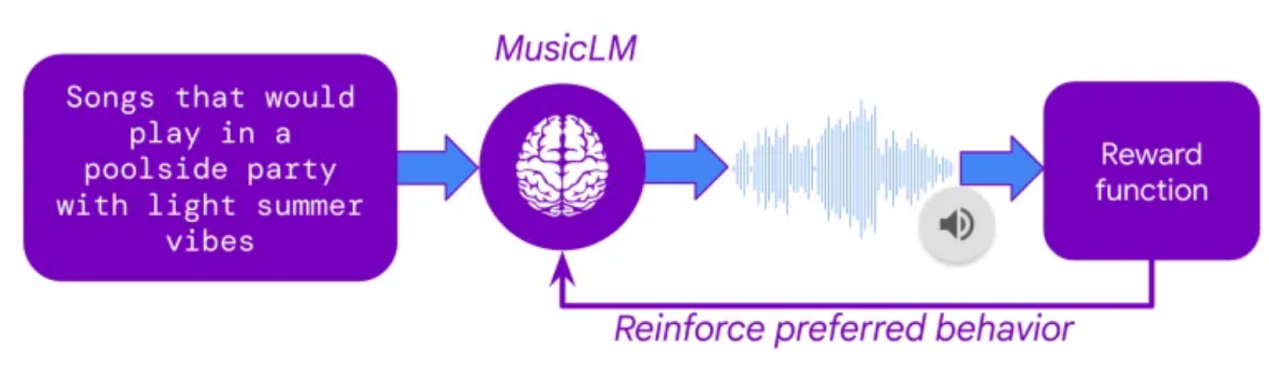

接下來的一個問題是,谷歌是如何利用這一龐大的用戶偏好集合來微調MusicLM的。其實,秘密在于一種名為“從人類反饋中強化學習(RLHF)”的技術,這是ChatGPT在2022年的關鍵突破技術之一。在RLHF中,人類偏好被用來訓練一個人工智能模型,該模型學習模仿人類偏好決策,從而產生一個人工評分器。一旦這個所謂的獎勵模型被訓練出來,它就可以接受任何兩個曲目,并預測哪一個曲目最有可能被人類評分者所偏好。

通過建立獎勵模型,人們可以對MusicLM進行微調,以最大限度地提高其輸出的預測用戶偏好。這意味著,文本到音樂模型可以生成數千首曲目,而每首曲目都能夠從獎勵模型中獲得評級。通過對模型權重的迭代自適應,MusicLM可學會生成相當于人工評分者“喜歡”的音樂。

從人類反饋中強化學習(RLHF)作出的解釋(圖片取自MusicRL論文:https://arxiv.org/abs/2402.04229)

除了對用戶偏好進行微調外,MusicLM還對另外兩個標準進行了微調:

1.提示遵從

使用谷歌專有的文本到音頻嵌入模型MuLan(https://research.google/pubs/mulan-a-joint-embedding-of-music-audio-and-natural-language/)可以計算用戶提示和生成的音頻之間的相似性。在微調過程中,這種遵從性得分被最大化。

2.音頻質量

谷歌在用戶數據上訓練了另一個獎勵模型,以評估其生成輸出的主觀音頻的質量。這些用戶數據似乎是在單獨的調查中收集的,而不是在MusicLM公開展示的版本中。

新的MusicLM有多好?

新出現的經過微調的模型大概率優于舊的MusicLM,有興趣的讀者可以聽一下其展示頁面(https://google-research.github.io/seanet/musiclm/rlhf/)上提供的示例聲音。當然,一個挑選出的公開展示作品可能是騙人的,因為創作者會被加以激勵以便展示他們的新模型看起來盡可能好。真心希望我們大家能很快在公共場所測試使用MusicRL。

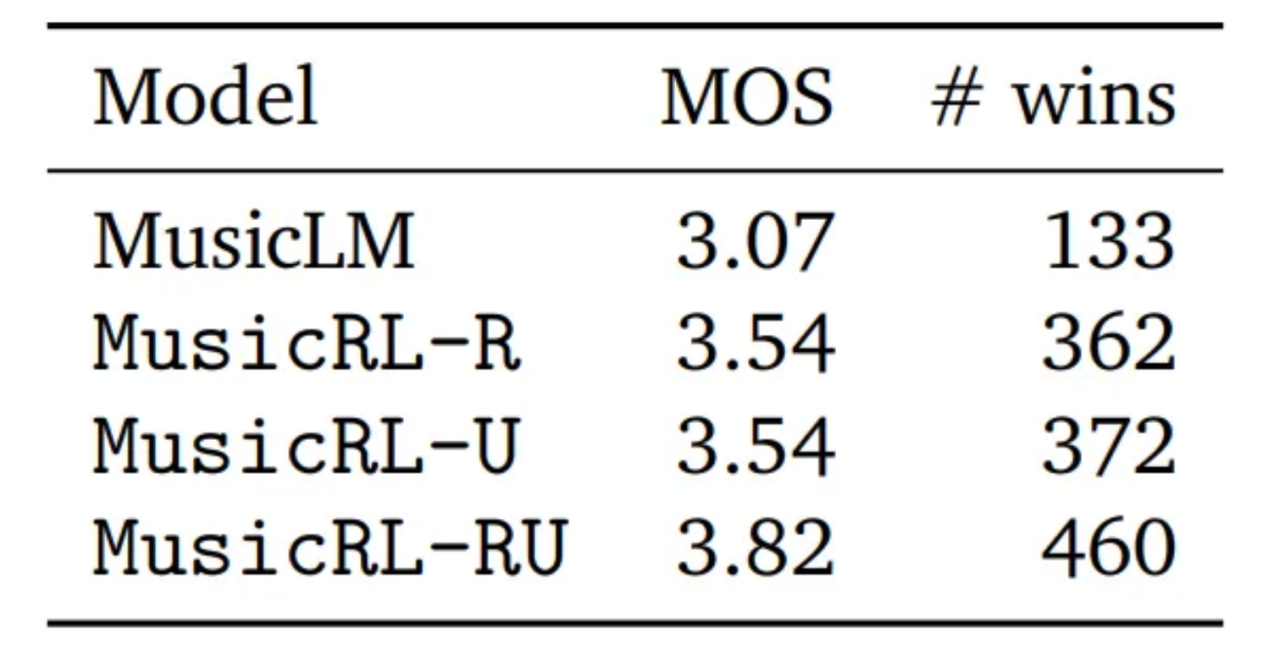

然而,論文中也提供了對于主觀質量的定量評估。為此,谷歌進行了一項研究,要求用戶為同一提示生成的兩首曲目加以比較,每條曲目的得分范圍是從1到5。將這個指標與平均意見得分(MOS)結合使用,我們不僅可以比較每個模型的直接比較獲勝次數,還可以計算平均意見得分(MOS)。

定量基準指標比較結果(圖片同樣取自上述MusicRL論文)

上述圖片中,MusicLM表示原始的MusicLM模型。MusicRL-R僅針對音頻質量和提示遵從方面進行了微調。MusicRL-U僅根據人類反饋(獎勵模型)進行微調。最后,MusicRL RU在所有三個目標上都進行了微調。毫不奇怪,MusicRL RU在直接比較和平均收視率方面擊敗了所有其他模型。

該論文還報道稱,完全微調的MusicRL-RU模型在87%的直接比較中擊敗了MusicLM模型。通過分析MusicRL-R和MusicRL-RU之間的直接比較,可以看出RLHF的重要性。在這里,后者的勝率為66%,比較有把握地超過了競爭對手。

這意味著什么?

盡管輸出質量的差異在質量和數量上都很明顯,但在大多數情況下,新的MusicLM與人類水平的輸出仍然相距甚遠。即使在公共演示頁面上,許多生成的輸出曲目聽起來也很奇怪,有節奏,無法捕捉到從提示中輸入的關鍵元素,或者聲音不自然。

在我看來,上面這篇論文仍然意義重大,因為它是第一次嘗試將RLHF用于音樂生成。RLHF在文本生成中已經被廣泛使用了一年多。但為什么花了這么長時間?我懷疑收集用戶反饋和微調模型的成本相當高。谷歌可能發布公開的MusicLM演示的主要目的是收集用戶反饋。顯然,這是一個明智的舉動,這會使他們比Meta公司有優勢,因為Meta公司有同樣強大的模型,但沒有提供開放的平臺來收集用戶數據。

總的來說,谷歌利用了從ChatGPT借鑒來的經過驗證的微調方法,使自己在競爭中領先。雖然借助于RLHF技術其改進版本的新的MusicLM仍然沒有達到人類水平的質量,但谷歌現在可以維護和更新其獎勵模型,通過相同的微調程序改進未來幾代的文本到音樂模型。

看看Meta或Stability AI等其他競爭對手是否以及何時會迎頭趕上,這將是一件有趣的事情。對于我們這些用戶來說,這一切都是個好消息!我們會擁有免費的公開演示版本和更強大的模型。

對于音樂家來說,AI目前的發展步伐可能會對他們有點威脅——這是有充分理由的。我希望在未來的1-3年里看到人類水平的文本到音樂的一代模型。我指的是文本到音樂人工智能方面的模型,它在制作音樂方面的能力至少與ChatGPT發布時編寫文本的能力一樣。音樂家必須了解人工智能,以及它如何在日常工作中為他們提供支持。隨著音樂行業再次被顛覆,好奇心和靈活性將是成功的首要關鍵。

對音樂AI感興趣?

如果你喜歡這篇文章,你可能想看看我撰寫的其他文章:

- “3 Music AI Breakthroughs to Expect in 2024”,我的Medium博客(https://medium.com/towards-data-science/3-music-ai-breakthroughs-to-expect-in-2024-2d945ae6b5fd)。

- “Where is Generative AI Music Now?”。YouTube采訪我的SyncMusic(https://www.youtube.com/watch?v=OLJi1b-B0i0)。

- “MusicLM — Has Google Solved AI Music Generation?”,我的Medium博客(https://medium.com/towards-data-science/musiclm-has-google-solved-ai-music-generation-c6859e76bc3c)。

您也可以在Linkedin上關注我(https://www.linkedin.com/in/max-hilsdorf/),隨時了解音樂人工智能的最新論文和趨勢。

參考文獻

- Agostinelli et al., 2023. MusicLM: Generating Music From Text. https://arxiv.org/abs/2301.11325。

- Cideron et al., 2024. MusicRL: Aligning Music Generation to Human Preferences. https://arxiv.org/abs/2402.04229。

譯者介紹

朱先忠,51CTO社區編輯,51CTO專家博客、講師,濰坊一所高校計算機教師,自由編程界老兵一枚。

原文標題:How Google Used Your Data to Improve their Music AI,作者:Max Hilsdorf

鏈接:??https://towardsdatascience.com/how-google-used-your-data-to-improve-their-music-ai-8948a1e85491?。