直接偏好優(yōu)化(DPO)簡介 原創(chuàng)

直接偏好優(yōu)化(Direct Preference Optimization,DPO)已成為對大模型進行微調(diào)的基本方式。著名的 Mistral 公司開發(fā)的 Mixtral 8x7B 模型,即稀疏專家混合模型(Sparse Mixture of Experts),通過使用 DPO,能夠以顯著較少的參數(shù)達到 LLaMa 70B 級別的性能。自然而然地,這一成功促使社區(qū)中許多人開始使用 DPO 對自己的模型進行微調(diào)。

目標

一旦你將一個模型預訓練得具有強大的生成能力,通常希望以某種方式控制其輸出。無論是將其優(yōu)化為在對話中作為聊天機器人回應,還是在代碼中回應而不是用英語,這里的目標是獲取一個已經(jīng)功能齊全的 LLM,并找到一種更加有選擇性地輸出的方式。

術(shù)語

損失函數(shù) — 用作我們優(yōu)化模型性能的指南的函數(shù)。這是根據(jù)已被發(fā)現(xiàn)的有效性選擇的。

KL 散度 — 指的是 Kullback-Leibler 散度,它是衡量兩個連續(xù)概率分布之間差異的一種方法。要了解更多信息,可以參考 Aparna Dhinakaran 寫的一篇關(guān)于此主題的精彩文章。

策略 — 描述神經(jīng)網(wǎng)絡將如何做出決策的抽象。換句話說,如果一個神經(jīng)網(wǎng)絡被訓練了 3 次,每次它都會有一個不同的策略,你可以比較它們的性能。

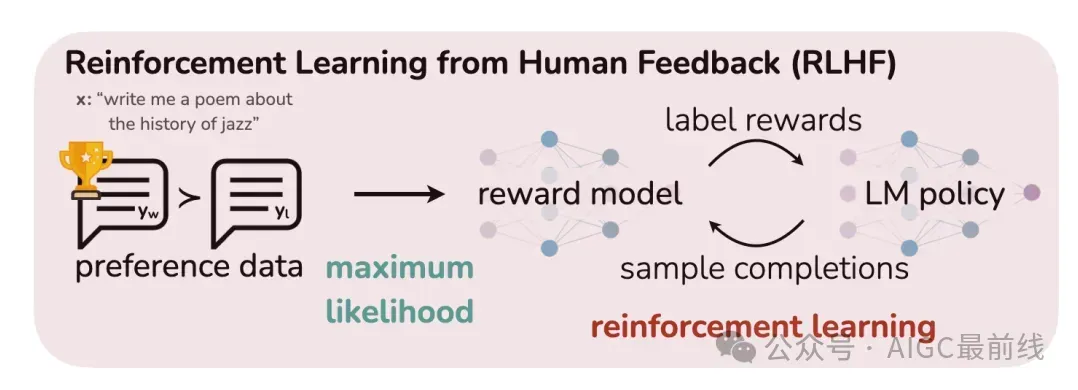

DPO 之前的現(xiàn)狀(PPO)

在 DPO 之前,我們通常不得不訓練一個完全獨立的模型來幫助我們進行微調(diào),通常稱為獎勵模型或 RLHF 模型。我們會從我們的 LLM 中采樣完成,并讓獎勵模型為每個完成度給出一個分數(shù)。這里的想法很簡單。人類評估您的 LLM 輸出是昂貴的,但您的 LLM 的質(zhì)量最終將由人類決定。為了保持成本低廉且質(zhì)量高,您將訓練獎勵模型來近似人類的反饋。

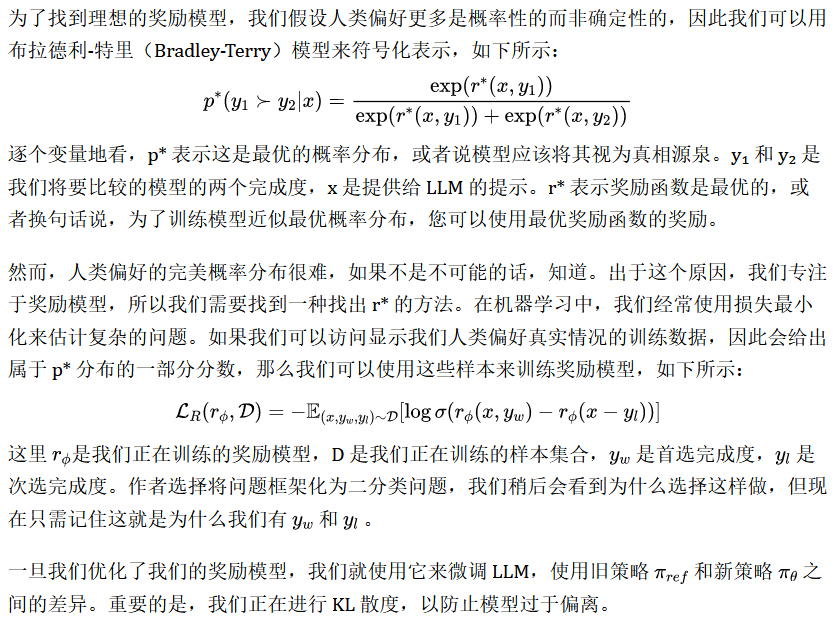

PPO背后的數(shù)學原理

為什么我們不希望它偏離太多?記住模型已經(jīng)基本功能齊全,而且已經(jīng)耗費了相當多的計算資源才達到這個水平。因此,我們希望確保模型保留許多當前具有的好特性,同時我們專注于讓它更好地遵循指令。

盡管上述方法是有效的——例如,LLaMa2 就是以這種方式進行微調(diào)的——但它有一個主要缺點:它需要訓練一個完全獨立的模型,這是昂貴的并且需要大量額外的數(shù)據(jù)。

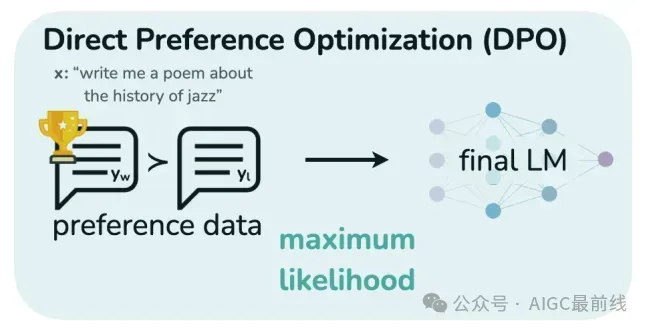

DPO如何改進這一點?

DPO完全消除了對獎勵模型的需求!這使我們避免了訓練昂貴的獨立獎勵模型,并且偶然地,我們發(fā)現(xiàn)DPO所需的數(shù)據(jù)量要少得多,就像PPO一樣有效。

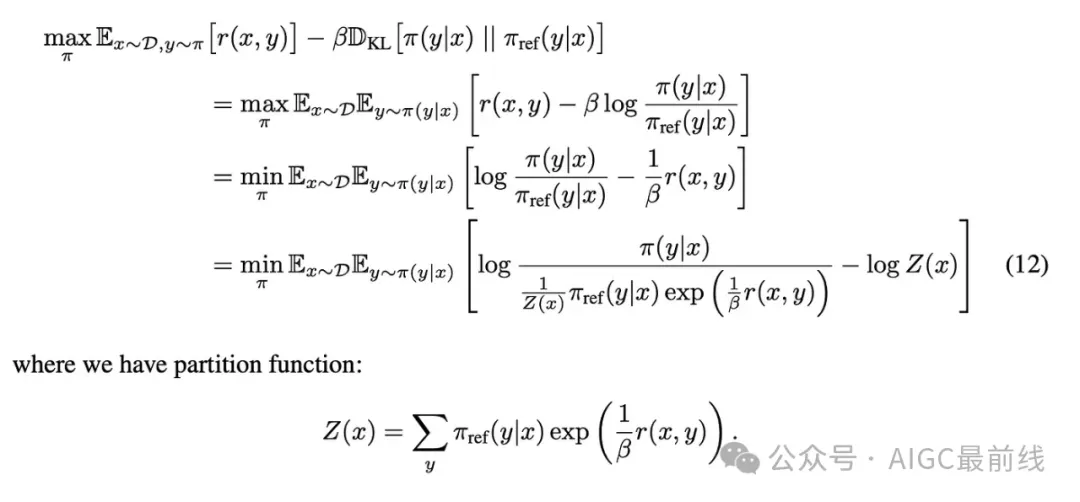

DPO背后的數(shù)學原理

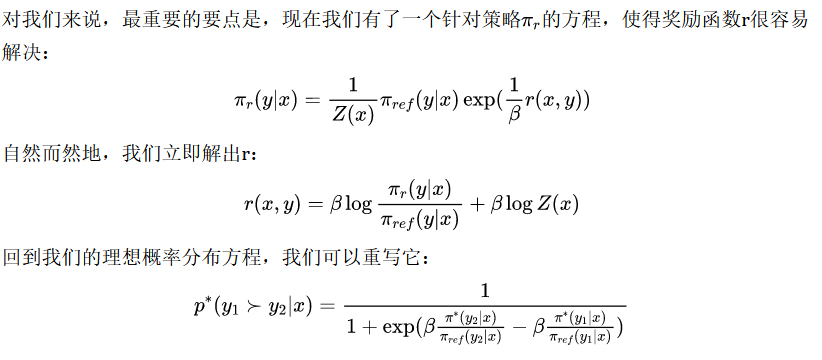

主要的飛躍源于施加的KL約束。通過添加這個約束,我們實際上可以推導出最大化KL受限獎勵模型的理想策略。代數(shù)如下所示:

這表明,您不需要獎勵模型來優(yōu)化策略以遵循人類偏好的理想概率分布。相反,您可以直接處理策略以改進它(這就是直接偏好優(yōu)化名稱的由來)。我們正在使用您的LLM為每個標記生成的概率來幫助它進行微調(diào)。

結(jié)論

首先,DPO不需要獎勵模型! 您只需要高質(zhì)量的數(shù)據(jù),使得模型清楚地知道什么是好的,什么是壞的,并且它會不斷改進。

其次,DPO是動態(tài)的。每次使用新數(shù)據(jù)時,它都會立即適應,這要歸功于它找到正確方向的方式。與PPO相比,您每次有新數(shù)據(jù)都必須重新訓練獎勵模型,這是一個巨大的優(yōu)勢。

第三,DPO使您能夠訓練模型避免某些話題,正如它會學習為其他話題提供良好答案一樣。對于新的損失方程,一種概念化的方法是將其視為指向正確方向的信號。通過同時使用好的和壞的示例,我們正在教導模型不僅要朝著某些響應方向前進,還要盡量避免其他響應方向。由于微調(diào)的一個很大部分涉及模型忽略某些主題,因此這個特性非常有價值。

譯自(有刪改):https://towardsdatascience.com/understanding-the-implications-of-direct-preference-optimization-a4bbd2d85841

本文轉(zhuǎn)載自公眾號AIGC最前線