谷歌創(chuàng)新框架:從非結(jié)構(gòu)化數(shù)據(jù),實(shí)現(xiàn)多模態(tài)學(xué)習(xí) 精華

看、聽(tīng)、說(shuō)的多模態(tài)已成為主流大模型的重要功能之一。但在數(shù)據(jù)爆炸時(shí)代,大模型學(xué)習(xí)文本類(lèi)的結(jié)構(gòu)化數(shù)據(jù)相對(duì)還好一些,但要去學(xué)習(xí)視頻、音頻、圖片等非結(jié)構(gòu)化數(shù)據(jù)非常困難。

目前,從結(jié)構(gòu)化和非結(jié)構(gòu)化數(shù)據(jù)實(shí)現(xiàn)多模態(tài)學(xué)習(xí),會(huì)隨著模態(tài)數(shù)量、輸入大小和數(shù)據(jù)異構(gòu)性的增加,深度神經(jīng)網(wǎng)絡(luò)會(huì)變過(guò)擬合和泛化效果不佳。

尤其是當(dāng)在規(guī)模有限的數(shù)據(jù)集上訓(xùn)練時(shí),這一狀況就越發(fā)明顯,例如,經(jīng)常表現(xiàn)出非平穩(wěn)行為的時(shí)間序列數(shù)據(jù)。因此,谷歌提出了創(chuàng)新框架LANISTR來(lái)解決這些難題。

論文地址:https://arxiv.org/pdf/2305.16556

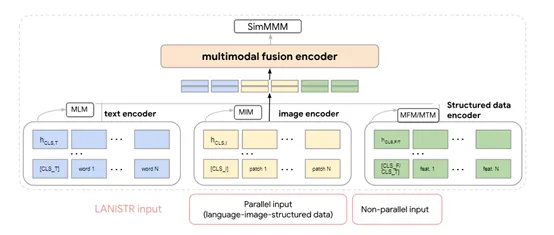

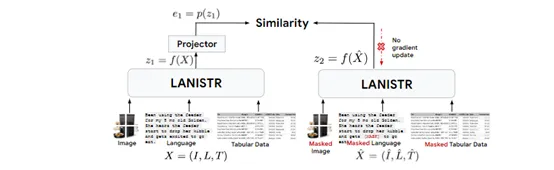

LANISTR是一個(gè)基于注意力機(jī)制的框架,其核心思想是在單模態(tài)和多模態(tài)層面上應(yīng)用基于掩碼的訓(xùn)練。

還特別引入了一種新的基于相似度的多模態(tài)掩碼損失,使其能夠從存在缺失模態(tài)的大型多模態(tài)數(shù)據(jù)中學(xué)習(xí)跨模態(tài)之間的關(guān)系。

多模態(tài)融合編碼器

?

現(xiàn)實(shí)數(shù)據(jù)經(jīng)常以復(fù)合形式存在,單一模態(tài)的數(shù)據(jù)往往不足以捕捉事件的全貌。例如,在醫(yī)療診斷中,臨床報(bào)告和MRI掃描圖像才能展現(xiàn)患者狀況的全面視圖;而在電子商務(wù)中,商品描述與銷(xiāo)售歷史(時(shí)間序列)相結(jié)合才能更好地預(yù)測(cè)市場(chǎng)需求。

因此,一個(gè)好用的多模態(tài)大模型,必須具備將這些分散信息源綜合的能力。為了實(shí)現(xiàn)這一目標(biāo),LANISTR采用了基于Transformer架構(gòu)的交叉注意力機(jī)制。

多模態(tài)融合編碼器可將來(lái)自各模態(tài)的嵌入向量首先被串聯(lián)起來(lái),然后通過(guò)一系列的Transformer層進(jìn)行處理。

在這些層中,交叉注意力機(jī)制發(fā)揮了重要作用,允許模型在不同的模態(tài)表示之間自由“詢(xún)問(wèn)”和“回答”,使每個(gè)模態(tài)的特征都能關(guān)注其他模態(tài)的特征,并根據(jù)它們的相關(guān)性和重要性進(jìn)行加權(quán)整合。

這一流程與人腦思考有些類(lèi)似,可根據(jù)上下文和情境在不同感官信號(hào)間切換注意力,從而實(shí)現(xiàn)信息的高效整合。

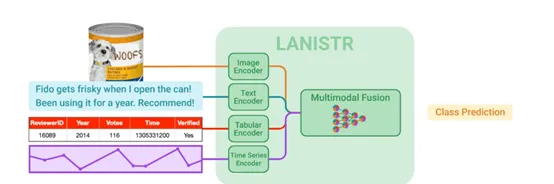

4種編碼器介紹

?

LANISTR中的多模態(tài)融合編碼器一共由文本、圖像、表格和時(shí)間序列4種編碼器組成,每種模態(tài)都有其獨(dú)特的表達(dá)方式和信息結(jié)構(gòu)。這種機(jī)制不僅增強(qiáng)了對(duì)單個(gè)模態(tài)特征的理解,還促進(jìn)了模態(tài)間的交互學(xué)習(xí),從而對(duì)整個(gè)場(chǎng)景有了更加全面的認(rèn)識(shí)。

文本編碼器:基于Transformer架構(gòu)主要處理文本數(shù)據(jù)。通過(guò)掩碼語(yǔ)言方法進(jìn)行預(yù)訓(xùn)練,隨機(jī)掩蓋文本中的部分詞匯,讓模型學(xué)習(xí)預(yù)測(cè)這些被掩蓋詞的能力。這種機(jī)制促使模型理解詞語(yǔ)間的依賴(lài)關(guān)系和語(yǔ)境含義,從而提取出豐富的語(yǔ)言特征。

圖像編碼器:采用Vision Transformer架構(gòu)用于處理視覺(jué)數(shù)據(jù)。可將圖像分割成多個(gè)小塊,并將這些塊視為序列輸入到Transformer中,通過(guò)自注意力機(jī)制學(xué)習(xí)圖像的高層次特征,還會(huì)使用掩碼圖像建模方法,通過(guò)重建被掩碼的像素或特征來(lái)訓(xùn)練,以提取圖像的視覺(jué)特征。

表格編碼器:使用了定制的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),針對(duì)分類(lèi)特征的嵌入層來(lái)編碼每一列數(shù)據(jù)的特征。考慮到表格數(shù)據(jù)的稀疏性和多樣性,了集成特征選擇或降維技術(shù),以聚焦于最有信息量的特征。

時(shí)間序列編碼器:由于大模型需要捕捉隨時(shí)間變化的動(dòng)態(tài)模式,時(shí)間序列編碼器使用了循環(huán)神經(jīng)網(wǎng)絡(luò)方法,長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)和門(mén)控循環(huán)單元。通過(guò)對(duì)序列進(jìn)行建模提取出時(shí)間序列的模式和趨勢(shì),為后續(xù)的多模態(tài)融合準(zhǔn)備數(shù)據(jù)。

研究人員在兩個(gè)數(shù)據(jù)集上測(cè)試了LANISTR的性能,在MIMIC-IV數(shù)據(jù)集上,當(dāng)僅使用0.1%的有標(biāo)簽數(shù)據(jù)進(jìn)行微調(diào)時(shí),模型的AUROC相比最先進(jìn)的方法提高了6.6%。

在亞馬遜產(chǎn)品評(píng)論數(shù)據(jù)集中,僅使用0.01%的有標(biāo)簽數(shù)據(jù),模型的準(zhǔn)確率提升了14%。值得一提的是,這些改進(jìn)是在高達(dá)35.7%和99.8%的樣本存在模態(tài)缺失的情況下完成的,這更加證明了LANISTR的多模態(tài)學(xué)習(xí)能力。

本文轉(zhuǎn)自 AIGC開(kāi)放社區(qū) ,作者:AIGC開(kāi)放社區(qū)