加州大學(xué)伯克利分校等發(fā)表的RouteLLM:利用偏好數(shù)據(jù)學(xué)習(xí)路由大語(yǔ)言模型

一、結(jié)論寫(xiě)在前面

論文標(biāo)題:RouteLLM: Learning to Route LLMs with Preference Data

論文鏈接:??https://arxiv.org/pdf/2406.18665v2??

LLM在廣泛的任務(wù)中展現(xiàn)出令人印象深刻的能力,然而在選擇使用哪個(gè)模型時(shí),往往需要在性能和成本之間做出權(quán)衡。更強(qiáng)大的模型雖然有效,但成本更高,而能力較弱的模型則更具成本效益。

為了解決這一難題,論文提出了幾種高效的路由模型,這些模型在推理過(guò)程中動(dòng)態(tài)選擇更強(qiáng)大或較弱的LLM,旨在優(yōu)化成本與響應(yīng)質(zhì)量之間的平衡。論文開(kāi)發(fā)了一個(gè)利用人類(lèi)偏好數(shù)據(jù)和數(shù)據(jù)增強(qiáng)技術(shù)的訓(xùn)練框架來(lái)提升這些路由器的性能。

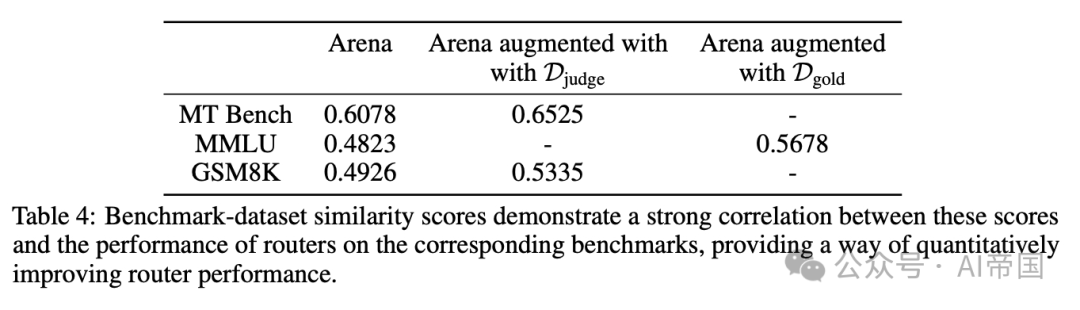

論文在廣泛認(rèn)可的基準(zhǔn)測(cè)試中評(píng)估了論文的方法,結(jié)果顯示,論文的方法在某些情況下顯著降低了成本——超過(guò)2倍——同時(shí)不犧牲響應(yīng)質(zhì)量。論文的結(jié)果還突出了數(shù)據(jù)集增強(qiáng)在提高路由器性能方面的有效性。僅在Arena數(shù)據(jù)集上訓(xùn)練路由器會(huì)導(dǎo)致在MMLU和GSM8K上的性能不佳,而通過(guò)使用LLM判斷或領(lǐng)域內(nèi)數(shù)據(jù)增強(qiáng)訓(xùn)練數(shù)據(jù),論文的路由器能夠在所有基準(zhǔn)測(cè)試中超越隨機(jī)基線。當(dāng)訓(xùn)練數(shù)據(jù)與評(píng)估數(shù)據(jù)高度相似時(shí),性能提升最大,這一點(diǎn)由基準(zhǔn)數(shù)據(jù)集相似性得分所表明。論文相信,這一框架為特定用例提升路由性能提供了一條清晰且可擴(kuò)展的路徑。

盡管論文的工作展示了強(qiáng)大的成果,但仍存在一些局限性。首先,雖然論文在多樣化的基準(zhǔn)測(cè)試上進(jìn)行了評(píng)估,但現(xiàn)實(shí)世界的應(yīng)用可能與這些基準(zhǔn)存在顯著差異。其次,雖然本工作聚焦于雙模型路由設(shè)置,但未來(lái)的一個(gè)有前景的方向是將此工作擴(kuò)展到多模型等等。

?二、論文的簡(jiǎn)單介紹

2.1 論文的背景?

LLMs的最新進(jìn)展在廣泛的天然語(yǔ)言任務(wù)中展示了卓越的能力。從開(kāi)放式對(duì)話和問(wèn)答到文本摘要和代碼生成,LLMs展示了令人印象深刻的流暢性和理解能力。這一快速進(jìn)步得益于架構(gòu)創(chuàng)新,如Transformer架構(gòu),以及在擴(kuò)展數(shù)據(jù)和訓(xùn)練基礎(chǔ)設(shè)施方面的改進(jìn)。

然而,并非所有大型語(yǔ)言模型(LLMs)都一視同仁——LLMs在成本和規(guī)模上存在顯著差異,其規(guī)模可以從十億到數(shù)千億參數(shù)不等。LLMs在訓(xùn)練數(shù)據(jù)方面也各不相同,這進(jìn)而導(dǎo)致了不同模型在優(yōu)勢(shì)、劣勢(shì)和能力上的差異。總體而言,規(guī)模較大的模型往往能力更強(qiáng),但成本也更高;而規(guī)模較小的模型雖然能力較弱,但部署成本更為低廉。

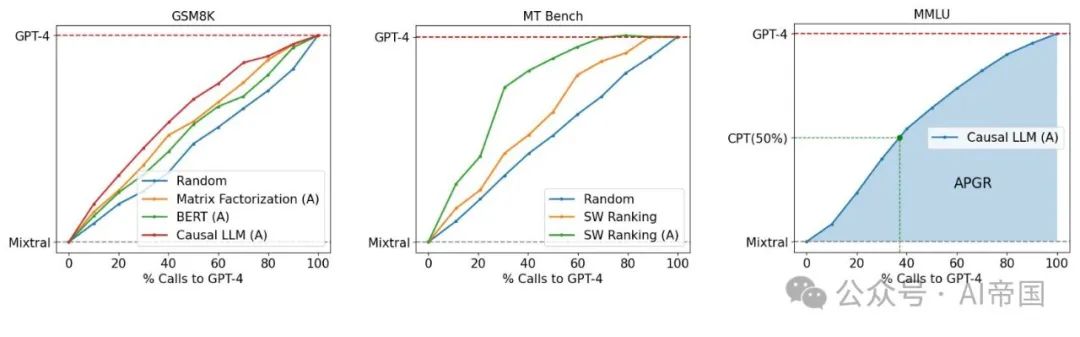

圖1:GPT-4與Mixtral-8x7B在路由性能/成本之間的權(quán)衡。(左)論文展示了在OOD評(píng)估GSM8K上優(yōu)于隨機(jī)基線的幾種路由器。(中)論文通過(guò)數(shù)據(jù)增強(qiáng)(標(biāo)記為(A))在MT Bench上展示了路由器性能的提升。(右)論文展示了主要考慮的指標(biāo):調(diào)用性能閾值(CPT,以綠色表示)和平均性能增益恢復(fù)(APGR,以藍(lán)色陰影區(qū)域表示)

這一異構(gòu)環(huán)境在實(shí)際部署LLM于現(xiàn)實(shí)應(yīng)用中提出了一個(gè)難題。雖然將所有用戶查詢路由到最大、最有能力的模型可以確保高質(zhì)量的結(jié)果,但這成本高昂。相反,將查詢路由到較小的模型可以節(jié)省成本——高達(dá)50倍以上(例如,Llama-3-70b對(duì)比GPT-4,或Claude-3 Haiku對(duì)比Opus-)——但可能導(dǎo)致響應(yīng)質(zhì)量較低,因?yàn)檩^小的模型可能無(wú)法有效處理復(fù)雜查詢。

為此,LLM路由是解決這一問(wèn)題的有前景的方案,其中每個(gè)用戶查詢首先由一個(gè)路由器模型處理,然后決定將查詢路由到哪個(gè)LLM。這有可能將較簡(jiǎn)單的查詢路由到較小的模型,將較困難的查詢路由到較大的模型,優(yōu)化模型響應(yīng)質(zhì)量同時(shí)最小化成本。然而,最優(yōu)LLM路由——定義為在給定成本目標(biāo)下實(shí)現(xiàn)最高質(zhì)量或在給定質(zhì)量目標(biāo)下最小化成本——是一個(gè)具有挑戰(zhàn)性的問(wèn)題。一個(gè)強(qiáng)大的路由器模型需要推斷傳入查詢的意圖、復(fù)雜性和領(lǐng)域,并理解候選模型的能力,以將查詢路由到最合適的模型。此外,路由器模型需要經(jīng)濟(jì)、快速且適應(yīng)不斷演變的模型環(huán)境,其中不斷引入具有改進(jìn)能力的新模型。

論文提出了一種基于原則的大型語(yǔ)言模型(LLM)間查詢路由框架。如圖1所示,論文的設(shè)置涉及學(xué)習(xí)在更強(qiáng)的模型和較弱的模型之間進(jìn)行路由。論文的目標(biāo)是通過(guò)智能地將簡(jiǎn)單查詢路由到較弱的模型,并將復(fù)雜查詢保留給較強(qiáng)的模型,以最小化成本同時(shí)達(dá)到特定的性能目標(biāo),例如達(dá)到較強(qiáng)模型性能的90%。論文開(kāi)發(fā)了一種利用人類(lèi)偏好數(shù)據(jù)和數(shù)據(jù)增強(qiáng)技術(shù)的路由系統(tǒng)訓(xùn)練框架。

?2.2 LLM路由

2.2.1 問(wèn)題定義?

考慮一組N個(gè)不同的LLM模型 ( M = {M_1, M_2, ..., M_N} )。每個(gè)模型 ( M_i ) 可以抽象為一個(gè)將查詢映射到答案的函數(shù)。路由函數(shù) ( R) 是一個(gè) ( N ) 路分類(lèi)器,它接收一個(gè)查詢 ( q ) 并選擇一個(gè)模型來(lái)回答 ( q ),答案為 ( a )。路由的挑戰(zhàn)在于在提高響應(yīng)質(zhì)量和降低成本之間實(shí)現(xiàn)最佳平衡。假設(shè)論文有權(quán)訪問(wèn)偏好數(shù)據(jù): ( D_pref = {(q, l_i,j) | q ∈ Q, i, j ∈ N, l_i,j ∈ C} ),其中 ( q ) 是一個(gè)查詢, ( l_i,j ) 是一個(gè)標(biāo)簽,表示在 ( q ) 上比較 ( M_i ) 和 ( M_j ) 的質(zhì)量結(jié)果。區(qū)分獎(jiǎng)勵(lì)建模 和路由至關(guān)重要。獎(jiǎng)勵(lì)建模在LLM生成響應(yīng)后評(píng)估其質(zhì)量,而路由要求路由器在看到響應(yīng)之前選擇適當(dāng)?shù)哪P汀_@需要深入理解問(wèn)題的復(fù)雜性以及可用LLMs的優(yōu)勢(shì)和劣勢(shì)。

論文專注于兩種模型類(lèi)別之間的路由問(wèn)題:(1) 強(qiáng)模型(M_strong),由能夠生成高質(zhì)量響應(yīng)但成本較高的模型組成。這一類(lèi)別主要包含最先進(jìn)的閉源模型,如GPT-4。(2) 弱模型(M_weak),由質(zhì)量相對(duì)較低且成本較低的模型組成,例如Mixtral-8x7B。這種二元路由問(wèn)題在實(shí)踐中相當(dāng)常見(jiàn),特別是當(dāng)LLM應(yīng)用的開(kāi)發(fā)者努力平衡質(zhì)量和成本時(shí)。此外,解決這一問(wèn)題構(gòu)成了解決更一般的N路路由問(wèn)題的基礎(chǔ)。

論文提出了一種基于原則的框架,用于從偏好數(shù)據(jù)中學(xué)習(xí)一個(gè)二元路由函數(shù)R,以在M_weak和M_strong之間進(jìn)行路由。為此,論文定義了R,它包含兩個(gè)組成部分:

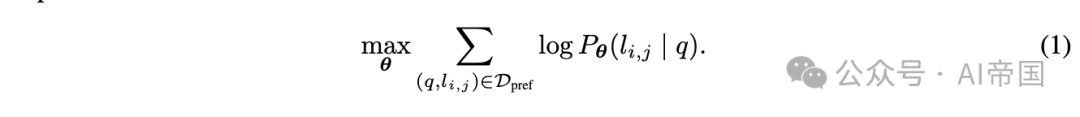

(1) 勝出預(yù)測(cè)模型,該模型預(yù)測(cè)強(qiáng)模型Mstrong的勝出概率。在論文的二元分類(lèi)設(shè)置中,這一概率捕捉了兩類(lèi)模型的勝/負(fù)概率。論文可以在偏好數(shù)據(jù)上使用最大似然估計(jì)來(lái)學(xué)習(xí)該模型的參數(shù):

通過(guò)在偏好數(shù)據(jù)上學(xué)習(xí)勝出概率,論文捕捉了兩類(lèi)模型在各種查詢上的優(yōu)勢(shì)和劣勢(shì)。論文提出了幾種參數(shù)化勝出預(yù)測(cè)模型的方法。

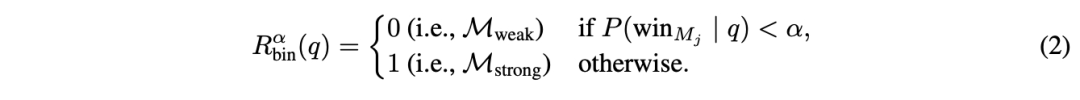

(2)成本閾值,它將勝出概率轉(zhuǎn)換為在M_strong和M_weak之間的路由決策。給定一個(gè)查詢q,路由決策表述為:

閾值 控制質(zhì)量與成本的權(quán)衡:較高的閾值施加更嚴(yán)格的成本約束,減少開(kāi)支但可能犧牲質(zhì)量。

最后,論文將路由器的響應(yīng)表示為 M_R,它代表根據(jù)路由器決策由弱模型或強(qiáng)模型生成的響應(yīng)。

2.2.2 評(píng)估指標(biāo)

論文定義了捕獲LLM路由問(wèn)題中成本與質(zhì)量之間權(quán)衡的評(píng)估指標(biāo)。論文首先獨(dú)立評(píng)估給定R的質(zhì)量和成本效率的指標(biāo),然后引入兩個(gè)復(fù)合指標(biāo),這些指標(biāo)將用于論文的實(shí)驗(yàn)評(píng)估。

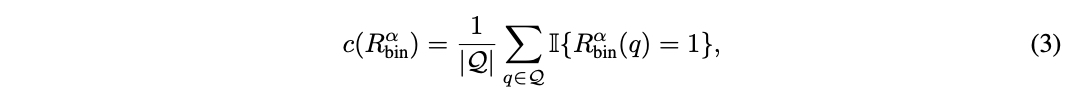

對(duì)于成本效率,論文計(jì)算調(diào)用強(qiáng)模型的百分比:

因?yàn)閺?qiáng)模型的成本顯著高于弱模型。

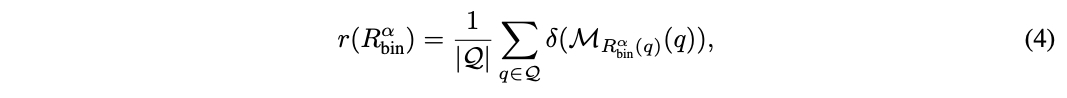

對(duì)于質(zhì)量,論文在評(píng)估集 Q 上測(cè)量平均響應(yīng)質(zhì)量:

該評(píng)分可以是預(yù)定義指標(biāo)在黃金標(biāo)注數(shù)據(jù)集(例如 MMLU)中測(cè)量響應(yīng)正確性的結(jié)果,或者是數(shù)值標(biāo)簽(例如 1-5 或 1-10),其中較高值表示質(zhì)量更好。

鑒于 R的性能介于弱模型和強(qiáng)模型之間,論文通過(guò)量化路由器相對(duì)于兩者模型性能差距的表現(xiàn)來(lái)定義總體性能增益(PGR):

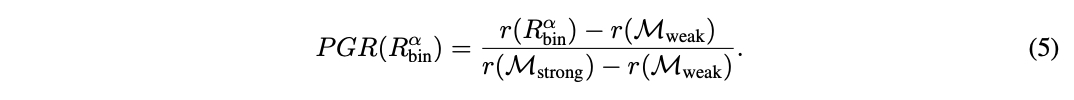

這兩個(gè)指標(biāo)單獨(dú)都不充分,因?yàn)樗鼈儧](méi)有捕捉到路由中的質(zhì)量-成本權(quán)衡。例如,一個(gè)將每個(gè)查詢都發(fā)送到強(qiáng)模型的簡(jiǎn)單路由器可以實(shí)現(xiàn)完美的 PGR = 1,而沒(méi)有任何成本降低。因此,論文通過(guò)改變閾值計(jì)算路由器 R的調(diào)用-性能圖。論文定義平均性能差距恢復(fù)(APGR)作為在不同成本約束下路由器恢復(fù)性能差距的總體度量:

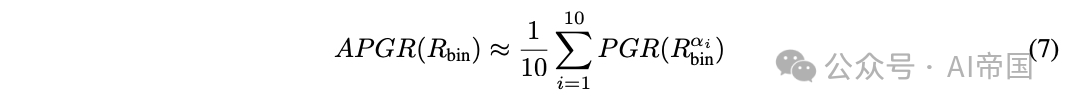

在圖 1-(右) 中,APGR 由路由器性能曲線與弱模型性能之間的區(qū)域表示。實(shí)際上,論文將調(diào)用百分比區(qū)間 [0%, 100%] 離散化為 { c_i }_i∈[1,10]。對(duì)于每個(gè) c_i,論文確定滿足成本約束的截止閾值。論文使用以下公式近似 APGR:

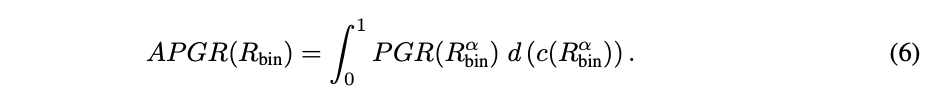

在許多實(shí)際應(yīng)用中,量化達(dá)到某個(gè)性能水平所需的成本是很重要的。因此,論文定義了第二個(gè)指標(biāo),稱為調(diào)用-性能閾值(CPT)。給定所需的路由器性能(以x%的PGR衡量),CPT(x%)指的是獲得所需PGR所需的對(duì)強(qiáng)模型調(diào)用的最小百分比。

在圖1-(右)中,虛線綠線表示CPT(50%),即達(dá)到50% PGR的期望性能所需的對(duì)GPT-4的調(diào)用百分比;在這里,CPT(50%) ≈ 37%。

?2.3 方法論

2.3.1 偏好數(shù)據(jù)?

論文首先描述如何獲取用于訓(xùn)練路由函數(shù)的偏好數(shù)據(jù)。論文主要使用來(lái)自在線Chatbot Arena平臺(tái)[10]的80k對(duì)戰(zhàn)數(shù)據(jù)。在該平臺(tái)上,用戶通過(guò)聊天機(jī)器人界面提交自選提示。提交后,他們會(huì)收到兩個(gè)匿名模型的響應(yīng),并投票選出獲勝模型或平局。由此產(chǎn)生的數(shù)據(jù)集,記為D_arena = {(q, M_i, M_j, l_i,j) | q ∈ Q, M_i, M_j ∈ A, l_{i,j} ∈ C},包含用戶查詢、兩個(gè)模型的回答M_i、M_j以及基于人類(lèi)判斷的成對(duì)比較標(biāo)簽。

使用原始Chatbot Arena數(shù)據(jù)的一個(gè)主要問(wèn)題是標(biāo)簽稀疏性。例如,任意兩個(gè)模型之間的比較標(biāo)簽平均占比不到0.1%。因此,論文按如下方式推導(dǎo)用于訓(xùn)練路由器的偏好數(shù)據(jù):首先,論文通過(guò)將D_arena中的模型聚類(lèi)成10個(gè)不同等級(jí)(見(jiàn)附錄A)來(lái)減少標(biāo)簽稀疏性,使用每個(gè)模型在Chatbot Arena排行榜上的Elo評(píng)分,并通過(guò)動(dòng)態(tài)規(guī)劃盡量減少每個(gè)等級(jí)內(nèi)的變異。論文選擇第一和第二等級(jí)的模型來(lái)代表強(qiáng)模型M_strong,第三等級(jí)的模型代表弱模型M_weak。雖然論文主要在跨這些等級(jí)對(duì)戰(zhàn)上進(jìn)行訓(xùn)練,但也利用涉及其他模型等級(jí)的對(duì)戰(zhàn)來(lái)規(guī)范論文的學(xué)習(xí)方法。關(guān)鍵的是,論文省略了D_arena中的實(shí)際模型響應(yīng),僅保留模型身份。比較標(biāo)簽l_i,j仍然提供了關(guān)于LLM M_i和M_j在不同類(lèi)型和復(fù)雜度查詢q上的相對(duì)能力的洞察。

2.3.1.1數(shù)據(jù)增強(qiáng)

即使在將模型分類(lèi)到等級(jí)后,不同模型類(lèi)別間的用戶偏好信號(hào)仍可能相當(dāng)稀疏。正如論文在第4.1節(jié)中討論的,這可能阻礙泛化,尤其是對(duì)于參數(shù)龐大的模型。因此,論文探索了兩種數(shù)據(jù)增強(qiáng)方法:

黃金標(biāo)注數(shù)據(jù)集:論文通過(guò)形式為D_gold的數(shù)據(jù)集來(lái)增強(qiáng)訓(xùn)練數(shù)據(jù)。此類(lèi)數(shù)據(jù)集的一個(gè)例子是MMLU基準(zhǔn)。論文通過(guò)簡(jiǎn)單比較M_i的響應(yīng)來(lái)計(jì)算l_g,用于增強(qiáng)。

LLM-judge-labeled 數(shù)據(jù)集:論文探索在開(kāi)放式目的聊天領(lǐng)域使用 LLM 判斷[30]獲取偏好標(biāo)簽,因?yàn)樗炎C明與人類(lèi)判斷高度相關(guān)。給定一組用戶查詢,論文首先從 M_strong 中的強(qiáng)模型和 Mweak 中的弱模型生成響應(yīng),然后使用 GPT-4 作為判斷生成成對(duì)比較標(biāo)簽。這種方法的主要挑戰(zhàn)是大量收集 GPT-4 響應(yīng)和成對(duì)比較的高成本。幸運(yùn)的是,Nectar 數(shù)據(jù)集[31]提供了多種查詢及其對(duì)應(yīng)的模型響應(yīng)。論文通過(guò)選擇帶有 GPT-4 響應(yīng)(作為 M_strong 的代表)的查詢,并在此基礎(chǔ)上生成 Mlixtral-8x7B(作為 M_weak 的代表)的響應(yīng),顯著降低了成本。最后,論文獲得了成對(duì)比較標(biāo)簽。

2.3.2 路由方法

論文現(xiàn)在詳細(xì)介紹從偏好數(shù)據(jù) D_pref 學(xué)習(xí)勝預(yù)測(cè)模型 P的方法。

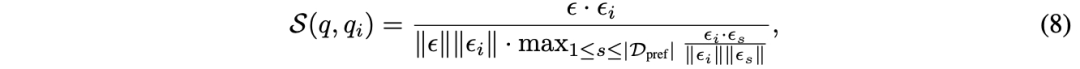

相似性加權(quán)(SW)排名 論文采用類(lèi)似于[10]的 Bradley-Terry(BT)模型。給定用戶查詢 q,論文為訓(xùn)練集中的每個(gè)查詢計(jì)算權(quán)重,基于其相似性。

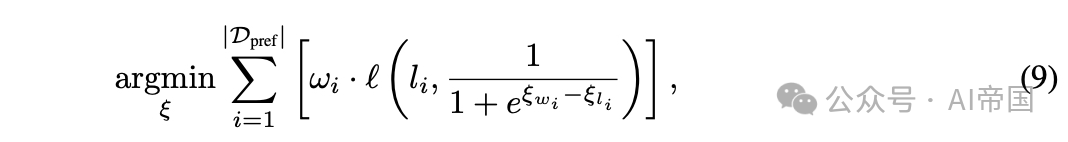

論文通過(guò)以下方式學(xué)習(xí) BT 系數(shù) (代表 10 個(gè)模型類(lèi)別):

其中 l是二元交叉熵?fù)p失。對(duì)于此路由模式,不需要訓(xùn)練,求解在推理時(shí)進(jìn)行。

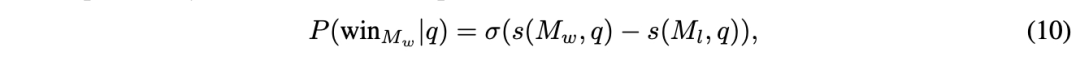

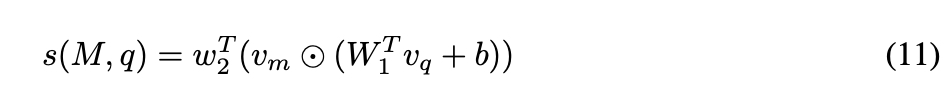

矩陣分解 受推薦系統(tǒng)中矩陣分解模型[18, 25]的啟發(fā),這些模型用于捕捉用戶-物品交互的低秩結(jié)構(gòu),論文利用這種方法對(duì)偏好數(shù)據(jù)進(jìn)行訓(xùn)練。關(guān)鍵在于揭示一個(gè)隱藏的評(píng)分函數(shù) 。評(píng)分 ( s(M_w, q) ) 應(yīng)當(dāng)表示模型 ( M_w ) 對(duì)查詢 ( q ) 的回答質(zhì)量,即如果模型 ( M_w ) 在查詢 ( q ) 上優(yōu)于模型 ( M_l ),則 ( s(M_w, q) > s(M_l, q) )。論文通過(guò)使用BT關(guān)系建模獲勝概率來(lái)強(qiáng)化這種關(guān)系:

論文在偏好數(shù)據(jù)上優(yōu)化這一關(guān)系。論文將評(píng)分函數(shù) ( s ) 建模為模型和查詢的雙線性函數(shù),并將模型身份 ( M ) 嵌入到一個(gè) ( d_m ) 維向量 ( v_m ) 中,將查詢嵌入到一個(gè) ( d_q ) 維向量 ( v_q ) 中;

這種方法本質(zhì)上是在集合上學(xué)習(xí)評(píng)分矩陣的矩陣分解。論文使用8GB GPU對(duì)模型進(jìn)行10個(gè)周期的訓(xùn)練,批次大小為64,采用學(xué)習(xí)率為3 x 10^-4、權(quán)重衰減為1 x 10^-5的Adam優(yōu)化器。

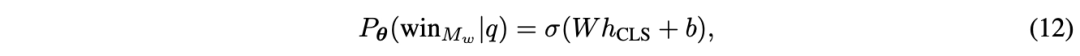

BERT分類(lèi)器 在此,論文探索使用一種標(biāo)準(zhǔn)文本分類(lèi)方法,該方法的參數(shù)數(shù)量較之前的方法更多。論文采用BERT-base架構(gòu),為用戶的查詢提供上下文嵌入,并定義勝率概率為:

因果LLM分類(lèi)器 論文最終通過(guò)使用Llama 3 8B參數(shù)化來(lái)擴(kuò)展論文路由器的能力。論文采用指令遵循范式[28],即論文提供包含用戶查詢的指令提示作為輸入,并以下一詞預(yù)測(cè)方式輸出獲勝概率,而不是使用單獨(dú)的分類(lèi)頭。值得注意的是,論文將比較標(biāo)簽作為額外詞匯追加,并計(jì)算標(biāo)簽類(lèi)別C上的softmax作為獲勝概率。

2.4 實(shí)驗(yàn)?

訓(xùn)練數(shù)據(jù):論文主要使用80K聊天機(jī)器人競(jìng)技場(chǎng)來(lái)訓(xùn)練論文的模型,但保留了5k樣本用于驗(yàn)證。論文剔除了所有少于16個(gè)字符的提示樣本,從而得到了65k對(duì)來(lái)自64個(gè)不同模型的比較。這些對(duì)話涵蓋了超過(guò)100種語(yǔ)言,其中大部分(81%)為英語(yǔ),其次是中文(3.1%)和俄語(yǔ)(2.2%)。論文將模型分配到10個(gè)類(lèi)別以減少比較標(biāo)簽的稀疏性。如第3.1.1節(jié)所討論,論文進(jìn)一步通過(guò)以下方式增強(qiáng)訓(xùn)練數(shù)據(jù):

評(píng)估基準(zhǔn):論文在三個(gè)廣泛使用的學(xué)術(shù)基準(zhǔn)上評(píng)估論文的路由器:MMLU 包含57個(gè)學(xué)科的14,042個(gè)問(wèn)題,MT Bench 使用LLM作為評(píng)判的160個(gè)開(kāi)放式問(wèn)題,以及GSM8K 超過(guò)1,000個(gè)小學(xué)數(shù)學(xué)問(wèn)題。此外,論文還進(jìn)行了評(píng)估與訓(xùn)練數(shù)據(jù)集之間的交叉污染檢查,并報(bào)告了未受污染的結(jié)果。論文展示公共基準(zhǔn)上的結(jié)果,以理解路由器的域外泛化能力。

路由器:對(duì)于矩陣分解路由器和相似性加權(quán)排序路由器,論文使用OpenAI的嵌入模型text-embedding-3-small來(lái)嵌入輸入查詢。論文對(duì)BERT和因果LLM進(jìn)行全參數(shù)微調(diào),并使用驗(yàn)證集進(jìn)行模型選擇。論文選擇使用gpt-4-1106-preview [20]作為Mstrong中的代表模型,以及Mixtral 8x7B 作為Mweak中的代表模型,以具體評(píng)估路由器性能。論文還使用了一個(gè)在成本約束下隨機(jī)路由查詢的隨機(jī)路由器作為基線。

2.4.1 結(jié)果

表1:MT Bench結(jié)果。注意,CPT在30%時(shí)的分?jǐn)?shù)(8.8)是95%的GPT-4性能(9.3)。論文的路由器在Darena訓(xùn)練時(shí)在MT Bench上表現(xiàn)出強(qiáng)勁性能,當(dāng)數(shù)據(jù)集增加Djudge時(shí),性能進(jìn)一步提高,與隨機(jī)路由器相比,成本降低了高達(dá)75%

表1展示了論文的路由器在MT Bench上的性能。對(duì)于在Arena數(shù)據(jù)集上訓(xùn)練的路由器,論文觀察到矩陣分解和相似性加權(quán)排序都有很強(qiáng)的性能,兩者在所有指標(biāo)上都顯著優(yōu)于隨機(jī)路由器。值得注意的是,矩陣分解所需的GPT-4調(diào)用次數(shù)是隨機(jī)路由器的一半,以達(dá)到50%的PGR。然而,論文的BERT和因果LLM分類(lèi)器在Arena數(shù)據(jù)集上訓(xùn)練時(shí)表現(xiàn)接近隨機(jī),論文認(rèn)為這是由于高容量方法在低數(shù)據(jù)體制下表現(xiàn)較差。

使用GPT-4法官增強(qiáng)偏好數(shù)據(jù),導(dǎo)致所有路由器的性能顯著提升。BERT和因果LLM路由器現(xiàn)在表現(xiàn)遠(yuǎn)超隨機(jī)基線,BERT分類(lèi)器的APGR比隨機(jī)提升了超過(guò)50%。在這個(gè)增強(qiáng)數(shù)據(jù)集上訓(xùn)練時(shí),矩陣分解是表現(xiàn)最好的路由器,其CPT(80%)幾乎減半,所需的GPT-4調(diào)用次數(shù)比隨機(jī)少50%。

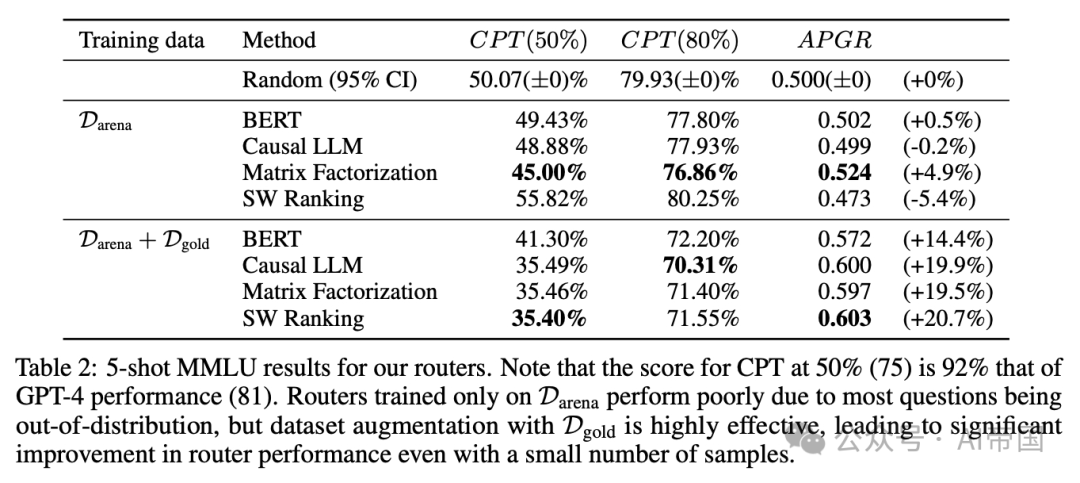

表2:論文的路由器在5-shot MMLU上的結(jié)果。請(qǐng)注意,CPT在50%(75)的得分是GPT-4性能(81)的92%。僅在Darena上訓(xùn)練的路由器表現(xiàn)不佳,因?yàn)榇蠖鄶?shù)問(wèn)題都是分布外的,但使用Dgold進(jìn)行數(shù)據(jù)集增強(qiáng)非常有效,即使樣本數(shù)量很少,也能顯著提高路由器性能

在MMLU測(cè)試集(表2)上,所有路由器在僅使用Arena數(shù)據(jù)集進(jìn)行訓(xùn)練時(shí)表現(xiàn)不佳,其水平相當(dāng)于隨機(jī)路由器,論文認(rèn)為這主要是由于大多數(shù)MMLU問(wèn)題超出了訓(xùn)練數(shù)據(jù)的分布范圍。然而,通過(guò)在訓(xùn)練數(shù)據(jù)集中加入來(lái)自MMLU驗(yàn)證集的金標(biāo)準(zhǔn)數(shù)據(jù),所有路由器在MMLU上的性能都得到了顯著提升,所有路由器所需的GPT-4調(diào)用次數(shù)比隨機(jī)路由器減少了約20%,以達(dá)到CPT(50%6)。重要的是,盡管額外加入的約1500個(gè)金標(biāo)準(zhǔn)樣本僅占總體訓(xùn)練數(shù)據(jù)的不到2%,這一結(jié)果仍展示了數(shù)據(jù)集增強(qiáng)在小樣本量情況下的有效性。

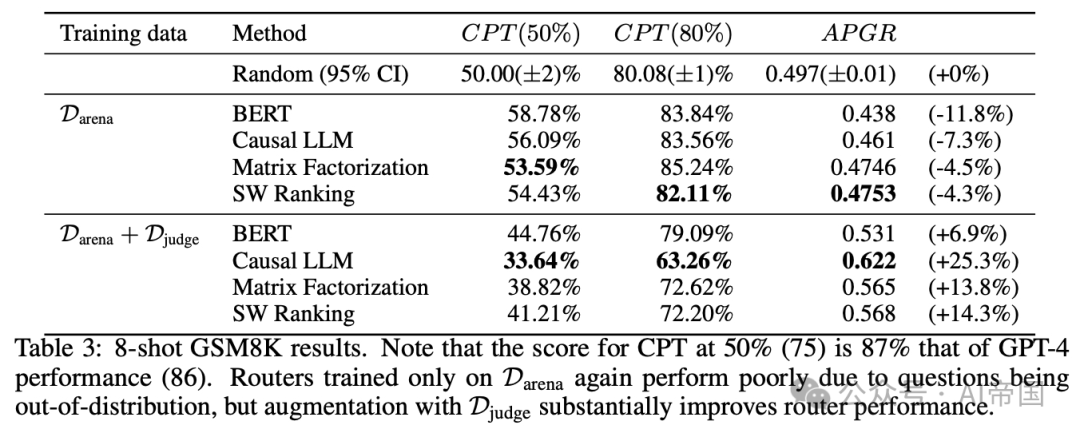

表3:8-shot GSM8K測(cè)試結(jié)果。注意,CPT在50%時(shí)的得分(75)是GPT-4性能(86)的87%。僅在PDarena上訓(xùn)練的路由器再次因問(wèn)題超出訓(xùn)練數(shù)據(jù)分布而表現(xiàn)不佳,但通過(guò)Diudge數(shù)據(jù)集的增強(qiáng),路由器性能得到了顯著提升。

最終,在GSM8K上(表3),論文觀察到與MMLU類(lèi)似,僅在Arena數(shù)據(jù)集上訓(xùn)練的所有路由器的性能接近隨機(jī)。然而,通過(guò)在由LLM法官生成的合成數(shù)據(jù)增強(qiáng)的數(shù)據(jù)集上訓(xùn)練論文的路由器,性能顯著提升,所有路由器的APGR從低于隨機(jī)變?yōu)楦哂陔S機(jī)。當(dāng)在此增強(qiáng)數(shù)據(jù)集上訓(xùn)練時(shí),因果LLM分類(lèi)器在所有路由器中表現(xiàn)最佳,相比隨機(jī)方法,實(shí)現(xiàn)CPT(50%)和CPT(80%)所需的GPT-4調(diào)用減少了17%。

2.4.2 量化數(shù)據(jù)集與基準(zhǔn)的相似性

論文將同一數(shù)據(jù)集上訓(xùn)練的路由器在不同基準(zhǔn)上性能差異歸因于評(píng)估數(shù)據(jù)和訓(xùn)練數(shù)據(jù)分布的不同。對(duì)于每個(gè)基準(zhǔn)-數(shù)據(jù)集對(duì),論文在表4中計(jì)算了一個(gè)基準(zhǔn)-數(shù)據(jù)集相似度分?jǐn)?shù),該分?jǐn)?shù)指示評(píng)估數(shù)據(jù)在訓(xùn)練數(shù)據(jù)中的代表性程度。

表4:基準(zhǔn)-數(shù)據(jù)集相似度分?jǐn)?shù)顯示這些分?jǐn)?shù)與路由器在相應(yīng)基準(zhǔn)上的性能之間存在強(qiáng)相關(guān)性,為定量提升路由器性能提供了一種方法

較高的基準(zhǔn)數(shù)據(jù)集相似度分?jǐn)?shù)與使用相應(yīng)數(shù)據(jù)集訓(xùn)練的路由器在該基準(zhǔn)上的更強(qiáng)性能相關(guān),如第4.1節(jié)所示。數(shù)據(jù)集增強(qiáng),無(wú)論是使用黃金標(biāo)注數(shù)據(jù)集還是LLM法官標(biāo)注數(shù)據(jù)集,都會(huì)使偏好數(shù)據(jù)的整體分布更符合基準(zhǔn),并提高基準(zhǔn)數(shù)據(jù)集相似度分?jǐn)?shù),從而轉(zhuǎn)化為性能提升。這種相似度分?jǐn)?shù)對(duì)于理解路由器在不同基準(zhǔn)上的相對(duì)性能也很有用:在Arena數(shù)據(jù)集上,MT Bench與所有數(shù)據(jù)集的相似度分?jǐn)?shù)明顯高于其他基準(zhǔn),論文認(rèn)為這解釋了與GSM8K和MMLU相比,路由器在MT Bench上的相對(duì)更強(qiáng)性能。鑒于對(duì)查詢分布的了解,基準(zhǔn)數(shù)據(jù)集相似度分?jǐn)?shù)是系統(tǒng)性提升路由器在實(shí)際用例中性能的有前景方向。

2.4.3 推廣到其他模型對(duì)

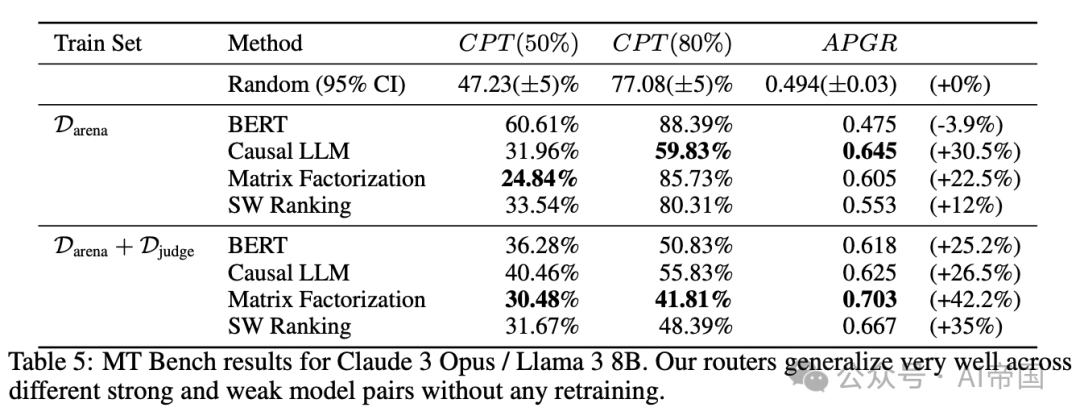

論文選擇gpt-4-1106-preview 和Mixtral 8x7B作為上述實(shí)驗(yàn)的代表性強(qiáng)模型和弱模型。然而,為了證明論文的框架對(duì)不同模型對(duì)的通用性,本節(jié)報(bào)告了在MT Bench上,當(dāng)路由器在Claude 3 Opus和Llama 3 8B之間路由時(shí)的性能。重要的是,論文使用相同的路由器而無(wú)需任何再訓(xùn)練,僅替換路由到的強(qiáng)模型和弱模型。這兩個(gè)模型也不存在于論文的訓(xùn)練數(shù)據(jù)中。

表5:Claude 3 Opus / Llama 3 8B在MT Bench上的結(jié)果。論文的路由器在不同強(qiáng)弱模型對(duì)之間具有很好的泛化能力,無(wú)需任何再訓(xùn)練

再次,論文觀察到即使在更換模型對(duì)的情況下,所有現(xiàn)有路由器在MT Bench上的性能依然強(qiáng)勁。所有路由器的性能與原始模型對(duì)相當(dāng)。新模型對(duì)和原始模型對(duì)的結(jié)果仍然明顯強(qiáng)于隨機(jī),論文的路由器在達(dá)到CPT(80%)時(shí)所需的GPT-4調(diào)用次數(shù)最多可減少30%。這些結(jié)果表明,論文的路由器已經(jīng)學(xué)習(xí)了一些能夠區(qū)分強(qiáng)弱模型的常見(jiàn)問(wèn)題特征,這些特征可以泛化到新的強(qiáng)弱模型對(duì),而無(wú)需額外訓(xùn)練。

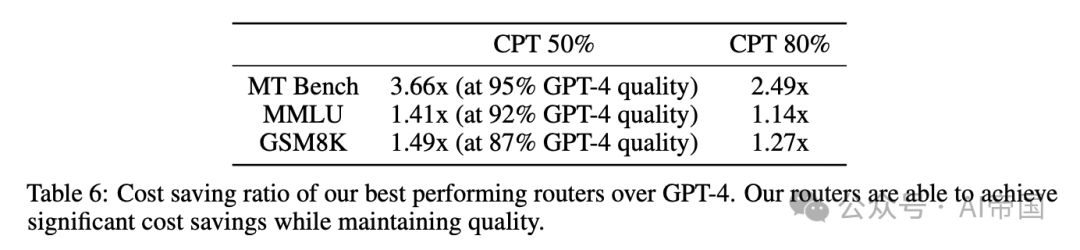

2.4.4 成本分析

表6:論文的最佳表現(xiàn)路由器相對(duì)于GPT-4的成本節(jié)約比率。論文的路由器能夠在保持質(zhì)量的同時(shí)實(shí)現(xiàn)顯著的成本節(jié)約

論文估計(jì)使用GPT-4和Mixtral 8x7B的平均成本分別為每百萬(wàn) tokens 24.7和0.24。在表6中,論文展示了量化論文方法所實(shí)現(xiàn)的成本節(jié)約的結(jié)果。論文計(jì)算了論文的頂級(jí)表現(xiàn)路由器相對(duì)于隨機(jī)基線的GPT-4調(diào)用比例的倒數(shù),因?yàn)镚PT-4的成本是論文分析中的主要因素。論文的路由器實(shí)現(xiàn)了高達(dá)3.66倍的最優(yōu)成本節(jié)約,表明路由可以在保持響應(yīng)質(zhì)量的同時(shí)顯著降低成本。

2.4.5 路由開(kāi)銷(xiāo)

表7:不同路由器的成本和推理開(kāi)銷(xiāo)。與LLM生成成本相比,部署路由器的成本較小,同時(shí)也能支持實(shí)際工作負(fù)載

與使用單一模型相比,LLM路由的一個(gè)擔(dān)憂是其路由開(kāi)銷(xiāo)。因此,論文在表7中測(cè)量并報(bào)告了論文的路由器的開(kāi)銷(xiāo),以展示它們?cè)趯?shí)際應(yīng)用中的可行性,使用了從Chatbot Arena隨機(jī)抽樣的對(duì)話。對(duì)于需要GPU的路由器,即矩陣分解和分類(lèi)器方法,論文使用了包含單個(gè)NVIDIA L4 GPU的Google Cloud的g2-standard-4 VM。對(duì)于相似性加權(quán)排序,論文使用了Google Cloud的僅CPU的n2-standard-8 VM。論文基于GPU的路由器目前比基于CPU的路由器效率高得多,但論文注意到在優(yōu)化路由器吞吐量方面仍有很大的改進(jìn)空間。然而,即使是SW排序,論文最昂貴的路由器,與GPT-4生成相比,引入的額外成本也不超過(guò)0.4%。

本文轉(zhuǎn)載自 ??AI帝國(guó)??,作者: 無(wú)影寺