Llama3背后的秘密:HuggingFace發布萬億級數據集Fineweb 原創 精華

Llama3是在15萬億個公共數據標記上進行訓練的。但是,您可以在哪里找到這樣的數據集和處理方法呢?

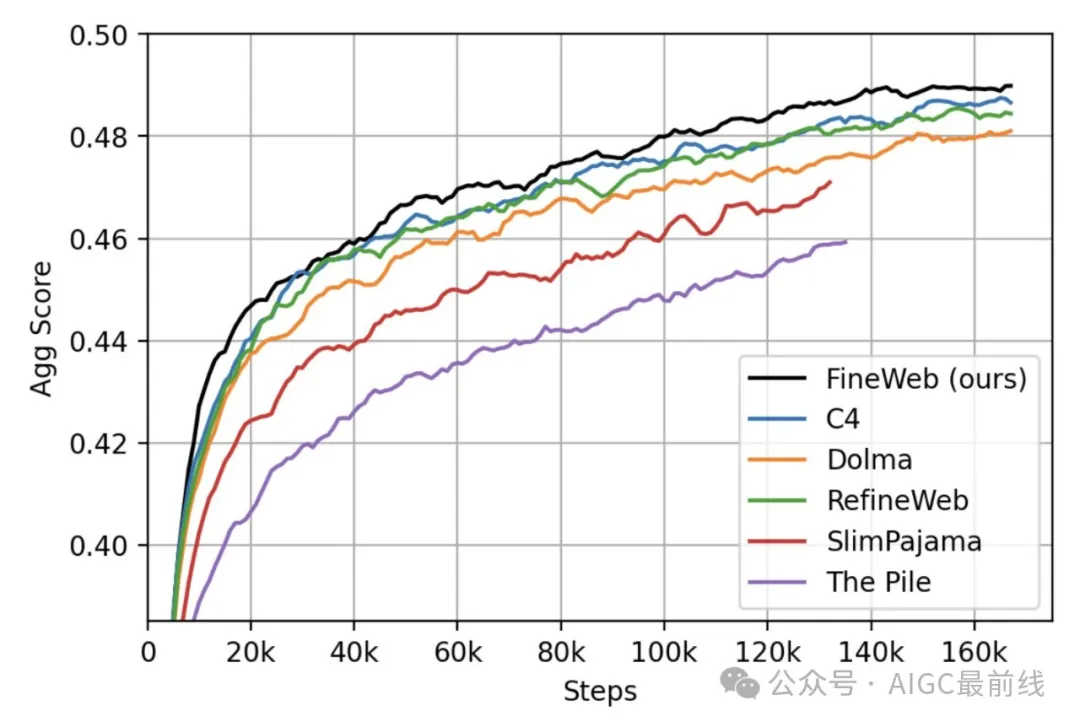

近日,HuggingFace發布??Fineweb,一個高質量的大規模篩選網絡數據集,優于目前所有同等規模的數據集。HuggingFace訓練了200多個消融模型,精心制作了這個數據集,對Common Crawl進行了解析和過濾。HuggingFace對2013年至2024年間的所有CommonCrawl數據進行了篩選和去重。在FineWeb上訓練的模型優于RefinedWeb、C4、DolmaV1.6、The Pile和SlimPajama

所有的處理方法、數據、消融模型和超參數都是開源的,并且HuggingFace計劃持續改進Fineweb。

這是什么?

?? FineWeb數據集由超過15T標記的英文網絡數據組成,經過了清洗和去重處理,數據來源于CommonCrawl。數據處理流程針對LLM性能進行了優化,并在我們的大規模數據處理庫?? datatrove上運行。

?? FineWeb最初旨在成為?? RefinedWeb的完全開放復制品,全套數據集將根據ODC-By 1.0許可證發布。然而,通過謹慎添加額外的過濾步驟,研究人員成功將?? FineWeb的性能推高到原始?? RefinedWeb的水平之上,并且在基準任務組上,基于數據集訓練的模型也優于基于其他常用高質量網絡數據集(如C4、Dolma-v1.6、The Pile、SlimPajama)訓練的模型。

發布了什么?

除了數據集之外,還包括自2013年以來的所有CommonCrawl轉儲數據。HuggingFace還在此處共享了使用?? datatrove庫完全重現我們處理設置所需的所有代碼。為了實現對結果的完全復制,HuggingFace還發布了我們使用nanotron訓練的小型消融模型,以驗證數據集并與其他參考數據集進行比較。您可以在此處找到它們,每1000步進行一次檢查點。HuggingFace還在此處發布了我們的評估結果。

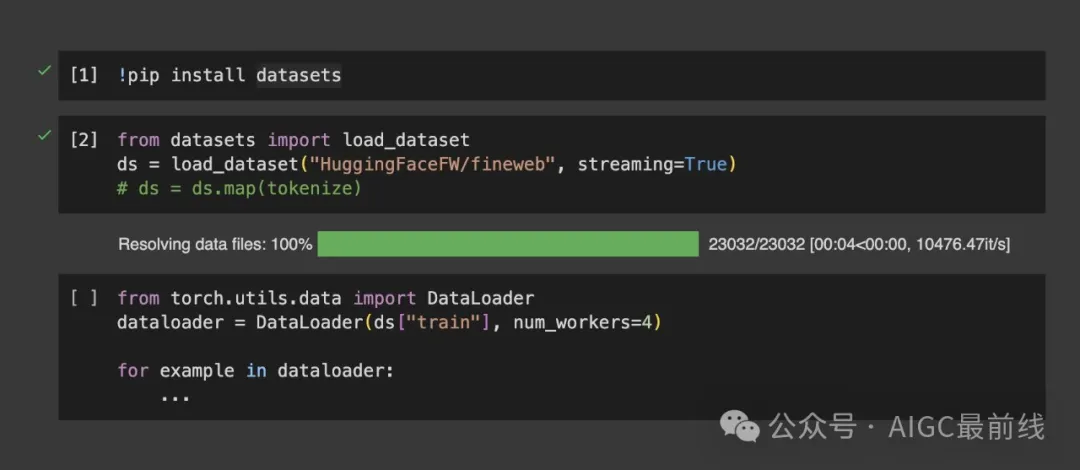

如何下載和使用?? FineWeb

方法1

from datasets import load_dataset

fw = load_dataset("HuggingFaceFW/fineweb", name="CC-MAIN-2024-10", split="train", streaming=True)方法2

from huggingface_hub import snapshot_download

folder = snapshot_download(

"HuggingFaceFW/fineweb",

repo_type="dataset",

local_dir="./fineweb/",

allow_patterns="data/CC-MAIN-2023-50/*")譯自(有刪改):https://huggingface.co/datasets/HuggingFaceFW/fineweb

本文轉載自公眾號AIGC最前線