統(tǒng)一多模態(tài)大模型!PUMA:多粒度策略笑傲生成、編輯、修復(fù)、著色、條件生成和理解!

文章鏈接:https://arxiv.org/pdf/2410.13861

項目鏈接:https://github.com/rongyaofang/PUMA

亮點直擊

- 多粒度特征處理: PUMA 能夠同時處理粗粒度和細粒度的視覺特征,適應(yīng)不同任務(wù)的需求,如文本到圖像生成和圖像編輯,解決了現(xiàn)有模型在多樣性和精確可控性之間的平衡問題。

- 統(tǒng)一多模態(tài)框架: PUMA 通過統(tǒng)一的多模態(tài)大模型框架,無縫集成圖像生成與理解,適用于從多樣化圖像生成到精確圖像編輯等多種任務(wù),擴展了多模態(tài)模型的應(yīng)用范圍。

- 兩階段訓(xùn)練策略: 首先微調(diào)預(yù)訓(xùn)練的擴散模型進行圖像解碼,然后訓(xùn)練自回歸多模態(tài)模型生成多尺度圖像特征,優(yōu)化了多任務(wù)處理的性能。

- 廣泛的多模態(tài)任務(wù)適應(yīng)性: PUMA 通過在語言-視覺數(shù)據(jù)集上的大規(guī)模預(yù)訓(xùn)練和指令微調(diào),展示了其在圖像理解、文本到圖像生成、圖像修復(fù)等多種任務(wù)中的出色表現(xiàn)。

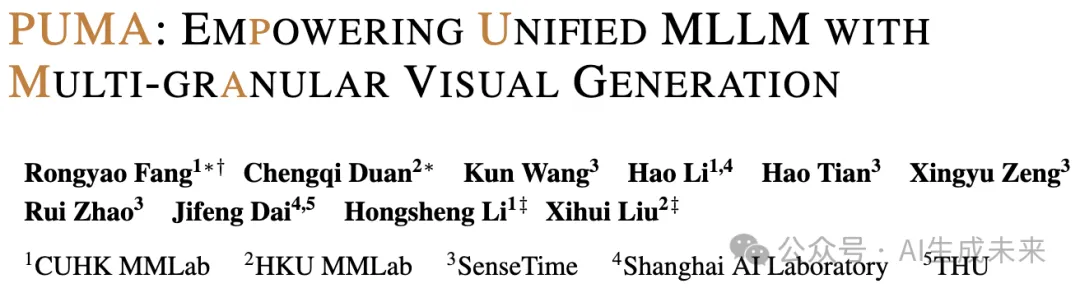

- a) 圖像生成任務(wù)中的多樣性和可控性權(quán)衡:多樣化的文本到圖像生成需要高多樣性和保真度,而條件生成和修剪等任務(wù)需要對圖像進行高可控性。

- b) 引入的PUMA是一種統(tǒng)一的多模態(tài)大語言模型,可以處理和生成多粒度視覺表示,平衡視覺生成任務(wù)的多樣性和可控性。它擅長圖像理解、多樣化的文本到圖像生成、編輯、修復(fù)、著色和條件圖像生成。

總結(jié)速覽

解決的問題:

現(xiàn)有的多模態(tài)大模型(MLLMs)在視覺內(nèi)容生成方面沒有充分解決不同圖像生成任務(wù)對粒度的需求差異,尤其是從文本到圖像生成的多樣性需求以及圖像編輯中的精確可控性。

提出的方案:

提出了一種名為PUMA(emPowering Unified MLLM with Multi-grAnular visual generation)的模型,旨在通過統(tǒng)一多粒度視覺特征作為MLLMs的輸入和輸出,優(yōu)雅地解決不同任務(wù)的粒度需求。

應(yīng)用的技術(shù):

采用了多模態(tài)預(yù)訓(xùn)練和任務(wù)特定的指令微調(diào),將多粒度視覺生成功能融入到統(tǒng)一的MLLM框架中。

達到的效果:

PUMA在廣泛的多模態(tài)任務(wù)中表現(xiàn)出色,能夠適應(yīng)不同視覺任務(wù)的粒度需求,向真正統(tǒng)一的MLLM邁出了重要一步。

方法

現(xiàn)有的方法通常僅優(yōu)化細粒度或粗粒度特征,從而在精確控制和生成多樣性之間存在權(quán)衡。為克服這一局限性,本文提出了PUMA,一個統(tǒng)一的多粒度MLLM范式。本文的方法能夠在統(tǒng)一的MLLM框架中同時處理多個層次的特征粒度,促進跨多種多模態(tài)任務(wù)的無縫轉(zhuǎn)換。

本文的框架包括三個關(guān)鍵組成部分:圖像編碼器、基于不同粒度特征的圖像解碼器集合以及多粒度自回歸MLLM。這些組件協(xié)同工作,以提取、處理和生成多尺度圖像特征,適應(yīng)各種任務(wù)特定的粒度需求。為了優(yōu)化MLLM,采用了預(yù)訓(xùn)練和指令微調(diào)的兩階段過程,使其能夠執(zhí)行包括圖像理解、生成、編輯和條件圖像生成在內(nèi)的多種任務(wù)。

圖像編碼與多粒度特征提取

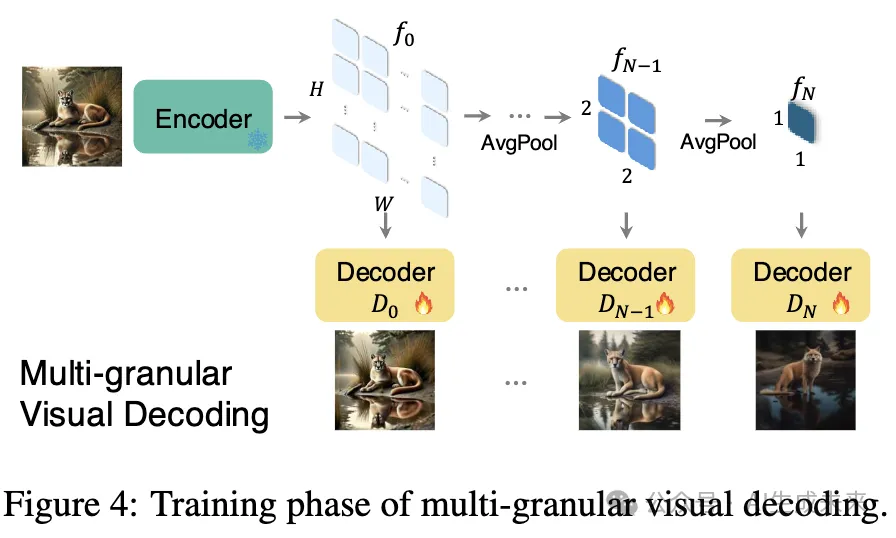

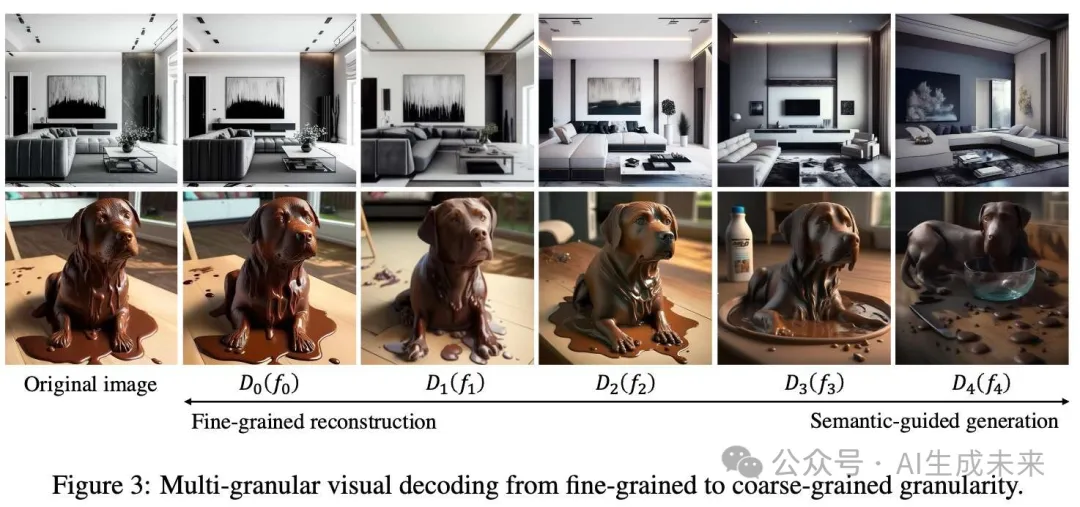

多粒度視覺解碼

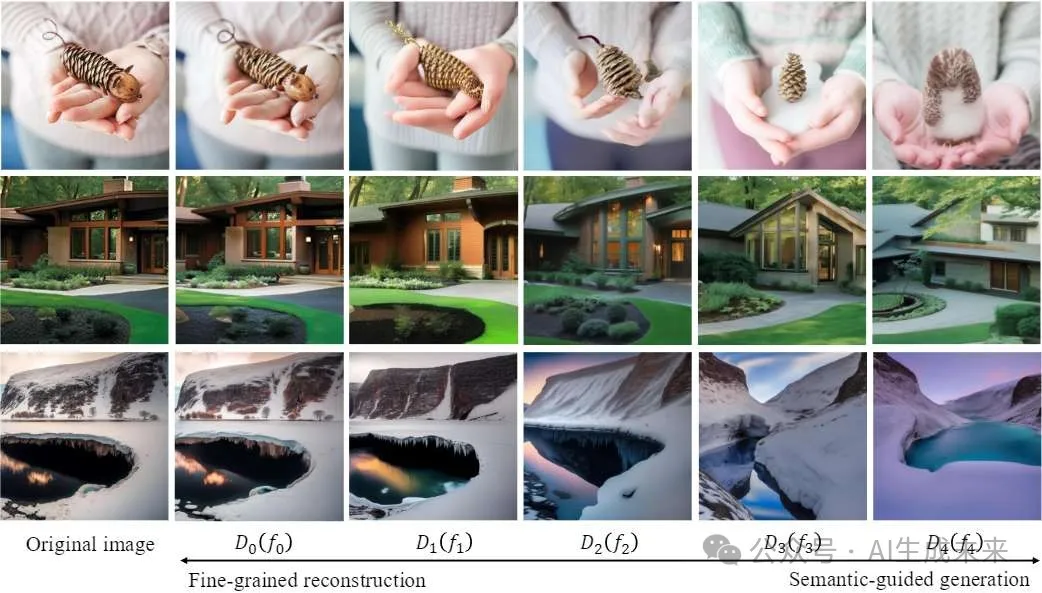

不同粒度的圖像特征編碼了不同層次的信息。采用基于擴散模型的解碼器,因為它們能夠靈活處理多尺度特征。在處理粗粒度語義特征時,解碼器能夠有效地利用它們學習到的圖像先驗,補充缺失的細粒度信息,并生成多樣化且語義對齊的圖像。另一方面,在處理細粒度特征時,它們能夠準確重構(gòu)精確的圖像細節(jié)。這種在不同粒度下生成或重構(gòu)圖像的多樣性使基于擴散模型的解碼器非常適合多粒度的方法。

下圖4展示了不同粒度圖像解碼的訓(xùn)練過程,其中圖像編碼器被凍結(jié)以保留語義屬性。

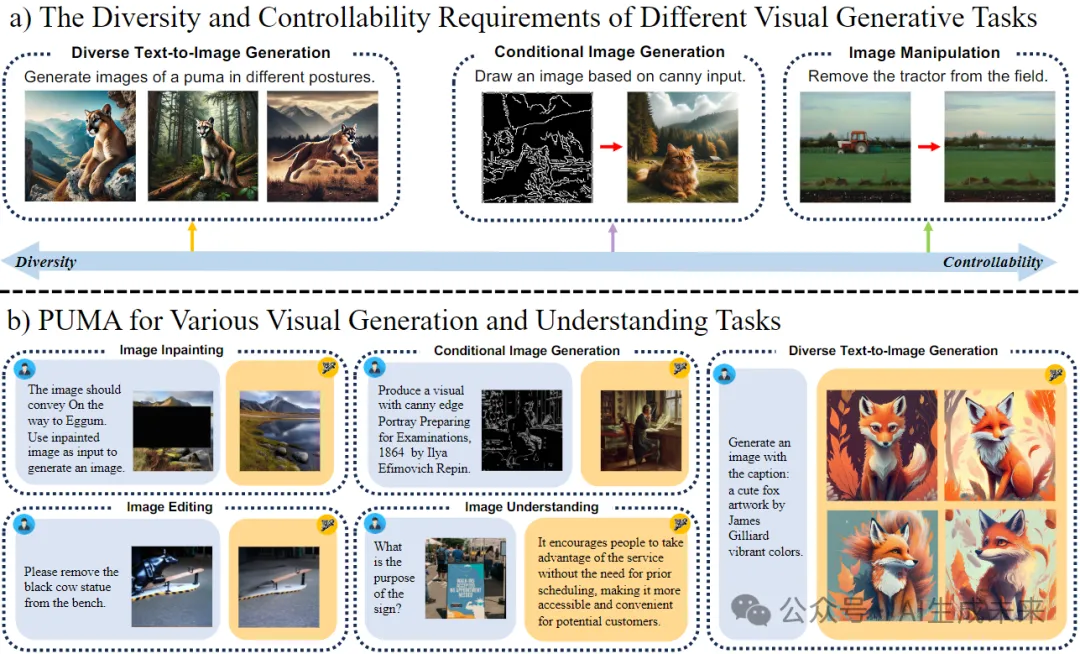

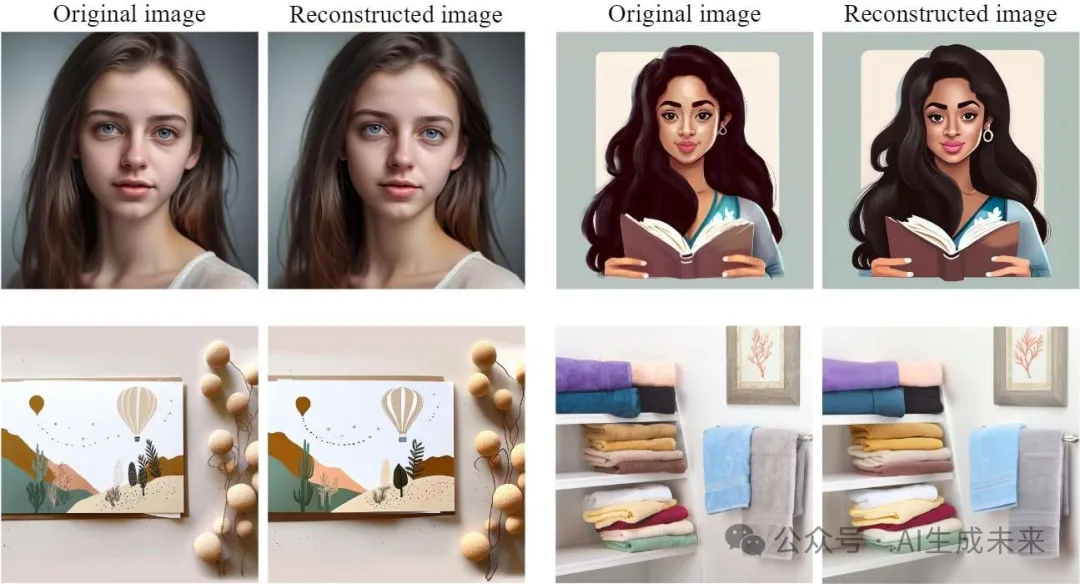

下圖3展示了多粒度解碼器的視覺解碼能力。這些可視化結(jié)果顯示了在不同粒度下解碼圖像的保真度,細粒度特征能夠生成與原始輸入更接近的重構(gòu)圖像,而粗粒度特征則根據(jù)輸入圖像的語義引導(dǎo)生成圖像。這驗證了本文方法在保留和利用多粒度視覺信息方面的有效性。

該多粒度解碼框架與層次化特征提取相結(jié)合,為MLLM架構(gòu)的后續(xù)階段奠定了基礎(chǔ),為后期訓(xùn)練階段中的多樣化視覺任務(wù)鋪平了道路。

自回歸MLLM中的漸進多粒度圖像建模

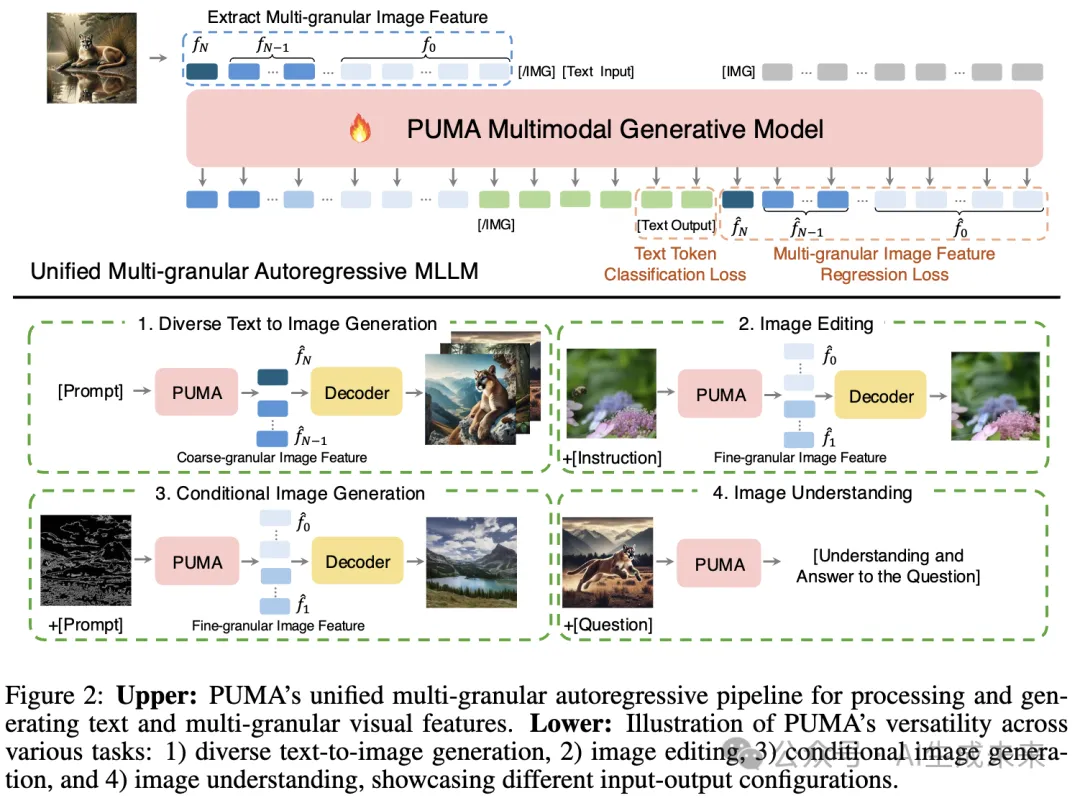

為了利用一個能夠適應(yīng)各種具有不同粒度需求的視覺-語言任務(wù)的統(tǒng)一框架,設(shè)計了一個自回歸MLLM來處理和生成文本tokens及多粒度圖像特征。

自回歸MLLM,記為 M,逐步處理文本和多粒度圖像特征,如下圖2所示。模型逐個tokens地處理特征,在每個粒度級別內(nèi)依次預(yù)測每個token,并從最粗的粒度級別N逐漸過渡到最細的粒度級別0。這種方法允許模型在獲取更多詳細信息時逐步改進其預(yù)測。

將輸入序列構(gòu)建為文本tokens和來自多個粒度級別的展平圖像特征tokens的拼接。該漸進方法使模型能夠捕捉不同尺度間的依賴關(guān)系,從粗略的全局結(jié)構(gòu)到精細的局部細節(jié)。

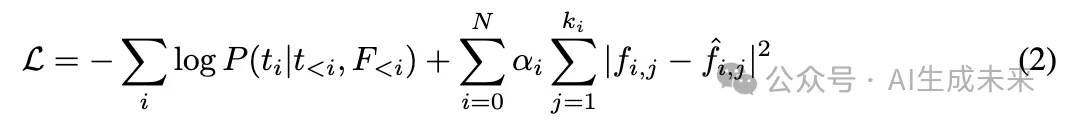

MLLM通過自回歸的下一個token預(yù)測目標進行訓(xùn)練,結(jié)合了文本和圖像的損失。

多模態(tài)預(yù)訓(xùn)練和指令微調(diào)

為了展示統(tǒng)一多粒度范式的有效性,為PUMA實施了一個全面的兩階段訓(xùn)練流程:首先是多模態(tài)預(yù)訓(xùn)練,隨后是任務(wù)特定的指令微調(diào)。這種方法使模型首先獲得廣泛的多模態(tài)能力,然后在后續(xù)的指令微調(diào)階段專注于目標視覺語言任務(wù)。

多模態(tài)預(yù)訓(xùn)練:多模態(tài)預(yù)訓(xùn)練利用了一組多樣化的大規(guī)模數(shù)據(jù)集:Laion-2B、Laion-Aesthetics、GRIT、The Pile、OCR-VQA-200K 和 LLaVAR。這些數(shù)據(jù)集的組合提供了豐富的圖文對、文本數(shù)據(jù)和特定的視覺問答樣本。為了增強模型對圖文關(guān)系的雙向理解,采用了一種動態(tài)訓(xùn)練策略,隨機交替每個圖文對的文本生成圖像和圖像生成文本任務(wù)。

指令微調(diào):在預(yù)訓(xùn)練之后,進行針對性的指令微調(diào),使模型適應(yīng)特定的視覺語言任務(wù)。為了評估PUMA在不同任務(wù)類型上的表現(xiàn),針對四種任務(wù)分別微調(diào)了四個模型,每個模型都從預(yù)訓(xùn)練檢查點初始化。

- 高質(zhì)量的文本生成圖像:利用 Laion-Aesthetics 和 JourneyDB 數(shù)據(jù)集,專注于生成美觀且多樣化的圖像。

- 精確的圖像操作:通過SEED-Edit數(shù)據(jù)集進行訓(xùn)練,實現(xiàn)準確且可控的圖像編輯。

- 條件圖像生成:利用 MultiGen-20M 數(shù)據(jù)集的子集(包括輪廓生成、修復(fù)、和著色)使模型具備在特定條件和限制下生成圖像的能力。

- 圖像理解:通過 LLaVA-OneVision 和 Cambrian 數(shù)據(jù)集的子集進行微調(diào),以增強模型的圖像理解能力。數(shù)據(jù)集中關(guān)于數(shù)學/推理以及重復(fù)數(shù)據(jù)被移除。

實驗

實驗結(jié)果如下:首先詳細描述了實驗設(shè)置。再評估了多粒度特征編碼和基于擴散的多粒度圖像解碼器的有效性。隨后展示了 PUMA 在多項任務(wù)中的多功能性:多樣化的文本生成圖像、圖像編輯、條件圖像生成和視覺語言理解。

設(shè)置

統(tǒng)一多粒度多模態(tài)語言模型 (MLLM) 采用 LLaMA-3 8B 作為語言模型骨干,使用 CLIP-Large (224×224 輸入) 作為圖像編碼器。圖像解碼器則初始化自預(yù)訓(xùn)練的 SDXL 模型。

多粒度視覺解碼

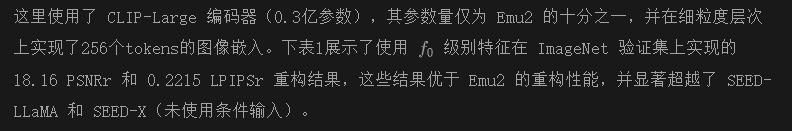

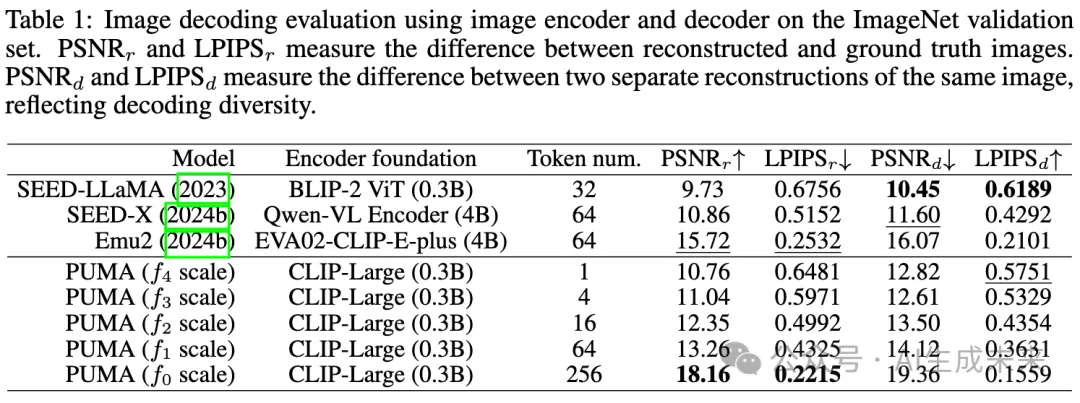

細粒度圖像重構(gòu)

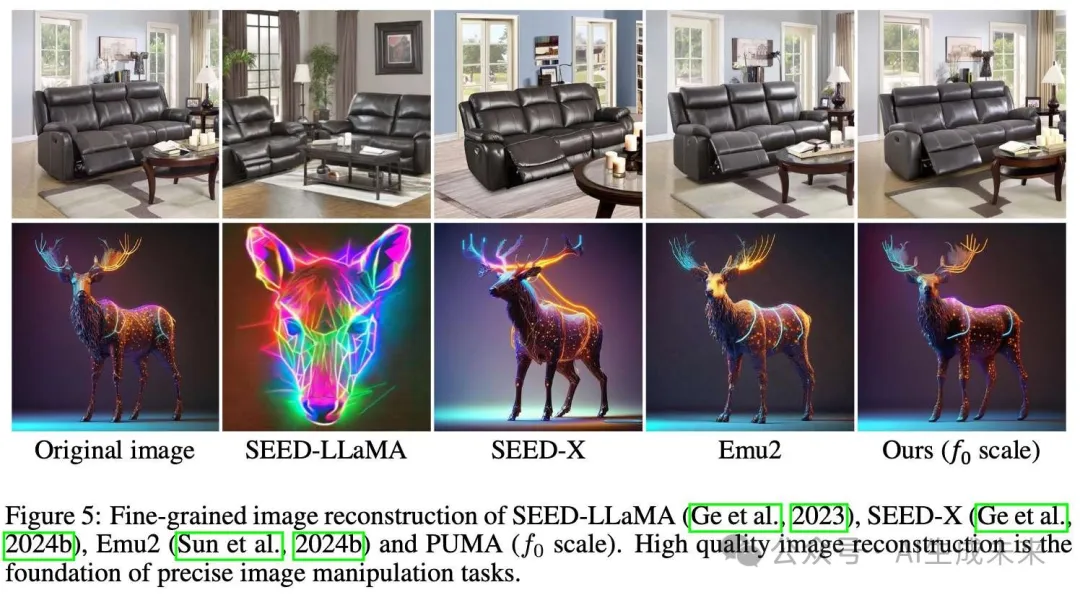

細粒度圖像重構(gòu)對于保持圖像細節(jié)至關(guān)重要,但對模型如 SEED-LLaMA、SEED-X 和 Emu2 而言是個重大挑戰(zhàn)。SEED-LLaMA 和 SEED-X 在詳細重構(gòu)上表現(xiàn)不佳,限制了它們在不使用如條件圖像輸入(SEED-X 中使用的)等額外技術(shù)的情況下精確操作圖像的能力。Emu2 嘗試通過將其圖像編碼器擴大至40億參數(shù)來改進重構(gòu)。本文的方法則通過更高效的架構(gòu)實現(xiàn)了優(yōu)越的重構(gòu)質(zhì)量。

下圖5也直觀展示了本文方法在重構(gòu)質(zhì)量上的優(yōu)越性。

語義引導(dǎo)的生成

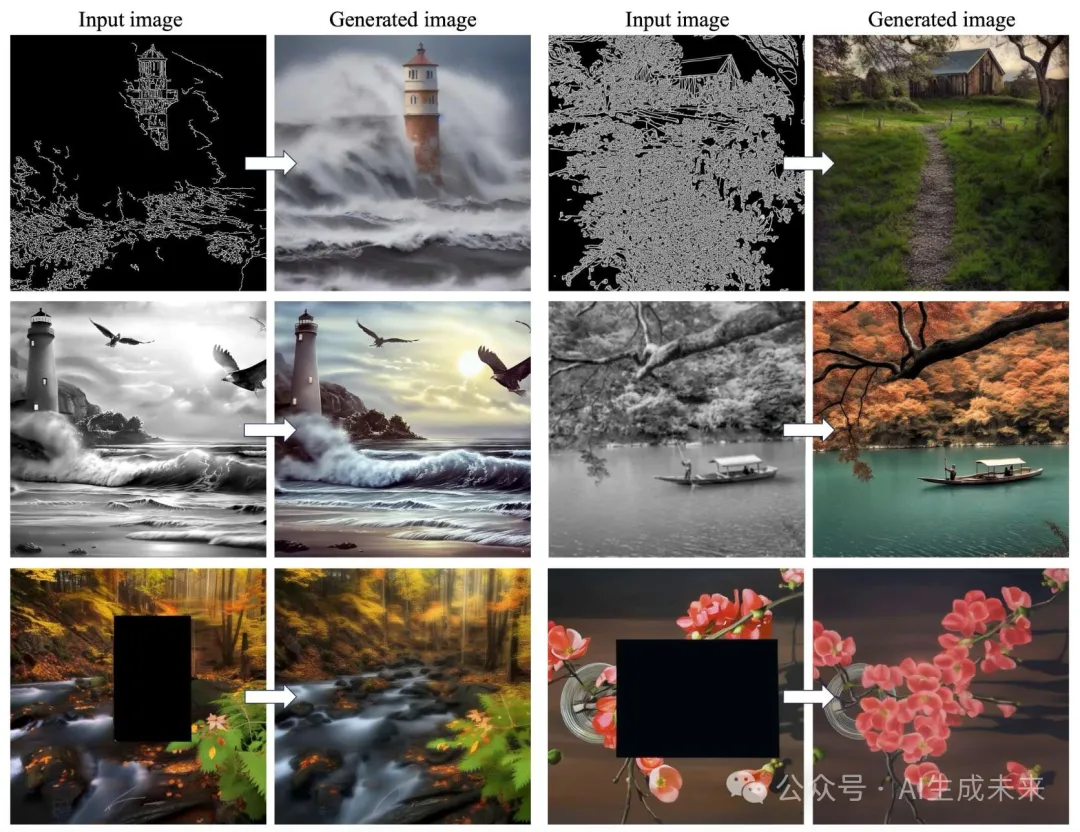

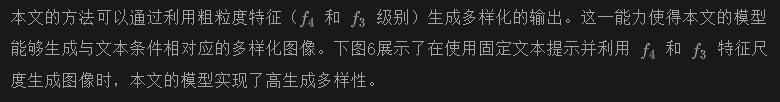

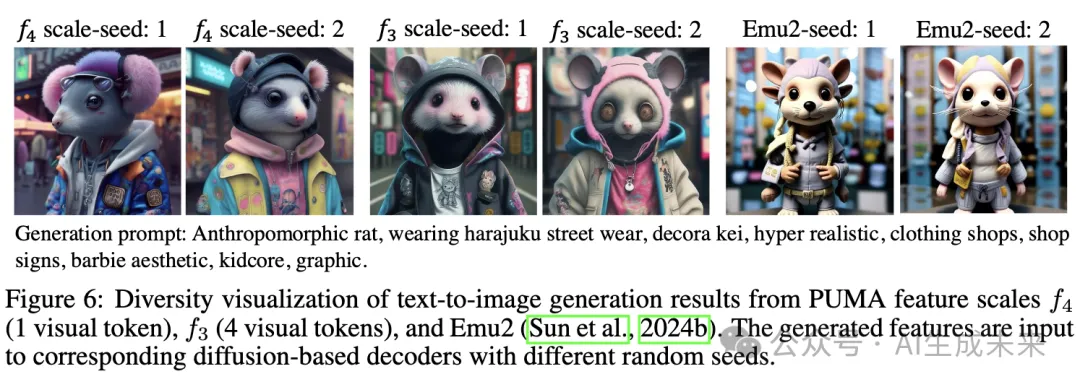

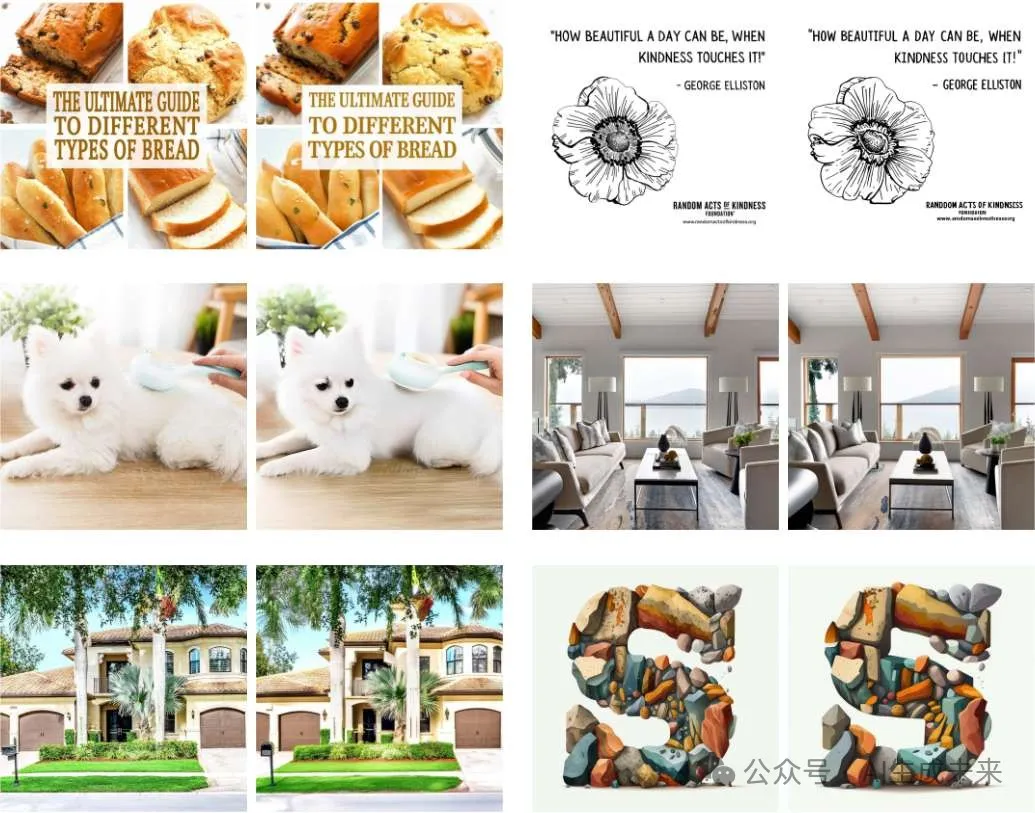

多樣化文本生成圖像

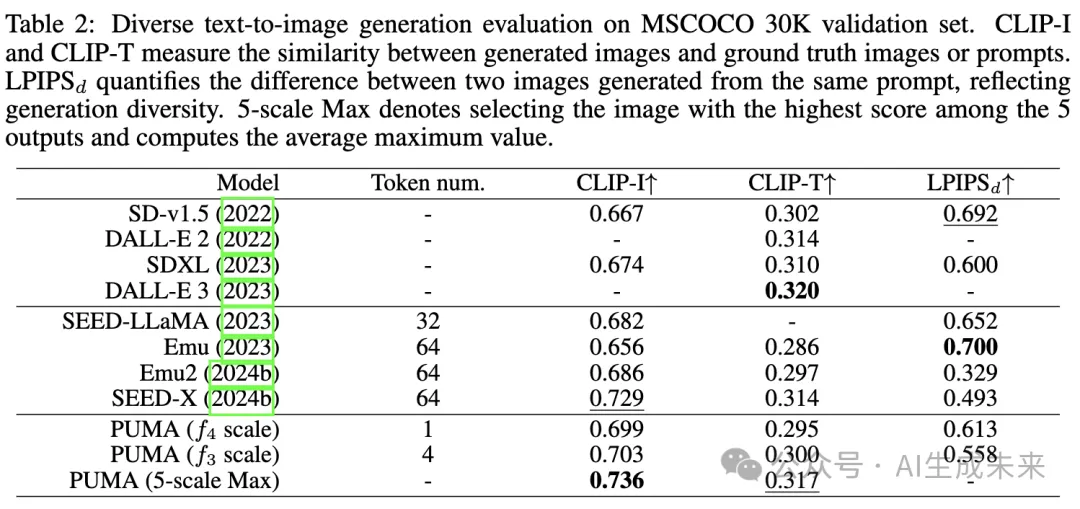

為定量評估,在 MSCOCO 30K 驗證數(shù)據(jù)集上評估了模型,并在下表2中展示了 CLIP-I、CLIP-T 和 LPIPSd 指標,前兩者衡量一致性,而 LPIPSd 衡量生成多樣性。與近期工作相比,本文的模型在生成質(zhì)量、多樣性和提示詞相關(guān)性上表現(xiàn)出了優(yōu)越的性能。

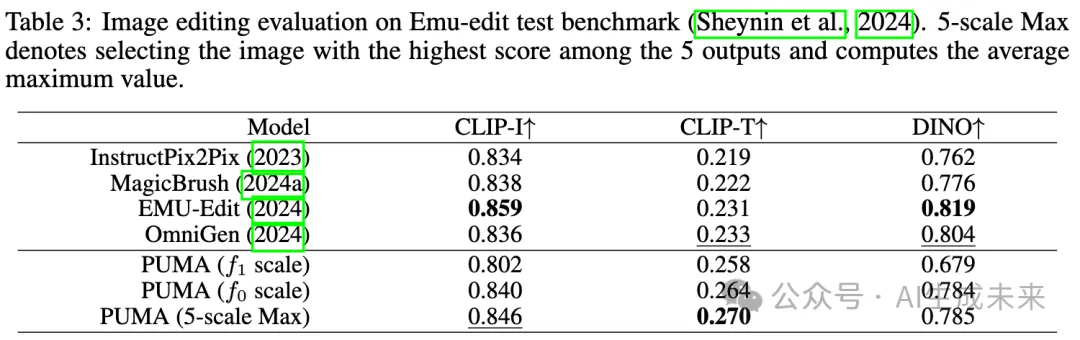

圖像編輯

為了評估PUMA的圖像編輯能力,在Emu-Edit測試基準上進行了評估。結(jié)果顯示在下表3中,包括CLIP-I、CLIP-T和DINO得分。CLIP-I和DINO得分衡量模型保留源圖像元素的能力,而CLIP-T反映輸出圖像與目標標題之間的一致性。

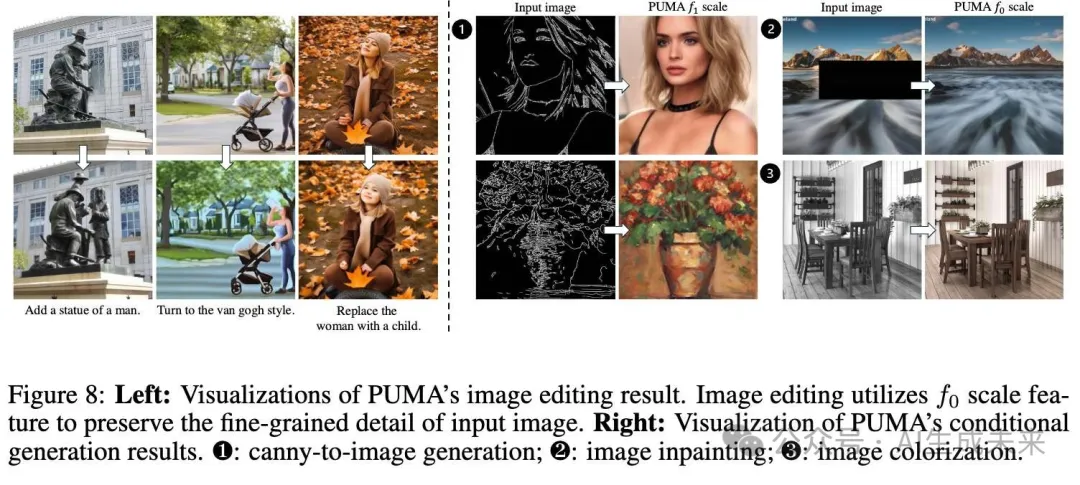

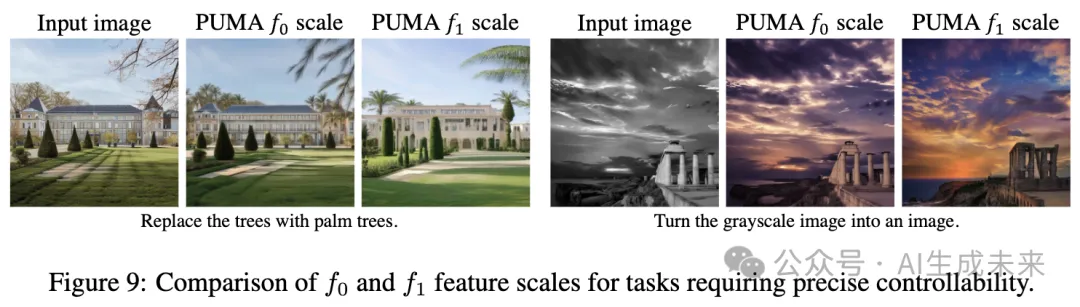

發(fā)現(xiàn)表明,PUMA展示了強大的保留能力,僅次于當前的最先進模型EMU-Edit。值得注意的是,PUMA在CLIP-T得分上顯著更高,甚至超越了最先進模型,這表明其在編輯圖像與目標標題之間的對齊能力更強。圖8中的可視化結(jié)果展示了PUMA在圖像操控任務(wù)中的有效性。

條件圖像生成

圖像理解

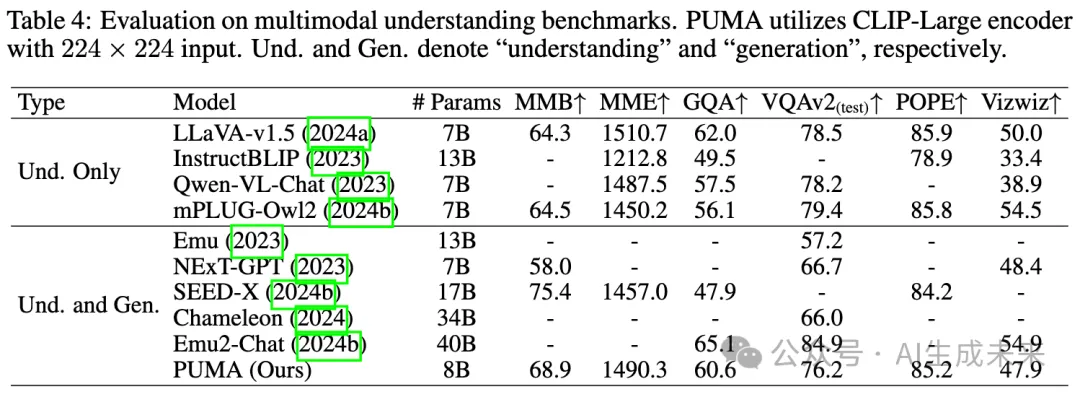

在多個MLLM基準(如MMB、MME、GQA、VQAv2、POPE和Vizwiz)上評估了PUMA的圖像理解性能。該評估的結(jié)果見下表4。盡管PUMA的參數(shù)數(shù)量相對較少(8B參數(shù)),且使用了224 × 224分辨率的圖像編碼器,但它在圖像理解性能上展現(xiàn)出競爭力,并且在許多情況下優(yōu)于其他統(tǒng)一理解和生成模型。

值得注意的是,在某些指標上,PUMA的表現(xiàn)甚至超過了一些僅進行理解的基線模型。這種性能可以歸因于PUMA使用多粒度連續(xù)視覺tokens作為輸入到MLLM。關(guān)于不同尺度特征輸入對圖像理解任務(wù)影響的詳細消融研究可在附錄中找到,為PUMA的多粒度策略的有效性提供了進一步的見解。

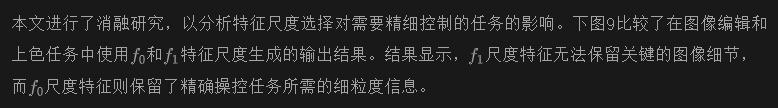

消融研究

結(jié)論

本文介紹了PUMA,一種新的統(tǒng)一多粒度MLLM,它整合了視覺生成和理解中的各種粒度任務(wù)。通過利用多粒度表示,PUMA有效地解決了圖像生成任務(wù)中平衡多樣性和可控性的挑戰(zhàn)。本文的方法在多種視覺任務(wù)中展示了優(yōu)越的性能,包括多樣化的文本到圖像生成、圖像編輯、修復(fù)、上色、條件生成和理解。PUMA在單一框架內(nèi)適應(yīng)不同粒度需求的能力標志著MLLM能力的重大進步。這項工作為更通用和強大的多模態(tài)人工智能系統(tǒng)開辟了新可能性,助力實現(xiàn)多模態(tài)領(lǐng)域的人工通用智能的更廣泛目標。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來