比Janus更強!15M數(shù)據(jù)實現(xiàn)顛覆性統(tǒng)一多模態(tài)大模型!華為諾亞提出ILLUME

文章鏈接:https://arxiv.org/pdf/2412.06673

亮點分析

- 本文提出了ILLUME,這是一種統(tǒng)一的多模態(tài)大語言模型(MLLM),能夠在單一的大語言模型(LLM)中無縫整合視覺理解與生成功能,并通過語義視覺分詞器和三階段訓(xùn)練流程實現(xiàn)高效訓(xùn)練。

- 為了促進理解與生成能力的協(xié)同增強,本文提出了一種新穎的自增強多模態(tài)對齊機制,該機制訓(xùn)練 MLLM 自行評估文本描述與自生成圖像之間的一致性。

- ILLUME 在現(xiàn)有的統(tǒng)一多模態(tài)大語言模型中表現(xiàn)出色,并在多模態(tài)理解、生成和編輯的多種基準(zhǔn)測試中展現(xiàn)出與專業(yè)模型相當(dāng)?shù)母偁幜Α?/li>

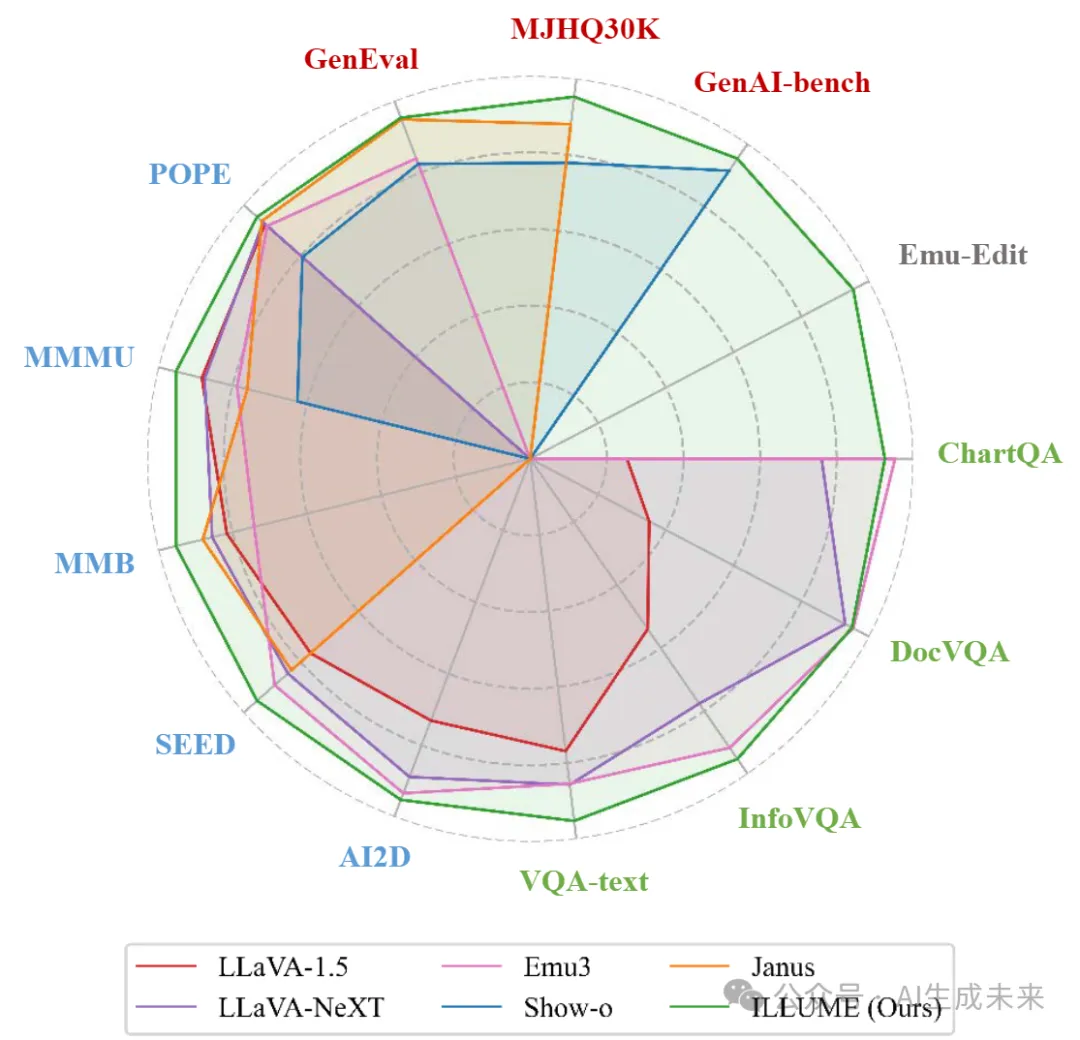

與SOTA的比較

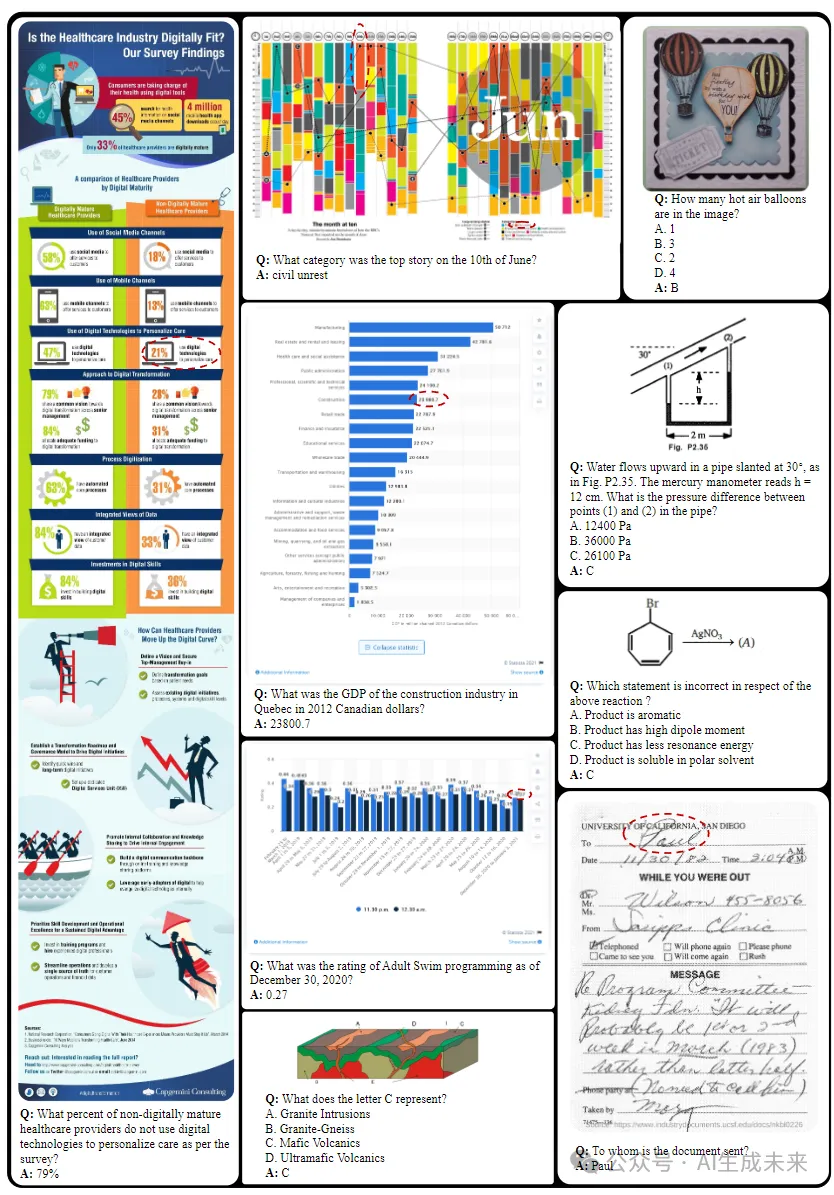

各種視覺理解(藍色表示通用,綠色表示面向文檔)、生成(紅色)和編輯(灰色)基準(zhǔn)的性能。ILLUME憑借最先進的工作取得了有競爭力的成果:

總結(jié)速覽

解決的問題

- 多模態(tài)統(tǒng)一建模挑戰(zhàn):如何在單一的大語言模型中無縫融合多模態(tài)理解和生成能力。

- 數(shù)據(jù)效率問題:減少圖文對齊所需的大規(guī)模數(shù)據(jù)集,降低訓(xùn)練成本。

- 多模態(tài)協(xié)同增強不足:現(xiàn)有模型在多模態(tài)理解和生成能力的協(xié)同提升方面探索有限。

提出的方案

- 統(tǒng)一的預(yù)測框架:通過統(tǒng)一的“下一個 token 預(yù)測”公式,實現(xiàn)多模態(tài)理解與生成的整合。

- 視覺分詞器設(shè)計:采用嵌入語義信息的視覺分詞器,提升圖文對齊效率。

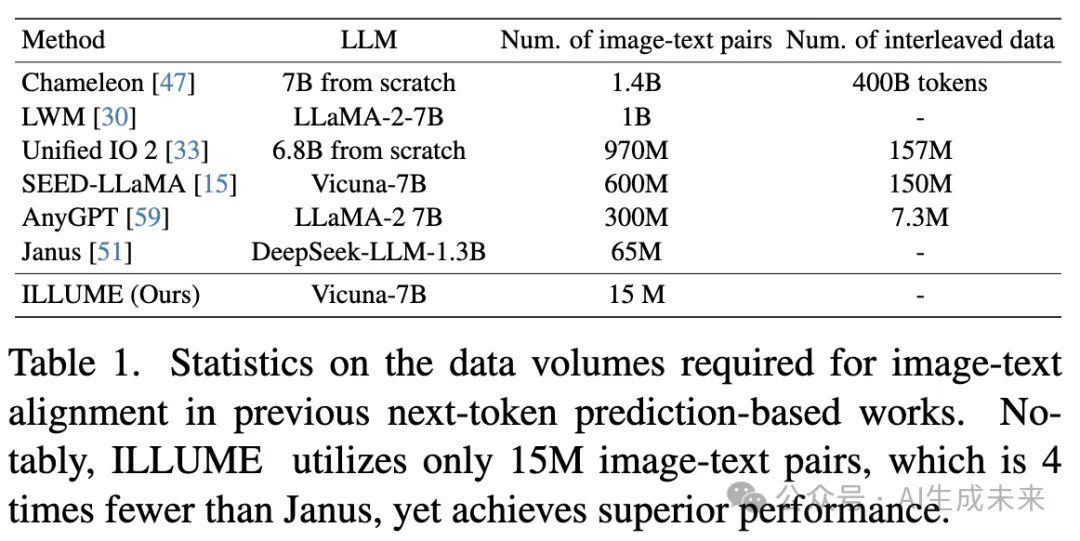

- 漸進式多階段訓(xùn)練:設(shè)計漸進式多階段訓(xùn)練流程,將預(yù)訓(xùn)練所需的數(shù)據(jù)量減少至 1500 萬,比傳統(tǒng)需求減少四倍以上。

- 自增強多模態(tài)對齊機制:提出一種新穎的機制,模型通過自評一致性來提升圖文對齊效果,避免圖像生成中的不真實與不準(zhǔn)確。

應(yīng)用的技術(shù)

- 視覺分詞器:結(jié)合語義信息,優(yōu)化圖像表征質(zhì)量。

- 漸進式多階段訓(xùn)練:通過分階段優(yōu)化提升數(shù)據(jù)利用率。

- 自增強對齊機制:讓模型通過自監(jiān)督評估生成圖像與文本描述的一致性,強化理解與生成的雙向能力。

達到的效果

- 數(shù)據(jù)效率提升:使用僅 1500 萬數(shù)據(jù)完成預(yù)訓(xùn)練,效率顯著高于同類模型。

- 性能優(yōu)勢:在多模態(tài)理解、生成和編輯的多項基準(zhǔn)測試中,與當(dāng)前最先進的統(tǒng)一多模態(tài)模型和專業(yè)化模型競爭,表現(xiàn)出色甚至更優(yōu)。

- 協(xié)同增強:通過對理解和生成能力的協(xié)同提升,實現(xiàn)多模態(tài)任務(wù)的全面優(yōu)化。

ILLUME

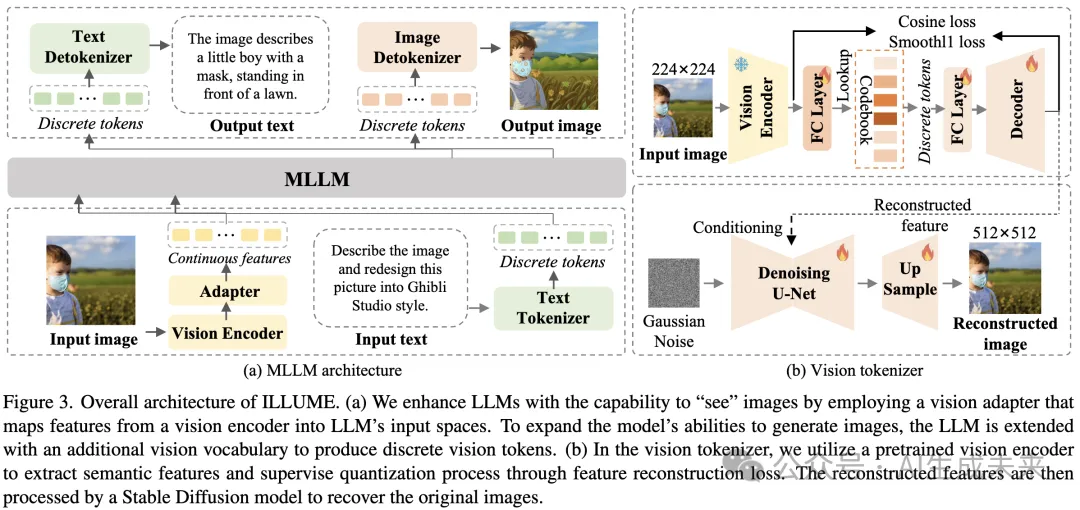

本節(jié)介紹 ILLUME 框架,這是一種用于視覺理解與生成的統(tǒng)一模型。具體而言,討論視覺分詞器、MLLM 以及訓(xùn)練流程的設(shè)計細節(jié)。

視覺分詞器

為了在 LLM 中處理輸入圖像,之前的視覺語言模型(VLM)如 LLaVA 利用視覺適配器將視覺編碼器的語義特征映射到文本空間,從而在僅使用 558K 數(shù)據(jù)樣本進行預(yù)訓(xùn)練時實現(xiàn)了高效的圖文對齊。然而,在圖像生成領(lǐng)域,大多數(shù)現(xiàn)有基于自回歸的統(tǒng)一模型面臨著 LLM 預(yù)訓(xùn)練所需的大規(guī)模數(shù)據(jù)問題(如下表 1 所示)。

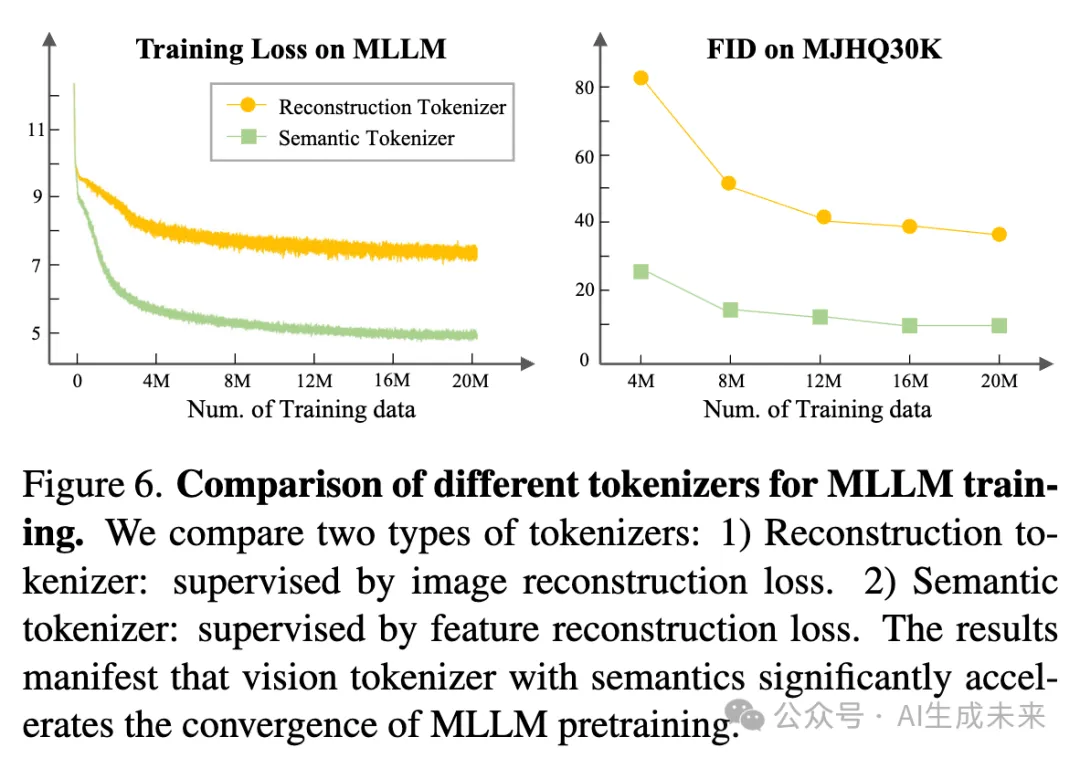

假設(shè)這一問題的根源在于現(xiàn)有視覺分詞器(如 VQGAN)提供的語義信息不足。這些分詞器主要基于圖像重建損失進行訓(xùn)練,其視覺表示專注于量化的低級紋理特征,從而阻礙了 MLLM 的圖文對齊。

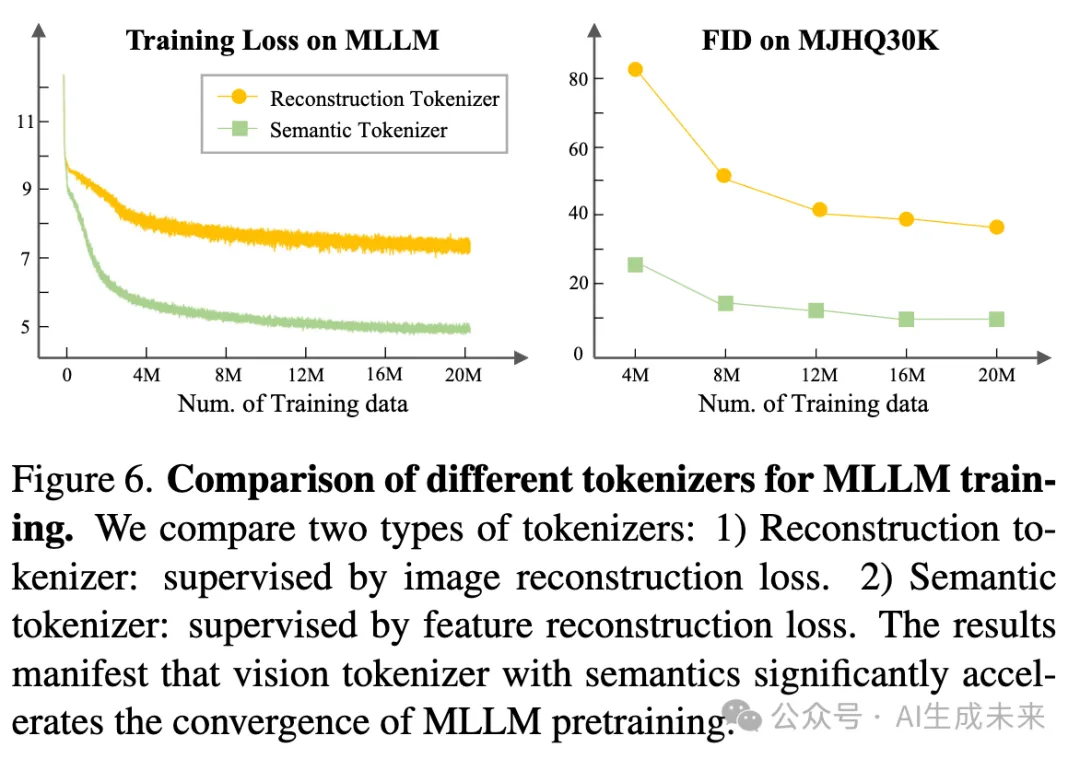

為此,將圖像量化為語義特征空間中的離散token。具體而言,如下圖 3(b) 所示,采用預(yù)訓(xùn)練的視覺編碼器 UNIT 提取語義特征,并通過特征重建損失監(jiān)督量化過程及碼本學(xué)習(xí)。相比基于圖像重建損失的分詞器,這種方法顯著加速了圖文對齊過程(如下圖 6 所示)。

此外,由于量化發(fā)生在語義特征空間中,進一步利用 Stable Diffusion (SD) 模型將這些語義特征重建回具有高壓縮比(32×)的圖像。魯棒的 SD 模型有效補償了量化過程中未保留的低級細節(jié),從而能夠從 MLLM 輸出的固定數(shù)量離散token生成更高分辨率的圖像。

MLLM

架構(gòu)如上圖 3 所示,ILLUME 繼承了現(xiàn)有視覺語言模型(VLM)的架構(gòu),通過擴展 LLM 并添加視覺詞匯表來生成離散視覺token。在視覺理解方面,我們利用 UNIT 編碼器(也用于我們提出的視覺分詞器)從輸入圖像中提取語義特征,并通過視覺適配器將這些特征對齊到 LLM 的輸入空間。該設(shè)計緩解了矢量量化導(dǎo)致的信息丟失,這對于處理細粒度多模態(tài)理解任務(wù)至關(guān)重要。

在視覺生成方面,使用視覺分詞器將圖像轉(zhuǎn)換為離散索引,并在 LLM 的共享預(yù)測頭中,對兩種模態(tài)的每個位置的token預(yù)測進行監(jiān)督。通過這種架構(gòu),ILLUME 采用通用的語言建模(LM)目標(biāo),以自回歸方式直接最大化每個多模態(tài)序列的似然。

其中, 表示文本或視覺token, 表示 LLM 的參數(shù)。值得注意的是,由于我們的模型能夠同時處理輸入和輸出中的圖像,所提出的框架兼容交錯的圖文數(shù)據(jù),從而支持任意多模態(tài)任務(wù)。

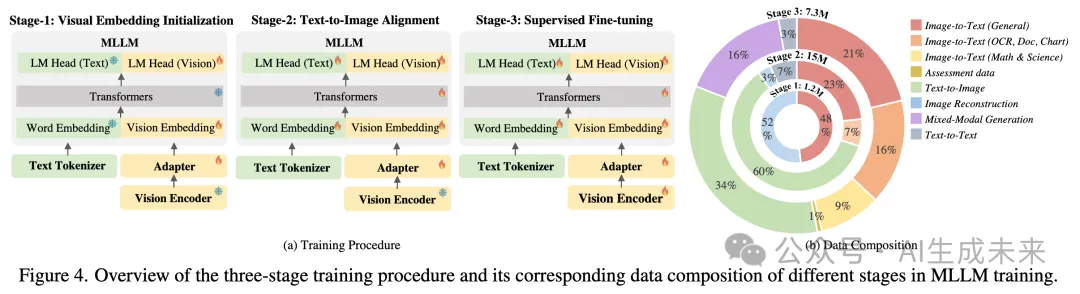

訓(xùn)練過程MLLM 的訓(xùn)練過程和數(shù)據(jù)組成如下圖 4 所示。訓(xùn)練過程分為以下三個階段:

- 階段 1:視覺嵌入初始化該階段的主要目標(biāo)是為后續(xù)訓(xùn)練步驟初始化良好的視覺表示。視覺適配器通過利用 LLaVA-Pretrain 的圖文對進行訓(xùn)練,將視覺編碼器的視覺特征轉(zhuǎn)換為 LLM 的文本空間。同時,該階段還涉及新可學(xué)習(xí)嵌入的學(xué)習(xí),僅更新視覺嵌入和 LLM 最終分類頭中的視覺部分。此外,我們引入了圖像重建任務(wù),即監(jiān)督 LLM 生成原始圖像,以便快速初始化 LLM 中的新增集成權(quán)重。

- 階段 2:統(tǒng)一圖文對齊本階段重點在多模態(tài)數(shù)據(jù)上進行圖文對齊,以學(xué)習(xí)理解和生成任務(wù)。解凍 LLM 和視覺適配器,利用 1500 萬訓(xùn)練數(shù)據(jù)進行訓(xùn)練,包括文本數(shù)據(jù)、自然圖像和文檔的圖像標(biāo)題數(shù)據(jù)、用于重建的圖像數(shù)據(jù)以及文本到圖像生成數(shù)據(jù)。

- 階段 3:監(jiān)督微調(diào)在預(yù)訓(xùn)練之后,使用特定任務(wù)數(shù)據(jù)對整個模型進行訓(xùn)練,以處理各種多模態(tài)理解和生成任務(wù)。為了獲得高分辨率圖像以應(yīng)對如 OCR 和面向文檔任務(wù)等細粒度的多模態(tài)理解,采用 LLaVA-NeXT的圖像切片策略。本階段利用 中的指令調(diào)優(yōu)數(shù)據(jù)進行視覺理解、高質(zhì)量圖文對進行文本到圖像生成,以及各種混合模態(tài)生成數(shù)據(jù)。

推理在推理過程中,我們的模型采用下一個token預(yù)測的方法。對于視覺理解,遵循標(biāo)準(zhǔn)方法,從預(yù)測分布中逐步采樣token。對于圖像生成,采用無分類器引導(dǎo)(CFG),與先前工作[26, 54]一致。

自增強多模態(tài)對齊

開發(fā)統(tǒng)一的多模態(tài)大語言模型(MLLM)的主要目標(biāo)有兩個:

- 能夠輕松擴展到各種視覺-語言任務(wù);

- 表示空間的完全統(tǒng)一能通過更高效的多模態(tài)交互和對齊促進學(xué)習(xí)過程的效率提升。

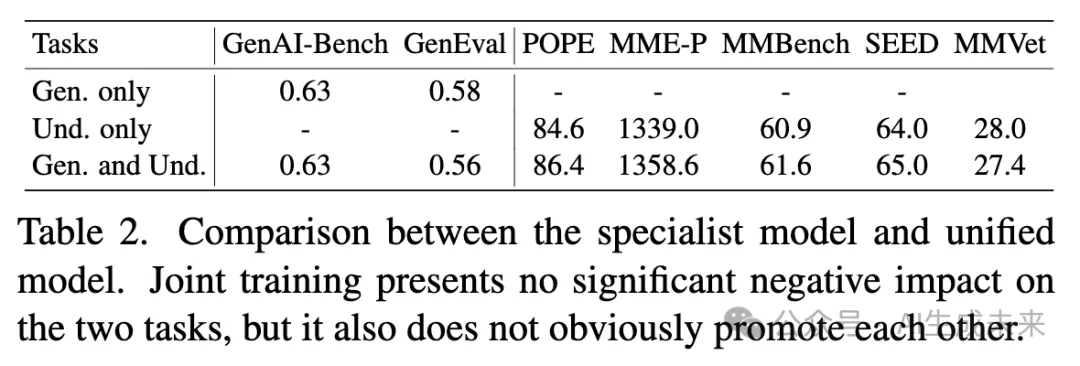

因此,在構(gòu)建 ILLUME 后,我們的首要任務(wù)是研究聯(lián)合改進這些能力是否能從每項任務(wù)所需知識的共性中獲益。然而,根據(jù)實驗結(jié)果(如下表 2 所示),盡管聯(lián)合訓(xùn)練未對性能產(chǎn)生顯著負(fù)面影響,但現(xiàn)有基準(zhǔn)測試并未表現(xiàn)出預(yù)期的理解與生成能力的互相增強。這表明,這些能力雖然可以共存而不互相影響,但要實現(xiàn)協(xié)同潛力可能需要進一步探索和更精細的方法。

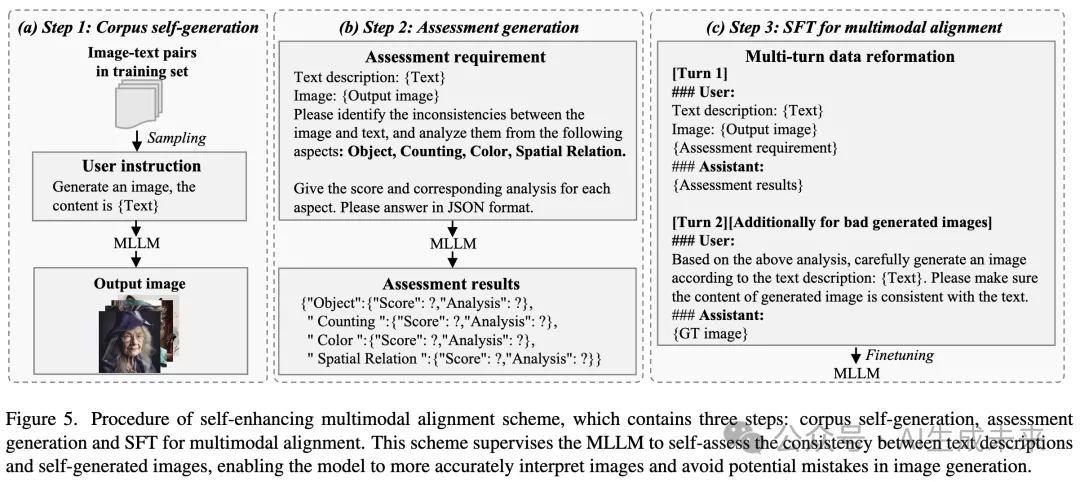

為此,本文提出了一種新穎的自增強多模態(tài)對齊方案,如下圖 5 所示,該方案通過自評估過程作為橋梁協(xié)同增強判別和生成能力。如果 MLLM 能在訓(xùn)練中學(xué)習(xí)評估其自生成圖像的質(zhì)量,它將從以下兩個方面獲益:

- 生成促進判別:通過分析自生成的負(fù)樣本,MLLM 學(xué)會識別并理解自身的失敗,從而提高對圖像的準(zhǔn)確解讀能力。此反思過程使模型能夠通過自我評估定位并改進其弱點,最終提升理解能力并減少誤判。

- 判別促進生成:MLLM 可以利用其判別能力評估自生成圖像是否與文本對齊,并基于此分析進行必要的調(diào)整。這種能力確保模型在推理過程中更加謹(jǐn)慎和精確,避免生成圖像中的潛在錯誤。

受到上述動機的啟發(fā),設(shè)計了以下三步的自增強多模態(tài)對齊方案:

- 步驟 1:語料自生成模型從訓(xùn)練集中一部分文本到圖像數(shù)據(jù)自生成圖像。

- 步驟 2:生成評估根據(jù)特定標(biāo)準(zhǔn)(如對象準(zhǔn)確性、數(shù)量、顏色、空間關(guān)系)評估圖像和文本之間的不一致性。在生成過程中,不僅包括評估分?jǐn)?shù)(如好或壞),還包括對應(yīng)的分析。為了獲得高質(zhì)量數(shù)據(jù),我們采用 GPT4-o 生成評估數(shù)據(jù),評估模板如上圖 5(b) 所示。

- 步驟 3:用于多模態(tài)對齊的監(jiān)督微調(diào)(SFT)將評估數(shù)據(jù)重新格式化,如圖 5(c) 所示。具體來說,對于被token為“良好生成案例”的實例,僅進行第一輪評估。而對于“錯誤生成案例”,數(shù)據(jù)將被重新構(gòu)建為兩輪對話,其中第一輪進行評估,第二輪進行改進。通過此方案,共生成 50K 條評估數(shù)據(jù),并將其納入訓(xùn)練過程的階段 3。

實驗

在多種多模態(tài)理解與生成基準(zhǔn)上評估了所提出的 ILLUME,并進行了消融實驗以驗證設(shè)計選擇的合理性。

實現(xiàn)細節(jié)

在實驗中,選擇Vicuna-7B 作為基礎(chǔ)語言模型。理解任務(wù)中使用的視覺編碼器為UNIT。以下是模型的具體設(shè)置:

- 輸入圖像分辨率:

- 階段 1 和階段 2 設(shè)置為224。

- 每張圖像為 LLM 生成256 個離散 tokens。

- 階段 3 采用image patchfy策略,以支持高分辨率圖像輸入,用于細粒度理解任務(wù)。最大切片數(shù)為9,基礎(chǔ)分辨率為448,每個切片的圖像下采樣為256 個 token。

- 圖像生成:

- 視覺分詞器的codebook大小為16384。

- 生成圖像的分辨率為512 × 512,對應(yīng)256 個離散 tokens。

- 訓(xùn)練配置:

- 訓(xùn)練超參數(shù)如下表 5 所示。

- 整個訓(xùn)練過程耗時3 天,在包含32 個節(jié)點的集群上進行,每個節(jié)點配備8 個 Ascend NPU。

評估設(shè)置

多模態(tài)理解

為了評估多模態(tài)理解能力,在兩類廣泛使用的基準(zhǔn)上進行測試:

- 通用基準(zhǔn):包括 POPE、MMBench、SEED、MME-P、MM-Vet、MMMU 和 AI2D。

- 文檔相關(guān)基準(zhǔn):包括 VQA-text、ChartQA、DocVQA、InfoVQA 和 OCRBench。

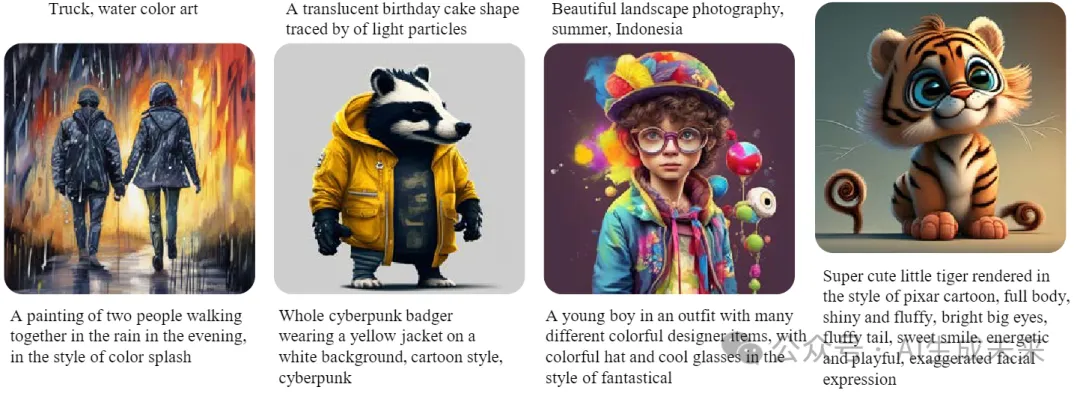

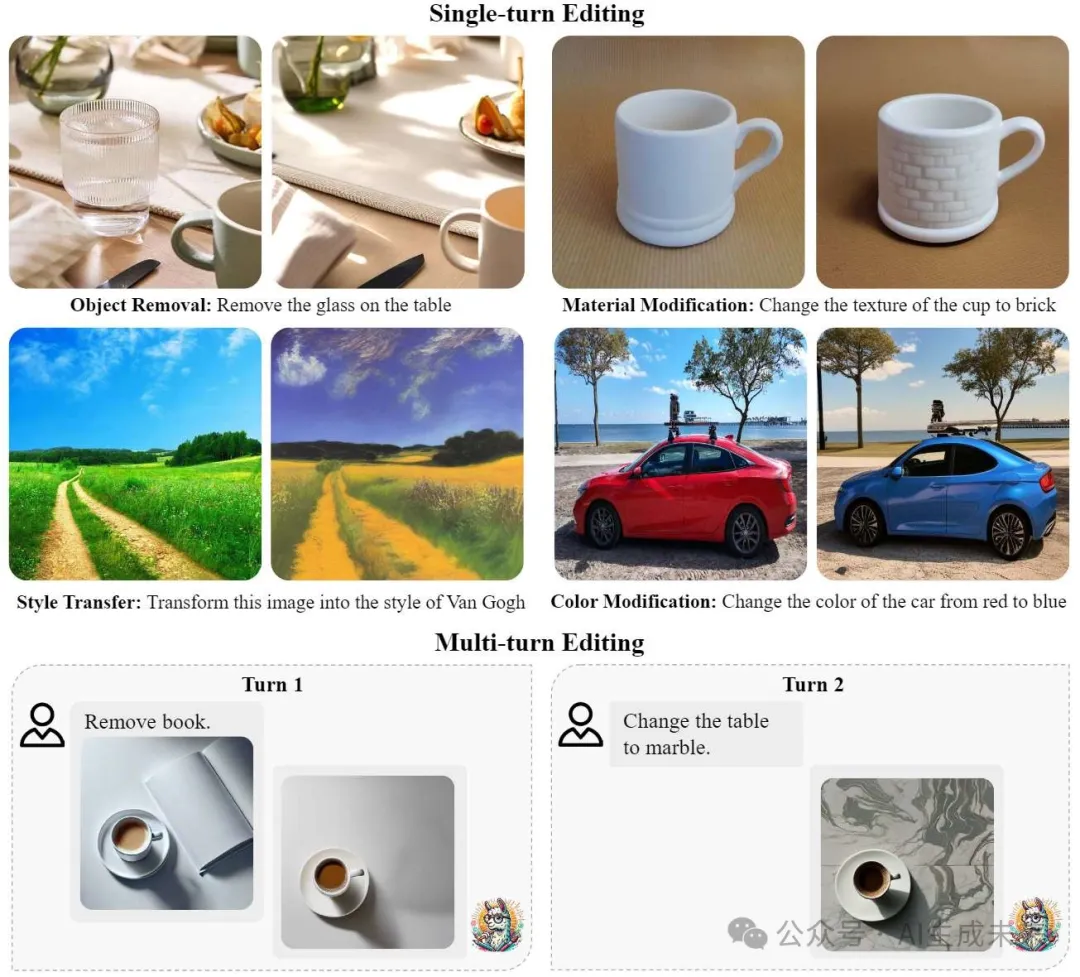

多模態(tài)圖像生成

為評估 ILLUME 的多模態(tài)視覺生成能力,采用了以下基準(zhǔn):

- MJHQ-30K:基于 Fréchet Inception Distance (FID) 指標(biāo),在 30K 生成圖像和 30K 高質(zhì)量真實圖像之間進行比較,衡量生成質(zhì)量與多樣性。

- GenAI-bench 和 GenEval:具有挑戰(zhàn)性的文本到圖像生成基準(zhǔn),用于反映綜合生成能力。

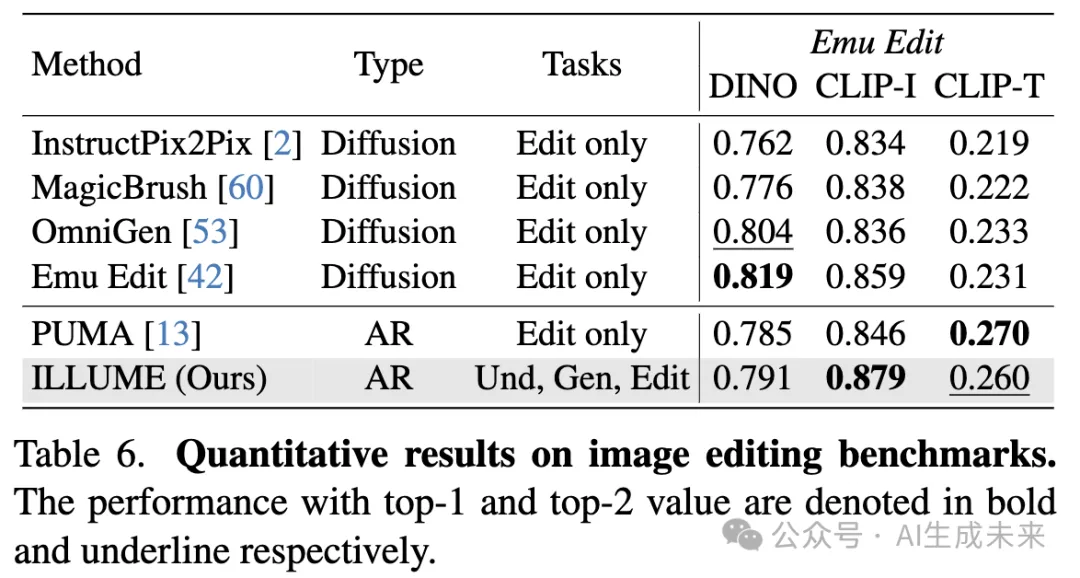

多模態(tài)圖像編輯

為了評估 ILLUME 的多模態(tài)圖像編輯能力,使用了 Emu Edit基準(zhǔn),并報告以下指標(biāo):

- CLIP-I 和 DINO 分?jǐn)?shù):衡量模型保留源圖像元素的能力。

- CLIP-T 分?jǐn)?shù):衡量輸出圖像與目標(biāo)文本描述之間的一致性。

與最新技術(shù)的對比

多模態(tài)理解

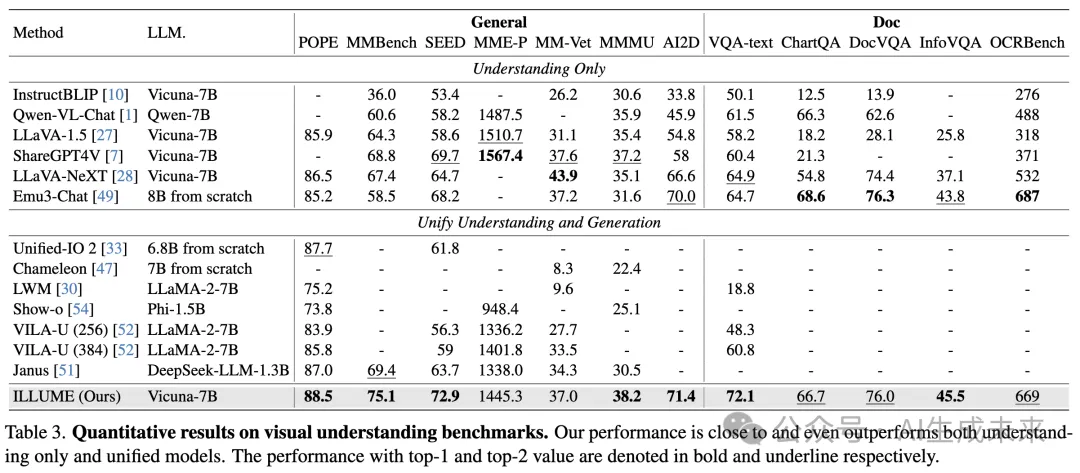

我們在多種多模態(tài)理解基準(zhǔn)上的性能與以往最先進的理解模型(如 InstructBLIP、Qwen-VL-Chat、LLaVA-1.5、ShareGPT4V、LLaVA-NeXT 和 Emu3-Chat)以及統(tǒng)一模型(如 Unified-IO 2、Chameleon、LWM、Show-o、VILA-U 和 Janus)進行比較(下表 3)。

- ILLUME 在 12 個基準(zhǔn)中的 10 個上獲得了第一或第二名。

- 在 MMMU 和 SEED 基準(zhǔn)上,ILLUME 分別比上一代最佳統(tǒng)一多模態(tài)模型 Janus 提高了 **25% 和 14%**。

- 相較于 Emu3,ILLUME 在文檔相關(guān)基準(zhǔn)上表現(xiàn)相當(dāng),但在幾乎所有通用基準(zhǔn)上表現(xiàn)更佳,表明其在多模態(tài)理解任務(wù)上的顯著優(yōu)勢。

多模態(tài)圖像生成

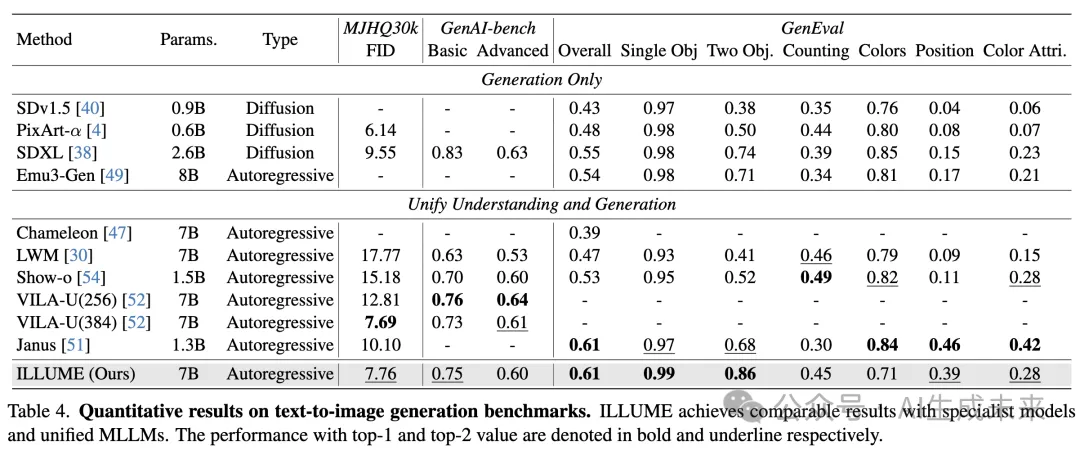

在 MJHQ-30K、GenAI-bench 和 GenEval 基準(zhǔn)上評估了 ILLUME 的生成能力(下表 4)。

- 在MJHQ30K 基準(zhǔn)上,ILLUME 的 FID 分?jǐn)?shù)為7.76,優(yōu)于 Show-o 和 Janus 等高性能統(tǒng)一模型,表明其生成質(zhì)量和多樣性更強。

- 在GenAI-bench 基準(zhǔn)上,ILLUME 的性能與基線方法相當(dāng)。

- 在GenEval 基準(zhǔn)上,ILLUME 的整體準(zhǔn)確率達到0.61,超越了之前的生成專用和統(tǒng)一模型,表現(xiàn)出卓越的綜合生成能力。

多模態(tài)圖像編輯

在 Emu Edit 基準(zhǔn)上,將 ILLUME 與以下圖像編輯模型對比:InstructPix2Pix、MagicBrush、Omni-Gen、Emu Edit 和 PUMA(下表 6)。

- 盡管 ILLUME 是一個統(tǒng)一模型,但其在圖像編輯任務(wù)中的表現(xiàn)與專用編輯模型相當(dāng),表明該框架的有效性。

消融研究

視覺分詞器的設(shè)計選擇

為了研究語義信息是否在設(shè)計有效的視覺分詞器中起著關(guān)鍵作用,在兩種不同的監(jiān)督下進行了視覺分詞器的比較分析:

- 重建分詞器:使用了 VQGAN 實現(xiàn),并通過圖像重建損失進行監(jiān)督。

- 語義分詞器:量化過程通過重建由 UNIT 提取的語義特征來進行監(jiān)督。

在相同的設(shè)置下,使用這兩種token器訓(xùn)練了 MLLM 模型,數(shù)據(jù)集為 2000 萬條文本到圖像的生成數(shù)據(jù)。正如下圖 6(左)所示,訓(xùn)練損失曲線表明,具有語義信息的視覺分詞器顯著加速了 MLLM 訓(xùn)練的收斂。為了進行圖像重建和細節(jié)補償,在我們的視覺分詞器中采用了擴散模型。為了確保公平比較,我們將 VQGAN 中的原始解碼器替換為擴散模型,以在 512 × 512 分辨率下重建圖像。圖 6(右)表明,在僅使用 2000 萬生成數(shù)據(jù)的情況下,重建token器的性能不盡人意,而語義token器則取得了可喜的成績。我們的研究結(jié)果證實,語義信息確實是適合 MLLMs 的視覺分詞器的關(guān)鍵因素。

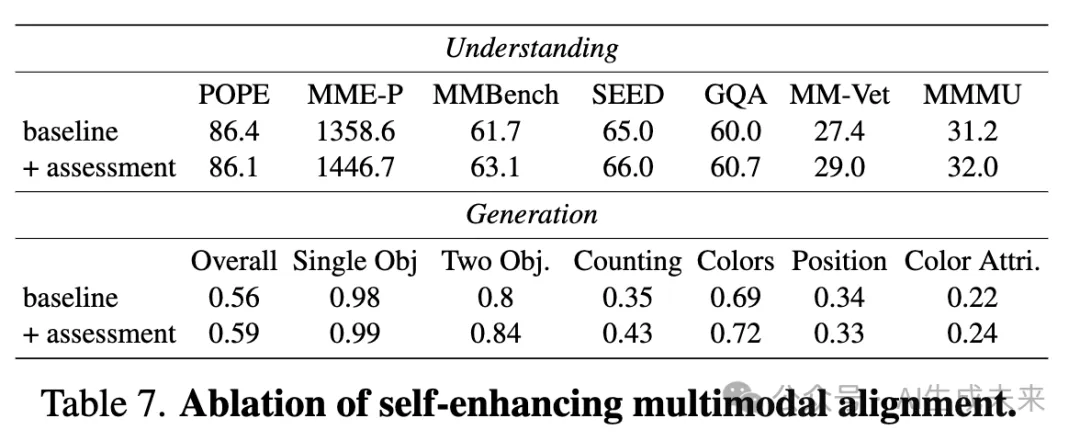

自增強多模態(tài)對齊方案的有效性

研究者們進行了一項消融分析,以驗證本文方法的有效性。基準(zhǔn)方法在 Stage-3 訓(xùn)練中采樣了 130 萬個數(shù)據(jù)點,以提高效率,而我們的方法還整合了由我們方案生成的評估數(shù)據(jù)。如下表 7 所示,盡管僅增加了 5 萬個數(shù)據(jù)點,在理解和生成基準(zhǔn)測試中的性能都得到了提升。這一提升表明,教會 MLLM 自我評估不僅能使模型更準(zhǔn)確地理解圖像,還能幫助防止圖像生成中的潛在錯誤。希望這一發(fā)現(xiàn)能激發(fā)更多關(guān)于判別能力和生成能力之間協(xié)同作用與泛化潛力的深入探索。

結(jié)論

ILLUME,一個統(tǒng)一的 MLLM(多模態(tài)大語言模型),該模型經(jīng)過高效預(yù)訓(xùn)練,并通過一種新穎的自增強多模態(tài)對齊方案進一步改進,表現(xiàn)出與現(xiàn)有統(tǒng)一 MLLM 在多個多模態(tài)基準(zhǔn)上的競爭性,甚至更優(yōu)的性能。展望未來,計劃在幾個關(guān)鍵領(lǐng)域進一步發(fā)展 ILLUME:

- 擴展能力:旨在擴展其能力,支持更多模態(tài),如視頻、音頻和 3D 數(shù)據(jù),以便在各個領(lǐng)域中實現(xiàn)更廣泛的應(yīng)用。

- 設(shè)計更通用的視覺分詞器:計劃設(shè)計一種更加多功能的視覺分詞器,能夠支持圖像和視頻。此外,在本研究中的發(fā)現(xiàn)表明,將語義信息融入傳統(tǒng)設(shè)計良好的視覺分詞器具有巨大的潛力,使其更適合 MLLM。

- 進一步探索自增強策略:計劃通過引入更多認(rèn)可的標(biāo)準(zhǔn)(如美學(xué)質(zhì)量)進一步探索我們的自增強策略,從而更好地利用數(shù)據(jù),并生成更符合人類偏好的內(nèi)容。

這些未來的方向?qū)@著拓寬 ILLUME 的應(yīng)用范圍和效果,為實現(xiàn)統(tǒng)一的、高效的“任何任務(wù)、任何模態(tài)” MLLM 奠定基礎(chǔ)。

本文轉(zhuǎn)自AI生成未來 ,作者:AI生成未來