多模態與生成正邁向終極大一統!阿里最新3萬字長文梳理統一的多模態理解和生成模型 精華

文章鏈接:https://arxiv.org/pdf/2505.02567

開源鏈接:https://github.com/AIDC-AI/Awesome-Unified-Multimodal-Models

亮點直擊

- 闡述多模態理解與文生圖模型的基礎概念與最新進展;

- 繼而梳理現有統一模型,將其歸納為三大架構范式:基于擴散的架構、基于自回歸的架構,以及融合自回歸與擴散機制的混合架構;

- 整理了適配統一模型的數據集與評測基準,為后續研究提供資源支持;

- 探討了這一新興領域面臨的核心挑戰,包括分詞策略、跨模態注意力機制與數據問題。

近年來,多模態理解模型與圖像生成模型均取得了顯著進展。盡管二者各自取得了成功,這兩個領域卻沿著獨立的路徑發展,形成了截然不同的架構范式:自回歸架構主導了多模態理解領域,而擴散模型則成為圖像生成的基石。近期,構建統一框架以整合這兩類任務的研究興趣日益增長。GPT-4o展現的新能力正是這一趨勢的例證,凸顯了統一化發展的潛力。然而,兩種架構間的顯著差異帶來了重大挑戰。為清晰梳理當前研究進展,本文系統性地綜述了該領域成果,旨在為未來研究提供指引。

引子

近年來,大語言模型(LLM)的快速發展——如LLaMa、PanGu、Qwen和GPT——徹底改變了人工智能領域。這些模型在規模與能力上的持續擴展,推動了跨領域應用的突破性進展。與此同時,LLM已延伸至多模態領域,催生出LLaVa、Qwen-VL、InternVL、Ovis和GPT4等強大的多模態理解模型。這些模型不僅實現了基礎圖像描述功能,更能基于用戶指令執行復雜推理任務。另一方面,圖像生成技術也取得顯著進步,SD系列和FLUX等模型已能生成高度符合用戶需求的高質量圖像。

當前LLM與多模態理解模型主要采用自回歸生成架構,其基于解碼器唯一結構和下一詞元預測機制實現序列化文本生成。而文生圖領域則沿不同路徑發展:早期以生成對抗網絡(GAN)為主導,后轉向基于擴散的模型。這類模型結合UNet、DiT等架構與CLIP、T5等先進文本編碼器。盡管已有研究嘗試采用LLM架構進行圖像生成,擴散模型目前仍是性能最優的解決方案。

雖然自回歸模型在圖像生成質量上遜于擴散方法,但其與LLM的結構一致性對構建統一多模態系統極具吸引力。能同時理解與生成多模態內容的統一模型潛力巨大:既可基于復雜指令生成圖像,又能推理視覺數據并通過生成輸出實現多模態分析可視化。2025年3月GPT-4o增強能力的發布進一步凸顯這一潛力,引發了學界對統一化的廣泛關注。

然而,設計此類統一框架面臨重大挑戰:需要整合自回歸模型在推理與文本生成上的優勢,以及擴散模型在高保真圖像合成上的魯棒性。若干關鍵問題尚待解決,例如如何為自回歸生成實現有效的圖像分詞。現有方案中,部分研究采用擴散模型中常用的VAE或VQ-GAN及其變體,另一些則使用EVA-CLIP和OpenAI-CLIP等語義編碼器。此外,雖然離散詞元是自回歸模型中文本處理的標配,新近研究表明連續表征可能更適合圖像詞元。除分詞策略外,混合架構通過將并行擴散策略與序列化自回歸生成相結合,為純自回歸架構提供了有前景的替代方案。由此可見,統一多模態模型的圖像分詞技術與架構設計仍處于早期探索階段。

為全面梳理當前統一多模態模型的研究現狀(如下圖1所示),助力未來研究發展,本文展開系統性綜述。本文首先介紹多模態理解與圖像生成的基礎概念及最新進展,涵蓋自回歸與擴散兩類范式;繼而回顧現有統一模型,將其歸類為三大架構范式:基于擴散的架構、基于自回歸的架構,以及融合自回歸與擴散機制的混合架構。針對自回歸與混合類別,本文進一步根據圖像分詞策略進行細分,以反映該領域方法的多樣性。

除架構外,本文還整理了適配統一多模態模型訓練與評估的數據集和基準測試,覆蓋多模態理解、文生圖、圖像編輯等相關任務,為后續研究提供資源支持。最后,本文探討該新興領域面臨的核心挑戰,包括高效分詞策略、數據構建、模型評估等。解決這些挑戰對提升統一多模態模型的能力與可擴展性至關重要。

學界已有關于大語言模型、多模態理解和圖像生成的優秀綜述,而本文聚焦于理解與生成任務的整合研究。建議讀者結合這些互補性綜述以獲取更全面的領域認知。本文期望激發這一快速發展領域的更多研究,并為學界提供有價值的參考。本文涉及的參考文獻、數據集和基準測試等材料將很快發布于GitHub,并將持續更新以反映最新進展。

初步

多模態理解模型

多模態理解模型是指基于LLM的架構,能夠接收、推理并從多模態輸入生成輸出。這些模型將LLM的生成與推理能力擴展到文本數據之外,實現了對多種信息模態的豐富語義理解。現有方法的大多數研究集中于視覺-語言理解(VLU),該任務整合了視覺(如圖像和視頻)與文本輸入,以支持對空間關系、對象、場景及抽象概念的更全面理解。圖2展示了一個典型的多模態理解模型架構。這些模型在一個混合輸入空間中運行,其中文本數據以離散形式表示,而視覺信號則被編碼為連續表示。與傳統LLM類似,其輸出以離散token的形式從內部表示生成,使用基于分類的語言建模和任務特定的解碼策略。

早期的VLU模型主要通過雙編碼器架構對視覺與文本模態進行對齊,在該架構中,圖像與文本首先被分別編碼,然后通過對齊的潛在表示進行聯合推理,這些模型包括CLIP、ViLBERT、VisualBERT 和 UNITER。盡管這些開創性的模型確立了多模態推理的關鍵原則,但它們嚴重依賴基于區域的視覺預處理及獨立的編碼器,限制了模型的可擴展性與通用性。隨著強大LLM的出現,VLU模型逐步轉向采用僅解碼器架構,這類架構通常結合凍結或最小微調的LLM主干。這些方法主要通過結構各異的連接器將圖像嵌入轉換,如下圖2所示。具體而言,MiniGPT-4 使用單個可學習層將CLIP提取的圖像嵌入投影到Vicuna的token空間中。BLIP-2 引入了一個查詢Transformer,用于連接凍結的視覺編碼器與凍結的LLM(如Flan-T5 或 Vicuna),以更少的可訓練參數實現高效的視覺-語言對齊。Flamingo采用門控交叉注意力層將預訓練的視覺編碼器與凍結的Chinchilla解碼器連接起來。

VLU的最新進展顯示出向通用多模態理解轉變的趨勢。GPT-4V 將GPT-4框架擴展為支持用戶提供的圖像輸入,盡管其為專有系統,但在視覺推理、圖像描述與多模態對話方面展現出強大能力。Gemini構建于僅解碼器架構之上,支持圖像、視頻與音頻模態,其Ultra版本在多模態推理任務中設立了新基準。Qwen系列體現了可擴展的多模態設計:Qwen-VL引入視覺接收器與定位模塊,而Qwen2-VL 增加了動態分辨率處理與M-RoPE,以實現對多樣輸入的魯棒處理。LLaVA-1.5 與 LLaVA-Next使用基于CLIP的視覺編碼器與Vicuna風格LLM,在VQA與指令跟隨任務中取得了有競爭力的性能。InternVL系列探索了一種統一的多模態預訓練策略,同時從文本與視覺數據中學習,以提升在各種視覺-語言任務中的表現。Ovis引入了一種結構性嵌入對齊機制,通過一個可學習的視覺嵌入查找表生成與文本token結構一致的視覺嵌入。近期,一些模型開始探索面向多模態處理的可擴展與統一架構。DeepSeek-VL2采用專家混合(Mixture-of-Experts, MoE)架構以增強跨模態推理。總體而言,這些模型清晰展現了向指令調優與token中心的框架發展的趨勢,使其能夠以統一且可擴展的方式應對多樣的多模態任務。

文本生成圖像模型

早期的擴散模型使用 U-Net 架構來逼近 score function。U-Net 基于 Wide ResNet 構建,集成了殘差連接和自注意力模塊,以維持梯度傳播并恢復圖像的細節。這些方法大致可分為像素級方法和潛特征級方法:

- 像素級方法:直接在像素空間執行擴散過程。例如,GLIDE 引入了“無分類器引導”(classifier-free guidance),Imagen 使用預訓練的大語言模型 T5-XXL 作為文本編碼器。但這些方法計算開銷大,訓練與推理成本高。

- 隱空間擴散模型(LDMs):在預訓練的變分自編碼器的隱空間中操作擴散過程,如[14] 所提出。LDMs 在保持高質量生成效果的同時顯著提升了計算效率,啟發了多種擴散生成模型的發展,包括 VQ-Diffusion、SD 2.0、SD XL 和 UPainting。

隨著 Transformer 架構的發展,出現了基于 Transformer 的擴散模型。例如:

- Diffusion Transformers (DiT):將輸入圖像分割為 patch 序列,并通過一系列 Transformer 塊進行處理。DiT 以擴散時間步t和條件信號c作為附加輸入。

DiT 的成功催生了更多先進的生成方法:

- REPA:在擴散訓練中注入自監督視覺特征以提升大規模性能;

- SD 3.0:使用兩組獨立權重分別建模文本與圖像模態;

- 其他方法。

文本編碼器方面,這些方法主要采用對比學習,將圖文模態對齊到共享的隱空間中,在大規模圖文對 (image-caption pairs) 上共同訓練圖像和文本編碼器。例如:

- GLIDE:探索了 CLIP 指導與無分類器指導,展示出 CLIP 條件擴散方法優于早期 GAN 方法,且支持強大的文本編輯;

- SD:使用凍結的 CLIP-ViT-L/14 編碼器作為條件輸入,生成高質量圖像并具有良好計算效率;

- SD 3.0:使用 CLIP ViT-L/14、OpenCLIP bigG/14 和 T5-v1.1 XXL 將文本轉為嵌入以用于生成指導。

近期擴散模型的進展還融合了大語言模型(LLMs),進一步提升了文本到圖像生成的對齊能力和生成質量:

- RPG:利用多模態 LLM 的視覺語言先驗,從文本提示中推理出補充的空間布局,并在文本引導圖像生成與編輯中操控對象組合。

不過,這些方法通常需為特定任務設計不同的模型架構、訓練策略和參數配置,增加了管理復雜性。更具可擴展性的解決方案是構建統一的生成模型,能夠處理多種數據生成任務:

- OmniGen:支持文本生成圖像、圖像編輯、主體驅動生成與視覺條件生成等多種任務;

- UniReal:將圖像任務視為不連續視頻生成,統一支持生成、編輯、定制和合成;

- GenArtist:通過多模態大模型協調統一圖像生成與編輯;

- UniVG:用一套權重處理多模態輸入,實現多種下游應用。

隨著該領域研究不斷深入,預計將出現越來越統一的模型,能夠處理更廣泛的圖像生成與編輯任務。

如下圖4所示,現有方法根據序列表示策略可分為三類:基于像素的模型、基于token的模型和基于多token的模型。

1)基于像素的模型。PixelRNN是首個用于預測下一個像素的前沿方法。它將二維圖像轉換為一維像素序列,并使用 LSTM 層根據先前生成的值逐個生成像素。盡管在建模空間依賴方面效果顯著,但其計算成本較高。PixelCNN 引入膨脹卷積以更高效地捕捉遠距離像素依賴關系,而 PixelCNN++采用離散化的邏輯混合似然函數和架構改進來提升圖像質量和生成效率。一些進階方法也提出了并行化策略,以降低計算開銷,尤其是在高分辨率圖像生成中提升速度。

2)基于token的模型。受自然語言處理范式啟發,基于token的自回歸(AR)模型將圖像轉換為離散token的緊湊序列,極大地縮短了序列長度,并支持高分辨率合成。這一過程始于向量量化(VQ):通過重建損失和承諾損失訓練的編碼器-解碼器學習到一個緊湊的潛在索引碼本,之后僅用一個解碼器Transformer對這些token建模條件分布。典型的VQ模型包括 VQ-VAE-2、VQGAN、ViT-VQGAN 等。許多工作專注于提升解碼器Transformer的能力。LlamaGen將VQGAN的分詞器應用于LLaMA骨干網絡,在性能上可與DiTs媲美,且隨著參數數量增加,生成質量也有所提升。與此同時,數據高效變體如 DeLVM在顯著減少數據需求的前提下仍能保持圖像質量;而像 AiM、ZigMa 和 DiM 等模型則引入了Mamba中的線性或門控注意力機制,以實現更快推理和更優性能。為了增強上下文建模,研究者提出了隨機和混合解碼策略。如 SAIM、RandAR 和 RAR 通過隨機打亂patch預測順序來克服固定掃描順序的偏差,而 SAR 將因果學習泛化到任意順序與跳躍間隔。混合框架進一步融合不同范式:如 RAL 使用對抗策略梯度緩解暴露偏差,ImageBART 將分層擴散更新與AR解碼交替進行,DisCo-Diff則結合了離散潛變量與擴散解碼器,獲得領先的FID得分。

3)基于多token的模型。為提升生成效率,近來的AR模型由單token生成轉向同時預測多個token,從而在不損失質量的前提下實現顯著加速。Next Patch Prediction(NPP)將圖像token聚合為高信息密度的patch級token,從而大幅減少序列長度。類似地,Next Block Prediction(NBP) 將聚合擴展到更大的空間塊(如整行或整個幀)。Neighboring AR(NAR)提出基于局部“鄰居”機制向外預測,而 Parallel Autoregression(PAR)則將token劃分為不重疊子集并發解碼。MAR 放棄了離散token化和固定順序,轉而采用用擴散損失訓練的連續表示。除空間聚合外,VAR引入粗到細的多尺度預測范式,并激發出一系列進階方法,包括 FlowAR、M-VAR、FastVAR 和 FlexVAR。一些基于頻率的方法則從頻域分解生成過程:FAR 和 NFIG 先生成低頻結構再細化高頻細節。xAR 抽象統一了自回歸單元,包括patch、cell、scale或整張圖像,在統一框架下處理不同生成粒度。這些多token方法突顯出合理定義自回歸單元的重要性,在圖像質量、生成效率和模型可擴展性之間實現平衡。

在自回歸解碼器中也逐步引入了控制機制,以實現更精細的圖像編輯。ControlAR在解碼過程中引入邊緣圖、深度圖等空間約束,支持對token級的細粒度編輯。ControlVAR 在此基礎上引入了尺度感知的條件機制,從圖像整體特征進行調控,提升了圖像的一致性與可編輯性。CAR 進一步擴展了上述思路,著重于構建更先進的控制機制,以增強圖像細節和適應能力。對于多物體或時序一致性強的復雜場景,Many-to-Many Diffusion(M2M) 將自回歸框架擴展用于多幀生成,以保證圖像間語義與時序的一致性。MSGNet 結合了VQ-VAE和AR建模,維持場景中多實體的空間-語義對齊。在醫學領域,MVG 將自回歸圖像到圖像的生成方式擴展到分割、圖像合成與去噪等任務,并通過配對的提示圖與圖像進行條件建模。這些圖像生成中的自回歸方法提供了基礎模型架構和視覺建模策略,有效推動了統一多模態理解與生成研究的發展。

統一的多模態模型:理解與生成

統一多模態模型旨在構建一個能夠同時進行多模態數據理解與生成的統一架構。這類模型被設計用于處理多種形式的輸入(如文本、圖像、視頻、音頻),并以統一的方式生成一個或多個模態的輸出。一個典型的統一多模態框架通常包含三個核心組件:模態特定編碼器,用于將不同輸入模態投影到同一表示空間;模態融合骨干網絡,用于整合多模態信息并實現跨模態推理;以及模態特定解碼器,用于在期望的模態中生成輸出(如文本生成或圖像合成)。

本節重點關注支持視覺-語言理解與生成的統一多模態模型,即以圖像和文本為輸入,并輸出文本或圖像的模型。如下圖5所示,現有統一模型大致可分為三類:擴散模型(diffusion models)、自回歸模型(autoregressive models),以及融合的AR+擴散模型(fused AR + diffusion models)。其中,自回歸模型根據其模態編碼方法進一步劃分為四個子類:基于像素的編碼(pixel-based encoding)、基于語義的編碼(semantic-based encoding)、基于可學習查詢的編碼(learnable query-based encoding)以及混合編碼(hybrid encoding)。每種編碼策略代表了處理視覺和文本數據的不同方式,導致其多模態表示在集成度和靈活性方面各有差異。而融合的AR+擴散模型根據模態編碼方式分為兩類:基于像素編碼和混合編碼。這類模型結合了自回歸與擴散技術的優勢,為實現更統一、高效的多模態生成提供了有前景的路徑。

接下來的各節將深入探討每一類模型:

- 第3.1節探討基于擴散的模型,分析其在從噪聲表示中生成高質量圖像和文本方面的獨特優勢。

- 第3.2節聚焦自回歸模型,細致解析不同編碼方法如何影響其在視覺-語言任務中的表現。

- 第3.3節介紹融合AR+擴散模型,探討兩種范式結合如何增強多模態生成能力。 最后,本文將討論任意對任意(any-to-any)多模態模型,它們將該框架擴展至圖像與語言之外,支持音頻、視頻、語音等更多模態,目標是構建通用的生成模型。

3.1 擴散模型

擴散模型因具備多項關鍵優勢,在圖像生成領域取得了顯著成功。首先,與生成對抗網絡(GAN)相比,它們在樣本質量方面表現更優,擁有更好的模式覆蓋能力,并能緩解常見問題如模式崩潰和訓練不穩定性。其次,擴散模型的訓練目標是預測添加噪聲后的數據中的噪聲部分,這是一項簡單的監督學習任務,避免了對抗式訓練的復雜性。第三,擴散模型具有高度靈活性,可在采樣過程中加入各種條件控制信號,如分類器引導 和無分類器引導,從而提升可控性和生成質量。此外,隨著噪聲調度機制 和加速采樣技術的改進,擴散模型的計算開銷大幅降低,變得更加高效和可擴展。

基于這些優勢,研究人員將擴散模型從單一模態任務擴展至多模態生成,目標是在統一框架下同時支持文本和圖像的輸出。如圖5(a)所示,在多模態擴散模型中,去噪過程不僅依賴于時間步和噪聲,還依賴于多模態上下文,如文本描述、圖像或聯合嵌入。這一擴展使得不同模態的同步生成成為可能,并促成了生成結果之間豐富的語義對齊。

一個具有代表性的例子是 Dual Diffusion,其提出了一個雙分支擴散過程,用于聯合文本和圖像生成。具體來說,給定一個文本-圖像對,Dual Diffusion 首先使用預訓練的 T5 編碼器 對文本進行 softmax 概率建模,從而獲得離散的文本表示;同時使用 Stable Diffusion中的 VAE 編碼器對圖像進行編碼,以獲得連續的圖像潛表示。這兩個模態的潛表示會分別通過各自的正向擴散過程添加噪聲,得到每個時間步上的噪聲潛變量。

在反向去噪過程中,模型使用兩個模態特定的去噪器聯合去噪文本和圖像潛表示:一個基于 Transformer 的文本去噪器和一個基于 UNet 的圖像去噪器。關鍵在于,在每個時間步,兩個去噪器都引入了跨模態的條件控制:文本潛表示關注圖像潛表示,反之亦然,這使得在整個去噪軌跡中實現了模態間的語義對齊。

去噪完成后,文本潛表示通過 T5 解碼器解碼為自然語言,而圖像潛表示則通過 VAE 解碼器解碼為高保真圖像。訓練過程中采用兩個獨立的損失項進行監督:圖像分支最小化標準的噪聲預測損失,文本分支則最小化對比式對數損失(contrastive log-loss)。通過耦合兩個擴散鏈,并引入明確的跨模態交互,Dual Diffusion 實現了從純噪聲出發的連貫、可控的多模態生成。

盡管 Dual Diffusion 在聯合文本與圖像生成方面展現了潛力,但仍面臨若干局限。其計算效率受限于多次擴散迭代的需求,速度慢于 GAN 或自回歸模型。雙分支架構增加了模型復雜性與訓練不穩定性。此外,雖然跨模態條件有助于模態對齊,但對噪聲水平仍較為敏感,可能導致輸出質量不佳。最后,對于生成細節的精細控制仍具挑戰,模型在處理分布外數據時的泛化能力也有待提升。

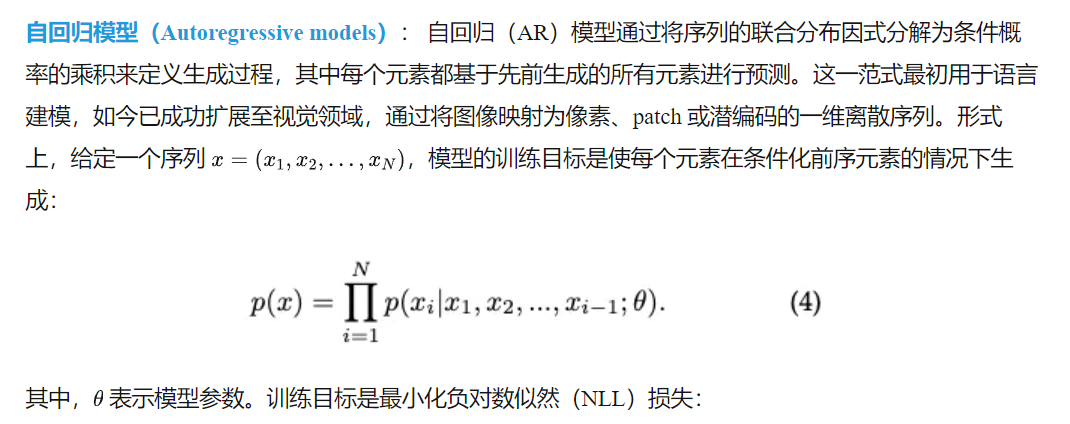

3.2 自回歸模型(Auto-Regressive Models)

在統一多模態理解與生成模型中,一個主要方向是采用自回歸(AR)架構,其中視覺和語言標記(tokens)通常被串行化并按順序建模。在這些模型中,主干 Transformer 模型(通常是從大語言模型 LLMs,如 LLaMA 系列,Vicuna,Gemma 系列以及 Qwen 系列中適配而來)作為統一的模態融合模塊,用于自回歸地預測多模態輸出。

如圖 5 所示,為了將視覺信息整合進 AR 框架,現有方法提出了多種圖像標記化策略。這些策略大致可分為四類:基于像素的編碼、基于語義的編碼、基于可學習查詢的編碼,以及混合式編碼方法。

1)基于像素的編碼(Pixel-based Encoding)

如圖 5 (b-1) 所示,基于像素的編碼通常是指將圖像表示為從預訓練自動編碼器中獲得的連續或離散標記,這些編碼器通常僅在圖像重建任務上進行監督訓練,例如 VQGAN 類模型。這些編碼器將高維像素空間壓縮為緊湊的潛在空間,其中每個空間補丁對應一個圖像標記。在統一的多模態自回歸模型中,從這類編碼器序列化得到的圖像標記可類比于文本標記進行處理,從而實現單序列內的兩種模態建模。

近期工作中,不同模型采用并增強了像素標記化的編碼設計。LWM 使用 VQGAN 標記器將圖像編碼為離散潛在代碼,而無需語義監督,并提出了多模態世界建模框架,在該框架中圖像和文本標記被串聯處理,實現統一的自回歸建模。通過僅使用重建驅動的圖像標記與文本描述進行世界動態建模,LWM 展示了即使不使用語義標記化,也能實現大規模的多模態生成。

Chameleon和 ANOLE均采用了 VQ-IMG,這是一種改進型 VQ-VAE 變體,適用于內容豐富的圖像生成。VQ-IMG 擁有更深的編碼器、更大的感受野,并加入了殘差預測機制,以更好地保留復雜的視覺細節。通過這些增強,Chameleon 和 ANOLE 能夠更忠實地序列化圖像內容,支持高質量的多模態生成。此外,這些模型還支持交錯生成(interleaved generation),即在統一的自回歸框架中交替生成文本和圖像標記。

Emu3、SynerGen-VL 和 UGen 采用了 SBER-MoVQGAN,這是一種多尺度的 VQGAN 變體,能編碼包含全局結構和細粒度細節的潛在圖像表示。通過多尺度標記化,這些模型增強了視覺表示的表達力,同時保持了訓練的效率。

與 LWM類似,Liquid 也使用 VQGAN 式的標記器,并揭示了一個新發現:在統一的自回歸目標和共享的視覺標記表示下,視覺理解與生成可以互相促進。此外,MMAR、Orthus 和 Harmon 引入了使用連續值圖像標記的框架,通過提取連續潛在表示來避免離散化所帶來的信息損失。這些方法還通過在每個自動回歸圖像塊嵌入上添加輕量級擴散頭,將擴散過程從 AR 主干中解耦,從而避免主干表示局限于最終的去噪步驟,有助于更好的圖像理解。

除 MMAR 和 Harmon外,這類模型在預訓練和生成階段均使用因果注意力掩碼,確保每個標記只能關注其序列中之前的標記。它們采用“下一個標記預測”損失函數進行訓練,圖像與文本標記均以自回歸方式進行預測,從而實現了跨模態統一的訓練目標。

在基于像素的編碼方法中,圖像重建通常采用 VQGAN 類模型中提出的配對解碼器結構。這些解碼器是輕量級卷積架構,主要用于將離散潛在網格準確還原為像素空間,專注于低級別的重建,而非高級語義推理。

此外,部分方法如 MMAR、Orthus 和 Harmon 采用連續潛變量進行圖像標記化,因此它們使用輕量擴散 MLP 解碼器將連續潛變量映射回像素空間。

盡管有效,基于像素的編碼方法仍面臨一些固有局限:

- 首先,視覺標記僅為像素重建而優化,通常缺乏高級語義抽象能力,使圖文之間的對齊更加困難;

- 其次,該方法傾向于生成密集的標記網格,尤其是在高分辨率圖像下,造成相比文本模型更長的序列長度,從而顯著增加自回歸訓練和推理的計算與內存開銷,限制了可擴展性;

- 最后,由于視覺編碼器以重建為主的目標進行訓練,生成的視覺標記可能保留過多模態特定的偏差,如對紋理或低級圖案的過度敏感,這不利于語義理解或細粒度跨模態推理。

2)語義編碼(Semantic Encoding)

為克服像素編碼中缺乏語義的問題,越來越多的工作采用語義編碼,即使用預訓練的、與文本對齊的視覺編碼器(如 OpenAI-CLIP、SigLIP、EVA-CLIP 或更新的統一標記器 UNIT)來處理圖像輸入,如圖 5 (b-2) 所示。這類模型通常在大規模圖文對數據集上,以對比學習或回歸目標進行訓練,生成的視覺嵌入能夠與語言特征在共享語義空間中對齊,從而更有效地實現跨模態對齊,有利于多模態理解與生成任務。

多種代表性模型基于不同語義編碼器和架構設計,支持統一的多模態任務。Emu、Emu2和 LaViT均采用 EVA-CLIP作為視覺編碼器。Emu 首次提出了將凍結的 EVA-CLIP 編碼器、大語言模型和擴散解碼器結合的架構,統一支持 VQA、圖像描述和圖像生成。Emu2 在此基礎上,提出了更簡潔、可擴展的預訓練框架,將模型參數規模擴大到 37B,顯著提升理解與生成能力。LaViT在 EVA-CLIP 基礎上引入了動態視覺標記機制,利用選擇器與合并模塊,根據圖像內容復雜度自適應選擇視覺標記序列長度,從而減少冗余信息并保留關鍵視覺特征,提升了訓練效率和生成質量,適用于圖像描述、問答和生成等任務。

DreamLLM、VL-GPT、MM-Interleaved 和 PUMA 采用 OpenAI-CLIP 編碼器。

DreamLLM 使用輕量線性投影對 CLIP 嵌入與語言標記對齊;VL-GPT在 CLIP 視覺編碼器后接強大的因果 Transformer,有效保留語義信息與圖像細節。MM-Interleaved和 PUMA 利用簡單的 ViT-Adapter 或池化操作從 CLIP 編碼器中提取多粒度圖像特征,支持豐富的多模態生成。

Mini-Gemini 引入了視覺標記增強機制,采用雙語義編碼器:一個 CLIP 預訓練的 ViT 編碼器提取全局視覺標記,另一個 LAION 預訓練的 ConvNeXt 編碼器提供密集的局部信息。通過交叉注意模塊將局部視覺信息注入到全局標記中,再與文本標記融合輸入至 LLM 進行聯合建模,有效融合語義抽象與像素細節。

MetaMorph使用 SigLIP提取視覺嵌入,并在語言模型多個 Transformer 層中插入模態特定適配器,支持更深層的視覺語言交互,相較淺層投影方法效果更好。ILLUME采用 UNIT作為視覺編碼器,提供語義對齊與像素保真之間平衡的統一表示。不同于僅使用對比損失的 CLIP 類模型,UNIT 同時以圖像重建和對比對齊目標進行訓練,生成兼顧理解與生成任務的圖像標記。ILLUME 基于 UNIT 的強大標記器,在圖像描述、問答、文本生成圖像與交錯生成等任務上表現優異。

類似地,VILA-U和 Unitok 模仿 UNIT,引入圖文對比學習,提出一種新型的文本對齊視覺標記器,在語義對齊與像素保真之間實現有效平衡。

在大多數此類模型中,在MLLM(多模態大語言模型)訓練期間會應用因果注意力掩碼,并采用下一標記預測損失來同時優化文本和視覺標記的生成。在圖像生成方面,大多數模型通常采用基于擴散的解碼器,如SD-v1.5、SD-v2.1、SDXL 或 IP-adapter,這些解碼器與MLLM是獨立訓練的。在推理階段,MLLM生成語義級視覺標記,然后將其傳遞給擴散解碼器以進行最終圖像合成。這種將語義編碼器與擴散解碼器配對的設計選擇,是基于以下事實:語義嵌入編碼了高層次的概念信息,但缺乏直接進行像素重建所需的空間密度和低層次細節。擴散模型通過其迭代去噪機制,特別適合此場景:即使輸入標記稀疏或抽象,它們也能逐步將語義表示細化為高分辨率、逼真的圖像。相比之下,盡管一些方法(如 VILA-U 和 Unitok)采用像素級解碼器,但其生成的圖像質量通常不如擴散解碼器。因此,擴散解碼器為語義壓縮的視覺標記提供了更強大、更具表現力的解碼路徑,顯著提升了文本-圖像對齊、整體連貫性和視覺保真度。

盡管語義編碼具有上述優勢,但也存在一些局限性。首先,由于缺乏低層次細節,生成的視覺標記在像素級控制上較弱,難以進行精細圖像編輯、局部修復或結構保持的變換。其次,語義編碼器通常僅提供全局或中層表示,對于需要空間對應關系的任務(如指代表達分割或姿態精確合成)來說可能不夠充分。最后,由于語義編碼器與擴散解碼器通常是分開訓練的,缺乏端到端的優化,這可能導致MLLM輸出與解碼器預期之間的不匹配,進而偶發語義漂移或生成偽影。

3)可學習查詢編碼(Learnable Query Encoding)

可學習查詢編碼作為一種生成自適應、任務相關圖像表示的有效策略逐漸興起。如圖5(b-3)所示,該方法不再完全依賴固定的視覺標記器或密集圖像塊,而是引入一組可學習的查詢標記,這些標記從圖像特征中動態提取信息。這些查詢標記充當感知內容的探針,與視覺編碼器交互,以生成緊湊且語義對齊的嵌入,適用于多模態理解與生成。

當前的可學習查詢編碼實現可大致分為兩類代表性范式。第一類由SEED代表,提出一種種子標記器(seed tokenizer)以學習因果視覺嵌入。具體來說,輸入圖像首先通過BLIP-2的ViT編碼器被編碼為密集標記特征,然后將其與一組可學習查詢標記拼接,并通過因果Q-Former處理以生成因果視覺嵌入。該設計在圖像-文本對比學習與圖像重建監督下訓練,使得所學嵌入同時保留低層視覺細節與高層語義對齊信息。基于這一基礎,SEED-LLAMA 與 SEED-X 通過將OPT主干替換為更強的LLaMA2模型并將解碼器升級為UnCLIP-SD或 SDXL ,從而提升了模型在理解與生成任務中的性能。

第二種方法由MetaQueries提出,提供了一個簡化版本的可學習查詢編碼方案。在此方法中,圖像特征通過一個凍結的SigLIP編碼器提取,然后與可學習查詢標記拼接,并直接輸入到如LLaVA 或 Qwen2.5-VL等凍結的視覺-語言主干模型中。輸出的因果嵌入用于擴散解碼器的條件輸入,從而實現高質量圖像生成。由于主干模型保持凍結,該方案在保留預訓練模型視覺語言理解能力的同時,提供了一種輕量且高效的多模態生成解決方案。

這些基于可學習查詢的設計具有一個共同優勢:它們提供了自適應、緊湊且語義豐富的表示,既支持高效圖像理解,也可實現高質量圖像生成。通過聚焦于任務驅動的標記提取,這類模型為傳統視覺標記器提供了一個靈活且可擴展的替代方案,尤其適用于統一多模態框架。

盡管具有靈活性與良好效果,可學習查詢編碼也存在一些限制,可能會影響其廣泛應用。首先,一個關鍵挑戰是可學習查詢標記帶來的計算開銷增加。隨著查詢標記數量增長,模型的內存消耗與計算復雜度可能顯著上升,尤其是在擴展至大型數據集或更復雜多模態任務時。其次,如SEED 和 MetaQueries所示,依賴凍結或預訓練的主干網絡可能限制視覺特征對下游任務的適應能力。雖然凍結可降低訓練成本并保留預學習知識,但也限制了模型在動態對齊圖像特征與不斷變化的查詢語義方面的能力,尤其在更復雜或組合性任務中更為明顯。最后,雖然可學習查詢能夠有效捕捉任務相關內容,但其在處理多樣化視覺內容方面未必均衡。例如,對于包含多個對象、細粒度細節或模糊視覺線索的復雜場景來說,相對少量的查詢標記可能無法充分捕捉圖像中的豐富性與變異性。這一局限在模型需生成高度精細輸出時尤為明顯,因為固定或較少的查詢集合可能不足以涵蓋某些上下文中的全部視覺信息。

4)混合編碼(Hybrid Encoding)

為了解決單一模態視覺表示的固有限制,統一多模態模型中引入了混合編碼策略。基于像素的編碼方法(如 VQ-VAE 或 VQGAN)擅長保留細粒度的視覺細節,但在與文本的語義對齊方面表現欠佳。相比之下,基于語義的編碼器(如 SigLIP 或 CLIP 變體)生成的表示具有豐富的語義信息,但不擅長保留圖像的低層次細節。混合編碼旨在通過將像素級和語義級特征整合為統一表示,結合兩者的優點。根據像素標記和語義標記的整合方式不同,混合編碼方法可大致分為兩類:偽混合編碼(pseudo hybrid encoding)與聯合混合編碼(joint hybrid encoding)。

偽混合編碼(Pseudo Hybrid Encoding) 這一類別的代表性工作包括 Janus、Janus-Pro、OmniMamba 和 Unifluid。如圖 5(b-4) 所示,這些模型采用雙編碼器架構——通常包括語義編碼器(例如 SigLIP)和像素編碼器(例如 VQGAN 或 VAE)——但以任務為導向的方式使用它們。在訓練過程中,語義編碼器被用于視覺-語言理解任務,而像素編碼器則用于圖像生成任務。盡管兩種編碼器通過混合的理解與生成數據進行聯合訓練,但在推理階段不會啟用像素編碼器。

這種設計的動機在于:通過同時訓練理解和生成任務,可以提升兩個方向的性能。然而,由于任一時刻僅激活一個編碼器,這些模型并未充分發揮混合編碼的潛力。具體而言,它們在圖像生成任務中錯失了利用語義信息進行語義對齊的機會,同時在理解任務中也無法充分利用圖像的高保真細節。因此,這些模型通常使用像素解碼器從潛在編碼中重構圖像。

聯合混合編碼(Joint Hybrid Encoding) 如圖 5(b-5) 所示,聯合混合編碼方法將語義與像素令牌整合為統一輸入,供語言模型或解碼器使用,從而實現兩種表示的同時利用。代表性工作包括 MUSE-VL、VARGPT、VARGPT-1.1 和 ILLUME+。這些模型在融合策略上存在差異:MUSE-VL 在通道維度上拼接 SigLIP 與 VQGAN 的特征后輸入 LLM;而 VARGPT、VARGPT-1.1 和 ILLUME+ 則在序列維度上拼接語義與像素令牌,并同時輸入給 LLM。

通過結合語義信息與高保真視覺細節,聯合混合編碼可提升多模態理解與生成的魯棒性與表達力。這些模型支持使用像素解碼器(如 VQGAN、Infinity、VAR-D30)以及基于擴散的解碼器(如 SDXL),從而生成在語義對齊與視覺逼真度方面更優秀的圖像。

盡管混合編碼通過整合像素級與語義級的互補優勢展現出巨大潛力,但仍面臨諸多限制。許多偽混合方法在推理時并不同時啟用兩個編碼器,從而未能利用二者的協同效果。即便是聯合混合方法,在處理異質令牌融合時也可能引入模態不平衡或冗余,若未加以妥善管理,可能影響下游任務表現。此外,雙編碼器架構顯著增加了計算與內存開銷,尤其在高分辨率或長序列任務中,存在擴展性挑戰。像素與語義令牌之間的對齊仍然是一項非平凡的問題,隱式的不匹配可能導致表征混亂或監督信號沖突。在訓練數據稀缺或數據噪聲較大時,這類錯配尤為明顯。

3.3 融合自回歸與擴散模型(Fused Autoregressive and Diffusion Models)

融合自回歸(AR)與擴散建模近期作為一種強大的視覺-語言統一生成框架快速興起。在該范式中,文本令牌采用自回歸方式生成,保留大語言模型的組合推理能力;而圖像令牌則通過多步去噪擴散過程生成,遵循擴散模型原理。該混合策略使圖像生成過程不再依賴嚴格的序列順序,從而提升視覺質量與全局一致性。

代表性模型包括 Transfusion、Show-o、MonoFormer 和 LMFusion。在生成過程中,這些模型將噪聲添加至視覺潛表示,并通過條件化在已生成文本或跨模態上下文基礎上進行多步去噪。盡管這種設計會因多輪采樣帶來更高的推理開銷,但在符號控制與圖像質量之間實現了有效權衡,特別適用于高質量的視覺-語言生成任務。

現有融合 AR + 擴散模型通常采用以下兩種圖像編碼策略:基于像素的編碼與混合編碼。

1)基于像素的編碼(Pixel-based Encoding)

如圖 5(c-1) 所示,該策略將圖像轉化為離散令牌或連續潛向量,隨后將其作為擴散過程的目標,并由自回歸生成的文本令牌進行條件引導。在近期工作中,Transfusion、MonoFormer 和 LMFusion 均采用由 SD-VAE 提取的連續潛表示。它們共享一個訓練目標,即結合語言建模的自回歸損失與圖像重構的擴散損失,同時利用雙向注意機制保證空間一致性。

盡管整體框架相似,但各模型在架構上各具特色:

- Transfusion提出了一個統一 Transformer 主干網絡,使用模態專屬的子層同時處理離散與連續輸入;

- MonoFormer則采用緊湊架構,通過共享模塊與任務相關的注意力屏蔽機制在 AR 與擴散任務間取得平衡;

- LMFusion允許凍結的 LLM 執行高質量圖像生成,其輕量視覺注入模塊在不影響語言能力的前提下,僅訓練視覺分支。

相較而言,Show-o 使用基于 MAGVIT-v2 的離散像素編碼器,以符號化圖像令牌的方式適配 Transformer 解碼流程。它支持自回歸文本生成與擴散圖像合成,同時使用自回歸與擴散損失聯合監督。

這些模型共同驗證了像素編碼在實現語言模型語義控制與擴散模型高保真圖像生成之間的有效平衡。

然而,這類像素編碼方法也面臨一系列問題:

- 使用 SD-VAE 提取連續潛表示會帶來訓練與推理過程中的大量計算開銷,尤其是在高分辨率圖像或多輪交互任務中更為明顯;

- 文本與圖像模態的對齊仍是挑戰。盡管使用雙向注意機制促進模態融合,但 SD-VAE 中的隱空間通常由無監督重建目標學習而來,可能與語言語義信息對齊不足,導致細粒度控制能力減弱或生成可解釋性降低;

- 離散編碼方案(如 Show-o)存在 VQ 模型常見的問題,例如代碼本坍塌與細節能力受限,使其在視覺多樣性與重建質量方面略遜于連續表示方法。

2)混合編碼(Hybrid Encoding):

如前面圖 5(c-2) 所示,混合編碼結合語義特征(如來自 CLIP 或 ViT 的編碼器)與像素級潛表示(如來自 SD-VAE),從而構建更具表現力的圖像表示方式。該方法允許模型在保留語義抽象能力的同時,也捕捉視覺細節。

代表性方法是 Janus-Flow,其采用雙編碼器架構,并提出一個精簡的架構用于將自回歸語言模型與整流流模型(rectified flow)整合。它解耦了理解與生成編碼器,使用 SigLIP 作為視覺編碼器進行多模態理解,使用 SDXL-VAE 執行圖像生成。然而,由于其偽混合編碼設計,在圖像合成過程中僅激活像素編碼器,限制了模型在生成時利用語義信息的能力,從而可能影響細粒度對齊與生成任務中的多模態組合能力。

盡管取得了一定進展,混合編碼方法仍面臨多個挑戰:

- 雙編碼器架構與 AR+擴散流程的結合提高了模型復雜度,帶來更高的計算成本與訓練時間,整體效率低于簡單模型;

- 實現語義特征與像素特征的有效對齊需要精心設計與優化,而這一過程往往非常復雜,制約了模型在兩種模態間的協同能力;

- 在統一模型中同時優化視覺-語言理解與圖像生成任務,可能導致權衡問題,即提升一個任務可能以犧牲另一個任務為代價。

這些限制凸顯出對更高效混合設計的迫切需求,即能在降低開銷的同時,充分利用視覺與語義特征的優勢,并在多任務中保持高性能。

3.4 任意對任意多模態模型

早期的統一多模態模型主要集中在文本-圖像對上,而最近的研究則擴展到了任意對任意的多模態建模。這種雄心勃勃的方法旨在創建能夠處理和生成各種模態的模型,包括音頻、視頻、語音、音樂等。這些模型的目標是將特定模態的編碼器和解碼器統一到單一架構中,從而實現文本到音頻、視頻到文本、語音到音樂甚至圖像到視頻的生成任務。本節回顧了該新興領域的代表性作品,重點介紹了它們的設計原則、模塊化結構和當前的局限性。

大多數任意對任意模型采用模塊化設計,每種模態配備專門的編碼器和解碼器,而共享的主干網絡則促進跨模態表示學習和序列建模。例如,OmniFlow 集成了用于音頻和音樂生成的 HiFiGen,用于圖像處理的 SD-VAE,并使用類似 DiT 的擴散模型(MMDiT) 作為主干。該模塊化設計使得模型能夠高效地結合不同模態進行復雜的生成任務。

一些模型依賴于共享嵌入空間,通過特征層次上統一不同模態。例如,Spider、X-VILA 和 Next-GPT利用 ImageBind —— 一種對比訓練的模型,將六種模態(文本、圖像、視頻、音頻、深度和熱成像)映射到單一的嵌入空間中。這種統一表示使得通過特定模態的解碼器進行靈活的條件生成成為可能,如 Stable Diffusion、Zeroscope 或基于 LLM 的文本解碼器。雖然這一方法理論上優雅,但其生成能力常常受到解碼器質量和共享嵌入粒度的限制。

其他模型,如 AnyGPT 和 Unified-IO 2,將序列到序列范式擴展到處理多模態。AnyGPT 使用 EnCodec進行音頻標記化,SpeechTokenizer進行語音處理,并訓練了一個統一的 Transformer 模型,通過模態特定的前綴進行訓練。另一方面,Unified-IO 2采用了更加結構化的編碼器-解碼器設計,包含視覺、音頻和語言模態,支持像 AST 到文本、語音到圖像或視頻字幕生成等任務。

盡管取得了令人鼓舞的進展,當前的任意對任意模型仍面臨一些挑戰。其中一個關鍵問題是模態不平衡,文本和圖像模態往往占主導地位,而音頻、視頻和音樂等模態則被代表不足,這限制了這些模型所能處理的任務多樣性。另一個挑戰是可擴展性,支持廣泛的模態增加了模型的復雜性,導致更高的推理延遲和更大的資源需求。此外,確保跨模態的語義一致性仍然是一個非平凡的任務,模型通常難以保持輸出的實用性和一致性。這些挑戰仍然是任意對任意多模態模型發展的研究方向。

盡管如此,這些模型代表了朝著開發能夠跨越整個感知和交流領域理解和生成的通用基礎模型邁出的重要一步。隨著數據、架構和訓練范式的不斷發展,未來的任意對任意模型預計將變得更加組合化、高效,并能夠實現真正的跨模態生成。

多模態統一模型的數據集

大規模、高質量且多樣的訓練數據是構建強大統一多模態理解和生成模型的基礎。這些模型通常需要在大量的圖像-文本對上進行預訓練,以學習跨模態的相關性和表示。需要注意的是,在對大規模多模態數據進行訓練之前,這些模型通常會使用來自大規模自然語言語料庫(如Common Crawl 1、RedPajama、WebText等)的訓練參數進行初始化。由于本綜述主要集中在多模態模型上,因此本節討論將排除純文本數據。根據主要用途和模態特征,常見的預訓練多模態數據集可以大致分為以下幾類:多模態理解數據集、文本到圖像生成數據集、圖像編輯數據集、交替圖像-文本數據集以及其他基于文本和圖像輸入的圖像生成數據集。本節將詳細介紹下表3中列出的每個類別的代表性數據集,重點關注2020年以后發布的數據集。

多模態理解數據集

這些數據集主要用于訓練模型的跨模態理解能力,支持圖像字幕生成、視覺問答(VQA)、圖像-文本檢索和視覺定位等任務。它們通常包含大量與相應文本描述配對的圖像。

- RedCaps:該數據集包含來自 Reddit 的1200萬個圖像-文本對,專門捕捉日常物品和時刻(如寵物、愛好、食物、休閑等),這些內容經常出現在社交媒體平臺上。

- Wukong:Wukong 數據集是一個大規模的中文多模態預訓練數據集,包含1億個來自網絡的中文圖像-文本對。該數據集的創建解決了大規模高質量中文多模態預訓練數據的不足,對于針對中文場景的多模態模型發展起到了重要作用。

- LAION:LAION(大規模人工智能開放網絡)項目提供了最大規模的公開圖像-文本對數據集之一。例如,LAION-5B 包含近60億個圖像-文本對,這些數據來自網絡爬蟲。使用 CLIP 模型對數據進行過濾,確保圖像和文本之間具有一定的相關性。由于其龐大的規模和多樣性,LAION 數據集已經成為許多大型多模態模型預訓練的基礎。其子集 Laion-COCO 包含6億個樣本,提供高質量的字幕,旨在提供與 MS COCO 在風格上更加接近的大規模數據集。

- COYO:COYO 是另一個大規模圖像-文本對數據集,包含約7.47億個樣本。與 LAION 類似,它是通過網絡爬蟲獲得的,并經過過濾過程。它為社區提供了 LAION 以外的另一種大規模預訓練資源。

- DataComp:DataComp 包含14億個樣本,來源于 Common Crawl,通過精心設計的過濾策略(CLIP評分和基于圖像的過濾)獲得,旨在提供比原始爬取數據更高質量的圖像-文本對。

- ShareGPT4V:該數據集提供約10萬個高質量的圖像-文本對話數據點,專門用于增強大型多模態模型的指令跟隨和對話能力,使其成為更好的對話代理。

- CapsFusion-120M:這是一個大規模的數據集,包含來自 Laion-COCO的1.2億個圖像-文本對。其字幕通過將 Laion-COCO 中的字幕與 CapsFusion-LLaMA結合獲得。

- 其他數據集:最近開發的其他理解數據集包括 GRIT(基于網格的圖像-文本表示)(20M 樣本,強調細粒度的圖像區域-文本短語對齊)。此外,雖然 SAM 數據集最初并不包含圖像-文本對,但它收錄了1100萬張高分辨率圖像和詳細的分割掩模,提供了有價值的空間和語義信息,可以增強多模態模型的細粒度理解能力,比如理解物體的位置、邊界或執行區域特定操作。

文本到圖像數據集

這些數據集主要用于訓練生成與文本描述相對應的圖像的模型。它們通常由圖像-文本對組成,通常更強調圖像的審美質量、內容的豐富性或特定的風格屬性。

- CC-12M(Conceptual Captions 12M):CC-12M包含約1200萬個從網絡Alt-text中提取并過濾的圖像-文本對。與原始的網頁抓取數據相比,其文本描述通常更加簡潔和描述性,使其成為訓練文本到圖像模型的廣泛使用的數據集。

- LAION-Aesthetics:這是LAION數據集的一個子集,通過使用審美評分模型進行過濾,選擇大約1.2億張被認為具有較高“審美價值”的圖像(及其文本)。

- Mario-10M 和 AnyWord-3M:這兩個數據集關注圖像中文字的準確渲染。Mario-10M(1000萬個樣本)用于訓練TextDiffuser模型,AnyWord-3M(300萬個樣本)用于訓練AnyText,提供專門設計的數據,用于提高生成圖像中文本的可讀性和位置。

- JourneyDB:JourneyDB包含400萬個由Midjourney平臺生成的高質量圖像-提示對。由于Midjourney以生成創意和藝術性圖像而聞名,這個數據集為訓練模型學習復雜、詳細和藝術風格的文本到圖像映射提供了寶貴的資源。

- CosmicMan-HQ 1.0:該數據集包含600萬個高質量的真實世界人像圖像,平均分辨率為1488 × 1255像素。這個數據集的特色在于其精確的文本注釋,來自1.15億個不同粒度的屬性。它可以用于提高生成人體圖像的能力。

- PixelProse:PixelProse從DataComp、CC-12M和RedCaps中提取,包含豐富注釋的圖像及其對應的文本描述。這個數據集提供了如水印存在與否、審美分數等有價值的元數據,可以用于過濾出符合期望的圖像。

- Megalith:Megalith是一個數據集,包含約1000萬個Flickr圖像鏈接,分類為“照片”,并具有不受版權限制的許可。社區使用如ShareCaptioner、Florence2和InternVL2等模型生成的字幕公開提供。

- PD12M:PD12M包含1240萬張高質量的公共領域和CC0許可圖像,這些圖像與使用Florence-2-large生成的合成標題配對。該數據集專為訓練文本到圖像模型設計,提供了大量的資源,并最大限度地減少了版權問題。

- 其他數據集:SAM數據集(約1100萬張高分辨率圖像)和DenseFusion(100萬個樣本)是其他可能的數據源,用于訓練文本到圖像生成模型。需要注意的是,多模態理解數據集可以通過審美分數過濾、NSFW過濾、分辨率過濾、水印過濾、重新標題等方式,用于合成文本到圖像生成數據,但此處未作介紹。

圖像編輯數據集

隨著模型能力的提升,基于指令的圖像編輯已成為一個重要的研究方向。此類數據集通常包含(源圖像、編輯指令、目標圖像)的三元組。這些數據集用于訓練模型根據文本指令修改輸入圖像,從而增強統一模型的理解和生成能力。

- InstructPix2Pix:該數據集采用創新的合成方法生成:首先,使用大語言模型(如GPT-3)生成編輯指令和目標圖像的標題;然后,使用文本到圖像模型(如Stable Diffusion)根據原始和目標標題生成“前后”圖像。此方法自動創建了約313K(指令、輸入圖像、輸出圖像)訓練樣本。

- MagicBrush:MagicBrush是一個高質量的、人工注釋的數據集,用于基于指令的圖像編輯。它包含約10K樣本,涵蓋各種現實且精細的編輯操作(如物體添加/移除/替換、屬性修改、風格轉換),并提供了編輯區域的掩碼。其人工注釋使得指令更加自然和多樣。

- HQ-Edit,SEED-Data-Edit,UltraEdit,OmniEdit,AnyEdit:這些是近年來更大規模的圖像編輯數據集。例如,SEED-Data-Edit包含370萬個樣本,UltraEdit有400萬個樣本,AnyEdit提供250萬個樣本,OmniEdit包含120萬個樣本,HQ-Edit包含19.7萬個樣本。它們通常結合了自動生成與人工過濾/注釋,旨在提供更大規模、更高質量和更多樣化的編輯指令和圖像對,用于訓練更強大的指令跟隨編輯模型。

圖像-文本交織數據集

除了由配對圖像和標題組成的數據集之外,另一個重要的類別是圖像-文本交織數據集。這些數據集包含文檔或序列,其中文本和圖像自然地交替出現,類似于網頁或文檔中的內容。對這些交織數據進行訓練,可以增強模型理解和生成多模態內容的能力,這是統一模型的一個重要目標。

- Multimodal C4 (MMC4):MMC4通過算法將圖像交織到來源于Common Crawl的文本文檔中,從而增強了大規模文本-only C4語料庫。該公共數據集包含超過1.01億個文檔和5.71億張圖像,旨在為旨在處理圖像和文本混合序列的模型提供必要的交織預訓練數據。

- OBELICS:OBELICS是一個開放的、Web規模的數據集,包含從Common Crawl中提取的1.41億個多模態Web文檔,特征包括3.53億張圖像和1150億個文本標記。該數據集側重于捕獲完整的文檔結構,而非孤立的圖像-文本對,旨在提高模型在各種基準測試中的表現。

- CoMM:CoMM是一個高質量的、精心策劃的數據集,專門關注圖像-文本交織序列的一致性和連貫性,包含約227K個樣本。它通過多角度過濾策略,主要來源于教程和視覺故事網站(如WikiHow),解決了在更大數據集中觀察到的敘事流程和視覺一致性問題。CoMM旨在提升MLLM生成邏輯結構和視覺一致的多模態內容的能力,并引入了新型的基準任務,專門評估這些能力。

其他文本+圖像到圖像的數據集

除了前面提到的類別,為了進一步增強統一模型的能力—例如根據提供的主題圖像生成圖像,或利用控制信號(如深度圖、Canny 邊緣圖)—本文在本節中介紹相關的數據集。

- LAION-Face:上面討論的數據集側重于一般的主題驅動生成,而 ID 保持圖像生成代表了這一類別的一個特殊子集。利用 LAION-Face 數據集,其中包含 5000 萬個圖像-文本對,最近的進展如 InstantID成功地在保持角色身份的同時生成圖像。

- MultiGen-20M:該數據集包含 2000 萬個樣本,旨在訓練能夠基于多個控制信號(例如文本描述、邊緣圖、深度圖、分割掩碼、草圖)進行統一圖像生成的模型,如 UniControl 。它整合了來自多個來源的數據,并將它們轉換為統一格式,使模型能夠學習多任務、多條件的圖像生成。數據集可以結構化為三元組,例如“深度圖、帶有提示的指令、目標圖像”(例如提示可能為:“根據深度圖生成一幅令人印象深刻的場景。”),以有效地訓練統一模型。

- Subjects200K:包含 20 萬個樣本,Subjects200K 集中于主題驅動的圖像生成,對于個性化內容創作至關重要。該數據集通過多階段pipeline合成生成:首先,由一個大語言模型(如 ChatGPT-4o)創建涉及物體類別和場景的結構化描述;隨后,由一個圖像合成模型(如 FLUX )根據這些描述生成多樣化且一致的配對圖像;最后,LLM 對生成的配對進行質量評估,以確保主題一致性、正確的構圖和高分辨率。

- SynCD:SynCD(Synthetic Customization Dataset)提供了大約 9.5 萬組專門為文本+圖像到圖像定制任務設計的圖像集,解決了缺乏多種條件下同一對象的公開數據集的問題。它通過利用現有的文本到圖像模型和 3D 資產數據集(如 Objaverse)來生成對象的多種一致視圖,具有不同的光照、背景和姿勢,并結合了共享注意力和深度引導等技術。主題驅動的生成,涉及單一和多個主題,是一種日益受到社區關注的圖像生成能力。這也是統一模型中一個重要的特性。然而,從公開數據集中獲取這種專業化的數據較為困難,因此經常使用數據合成方法,如 Subjects200K 和 SynCD 數據集所示。這些數據集展示了利用合成數據來解決公開可用訓練樣本短缺問題的日益增長的依賴。

為了創建大規模數據集,已開發出多種pipeline,用于程序化生成合適的訓練數據,通常利用現成的圖像或視頻來源。以下是這些pipeline的簡要概述,供參考。

- 從圖像合成數據:這些pipeline通常從單張圖像開始,使用像 BLIP-2 或 Kosmos2 這樣的模型進行初步標注(包括使用邊界框進行的定位標注),然后通過物體檢測(例如 Grounding DINO)和分割(例如 SAM)來提取物體的掩碼和區域標注。這些pipeline可以生成單一物體定制和多個物體定制的數據。

- 從視頻合成數據:從圖像構建的數據通常會導致模型學習中的復制粘貼問題。通過從不同幀中提取物體,使用視頻分割模型(如 SAM2)的視頻合成數據pipeline可以緩解這一問題。此外,這一pipeline還可以支持圖像編輯任務的訓練數據生成。

強大的統一多模態模型在很大程度上依賴于最近開發的大規模、高質量和多樣化的訓練數據集,這些數據集包括圖像-文本對、交織的圖像-文本文檔和特定任務格式。雖然大規模的網絡規模配對數據(如 LAION、COYO)和交織的文檔語料庫(如 MMC4、OBELICS)為預訓練提供了廣泛的語義覆蓋和上下文理解,但顯著的努力集中在提高數據質量和為特定屬性或高級能力定制資源上。專門化的數據集對于提升基于指令的編輯、精確文本渲染、一致的多模態生成和復雜的條件控制變得越來越重要。此外,認識到高質量公開數據的稀缺性,特別是在圖像編輯和主題定制任務等方面,開發和利用數據合成管道變得至關重要,這使得能夠創建針對性數據集以訓練這些高度專業化的模型功能。最終,數據資源的持續演變、規模擴大、針對性專門化和創新的合成是推動統一多模態模型越來越復雜的理解和生成能力的根本動力。

基準測試

現代的大規模統一多模態模型不僅需要在像素級對視覺和語言信息進行對齊,還要能夠進行復雜的推理,支持連貫的多輪對話,并整合外部知識。同時,這些模型還需要生成高保真度的視覺輸出,忠實地遵循文本提示,并為用戶提供對風格和組成元素的精細控制。本節系統地總結了相關的評估基準。請參閱下表 4 以獲取統計摘要。

理解評估

感知。現代的視覺-語言大規模模型必須準確地將視覺輸入與語言描述進行對接,通過定位、識別和檢索。早期的圖像-文本檢索和標題生成基準(如Flickr30k,MS COCO Captions)評估模型是否能夠檢索相關標題并將文本短語定位到圖像區域。視覺問答基準(如VQA,VQA v2,VisDial,TextVQA)進一步要求模型解釋復雜的場景并回答關于物體、屬性和關系的自由形式問題。領域特定的挑戰(如ChartQA)評估對結構化圖表和圖形的理解,而VSR則探討現實世界圖像中的空間關系推理。

為了統一評估,大規模的元基準套件測試低級別的感知和專家推理。MMBench 提供了3K個雙語多項選擇問題,涵蓋了定位、識別和檢索,支持跨語言對比。MMMU 添加了大約11.5K個大學級別的多模態問題,涵蓋六個學科,測試領域知識和邏輯推理。HaluEval 診斷模型生成的陳述中的幻覺識別。MM-Vet涵蓋了識別、OCR、空間推理、數學和開放式問答,其v2進一步評估交錯的圖像-文本序列。SEED-Bench設計了一個生成多項選擇問題的管道,針對特定的評估維度,最終提供了19K個多項選擇項,涵蓋12個維度。LLaVa-Bench 提供了COCO和真實圖像集,并配有密集查詢,用于通用化檢查。LAMM提供了涵蓋2D和3D模式的指令調優示例,用于代理開發。Open-VQA設計了分層的后續問題,以完善粗略的VQA答案。OwlEval提供了人工評定的開放式視覺問題,評估其相關性和信息量。MMStar精心策劃了涵蓋六個核心技能和18個評估軸的挑戰樣本,用于高精度評估。

推理。在感知級別評估的基礎上,推理基準探討更豐富的認知技能。CLEVR系統地改變物體屬性和空間關系,迫使模型執行多跳程序,測試計數、比較和關系邏輯。轉向自然圖像,GQA利用密集場景圖生成組合問題,其功能程序用于測試一致性、定位和可信性。

常識推理擴展(如OK-VQA及其較大的后續版本A-OKVQA)選擇問題,其答案超出了圖像,需要在世界知識庫上進行檢索或推理。VCR進一步要求模型不僅選擇正確的答案,還要選擇一個連貫的理由,從而將識別與解釋結合起來,測試多步常識鏈條。

領域特定的推理數據集將這一進展擴展到超越日常場景的范圍。ChartQA引入了將視覺感知與對條形圖、折線圖和餅圖的定量推理相結合的問題,整合數據提取、邏輯比較和算術計算。MathVista將范圍擴展到數學問題求解,在視覺上下文中結合了細粒度的視覺理解和符號操作,涵蓋了多樣化的示例。這些基準測試形成了一個分層的光譜,涵蓋了結構化邏輯推理、開放領域常識、視覺解釋和數字密集型任務,為多模態推理系統提供了全面的壓力測試。

圖像生成評估

文本到圖像生成。早期的自動化評估指標(如FID 和 CLIPScore)為圖像質量評估奠定了基礎。然而,最近的基準將重點轉向了組合性、對齊性和現實世界的適用性。GenEval 評估六個細化任務,包括單物體生成、物體共現、計數、顏色控制、相對定位和屬性綁定,通過將預訓練的檢測器輸出與真實注釋進行比較來進行評估。

在此基礎上,GenAI-Bench 提出了1600個精心設計的人類提示,涵蓋了關系、邏輯和屬性等類別。其評估框架結合了人類偏好判斷與自動對齊評分,提供了全面的評估。此外,HRS-Bench 評估了準確性、魯棒性、泛化能力、公平性和偏差等13個不同的技能,將其分為五大類,從而確保了可擴展性和可靠的性能測量。此外,DPG-Bench專注于密集提示,描述了多個物體,每個物體具有多種屬性和關系。

T2I-CompBench及其后續版本T2I-CompBench++ 專門針對組合生成的泛化能力,測試生成新的屬性和關系組合,使用基于檢測器的評分。VISOR提出了一個自動化方法來評估生成模型的空間理解能力。與此互補,Commonsense-T2I 挑戰模型描繪需要常識基礎的日常概念。

為了支持大規模的概念多樣性,EvalMuse-40K提供了40K個眾包提示,專注于細致的概念表示,HEIM確定了12個方面,包括文本-圖像對齊、圖像質量、美學、原創性、推理、知識、偏差、毒性、公平性、魯棒性、跨語言能力和效率。考慮到實際需求,FlashEval通過迭代搜索將大規模評估集縮小為多樣化的小型評估集,以加速基準測試。MEMO-Bench 引入了一個全面的基準,評估T2I模型和多模態大語言模型的情感理解與表達能力。

圖像編輯。指導性圖像編輯的基準在規模和范圍上不斷擴大。MagicBrush 是第一個大規模、手動注釋的數據集,用于指導性的真實圖像編輯,涵蓋了多種場景:單輪、多輪、掩碼提供和無掩碼編輯。HQ-Edit包含約20萬個高分辨率編輯,計算了對齊性和一致性評分,允許通過GPT-4V定量評估圖像編輯對。

在此基礎上,I2EBench 整合了2000多張圖像和超過4000條跨16個編輯維度的多步驟指令。EditVAl提供了一個標準化的基準,使用預訓練的視覺-語言模型自動評估編輯類型,并且其評分與人類評估高度相關。Emu-Edit 包括七個基于指令的編輯任務,涵蓋背景更改、綜合修改、風格變換、物體移除、物體添加、局部編輯和紋理修改,提供了帶有輸入/輸出描述的人類指令/圖像對。HumanEdit提供了5751張高分辨率圖像,配有跨六個編輯類別的開放式語言指令:動作、添加、計數、關系、移除和替換,并配有掩碼和多階段的人工反饋,以嚴格評估指導性圖像編輯模型。

最近,提出了GEdit-Bench,這是一個現實世界的圖像編輯基準,包含606個圖像-指令對,來自1000多個用戶編輯示例,旨在全面評估實際圖像編輯模型的表現。

其他類型的圖像生成

除了文本到圖像生成和圖像編輯,其他基準測試則探討了大規模條件化和個性化合成。MultiGen-20M 包含來自LAION-Aesthetics-V2的2000萬對圖像-提示-條件三元組,用于在不同視覺條件下評估對齊性,并提供每個任務100-300個圖像-條件-提示三元組的評估集。

DreamBench引入了一個個性化生成測試,涵蓋30個參考對象,配有精心策劃的提示和人工注釋的保真度評判。DreamBench++ 擴展了這個框架,包含150個多樣的參考圖像和1350個提示,采用先進的多模態語言模型進行自動化、人類對齊的評分,評估概念保留、組成忠實性和風格一致性。總的來說,這些數據集提供了從大規模自動化基準到聚焦于人類中心的條件和主題驅動圖像生成評估的統一譜系。

交替生成的評估

交替評估基準挑戰模型無縫地在文本和圖像模態之間交替生成,反映了現實世界中的對話和講故事場景。InterleavedBench 是第一個專門為交替文本和圖像生成評估而精心策劃的基準,涵蓋了多樣的任務,評估模型在文本質量、感知保真度、多模態一致性和有用性方面的表現。基于此,ISG 引入了場景圖注釋和四級評估(整體、結構、區塊級別和圖像特定)來對1000個樣本的八個場景和21個子任務進行細粒度評估,提供了對交替文本-圖像輸出的深入考核。

其他基準強調開放領域指令和端到端的交替生成。OpenING收集了5000個人工注釋的實例,涵蓋56個現實世界任務(例如旅游指南、設計構思),并使用IntJudge測試開放式多模態生成方法在任意指令驅動的交替生成中的表現。相對地,OpenLEAF收集了30個開放領域的查詢,每個查詢都經過注釋員的撰寫和審閱,旨在探討基礎的交替文本-圖像生成,通過LMM評估器和人工驗證來衡量實體和風格的一致性。最后,MMIE提出了一個統一的交替生成基準,采樣自12個領域和102個子領域,提供了多項選擇題和開放式問題格式,評估模型在多樣化方式中的表現。

統一模型的挑戰與機會

目前,統一的多模態模型仍處于初級階段,面臨一些顯著挑戰,必須解決這些問題才能實現強大且可擴展的理解與生成能力。首先,視覺和文本數據的高維度導致極長的標記序列。有效的標記化和壓縮策略對于減少內存和計算成本同時保持表示的忠實度至關重要。

其次,隨著圖像分辨率和上下文長度的增加,跨模態注意力成為性能瓶頸。稀疏或層次化注意力機制等可擴展的替代方法可能有助于緩解這一問題。第三,預訓練數據集往往包含噪聲或偏見的圖像-文本對,特別是在復雜的圖像構圖和交替圖像-文本數據中。可靠的數據過濾、去偏和合成對于確保公平性和魯棒性至關重要。第四,評估協議通常為單一任務設計,存在對理解和生成綜合評估的需求,尤其是在圖像編輯和交替圖像-文本生成等復雜任務中。

據本文所知,目前大多數統一的多模態模型主要強調圖像理解和文本到圖像生成,而圖像編輯等能力僅通過后期微調實現。此外,像空間控制圖像生成、基于主題的圖像生成和交替圖像-文本生成等高級功能,在統一框架中仍未得到充分探索。因此,本文認為,通過解決關鍵領域如架構設計、訓練效率、數據集策劃和評估方法,有豐富的機會推動該領域的進步。

結論

本文提供了一個全面的視角,探討了將視覺-語言理解與圖像生成集成在單一框架中的統一多模態模型。首先,本文簡要概述了多模態理解和文本到圖像生成模型的基礎知識和近期進展。接下來,本文通過將統一多模態模型分為三大范式:基于擴散的、基于自回歸的和混合型方法,對相關工作進行系統的調查。對于每個范式,本文介紹了相關的工作,并進一步細分成不同的子類別,幫助讀者更好地掌握該領域的全貌。此外,本文策劃了相關的數據集和基準,以促進實踐中的實現和評估。最后,本文討論了該領域的關鍵挑戰和機遇,強調了統一多模態模型的研究仍處于起步階段。本文希望本文的綜述能為推動統一多模態模型研究與創新提供寶貴的資源。

本文轉自AI生成未來 ,作者:AI生成未來