SEED-Bench:基于生成理解的多模態(tài)大語(yǔ)言模型基準(zhǔn)測(cè)試(CVPR2024) 原創(chuàng)

摘要:基于強(qiáng)大的大語(yǔ)言模型(LLMs),最近的生成型多模態(tài)大語(yǔ)言模型(MLLMs)作為一個(gè)重要的研究領(lǐng)域,展示了在理解和生成方面的顯著能力。在這項(xiàng)工作中,我們引入了一個(gè)名為SEED-Bench的基準(zhǔn)測(cè)試,以評(píng)估MLLMs的生成理解能力,作為對(duì)生成模型進(jìn)行全面評(píng)估的初步步驟。SEED-Bench包含19,000道多項(xiàng)選擇題,配有精確的人類標(biāo)注(是現(xiàn)有基準(zhǔn)的6倍),涵蓋了包括圖像和視頻模態(tài)理解在內(nèi)的12個(gè)評(píng)估維度。我們開發(fā)了一個(gè)先進(jìn)的流程,用于生成針對(duì)特定評(píng)估維度的多項(xiàng)選擇題,集成了自動(dòng)過(guò)濾和人工驗(yàn)證過(guò)程。由人類注釋得出的具有真實(shí)選項(xiàng)的多項(xiàng)選擇題,使得模型性能的評(píng)估能夠客觀且高效,無(wú)需在評(píng)估過(guò)程中進(jìn)行人工或GPT干預(yù)。我們進(jìn)一步評(píng)估了18個(gè)模型在所有12個(gè)維度上的表現(xiàn),涵蓋了空間和時(shí)間理解。通過(guò)評(píng)估結(jié)果揭示現(xiàn)有MLLMs的局限性,我們希望SEED-Bench能為未來(lái)的研究提供啟示。我們將推出并持續(xù)維護(hù)一個(gè)排行榜,為社區(qū)提供一個(gè)評(píng)估和研究模型能力的平臺(tái)。

1.引言

近年來(lái),大語(yǔ)言模型(LLMs)在各種開放性任務(wù)中展示了卓越的理解、推理和生成文本的能力。利用LLMs的強(qiáng)大通用性,生成型多模態(tài)大語(yǔ)言模型(MLLMs)在多模態(tài)理解和生成方面展示了增強(qiáng)的能力。然而,目前的MLLMs主要通過(guò)有限數(shù)量的定性示例或使用不適合評(píng)估開放形式輸出的現(xiàn)有基準(zhǔn)來(lái)評(píng)估其性能。例如,在VQAv2中,只有當(dāng)模型的輸出與標(biāo)準(zhǔn)答案完全匹配時(shí),答案才被視為正確,而標(biāo)準(zhǔn)答案通常只有一兩個(gè)詞。缺乏一個(gè)全面客觀的基準(zhǔn)來(lái)評(píng)估MLLMs,這對(duì)比較和研究各種模型的性能構(gòu)成了重大挑戰(zhàn)。

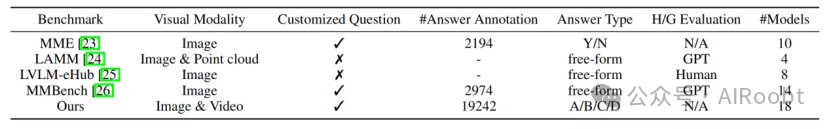

并行研究工作已經(jīng)做出努力,開發(fā)專門評(píng)估MLLMs的基準(zhǔn),如表1所示。例如,LVLM-eHub和LAMM利用各種計(jì)算機(jī)視覺任務(wù)的現(xiàn)有公共數(shù)據(jù)集作為評(píng)估樣本,并使用人類注釋者或GPT來(lái)評(píng)估模型預(yù)測(cè)的質(zhì)量、相關(guān)性和實(shí)用性。然而,在評(píng)估過(guò)程中涉及人類和GPT不僅降低了效率,還導(dǎo)致了評(píng)估的主觀性增加和準(zhǔn)確性降低。MME和MMBench通過(guò)構(gòu)建判斷題或選擇題進(jìn)一步推進(jìn)了MLLMs的客觀評(píng)估,涵蓋了各種能力維度。將模型的輸出限制在判斷題或A/B/C/D選項(xiàng)上,方便了準(zhǔn)確率的計(jì)算,作為評(píng)估的客觀指標(biāo)。然而,這些基準(zhǔn)相對(duì)較小的規(guī)模(少于3K樣本)引入了評(píng)估統(tǒng)計(jì)的不穩(wěn)定性。

表1:現(xiàn)有多模態(tài)大語(yǔ)言模型基準(zhǔn)的比較。“H/G 評(píng)估”表示評(píng)估過(guò)程中是否使用人類或GPT。

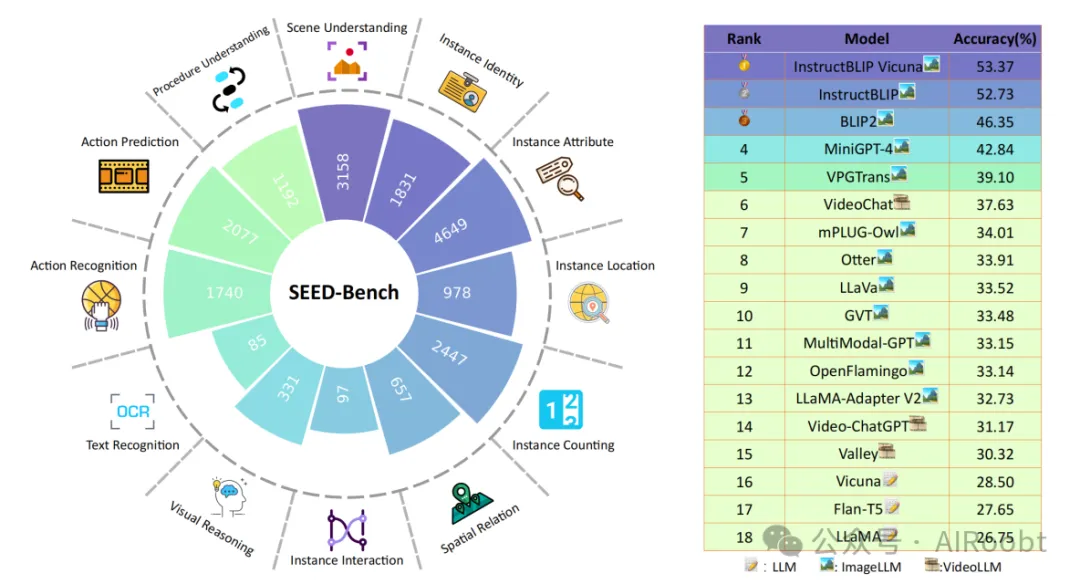

圖1:左圖:SEED-Bench中12個(gè)評(píng)估維度的概述,包括空間和時(shí)間理解,柱狀圖中的數(shù)字表示每個(gè)維度中人類標(biāo)注的多項(xiàng)選擇題的數(shù)量。右圖:顯示18個(gè)模型在12個(gè)評(píng)估維度上的平均準(zhǔn)確率的整體排行榜。

在這項(xiàng)工作中,我們專注于評(píng)估MLLMs的生成理解能力,作為對(duì)生成模型進(jìn)行全面評(píng)估的初步步驟,引入了一個(gè)名為SEED-Bench的基準(zhǔn)測(cè)試。SEED-Bench涵蓋了圖像和視頻模態(tài)的12個(gè)評(píng)估維度。SEED-Bench包含19,000道多項(xiàng)選擇題,標(biāo)準(zhǔn)答案由人類注釋得出(是MME的9倍,MMBench的6倍)。我們?cè)O(shè)計(jì)了一個(gè)復(fù)雜的流程,用于生成針對(duì)特定評(píng)估維度的多項(xiàng)選擇題,并進(jìn)一步結(jié)合自動(dòng)過(guò)濾機(jī)制和人工驗(yàn)證過(guò)程,以確保問(wèn)題的質(zhì)量和標(biāo)準(zhǔn)答案的準(zhǔn)確性。

具體來(lái)說(shuō),對(duì)于圖像,我們利用各種基礎(chǔ)模型提取其視覺信息,包括圖像級(jí)別的描述、實(shí)例級(jí)別的描述和文本元素。對(duì)于視頻,我們利用原始人類注釋提供視覺信息。然后我們將視覺信息輸入ChatGPT/GPT-4,通過(guò)專門設(shè)計(jì)的提示生成針對(duì)特定評(píng)估維度的問(wèn)題以及四個(gè)候選選項(xiàng)和一個(gè)標(biāo)準(zhǔn)答案。我們進(jìn)一步利用多個(gè)LLMs過(guò)濾掉可以在沒有視覺輸入的情況下回答的問(wèn)題。最后,我們雇傭人類注釋者選擇每個(gè)多項(xiàng)選擇題的正確選項(xiàng),并將每個(gè)問(wèn)題分類到一個(gè)評(píng)估維度中,最終得到一個(gè)包含19,000道多項(xiàng)選擇題的清晰且高質(zhì)量的基準(zhǔn)測(cè)試。我們的流程支持跨多個(gè)領(lǐng)域擴(kuò)展評(píng)估數(shù)據(jù),并將繼續(xù)擴(kuò)展基準(zhǔn)測(cè)試以增加更多評(píng)估維度。

基于SEED-Bench,我們?nèi)嬖u(píng)估了包括LLMs、ImageLLMs和VideoLLMs在內(nèi)的18個(gè)模型在所有12個(gè)維度上的表現(xiàn)。不同于MMBench使用ChatGPT將模型的預(yù)測(cè)與多項(xiàng)選擇題中的選項(xiàng)匹配(僅實(shí)現(xiàn)了87.0%的匹配率),我們遵循GPT-3的方法計(jì)算每個(gè)候選選項(xiàng)的對(duì)數(shù)似然值,并選擇最高值作為最終預(yù)測(cè),而不依賴模型的指令遵循能力輸出“A”或“B”或“C”或“D”。通過(guò)分析12個(gè)維度的結(jié)果,我們對(duì)現(xiàn)有多模態(tài)模型在空間和時(shí)間理解能力進(jìn)行了全面比較。我們觀察到大多數(shù)MLLMs在所有12個(gè)評(píng)估維度上仍表現(xiàn)有限,并驚訝地發(fā)現(xiàn)VideoLLMs在時(shí)間理解方面未能實(shí)現(xiàn)與ImageLLMs相競(jìng)爭(zhēng)的表現(xiàn)。通過(guò)評(píng)估結(jié)果,我們希望SEED-Bench能夠?yàn)槲磥?lái)探索更高級(jí)的MLLMs提供啟示。我們將推出一個(gè)評(píng)估平臺(tái)并持續(xù)維護(hù)一個(gè)排行榜,用于評(píng)估和比較模型性能。

2.相關(guān)工作

多模態(tài)大語(yǔ)言模型

隨著大語(yǔ)言模型(LLM)的顯著成功,最近的研究致力于生成型多模態(tài)大語(yǔ)言模型(MLLMs),通過(guò)利用LLMs的強(qiáng)大通用性來(lái)提高多模態(tài)理解和生成能力。一些工作進(jìn)一步考慮視頻輸入,并利用LLMs的巨大能力來(lái)進(jìn)行視頻理解任務(wù)。在SEED-Bench中,我們提供了對(duì)這些模型的全面定量評(píng)估,以徹底評(píng)估和比較它們?cè)谏衫斫夥矫娴谋憩F(xiàn)。

多模態(tài)大語(yǔ)言模型的基準(zhǔn)測(cè)試

隨著多模態(tài)大語(yǔ)言模型(MLLMs)的快速發(fā)展,一些并行工作提出了各種評(píng)估MLLMs的基準(zhǔn)。例如,GVT通過(guò)匯總兩個(gè)語(yǔ)義級(jí)理解任務(wù)(VQA和圖像描述)和兩個(gè)細(xì)粒度任務(wù)(對(duì)象計(jì)數(shù)和多類識(shí)別)來(lái)構(gòu)建基準(zhǔn),但其評(píng)估僅限于視覺理解的有限方面。LVLM-eHub結(jié)合多個(gè)現(xiàn)有的計(jì)算機(jī)視覺基準(zhǔn),并開發(fā)了一個(gè)在線平臺(tái),在該平臺(tái)上兩個(gè)模型被提示回答與圖像相關(guān)的問(wèn)題,并雇用人類注釋者比較模型的預(yù)測(cè)。評(píng)估過(guò)程中涉及人類注釋者不僅引入了偏見,還帶來(lái)了顯著的成本。LAMM通過(guò)使用實(shí)體提取從開放形式的預(yù)測(cè)中獲取關(guān)鍵答案,并利用GPT評(píng)估答案與標(biāo)準(zhǔn)答案的相關(guān)性和準(zhǔn)確性,來(lái)評(píng)估圖像和點(diǎn)云任務(wù)。依賴實(shí)體提取和GPT指標(biāo)可能影響評(píng)估的準(zhǔn)確性和可靠性。MME和MMBench分別通過(guò)構(gòu)建2914道判斷題和2974道多項(xiàng)選擇題,旨在增強(qiáng)MLLMs的客觀評(píng)估。考慮到這些基準(zhǔn)相對(duì)較小的規(guī)模,其評(píng)估結(jié)果可能表現(xiàn)出不穩(wěn)定性。在這項(xiàng)工作中,我們引入了SEED-Bench,以提供對(duì)MLLMs的客觀和全面的評(píng)估,其中包含19K道多項(xiàng)選擇題,涵蓋了包括空間和時(shí)間理解在內(nèi)的12個(gè)評(píng)估維度。

3. SEED-Bench

我們的基準(zhǔn)包含19K道多項(xiàng)選擇題,帶有精確的人類注釋,涵蓋了包括空間和時(shí)間理解在內(nèi)的12個(gè)評(píng)估維度。在本節(jié)中,我們首先在3.1節(jié)中介紹SEED-Bench的評(píng)估維度。在3.2節(jié)中介紹數(shù)據(jù)來(lái)源,并在3.3節(jié)中介紹構(gòu)建多項(xiàng)選擇題的流程。最后,我們?cè)?.4節(jié)描述了MLLMs回答多項(xiàng)選擇題的評(píng)估策略。

3.1 評(píng)估維度

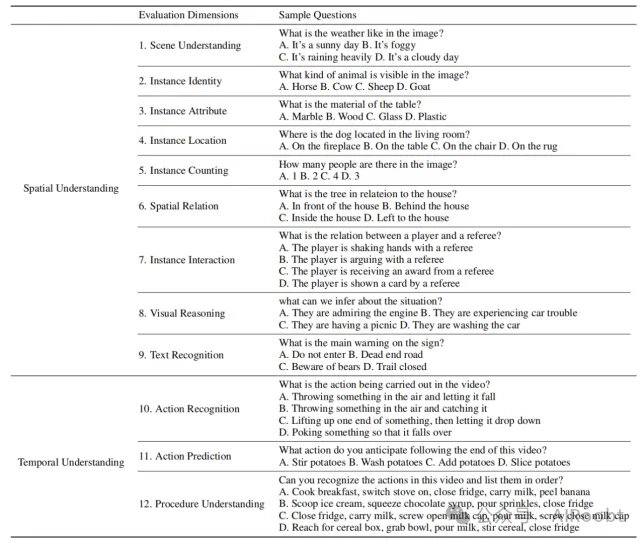

為了全面評(píng)估MLLMs的視覺理解能力,SEED-Bench包括12個(gè)評(píng)估維度,涵蓋空間和時(shí)間理解,如表2所示。

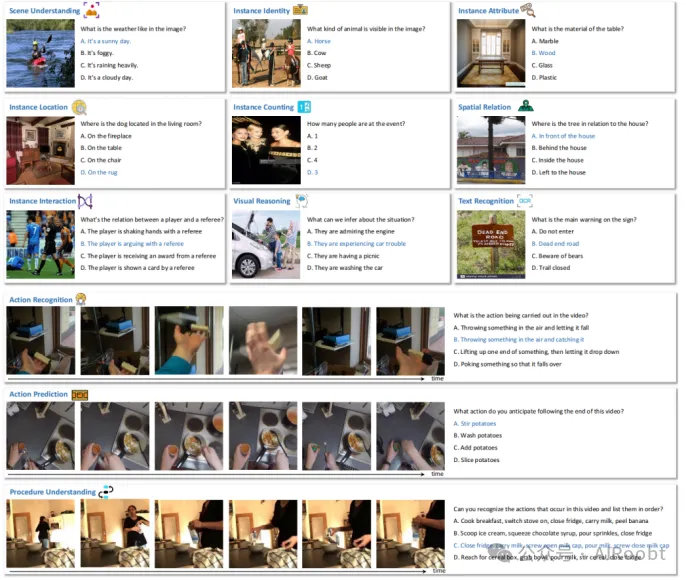

圖2:SEED-Bench的數(shù)據(jù)樣本,涵蓋包括空間和時(shí)間理解在內(nèi)的12個(gè)評(píng)估維度。每個(gè)評(píng)估維度包含由人類注釋得出的多項(xiàng)選擇題及其標(biāo)準(zhǔn)選項(xiàng)。

表2:SEED-Bench的評(píng)估維度,包括空間和時(shí)間理解。我們省略了示例問(wèn)題中的圖像。

空間理解

在空間理解評(píng)估中,我們考慮了9個(gè)維度,涵蓋了圖像級(jí)和實(shí)例級(jí)的感知和推理。

- 場(chǎng)景理解:該維度關(guān)注圖像中的全局信息。通過(guò)整體理解圖像來(lái)回答問(wèn)題。

- 實(shí)例身份:該維度涉及圖像中某個(gè)實(shí)例的識(shí)別,包括某個(gè)對(duì)象的存在或類別。評(píng)估模型的對(duì)象識(shí)別能力。

- 實(shí)例屬性:該維度與實(shí)例的屬性有關(guān),如顏色、形狀或材質(zhì)。評(píng)估模型對(duì)對(duì)象視覺外觀的理解。

- 實(shí)例位置:該維度關(guān)注某個(gè)指定實(shí)例的絕對(duì)位置。要求模型正確定位問(wèn)題中提到的對(duì)象。

- 實(shí)例計(jì)數(shù):該維度要求模型計(jì)算圖像中特定對(duì)象的數(shù)量。這需要模型理解所有對(duì)象,并成功計(jì)算所指對(duì)象的實(shí)例數(shù)量。

- 空間關(guān)系:該維度要求模型識(shí)別圖像中兩個(gè)提到的對(duì)象之間的相對(duì)空間關(guān)系。

- 實(shí)例互動(dòng):該維度要求模型識(shí)別兩個(gè)對(duì)象或人之間的狀態(tài)關(guān)系或互動(dòng)關(guān)系。

- 視覺推理:該維度評(píng)估模型是否能夠基于視覺信息進(jìn)行推理。這需要模型充分理解圖像并利用其常識(shí)知識(shí)來(lái)正確回答問(wèn)題。

- 文本理解:在這個(gè)維度中,模型應(yīng)回答有關(guān)圖像中文本元素的問(wèn)題。

時(shí)間理解

在時(shí)間理解評(píng)估中,我們考慮了3個(gè)維度,側(cè)重于動(dòng)作的識(shí)別、預(yù)測(cè)和過(guò)程理解。

- 動(dòng)作識(shí)別:在該維度中,模型需要識(shí)別視頻中展示的動(dòng)作。評(píng)估的不僅是捕捉時(shí)間動(dòng)態(tài)的能力,還包括對(duì)物理動(dòng)作、人類動(dòng)作和對(duì)象之間動(dòng)態(tài)互動(dòng)的知識(shí)。

- 動(dòng)作預(yù)測(cè):該維度的目標(biāo)是通過(guò)視頻前段預(yù)測(cè)未來(lái)的動(dòng)作,這需要理解視頻的上下文信息和時(shí)間推理。

- 過(guò)程理解:該維度要求模型捕捉所有關(guān)鍵動(dòng)作并對(duì)它們進(jìn)行時(shí)間排序。我們旨在評(píng)估模型的時(shí)間細(xì)粒度理解和過(guò)程推理能力。

3.2 數(shù)據(jù)來(lái)源

為了創(chuàng)建一個(gè)涵蓋各種評(píng)估維度的基準(zhǔn),我們需要收集包含豐富視覺信息的圖像和具有豐富時(shí)間動(dòng)態(tài)的視頻,以便構(gòu)建多樣且具有挑戰(zhàn)性的多項(xiàng)選擇題。在SEED-Bench中,我們使用經(jīng)過(guò)過(guò)濾的CC3M數(shù)據(jù)集來(lái)構(gòu)建空間理解問(wèn)題。具體來(lái)說(shuō),考慮到CC3M原始描述的噪音,我們使用Tag2Text為每張圖像生成描述。我們過(guò)濾掉描述中名詞不超過(guò)5個(gè)的圖像,以確保剩余圖像的信息豐富性,以便構(gòu)建問(wèn)題。

我們進(jìn)一步采用Something-Something-v2(SSV2)、Epic-kitchen 100和Breakfast數(shù)據(jù)集來(lái)構(gòu)建時(shí)間理解問(wèn)題。SSV2是一個(gè)動(dòng)作識(shí)別數(shù)據(jù)集,包括174個(gè)基本動(dòng)作的細(xì)粒度類別,我們從其驗(yàn)證集中采用了1740個(gè)視頻。我們還選擇了Epic-kitchen 100數(shù)據(jù)集中有時(shí)間注釋動(dòng)作標(biāo)簽的138個(gè)長(zhǎng)視頻。此外,Breakfast數(shù)據(jù)集中的視頻和細(xì)粒度動(dòng)作分割注釋用于過(guò)程理解任務(wù)。

3.3 多項(xiàng)選擇題

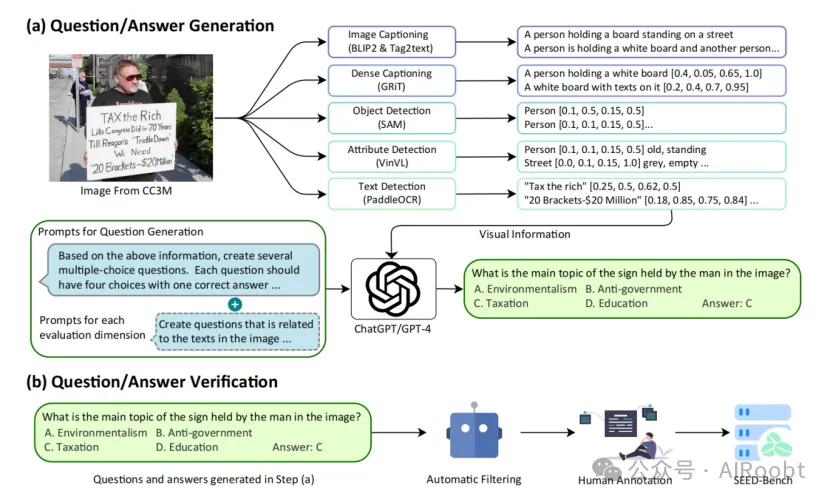

如圖3所示,我們生成多項(xiàng)選擇題的流程包括問(wèn)題/答案生成和驗(yàn)證。為了生成問(wèn)題/答案對(duì),我們首先利用各種基礎(chǔ)模型提取視覺信息,包括圖像級(jí)描述、實(shí)例級(jí)描述和文本元素。基于與特定評(píng)估維度相對(duì)應(yīng)的專門設(shè)計(jì)的提示,ChatGPT/GPT-4隨后生成問(wèn)題和四個(gè)候選選項(xiàng),其中一個(gè)為標(biāo)準(zhǔn)答案。為了驗(yàn)證問(wèn)題/答案對(duì),我們過(guò)濾掉可以通過(guò)多個(gè)LLMs在沒有視覺信息的情況下正確回答的問(wèn)題。我們進(jìn)一步雇傭人類注釋者選擇正確選項(xiàng)并將每個(gè)問(wèn)題分類到一個(gè)評(píng)估維度。

圖3:SEED-Bench生成圖像多項(xiàng)選擇題的流程概述。

(a) 我們首先利用各種基礎(chǔ)模型提取視覺信息,包括圖像級(jí)描述、實(shí)例級(jí)描述和文本元素。基于與特定評(píng)估維度相對(duì)應(yīng)的專門設(shè)計(jì)的提示,ChatGPT/GPT-4隨后生成問(wèn)題和四個(gè)候選選項(xiàng),其中一個(gè)為標(biāo)準(zhǔn)答案。(b) 我們進(jìn)一步利用LLMs篩選問(wèn)題,并雇傭人類注釋者選擇正確選項(xiàng),并將每個(gè)問(wèn)題分類到一個(gè)評(píng)估維度。

視覺信息提取

為了構(gòu)建與空間理解相關(guān)的問(wèn)題,我們使用多種預(yù)訓(xùn)練模型將每張圖像的豐富信息解釋為文本,以便ChatGPT/GPT-4能夠理解圖像并相應(yīng)地創(chuàng)建問(wèn)題。為了構(gòu)建與時(shí)間理解相關(guān)的問(wèn)題,考慮到從視頻中提取可靠的時(shí)間信息(尤其是細(xì)粒度動(dòng)作和長(zhǎng)期時(shí)間上下文)非常困難,我們利用視頻數(shù)據(jù)集的標(biāo)準(zhǔn)注釋。我們將探索如何基于自動(dòng)提取的視頻信息生成問(wèn)題。

圖像的視覺信息提取包括以下部分:

- 圖像描述:圖像描述包含圖像的整體描述。我們使用BLIP2和Tag2Text為每張圖像創(chuàng)建描述。前者為整個(gè)圖像創(chuàng)建描述,而后者基于每個(gè)實(shí)例的描述生成描述。兩個(gè)模型相輔相成,以單個(gè)句子的形式描述圖像內(nèi)容。

- 實(shí)例描述:除了可能忽略圖像中具體細(xì)節(jié)的描述外,我們還使用實(shí)例級(jí)描述從圖像中提取視覺信息,包括對(duì)象檢測(cè)、屬性檢測(cè)和密集描述。具體來(lái)說(shuō),我們使用SAM對(duì)圖像中的每個(gè)實(shí)例進(jìn)行分割,并根據(jù)分割結(jié)果獲取它們的邊界框。對(duì)象標(biāo)簽使用Tag2Text獲得。此外,我們還使用屬性檢測(cè)器獲取圖像中每個(gè)實(shí)例的屬性。最后,我們使用GRiT生成密集描述,使用簡(jiǎn)短句子描述圖像中每個(gè)檢測(cè)到的實(shí)例。這些實(shí)例級(jí)描述對(duì)圖像描述是補(bǔ)充,進(jìn)一步豐富了每張圖像的視覺信息。

- 文本元素:除了對(duì)象,圖像中的文本也包含描述圖像的重要信息。我們使用PaddleOCR檢測(cè)文本元素。

問(wèn)題-答案生成

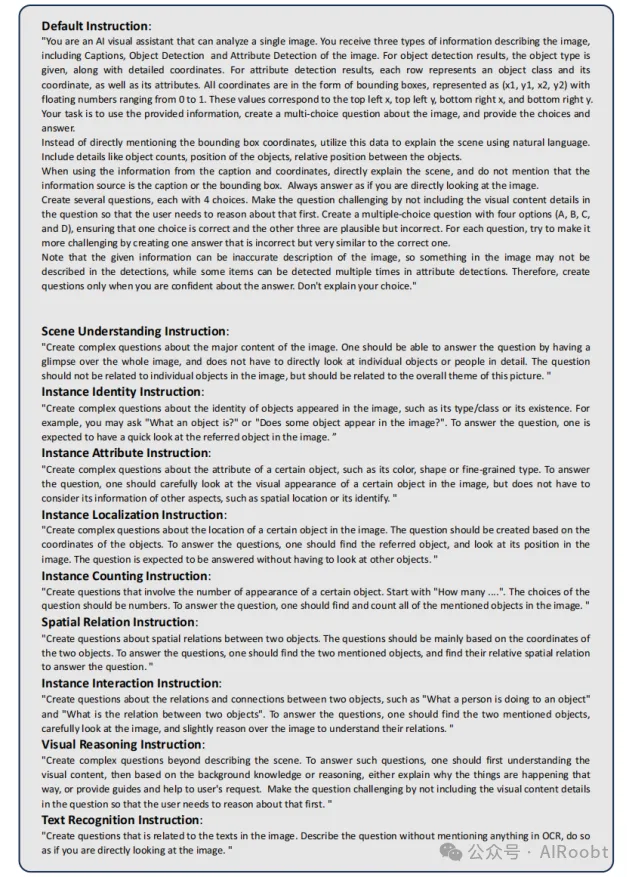

在從圖像和視頻中提取視覺信息后,我們讓ChatGPT/GPT-4基于提取的信息或視頻注釋生成多項(xiàng)選擇題。對(duì)于每個(gè)空間理解評(píng)估,我們仔細(xì)設(shè)計(jì)提示,要求ChatGPT/GPT-4根據(jù)提取的視覺信息創(chuàng)建四個(gè)候選選項(xiàng)的問(wèn)題。我們使用ChatGPT為所有評(píng)估維度創(chuàng)建問(wèn)題,除了推理維度,我們使用GPT-4因?yàn)槠渥吭降耐评砟芰Α?duì)于每個(gè)問(wèn)題,我們要求ChatGPT/GPT-4創(chuàng)建一個(gè)正確選項(xiàng)和三個(gè)干擾選項(xiàng)。我們?cè)噲D通過(guò)使三個(gè)錯(cuò)誤選項(xiàng)與正確選項(xiàng)相似來(lái)使多項(xiàng)選擇題具有挑戰(zhàn)性。生成不同評(píng)估維度多項(xiàng)選擇題的詳細(xì)提示列在圖4中。對(duì)于生成與時(shí)間理解相關(guān)的問(wèn)題,我們使用選定視頻的標(biāo)準(zhǔn)注釋作為

多項(xiàng)選擇題的答案,并雇傭ChatGPT生成三個(gè)干擾選項(xiàng)。

圖4:為不同評(píng)估維度生成多項(xiàng)選擇題的提示語(yǔ)。

(翻譯:

默認(rèn)指令:

“你是一個(gè)AI視覺助手,可以分析單張圖像。你會(huì)收到描述圖像的三種信息,包括圖像的描述、對(duì)象檢測(cè)和屬性檢測(cè)結(jié)果。對(duì)象檢測(cè)結(jié)果中提供了對(duì)象類型及其詳細(xì)坐標(biāo)。屬性檢測(cè)結(jié)果中的每一行代表一個(gè)對(duì)象類別及其坐標(biāo),以及其屬性。所有坐標(biāo)以邊界框的形式表示,格式為(x1, y1, x2, y2),數(shù)值范圍從0到1。這些值分別對(duì)應(yīng)左上角x,左上角y,右下角x,右下角y。你的任務(wù)是使用提供的信息,創(chuàng)建關(guān)于圖像的多項(xiàng)選擇題,并提供選項(xiàng)和答案。

不要直接提到邊界框坐標(biāo),而是利用這些數(shù)據(jù)用自然語(yǔ)言解釋場(chǎng)景。包括對(duì)象數(shù)量、對(duì)象位置、對(duì)象之間的相對(duì)位置等細(xì)節(jié)。

在使用描述和坐標(biāo)信息時(shí),直接解釋場(chǎng)景,不要提及信息來(lái)源是描述或邊界框。始終回答時(shí)要像是你在直接看圖像。

創(chuàng)建多個(gè)問(wèn)題,每個(gè)問(wèn)題有4個(gè)選項(xiàng)。通過(guò)不在問(wèn)題中包含視覺內(nèi)容的細(xì)節(jié)來(lái)使問(wèn)題具有挑戰(zhàn)性,以便用戶首先需要推理這些內(nèi)容。創(chuàng)建一個(gè)有四個(gè)選項(xiàng)(A、B、C和D)的多項(xiàng)選擇題,確保一個(gè)選項(xiàng)是正確的,其他三個(gè)選項(xiàng)是合理但不正確的。對(duì)于每個(gè)問(wèn)題,嘗試通過(guò)創(chuàng)建一個(gè)非常類似于正確答案但錯(cuò)誤的選項(xiàng)來(lái)增加其挑戰(zhàn)性。

請(qǐng)注意,給定的信息可能是不準(zhǔn)確的圖像描述,因此圖像中可能沒有被檢測(cè)描述,而某些項(xiàng)目在屬性檢測(cè)中可能會(huì)被多次檢測(cè)到。因此,僅在你對(duì)答案有信心時(shí)才創(chuàng)建問(wèn)題。不要解釋你的選擇。”

場(chǎng)景理解指令:

“創(chuàng)建關(guān)于圖像主要內(nèi)容的復(fù)雜問(wèn)題。應(yīng)該能夠通過(guò)快速瀏覽整個(gè)圖像回答問(wèn)題,而不必直接仔細(xì)查看單個(gè)對(duì)象或人。問(wèn)題不應(yīng)與圖像中的單個(gè)對(duì)象相關(guān),而應(yīng)與此圖片的整體主題相關(guān)。”

實(shí)例身份指令:

“創(chuàng)建關(guān)于圖像中出現(xiàn)對(duì)象身份的復(fù)雜問(wèn)題,例如其類型/類別或其存在。例如,你可以問(wèn)‘某個(gè)對(duì)象是什么?’或‘某個(gè)對(duì)象是否出現(xiàn)在圖像中?’。回答問(wèn)題時(shí),預(yù)期需要快速查看圖像中提到的對(duì)象。”

實(shí)例屬性指令:

“創(chuàng)建關(guān)于某個(gè)對(duì)象屬性的復(fù)雜問(wèn)題,例如其顏色、形狀或細(xì)粒度類型。回答問(wèn)題時(shí),需要仔細(xì)查看圖像中某個(gè)對(duì)象的視覺外觀,但不必考慮其他方面的信息,如空間位置或其身份。”

實(shí)例定位指令:

“創(chuàng)建關(guān)于圖像中某個(gè)對(duì)象位置的復(fù)雜問(wèn)題。問(wèn)題應(yīng)基于對(duì)象的坐標(biāo)創(chuàng)建。回答問(wèn)題時(shí),需要找到提到的對(duì)象,并查看其在圖像中的位置。預(yù)期在不必查看其他對(duì)象的情況下回答問(wèn)題。”

實(shí)例計(jì)數(shù)指令:

“創(chuàng)建涉及某個(gè)對(duì)象出現(xiàn)次數(shù)的問(wèn)題。以‘有多少....’開頭。問(wèn)題的選項(xiàng)應(yīng)為數(shù)字。回答問(wèn)題時(shí),需要找到并計(jì)數(shù)圖像中提到的所有對(duì)象。”

空間關(guān)系指令:

“創(chuàng)建關(guān)于兩個(gè)對(duì)象之間空間關(guān)系的問(wèn)題。問(wèn)題主要應(yīng)基于兩個(gè)對(duì)象的坐標(biāo)。回答問(wèn)題時(shí),需要找到提到的兩個(gè)對(duì)象,并找到它們的相對(duì)空間關(guān)系來(lái)回答問(wèn)題。”

實(shí)例互動(dòng)指令:

“創(chuàng)建關(guān)于兩個(gè)對(duì)象之間關(guān)系和連接的問(wèn)題,例如‘某人正在對(duì)某個(gè)對(duì)象做什么’和‘兩個(gè)對(duì)象之間的關(guān)系是什么’。回答問(wèn)題時(shí),需要找到提到的兩個(gè)對(duì)象,仔細(xì)查看圖像,并稍微推理圖像以理解它們的關(guān)系。”

視覺推理指令:

“創(chuàng)建超越描述場(chǎng)景的復(fù)雜問(wèn)題。回答此類問(wèn)題時(shí),首先應(yīng)理解視覺內(nèi)容,然后基于背景知識(shí)或推理,解釋為什么事情會(huì)這樣發(fā)生,或?yàn)橛脩舻恼?qǐng)求提供指導(dǎo)和幫助。通過(guò)不在問(wèn)題中包含視覺內(nèi)容的細(xì)節(jié)來(lái)使問(wèn)題具有挑戰(zhàn)性,以便用戶首先需要推理這些內(nèi)容。”

文本識(shí)別指令:

“創(chuàng)建與圖像中的文本相關(guān)的問(wèn)題。描述問(wèn)題時(shí)不要提及OCR中的任何內(nèi)容,而要像直接查看圖像一樣。”)

自動(dòng)過(guò)濾

我們的基準(zhǔn)旨在評(píng)估MLLMs的多模態(tài)視覺語(yǔ)言理解能力。然而,我們發(fā)現(xiàn)一些生成的問(wèn)題可以通過(guò)LLMs在不看圖像的情況下正確回答。我們認(rèn)為這些問(wèn)題對(duì)于評(píng)估MLLMs的視覺理解能力沒有幫助。為此,我們將生成的問(wèn)題(不含圖像)輸入三個(gè)強(qiáng)大的LLMs,包括Vicuna-7B、Flan-T5-XXL和LLaMA-7B,并要求它們回答這些問(wèn)題。我們經(jīng)驗(yàn)發(fā)現(xiàn),5.52%的生成問(wèn)題可以通過(guò)所有三個(gè)LLMs正確回答。我們將這些問(wèn)題從基準(zhǔn)中篩選掉。

人類注釋

為了確保SEED-Bench的準(zhǔn)確性和客觀性,我們進(jìn)一步雇傭人類注釋者驗(yàn)證生成的問(wèn)題/答案對(duì)。人類注釋者被要求為每個(gè)多項(xiàng)選擇題選擇正確答案并將每個(gè)問(wèn)題分類到一個(gè)評(píng)估維度。如果一個(gè)問(wèn)題不能基于視覺輸入回答,或者沒有正確選擇,或者有多個(gè)正確選擇,它將被人類注釋者丟棄。最終得到一個(gè)包含19K道多項(xiàng)選擇題的清晰、高質(zhì)量且分類良好的評(píng)估基準(zhǔn)。每個(gè)評(píng)估維度多項(xiàng)選擇題的數(shù)量統(tǒng)計(jì)如圖1所示。我們可以觀察到文本識(shí)別維度的問(wèn)題最少,有85個(gè)樣本,實(shí)例定位維度的問(wèn)題最多,有4649個(gè)樣本。我們將在未來(lái)保持不同評(píng)估維度多項(xiàng)選擇題的均勻分布。

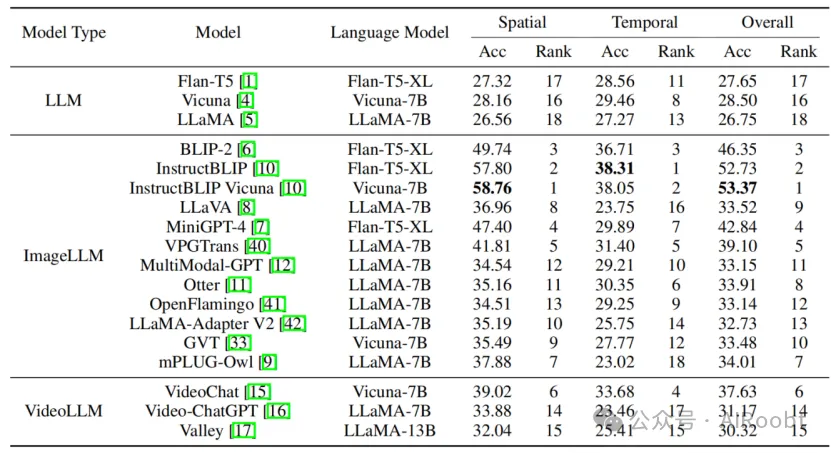

表3:不同模型在SEED-Bench上的評(píng)估結(jié)果,其中“Spatial”顯示了在評(píng)估空間理解的九個(gè)維度上的平均表現(xiàn),“Temporal”顯示了在評(píng)估時(shí)間理解的三個(gè)維度上的平均表現(xiàn)。

3.4 評(píng)估策略

不同于MMBench使用ChatGPT將模型的預(yù)測(cè)與多項(xiàng)選擇題中的選項(xiàng)匹配(僅實(shí)現(xiàn)了87.0%的匹配率),我們采用答案排名策略來(lái)評(píng)估現(xiàn)有的MLLMs與多項(xiàng)選擇題。具體來(lái)說(shuō),對(duì)于每個(gè)問(wèn)題的每個(gè)選擇,我們計(jì)算MLLM生成該選擇內(nèi)容的可能性。我們選擇可能性最高的選項(xiàng)作為模型的預(yù)測(cè)。我們的評(píng)估策略不依賴于模型輸出“A”或“B”或“C”或“D”的指令遵循能力。此外,這種評(píng)估策略消除了多項(xiàng)選擇題選項(xiàng)順序?qū)δP托阅艿挠绊憽?/p>

4 評(píng)估結(jié)果

4.1 模型

基于我們的SEED-Bench,我們?cè)u(píng)估了包括3個(gè)LLMs(即Flan-T5、Vicuna、LLaMA)、12個(gè)ImageLLMs(即OpenFlamingo、BLIP-2、MiniGPT-4、LLaVa、mPLUG-Owl、InstructBLIP、Otter、MultimodalGPT、GVT、PandaGPT、VPGTrans、LLaMA-Adapter V2)和3個(gè)VideoLLMs(即VideoChat、Video-ChatGPT和Valley)在內(nèi)的18個(gè)模型。每個(gè)模型都在包括空間和時(shí)間理解的12個(gè)維度上進(jìn)行了評(píng)估。對(duì)于ImageLLMs,除了評(píng)估其空間理解能力外,我們還旨在調(diào)查其在多個(gè)幀之間進(jìn)行時(shí)間推理的能力。對(duì)于VideoLLMs,我們探討了其在輸入單張圖像時(shí),空間理解能力是否有所退化。

4.2 結(jié)果

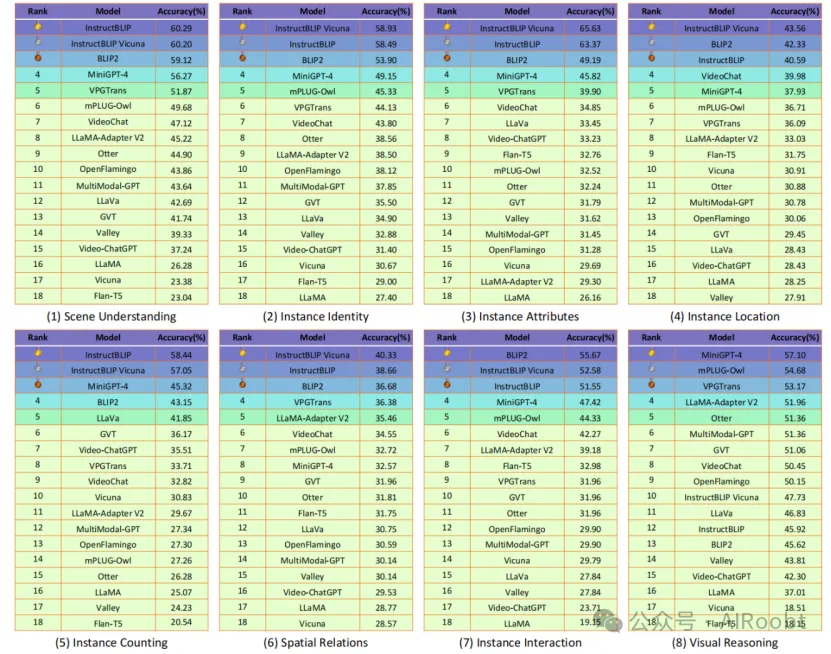

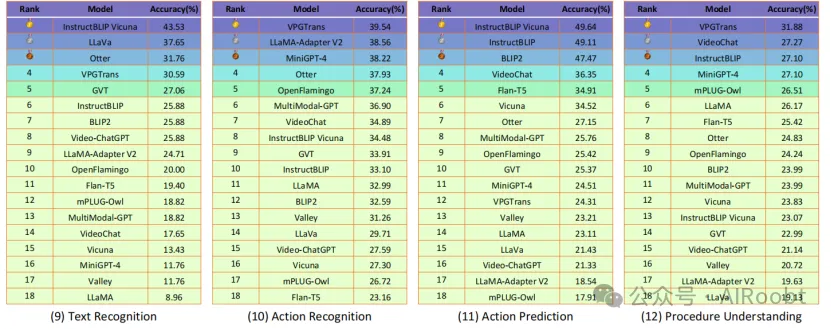

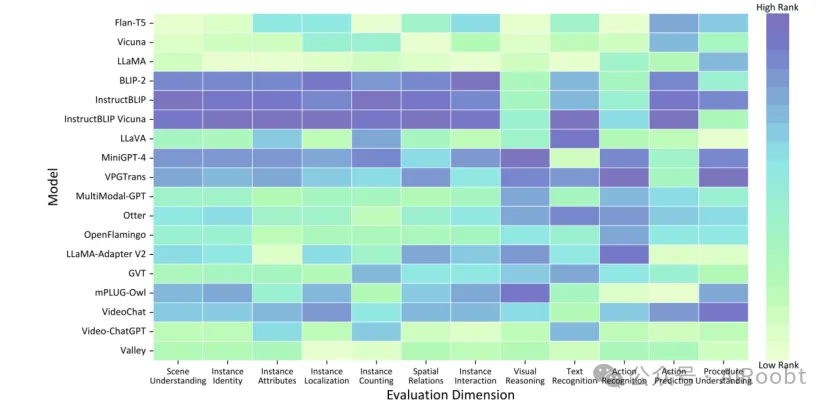

不同模型在SEED-Bench上的評(píng)估結(jié)果列在表1中,其中準(zhǔn)確率指正確回答的多項(xiàng)選擇題相對(duì)于問(wèn)題總數(shù)的比例。我們驚訝地發(fā)現(xiàn),InstructBLIP不僅在評(píng)估空間理解的九個(gè)維度的平均結(jié)果中取得了最佳表現(xiàn),而且在評(píng)估時(shí)間理解的三個(gè)維度的平均結(jié)果中也超過(guò)了VideoLLMs。我們?cè)趫D5中展示了SEED-Bench上各種評(píng)估維度的排行榜,以提供對(duì)不同模型的全面評(píng)估。基于所有評(píng)估維度平均結(jié)果的總體排行榜顯示在圖1中。為了更好地展示模型在不同評(píng)估維度中的能力,我們進(jìn)一步在圖6中可視化了每個(gè)模型在每個(gè)評(píng)估維度中的排名,其中顏色越深表示排名越高。我們可以觀察到,BLIP系列模型在多個(gè)評(píng)估維度中取得了競(jìng)爭(zhēng)性結(jié)果,但在視覺推理和動(dòng)作識(shí)別方面表現(xiàn)不佳。VideoLLM Valley在大多數(shù)評(píng)估維度中表現(xiàn)次優(yōu)。LLaVa在文本識(shí)別評(píng)估中表現(xiàn)出與其他評(píng)估維度相比無(wú)與倫比的能力。就具體評(píng)估維度而言,MiniGPT-4和mPLUG-Owl模型在視覺推理方面表現(xiàn)更好,而VPGTrans模型在動(dòng)作識(shí)別和過(guò)程理解方面表現(xiàn)出色。LLaMA Adapter V2模型在動(dòng)作識(shí)別方面表現(xiàn)更加熟練。此外,Multimodal GPT、Otter、Openflamingo、GVT和三種VideoLLMs在各種評(píng)估維度中表現(xiàn)均衡。

圖5:SEED-Bench上不同評(píng)估維度的排行榜。

圖6:各模型在不同評(píng)估維度中的表現(xiàn)示意圖,其中顏色越深表示排名越高。

4.3 分析

通過(guò)對(duì)各種模型在SEED-Bench上的全面和客觀評(píng)估,我們觀察到了一些可以為未來(lái)工作帶來(lái)啟示的發(fā)現(xiàn)。

大多數(shù)MLLMs在所有12個(gè)評(píng)估維度上的表現(xiàn)仍然有限。如圖1和圖5所示,除BLIP系列模型外,大多數(shù)MLLMs在平均表現(xiàn)和超過(guò)三個(gè)單一評(píng)估維度上的表現(xiàn)均未達(dá)到50%的準(zhǔn)確率。在某些特定的評(píng)估維度(例如視覺推理)中,大多數(shù)MLLMs似乎取得了較高的準(zhǔn)確率。然而,當(dāng)將MLLMs的表現(xiàn)與LLMs進(jìn)行比較時(shí),我們發(fā)現(xiàn)大多數(shù)MLLMs的性能提升仍然相對(duì)有限。

MLLMs在全局圖像理解上表現(xiàn)相對(duì)較高。在場(chǎng)景理解和視覺推理的評(píng)估中,大多數(shù)MLLMs的準(zhǔn)確率超過(guò)40%,且所有MLLMs的表現(xiàn)均優(yōu)于LLMs。這表明,MLLMs在圖像的全局理解和推理方面比在其他需要細(xì)粒度實(shí)例級(jí)理解的評(píng)估維度上更為熟練。

InstructBLIP在12個(gè)評(píng)估維度中的8個(gè)維度上表現(xiàn)最佳。我們觀察到,InstructBLIP在8個(gè)評(píng)估維度上超過(guò)了其他模型,可能的解釋如下:(a) InstructBLIP的指令調(diào)整數(shù)據(jù)包含總計(jì)1600萬(wàn)樣本(比其他指令調(diào)整數(shù)據(jù)集更大),涵蓋了廣泛的多模態(tài)任務(wù),甚至包括OCR和時(shí)間視覺推理的QA數(shù)據(jù)。(b) 在執(zhí)行InstructBLIP的指令調(diào)整時(shí),LLMs的權(quán)重被凍結(jié),這可能緩解了災(zāi)難性遺忘。然而,InstructBLIP系列模型在動(dòng)作識(shí)別和過(guò)程理解方面表現(xiàn)仍然較差,這與指令調(diào)整數(shù)據(jù)顯著不同。例如,在需要理解細(xì)粒度動(dòng)作的Something-Something-v2上的動(dòng)作識(shí)別方面,InstructBLIP系列模型的性能提升相比LLMs并不顯著(低于2%)。這表明InstructBLIP系列模型可能在分布外數(shù)據(jù)上的泛化能力較差。

MLLMs在理解對(duì)象間的空間關(guān)系方面表現(xiàn)較弱。排名最高的InstructBLIP在空間關(guān)系評(píng)估中的準(zhǔn)確率僅為40%,這表明識(shí)別實(shí)例之間的相對(duì)空間關(guān)系是具有挑戰(zhàn)性的,因?yàn)榭赡艽嬖诙喾N空間關(guān)系的排列和組合。此外,某些情況下對(duì)象之間的空間關(guān)系可能會(huì)引起歧義,使得確定它們的關(guān)系變得困難。

大多數(shù)MLLMs在文本識(shí)別方面表現(xiàn)不佳。除了InstructBLIP,所有其他模型在文本識(shí)別方面的準(zhǔn)確率均低于40%,這主要是由于多模態(tài)預(yù)訓(xùn)練數(shù)據(jù)集中缺乏文本元素。由于準(zhǔn)確識(shí)別和提取圖像中的文本能力非常重要,未來(lái)的工作應(yīng)開發(fā)更好地處理文本識(shí)別的模型,通過(guò)在包含豐富文本元素的視覺數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練。

VideoLLMs在空間理解方面取得了令人鼓舞的結(jié)果。例如,VideoChat在實(shí)例定位中的準(zhǔn)確率為39.98%(排名第4),超過(guò)了LLaVa 11.55%,且僅比排名第一的模型低3.58%。這表明,VideoChat在預(yù)訓(xùn)練和指令調(diào)整階段聯(lián)合訓(xùn)練圖像和視頻數(shù)據(jù)時(shí),其空間理解能力沒有退化。

大多數(shù)MLLMs在細(xì)粒度時(shí)間理解方面表現(xiàn)不佳。值得注意的是,在過(guò)程理解的評(píng)估中,排名最高的模型VPGTrans的準(zhǔn)確率僅比LLaMA高出5%。接下來(lái)的4個(gè)MLLMs的性能提升相比LLaMA甚至低于1.2%。這表明,ImageLLMs和VideoLLMs在執(zhí)行細(xì)粒度時(shí)間推理以識(shí)別和排序視頻中的關(guān)鍵動(dòng)作方面都非常困難。

VideoLLMs在時(shí)間理解方面未能實(shí)現(xiàn)競(jìng)爭(zhēng)力的表現(xiàn)。盡管VideoLLMs在視頻數(shù)據(jù)上進(jìn)行了指令調(diào)整,但在時(shí)間理解的評(píng)估維度上并未表現(xiàn)出顯著優(yōu)勢(shì)。令人驚訝的是,兩種VideoLLMs(Video-ChatGPT和Valley)在動(dòng)作識(shí)別、動(dòng)作預(yù)測(cè)和過(guò)程理解方面的表現(xiàn)甚至低于大多數(shù)ImageLLMs。這表明現(xiàn)有VideoLLMs在細(xì)粒度動(dòng)作識(shí)別、時(shí)間關(guān)系理解和時(shí)間推理方面的能力仍然有限。最近的研究工作也提出了對(duì)現(xiàn)有VideoLLMs的類似擔(dān)憂。

5.結(jié)論

在這項(xiàng)工作中,我們提出了一個(gè)大規(guī)模基準(zhǔn)SEED-Bench,以對(duì)多模態(tài)大語(yǔ)言模型(MLLMs)的生成理解進(jìn)行全面和客觀的評(píng)估。SEED-Bench包含19K道帶有精確人類注釋的多項(xiàng)選擇題,涵蓋了包括空間和時(shí)間理解在內(nèi)的12個(gè)評(píng)估維度。我們?cè)O(shè)計(jì)了一個(gè)先進(jìn)的流程來(lái)創(chuàng)建針對(duì)特定評(píng)估維度的多項(xiàng)選擇題,促進(jìn)了跨各種領(lǐng)域的評(píng)估數(shù)據(jù)的可擴(kuò)展性。我們還整合了自動(dòng)過(guò)濾和人工驗(yàn)證,以提高生成問(wèn)題和答案的質(zhì)量。我們對(duì)18個(gè)模型進(jìn)行了全面評(píng)估,分析和比較了它們的表現(xiàn),為未來(lái)的研究提供了見解。我們計(jì)劃推出并持續(xù)維護(hù)一個(gè)排行榜,為社區(qū)提供評(píng)估模型性能的平臺(tái)。我們將繼續(xù)通過(guò)更多數(shù)據(jù)進(jìn)一步拓寬SEED-Bench的評(píng)估維度。

Li B, Wang R, Wang G, et al. Seed-bench: Benchmarking multimodal llms with generative comprehension[J]. arXiv preprint arXiv:2307.16125, 2023.

1Tencent AI Lab

2ARC Lab, Tencent PCG

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:AIRoobt