Scaling laws在視覺自回歸模型上失效了?谷歌聯合MIT發布Fluid:文生圖質量刷新紀錄! 精華

文章鏈接:https://arxiv.org/pdf/2410.13863

縮放法則(Scaling laws)是大語言模型(LLMs)前所未有成功的基礎。實證研究表明,在自回歸模型中增加參數數量通常會顯著提升性能,并在自然語言處理(NLP)任務中產生新的能力。這一實證關系激勵了眾多擴展語言模型的努力,導致許多高性能模型的發展。受到這一成功的鼓舞,許多嘗試將自回歸模型應用并擴展到計算機視覺領域,特別是在文本到圖像生成等生成任務中。然而,這些模型生成的內容在性能和視覺質量上往往不及其他生成模型,如擴散模型,使得在視覺領域是否適用類似的縮放法則仍不清楚。

本文提出了幾個關于性能差距的假設。

- 首先,大多數視覺自回歸模型所需的矢量量化(VQ)步驟可能會引入顯著的信息損失,最終限制模型的性能。

- 其次,與語言的固有順序性質不同,生成視覺內容可能更需要不同的自回歸預測順序。

- 第三,在評估視覺模型的縮放法則時,通常會在兩個層次的泛化能力之間產生混淆:(a) 使用與訓練損失相同的指標(通常稱為驗證損失)對新數據的泛化,和 (b) 對不同于訓練目標的新指標或問題的泛化,例如FID、GenEval基準或視覺質量。我們假設,冪律縮放適用于自回歸模型在視覺數據上的(a)情況,但不一定適用于(b)情況。

為了研究這些假設,對文本到圖像生成背景下自回歸模型的縮放行為進行了全面的實證研究。并基于研究提出了一個新的模型——Fluid,先來看看效果如何。

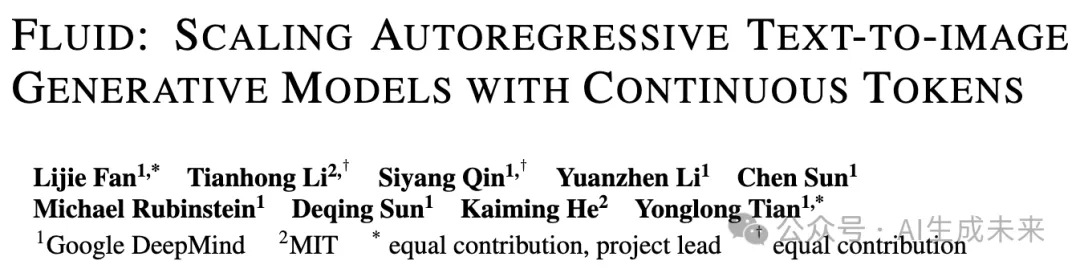

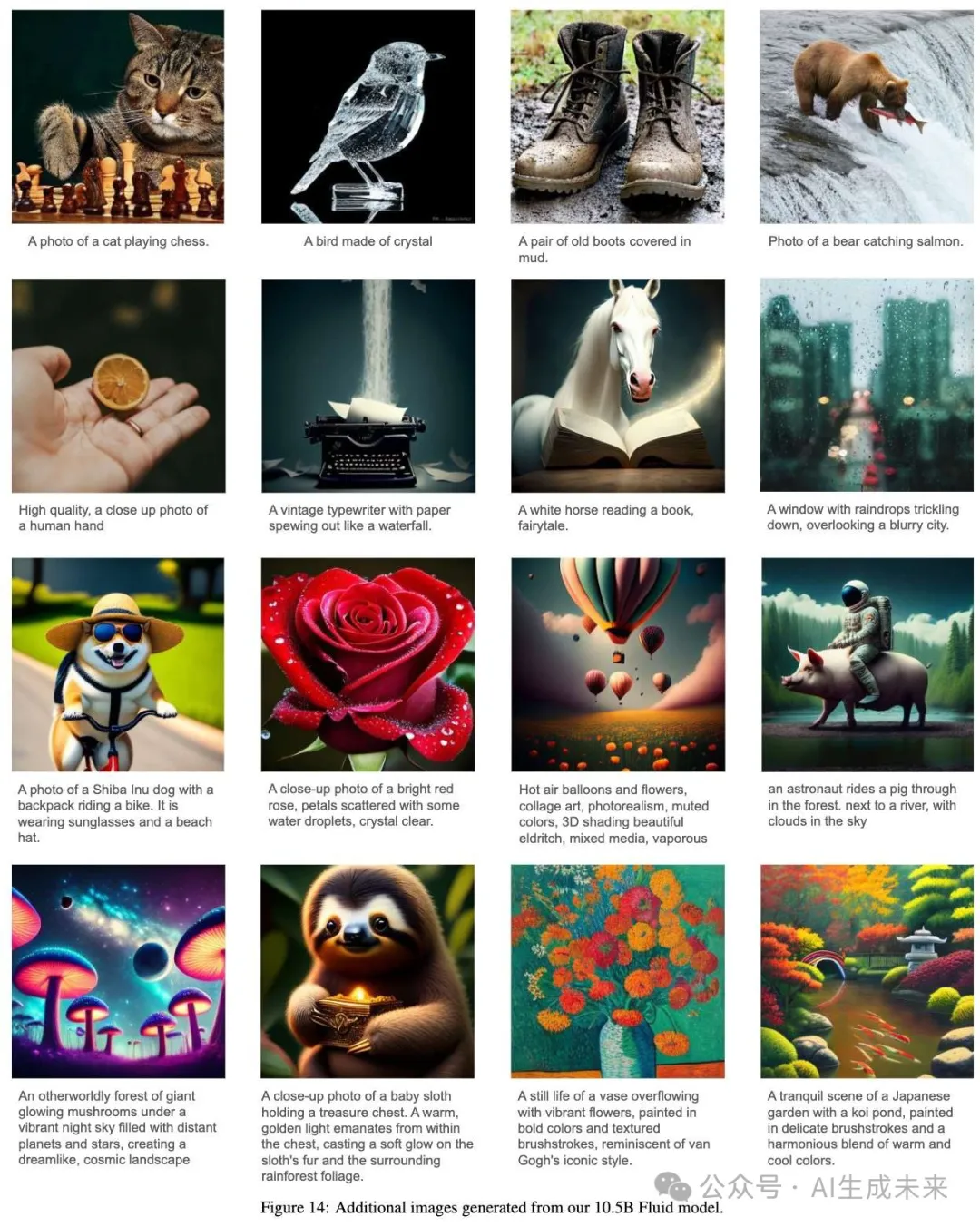

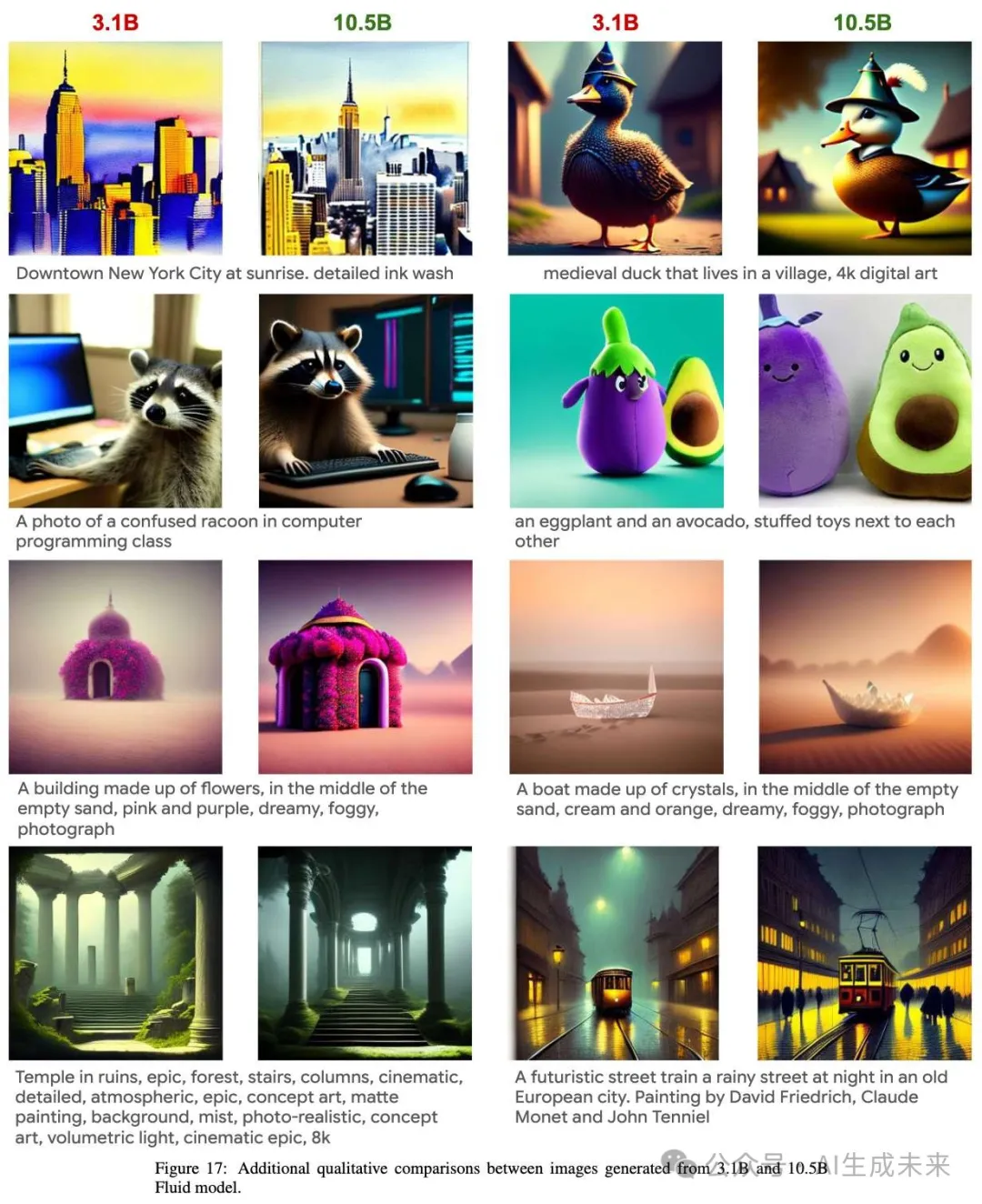

效果展示

總結速覽

解決的問題:本文探討了在視覺領域,特別是文本生成圖像任務中,擴大自回歸模型并不像在大語言模型中那樣有益的現象。具體關注了以下兩個關鍵問題:

- 模型使用離散還是連續的token。

- 模型在生成token時,使用隨機順序還是固定順序(基于BERT或GPT的Transformer架構)。

提出的方案:

- 通過實驗對比不同模型,研究模型在使用離散或連續token,以及在隨機順序或光柵順序生成時的表現。

- 基于實驗結果,提出了一種新的模型——Fluid,該模型使用隨機順序的自回歸生成方式,并基于連續token進行訓練。

應用的技術:

- 使用BERT和GPT類型的Transformer架構,結合離散和連續token的生成。

- 通過FID(Fréchet Inception Distance)、GenEval評分,以及視覺質量來評估模型性能。

- 在新提出的Fluid模型中采用隨機順序的自回歸生成方式,并利用連續token進行訓練。

達到的效果:

- 使用連續token的模型在視覺質量上顯著優于使用離散token的模型。

- 隨機順序的模型在GenEval評分上優于光柵順序的模型。

- Fluid 10.5B 模型在MS-COCO 30K數據集上實現了新的零樣本生成的FID紀錄,并在GenEval基準上獲得了 0.69 的綜合評分,達到當前最佳表現。

實現

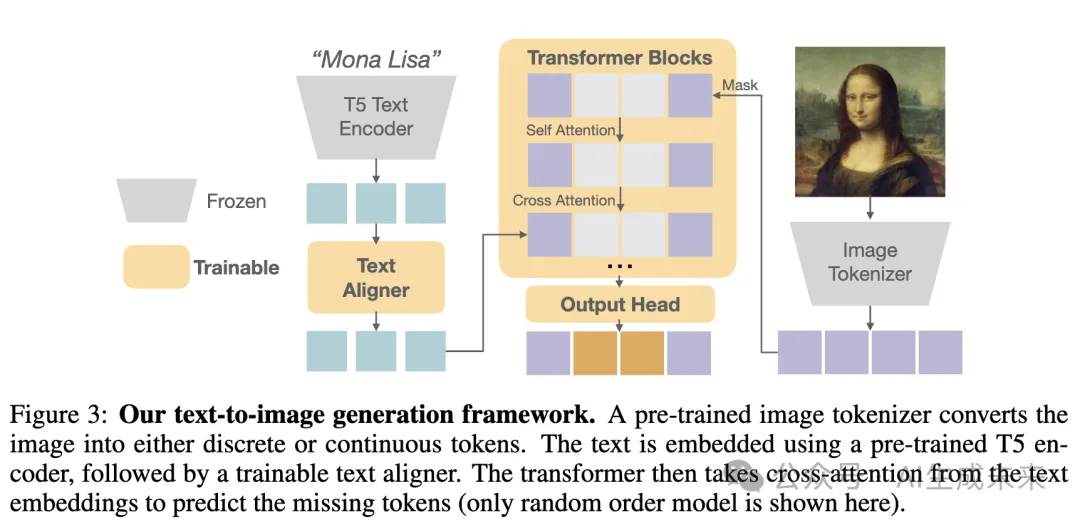

本文的文本生成圖像模型訓練的整體框架非常簡單。首先,圖像分詞器將原始圖像轉換為tokens。然后,這些tokens被部分masked,接著訓練一個Transformer模型,在文本的條件下重建被masked的tokens。下圖3詳細描述框架中的每個組件。

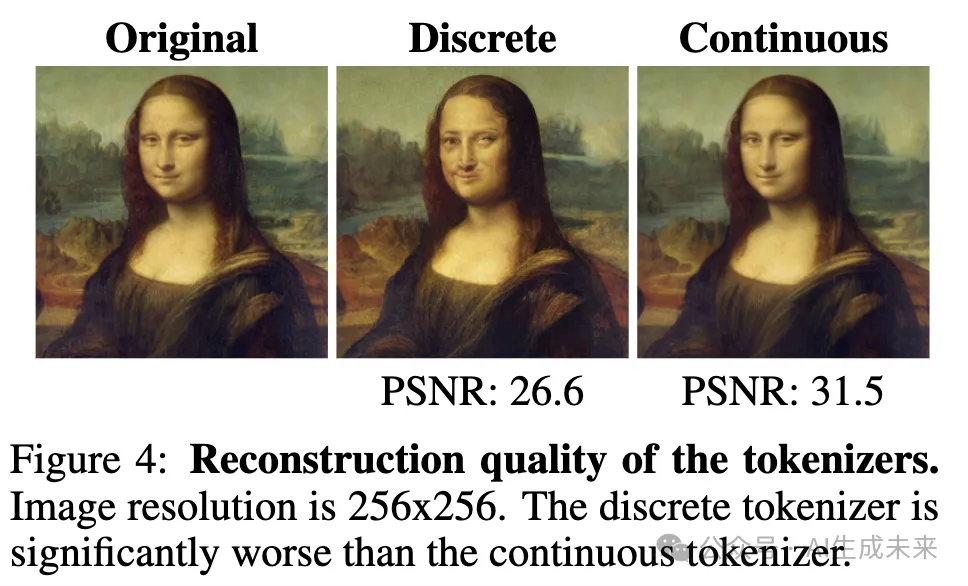

圖像分詞器:使用一個預訓練的圖像分詞器將256×256的圖像編碼為token空間。該分詞器可以是離散的或連續的,以便為自回歸模型實現不同的訓練目標。實驗中,離散分詞器是一個預訓練于WebLI數據集的VQGAN模型。Muse的方法,將每張圖像編碼為16×16的離散tokens,詞匯表大小為8192。對于連續分詞器采用了Stable Diffusion模型,該模型將圖像編碼為32×32的連續tokens,每個token包含4個通道。為了與離散分詞器在序列長度上一致,將每2×2塊的連續tokens分組為一個token,最終序列長度為256,每個token包含16個通道。如下圖4所示,連續分詞器在重建質量上明顯優于離散分詞器。

文本編碼器:原始文本(最大長度128)通過SentencePiece進行分詞,并通過預訓練的T5-XXL編碼器進行嵌入,該編碼器有47億個參數并在訓練期間被凍結。為了進一步對齊用于圖像生成的文本embeddings,在T5嵌入的基礎上添加了一個由六個可訓練的Transformer模塊組成的小型文本對齊器,來提取最終的文本表示。

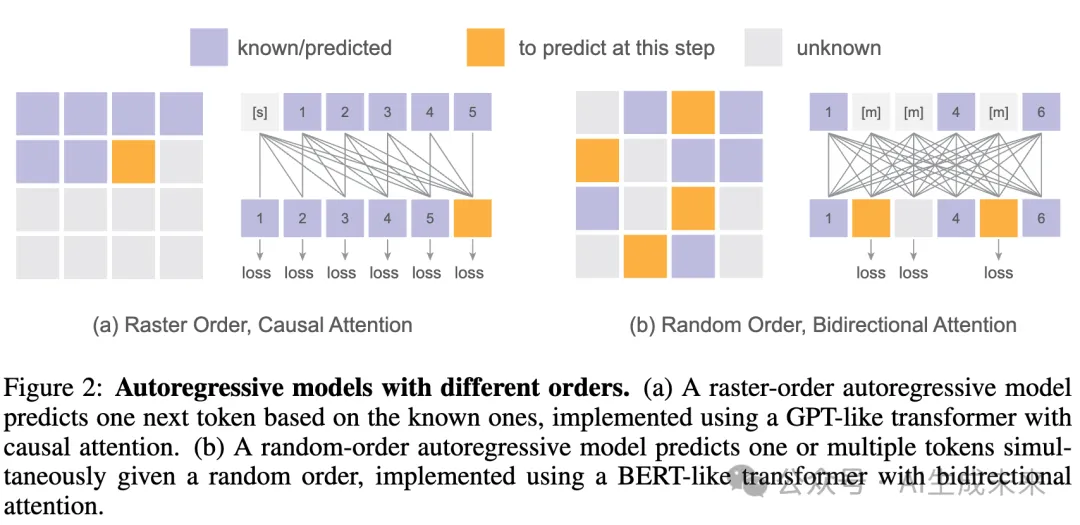

Transformer:在將原始圖像編碼為tokens序列后,使用一個標準的僅解碼Transformer模型進行自回歸生成。每個塊由三個連續的層組成——自注意力、交叉注意力和MLP層。自注意力和MLP層僅應用于視覺tokens,而交叉注意力層則將視覺和文本tokens分別作為查詢和鍵。如下圖2所示,對于光柵順序模型,Transformer使用自注意力塊中的因果注意力基于先前的tokens預測下一個token,類似于GPT。在隨機順序模型中,未知的tokens由一個可學習的token masked,Transformer使用雙向注意力來預測這些被masked的tokens,類似于BERT。

輸出頭:對于離散tokens,遵循自回歸模型的常見做法。輸出通過一個線性層后,使用softmax轉換為類別分布,這個線性層的權重與輸入embedding層的權重共享。對于連續tokens,應用一個六層輕量級的MLP作為擴散頭來建模每個token的分布。該擴散頭的嵌入維度與主干transformer相同。每個token的擴散過程遵循。噪聲調度為余弦形狀,訓練時為1000步;在推理時,重新采樣為100步。

實驗

數據集:使用WebLI(Web Language Image)數據集的一個子集作為訓練集,該數據集由網絡上的圖像-文本對組成,并且這些對在圖像質量和alt文本相關性上都有高分。默認情況下,圖像進行中心裁剪并調整大小為256×256。

推理:遵循Imagen、Muse和Parti的做法,根據文本提示生成圖像,不進行拒絕采樣。對于隨機順序模型,使用64步生成并按照余弦調度。為了進一步增強生成性能,應用了溫度和無分類器引導,這是常見的做法。

評估:對不同的自回歸模型變體的擴展行為進行了定量和定性評估。定量評估包括在MS-COCO 2014訓練集中的30K圖像上計算驗證損失,以及兩個廣泛采用的指標:MS-COCO上的零樣本Frechet Inception Distance(FID)和GenEval分數。推理的超參數,如溫度和無分類器引導,針對每個評估指標進行優化。FID是在MS-COCO 2014訓練集中的30K隨機選取的圖像-文本對上計算的,用于評估生成圖像的保真度和多樣性。GenEval基準則衡量模型生成準確反映給定提示的圖像的能力。對于定性評估,從幾個提示中生成圖像,并比較生成圖像的視覺質量。

擴展行為

研究者們探索了自回歸圖像生成模型中的兩個關鍵設計選擇——token表示和生成順序——如何影響性能和擴展行為。構建了具有這兩種設計選擇不同組合的模型,產生了四種不同的自回歸圖像生成模型變體。還探討了這些模型在不同數據和評估指標上的泛化能力。本文的實驗揭示了幾個有趣的特性。

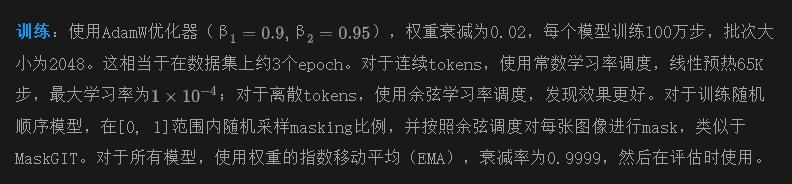

驗證損失隨模型規模線性擴展。在下圖5中,研究者們考察了四種自回歸變體在驗證損失方面的擴展行為。驗證損失和模型規模在對數空間中呈現線性關系,模型規模從1.5億參數增加到30億參數。這與Henighan等人發現的冪律規律相一致。這表明,增加模型規模所帶來的訓練損失改進能夠很好地泛化到與訓練數據不同的驗證數據上。

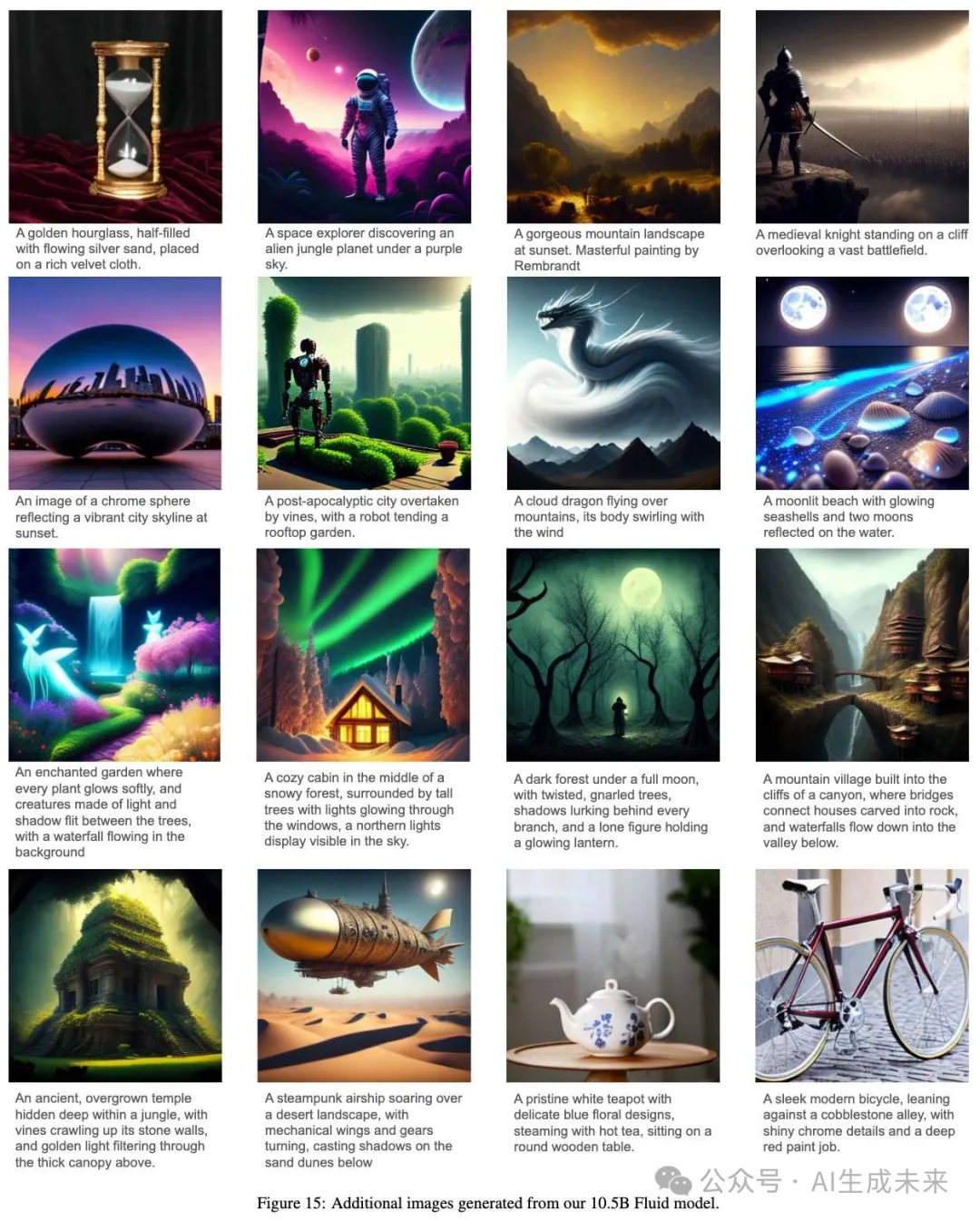

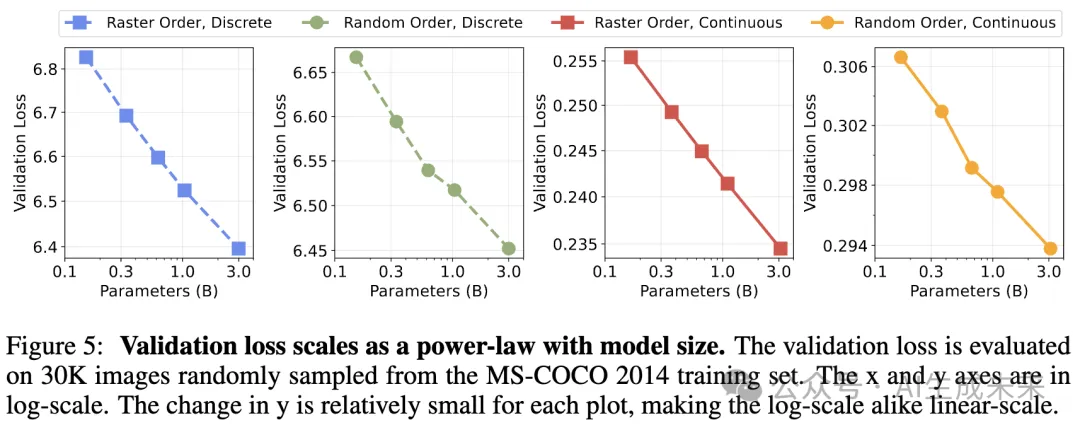

使用連續tokens的隨機順序模型在評估分數上的擴展表現最佳。下圖6中分析了四種自回歸變體在FID和GenEval總體分數方面的擴展行為。驗證損失的改進并不總是線性地轉化為更好的評估指標,這意味著這些指標與模型規模之間沒有嚴格的冪律關系。例如,使用離散tokens的光柵順序模型(藍線)在約10億參數時FID和GenEval分數趨于平穩。在四種變體中,使用連續tokens的隨機順序模型(即Fluid)在評估指標上顯示出一致的改進,參數規模擴展至30億,表現最佳。

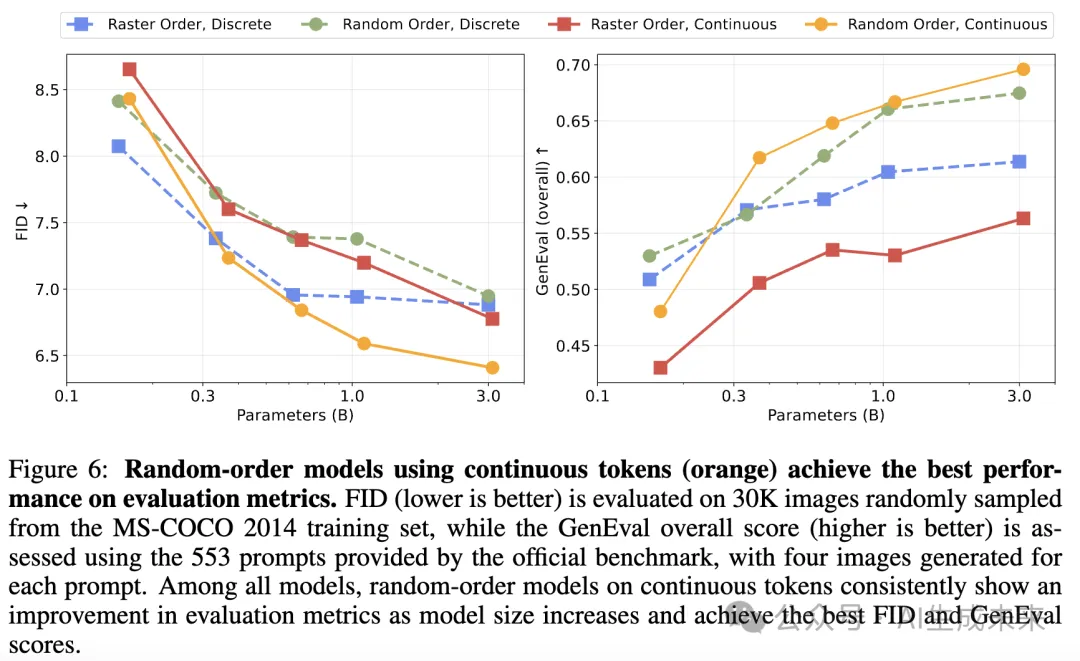

隨機順序模型的連續token隨訓練計算量擴展。下圖7中繪制了不同大小的Fluid模型在總訓練步數和計算量上的驗證損失、FID和GenEval分數。隨著訓練步數和計算量的增加,驗證損失和評估性能都表現出持續改進。然而,訓練步數的收益在大約1M步時趨于飽和,這表明相比于訓練較小模型更長時間,訓練較大模型更少的步數在計算上更加高效。這一行為與語言模型中的觀察結果一致,突顯了在足夠的訓練條件下擴展模型大小的潛力。

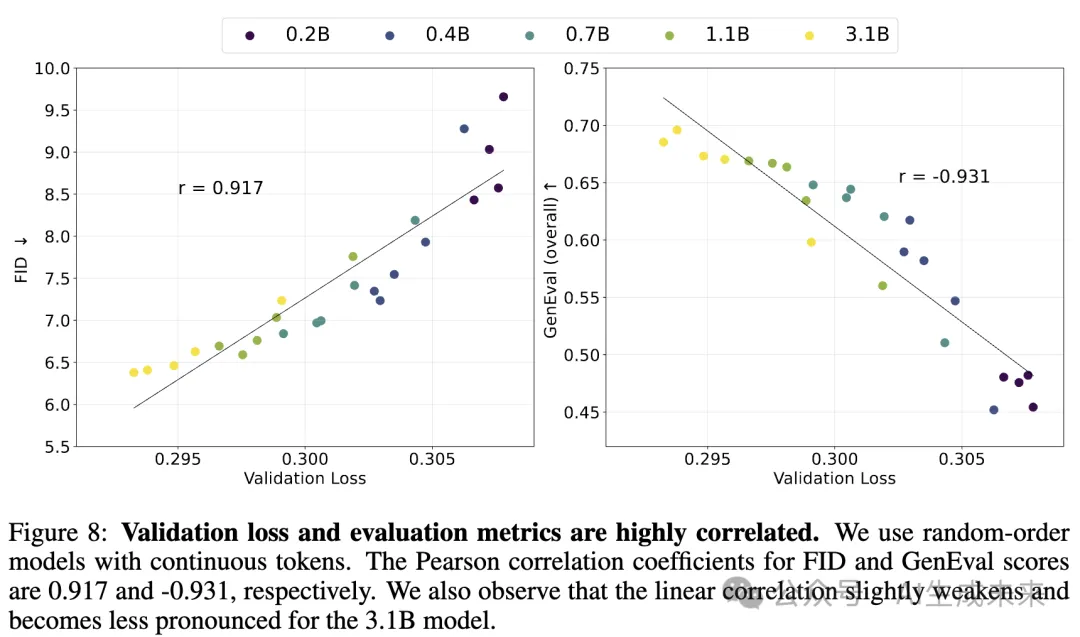

驗證損失和評估指標之間的強相關性。下圖8繪制了不同大小的Fluid模型的FID和GenEval分數與驗證損失的關系,并觀察到兩者之間存在強相關性。為了量化這一關系,使用線性回歸擬合了數據點。FID和GenEval分數的皮爾遜相關系數分別為0.917和-0.931,表明在150M到3B的模型規模范圍內,驗證損失與這些評估指標之間存在近乎線性的關系。訓練了一個擁有10.5B參數、批次大小為4096的模型,并訓練1M步,取得了最先進的文本生成圖像性能。

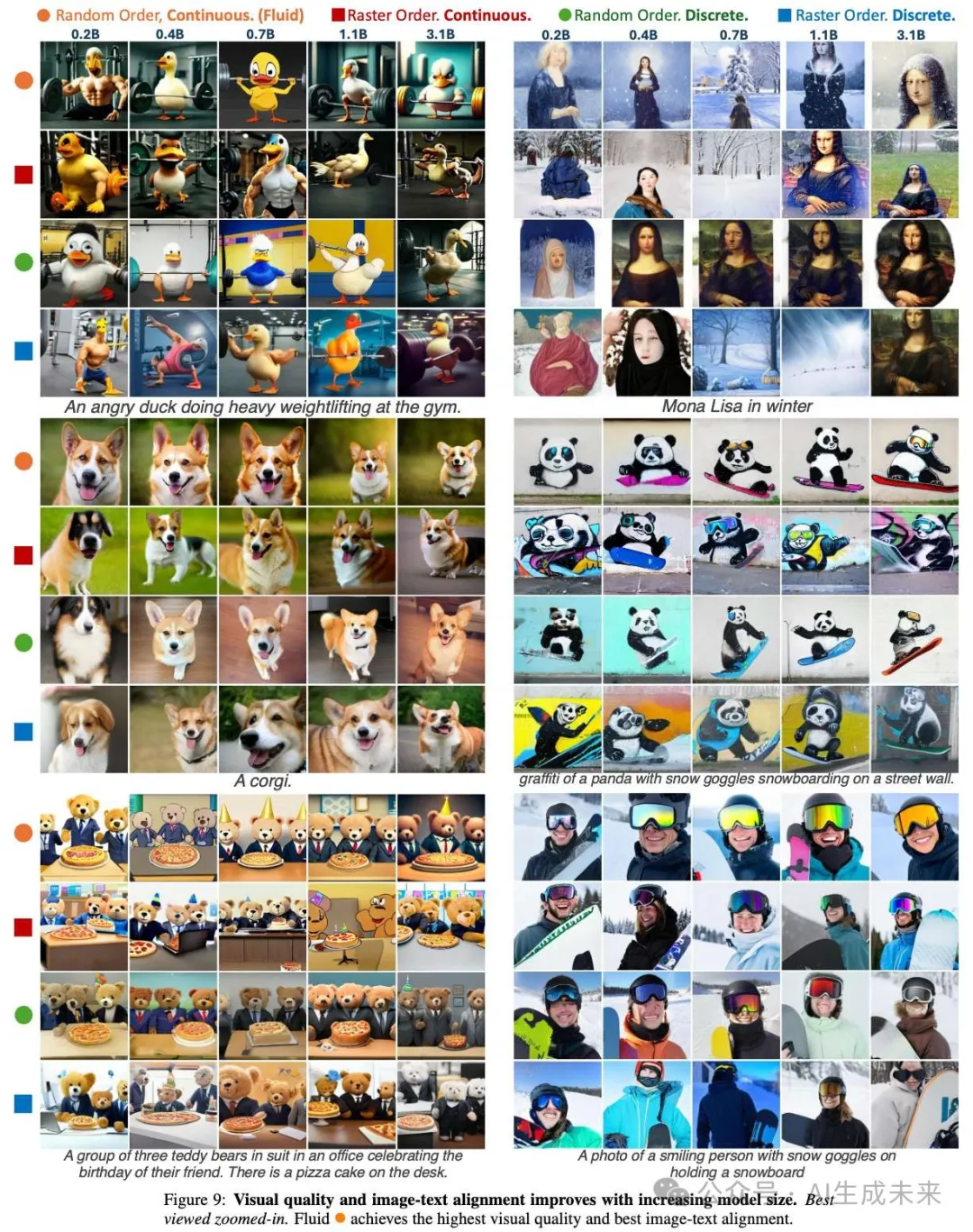

連續token和大模型對視覺質量至關重要。下圖9比較了四種自回歸變體生成的圖像的視覺質量。使用離散token的模型生成的圖像質量明顯不如使用連續token的模型。例如,離散token模型生成的柯基犬的眼睛是不對稱的,擴大模型規模無法解決這個問題。這個局限性主要是由于離散tokenizer引入了大量信息丟失。例如,即使擁有3B參數,使用離散token的模型也無法生成精確的《蒙娜麗莎》,這是因為tokenizer的重構質量較差(見前面圖4)。相比之下,使用連續token的模型能夠生成質量更高的圖像。

此外,較大的模型在視覺質量和圖像-文本對齊方面表現出持續改進。例如,一個擁有0.2B參數的隨機順序模型難以生成“一個憤怒的鴨子在健身房舉重”,而擁有3B參數的相同模型則可以成功生成對應的圖像。這表明,處理連續token并增加模型規模對于在自回歸圖像生成模型中實現高質量視覺效果至關重要。

與之前系統的對比

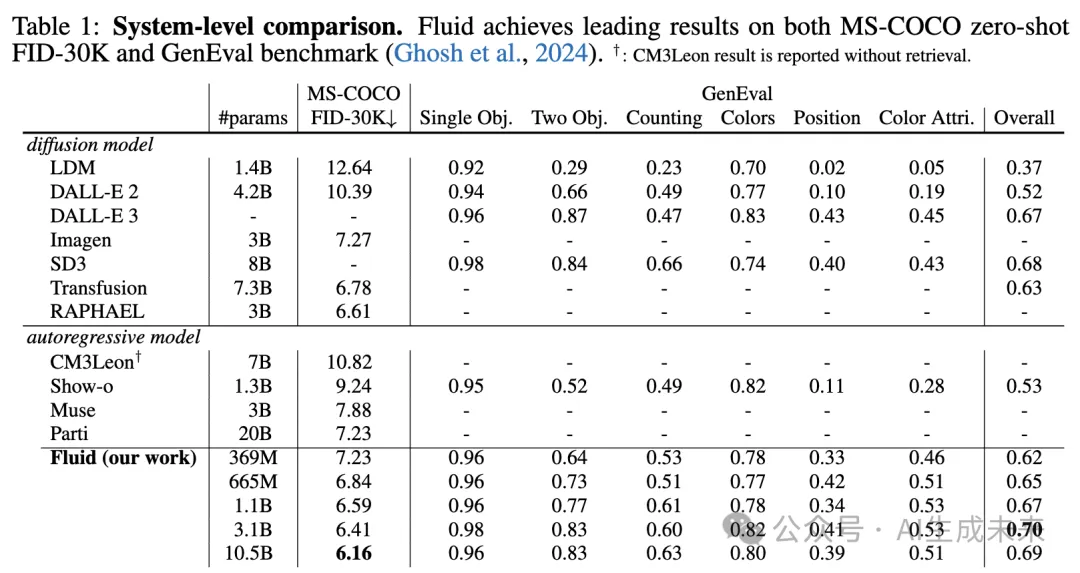

下表1為Fluid模型(即連續隨機順序自回歸模型)與領先的文本生成圖像系統進行比較。Fluid最小的模型,擁有369M參數,在MS-COCO數據集上實現了零樣本FID 7.23和GenEval總分0.62,與許多擁有數十億參數的最先進模型相匹敵(例如,Parti擁有20B參數僅實現了7.23)。Fluid最大的模型,擁有10.5B參數,進一步將MS-COCO數據集上的零樣本FID提高到6.16,并將GenEval總分提升至0.692,在每個TPU上生成每張圖像的速度為1.571秒(基于32 TPU v5,批次大小為2048)。

結論

本文對自回歸模型在文本生成圖像任務中的擴展行為進行了實證研究。探討了兩個關鍵設計因素:隨機順序與光柵順序,以及離散token與連續token。結果表明,使用連續token的隨機順序模型在各種評估指標和視覺質量方面均表現出最佳的性能和擴展性。基于這些發現,將連續token的隨機順序模型(即Fluid)擴展至10.5B參數,取得了最先進的文本生成圖像性能。希望這些發現和有前景的結果能為自回歸模型在圖像生成任務中的擴展性行為提供有價值的見解,并幫助縮小視覺模型與語言模型之間的性能差距。

本文轉自AI生成未來,作者:AI生成未來