大模型提示學習樣本量有玄機,自適應調節方法好

引言:探索文本分類中的個性化示例數量

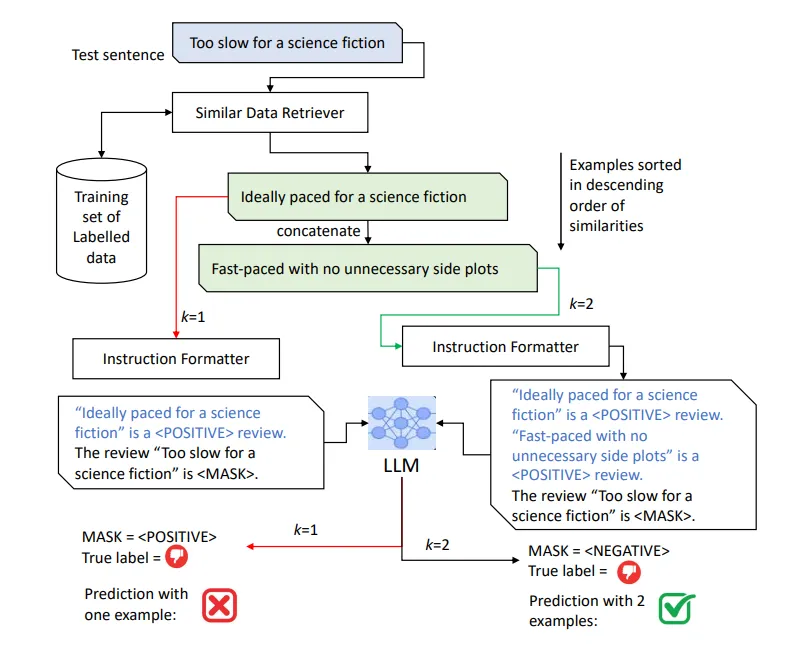

在自然語言處理(NLP)領域,預測模型已經從零開始訓練演變為使用標記數據對預訓練模型進行微調。這種微調的極端形式涉及到上下文學習(In-Context Learning, ICL),其中預訓練生成模型的輸出(凍結的解碼器參數)僅通過輸入字符串(稱為指令或提示)的變化來控制。ICL的一個重要組成部分是在提示中使用少量標記數據實例作為示例。盡管現有工作在推理過程中對每個數據實例使用固定數量的示例,但本研究提出了一種根據數據動態調整示例數量的新方法。這類似于在k-最近鄰(k-NN)分類器中使用可變大小的鄰域。該研究提出的自適應ICL(Adaptive ICL, AICL)工作流程中,在特定數據實例上的推理過程中,通過分類器的Softmax后驗概率來預測使用多少示例。這個分類器的參數是基于ICL中正確推斷每個實例標簽所需的最佳示例數量來擬合的,假設與訓練實例相似的測試實例應該使用相同(或接近匹配)的少量示例數量。實驗表明,AICL方法在多個標準數據集上的文本分類任務中取得了改進。

論文標題:

‘One size doesn’t fit all’: Learning how many Examples to use for In-Context Learning for Improved Text Classification

論文鏈接:

???https://arxiv.org/pdf/2403.06402.pdf??

理解在上下文學習中使用示例的動機

上下文學習(In-Context Learning, ICL),通過改變輸入字符串(稱為指令或提示)來控制預訓練生成模型(凍結的解碼器參數)的輸出。ICL的一個重要組成部分是在提示中使用少量標記數據實例作為示例。

動機來源于信息檢索(IR),不同的查詢由于信息需求的固有特性或查詢的制定質量,表現出不同的檢索性能。將IR中的查詢類比為ICL中的測試實例,以及將本地化示例視為潛在相關文檔,假設某些測試實例與訓練示例的關聯更好(即包含它們作為提示的一部分可以導致正確預測),因此包含少量示例就足夠了。另一方面,某些測試實例作為查詢的檢索質量不佳,因此需要進一步查看排名列表以收集有用的示例。這意味著需要替換查詢與文檔相關性的概念,以及測試實例對示例的下游有用性。

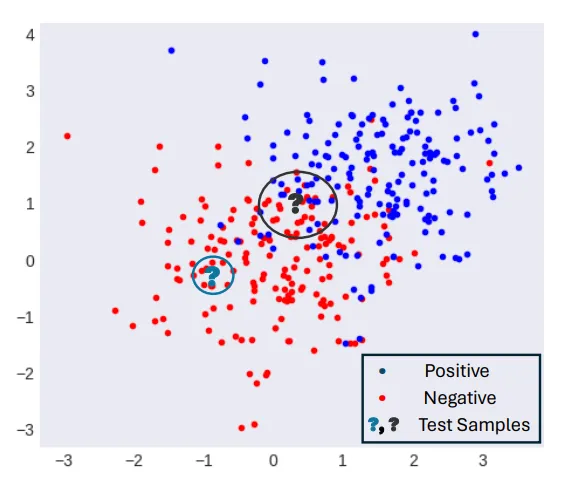

選擇可變數量的本地化示例的想法也類似于為k-NN分類選擇可變大小的鄰域,關鍵是同質鄰域可能只需要相對較小的鄰域就能做出正確預測,而非同質鄰域可能需要更大的鄰域。這個想法可以應用于ICL,其中一個測試實例如果與多個具有沖突標簽的訓練實例相似,可能需要更多的示例。

上下文學習(ICL)方法介紹

1. ICL的定義和工作原理

上下文學習(ICL)與監督學習不同,不涉及在標記示例上訓練一組參數θ。相反,后驗概率是以下因素的函數:a) 輸入測試實例的文本,b) 預訓練LLM的解碼器參數,c) 提示指令,d) 可選的一組k個輸入示例(通常稱為k-shot學習)。在這里,與監督設置不同,函數f沒有參數化表示,可以使用帶有梯度下降的訓練集進行學習。函數本身依賴于預訓練的LLM參數,當前輸入的標簽預測,以及由Nk(x)表示的k個文本單元組成的提示。

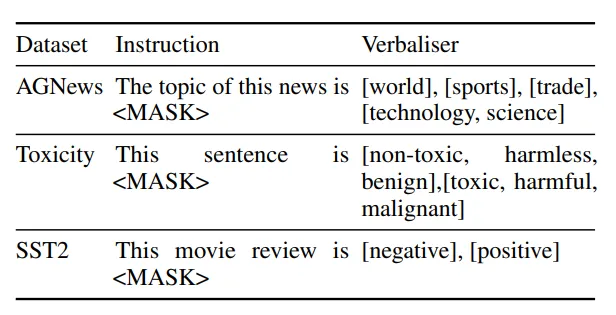

由于LLM的解碼器生成一系列單詞w1, ..., wl(l是序列的最大長度),類別后驗概率通過將p個可能的類別映射到p組不同的等效單詞集V(y)來計算,其中y ∈ Zp,這些集合通常稱為verbalisers。

2. ICL中的示例選擇和其重要性

ICL的一個最重要的組成部分是搜索組件,它輸出訓練集中與當前實例相似的top-k候選集。雖然原則上可以在提示中包含來自訓練集的隨機示例,但已經證明本地化示例(即與當前實例主題相似的示例)可以提供更好的性能。

上下文學習中的自適應(AICL)

1. AICL的動機和理論基礎

自適應在上下文學習(Adaptive In-Context Learning,簡稱AICL)的動機源自信息檢索(IR)領域的實踐,其中不同的查詢由于信息需求的固有特性或查詢的構造方式而表現出不同的檢索性能。類似地,在自然語言處理(NLP)中,特定的測試實例在使用上下文學習(In-Context Learning,簡稱ICL)時,可能會因為訓練示例的選擇而影響預測結果。AICL的理論基礎與k-最近鄰(k-NN)分類器中使用可變大小鄰域的概念相似,即對于同質的鄰域,可能只需要較小的鄰域就能做出正確的預測,而對于非同質的鄰域,則可能需要更大的鄰域。AICL的目標是動態地適應每個數據實例所需的示例數量,以提高文本分類任務的性能。

2. AICL工作流程

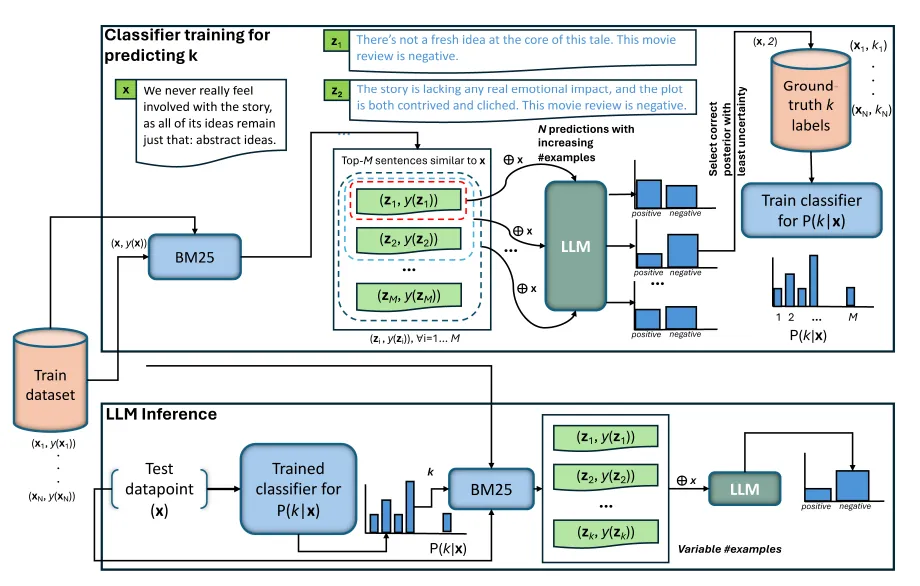

ICL的工作流程包括兩個主要階段:訓練和推理。在訓練階段,首先對訓練集中的每個實例執行k-shot推理,逐步增加k的值,然后基于一些標準(例如最少示例數量導致正確預測)來確定最佳的示例數量。這個最佳示例數量隨后用于訓練一個分類器,該分類器能夠根據訓練數據中的相似實例預測測試實例所需的示例數量。在推理階段,給定一個測試實例,首先使用訓練好的分類器預測所需的示例數量,然后將這些示例作為額外上下文輸入到預訓練的語言模型(LLM)中,以進行下游任務的預測。

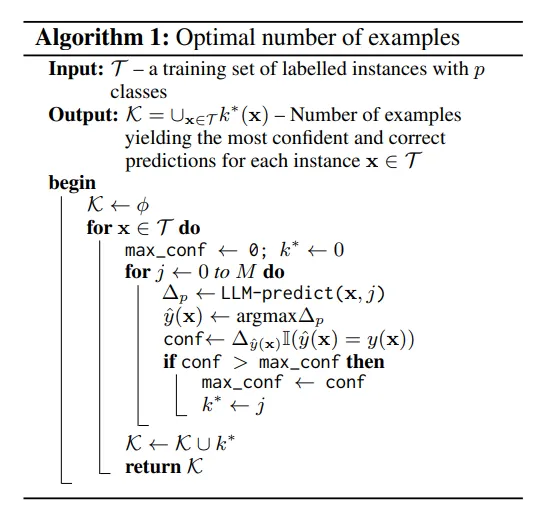

3. 選擇示例數量的方法

選擇示例數量的方法是通過監督學習來解決的。對于訓練集中的每個實例,首先使用逐漸增加的示例數量進行k-shot推理,然后根據一些啟發式標準(例如最小示例數量或分類置信度)來確定理想的示例數量。這些理想的示例數量隨后用于訓練一個分類器,該分類器能夠泛化到未見過的數據上,預測測試實例所需的示例數量。

實驗設計與數據集

1. 使用的數據集和任務說明

實驗使用了三個文本分類數據集:AGNews、Jigsaw Toxic Comment和SST2。AGNews是一個主題分類數據集,包含來自網絡的新聞文章,分為世界、體育、商業和科技四個類別。Jigsaw Toxic Comment數據集包含從維基百科的討論頁中提取的評論,這些評論被人類評估者按照六個代表有害行為的類別進行了注釋。SST2是一個情感分析數據集,包含從電影評論中提取的句子,用于二元分類任務。

2. AICL的不同變體和比較方法

AICL的變體包括AICL-L和AICL-U,分別應用最小示例數量和基于置信度的啟發式來訓練預測示例數量的分類器。此外,還比較了0-shot、靜態ICL(SICL)和隨機ICL(RICL)方法。SICL使用固定數量的示例作為輸入,而RICL使用從訓練集中隨機采樣的固定數量的示例。這些方法的性能通過精確度、召回率和F分數等指標進行評估,并考慮了平均輸入大小(AIS)和相對運行時間(RRT)作為效率指標。

實驗分析

1. AICL與其他基線方法比較

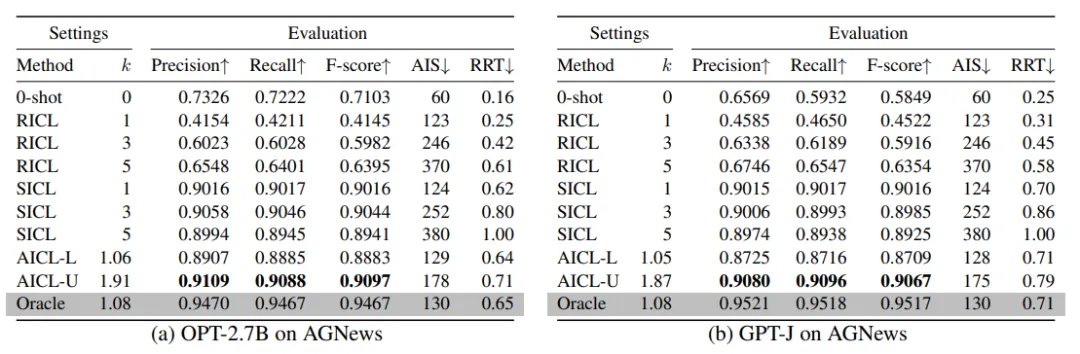

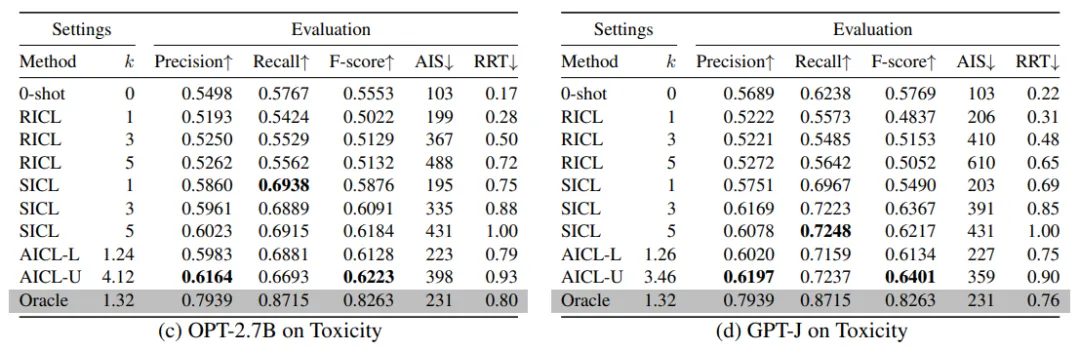

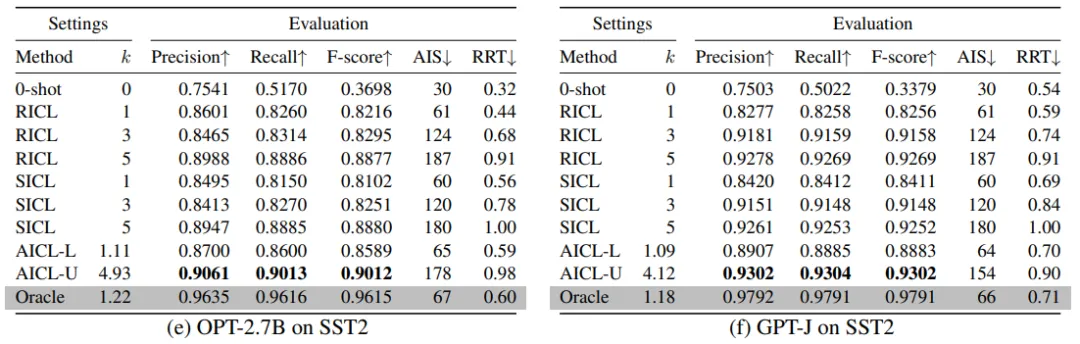

實驗結果表明,自適應上下文學習(AICL)方法在文本分類任務上優于靜態ICL(SICL)和隨機ICL(RICL)等基線方法。AICL通過動態調整用于推斷的示例數量,避免了非相關(無用)示例的負面影響。AICL學習了主題內容與所需上下文量之間的潛在關系,有效地指導了解碼器輸出的正確方向。

2. AICL在不同數據集上的表現

在AGNews、Toxicity和SST2等標準數據集上的實驗顯示,AICL在不同的文本分類任務中均表現出色。例如,在AGNews數據集上,AICL的平均精度、召回率和F分數均超過了SICL和RICL。這表明AICL能夠自動適應特定領域,而無需進行領域特定的調整。

3. AICL的效率和準確性分析

AICL不僅在準確性上表現出色,而且在效率上也有所提升。AICL能夠使用更少的輸入大小(平均k值和AIS值),這意味著在與SICL相匹配的示例數量下,AICL的計算速度更快。此外,AICL與測試集標簽訪問的oracle方法相比,僅在有效性和效率上略有落后,尤其是在主題分類和電影評論檢測任務(AGNews和SST2)上。

AICL的實際應用

1. 訓練κ分類器的實際性

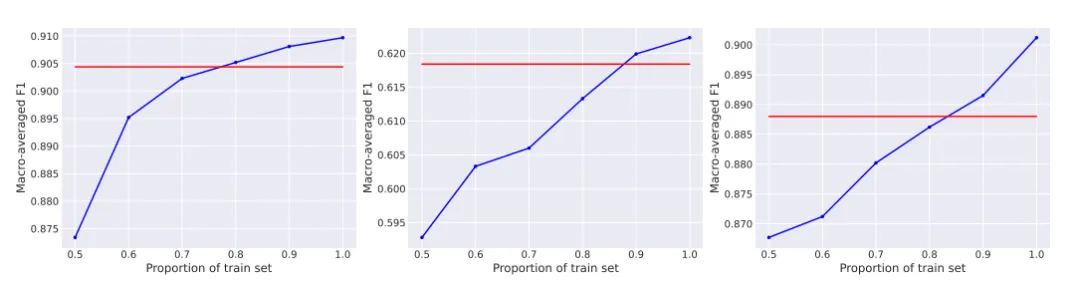

訓練κ分類器以預測測試實例的理想示例數量可能在大型訓練數據集上不切實際。然而,實驗表明,使用訓練數據的80%就足以超過SICL的性能,這表明κ分類器可以在較小的數據集上有效地訓練。

2. AICL在不同訓練數據規模下的表現

在不同比例的訓練數據上進行的實驗表明,即使在訓練數據較少的情況下,AICL也能夠保持良好的性能。這為在資源受限的環境中部署AICL提供了可能性,同時也表明AICL對訓練數據的規模不太敏感。

結論與未來展望

1. AICL方法總結

本研究提出了一種新穎的自適應上下文學習(Adaptive In-Context Learning, AICL)方法,旨在改進文本分類任務的性能。AICL方法的核心思想是動態調整用于推理的示例數量,而不是在所有測試實例中使用固定數量的示例。這種方法類似于k-最近鄰(k-NN)分類器中使用可變大小的鄰域。通過預測每個測試實例所需的示例數量,AICL能夠根據數據本身的特性來調整示例的數量,從而提高預測的準確性和運行時效率。

實驗結果表明,AICL在多個標準數據集上的文本分類任務中,相比靜態上下文學習(Static ICL, SICL)方法,能夠取得更好的效果。AICL通過學習訓練集中每個實例所需的最佳示例數量,并將這一信息泛化到未見過的數據上,從而實現了對測試實例的有效推理。此外,AICL在計算效率上也表現出色,因為使用較少的示例可以減少輸入字符串的長度,從而縮短解碼時間。

2. 未來展望

未來的研究將探索自適應上下文學習(AICL)方法的其他潛在改進方向,例如調整語言模型的提示模板和口令(verbaliser)。此外,研究將考慮如何在不同的任務和數據集上進一步優化AICL方法,以及如何將AICL與其他類型的學習策略(例如主動學習或元學習)結合起來,以提高模型的泛化能力和適應性。

考慮到在大型訓練數據集上進行語言模型推理可能在實踐中不太可行,未來的工作還將探討如何在較小的數據集上有效地訓練κ分類器。初步的實驗結果表明,使用訓練數據的80%就足以超過靜態上下文學習(SICL)的性能,這為在資源受限的情況下訓練κ分類器提供了可能性。

總之,AICL方法為自然語言處理中的上下文學習提供了一種有效的改進策略,未來的研究將繼續在這一方向上深入探索,以實現更加智能和高效的文本處理能力。

本文轉載自夕小瑤科技說,作者: 芒果