「數據墻」迫近?蘋果OpenAI等巨頭走投無路,被迫「偷師」YouTube視頻!

AI科技巨頭的「數據荒」到底該拿什么拯救?

為了訓練生成式AI,尤其是在scalling law的支配之下,互聯網上現存的內容早已不能滿足LLM越來越大的胃口,It's soooo hungry for data!

「數據荒」的直接結果,就是科技巨頭對GenAI的訓練數據越來越「饑不擇食」。

不僅僅是書籍、文章,甚至Instagram、X、Fackbook等各種社交平臺上的內容也是來者不拒。

前段時間和OpenAI簽合作協議,而且坑了谷歌搜索、導致Gemini教唆網友給披薩加膠水的Reddit也是其中之一。

為了規避潛在的法律糾紛,GPT、Gemini、Claude等商業模型在發布時往往選擇對訓練數據「三緘其口」,絕口不提及其來源、構成、使用許可等信息。

然而,這個問題早就引起了創作者和各種媒體平臺越來越強烈的不滿。

近日,Anthropic、英偉達、蘋果和Salesforce等公司再次身陷「數據門」,遭受到《連線》雜志和非營利新聞工作室ProofNews的猛烈攻擊。

兩家媒體聯合進行了一項調查,發現這些科技巨頭們大量竊取了Youtube上的視頻字幕用于訓練,使用了共計超過4.8萬個頻道的17.4萬個視頻。

ProofNews甚至制作了一個在線搜索工具,對這種行為進行持續的「公開處刑」。哪些創作者和視頻被偷偷納入數據庫,一搜就知道。

網頁地址:https://www.proofnews.org/youtube-ai-search/

追根溯源,這些數據指向一個共同來源——Eleuther AI在2020年發布的數據集Pile。

作為非營利組織,Eleuther AI建立Pile項目的初衷本是為了幫助小型組織和研究人員,促進AI研究的民主化,沒想到最后也成為了大公司的囊中之物。

這正是事情的吊詭之處——本來是為反巨頭而生的「Pile」反而讓巨頭用得不亦樂乎。

一邊是怨聲載道的創作者,不滿科技巨頭又用數據、又搶飯碗的粗暴行徑;另一邊是宣揚著偉大AGI愿景的科技巨頭。

像EleutherAI這樣辛辛苦苦爬數據還開源的NPO,懷抱著促進數據共享和技術公平的初衷,結果只落得被大公司利用、被創作者批判的境地。

Pile:有罪的開源?

ProofNews和《連線》雜志將主要矛頭對準了Eleuther AI在2020年發布的大型開源文本數據集Pile。

文章憤怒地指出,Pile不僅包括YouTube字幕,還有來自歐洲議會、英語維基百科的語料,甚至還有安然(Enron)公司員工的大量電子郵件。

然而,Pile數據集的論文本身卻給我們呈現出完全不一樣的圖景。

論文地址:https://arxiv.org/abs/2101.00027

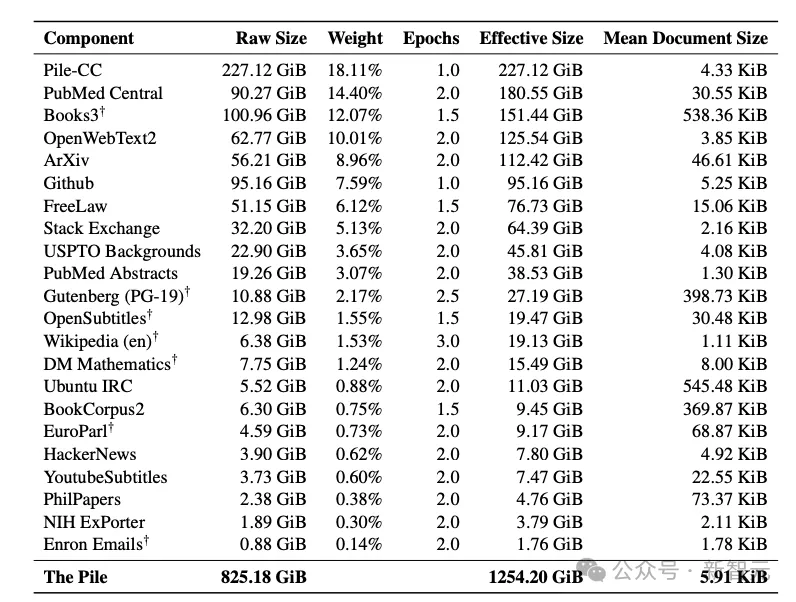

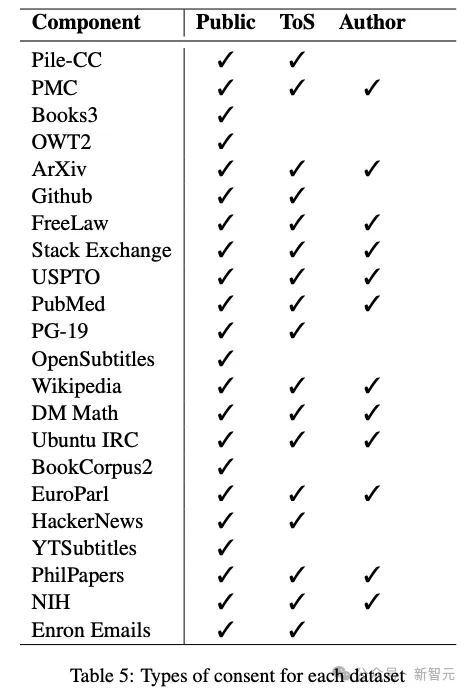

這篇將近40頁的論文不僅詳細披露了共825GB文本數據的全部22個來源,還詳細討論了數據收集應當遵循的原則和廣泛影響。

從上圖中可以看到,處于爭議焦點的兩個數據集——YoutubeSubtitles和Enron Emails被公開列了出來。

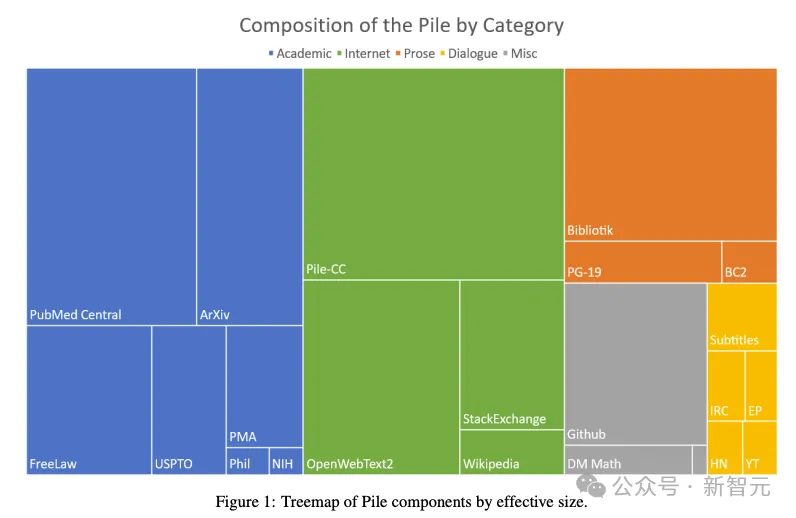

下面的樹狀圖中,也沒有避諱「字幕」類數據的使用,反而是在佐證數據集內容的多樣性。

為什么Eleuther AI的研究團隊能這么毫不心虛?

首先,Enron Emails是美國聯邦政府對該公司進行調查期間發布到網上的,已經作為公開數據集被使用多年,因此不存在我們想象中的隱私泄露問題。

https://www.cs.cmu.edu/~enron/

其次,作者團隊對Youtube字幕數據的使用也做出了充分的說明和討論。

所有數據集的可用性被分為三類:

- 公開數據:網絡上完全免費、公開的數據,沒有任何訪問障礙

- 符合服務條款(ToS)的數據:數據的獲得和使用符合服務條款的相關要求

- 得到作者許可的數據:原作者已經同意對數據的使用

如表5所示,22個數據集中,僅有5個數據集沒有得到ToS許可,但在NLP社區中,除了YoutubeSubtitles外的其他4個都已經被廣泛傳播并使用。

對于YoutubeSubtitles本身,作者在抓取數據時使用了一個非官方API,并進行了大量數據處理工作。而且,這個AP工具在Pip、Conda、GitHub等平臺上都很流行且能極易取得。

「API流行且極易取得」,意味著相關數據的廣泛傳播和使用也許已經是既成事實。

「大量處理工作」似乎是暗示,這個數據集并非只包含視頻創作者的心血,同時也凝結了論文作者的技術知識和勞動。

因此,論文中有這樣一句總結性陳述:

Given the processing applied and the difficulty of identifying particular files in the Pile, we feel that our use of these datasets does not constitute significantly increased harm beyond that which has already been done by the widespread publication of these datasets.

考慮到所采用的處理方法,以及在Pile中識別特定文件的難度,我們認為,基于這些數據集目前的大范圍公布,我們的使用并不會顯著增加其危害。

除了可用性討論,作者也用了不少篇幅指出Pile中包含的有害內容,比如性別、種族、宗教等方面的偏見,以及褻瀆或貶損類話語。

此外,研究團隊還公開了數據集全部內容,以及預訓練所用的代碼。

https://pile.eleuther.ai/

https://github.com/EleutherAI/the-pile?tab=readme-ov-file

除了建立數據集,論文也提出了將Pile作為基準測試的可能,并在對GPT-2和GPT-3的實驗中,揭示了文本數據多樣性對模型性能的影響。

綜合上述內容,站在AI技術人的角度,Eleuther AI的這篇論文不僅無過,而且可以稱得上是非常負責且有貢獻的研究。

然而,Pile自從發布后就惹上了一身麻煩,各種訴訟案件接踵而來。

目前,Eleuther的官方網站已經將Pile數據集刪除,但它憑借自己強大的歷史影響,依舊在AI/ML社區廣泛流傳。

倒下了一個Pile,后來的開源數據集還會繼續站起來。

上圖中提到的BigCode項目如此,NLP社區廣為人知的Common Crawl也是如此。

這個非營利組織從2007年開始抓取網頁數據,堅持至今,收集網頁數量超過2500億。

據Hacker News網友估計,總數據量大概以每月200~300TB的速度穩定增長,可能已經累積到數十甚至數百PB。

與Pile的命運不同,CC數據集安然存活至今。這些數據都托管在亞馬遜云平臺上,可以通過命令行直接下載。

https://commoncrawl.org/get-started

創作者:請停止剝削

雖然在AI從業者的眼中,對Pile的指責有些過分苛責,但對于Youtube創作者而言,他們的憤怒和無奈也是真實的。

ProofNews的調查發現,被Pile搜刮的創作者中不乏粉絲千萬的YouTube網紅,甚至一些官方賬號也未能幸免。

YouTube Subtitles數據集中,不僅包含可汗學院、哈佛、MIT等在線教育頻道的視頻轉錄字幕,還有《華爾街日報》、NPR、BBC等媒體的新聞視頻,Stephen Colbert、Jimmy Kimmel等人主持的風靡全美的脫口秀節目也赫然在列。

在創作者眼中,沒有經過本人同意就抓取創作內容用于訓練AI,實質上是一種剽竊,甚至剝削。

David Pakman是自己同名脫口秀節目的主持人,擁有200多萬訂閱者,瀏覽量超過20億次。

YouTube Subtitle數據集中,收錄了該節目的近160個視頻。但更讓Pakman感到憤怒的是,他發現自己在TikTok上被「克隆」了。

Pakman自己曾經說過的臺詞被一字不差地挪用,甚至連語調都一樣,只不過換成了一個叫作Tucker Carlson的人。更讓他震驚的是,評論區居然只有一個人發現了這一點。

Pakman對此忿忿不平:「這是我的生計,我投入了時間、資源、金錢和員工的時間來制作這些內容」。

他認為,如果人工智能公司從「克隆」中盈利,那么自己也應該獲得報酬。

Nebula的首席執行官Dave Wiskus則說得更加露骨:「這是盜竊行為」。

Nebula是一家流媒體公司,其內容同樣也被大公司從YouTube上盜用,用于訓練人工智能。

Wiskus表示,未經創作者同意就使用他們的作品是「不尊重」他們的行為,尤其是「生成式人工智能會盡可能多地取代藝術家」。

「這絕對是對藝術家的嚴重傷害和剝削!」

孤立無援的創作者對未來的道路感到十分迷茫,心中充滿了不確定。

一些全職YouTube用戶會巡查他們的作品是否被未經授權使用,定期提交刪除通知,不能心無旁騖地創作。

即便如此,他們還是被焦慮籠罩,擔心AI能夠生成與他們制作的內容類似的內容只是時間問題。

通過YouTube可以快速學習人類說話的方式和習慣,這件事好理解,可關鍵是AI它什么都學啊!

ProofNews發現,AI公司使用的視頻中有146個來自Einstein Parrot,這個賬號有15萬粉絲,但博主的身份是一只非洲灰鸚鵡。

鸚鵡模仿人類說話,然后AI再模仿鸚鵡模仿人類說話,然后人類每天跟AI聊天機器人說話,開始模仿AI……閉環了,朋友們。

大公司:用開源,我錯了么

除了爬取的視頻數據翻個底朝天,ProofNews還搬出了大公司使用Pile來訓練人工智能的「鐵證」——

蘋果4月份發布了一個備受矚目的模型OpenELM,在論文當中就提及了Pile。

論文地址:https://machinelearning.apple.com/research/openelm

可是蘋果也很委屈,表示OpenELM模型的目的是為研究社區作貢獻,推動開源LLM的發展。

Anthropic也是如此,其發言人Jennifer Martinez在一份聲明中證實,Claude確實使用了Pile數據集,但是關于侵權問題,她表示「我們必須請教Pile的作者」。

Salesforce也確認,他們使用了Pile來構建用于「學術和研究目的」的人工智能模型,但公司人工智能研究副總裁Caiming Xiong在聲明中強調,Pile是「公開」數據集,因此他們的使用無可指摘。

實際上,盯上Youtube這個「數據金礦」的科技巨頭遠不止這幾家。

今年4月,紐約時報就披露了OpenAI、谷歌、Meta等公司「收割」Youtube數據的情況。

https://www.nytimes.com/2024/04/06/technology/tech-giants-harvest-data-artificial-intelligence.html

比如OpenAI創建了一款名為Whisper的語音識別工具,用于將Youtube視頻轉錄為文本,用作訓練數據。

擁有Youtube平臺的谷歌則可以理直氣壯的表示,使用平臺上的視頻內容進行模型訓練,這是是與創作者達成的條款中所允許的。

硅谷風投公司Andreessen Horowitz的律師Sy Damle表示,「模型所需的數據如此龐大,即使是集體許可也確實行不通。」

在這個未形成共識的灰色地帶,似乎所有利益相關方都在困境中,但所有人都無解。

從小型組織、研究者,到Eleuther AI這樣的NPO,再到科技巨頭,「數據墻」的威脅近在眼前。要想跟上技術發展的節奏,就得竭盡所能利用一切數據來源。

內容創作者們,則眼看著自己的心血創意變成反噬自己的強大力量,想要阻止卻收效甚微。

我們正在踏入一種未知,或許只有未來才能給出答案。