CVPR世界第二僅次Nature!谷歌2024學(xué)術(shù)指標(biāo)出爐,NeurIPS、ICLR躋身前十

谷歌2024學(xué)術(shù)指標(biāo),剛剛出爐了!

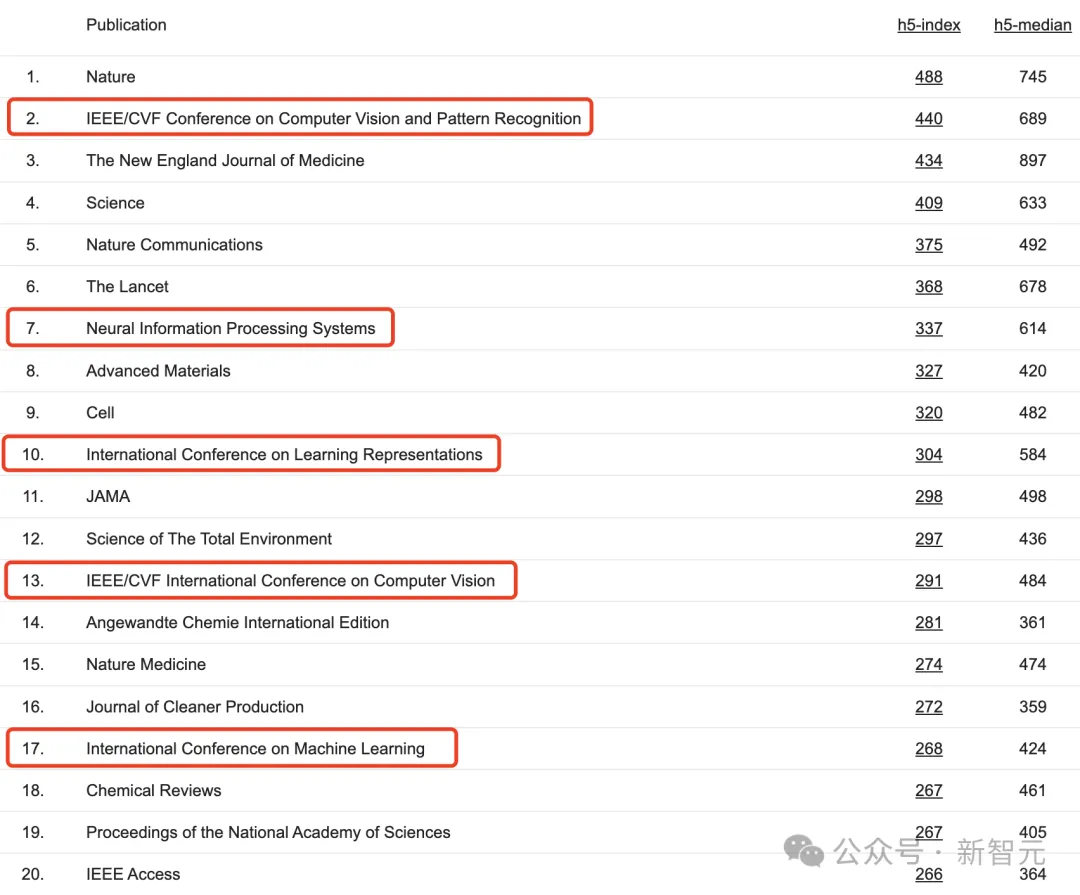

最新排名是針對(duì)2019-2023年之間發(fā)表的文章的統(tǒng)計(jì),還包含了截至2024年7月在Google Scholar中被引的所有文章數(shù)。

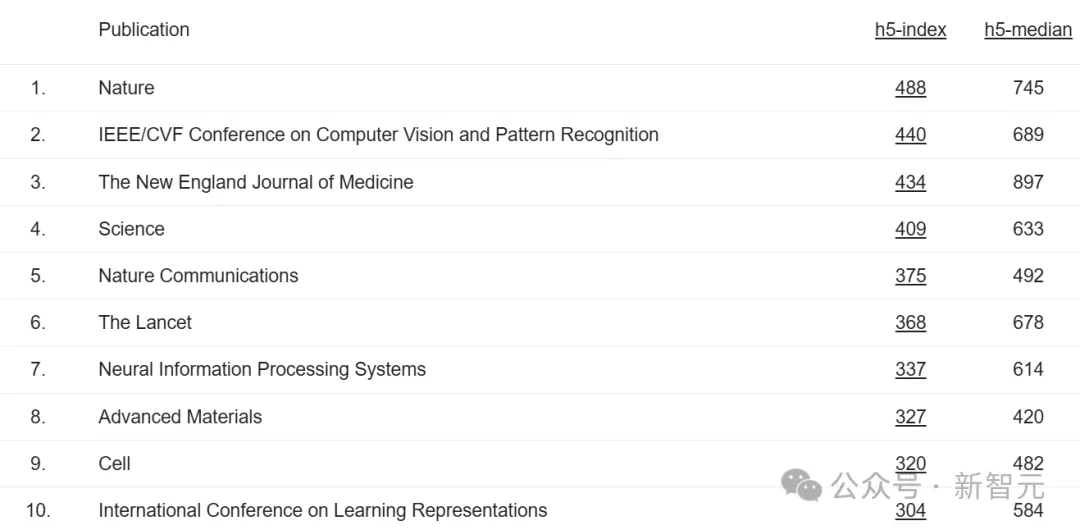

今年,依據(jù)h5-index,排在前十的期刊/國(guó)際頂級(jí)學(xué)術(shù)會(huì)議中,Nature已經(jīng)連續(xù)霸榜多年。

除了Nature,還有新英格蘭醫(yī)學(xué)雜志、Science、自然通訊、柳葉刀、Advanced Materials、細(xì)胞國(guó)際期刊進(jìn)入前十。

此外,CVPR、NeurIPS、ICLR三大頂會(huì)躋身TOP 10,分別位列第二、第七和第十。

2023學(xué)術(shù)指標(biāo)中,CVPR位列第四,NeurIPS位列第九。ICLR排名不變。

網(wǎng)友們紛紛驚嘆道,「CVPR已經(jīng)攀升至第二,僅次Nature」!

「看到CVPR比Science有更大一個(gè)影響力,和Nature相差不遠(yuǎn),簡(jiǎn)直太瘋狂了」。

CVPR、NeurIPS頂會(huì)排名躍升如此之高,說明了什么問題?

加拿大滑鐵盧大學(xué)計(jì)算機(jī)教授Gautam Kamath稱,要么是很多人引用了這些頂會(huì)中的論文,要么是很多人在頂會(huì)中發(fā)表了論文。也就是說,這一現(xiàn)象主要反映了該研究領(lǐng)域的增長(zhǎng)。

AI五大頂會(huì)沖進(jìn)TOP 20

除了開頭我們提到了三個(gè)頂會(huì)位列前十,在總榜前20名中,還有ICCV、ICML兩個(gè)機(jī)器學(xué)習(xí)/計(jì)算機(jī)視覺頂會(huì)入選。

其中,ICCV位列第13,ICML位列第17。

接下來,一起分別看看這5大頂會(huì),近5年來(2019-2023年)被引最高的文章。

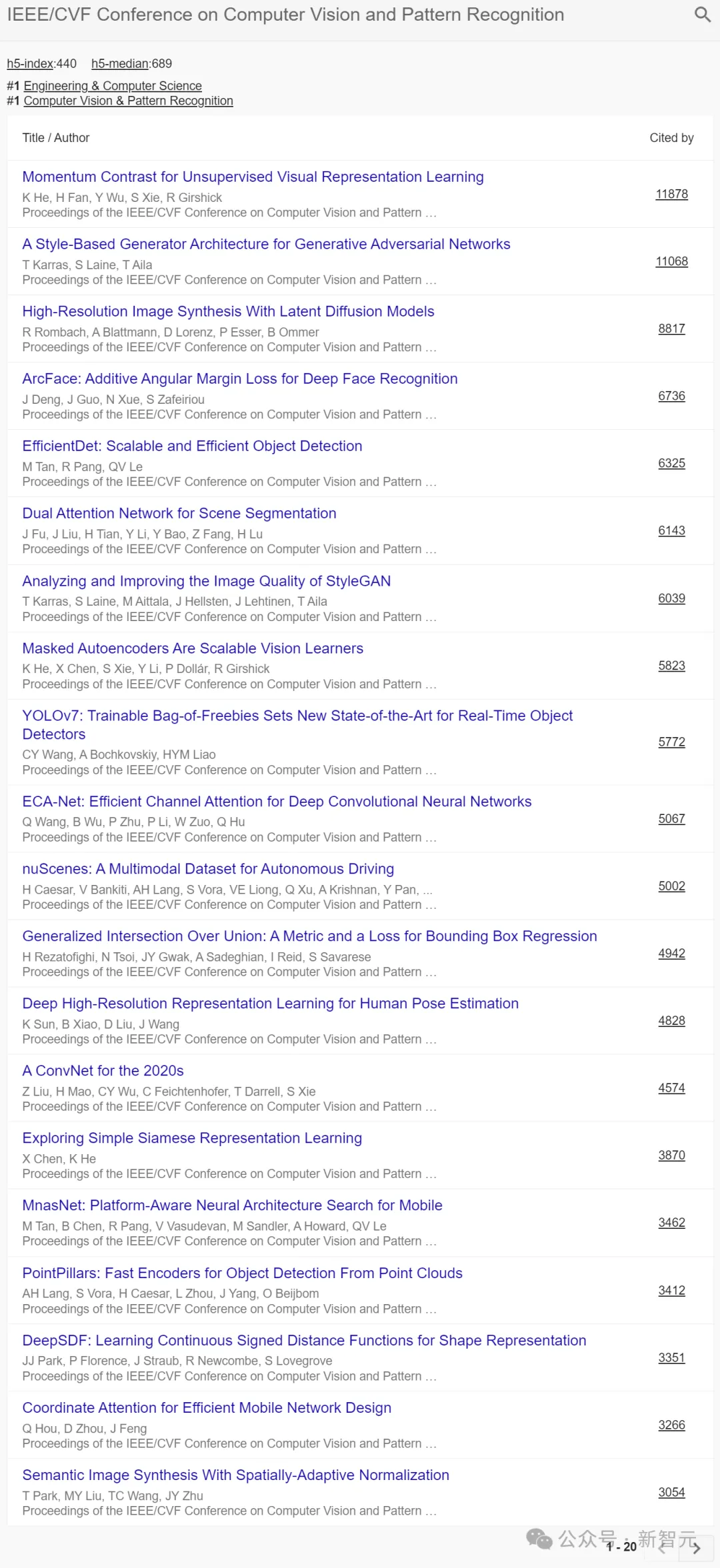

CVPR:StyleGAN、LDM

首先來看CVPR,h5-index為440,h5-median為689。

在前20篇高被引的論文中,優(yōu)秀的產(chǎn)出成果分別聚集在2019年、2020年、2022年中,分散在2021年、2023年的論文只有零星幾篇。

這里,有幾篇極具代表性,每個(gè)人或多或少熟知的作品:

由何凱明、謝賽寧等人聯(lián)手在2020年提出的動(dòng)量對(duì)比(MoCo)算法被引最高,達(dá)11878次。這是一種構(gòu)建大型且一致的詞典的方法,用于無監(jiān)督學(xué)習(xí)。

還有英偉達(dá)團(tuán)隊(duì)提出的StyleGAN算法,讓AI可以生成無數(shù)個(gè)細(xì)節(jié)豐富、逼真的人臉,很難看出偽造的痕跡。

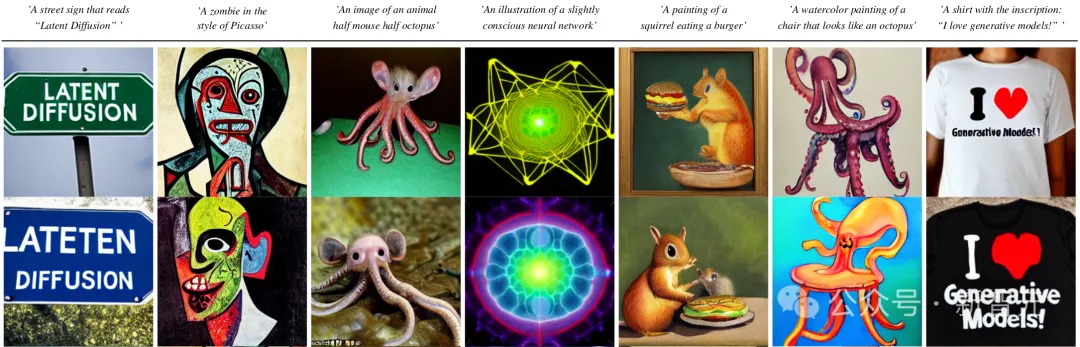

Runway的AI視頻模型從Gen-1到Gen-3 Alpha完成多次進(jìn)化,離不開的是「潛在擴(kuò)散模型」(LDM)。

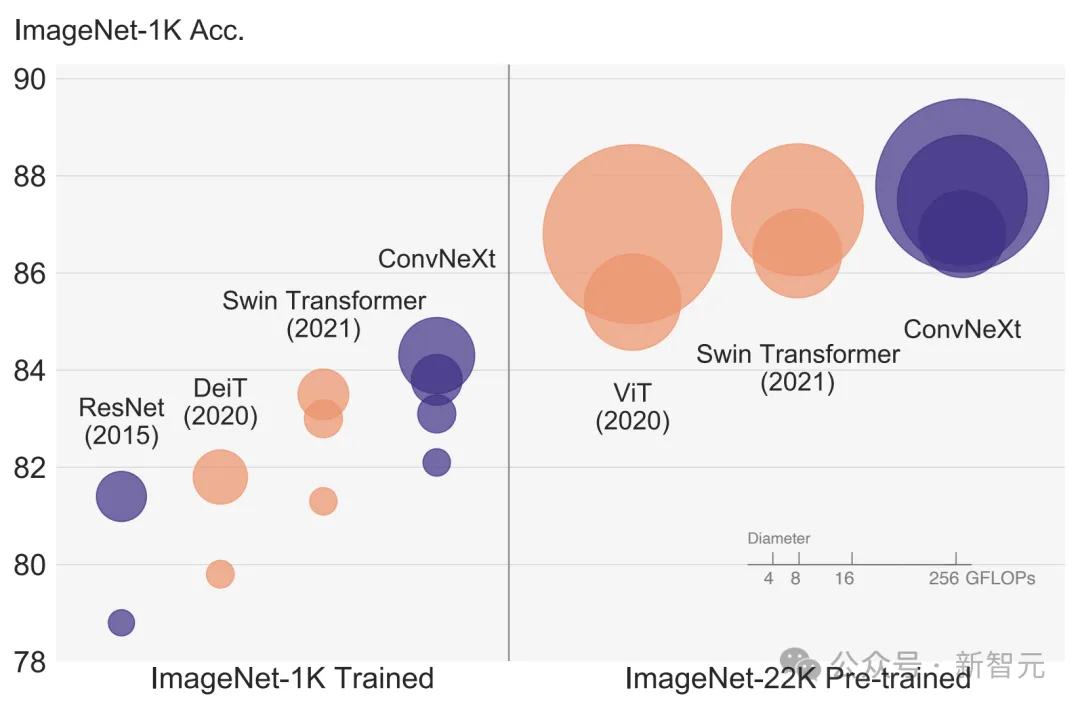

還有謝賽寧帶領(lǐng)團(tuán)隊(duì)發(fā)表的A ConvNet for the 2020s,帶來全新純卷積模型ConvNeXt,性能反超Swin Transformer,直接在CV圈里掀起了模型架構(gòu)之爭(zhēng)。

2023年有一篇YOLOv7的論文進(jìn)入TOP 20,現(xiàn)在這一算法已經(jīng)改進(jìn)到了YOLOv10(清華團(tuán)隊(duì))。

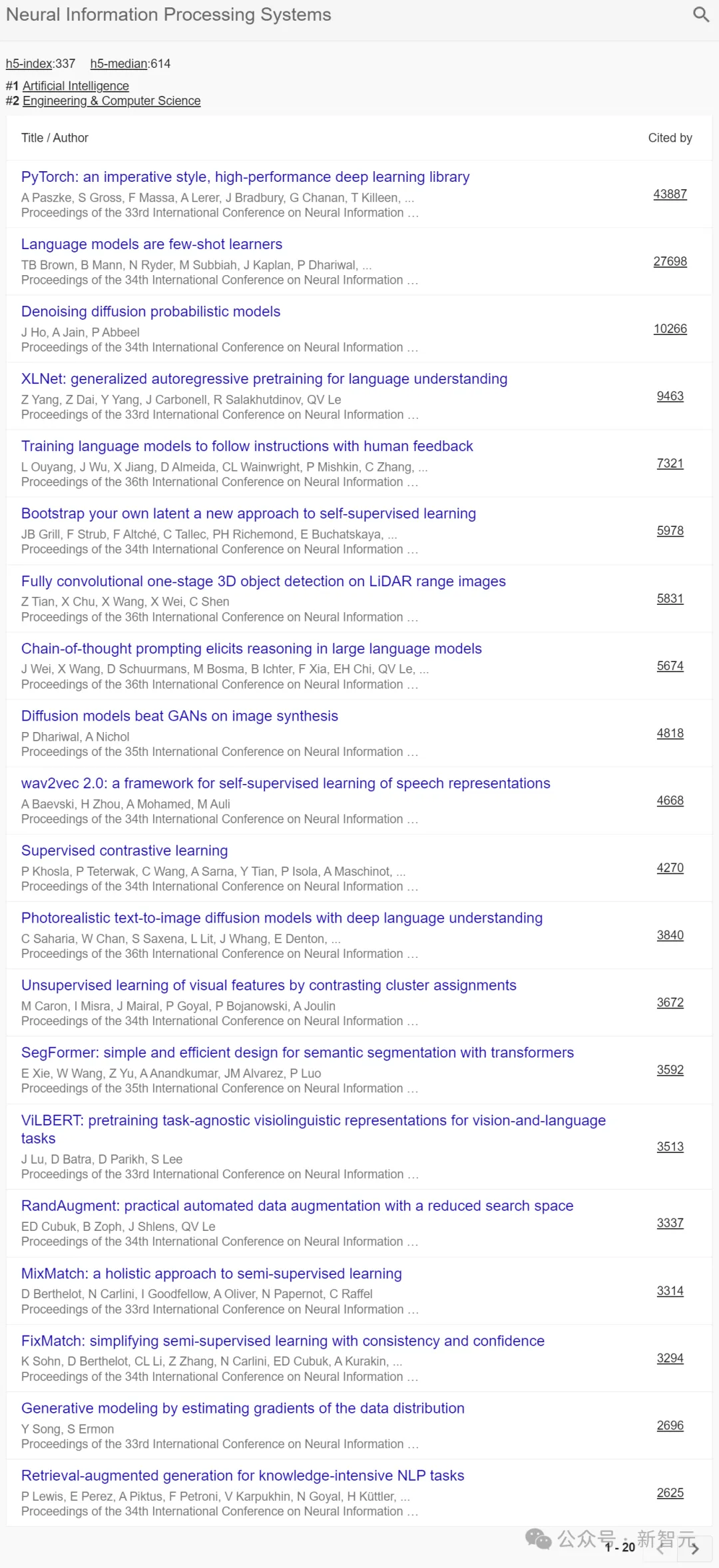

NeurIPS:GPT-3、CoT、RAG

在NeurIPS中,h5-index為337,h5-median為614。

在前20篇高被引的論文中,優(yōu)秀的產(chǎn)出成果分別聚集在2019-2022年之間。

被引最高的論文是PyTorch開山之作,被引數(shù)為43887,可見其影響力之深遠(yuǎn)。

其次,被引第二高的是由前OpenAI科學(xué)家Ilya Sutskever帶隊(duì)的研究——大名鼎鼎的GPT-3背后之作,成為業(yè)界拜讀之筆。

其他著名的研究還包括:

谷歌大腦一作Jason Wei和團(tuán)隊(duì)提出「思維鏈」(CoT)算法,已經(jīng)成為當(dāng)今大模型彌補(bǔ)幻覺問題的一種重要的手段。

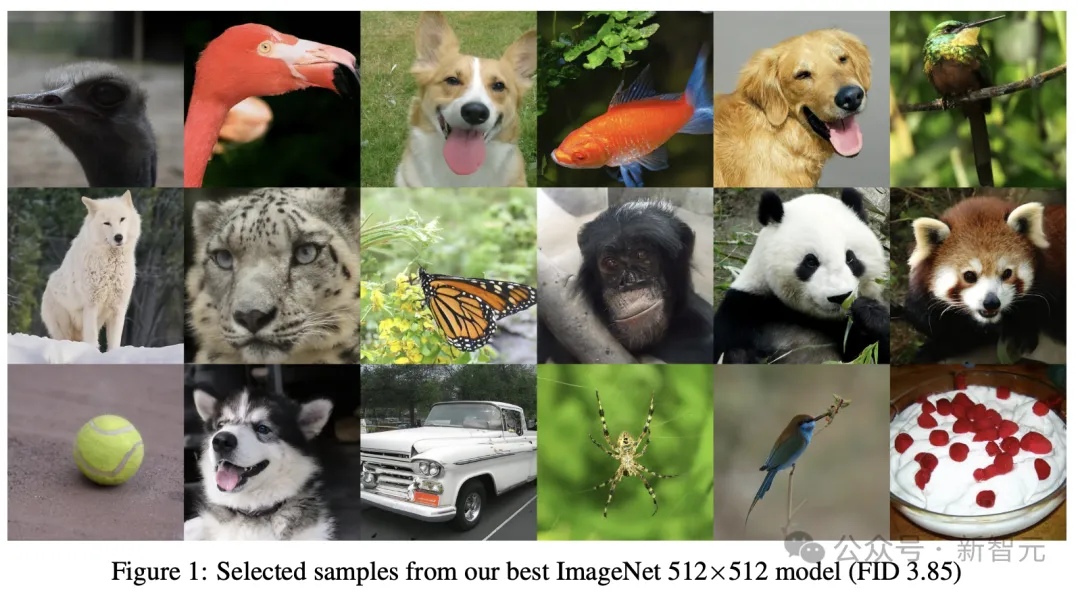

還有OpenAI團(tuán)隊(duì)提出的使用類別引導(dǎo)圖像生成擴(kuò)散模型,首次擊敗了GAN。

另有Meta(Facebook)團(tuán)隊(duì)在2020年在如下論文中,首次提出了如今大模型用到的一項(xiàng)技術(shù)的概念——檢索增強(qiáng)生成(RAG)。

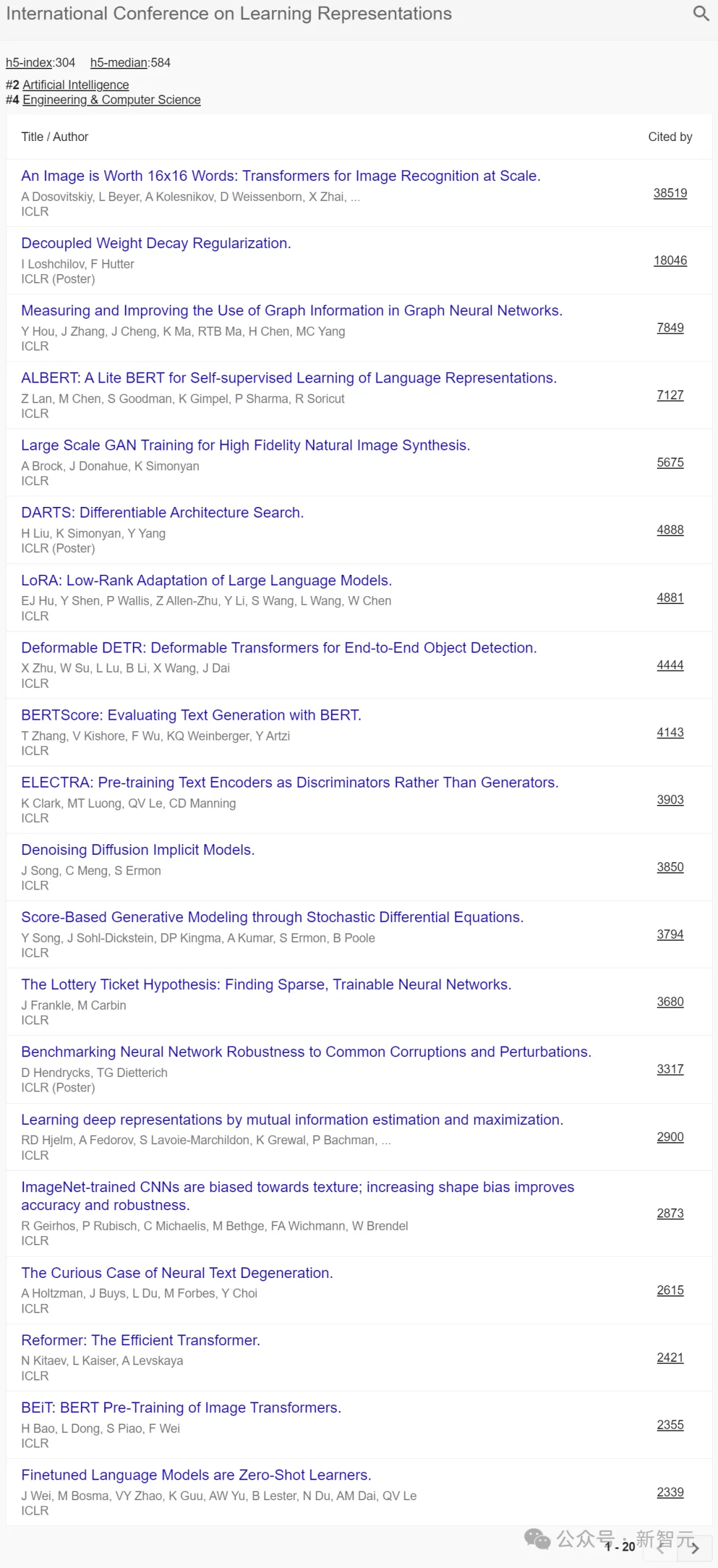

ICLR:LoRA、ViT

在ICLR中,h5-index為304,h5-median為584。

在前20篇高被引的論文中,優(yōu)秀的產(chǎn)出成果分別聚集在2019-2022年之間,2021年比例偏少一些。

其中的經(jīng)典之作,包括微軟團(tuán)隊(duì)提出的大模型時(shí)代爆火技術(shù)之一——LoRA。這是一種降低模型可訓(xùn)練參數(shù),又盡量不損失模型表現(xiàn)的大模型微調(diào)方法。

如下這篇論文成為Transfomer在CV領(lǐng)域的里程碑之作,引爆了后續(xù)的相關(guān)研究。

谷歌大腦團(tuán)隊(duì)提出了Vision Transformer(ViT)全新架構(gòu),不用卷積神經(jīng)網(wǎng)絡(luò)(CNN),可以直接用Transformer對(duì)圖像進(jìn)行分類,性能趕超CNN。

斯坦福團(tuán)隊(duì)提出的「去噪擴(kuò)散隱式模型」(DDIM),大幅減少采樣的步驟,極大的提高了圖像生成的效率。

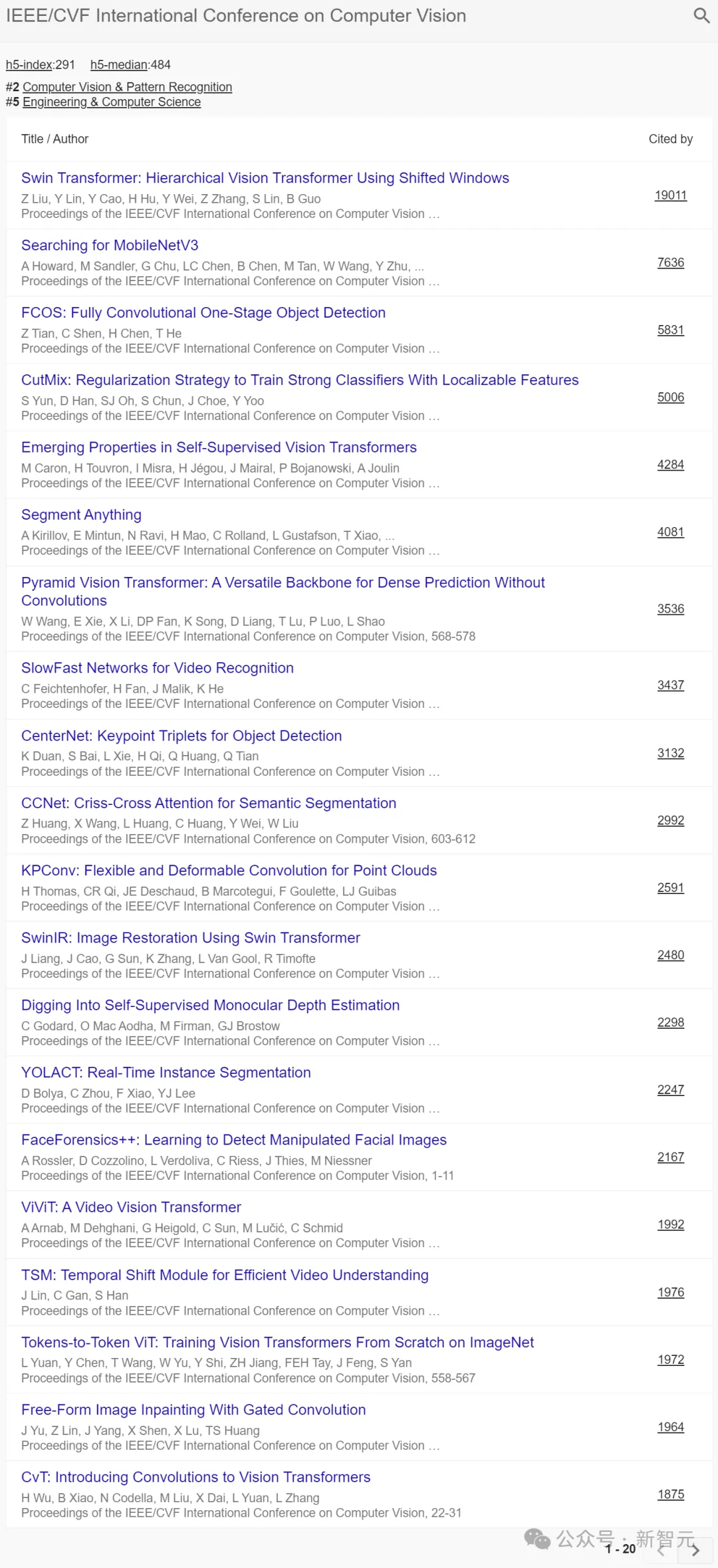

ICCV:Swin Transformer、SAM

在ICLR中,h5-index為291,h5-median為484。

在前20篇高被引的論文中,優(yōu)秀的產(chǎn)出成果主要聚集在2019年、2021年。

其中,有大家熟知的:

全華人團(tuán)隊(duì)提出的Swin Transformer,是Transformer模型在視覺領(lǐng)域的又一次碰撞。它在物體檢測(cè)和語(yǔ)義分割任務(wù)中大幅刷新了此前的紀(jì)錄,并被廣泛應(yīng)用于眾多視覺任務(wù)中。

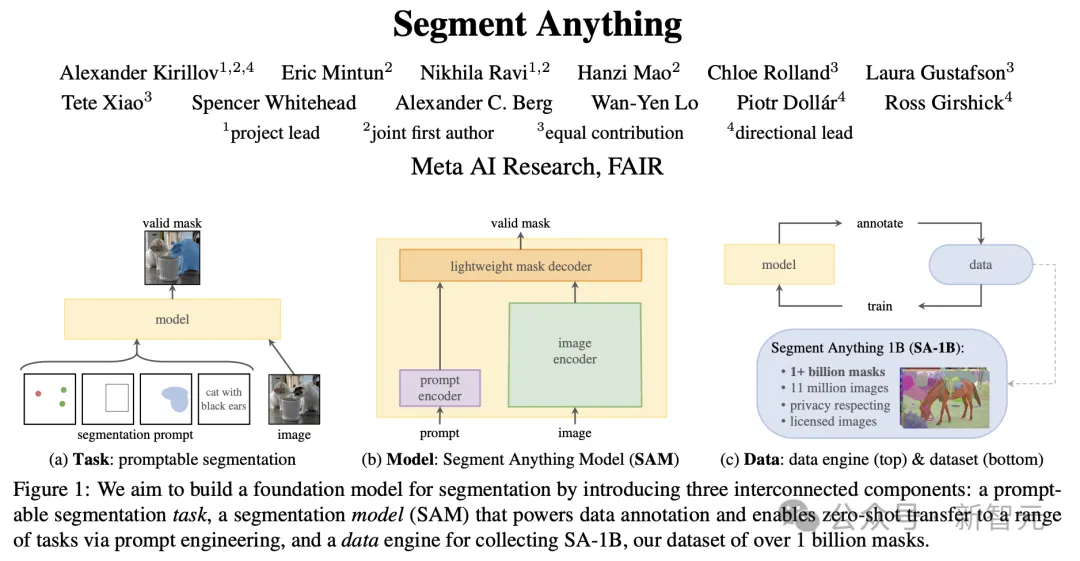

Meta團(tuán)隊(duì)提出的「分割一切」(SAM)模型,讓學(xué)術(shù)圈直呼CV不存在了。

ICML:DALL·E、GLIDE、BLIP

在ICML中,h5-index為268,h5-median為424。

在前20篇高被引的論文中,優(yōu)秀的產(chǎn)出成果分散在2019-2023年之間。

在GAN之后,Ian Goodfellow團(tuán)隊(duì)又提出了「自注意力生成對(duì)抗網(wǎng)絡(luò)」(SAGAN),在GAN的基礎(chǔ)上引入了自注意力機(jī)制,改進(jìn)了圖像生成的質(zhì)量和多樣性。

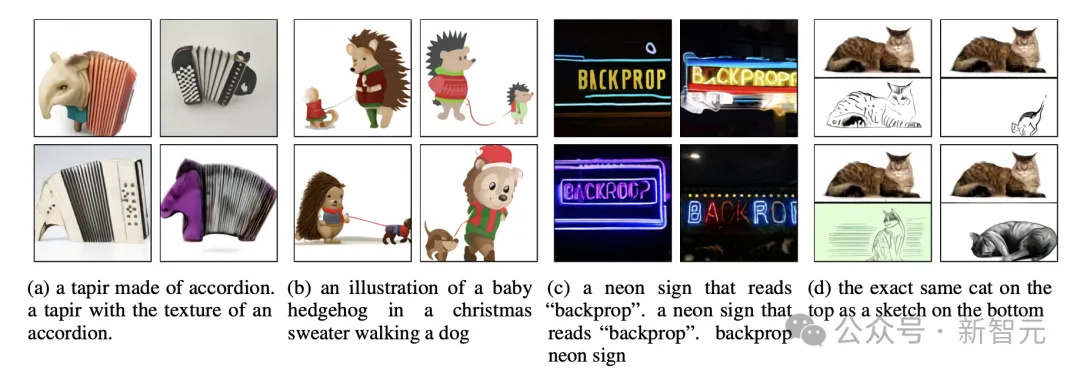

OpenAI DALL·E背后經(jīng)典之作,便是如下這篇了。

另一篇同由OpenAI團(tuán)隊(duì)提出的的文本生成圖像模型GLIDE,僅用35億參數(shù),就能媲美初代DALL·E的性能。

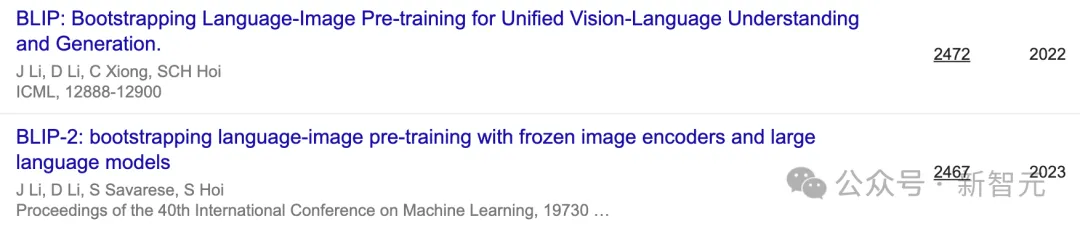

此外,還有雙語(yǔ)視覺語(yǔ)言模型BLIP、BLIP-2。

從以上五大頂會(huì)的趨勢(shì)研究中,看得出當(dāng)前GenAI、大模型的爆發(fā),與近年來的研究一脈相承。

另外,對(duì)于其他領(lǐng)域感興趣的讀者,可以進(jìn)入Google Scholar主頁(yè)自行查閱。

傳送門:https://scholar.google.com/citations?view_op=top_venues

最權(quán)威學(xué)術(shù)指標(biāo),也陷爭(zhēng)議

每年,Google Scholar都會(huì)更新一次學(xué)術(shù)指標(biāo),并列出位列前100名的出版物。

「谷歌學(xué)術(shù)指標(biāo)」提供了一種簡(jiǎn)便的方法,可以快速評(píng)估近期文章在學(xué)術(shù)出版物中的可見度和影響力。

它總結(jié)了許多出版物最近的引用情況,可以幫助業(yè)界研究者們參考那里發(fā)表最新的研究成果。

這些出版物按照5年h-index、h-median,這兩個(gè)指標(biāo)去排序。

若想具體查看,排名中某出版物中哪些文章被引數(shù)最多,以及誰(shuí)引用了這些文章,直接單擊h-index,便可查看。

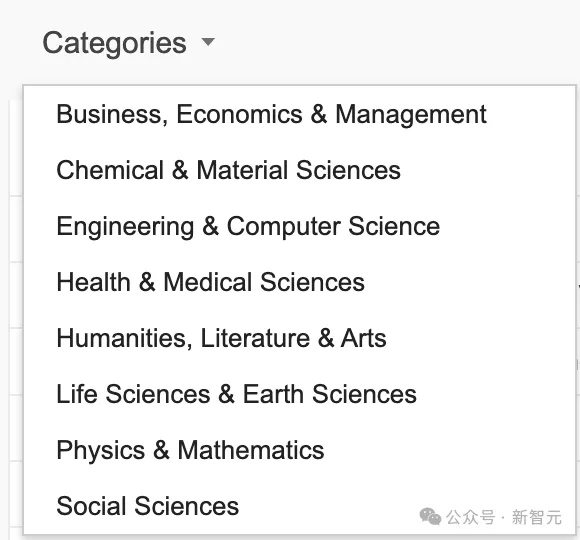

總榜,是不分類榜單。針對(duì)不同領(lǐng)域,比如工程&計(jì)算機(jī)視覺、物理&數(shù)學(xué)、化學(xué)&材料科學(xué)等,都有各自榜單排名。

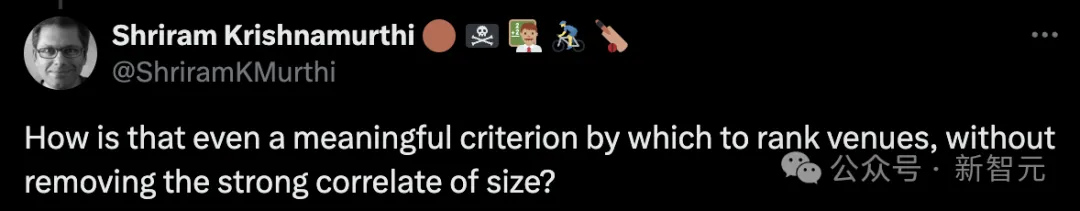

有網(wǎng)友發(fā)出質(zhì)疑:如果不考慮「頂會(huì)規(guī)模」這一「強(qiáng)相關(guān)」的因素,這怎么可能成為一個(gè)有意義的評(píng)價(jià)頂會(huì)的標(biāo)準(zhǔn)呢?

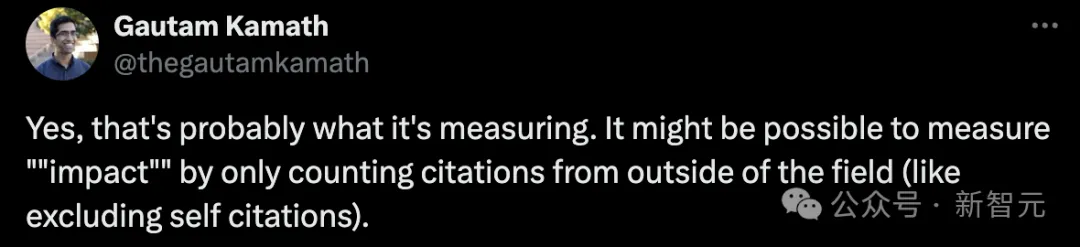

對(duì)此,Gautam Kamath稱,是的這就是谷歌正在衡量的因素。我覺得這里有一個(gè)更好的衡量「影響力」的方法——只計(jì)算來自本領(lǐng)域外的引用(類似于排除「自引」)。

另有網(wǎng)友粗略計(jì)算了下,14個(gè)頂會(huì)中,僅有4個(gè)不收取出版費(fèi)用。當(dāng)然,雖然沒有出版費(fèi)用,但參加會(huì)議仍有其他相關(guān)費(fèi)用,而且根據(jù)提交論文的數(shù)量等因素而變化。

TOP 100名單

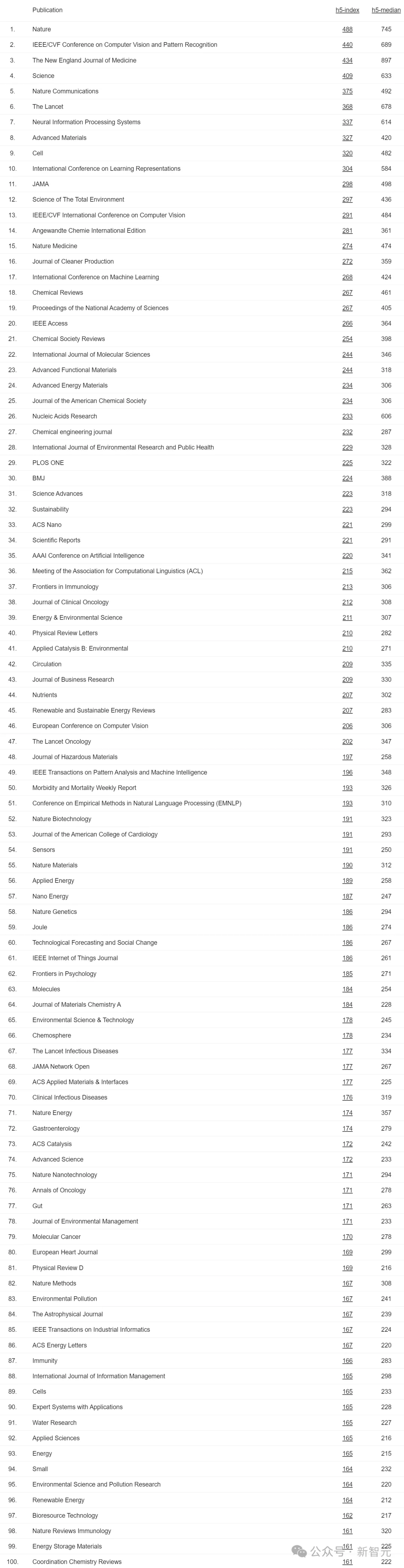

今年谷歌學(xué)術(shù)指標(biāo)中,所有TOP 100名單如下: