北大字節VAR獲最佳論文、廈大清華獲亞軍,NeurIPS 2024最佳論文出爐

剛剛,人工智能頂會 NeurIPS 公布了今年的最佳論文(包括 Best Paper 和 Best Paper Runner-up,大會注冊者可以看到)。

一共有兩篇論文獲得最佳論文獎:

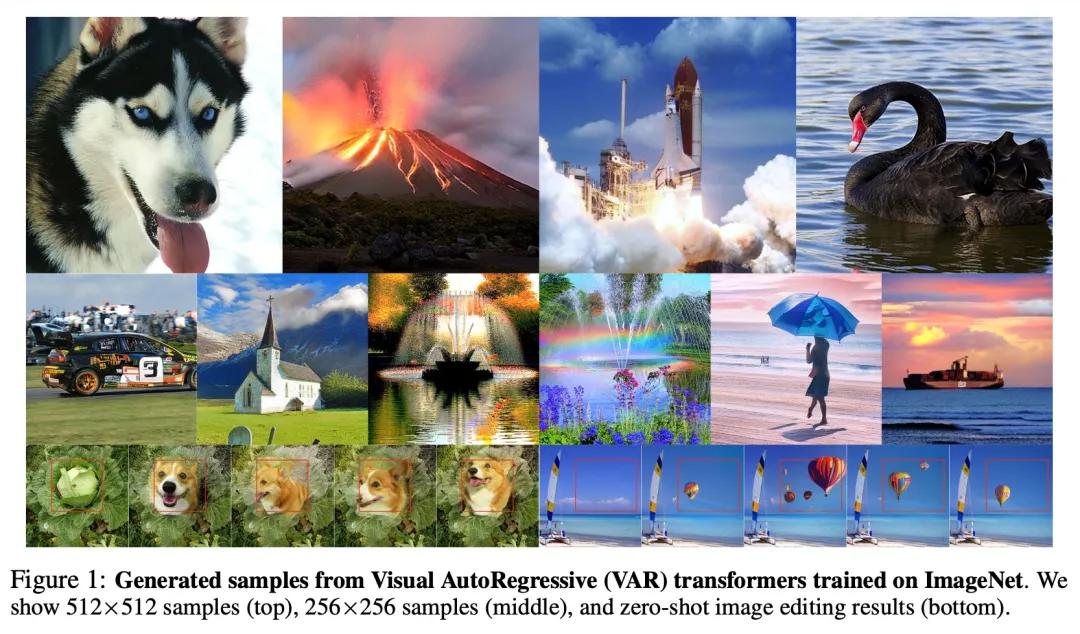

一是由北京大學、字節跳動研究者共同完成的《Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction》(視覺自回歸建模:通過 Next-Scale 預測生成可擴展圖像),論文一作為田柯宇(此前因涉攻擊內部大模型,被字節起訴)。

機器之心獲悉,從 2023 年開始,字節商業化技術團隊就在研究圖像生成的自回歸模型,一直將 VAR 作為高優項目推進,不僅安排多名研究人員重點攻關此技術方向,還投入大量算力資源支持模型訓練和實驗。該團隊近期將發布新的 VAR T2I 模型研究成果,并將對模型開源。

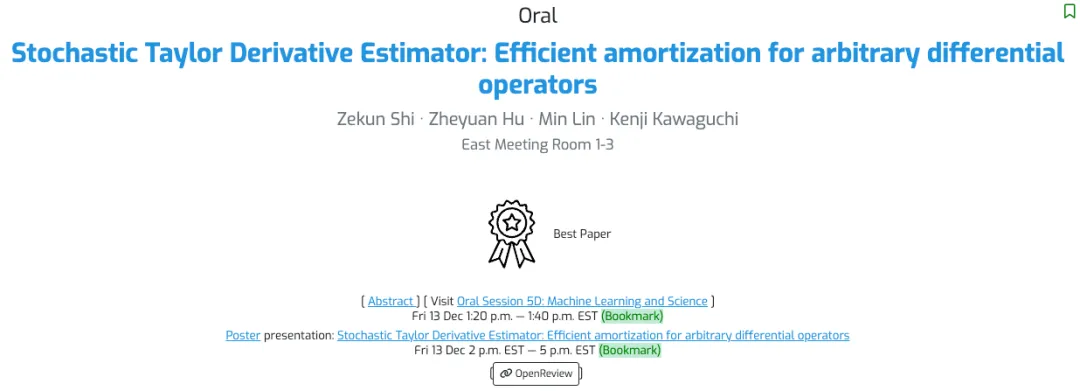

二是由新加坡國立大學、 Sea AI Lab 研究者共同完成的《Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators》(隨機泰勒導數估計器:任意微分算子的有效攤銷),論文一作為 Zekun Shi。

此外,還有兩篇論文獲得了最佳論文亞軍(Best Paper Runner-up):

由廈門大學、清華大學、微軟研究者共同完成的《Not All Tokens Are What You Need for Pretraining》(并非所有 token 都是預訓練所需的), Zhenghao Lin 和 Zhibin Gou(茍志斌)為共同一作。

由英偉達和阿爾托大學共同完成的《Guiding a Diffusion Model with a Bad Version of Itself》(使用擴散模型的一個糟糕版本引導其自身),論文一作為 Tero Karras。

NeurIPS 2024 將于 12 月 10 日星期二至 12 月 15 日星期日在溫哥華舉辦。本屆共收到 15671 篇有效論文投稿,比去年又增長了 27%,但最終接收率低于 2023 年,僅有 25.8%。最佳論文的公布提前引爆了有關此次大會的討論。

以下是獲獎論文的詳細信息:

最佳論文

論文 1:Visual Autoregressive Modeling: Scalable Image Generation via Next-Scale Prediction

- 作者:Keyu Tian, Yi Jiang, Zehuan Yuan, Bingyue Peng, Liwei Wang

- 機構:北京大學、字節跳動

- 論文地址:https://arxiv.org/pdf/2404.02905

- 項目地址:https://github.com/FoundationVision/VAR

論文簡介:在自然語言處理中,以 GPT、LLaMa 系列等大語言模型為例的 Autoregressive(自回歸模型已經取得了較大的成功,尤其擴展定律(Scaling Law)和零樣本任務泛化能力(Zero-shot Task Generalizability)十分亮眼,初步展示出通往「通用人工智能 AGI」的潛力。

然而在圖像生成領域中,自回歸模型卻廣泛落后于擴散(Diffusion)模型:DALL-E、Stable Diffusion、Sora 等模型均屬于 Diffusion 家族。

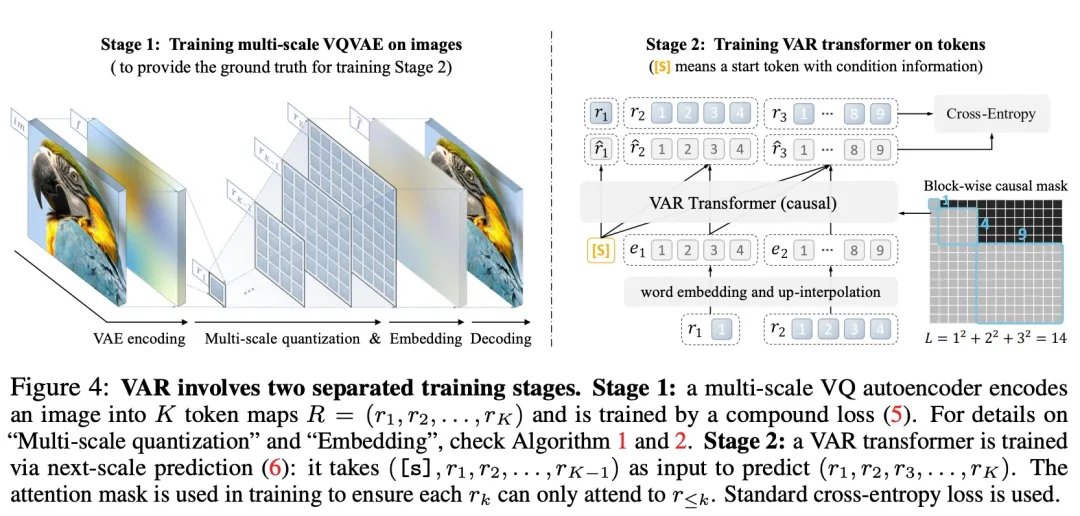

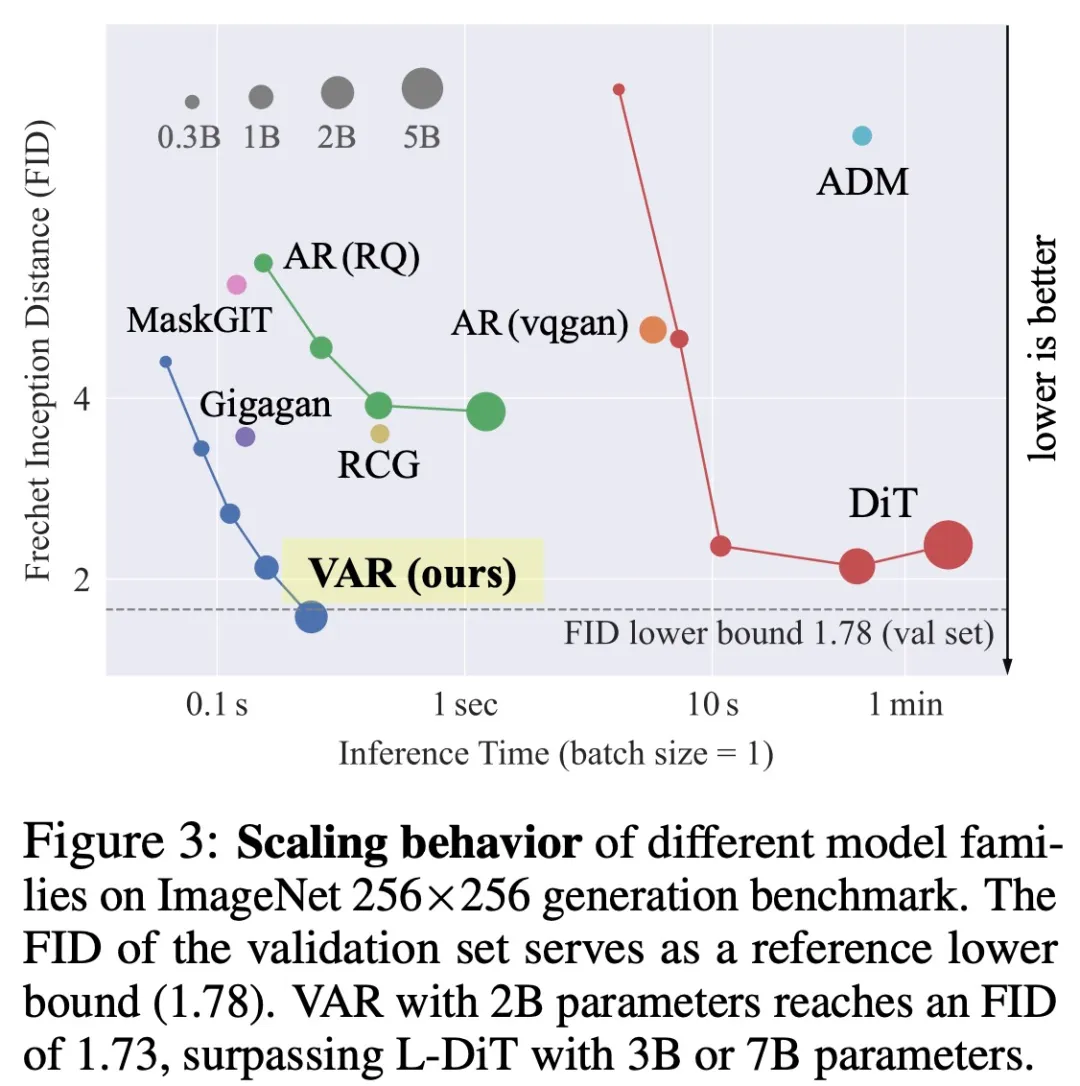

為了「解鎖」自回歸模型的能力和 Scaling Laws,研究團隊從圖像模態內在本質出發,模仿人類處理圖像的邏輯順序,提出一套全新的「視覺自回歸」生成范式:VAR, Visual AutoRegressive Modeling,首次使得 GPT 風格的自回歸視覺生成,在效果、速度、Scaling 能力多方面超越 Diffusion,迎來了視覺生成領域的 Scaling Laws。

VAR 為如何定義圖像的自回歸順序提供了一個全新的視角,即由粗到細、由全局輪廓到局部精調的順序。在符合直覺的同時,這樣的自回歸算法帶來了很好的效果:VAR 顯著提升了自回歸模型的速度和生成質量,在多方面使得自回歸模型首次超越擴散模型。同時 VAR 展現出類似 LLM 的 Scaling Laws 和零樣本任務泛化能力。

論文 2:Stochastic Taylor Derivative Estimator: Efficient amortization for arbitrary differential operators

- 作者:Zekun Shi, Zheyuan Hu, Min Lin, Kenji Kawaguchi

- 機構:新加坡國立大學、 Sea AI Lab

- 論文地址:https://arxiv.org/abs/2412.00088

- 項目地址:https://github.com/sail-sg/stde

論文簡介:使用包含高維和高階微分算子的損失函數來優化神經網絡是非常昂貴的,因為反向傳播中導數張量的大小按 縮放,計算圖中的計算按

縮放,計算圖中的計算按 縮放,其中,d 是域的維度,L 是前向計算圖中操作的數量,k 是導數的階數。

縮放,其中,d 是域的維度,L 是前向計算圖中操作的數量,k 是導數的階數。

在之前的研究中,d 中多項式縮放是通過隨機化在優化過程中平攤計算來解決的。另外,單變量函數(d = 1)中 k 的指數縮放通過高階自動微分(AD)解決。

本研究展示了如何通過正確構造單變量高階 AD 輸入切線(input tangent),有效地對多元函數的任意階導數張量進行任意收縮,這可用于有效地隨機化任何微分算子。

當應用于 PINN( Physics-Informed Neural Networks )時,與使用一階 AD 進行隨機化相比,本文方法提供了 1000 倍以上的速度提升和 30 倍以上的內存減少,而且現在可以在單個 NVIDIA A100 GPU 上在 8 分鐘內解決 100 萬維 PDE。這項工作開啟了在大規模問題中使用高階微分算子的可能性。

最佳論文亞軍(Best Paper Runner-up)

論文 1:Not All Tokens Are What You Need for Pretraining

- 作者:Zhenghao Lin, Zhibin Gou, Yeyun Gong, Xiao Liu, yelong shen, Ruochen Xu, Chen Lin, Yujiu Yang, Jian Jiao, Nan Duan, Weizhu Chen

- 機構:廈門大學、清華大學、微軟

- 論文地址:https://openreview.net/pdf?id=0NMzBwqaAJ

- 項目地址:https://github.com/microsoft/rho

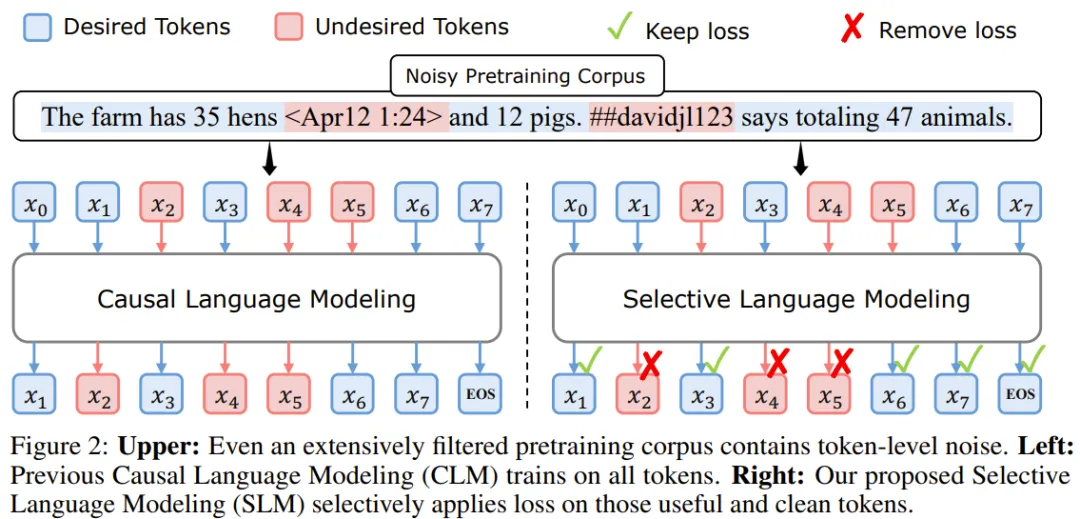

論文簡介:以前的語言模型預訓練方法會統一對所有訓練 token 應用下一個 token 預測損失。

但這一范式并非不可挑戰。這篇論文的作者首先做出了一個假設:「對于語言模型訓練,并非語料庫中的所有 token 都同等重要」。

然后,他們分析了語言模型的 token 級訓練動態,結果發現不同 token 有著不同的損失模式。

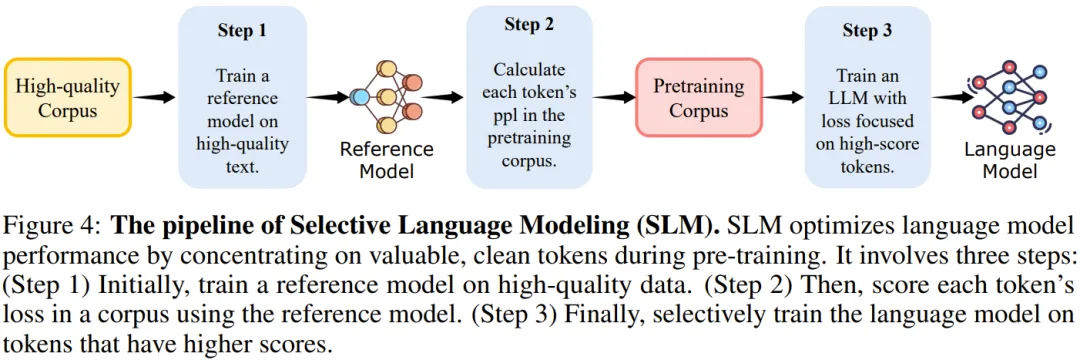

基于這些見解,他們開發了一種新模型 RHO-1。不同于傳統語言模型(會學習預測語料庫中的每一下個 token),RHO-1 采用了選擇性語言建模(SLM),它會選擇性地使用與所需分布對齊的有用 token 進行訓練。

該方法需要使用一個參考模型來給 token 評分,然后再在分數更高的 token 上使用一個重點關注損失(focused loss)來訓練模型。

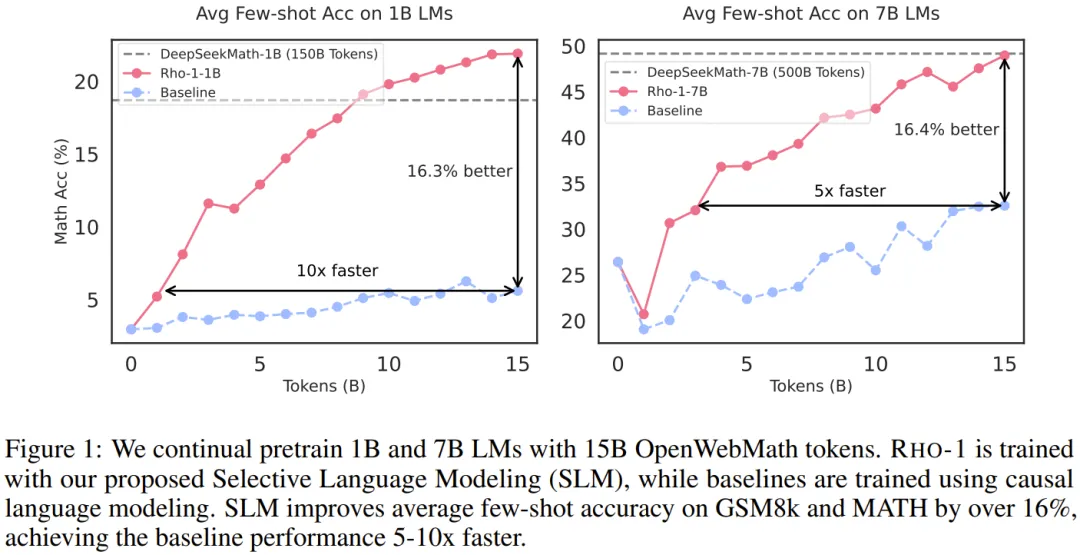

在 15B OpenWebMath 語料庫上進行持續預訓練時,RHO-1 在 9 個數學任務上的少樣本準確率實現了 30% 的絕對提升。經過微調后,RHO-1-1B 和 7B 在 MATH 數據集上分別取得了 40.6% 和 51.8% 的 SOTA 結果 —— 僅用 3% 的預訓練 token 就達到了 DeepSeekMath 相當的水平。此外,在對 80B 個通用 token 進行持續預訓練時,RHO-1 在 15 個不同任務上實現了 6.8% 的平均提升,數據效率和語言模型預訓練的性能都得到了提升。

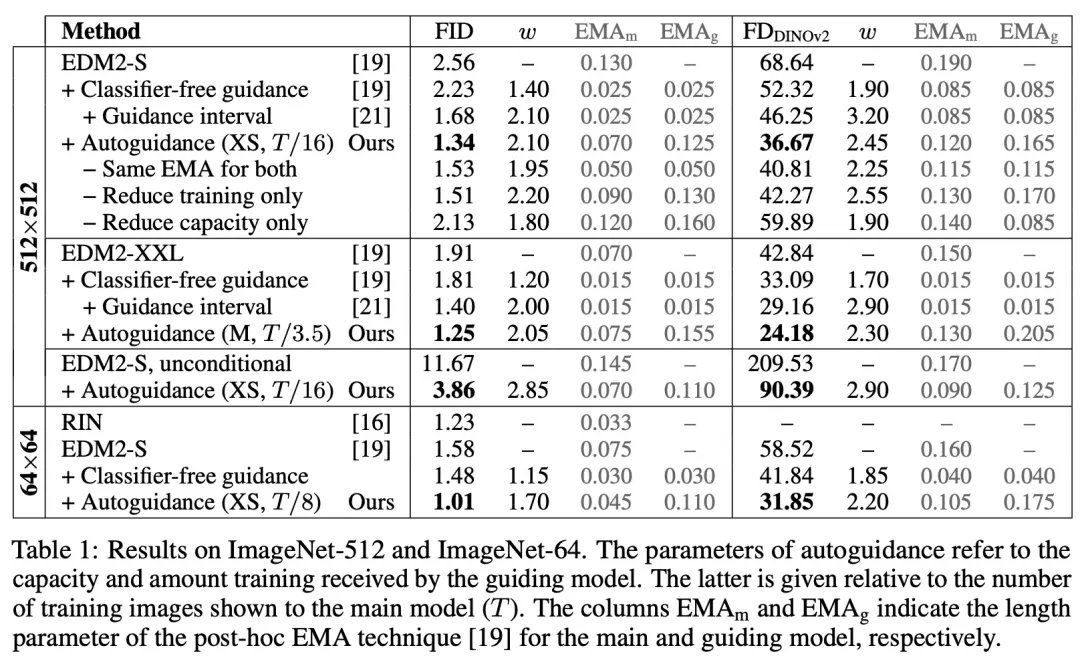

論文 2:Guiding a Diffusion Model with a Bad Version of Itself

- 作者:Tero Karras, Miika Aittala, Tuomas Kynk??nniemi, Jaakko Lehtinen, Timo Aila, Samuli Laine

- 機構:英偉達、阿爾托大學

- 論文地址:https://arxiv.org/pdf/2406.02507

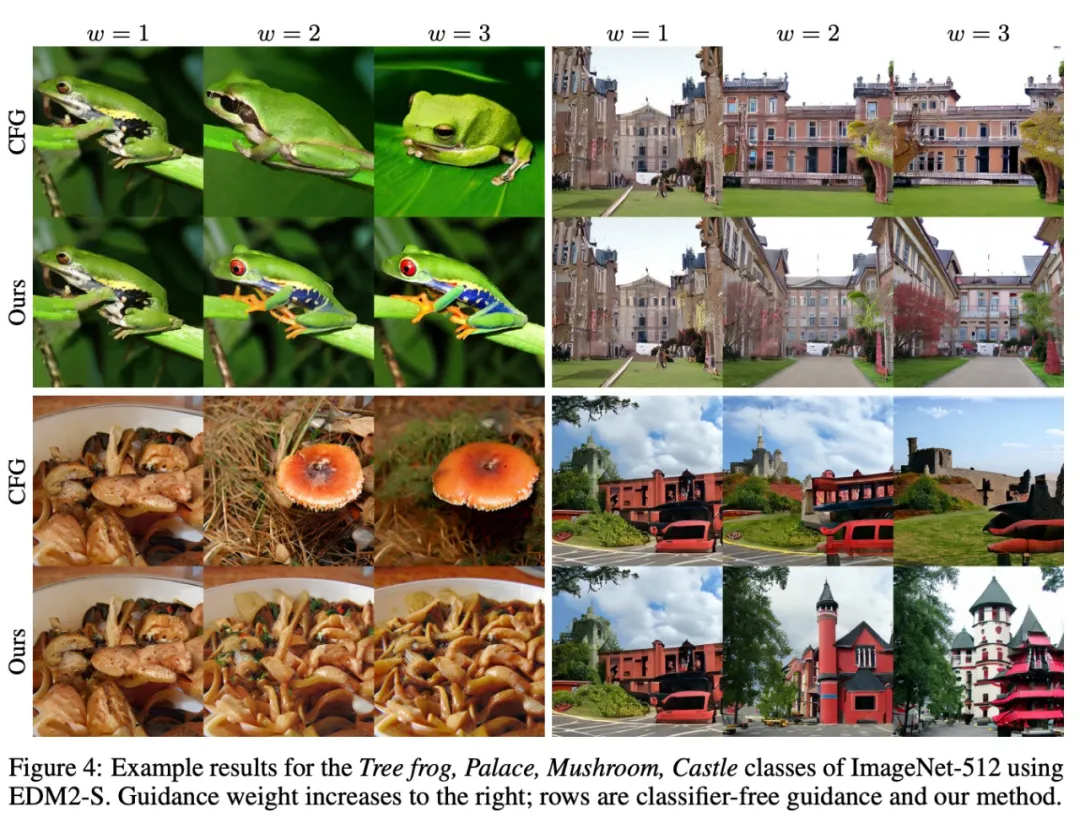

論文簡介:圖像生成擴散模型關注的核心是圖像質量、結果的多變程度以及結果與給定條件(例如類標簽或文本提示)的對齊程度。

常見的無分類器引導方法是使用無條件模型來引導條件模型,這樣既能實現更好的提示詞對齊,也能得到更高質量的圖像,但代價是多變程度下降。

這些效果似乎本質上是糾纏在一起的,因此很難控制。

基于此,該團隊得出了一個令人驚訝的觀察結果:通過使用較小、訓練較少的模型版本(而不是無條件模型)來引導生成,就可以在不影響多變程度的情況下獲得對圖像質量的控制。由此,圖像質量與多變程度就分離了。

實驗表明,這能顯著提升 ImageNet 生成效果。他們使用公開可用的網絡,為 64×64 分辨率下的生成創造了 1.01 的 FID 記錄,為 512×512 創造了 1.25 的 FID 記錄。此外,該方法也適用于無條件擴散模型,可極大提高其質量。