LLM用于時(shí)序預(yù)測(cè)真的不行,連推理能力都沒(méi)用到

語(yǔ)言模型真的能用于時(shí)序預(yù)測(cè)嗎?根據(jù)貝特里奇頭條定律(任何以問(wèn)號(hào)結(jié)尾的新聞標(biāo)題,都能夠用「不」來(lái)回答),答案應(yīng)該是否定的。事實(shí)似乎也果然如此:強(qiáng)大如斯的 LLM 并不能很好地處理時(shí)序數(shù)據(jù)。

時(shí)序,即時(shí)間序列,顧名思義,是指一組按照時(shí)間發(fā)生先后順序進(jìn)行排列的數(shù)據(jù)點(diǎn)序列。

在很多領(lǐng)域,時(shí)序分析都很關(guān)鍵,包括疾病傳播預(yù)測(cè)、零售分析、醫(yī)療和金融。在時(shí)序分析領(lǐng)域,近期不少研究者都在研究如何使用大型語(yǔ)言模型(LLM)來(lái)分類、預(yù)測(cè)和檢測(cè)時(shí)間序列中的異常。這些論文假設(shè)擅長(zhǎng)處理文本中順序依賴關(guān)系的語(yǔ)言模型也能泛化用于時(shí)間序列數(shù)據(jù)中的順序依賴關(guān)系。這個(gè)假設(shè)并不令人意外,畢竟語(yǔ)言模型是現(xiàn)在機(jī)器學(xué)習(xí)領(lǐng)域的香餑餑。

那么,語(yǔ)言模型究竟能給傳統(tǒng)時(shí)序任務(wù)帶去多大助益?

近日,弗吉尼亞大學(xué)和華盛頓大學(xué)一個(gè)團(tuán)隊(duì)嘗試解答了這一問(wèn)題,并最終給出了一個(gè)簡(jiǎn)單卻又重要的主張:對(duì)于時(shí)序預(yù)測(cè)任務(wù),使用語(yǔ)言模型的常用方法的表現(xiàn)都接近或劣于基本的消融方法,但前者所需的計(jì)算量比后者多幾個(gè)數(shù)量級(jí)。

- 論文標(biāo)題:Are Language Models Actually Useful for Time Series Forecasting?

- 論文地址:https://arxiv.org/pdf/2406.16964

這些發(fā)現(xiàn)是該團(tuán)隊(duì)通過(guò)大量消融研究得到的,其中揭示出當(dāng)前時(shí)序預(yù)測(cè)研究中存在一個(gè)「令人擔(dān)憂的趨勢(shì)」。

但該團(tuán)隊(duì)也表示:「我們的目標(biāo)并不是暗示語(yǔ)言模型永遠(yuǎn)無(wú)法用于時(shí)間序列。」事實(shí)上,近期一些研究表明語(yǔ)言和時(shí)間序列之間具有很好的互動(dòng)潛力,可以處理時(shí)間序列推理和社交理解等任務(wù)。

相反,他們的目標(biāo)是強(qiáng)調(diào)這一驚人發(fā)現(xiàn):對(duì)于已有的時(shí)間序列任務(wù),現(xiàn)有方法幾乎沒(méi)有用到預(yù)訓(xùn)練語(yǔ)言模型那與生俱來(lái)的推理能力。

實(shí)驗(yàn)設(shè)置

該團(tuán)隊(duì)使用了三種最先進(jìn)的時(shí)間序列預(yù)測(cè)方法,并為 LLM 提出了三種消融方法:w/o LLM、LLM2Attn、LLM2Trsf。

為了評(píng)估 LLM 在時(shí)間序列預(yù)測(cè)任務(wù)上的有效性,他們?cè)?8 個(gè)標(biāo)準(zhǔn)數(shù)據(jù)集上對(duì)這些方法進(jìn)行了測(cè)試。

用于語(yǔ)言模型和時(shí)間序列的參考方法

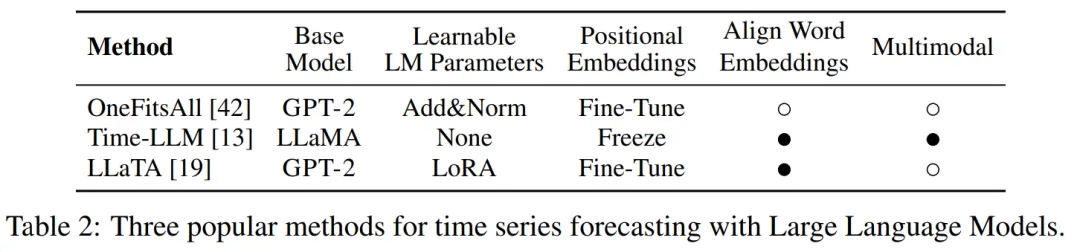

他們實(shí)驗(yàn)了三種近期的使用 LLM 進(jìn)行時(shí)間序列預(yù)測(cè)的方法。見表 2,這些方法使用的基礎(chǔ)模型為 GPT-2 或 LLaMA,同時(shí)使用了不同的對(duì)齊和微調(diào)策略。

OneFitsAll:OneFitsAll(有時(shí)也被稱為 GPT4TS)方法會(huì)先對(duì)輸入時(shí)間序列使用實(shí)例歸一化和 patching 技術(shù),然后將其饋送給一個(gè)線性層,以獲得用于語(yǔ)言模型的輸入表征。在訓(xùn)練期間,語(yǔ)言模型的多頭注意力和前饋層會(huì)被凍結(jié),而位置嵌入和層歸一化會(huì)得到優(yōu)化。最終層的作用是將語(yǔ)言模型的最終隱藏狀態(tài)轉(zhuǎn)換成預(yù)測(cè)結(jié)果。

Time-LLM:使用 Time-LLM 時(shí),輸入時(shí)間序列會(huì)被 patching 技術(shù) token 化,并且多頭注意力會(huì)將其與詞嵌入的低維表征對(duì)齊。之后,將這個(gè)對(duì)齊過(guò)程的輸出與描述性統(tǒng)計(jì)特征的嵌入一起輸送給一個(gè)凍結(jié)的預(yù)訓(xùn)練語(yǔ)言模型。然后,將該語(yǔ)言模型的輸出表征展平,并使其通過(guò)一個(gè)線性層,從而得到預(yù)測(cè)結(jié)果。

LLaTA:LLaTA 嵌入輸入時(shí)間序列的方式是將每個(gè)通道都視為一個(gè) token。該架構(gòu)的一半是「文本分支」,其使用交叉注意力來(lái)將時(shí)間序列表征與語(yǔ)言模型的詞嵌入的低維表征對(duì)齊。然后將該表征傳遞給一個(gè)凍結(jié)的預(yù)訓(xùn)練語(yǔ)言模型,得到一個(gè)「文本式預(yù)測(cè)」。同時(shí),該架構(gòu)的「時(shí)間」分支會(huì)基于輸入時(shí)間序列為預(yù)訓(xùn)練語(yǔ)言模型學(xué)習(xí)一個(gè)低秩適應(yīng)器,從而得到一個(gè)用于推理的「時(shí)間預(yù)測(cè)」。該模型包含考慮這些表征之間的相似度的額外損失項(xiàng)。

該團(tuán)隊(duì)提出的消融方法

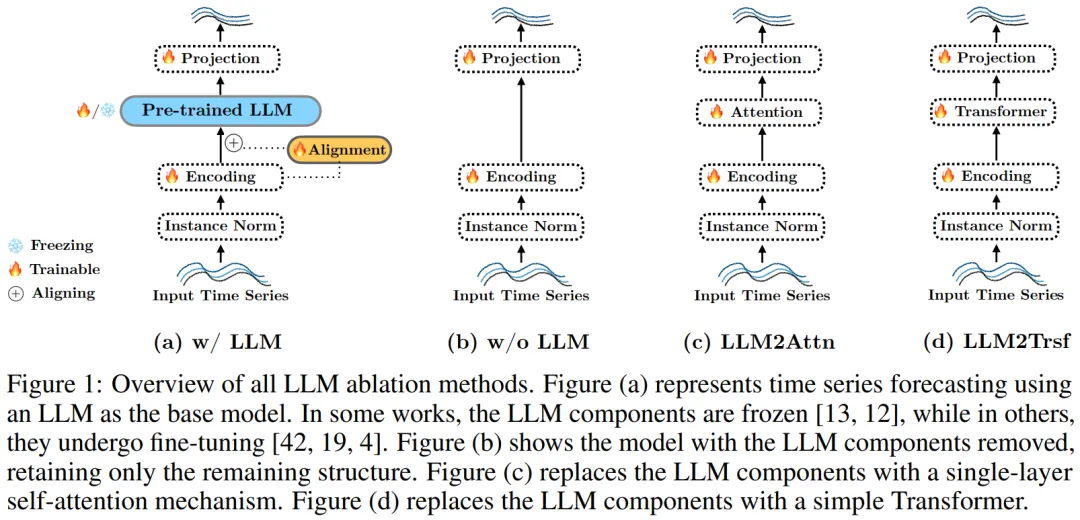

對(duì)于基于 LLM 的預(yù)測(cè)器,為了將 LLM 的影響隔離開,該團(tuán)隊(duì)提出了三種消融方法:移除 LLM 組件或?qū)⑵涮鎿Q成一個(gè)簡(jiǎn)單模塊。

具體來(lái)說(shuō),對(duì)于上述三種方法中的每一種,他們都進(jìn)行了以下三項(xiàng)修改:

w/o LLM,見圖 1b。完全移除語(yǔ)言模型,直接將輸入 token 傳遞給參考方法的最終層。

LLM2Attn,見圖 1c。將語(yǔ)言模型替換成單個(gè)隨機(jī)初始化的多頭注意力層。

LLM2Trsf,見圖 1d。將語(yǔ)言模型替換成單個(gè)隨機(jī)初始化的 Transformer 模塊。

在上述消融研究中,預(yù)測(cè)器的其余部分都保持不變(可訓(xùn)練)。比如,如圖 1b 所示,在移除了 LLM 之后,輸入編碼會(huì)被直接傳遞給輸出映射。而如圖 1c 和 1d 所示,在將 LLM 替換成注意力或 Transformer 后,它們會(huì)與原始方法的剩余結(jié)構(gòu)一起獲得訓(xùn)練。

數(shù)據(jù)集和評(píng)估指標(biāo)

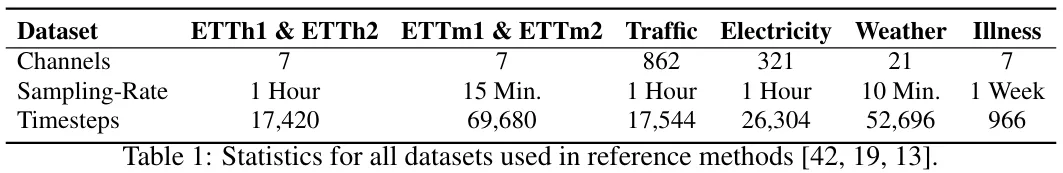

基準(zhǔn)數(shù)據(jù)集。評(píng)估使用了以下真實(shí)世界數(shù)據(jù)集:ETT(其包含 4 個(gè)子集:ETTm1、ETTm2、ETTh1、ETTh2)、Illness、Weather、Traffic、Electricity。表 1 給出了這些數(shù)據(jù)集的統(tǒng)計(jì)情況。另外還有 Exchange Rate、Covid Deaths、Taxi (30 min)、NN5 (Daily) 和 FRED-MD。

評(píng)估指標(biāo)。該研究報(bào)告的評(píng)估指標(biāo)是預(yù)測(cè)時(shí)序值和真實(shí)時(shí)序值之間的平均絕對(duì)誤差(MAE)和均方誤差(MSE)。

結(jié)果

具體來(lái)說(shuō),該團(tuán)隊(duì)探究了以下研究問(wèn)題(RQ):

- (RQ1)預(yù)訓(xùn)練語(yǔ)言模型是否有助于提升預(yù)測(cè)性能?

- (RQ2)基于 LLM 的方法是否值得其消耗的計(jì)算成本?

- (RQ3)語(yǔ)言模型預(yù)訓(xùn)練是否有助于執(zhí)行預(yù)測(cè)任務(wù)的性能?

- (RQ4)LLM 能否表征時(shí)間序列中的順序依賴關(guān)系?

- (RQ5)LLM 是否有助于少樣本學(xué)習(xí)?

- (RQ6)性能從何而來(lái)?

預(yù)訓(xùn)練語(yǔ)言模型是否有助于提升預(yù)測(cè)性能?(RQ1)

實(shí)驗(yàn)結(jié)果表明,預(yù)訓(xùn)練 LLM 對(duì)時(shí)間序列預(yù)測(cè)任務(wù)來(lái)說(shuō)還不是很有用。

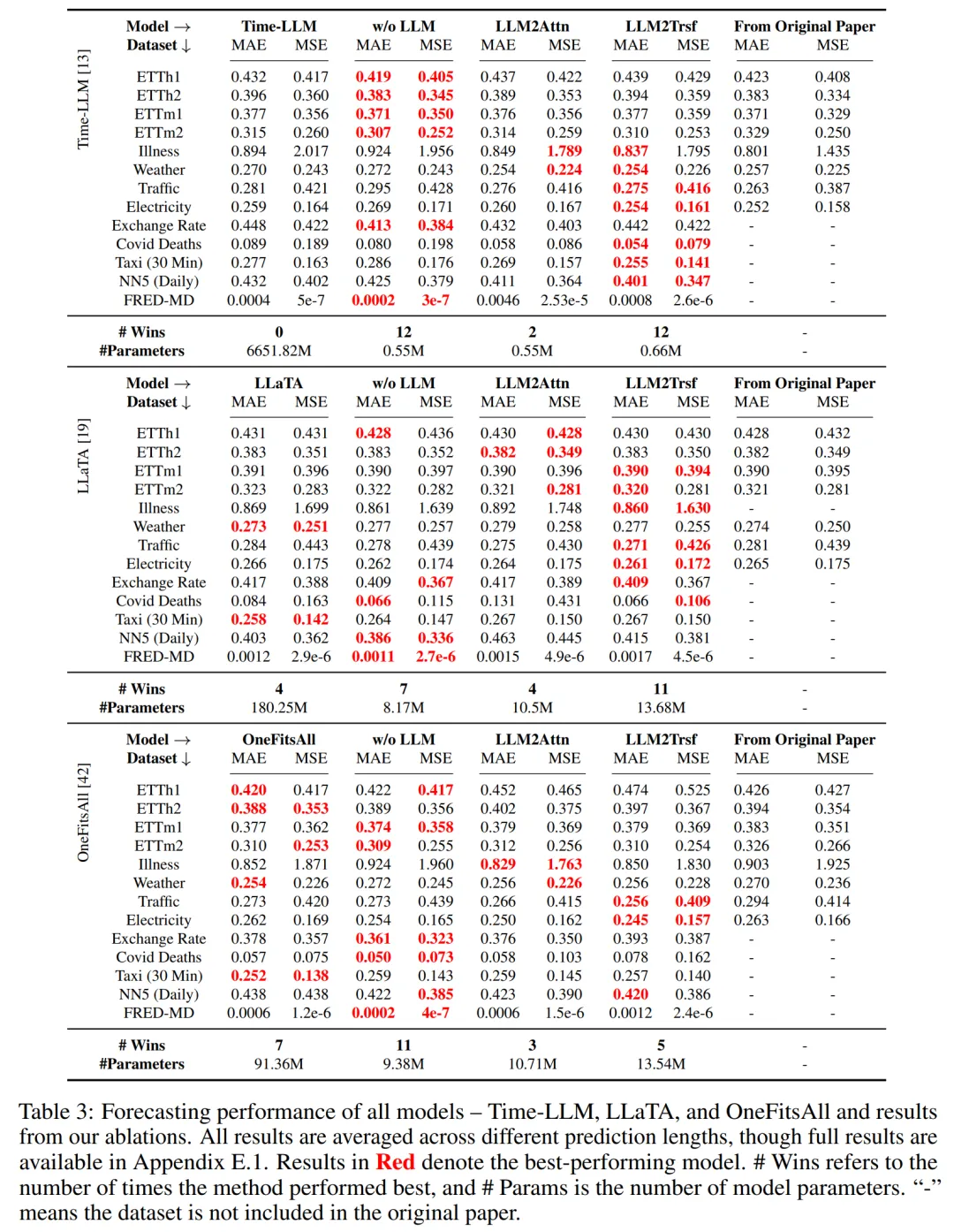

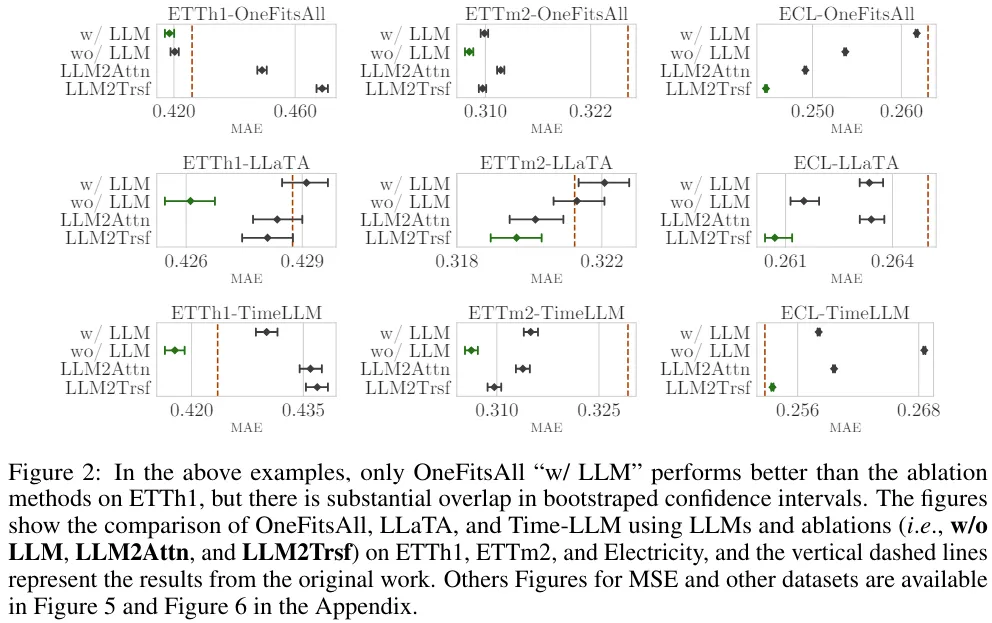

總體而言,如表 3 所示,在 8 個(gè)數(shù)據(jù)集和 2 個(gè)指標(biāo)上,消融方法在 26/26 案例中優(yōu)于 Time-LLM 方法,在 22/26 案例中優(yōu)于 LLaTA,在 19/26 案例中優(yōu)于 OneFitsAll。

總之,很難說(shuō) LLM 可以有效地用于時(shí)間序列預(yù)測(cè)。

基于 LLM 的方法是否值得其消耗的計(jì)算成本?(RQ2)

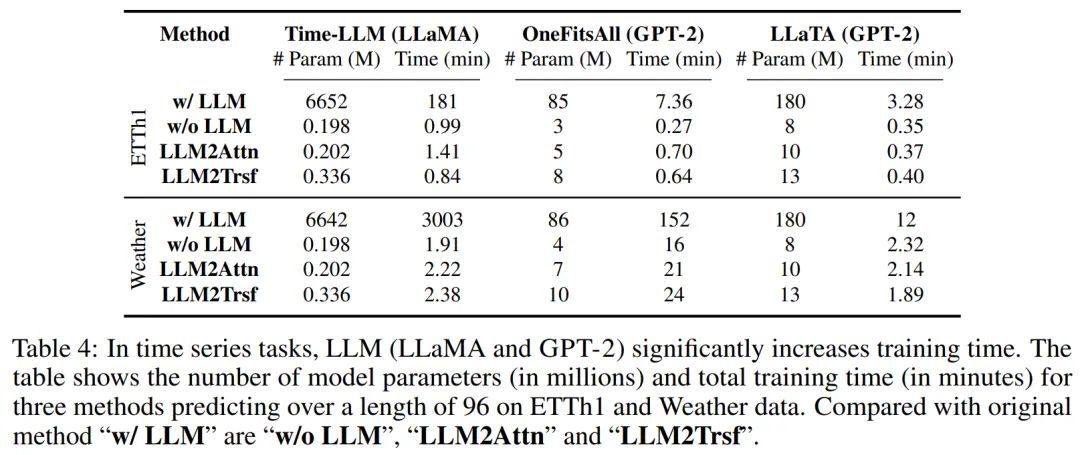

這里,根據(jù)這些方法的名義性能來(lái)評(píng)估它們的計(jì)算強(qiáng)度。參考方法中的語(yǔ)言模型使用了數(shù)億乃至數(shù)十億參數(shù)來(lái)執(zhí)行時(shí)間序列預(yù)測(cè)。即使當(dāng)這些語(yǔ)言模型的參數(shù)凍結(jié)時(shí),它們?cè)谟?xùn)練和推理時(shí)依然會(huì)有很大的計(jì)算開銷。

舉個(gè)例子,Time-LLM 有 6642 M 參數(shù),在 Weather 數(shù)據(jù)集上耗時(shí) 3003 分鐘才完成訓(xùn)練,而消融方法僅有 0.245 M 參數(shù),平均訓(xùn)練時(shí)間僅有 2.17 分鐘。表 4 給出了在 ETTh1 和 Weather 數(shù)據(jù)集上訓(xùn)練其它方法的相關(guān)信息。

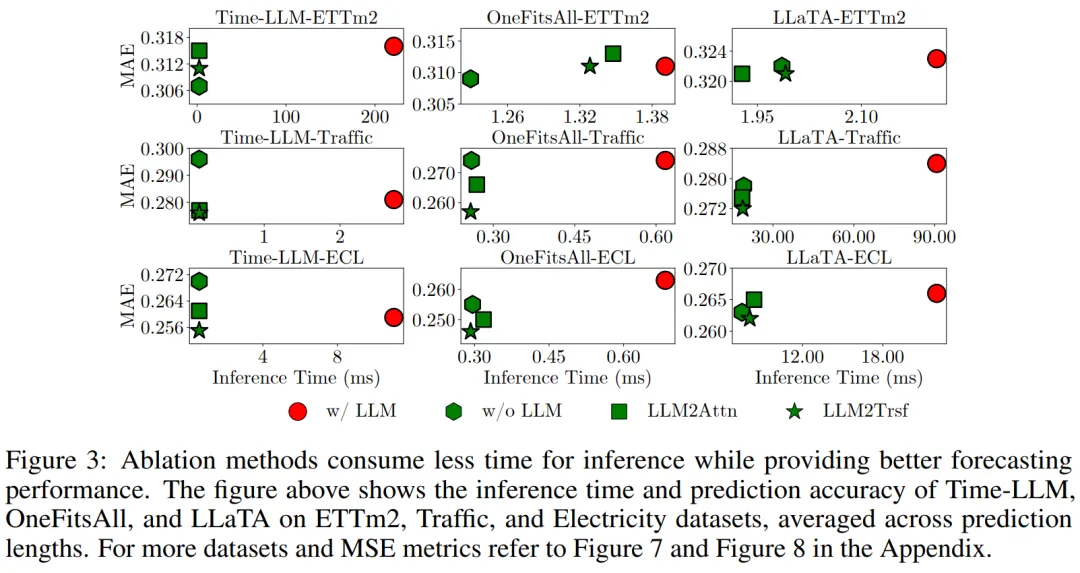

至于推理時(shí)間,這里的做法是除以最大批量大小,以估計(jì)每個(gè)示例的推理時(shí)間。平均而言,相比于修改后的模型,Time-LLM、OneFitsAl、LLaTA 所用的推理時(shí)間多 28.2、2.3、1.2 倍。

圖 3 給出了一些示例,其中綠色標(biāo)記(消融方法)通常低于紅色標(biāo)記(LLM),并且集中于左側(cè),這說(shuō)明它們計(jì)算成本更低但預(yù)測(cè)性能更好。

總之,在時(shí)間序列預(yù)測(cè)任務(wù)上,LLM 的計(jì)算強(qiáng)度無(wú)法為性能帶來(lái)相應(yīng)的提升。

語(yǔ)言模型預(yù)訓(xùn)練是否有助于執(zhí)行預(yù)測(cè)任務(wù)的性能?(RQ3)

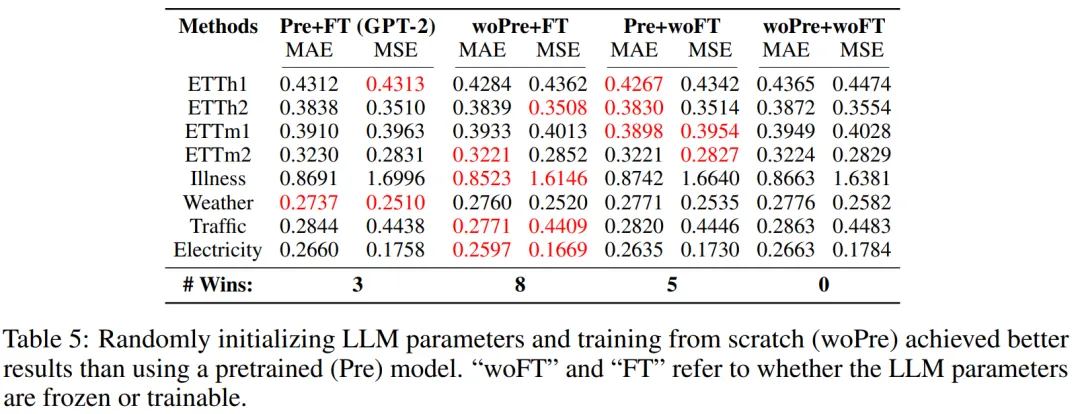

評(píng)估結(jié)果表明,對(duì)于時(shí)間序列預(yù)測(cè)任務(wù)而言,使用大型數(shù)據(jù)集進(jìn)行預(yù)訓(xùn)練實(shí)在沒(méi)有必要。為了檢驗(yàn)預(yù)訓(xùn)練期間學(xué)到的知識(shí)能否給預(yù)測(cè)性能帶來(lái)有意義的提升,該團(tuán)隊(duì)實(shí)驗(yàn)了在時(shí)間序列數(shù)據(jù)上,對(duì) LLaTA 進(jìn)行不同組合的預(yù)訓(xùn)練和微調(diào)的效果。

- 預(yù)訓(xùn)練 + 微調(diào)(Pre+FT):這是原始方法,即在時(shí)間序列數(shù)據(jù)上微調(diào)預(yù)訓(xùn)練語(yǔ)言模型。對(duì)于這里的 LLaTA,做法是凍結(jié)基礎(chǔ)語(yǔ)言模型,學(xué)習(xí)一個(gè)低秩適應(yīng)器(LoRA)。

- 隨機(jī)初始化 + 微調(diào)(woPre+FT):預(yù)訓(xùn)練得到的文本知識(shí)是否有助于時(shí)間序列預(yù)測(cè)?這里,隨機(jī)初始化語(yǔ)言模型的權(quán)重(由此清除了預(yù)訓(xùn)練的效果),再在微調(diào)數(shù)據(jù)集上從頭開始訓(xùn)練 LLM。

- 預(yù)訓(xùn)練 + 不使用微調(diào)(Pre+woFT):在時(shí)間序列數(shù)據(jù)上進(jìn)行微調(diào)又能給預(yù)測(cè)性能帶來(lái)多大提升呢?這里是凍結(jié)語(yǔ)言模型,同時(shí)放棄學(xué)習(xí) LoRA。這能反映語(yǔ)言模型自身處理時(shí)間序列的性能。

- 隨機(jī)初始化 + 無(wú)微調(diào)(woPre+woFT):很明顯,這就是將輸入時(shí)間序列隨機(jī)投射到一個(gè)預(yù)測(cè)結(jié)果。該結(jié)果被用作與其它方法進(jìn)行比較的基準(zhǔn)。

整體結(jié)果見表 5。在 8 個(gè)數(shù)據(jù)集上,依照 MAE 和 MSE 指標(biāo),「預(yù)訓(xùn)練 + 微調(diào)」有三次表現(xiàn)最佳,而「隨機(jī)初始化 + 微調(diào)」獲得了 8 次最佳。這說(shuō)明語(yǔ)言知識(shí)對(duì)時(shí)間序列預(yù)測(cè)的幫助有限。但是,「預(yù)訓(xùn)練 + 無(wú)微調(diào)」與基準(zhǔn)「隨機(jī)初始化 + 無(wú)微調(diào)」各自有 5 和 0 次最佳,這說(shuō)明語(yǔ)言知識(shí)對(duì)微調(diào)過(guò)程的幫助也不大。

總之,預(yù)訓(xùn)練得到的文本知識(shí)對(duì)時(shí)間序列預(yù)測(cè)的幫助有限。

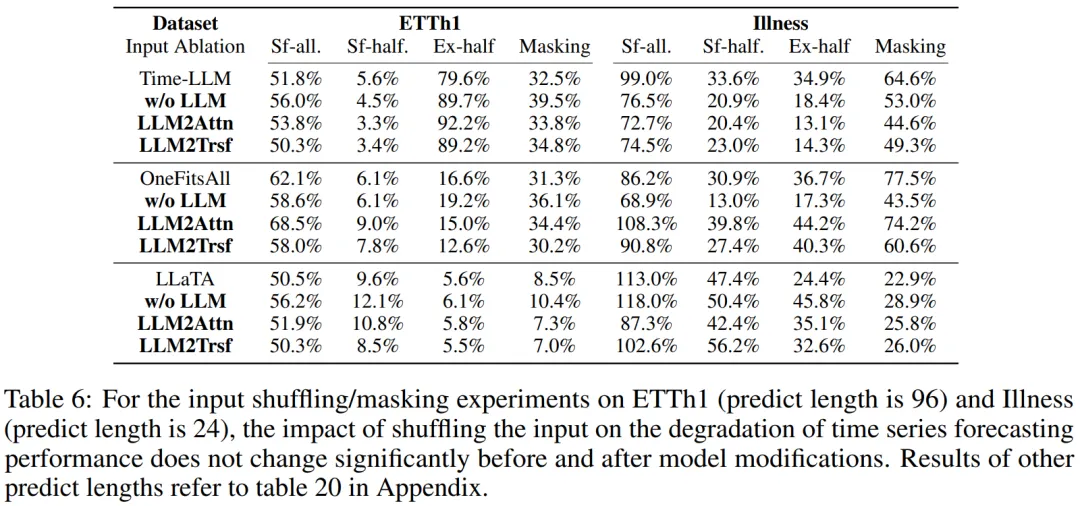

LLM 能否表征時(shí)間序列中的順序依賴關(guān)系?(RQ4)

大多數(shù)使用 LLM 來(lái)微調(diào)位置編碼的時(shí)間序列預(yù)測(cè)方法都有助于理解序列中時(shí)間步驟的位置。該團(tuán)隊(duì)預(yù)計(jì),對(duì)于一個(gè)有優(yōu)良位置表征的時(shí)間序列模型,如果將輸入的位置打亂,那么其預(yù)測(cè)性能將會(huì)大幅下降。他們實(shí)驗(yàn)了三種打亂時(shí)間序列數(shù)據(jù)的方法:隨機(jī)混洗整個(gè)序列(sf-all)、僅隨機(jī)混洗前一半序列(sf-half)、交換序列的前半和后半部分(ex-half)。結(jié)果見表 6。

輸入混洗對(duì)基于 LLM 的方法與其消融方法的影響差不太多。這說(shuō)明 LLM 在表征時(shí)間序列中的順序依賴關(guān)系方面并沒(méi)有什么突出能力。

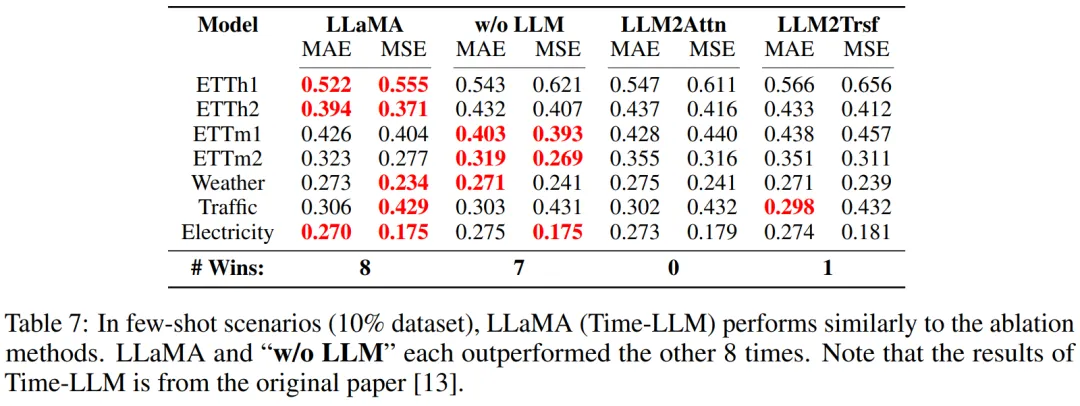

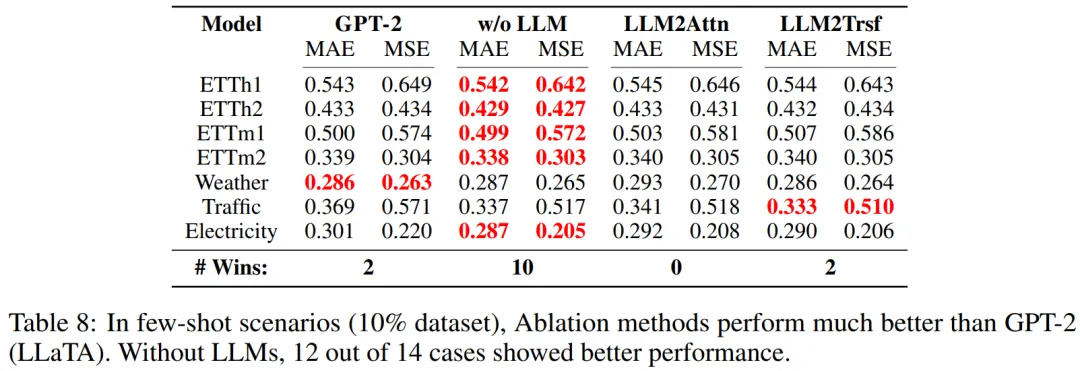

LLM 是否有助于少樣本學(xué)習(xí)?(RQ5)

評(píng)估結(jié)果表明,LLM 對(duì)少樣本學(xué)習(xí)場(chǎng)景而言意義不大。

他們的評(píng)估實(shí)驗(yàn)是取用每個(gè)數(shù)據(jù)集的 10%,再訓(xùn)練模型及其消融方法。具體來(lái)說(shuō),這里評(píng)估的是 LLaMA(Time-LLM)。結(jié)果見表 7。

可以看到,有無(wú) LLM 的表現(xiàn)差不多 —— 各自都有 8 個(gè)案例表現(xiàn)更好。該團(tuán)隊(duì)也使用基于 GPT-2 的方法 LLaTA 進(jìn)行了類似的實(shí)驗(yàn)。結(jié)果見表 8,這里消融方法在少樣本場(chǎng)景中的表現(xiàn)還優(yōu)于 LLM。

性能從何而來(lái)?(RQ6)

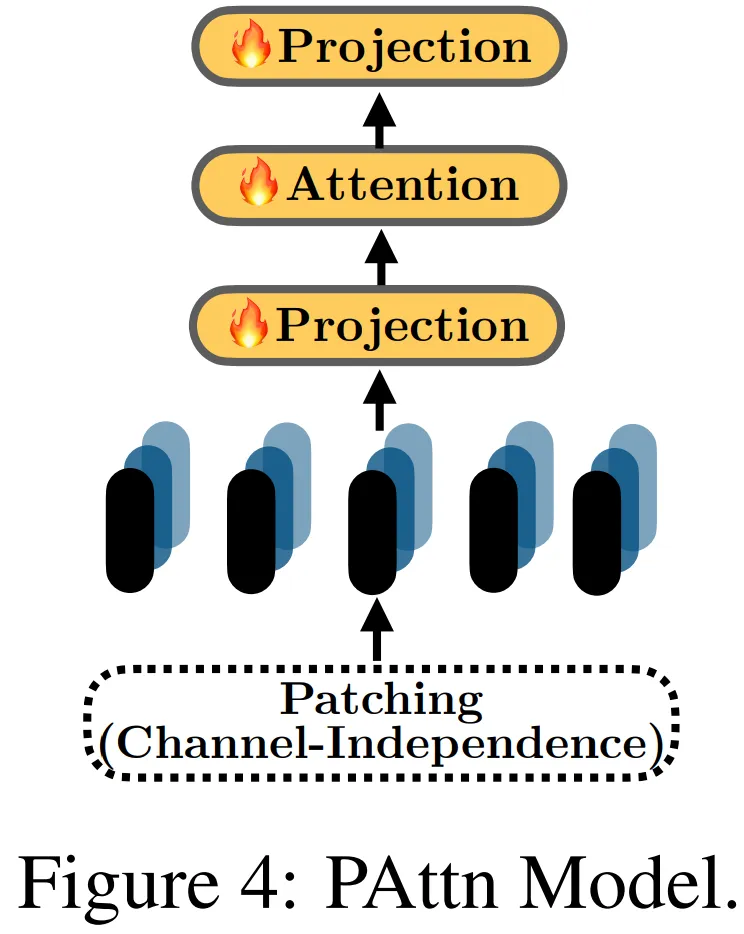

這一節(jié)評(píng)估的是 LLM 時(shí)間序列模型中常用的編碼技術(shù)。結(jié)果發(fā)現(xiàn),將 patching 和單層注意力組合起來(lái)是一種簡(jiǎn)單卻有效的選擇。

前面發(fā)現(xiàn)對(duì)基于 LLM 的方法進(jìn)行簡(jiǎn)單的消融并不會(huì)降低其性能。為了理解這一現(xiàn)象的原因,該團(tuán)隊(duì)研究了 LLM 時(shí)間序列任務(wù)中常用的一些編碼技術(shù),比如 patching 和分解。一種基本的 Transformer 模塊也可用于輔助編碼。

結(jié)果發(fā)現(xiàn),一種組合了 patching 和注意力的結(jié)構(gòu)在小數(shù)據(jù)集(時(shí)間戳少于 100 萬(wàn))上的表現(xiàn)優(yōu)于其它大部分編碼方法,甚至能與 LLM 方法媲美。

其詳細(xì)結(jié)構(gòu)如圖 4 所示,其中涉及將「實(shí)例歸一化」用于時(shí)間序列,然后進(jìn)行 patching 和投射。然后,在 patch 之間使用一層注意力進(jìn)行特征學(xué)習(xí)。對(duì)于 Traffic(約 1500 萬(wàn))和 Electricity(約 800 萬(wàn))等更大的數(shù)據(jù)集,則使用了基本 Transformer 的單層線性模型的編碼表現(xiàn)更優(yōu)。在這些方法中,最后還要使用單層線性層來(lái)投射時(shí)間序列嵌入,從而得到預(yù)測(cè)結(jié)果。

總之,patching 對(duì)編碼而言非常重要。此外,基本的注意力和 Transformer 模塊也能為編碼帶來(lái)有效助益。