LLM自學(xué)成才變身「預(yù)言家」!預(yù)測(cè)未來(lái)能力大幅提升

最近,有個(gè)爆火的話(huà)題:LLM學(xué)會(huì)教自己預(yù)測(cè)未來(lái)了!

像神秘的預(yù)言家一樣,預(yù)測(cè)未來(lái)的天氣、某部電影的票房成績(jī),甚至是股市走勢(shì),聽(tīng)起來(lái)是不是特別像科幻電影里的情節(jié)?

來(lái)自Lightning Rod Labs和倫敦政治經(jīng)濟(jì)學(xué)院的研究者對(duì)提升LLM預(yù)測(cè)未來(lái)的能力展開(kāi)了研究。

圖片

圖片

論文鏈接:https://arxiv.org/abs/2502.05253

人類(lèi)專(zhuān)家在預(yù)測(cè)時(shí),會(huì)綜合考量大量的信息,包括各種事實(shí)、發(fā)展趨勢(shì),以及相互矛盾的證據(jù)等,經(jīng)過(guò)復(fù)雜的分析和思考,才能做出較為準(zhǔn)確的預(yù)測(cè)。

在金融領(lǐng)域,準(zhǔn)確的市場(chǎng)預(yù)測(cè)能夠幫助投資者把握時(shí)機(jī),做出明智的投資決策,實(shí)現(xiàn)財(cái)富的增長(zhǎng)。

在商業(yè)領(lǐng)域,對(duì)市場(chǎng)需求和產(chǎn)品趨勢(shì)的預(yù)測(cè),能讓企業(yè)提前布局,推出更受消費(fèi)者歡迎的產(chǎn)品,占據(jù)市場(chǎng)優(yōu)勢(shì)。

為了提升LLM的預(yù)測(cè)能力,科研人員進(jìn)行了諸多嘗試,采用了數(shù)據(jù)聚合、新聞檢索、模型微調(diào)等多種方法。

這些方法在一定程度上確實(shí)提高了模型的預(yù)測(cè)性能,但它們存在一個(gè)共同的問(wèn)題——過(guò)度依賴(lài)人工整理的數(shù)據(jù)。

比如,需要借助最新的大眾預(yù)測(cè)結(jié)果,或者依賴(lài)人工篩選的內(nèi)容。而且,模型往往無(wú)法從已經(jīng)確定結(jié)果的事件中學(xué)習(xí)經(jīng)驗(yàn),實(shí)現(xiàn)自我提升。

獲取人工數(shù)據(jù)成本高昂,效率也較低,使得模型難以持續(xù)學(xué)習(xí)和進(jìn)步。

LLM的「自學(xué)秘籍」

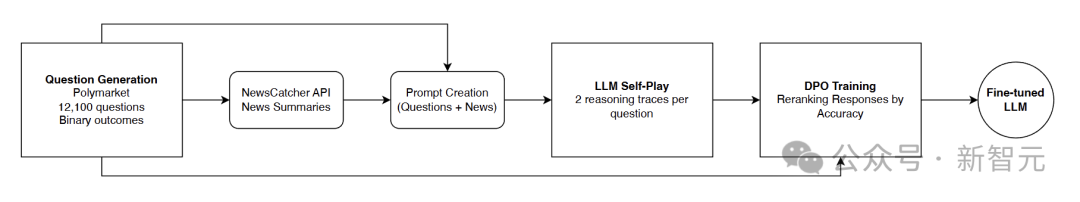

研究人員提出了一個(gè)結(jié)果驅(qū)動(dòng)的微調(diào)框架,讓LLM能夠擺脫對(duì)人工輸入的過(guò)度依賴(lài),通過(guò)自我學(xué)習(xí)來(lái)提升預(yù)測(cè)能力。

圖片

圖片

讓模型「自我博弈」,生成多樣化推理軌跡和概率預(yù)測(cè)。根據(jù)這些推理預(yù)測(cè)與實(shí)際結(jié)果的接近程度,對(duì)推理組合進(jìn)行排序。最后,利用直接偏好優(yōu)化(DPO)技術(shù)對(duì)模型進(jìn)行微調(diào)。

圖片

圖片

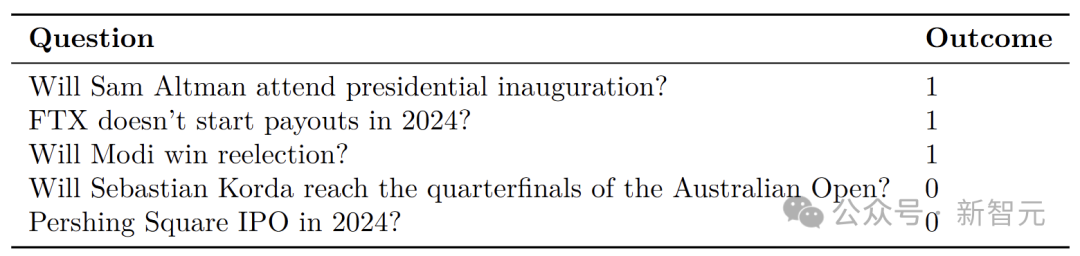

數(shù)據(jù)與新聞收集

研究人員從預(yù)測(cè)市場(chǎng)Polymarket收集了多達(dá)12100個(gè)具有二元結(jié)果的預(yù)測(cè)問(wèn)題,像「奧特曼會(huì)參加總統(tǒng)就職典禮嗎?」「FTX在2024年會(huì)停止付款嗎?」。

研究者篩選數(shù)據(jù),排除了那些結(jié)果不明確的問(wèn)題,并將剩余數(shù)據(jù)劃分為訓(xùn)練集和測(cè)試集。

訓(xùn)練集包含9800個(gè)問(wèn)題,其結(jié)果在2024年7月1日至12月15日期間確定;測(cè)試集則有2300個(gè)問(wèn)題,結(jié)果在2024年12月25日至2025年1月23日揭曉。

圖片

圖片

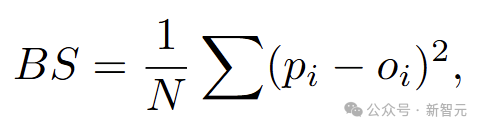

將事件未發(fā)生標(biāo)記為「0」,發(fā)生標(biāo)記為「1」。為了評(píng)估模型預(yù)測(cè)的準(zhǔn)確性,研究人員引入了Brier分?jǐn)?shù)(BS)這一指標(biāo),分?jǐn)?shù)越低,代表預(yù)測(cè)越準(zhǔn)確。

圖片

圖片

其中N代表預(yù)測(cè)問(wèn)題數(shù)量。

在答案揭曉前14天,研究人員借助NewsCatcher API收集新聞。先通過(guò)GPT-4o生成搜索查詢(xún),再利用Newscatcher等外部新聞檢索服務(wù),對(duì)相關(guān)新聞進(jìn)行聚合和處理。

這些新聞將為后續(xù)模型的自我學(xué)習(xí)和預(yù)測(cè)提供重要的支持。

模型Self-Play數(shù)據(jù)生成

研究者選用了Phi-4 14B和DeepSeek-R1 14B這兩個(gè)模型。別看參數(shù)只有14B,在一般科學(xué)和編程基準(zhǔn)測(cè)試中,表現(xiàn)十分出色。

研究人員讓這兩個(gè)模型針對(duì)每個(gè)問(wèn)題進(jìn)行推理,并給出最終的概率預(yù)測(cè)。

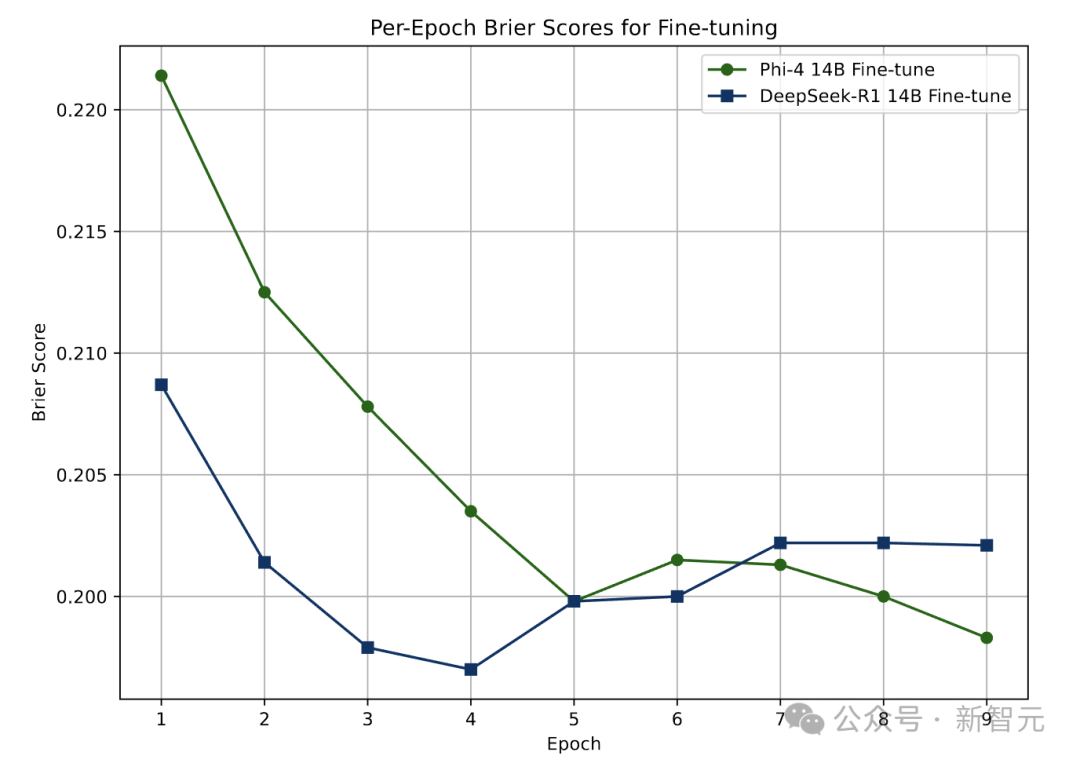

對(duì)于Phi-4 14B模型,采用scratchpad提示法,就像給它提供了一個(gè)草稿本,便于逐步展示推理過(guò)程。DeepSeek-R1 14B模型由于輸出中已有<think>標(biāo)簽,所以使用零樣本提示法。

提示內(nèi)容不僅有問(wèn)題本身,還包含收集到的新聞?wù)C總€(gè)問(wèn)題都會(huì)生成一對(duì)推理軌跡,具體做法是先生成一個(gè)推理和預(yù)測(cè),然后最多重新運(yùn)行四次,以獲得第二個(gè)不同的預(yù)測(cè)。若后續(xù)預(yù)測(cè)都相同,則舍棄這組預(yù)測(cè)。

最終,為9427個(gè)預(yù)測(cè)問(wèn)題,生成了18854條推理軌跡。

基于結(jié)果的重新排序

生成推理軌跡和預(yù)測(cè)結(jié)果后,需要根據(jù)預(yù)測(cè)與實(shí)際結(jié)果的接近程度進(jìn)行重新排序。

研究人員定義了一個(gè)排序指標(biāo),通過(guò)計(jì)算預(yù)測(cè)概率與實(shí)際結(jié)果的絕對(duì)差值來(lái)衡量?jī)烧叩慕咏潭取?/span>

例如,若實(shí)際結(jié)果為0,一個(gè)預(yù)測(cè)概率是4%,另一個(gè)是8%,那么概率為4%的預(yù)測(cè)推理軌跡排名更高。這樣,模型就知道哪些推理方式能帶來(lái)更準(zhǔn)確的預(yù)測(cè)。

此外,為了排除新聞聚合信息對(duì)排序的影響,研究人員還微調(diào)了一組標(biāo)簽隨機(jī)化的控制模型,通過(guò)對(duì)比,來(lái)確定模型的學(xué)習(xí)效果是否源于更準(zhǔn)確的預(yù)測(cè)依據(jù)。

直接偏好優(yōu)化(DPO)微調(diào)

研究人員使用直接偏好優(yōu)化(DPO)方法對(duì)Phi-4 14B和DeepSeek-R1 14B進(jìn)行微調(diào)。

這種方法無(wú)需訓(xùn)練單獨(dú)的獎(jiǎng)勵(lì)模型,而是直接從模型自我博弈生成的排序推理對(duì)中學(xué)習(xí)獎(jiǎng)勵(lì)信號(hào)。即使單個(gè)預(yù)測(cè)并不完美,DPO也能通過(guò)成對(duì)比較,發(fā)現(xiàn)預(yù)測(cè)之間的細(xì)微質(zhì)量差異,系統(tǒng)地糾正偏差。

與傳統(tǒng)的監(jiān)督微調(diào)(SFT)相比,SFT依賴(lài)人工挑選的示例,并視其為完全正確,容易丟棄有價(jià)值的信息。DPO則能從所有樣本中學(xué)習(xí),顯著提高了微調(diào)過(guò)程的穩(wěn)健性和效率。

在微調(diào)過(guò)程中,研究人員使用LoRA適配器,對(duì)參數(shù)進(jìn)行了精心調(diào)整,如設(shè)置合適的學(xué)習(xí)率、使用AdamW優(yōu)化器、采用BF16混合精度等,用8個(gè)H100 GPU訓(xùn)練。

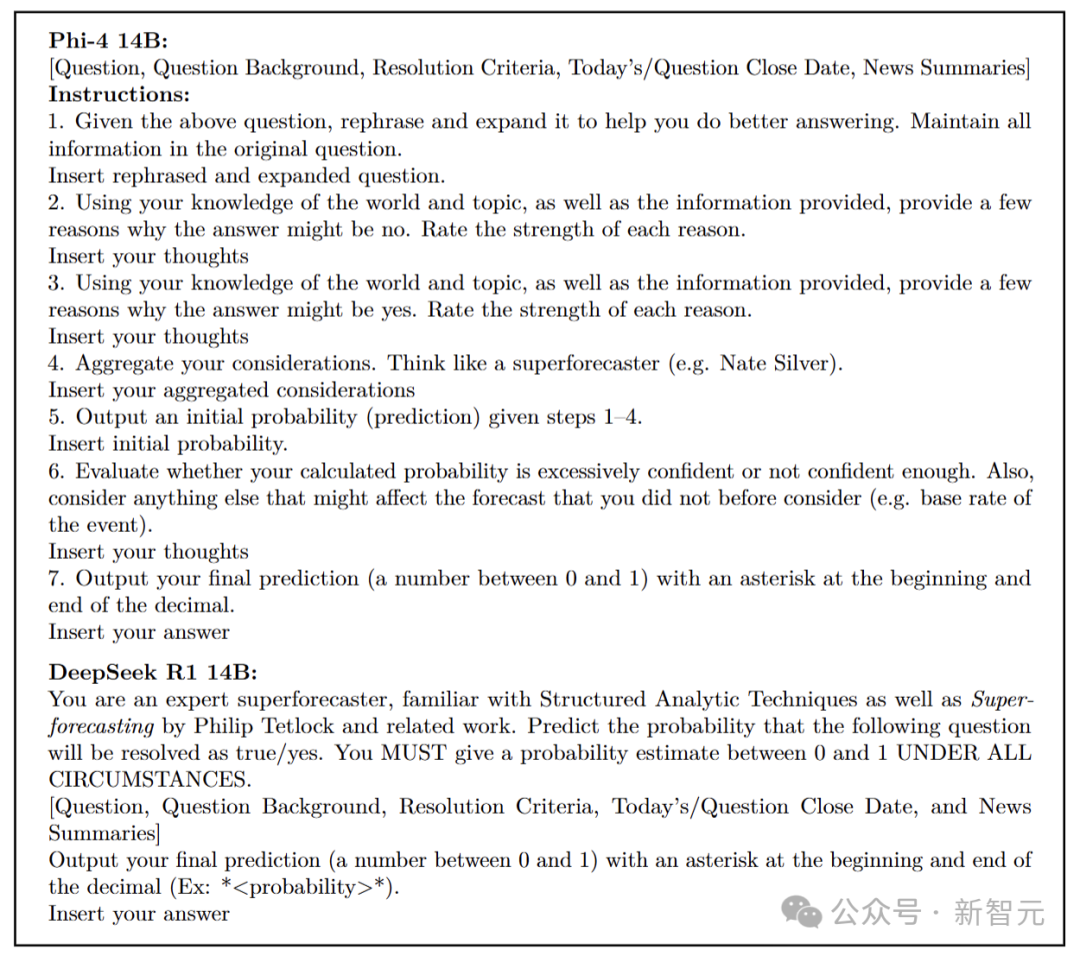

Phi-4 14B在第五輪訓(xùn)練時(shí)效果趨于穩(wěn)定,而DeepSeek-R1 14B在第四輪就達(dá)到了穩(wěn)定狀態(tài)。

圖片

圖片

最后,用一個(gè)包含2300個(gè)問(wèn)題的測(cè)試集來(lái)檢驗(yàn)?zāi)P偷膶W(xué)習(xí)成果。

這個(gè)測(cè)試集的問(wèn)題結(jié)果在訓(xùn)練集最后一個(gè)問(wèn)題結(jié)果出來(lái)10天后才揭曉,確保微調(diào)后的模型沒(méi)有接觸過(guò)與測(cè)試集相關(guān)的新聞信息,以免影響測(cè)試結(jié)果。

每個(gè)模型都以原始基礎(chǔ)模型、使用正確結(jié)果微調(diào)的模型,以及使用隨機(jī)結(jié)果微調(diào)的對(duì)照模型這三個(gè)版本參與測(cè)試。這樣可以清晰地區(qū)分模型的學(xué)習(xí)效果是源于接觸新信息,還是優(yōu)化推理過(guò)程。

在測(cè)試時(shí),針對(duì)不同模型設(shè)計(jì)了特定的提示。Phi-4 14B模型的提示就像一份詳細(xì)的任務(wù)指南,引導(dǎo)它逐步思考。DeepSeek-R1 14B模型則被設(shè)定為專(zhuān)家角色,直接進(jìn)行預(yù)測(cè)。

兩個(gè)模型都會(huì)獲得問(wèn)題、問(wèn)題背景、判斷標(biāo)準(zhǔn)、當(dāng)前日期、問(wèn)題截止日期以及最多10篇新聞文章的摘要等信息。

最終,收集了每個(gè)模型對(duì)2300個(gè)問(wèn)題的預(yù)測(cè)結(jié)果,模型均給出了有效的預(yù)測(cè)。

圖片

圖片

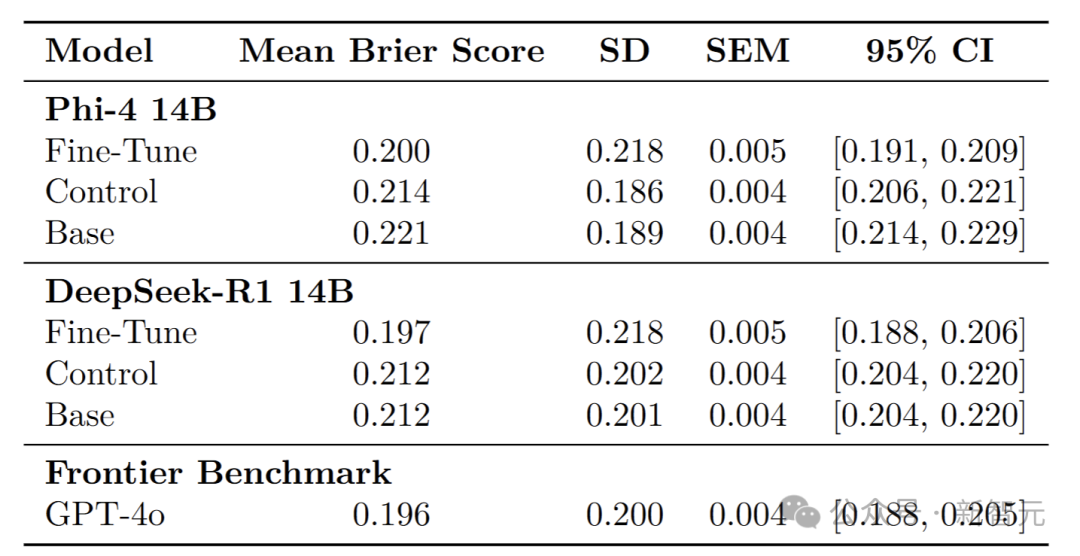

預(yù)測(cè)能力大幅提升

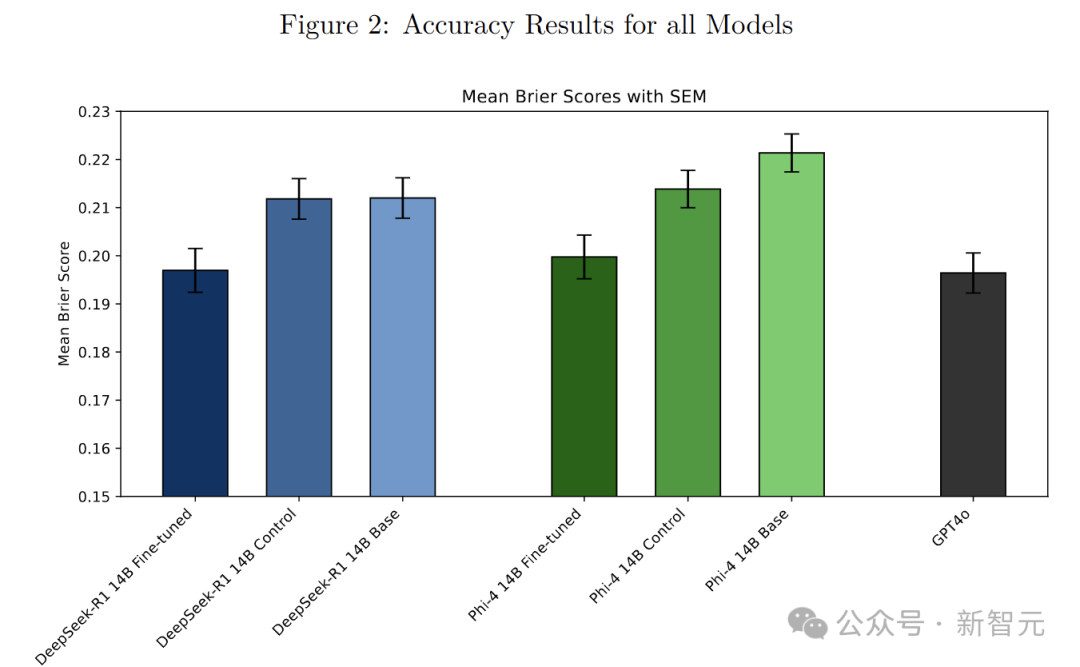

經(jīng)過(guò)這一系列操作,Phi-4 14B和DeepSeek-R1 14的預(yù)測(cè)準(zhǔn)確性有了顯著提升。

Phi-4 14B和DeepSeek-R1 14B的預(yù)測(cè)準(zhǔn)確率,比基礎(chǔ)模型以及用DPO微調(diào)但標(biāo)簽隨機(jī)化的對(duì)照模型提高了7-10%,在預(yù)測(cè)能力上能與GPT-4o這樣的大型模型相媲美。

圖片

圖片

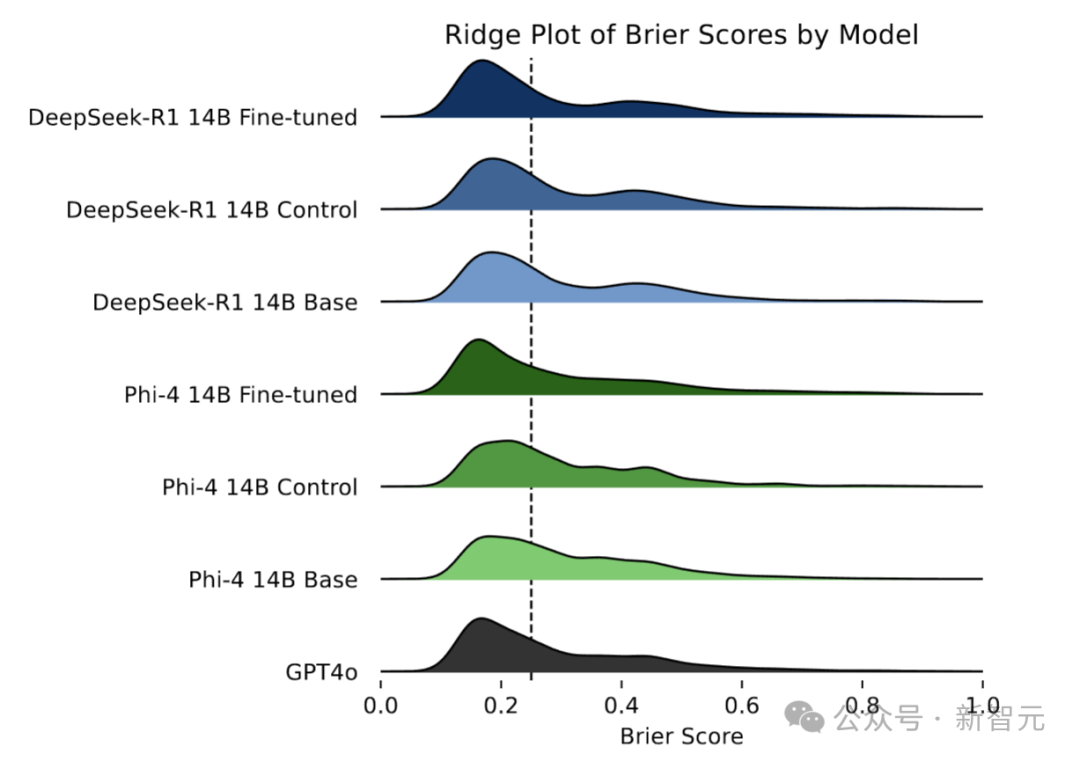

圖中展示了每個(gè)模型的Brier分?jǐn)?shù)核密度估計(jì),較低的Brier分?jǐn)?shù)表示較高的準(zhǔn)確性。

Phi-4 14B微調(diào)后的平均Brier分?jǐn)?shù)達(dá)到0.200,優(yōu)于隨機(jī)標(biāo)簽的對(duì)照模型(0.214)和基礎(chǔ)模型(0.221)。DeepSeek-R1 14B微調(diào)后的平均Brier分?jǐn)?shù)為0.197,同樣超過(guò)了其對(duì)照模型(0.212)和基礎(chǔ)模型(0.212)。

圖片

圖片

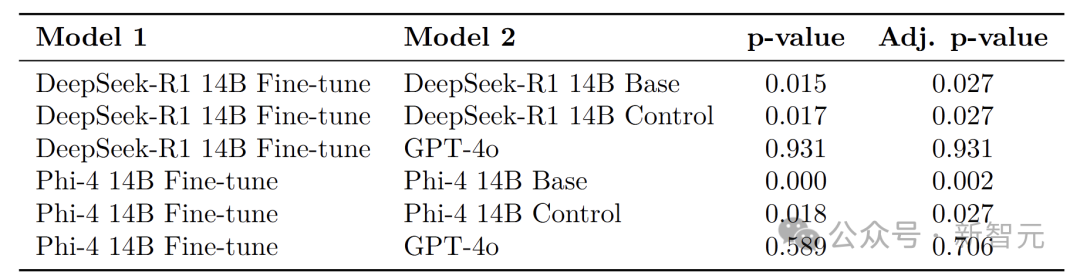

通過(guò)獨(dú)立樣本t檢驗(yàn)發(fā)現(xiàn),兩個(gè)微調(diào)后的模型在預(yù)測(cè)準(zhǔn)確性上都顯著優(yōu)于各自的基礎(chǔ)和對(duì)照模型,并且在經(jīng)過(guò)多重比較調(diào)整p值后,這一結(jié)論依然成立。

充分證明了該方法能夠切實(shí)有效地提升模型的預(yù)測(cè)性能,而且這種提升并非源于微調(diào)時(shí)接觸的額外信息。

圖片

圖片

與前沿模型GPT-4o相比,Phi-4 14B和DeepSeek-R1 14B雖然參數(shù)較少,但微調(diào)后的預(yù)測(cè)性能卻與之相當(dāng)。

在統(tǒng)計(jì)檢驗(yàn)中,微調(diào)后的模型與GPT-4o之間沒(méi)有顯著差異。

進(jìn)一步分析模型在不同問(wèn)題上的預(yù)測(cè)準(zhǔn)確性分布,可以發(fā)現(xiàn)微調(diào)后的模型雖然偶爾會(huì)出現(xiàn)一些準(zhǔn)確性極低的預(yù)測(cè)(Brier分?jǐn)?shù)高于0.5),但同時(shí)也能做出更多極其準(zhǔn)確的預(yù)測(cè)(Brier分?jǐn)?shù)低于0.05)。

以DeepSeek-R1 14B為例,微調(diào)后的模型有8.52%的問(wèn)題Brier分?jǐn)?shù)高于0.5,略高于基礎(chǔ)模型(7.48%)和對(duì)照模型(7.61%);但有32.78%的問(wèn)題Brier分?jǐn)?shù)低于 0.05,遠(yuǎn)高于基礎(chǔ)模型(23.22%)和對(duì)照模型(23.13%),Phi-4 14B也呈現(xiàn)出類(lèi)似的趨勢(shì)。

這項(xiàng)研究為L(zhǎng)LM提升預(yù)測(cè)能力開(kāi)辟了新的道路。

通過(guò)自我博弈和直接偏好優(yōu)化,LLM能在不依賴(lài)大量人工標(biāo)注數(shù)據(jù)的情況下,從實(shí)際結(jié)果中學(xué)習(xí)并改進(jìn)預(yù)測(cè),使小模型也能達(dá)到與大模型相媲美的性能,極大地提高了實(shí)用性和應(yīng)用范圍。

參考資料: