用BigDL-LLM 即刻加速百億級參數LLM推理

我們正邁入一個由大語言模型(Large Language Model, LLM)驅動的 AI 新時代,LLM在諸如客戶服務、虛擬助理、內容創作、編程輔助等各類應用中正發揮著越來越重要的作用。

然而,隨著 LLM 規模不斷擴大,運行大模型所需的資源消耗也越來越大,導致其運行也越來越慢,這給 AI 應用開發者帶來了相當大的挑戰。

為此,英特爾最近推出了一個名為BigDL-LLM[1]的大模型開源庫,可助力 AI 開發者和研究者在英特爾? 平臺上加速優化大語言模型,提升大語言模型在英特爾? 平臺上的使用體驗。

下面就展示了使用 BigDL-LLM 加速過的 330 億參數的大語言模型 Vicuna-33b-v1.3[2]在一臺搭載英特爾? 至強? 鉑金 8468 處理器的服務器上運行的實時效果。

△在一臺搭載英特爾? 至強? 鉑金 8468 處理器的服務器上運行 330 億參數大語言模型的實際速度(實時錄屏)

BigDL-LLM:英特爾? 平臺上的開源大語言模型加速庫

BigDL-LLM 是一個針對大語言模型的優化加速庫,是開源 BigDL 的一部分,通過 Apache 2.0 許可證發布。

它提供了各種低精度優化(例如 INT4/INT5/INT8),并可利用多種英特爾? CPU集成的硬件加速技術(AVX/VNNI/AMX 等)和最新的軟件優化,來賦能大語言模型在英特爾? 平臺上實現更高效的優化和更為快速的運行。

BigDL-LLM 的一大重要特性是:對基于 Hugging Face Transformers API 的模型,只需改動一行代碼即可對模型進行加速,理論上可以支持運行任何 Transformers 模型,這對熟悉 Transformers API 的開發者非常友好。

除了 Transformers API,很多人也會使用 LangChain 來開發大語言模型應用。

為此,BigDL-LLM 也提供便于使用的 LangChain 的集成[3],從而讓開發者能夠輕松使用 BigDL-LLM 來開發新應用或遷移現有的、基于 Transformers API 或 LangChain API 的應用。

此外,對于一般的 PyTorch 大語言模型(沒有使用 Transformer 或 LangChain API 的模型),也可使用 BigDL-LLM optimize_model API 一鍵加速來提升性能。詳情請參閱 GitHub README[4]以及官方文檔[5]。

BigDL-LLM 還提供了大量常用開源 LLM的加速樣例(e.g. 使用 Transformers API 的樣例[6]和使用 LangChain API 的樣例[7],以及教程(包括配套 jupyter notebooks)[8] ,方便開發者快速上手嘗試。

安裝和使用:簡便的安裝過程和易用的 API 接口

安裝 BigDL-LLM 非常簡便,只需執行如下所示的這一行命令即可。

pip install --pre --upgrade bigdl-llm[all]△若代碼顯示不全,請左右滑動

使用 BigDL-LLM對大模型進行加速也是非常容易的(這里僅用 Transformers 風格 API 進行舉例)。

使用 BigDL-LLM Transformer 風格 API 對模型加速,只需要改動模型加載部分,后續使用過程與原生 Transformers 完全一致。

而用 BigDL-LLM API 加載模型的方式與 Transformers API 也幾乎一致——用戶只需要更改 import,在 from_pretrained 參數中設置 load_in_4bit=True 即可。

BigDL-LLM 會在加載模型的過程中對模型進行 4-bit 低精度量化,并在后續推理過程中利用各種軟硬件加速技術優化其執行。

#Load Hugging Face Transformers model with INT4 optimizations

from bigdl.llm. transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained('/path/to/model/', load_in_4bit=True)△若代碼顯示不全,請左右滑動

示例:快速實現一個基于大語言模型的語音助手應用

下文將以 LLM 常見應用場景“語音助手”為例,展示采用 BigDL-LLM 快速實現 LLM 應用的案例。通常情況下,語音助手應用的工作流程分為以下兩個部分:

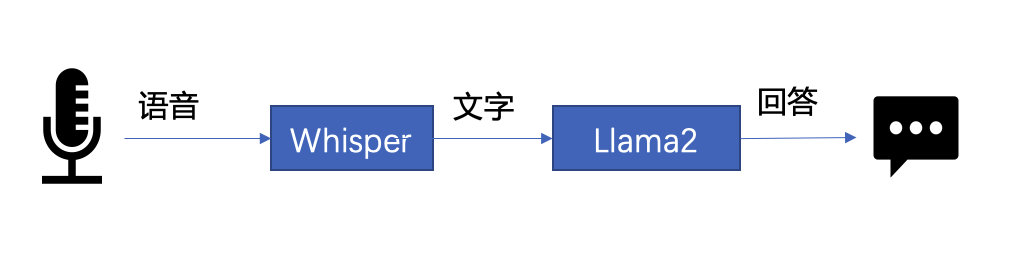

△圖 1. 語音助手工作流程示意

- 語音識別——使用語音識別模型(本示例采用了 Whisper 模型[9] )將用戶的語音轉換為文本;

- 文本生成——將 1 中輸出的文本作為提示語 (prompt),使用一個大語言模型(本示例采用了 Llama2[10] )生成回復。

以下是本文使用 BigDL-LLM 和 LangChain[11] 來搭建語音助手應用的過程:

在語音識別階段:第一步,加載預處理器 processor 和語音識別模型 recog_model。本示例中使用的識別模型 Whisper 是一個 Transformers 模型。

只需使用 BigDL-LLM 中的 AutoModelForSpeechSeq2Seq 并設置參數 load_in_4bit=True,就能夠以 INT4 精度加載并加速這一模型,從而顯著縮短模型推理用時。

#processor = WhisperProcessor .from_pretrained(recog_model_path)

recog_model = AutoModelForSpeechSeq2Seq .from_pretrained(recog_model_path, load_in_4bit=True)△若代碼顯示不全,請左右滑動

第二步,進行語音識別。首先使用處理器從輸入語音中提取輸入特征,然后使用識別模型預測 token,并再次使用處理器將 token 解碼為自然語言文本。

input_features = processor(frame_data,

sampling_rate=audio.sample_rate,

return_tensor=“pt”).input_features

predicted_ids = recogn_model.generate(input_features, forced_decoder_ids=forced_decoder_ids)

text = processor.batch_decode(predicted_ids, skip_special_tokens=True)[0]△若代碼顯示不全,請左右滑動

在文本生成階段,首先使用 BigDL-LLM 的 TransformersLLM API 創建一個 LangChain 語言模型(TransformersLLM 是在 BigDL-LLM 中定義的語言鏈 LLM 集成)。

您可以使用這個 API 加載任何一個 Hugging Face Transformers 模型。

llm = TransformersLLM . from_model_id(

model_id=llm_model_path,

model_kwargs={"temperature": 0,

"max_length": args.max_length,

"trust_remote_code": True},

)△若代碼顯示不全,請左右滑動

然后,創建一個正常的對話鏈 LLMChain,并將已經創建的 llm 設置為輸入參數。

# The following code is complete the same as the use-case

voiceassistant_chain = LLMChain(

llm=llm,

prompt=prompt,

verbose=True,

memory=ConversationBufferWindowMemory(k=2),

)△若代碼顯示不全,請左右滑動

這個鏈條將會記錄所有的對話歷史,并將對話歷史適當地格式化為大語言模型的提示語,用于生成回復。這時候只需要將識別模型生成的文本作為 “human_input” 輸入即可,代碼如下:

response_text = voiceassistant_chain .predict(human_input=text,

stop=”\n\n”)△若代碼顯示不全,請左右滑動

最后,將語音識別和文本生成步驟放入循環中,即可在多輪對話中與該“語音助手”交談。您可訪問底部 [12] 鏈接,查看完整的示例代碼,并使用自己的電腦進行嘗試。快用 BigDL-LLM 來快速搭建自己的語音助手吧!

作者簡介

英特爾公司 AI 資深架構師黃晟盛,英特爾公司 AI 框架工程師黃凱,英特爾院士、大數據技術全球 CTO、BigDL項目創始人戴金權,都在從事大數據和 AI 相關工作。