零成本突破多模態(tài)大模型瓶頸!多所美國(guó)頂尖高校華人團(tuán)隊(duì),聯(lián)合推出自增強(qiáng)技術(shù)CSR

多模態(tài)大模型展現(xiàn)出了多種多樣的能力,這些能力都通過(guò)SFT和預(yù)訓(xùn)練從龐大的訓(xùn)練數(shù)據(jù)集中學(xué)習(xí)。

但是模態(tài)之間的簡(jiǎn)單對(duì)齊可能會(huì)使得模型存在幻覺(jué),細(xì)粒度圖像感知能力差等各種問(wèn)題。

已有的多模態(tài)大模型對(duì)齊方案一般采用DPO,POVID等偏好優(yōu)化方法,或是蒸餾 GPT-4等昂貴閉源模型的方式來(lái)提升模型能力。

這些方法大多需要外源模型數(shù)據(jù),這些數(shù)據(jù)構(gòu)造存在很多問(wèn)題,一是需要昂貴的價(jià)格,二是缺乏質(zhì)量和多樣性的保證。

再者說(shuō),這真的適合需要提升模型本身的分布偏好嗎?

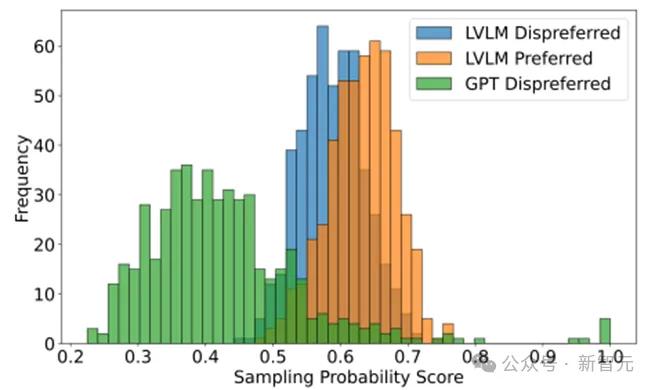

在Calibrated Self-Rewarding Vision Language Models文中,通過(guò)模型自身輸出概率證明了,外來(lái)模型構(gòu)造的偏好數(shù)據(jù)可能不適合用于模型的偏好學(xué)習(xí),相較于模型自身的response,外源模型所構(gòu)造的數(shù)據(jù)模型自己說(shuō)出的概率很小,簡(jiǎn)單來(lái)說(shuō)對(duì)于偏好數(shù)據(jù)中的負(fù)樣本模型并不會(huì)犯一樣的錯(cuò)誤,對(duì)于偏好數(shù)據(jù)中的正樣本模型也不會(huì)講出那么好的response。

這種偏好數(shù)據(jù)用于偏好學(xué)習(xí)可能會(huì)引入模型自身分布的偏差導(dǎo)致其他錯(cuò)誤,同時(shí)因?yàn)槟P妥陨碚f(shuō)同樣話的概率低,用這樣的數(shù)據(jù)來(lái)偏好學(xué)習(xí)增強(qiáng)模型收益很小。

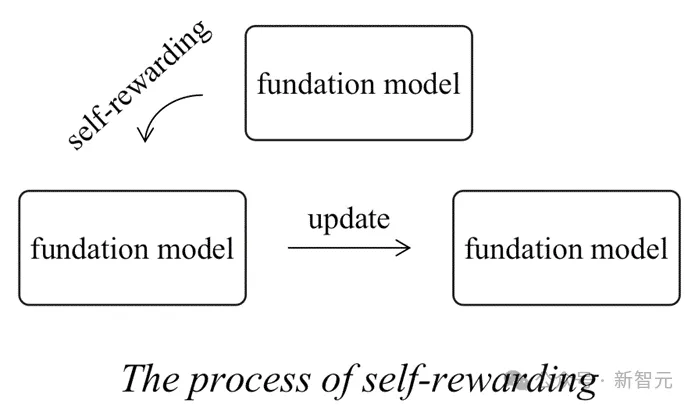

同時(shí)傳統(tǒng)純文本大模型領(lǐng)域的Self-rewarding范式存在一定缺陷。

在此前self rewarding提供reward的模型是模型自身,當(dāng)模型自身無(wú)法準(zhǔn)確分辨偏好、所具有的知識(shí)不夠強(qiáng)大的時(shí)候,它所提供的反饋可能不夠精準(zhǔn)或者沒(méi)用導(dǎo)致所更新的模型的分布無(wú)法向著目標(biāo)分布更新。

為了解決上述問(wèn)題,來(lái)自UNC ,芝加哥大學(xué),UMD和羅格斯大學(xué)的研究團(tuán)隊(duì)提出了Calibrated Self-Rewarding(CSR),多模態(tài)大模型的自我增強(qiáng)因?yàn)闀?huì)存在一個(gè)真實(shí)圖像的參照,這會(huì)使得self-rewarding的過(guò)程更加可靠。

論文地址: https://arxiv.org/pdf/2405.14622

項(xiàng)目地址:https://github.com/YiyangZhou/CSR

項(xiàng)目頁(yè)面:https://dongjie-cheng.github.io/CSR.html

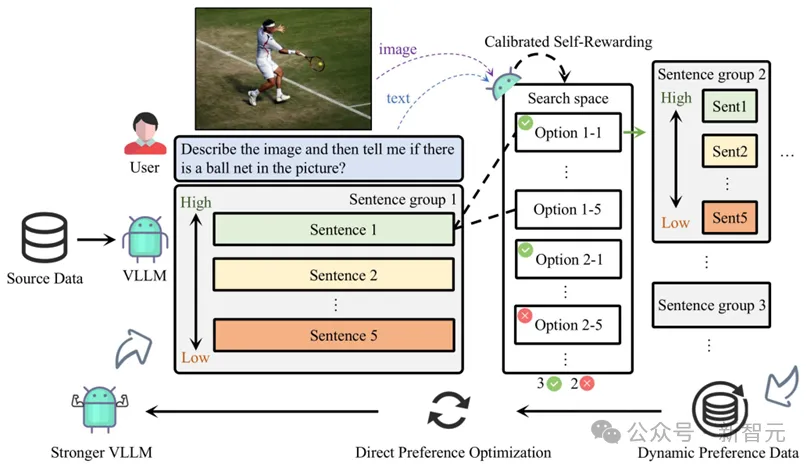

整個(gè)Calibrated Self-Rewarding(CSR)框架如下:

1. 通過(guò)模型本身在beam search過(guò)程中的輸出構(gòu)造偏好數(shù)據(jù)對(duì),過(guò)程中的獎(jiǎng)勵(lì)來(lái)自于校準(zhǔn)的自我獎(jiǎng)勵(lì):LVLM對(duì)于每句話的自我生成概率 + 結(jié)合視覺(jué)約束獎(jiǎng)勵(lì),用于獎(jiǎng)勵(lì)校準(zhǔn)。

2. 基于每一輪構(gòu)造的偏好數(shù)據(jù)在線通過(guò)DPO迭代學(xué)習(xí)。

實(shí)驗(yàn)

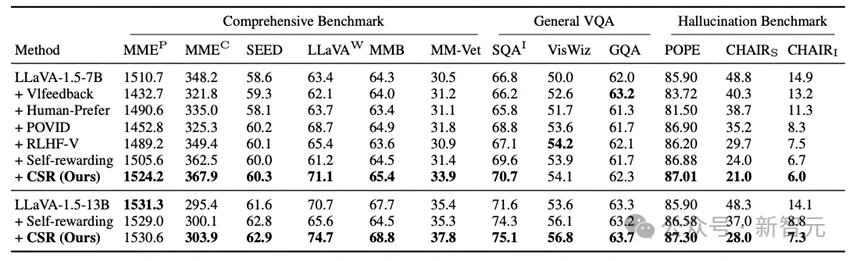

CSR相較于數(shù)據(jù)驅(qū)動(dòng)的偏好學(xué)習(xí)對(duì)齊方法和模型自我反饋的方法均有較大提升。

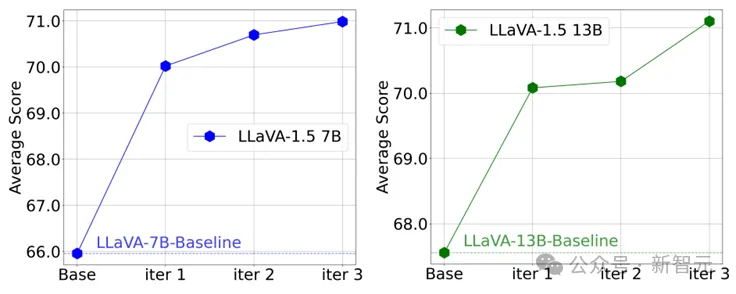

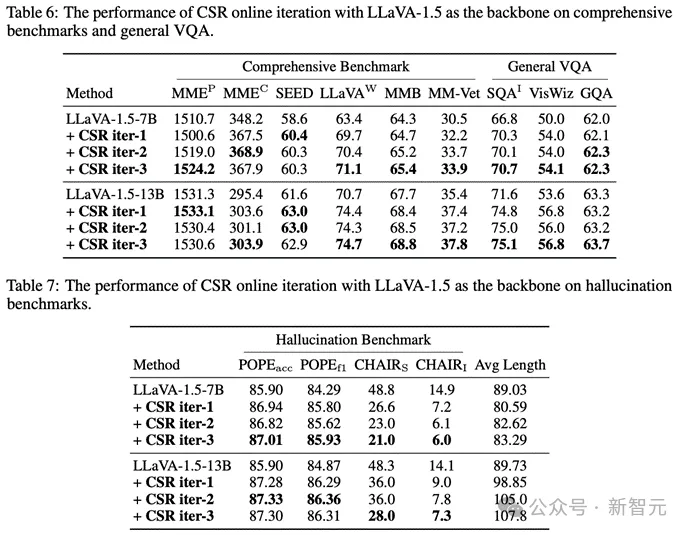

更值得注意的是,在CSR多輪在線迭代過(guò)程中,模型能逐步提升自我能力!可以看到在多個(gè)輪次中以LLaVA-1.5為例,模型在多個(gè)benchmark上的均分逐步提升。

同時(shí)也可以看到特別是幻覺(jué),在多輪迭代中是逐步減少的:

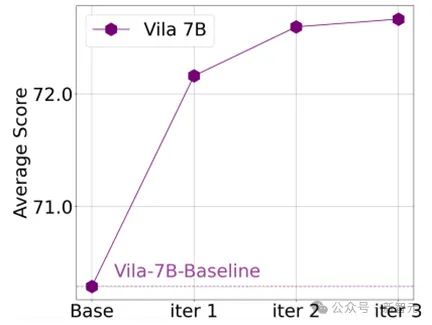

同時(shí)CSR也適用于其他模型,例如Vila:

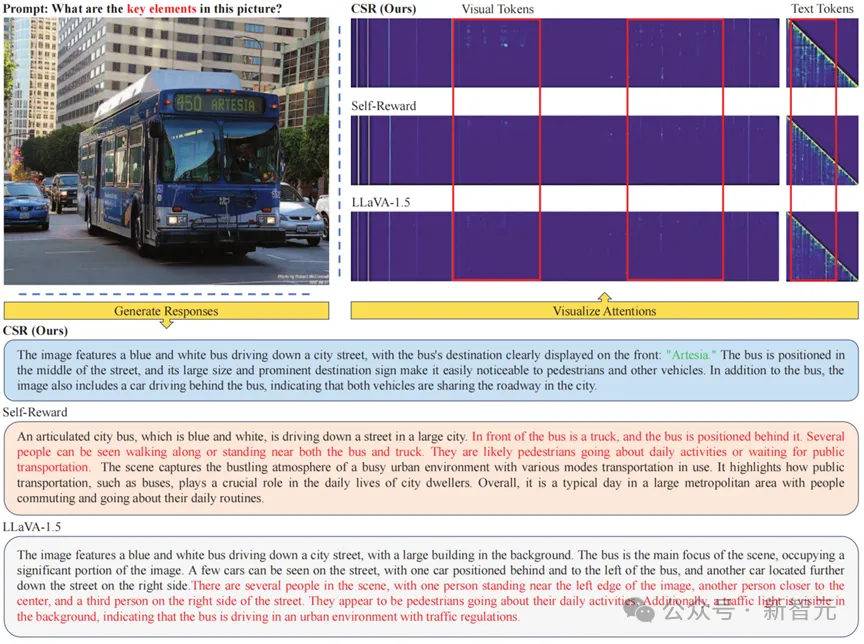

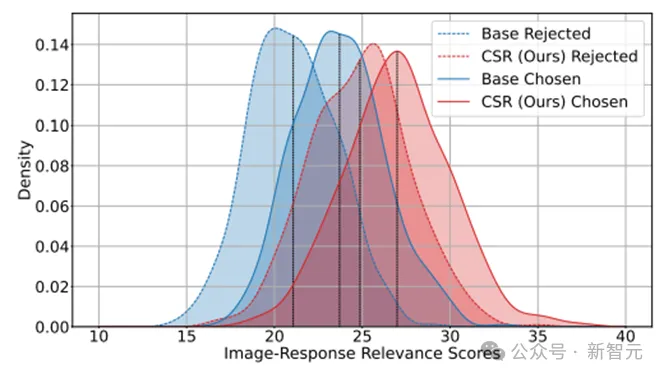

那么在Calibrated Self-Rewarding(CSR)的過(guò)程中究竟發(fā)生了什么呢?通過(guò)可視化經(jīng)過(guò)CSR迭代前后模型自身的正樣本和負(fù)樣本輸出可以發(fā)現(xiàn),經(jīng)過(guò)多輪CSR學(xué)習(xí)后,模型自身說(shuō)出的回復(fù)會(huì)有更高的分?jǐn)?shù):這代表模型的response更加符合圖像信息;同時(shí)負(fù)樣本和正樣本的gap更小:這說(shuō)明模型所輸出的負(fù)樣本傾向于正樣本,模型的誤差和性能下界提升。

通過(guò)可視化attention可以看到,CSR能使得LVLM更加偏重于視覺(jué)模型,同時(shí)能緩解文本attention中存在的上下文依賴問(wèn)題。