多模態(tài)大模型技術(shù)方向和應(yīng)用場景

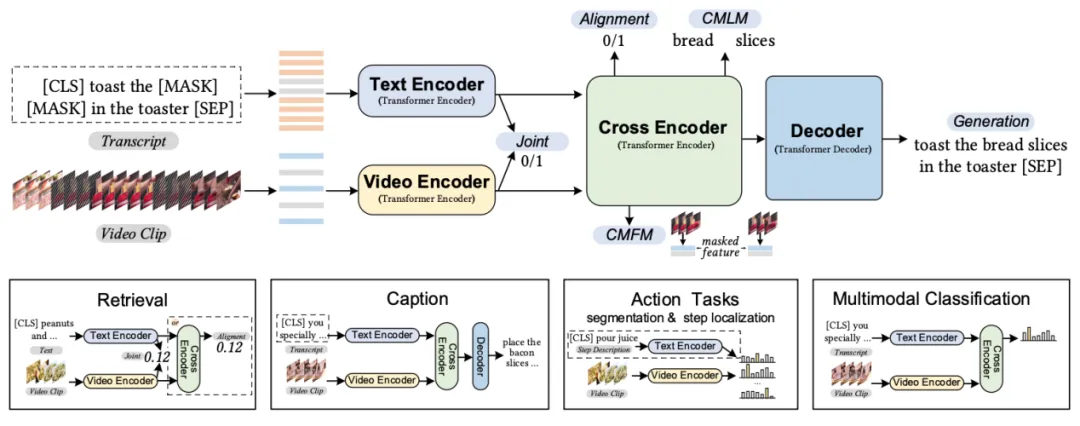

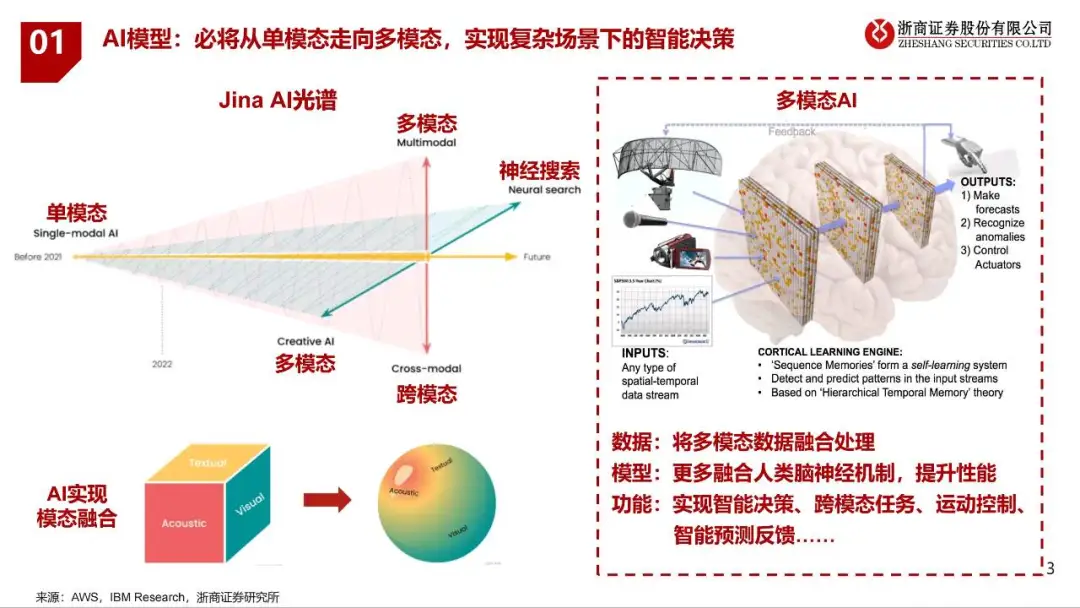

多模態(tài)大模型(Multimodal Large Language Models,MLLM)是一種結(jié)合了大型語言模型(LLM)和大型視覺模型(LVM)的深度學(xué)習(xí)模型,它們能夠處理和理解多種類型的數(shù)據(jù),如文本、圖像和音頻,從而在跨模態(tài)任務(wù)中展現(xiàn)出卓越的性能。

核心特點(diǎn)

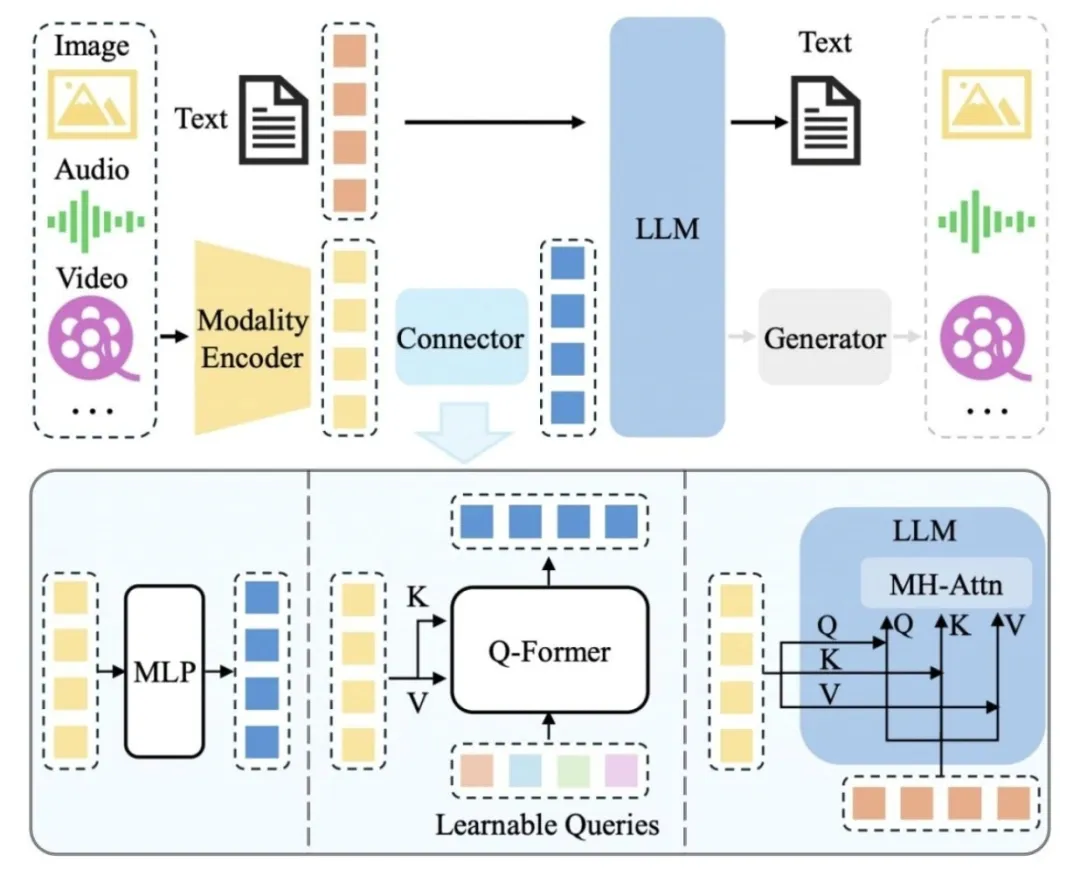

對(duì)于多模態(tài)輸入-文本輸出的典型 MLLM,其架構(gòu)一般包括編碼器、連接器以及 LLM。如要支持更多模態(tài)的輸出(如圖片、音頻、視頻),一般需要額外接入生成器,如下圖所示:

MLLM 架構(gòu)圖

MLLM 架構(gòu)圖

模態(tài)編碼器負(fù)責(zé)將原始的信息(如圖片)編碼成特征,連接器則進(jìn)一步將特征處理成LLM 易于理解的形式,即視覺 Token。LLM 則作為“大腦”綜合這些信息進(jìn)行理解和推理,生成回答。目前,三者的參數(shù)量并不等同,以 Qwen-VL[1]為例,LLM 作為“大腦”參數(shù)量為 7.7B,約占總參數(shù)量的 80.2%,視覺編碼器次之(1.9B,約占 19.7%),而連接器參數(shù)量僅有 0.08B。

對(duì)于視覺編碼器而言,增大輸入圖片的分辨率是提升性能的有效方法。一種方式是直接提升分辨率,這種情況下需要放開視覺編碼器進(jìn)行訓(xùn)練以適應(yīng)更高的分辨率,如 Qwen-VL[1]等。另一種方式是將大分辨率圖片切分成多個(gè)子圖,每個(gè)子圖以低分辨率送入視覺編碼器中,這樣可以間接提升輸入的分辨率,如 Monkey[2]等工作。

對(duì)于預(yù)訓(xùn)練的 LLM,常用的包括 LLaMA[3]系列、Qwen[4]系列和 InternLM[5]系列等,前者主要支持英文,而后兩者中英雙語支持得更好。就性能影響而言,加大 LLM 的參數(shù)量可以帶來顯著的性能增益,如 LLaVA-NeXT[6]等工作在 7B/13B/34B 的 LLM 上進(jìn)行實(shí)驗(yàn),發(fā)現(xiàn)提升LLM 大小可以帶來各 benchmark 上的顯著提升,在 34B 的模型上更涌現(xiàn)出 zero-shot 的中文能力。除了直接增大 LLM 參數(shù)量,近期火熱的 MoE 架構(gòu)則提供了更高效實(shí)現(xiàn)的可能性,即通過稀疏計(jì)算的方式,在不增大實(shí)際計(jì)算參數(shù)量的前提下提高總的模型參數(shù)量。

相對(duì)前兩者來說,連接器的重要性略低。例如,MM1[7]通過實(shí)驗(yàn)發(fā)現(xiàn),連接器的類型不如視覺 token 數(shù)量(決定之后 LLM 可用的視覺信息)及圖片的分辨率(決定視覺編碼器的輸入信息量)重要。

數(shù)據(jù)與訓(xùn)練

MLLM 的訓(xùn)練大致可以劃分為預(yù)訓(xùn)練階段、指令微調(diào)階段和對(duì)齊微調(diào)階段。預(yù)訓(xùn)練階段主要通過大量配對(duì)數(shù)據(jù)將圖片信息對(duì)齊到 LLM 的表征空間,即讓 LLM 讀懂視覺 Token。指令微調(diào)階段則通過多樣化的各種類型的任務(wù)數(shù)據(jù)提升模型在下游任務(wù)上的性能,以及模型理解和服從指令的能力。對(duì)齊微調(diào)階段一般使用強(qiáng)化學(xué)習(xí)技術(shù)使模型對(duì)齊人類價(jià)值觀或某些特定需求(如更少幻覺)。

影響對(duì)齊的效果。后來的工作則探索使用更干凈、文本內(nèi)容更豐富的數(shù)據(jù)做對(duì)齊。由于數(shù)據(jù)規(guī)模受限,其包含的世界知識(shí)也是有限的,比如是否能夠識(shí)別出圖像中的建筑為廣州塔。此類世界知識(shí)通常儲(chǔ)備于大規(guī)模的粗粒度圖文對(duì)中。

第二階段的微調(diào)數(shù)據(jù)一方面可以來源于各種任務(wù)的數(shù)據(jù),如 VQA 數(shù)據(jù)、OCR 數(shù)據(jù)等,也可以來源于 GPT-4V 生成的數(shù)據(jù),如問答對(duì)。雖然后者一般能夠生成更復(fù)雜、更多樣化的指令數(shù)據(jù),但這種方式也顯著地增加了成本。值得一提的是,第二階段的訓(xùn)練中一般還會(huì)混合部分純文本的對(duì)話數(shù)據(jù),這類數(shù)據(jù)可以視為正則化的手段,保留 LLM 原有的能力與內(nèi)嵌知識(shí)。

第三階段的數(shù)據(jù)主要是針對(duì)于回答的偏好數(shù)據(jù)。這類數(shù)據(jù)通常由人工標(biāo)注收集,因而成本較高。近期出現(xiàn)一些工作使用自動(dòng)化的方法對(duì)來自不同模型的回復(fù)進(jìn)行偏好排序,如 Silkie[9]通過調(diào)用 GPT-4V 來收集偏好數(shù)據(jù)。

1. 模態(tài)融合:MLLM通過融合不同模態(tài)的數(shù)據(jù),如圖像和文本,增強(qiáng)了模型對(duì)信息的理解和處理能力。

2. 跨模態(tài)表示學(xué)習(xí):MLLM學(xué)習(xí)跨模態(tài)數(shù)據(jù)之間的關(guān)聯(lián),實(shí)現(xiàn)更深層次的語義理解。

3. 端到端訓(xùn)練:MLLM通過模態(tài)對(duì)齊技術(shù),實(shí)現(xiàn)了不同模態(tài)間的有效整合。

技術(shù)方向

技術(shù)方向

多模態(tài)幻覺的研究主要關(guān)注模型生成的回答與圖片內(nèi)容不符的問題。視覺和文本本質(zhì)上是異構(gòu)的信息,完全對(duì)齊兩者本身就具有相當(dāng)大的挑戰(zhàn)。增大圖像分辨率和提升訓(xùn)練數(shù)據(jù)質(zhì)量是降低多模態(tài)幻覺的兩種最直觀的方式,此外我們?nèi)匀恍枰谠砩咸剿鞫嗄B(tài)幻覺的成因和解法。例如,當(dāng)前的視覺信息的 Token 化方法、多模態(tài)對(duì)齊的范式、多模態(tài)數(shù)據(jù)和 LLM 存儲(chǔ)知識(shí)的沖突等對(duì)多模態(tài)幻覺的影響仍需深入研究。

多模態(tài)上下文學(xué)習(xí)技術(shù)為少樣本學(xué)習(xí)方法,旨在使用少量的問答樣例提示模型,提升模型的few-shot 性能。提升性能的關(guān)鍵在于讓模型有效地關(guān)注上下文,并將內(nèi)在的問題模式泛化到新的問題上。以 Flamingo[10]為代表的工作通過在圖文交錯(cuò)的數(shù)據(jù)上訓(xùn)練來提升模型關(guān)注上下文的能力。目前對(duì)于多模態(tài)上下文學(xué)習(xí)的研究還比較初步,有待進(jìn)一步探索。

多模態(tài)思維鏈的基本思想是通過將復(fù)雜的問題分解為較簡單的子問題,然后分別解決并匯總。相較于純文本的推理,多模態(tài)的推理涉及更多的信息來源和更復(fù)雜的邏輯關(guān)系,因此要復(fù)雜得多。當(dāng)前該方面的工作也比較少。

LLM 輔助的視覺推理方法探索如何利用 LLM 強(qiáng)大的內(nèi)嵌知識(shí)與能力,并借助其他工具,設(shè)計(jì)各種視覺推理系統(tǒng),解決各種現(xiàn)實(shí)問題。相比于通過端到端訓(xùn)練獲得單一模型,這類方法一般關(guān)注如何通過免訓(xùn)練的方式擴(kuò)展和加強(qiáng) LLM 的能力,從而構(gòu)建一個(gè)綜合性的系統(tǒng)。

應(yīng)用場景

應(yīng)用場景

多模態(tài)大模型作為人工智能領(lǐng)域的重要研究方向之一,通過模態(tài)融合和跨模態(tài)表示學(xué)習(xí)技術(shù),能夠更好地處理和理解跨模態(tài)數(shù)據(jù),為人工智能領(lǐng)域的發(fā)展帶來新的機(jī)遇和挑戰(zhàn)。隨著技術(shù)的不斷成熟和應(yīng)用場景的不斷拓展,多模態(tài)大模型將在各個(gè)領(lǐng)域發(fā)揮越來越重要的作用。

1.多模態(tài)情感分析:結(jié)合文本、圖像、音頻等多種模態(tài)的數(shù)據(jù)進(jìn)行情感分析,例如識(shí)別社交媒體上用戶的情緒狀態(tài)。

2.多模態(tài)問答系統(tǒng):利用文本、圖像等多種數(shù)據(jù)模態(tài)來回答用戶提出的問題,例如結(jié)合圖像和文本來回答關(guān)于特定場景的問題。

3.跨模態(tài)推薦系統(tǒng):結(jié)合用戶的文本描述、點(diǎn)擊行為、圖像偏好等多種數(shù)據(jù)模態(tài)來進(jìn)行個(gè)性化推薦,提高推薦系統(tǒng)的準(zhǔn)確性和用戶體驗(yàn)。

4.多模態(tài)翻譯:結(jié)合文本和圖像等多種數(shù)據(jù)模態(tài)進(jìn)行跨語言翻譯,例如將圖像中的文字翻譯成其他語言。

5.智能輔助:多模態(tài)大模型還可以用于智能輔助領(lǐng)域,例如輔助盲人識(shí)別周圍環(huán)境的圖像信息、識(shí)別聲音中的指令等。

6.辦公自動(dòng)化:在辦公領(lǐng)域,多模態(tài)大模型可以應(yīng)用于智能文檔處理、會(huì)議記錄、語音助手等,通過自然語言理解和生成技術(shù),輔助用戶完成復(fù)雜的辦公任務(wù)。、

7.電子商務(wù):在電商領(lǐng)域,多模態(tài)大模型可用于商品推薦、智能客服、虛擬試衣等場景,通過分析用戶的購物歷史和偏好,為用戶提供個(gè)性化的購物體驗(yàn)。

8.娛樂產(chǎn)業(yè):多模態(tài)大模型在娛樂產(chǎn)業(yè)中的應(yīng)用包括游戲設(shè)計(jì)、虛擬偶像、電影制作等,通過生成高質(zhì)量的圖像和視頻內(nèi)容,為娛樂產(chǎn)業(yè)帶來全新的創(chuàng)作方式和商業(yè)模式。

9.教育領(lǐng)域:在教育領(lǐng)域,多模態(tài)大模型可用于智能輔導(dǎo)、在線課堂、虛擬實(shí)驗(yàn)室等場景,提供個(gè)性化的學(xué)習(xí)資源和互動(dòng)體驗(yàn),幫助學(xué)生更好地掌握知識(shí)和技能。

10.醫(yī)療健康:在醫(yī)療健康領(lǐng)域,多模態(tài)大模型可用于醫(yī)療影像分析、疾病診斷、藥物研發(fā)等場景,通過處理和分析大量的醫(yī)療數(shù)據(jù),為醫(yī)生提供更準(zhǔn)確的診斷建議和治療方案。

挑戰(zhàn)和未來方向

針對(duì) MLLM 的研究現(xiàn)狀,我們進(jìn)行了深入思考,將挑戰(zhàn)與可能的未來發(fā)展方向總結(jié)如下:

- 現(xiàn)有 MLLM 處理多模態(tài)長上下文的能力有限,導(dǎo)致模型在長視頻理解、圖文交錯(cuò)內(nèi)容理解等任務(wù)中面臨巨大挑戰(zhàn)。以 Gemini 1.5 Pro 為代表的 MLLM 正在掀起長視頻理解的浪潮,而多模態(tài)圖文交錯(cuò)閱讀理解(即長文檔中既有圖像也有文本)則相對(duì)空白,很可能會(huì)成為接下來的研究熱點(diǎn)。

- MLLM 服從復(fù)雜指令的能力不足。例如,GPT-4V 可以理解復(fù)雜的指令來生成問答對(duì)甚至包含推理信息,但其他模型這方面的能力則明顯不足,仍有較大的提升空間。

- MLLM 的上下文學(xué)習(xí)和思維鏈研究依然處于初步階段,相關(guān)的能力也較弱,亟需相關(guān)底層機(jī)制以及能力提升的研究探索。

- 開發(fā)基于 MLLM 的智能體是一個(gè)研究熱點(diǎn)。要實(shí)現(xiàn)這類應(yīng)用,需要全面提升模型的感知、推理和規(guī)劃能力。

- 安全問題。MLLM 容易受設(shè)計(jì)的惡意攻擊影響,生成有偏的或不良的回答。該方面的相關(guān)研究也仍然欠缺。

- 目前 MLLM 在訓(xùn)練時(shí)通常都會(huì)解凍 LLM,雖然在訓(xùn)練過程中也會(huì)加入部分單模態(tài)的文本訓(xùn)練數(shù)據(jù),但大規(guī)模的多模態(tài)和單模態(tài)數(shù)據(jù)共同訓(xùn)練時(shí)究竟對(duì)彼此互有增益還是互相損害仍然缺乏系統(tǒng)深入的研究。