LeCun轉(zhuǎn)發(fā),AI讓失語者重新說話!紐約大學(xué)發(fā)布全新「神經(jīng)-語音」解碼器

腦機接口(BCI)在科研和應(yīng)用領(lǐng)域的進展在近期屢屢獲得廣泛的關(guān)注,大家通常都對腦機接口的應(yīng)用前景有著廣泛的暢享。

比如,由于神經(jīng)系統(tǒng)的缺陷造成的失語癥不僅嚴重阻礙患者的日常生活,還可能限制他們的職業(yè)發(fā)展和社交活動。隨著深度學(xué)習(xí)和腦機接口技術(shù)的迅猛發(fā)展,現(xiàn)代科學(xué)正向著通過神經(jīng)語音假肢來輔助失語者重新獲得交流能力的方向邁進。

腦機接口在解碼人的語音、動作等信號方面已經(jīng)有了一系列激動人心的進展。特別值得一提的是,埃隆·馬斯克(Elon Musk)的Neuralink公司在這一領(lǐng)域也取得了突破性進展。

該公司成功地在一位試驗對象的大腦中植入了電極,實現(xiàn)了通過簡單的光標操作來進行打字、游戲等功能。這標志著我們在向更高復(fù)雜度的神經(jīng)-語音/動作解碼邁進的路上又進了一步。相比于其他腦機接口技術(shù),神經(jīng)-語音解碼的復(fù)雜性更高,其研發(fā)工作主要依賴于特殊的數(shù)據(jù)源——皮層電圖(ECoG)。

皮層電圖在臨床上主要是從進行癲癇治療的患者那里收集的,因為這些患者通常會植入電極以監(jiān)測大腦活動。研究人員利用這些電極,在發(fā)音時收集大腦皮層的數(shù)據(jù)。這些數(shù)據(jù)不僅具有高度的時空分辨率,而且已經(jīng)在語音解碼研究中取得了顯著成果,極大地推動了腦機接口技術(shù)的發(fā)展。通過這些先進技術(shù)的幫助,未來我們有望看到更多患有神經(jīng)障礙的人士重獲交流的自由。

最近在《自然》雜志上發(fā)表的一項研究取得了突破,研究中在一位植入設(shè)備的患者身上使用了量化的HuBERT特征作為中間表征,結(jié)合預(yù)訓(xùn)練的語音合成器將這些特征轉(zhuǎn)化為語音,這種方法不僅提高了語音的自然度,也保持了高準確性。

然而,HuBERT特征并不能捕捉到發(fā)音者的獨特聲學(xué)特征,生成的聲音通常是統(tǒng)一的發(fā)音者聲音,因此仍需額外的模型來將這種通用聲音轉(zhuǎn)換為特定患者的聲音。

另一個值得注意的點是,該研究及大部分先前嘗試采用了非因果架構(gòu),這可能限制了其在需要因果操作的腦機接口應(yīng)用中的實際使用。

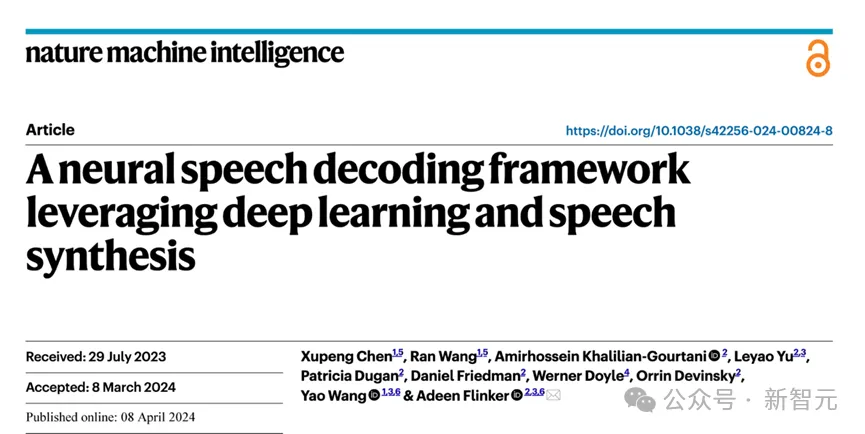

2024年4月8日,紐約大學(xué)VideoLab和Flinker Lab聯(lián)合在《Nature Machine Intelligence》雜志上發(fā)表了一項突破性研究。

圖片

圖片

論文鏈接:https://www.nature.com/articles/s42256-024-00824-8

研究相關(guān)代碼開源在https://github.com/flinkerlab/neural_speech_decoding

更多生成的語音例子在:https://xc1490.github.io/nsd/

這項名為“A neural speech decoding framework leveraging deep learning and speech synthesis”的研究,介紹了一個創(chuàng)新的可微分語音合成器。

該合成器結(jié)合了輕量級卷積神經(jīng)網(wǎng)絡(luò),能夠?qū)⒄Z音編碼為一系列可解釋的語音參數(shù),如音高、響度和共振峰頻率等,并利用可微分的技術(shù)重新合成語音。

此研究通過將神經(jīng)信號映射到這些具體的語音參數(shù),成功構(gòu)建了一個高度可解釋并適用于小數(shù)據(jù)集的神經(jīng)語音解碼系統(tǒng)。這一系統(tǒng)不僅能重構(gòu)出高保真且聽起來自然的語音,而且為未來腦機接口應(yīng)用的高準確性提供了實證基礎(chǔ)。

研究團隊共收集了48位受試者的數(shù)據(jù),并在這一基礎(chǔ)上進行了語音解碼的嘗試,為高精度腦機接口技術(shù)的實際應(yīng)用和發(fā)展打下了堅實的基礎(chǔ)。

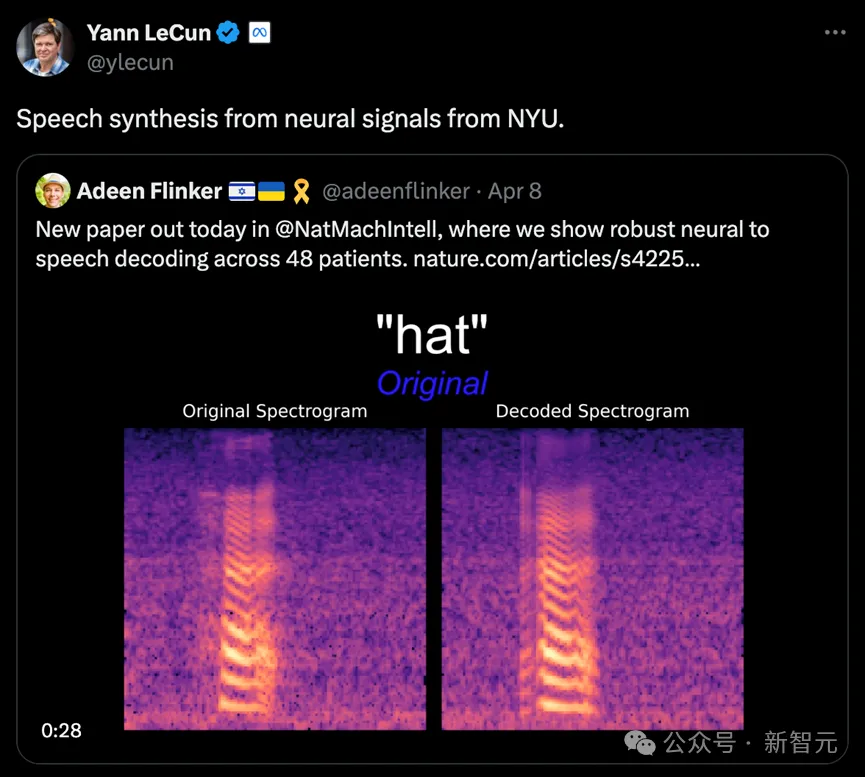

圖靈獎得主Lecun也轉(zhuǎn)發(fā)了研究進展。

圖片

圖片

研究現(xiàn)狀

在當(dāng)前神經(jīng)信號到語音解碼的研究中,面臨兩大核心挑戰(zhàn)。

首先是數(shù)據(jù)量的限制:為了訓(xùn)練個性化的神經(jīng)到語音解碼模型,通常每個病人的可用的數(shù)據(jù)時間總長僅約十分鐘,這對于依賴大量訓(xùn)練數(shù)據(jù)的深度學(xué)習(xí)模型而言是一個顯著的制約因素。

其次,人類語音的高度多樣性也增加了建模的復(fù)雜度。即便同一人反復(fù)發(fā)音拼讀同一個單詞,其語速、語調(diào)和音調(diào)等因素亦可能發(fā)生變化,從而為模型的構(gòu)建增添了額外的難度。

在早期嘗試中,研究者們主要采用線性模型來解碼神經(jīng)信號到語音。這類模型不需龐大的數(shù)據(jù)集支持,具備較強的可解釋性,但其準確率通常較低。

近期,隨著深度學(xué)習(xí)技術(shù)的進步,特別是卷積神經(jīng)網(wǎng)絡(luò)(CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)的應(yīng)用,研究者在模擬語音的中間潛在表征和提升合成語音質(zhì)量方面進行了廣泛嘗試。

例如,一些研究通過將大腦皮層活動解碼為口型運動,再轉(zhuǎn)化為語音,盡管這種方法在解碼性能上較為強大,重建的聲音卻往往聽起來不夠自然。

此外,一些新方法嘗試利用Wavenet聲碼器和生成對抗網(wǎng)絡(luò)(GAN)來重建自然聽感的語音,雖然這些方法能夠改善聲音的自然度,但在準確度上仍有局限。

主要模型框架

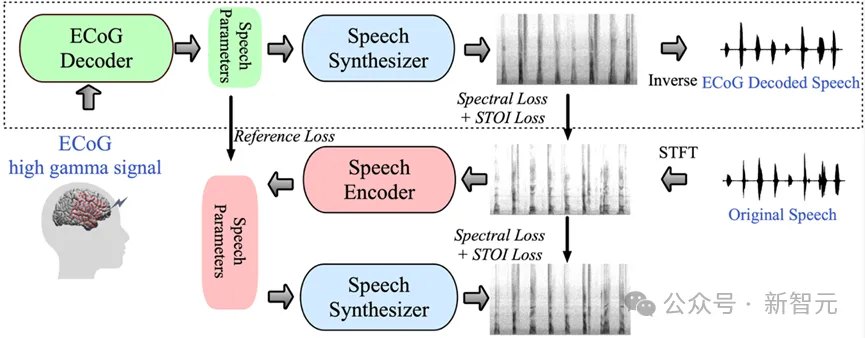

在該研究中,研究團隊展示了一種創(chuàng)新的從腦電(ECoG)信號到語音的解碼框架。他們構(gòu)建了一個低維度的潛在表示空間,該空間通過一個輕量級的語音編解碼模型,僅使用語音信號來生成。

這一框架包含兩個核心部分:首先是ECoG解碼器,它負責(zé)將ECoG信號轉(zhuǎn)換為一系列可理解的聲學(xué)語音參數(shù),如音高、是否發(fā)聲、響度及共振峰頻率等;其次是語音合成器部分,負責(zé)將這些參數(shù)轉(zhuǎn)換為頻譜圖。

通過構(gòu)建一個可微分的語音合成器,研究人員實現(xiàn)了在訓(xùn)練ECoG解碼器的同時,也對語音合成器進行優(yōu)化,共同減少頻譜圖重建的誤差。這種低維度潛在空間的可解釋性強,結(jié)合輕量級的預(yù)訓(xùn)練語音編碼器生成的參考語音參數(shù),使得整個神經(jīng)語音解碼框架高效且適應(yīng)性強,有效解決了該領(lǐng)域中數(shù)據(jù)稀缺的問題。

此外,這個框架不僅能生成與說話者非常接近的自然語音,而且在ECoG解碼器部分支持插入多種深度學(xué)習(xí)模型架構(gòu),并能進行因果操作。

研究團隊處理了48名神經(jīng)外科病人的ECoG數(shù)據(jù),并使用了多種深度學(xué)習(xí)架構(gòu)(包括卷積、循環(huán)神經(jīng)網(wǎng)絡(luò)和Transformer)來實現(xiàn)ECoG解碼。

這些模型在實驗中均顯示了高準確度,尤其是采用ResNet卷積架構(gòu)的表現(xiàn)最為出色。該研究框架不僅通過因果操作和相對較低的采樣率(10mm間隔)實現(xiàn)了高準確度,還展示了能從大腦的左右半球都有效進行語音解碼的能力,從而將神經(jīng)語音解碼的應(yīng)用范圍擴展到了右腦。

圖片

圖片

本研究的核心創(chuàng)新之一是開發(fā)了一種可微分的語音合成器,這大大提高了語音重合成的效率,并能合成接近原聲的高保真音頻。

這種語音合成器的設(shè)計靈感來源于人類的發(fā)聲系統(tǒng),將語音細分為兩個部分:Voice(主要用于元音的模擬)和Unvoice(主要用于輔音的模擬)。

在Voice部分,首先使用基頻信號生成諧波,然后通過由F1至F6共振峰構(gòu)成的濾波器,以獲得元音的頻譜特征。

對于Unvoice部分,通過對白噪聲進行特定濾波,生成相應(yīng)的頻譜。一個可學(xué)習(xí)的參數(shù)控制這兩部分在每個時間點的混合比例。

最后,通過調(diào)整響度信號和添加背景噪聲,生成最終的語音頻譜。

基于這種語音合成器,研究團隊設(shè)計了一個高效的語音重合成框架及神經(jīng)-語音解碼框架。詳細的框架結(jié)構(gòu)可以參考原文的圖6。

研究結(jié)果

1. 具有時序因果性的語音解碼結(jié)果

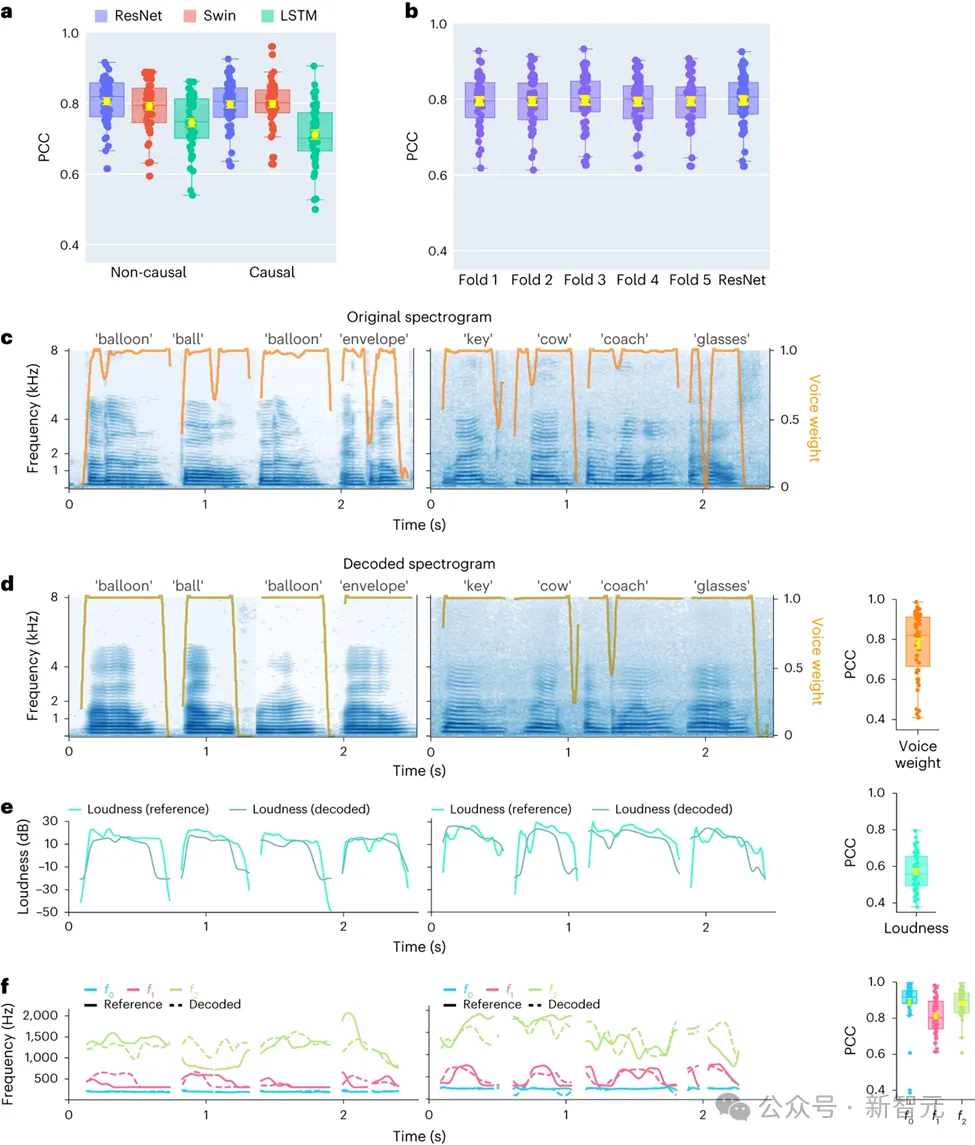

在此項研究中,研究者首先對不同的模型架構(gòu)進行了直接比較,包括卷積網(wǎng)絡(luò)(ResNet)、循環(huán)神經(jīng)網(wǎng)絡(luò)(LSTM)和Transformer架構(gòu)(3D Swin),以評估它們在語音解碼性能上的差異。

值得注意的是,這些模型均能執(zhí)行時間序列上的非因果或因果操作。

圖片

圖片

在大腦-計算機接口(BCI)的應(yīng)用中,解碼模型的因果性具有重要意義:因果模型只利用過去和當(dāng)前的神經(jīng)信號來生成語音,而非因果模型還會參考未來的神經(jīng)信號,這在實際操作中是不可行的。

因此,研究的重點在于比較同一模型在執(zhí)行因果和非因果操作時的性能表現(xiàn)。結(jié)果顯示,即使是因果版本的ResNet模型,其性能也能與非因果版本相媲美,二者之間沒有顯著的性能差異。

類似地,Swin模型的因果和非因果版本性能相近,但LSTM的因果版本在性能上顯著低于其非因果版本。研究還展示了幾個關(guān)鍵的語音參數(shù)的平均解碼準確率(總樣本數(shù)為48),包括聲音權(quán)重(區(qū)分元音和輔音的參數(shù))、響度、基頻f0、第一共振峰f1和第二共振峰f2。

準確地重建這些語音參數(shù),特別是基頻、聲音權(quán)重和前兩個共振峰,對于實現(xiàn)精確的語音解碼和自然地重現(xiàn)參與者聲音至關(guān)重要。

研究結(jié)果表明,無論是非因果還是因果模型,都能提供合理的解碼效果,這為未來的相關(guān)研究和應(yīng)用提供了積極的啟示。

2. 對左右大腦神經(jīng)信號語音解碼以及空間采樣率的研究

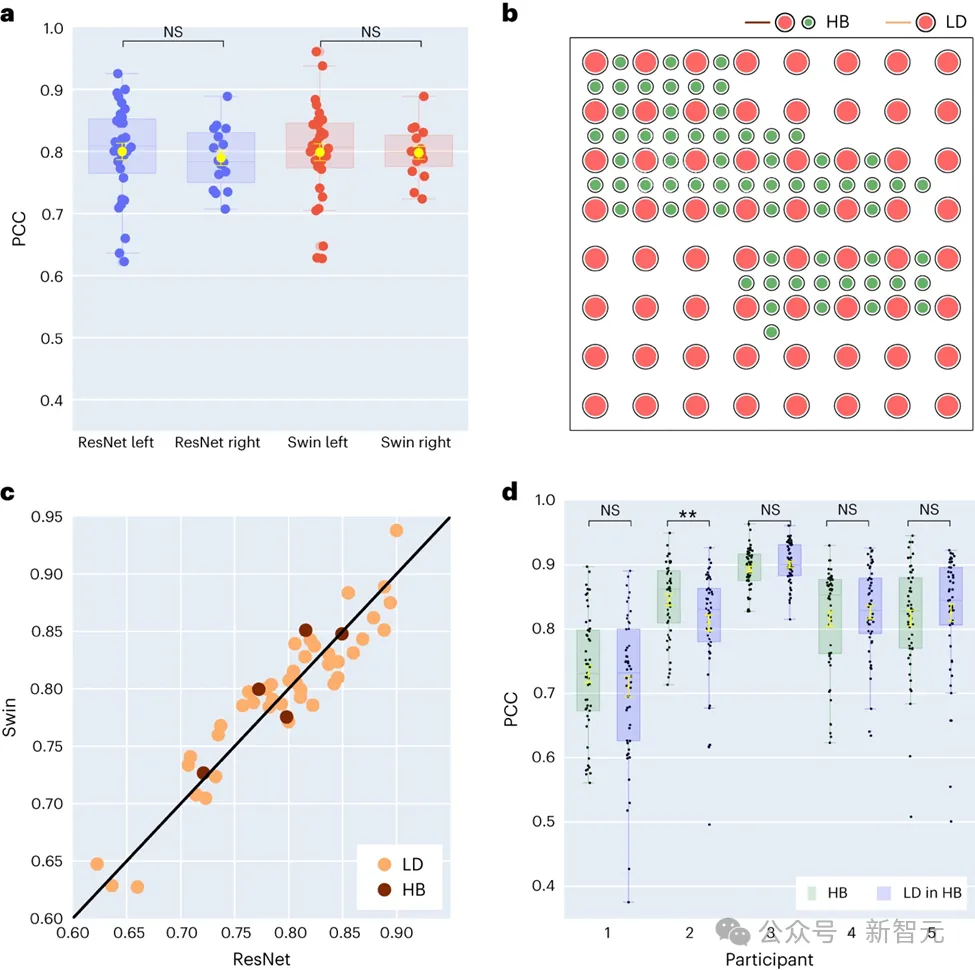

研究者在最新的研究中進一步探索了左右大腦半球在語音解碼上的性能差異。

傳統(tǒng)上,大多數(shù)研究主要集中在與語音和語言功能密切相關(guān)的左腦半球。

圖片

圖片

然而,關(guān)于右腦半球在語言信息解碼方面的能力,我們了解的還很有限。為了探索這一領(lǐng)域,研究團隊比較了參與者左右腦半球的解碼性能,驗證了使用右腦半球進行語音恢復(fù)的可行性。

在研究中收集的48位受試者中,16位的ECoG信號來自右腦。研究者通過比較使用ResNet和Swin解碼器的性能,發(fā)現(xiàn)右腦半球同樣能夠有效地進行語音解碼,其效果與左腦半球相近。這一發(fā)現(xiàn)為那些左腦受損且失去語言功能的患者提供了一種可能的語言恢復(fù)方案。

研究還涉及到了電極采樣密度對語音解碼效果的影響。以往的研究多使用較高密度的電極網(wǎng)格(0.4 mm),而在臨床實踐中常用的電極網(wǎng)格密度則較低(1 cm)。

本研究中有五位參與者使用了混合類型(HB)的電極網(wǎng)格,這類網(wǎng)格主要是低密度,但添加了一些額外的電極。其余四十三位參與者均使用了低密度采樣。

結(jié)果顯示,這些混合采樣(HB)的解碼表現(xiàn)與傳統(tǒng)的低密度采樣(LD)相近,表明模型能夠有效地從不同密度的大腦皮層電極網(wǎng)格中學(xué)習(xí)語音信息。這一發(fā)現(xiàn)暗示了在臨床常用的電極采樣密度可能已足夠支持未來的腦機接口應(yīng)用。

3. 對于左右腦不同腦區(qū)對語音解碼貢獻度的研究

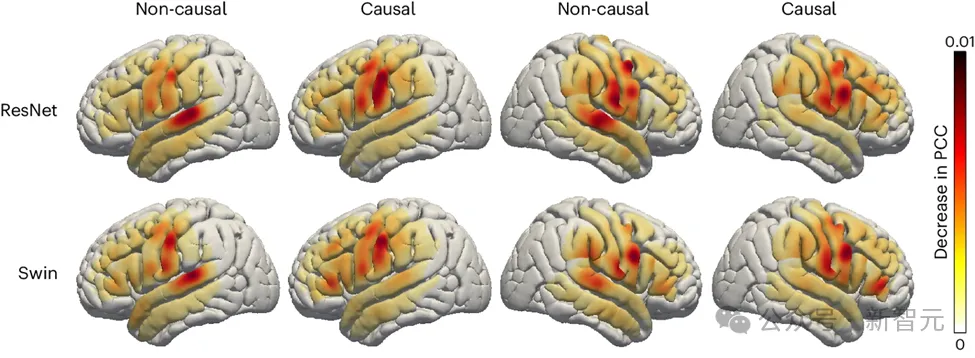

研究者還探討了大腦中與語音相關(guān)區(qū)域在語音解碼過程中的作用,這一點對于將來可能在左右腦半球植入語音恢復(fù)設(shè)備具有重要意義。為了評估不同大腦區(qū)域?qū)φZ音解碼的影響,研究團隊采用了遮擋技術(shù)(occlusion analysis)。

通過對ResNet和Swin解碼器的因果與非因果模型進行比較,研究發(fā)現(xiàn),在非因果模型中,聽覺皮層的作用更加顯著。這一結(jié)果強調(diào)了在實時語音解碼應(yīng)用中使用因果模型的必要性,因為實時應(yīng)用無法依賴未來的神經(jīng)反饋信號。

圖片

圖片

此外,研究也顯示,無論在大腦的左半球還是右半球,傳感運動皮層特別是腹部區(qū)域?qū)φZ音解碼的貢獻度都相似。這一發(fā)現(xiàn)表明,在右半球植入神經(jīng)假肢來恢復(fù)語音可能是一個可行的方案,提供了對未來治療策略的重要見解。

結(jié)論(啟發(fā)展望)

研究團隊開發(fā)了一種新型的可微分語音合成器,這一合成器使用輕型卷積神經(jīng)網(wǎng)絡(luò)將語音編碼為一系列可解釋的參數(shù),如音高、響度和共振峰頻率等,并利用同一可微分合成器對語音進行重新合成。

通過將神經(jīng)信號映射到這些參數(shù)上,研究者們構(gòu)建了一個高度可解釋并適用于小數(shù)據(jù)集的神經(jīng)語音解碼系統(tǒng),能夠生成自然聽感的語音。

這一系統(tǒng)在48名參與者中表現(xiàn)出高度的可復(fù)現(xiàn)性,能夠處理不同空間采樣密度的數(shù)據(jù),并能同時處理左、右腦半球的腦電信號,展示了其在語音解碼方面的強大潛力。

盡管取得了顯著進展,研究者也指出了模型當(dāng)前的一些局限性,如解碼過程依賴于與ECoG記錄配對的語音訓(xùn)練數(shù)據(jù),這對于失語癥患者可能不適用。

未來,研究團隊希望建立能夠處理非網(wǎng)格數(shù)據(jù)的模型架構(gòu),并更有效地利用多病人、多模態(tài)的腦電數(shù)據(jù)。隨著硬件技術(shù)的持續(xù)進步和深度學(xué)習(xí)技術(shù)的快速發(fā)展,腦機接口領(lǐng)域的研究仍處于早期階段,但隨著時間的推移,科幻電影中的腦機接口設(shè)想將逐步成為現(xiàn)實。

參考資料:

https://www.nature.com/articles/s42256-024-00824-8

本文第一作者:Xupeng Chen (xc1490@nyu.edu), Ran Wang,通訊作者:Adeen Flinker

更多關(guān)于神經(jīng)語音解碼中的因果性討論,可以參考作者們的另一篇論文:

https://www.pnas.org/doi/10.1073/pnas.2300255120