GPT-4、ChatGLM2、Llama2、PaLM2在KDD LLM Day上一起開了個會

這個星期,數據挖掘頂會 ACM KDD 2023 在美國長灘開幕,在五天的主會議期間,大會專門給大模型準備了一整天。來自 Open AI、Meta、智譜 AI、Google DeepMind、Microsoft、Intel 等大語言模型領域走在前沿的公司及研究學者進行了精彩的思想碰撞。

這也是為數不多的一次,是中國的大語言模型專家與國際巨頭們同臺競技,深度交流。

此次大模型開放日的 Keynote 演講嘉賓包括:微軟首席科學家 & 技術院士 Jaime Teevan,OpenAI ChatGPT 團隊成員 Jason Wei,智譜 AI CEO 張鵬,谷歌 DeepMind 首席科學家 / 研究主管 Denny Zhou,以及 Meta FAIR 研究工程師 Vedanuj Goswami,他們就大模型賦能未來工作、語言模型推理能力、Llama 2、GLM-130B 和 ChatGLM、大模型范式與挑戰等主題進行了分享。

此次活動聚焦兩大主題:大語言模型以及其在不同領域應用的最新研究進展,以及如何建立值得信賴的大語言模型。讓我們一起聽聽他們都說了什么。

OpenAI Jason Wei

大語言模型的復興:范式和挑戰

Jason Wei 是 OpenAI ChatGPT 研發團隊成員之一。此前他在谷歌大腦團隊擔任高級研究科學家,期間致力于推廣思維鏈提示,共同領導了指令調優前期工作,并撰寫關于大語言模型涌現的工作。

Jason 的分享主題為《大語言模型的復興:范式和挑戰》。他首先概述了大語言模型的三個主要特征,分別是縮放法則、涌現能力和推理能力,并探討了這些特征如何影響自己的 AI 研究領域。

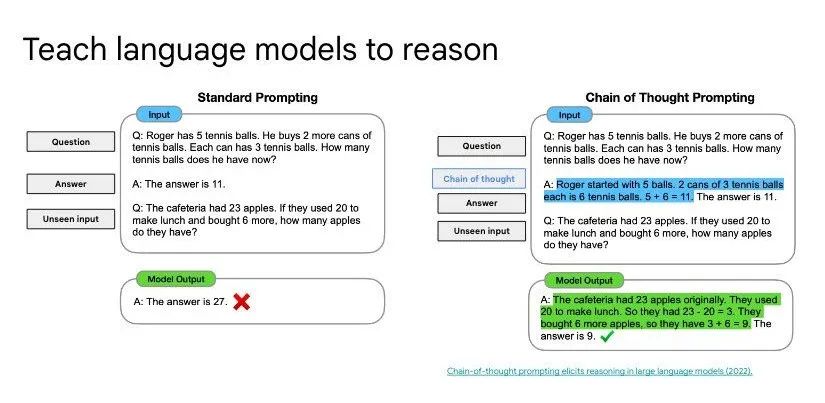

隨后,Jason 介紹了他和其他人在 LLM 推理能力上所做的研究工作。首先是思維鏈(Chain-of-Thought)。如果你用一個想法來提示 LLM,它給出的回復質量就會飛躍。

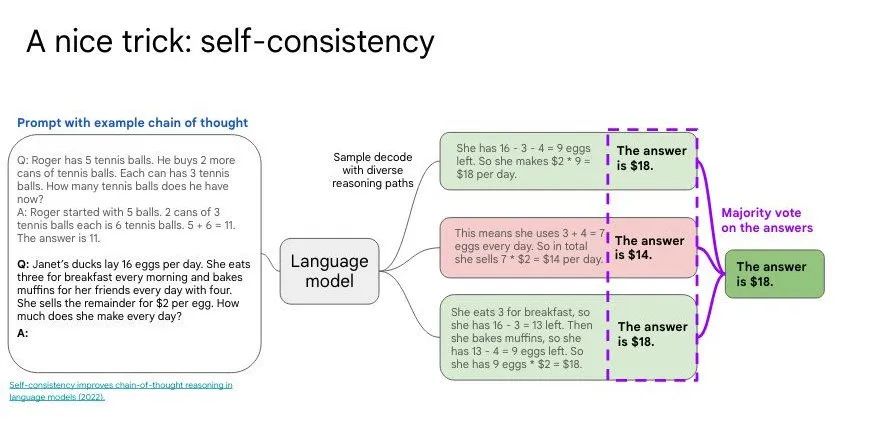

第二個想法是「自我一致性」(Self-Consistency):對多次生成進行采樣調查,然后選擇最常見的答案。「自我一致性」改善了語言模型中的思維鏈推理。

第三個想法是「從最少到最多的提示」(Least-to-Most Prompting),這要求 LLM 將問題分解成不同的任務,并從易到難進行排序。

智譜 AI 張鵬

從 GLM-130B 到 ChatGLM

作為智譜 AI(Zhipu AI)的 CEO,張鵬帶領團隊成功開發了 1300 億參數的雙語(中英文)大語言模型 GLM-130B。自 2022 年 8 月起,該模型已開源,在準確性和魯棒性方面可媲美 GPT-3 davinci。

2023 年 3 月 14 日,基于 GLM-130B,智譜 AI 正式發布了 ChatGLM,一款類 ChatGPT 的對話機器人產品。此外,其開源、緊湊的版本 ChatGLM-6B 與 ChatGLM2-6B 全球下載量超過 5,000,000 次,連續 28 天位居 Hugging Face Trending 榜首,并在 GitHub 上獲得超過 4.4 萬顆星標。

最近,智譜 AI 還把 ChatGLM 升級到 ChatGLM2,推出了多個參數尺寸,大幅提升了能力,基于 ChatGLM2-6B 的代碼生成模型,智譜 AI 還更新了代碼生成工具 CodeGeeX2。

張鵬的分享主題是《從 GLM-130B 到 ChatGLM》。張鵬介紹了智譜 AI 自研的 GLM 框架,GLM 的預訓練框架是一種自回歸填空的方法,集成了 GPT 和 BERT 這兩種預訓練框架的優勢,既能夠實現單項注意力的計算,做序列的生成,也可以做到雙向注意力的計算,做回歸的模型。

在 GLM 基礎上,2022 年 8 月,智譜推出擁有 1300 億參數的中英雙語稠密模型 GLM-130B。得益于新的模型架構,GLM 在許多具有百萬參數甚至更少訓練步驟的基準測試中,能夠在自然語言理解方面實現比 BERT 和 T5 更好的性能。訓練一個 1000 億規模的大型語言模型并非易事,智譜團隊解決了許多工程問題和算法上的挑戰,包括頻繁且隨機的硬件故障、訓練穩定性等問題,相關細節都發表在 ICLR 2023 的論文中。

微軟 Jaime Teevan

從文檔到對話:LLM 如何塑造未來的工作

Jaime 是微軟首席科學家和技術院士,負責公司核心產品中的驅動技術創新。她提倡人們應找到更聰明的方式來充分利用好時間,領導微軟的未來工作倡議,探索 AI 和混合辦公等如何改變人們完成事情的方式。此前她曾擔任微軟 CEO 薩提亞?納德拉的技術顧問,并領導了微軟研究院的生產力團隊。

此外,Jaime 是 ACM Fellow 以及 ACM SIGIR and SIGCHI Academies 的會員。她還曾榮獲 TR35、BECA 和 Karen Sparck Jones 獎。她本科畢業于耶魯大學,并獲得了 MIT 人工智能博士學位。她也是華盛頓大學的客座教授。

此次她的分享主題為《從文檔到對話:LLM 如何塑造未來的工作》。可以想象的是,伴隨 LLM 的崛起,未來的工作方式正在發生迅速變化,知識越來越多地蘊含在對話而非文檔中。

在演講中,Jaime 探討了 LLM 如何通過生成符合人們語境和意圖的自然語言建議和反饋,以提高人們的工作效率和創造力。要有效地做到這一點,LLM 需要能夠利用各種來源的相關內容作為其響應的基礎。人們還需要學習新的對話模式,以充分發揮大模型的價值,因為在人際交往中行之有效的模式對 LLM 來說可能并不是最佳的。

此外,Jaime 討論了提示工程在生產環境中的重要性,并強調能夠識別和推薦對話模板的價值。通過對這些研究課題的深入研究,推薦系統界有機會創造一個全新的、更美好的工作未來。

谷歌 DeepMind Denny Zhou

教語言模型學推理

Denny Zhou 是 Google DeepMind 的首席科學家 / 研究主管,他是推理團隊的創立者和現任負責人。主要研究興趣在于構建和教導大語言模型實現類人的推理能力。他領導的團隊已經開發了思維鏈提示、自洽性解碼、最少到最多提示、指令調優(FLAN2)、LLM 自我調試等大語言模型的各種涌現屬性。Denny Zhou 曾獲得 2022 年谷歌研究技術影響力獎(Google Research Tech Impact Award)。

他的分享主題為《教語言模型學推理》。過去數十年,機器學習社區已經開發了大量用來增強學習效率的數據驅動方法,比如半監督學習、元學習、主動學習、遷移學習等。然而,所有這些方法已被證明對于現實世界的 NLP 任務并不是特別有效,由此暴露了機器學習的一大缺陷 —— 缺乏推理。人們往往可以從很少的示例中學習,這就歸功于推理能力而不是依賴數據統計。

因此在此次分享中,Denny Zhou 探討了谷歌 DeepMind 引領的 LLM 推理工作,他們開發的方法極大縮小了人類智能與機器學習之間的差距,在僅要求很少的注釋示例且不需要訓練的情況下也能實現新的 SOTA。這些工作,谷歌 CEO 桑達爾?皮查伊在 2021 年的 Google I/O 大會上進行過重點展示。

Meta FAIR Vedanuj Goswami

Llama 2:開放基礎和微調聊天模型

上個月,最強的開源大模型 Llama 2 驚艷發布,一夜之間改變了大模型競爭格局。發布之后, Llama 2 模型迅速成為了社區最廣泛使用和下載的開源模型之一。Vedanuj 曾經參與訓練 Llama 2 系列模型,目前在 Meta AI 的 LLM 研究團隊擔任研究工程師,重點研究 LLM 預訓練和縮放技巧。

Vedanuj 還曾是「No Language Left Behind」(不落下任何語言)和「Universal Speech Translation for Unwritten Languages」(非書面語的通用語音翻譯)等翻譯項目的研究負責人,并在 FAIR 從事過多模態研究,領導 FLAVA 和 MMF 等著名項目。

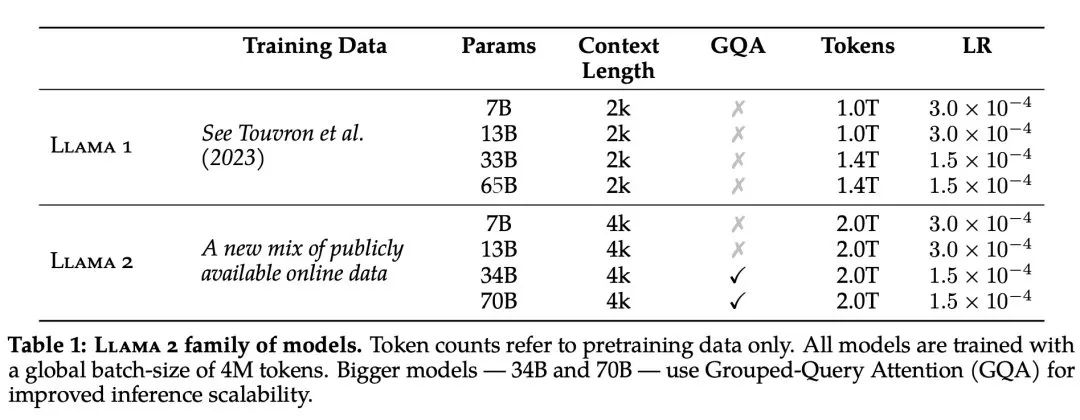

這一次,他的分享主題為《Llama 2:開放基礎和微調聊天模型》。7 月 18 日剛剛發布的 Llama 2 模型系列包含 70 億、130 億和 700 億三種參數變體,因為開源且可以直接商用化,吸引了整個業界的關注。

在預訓練層面,Llama 2 模型系列以 Llama 1 論文中描述的預訓練方法為基礎,使用了優化的自回歸 transformer,并做了一些改變以提升性能。相比于 Llama 1,Llama 2 的訓練數據多了 40%,上下文長度也翻倍,并采用了分組查詢注意力機制。具體來說,Llama 2 預訓練模型是在 2 萬億的 token 上訓練的,精調 Chat 模型是在 100 萬人類標記數據上訓練的。

在訓練硬件方面,Meta 在其研究超級集群(Research Super Cluster, RSC)以及內部生產集群上對模型進行了預訓練。兩個集群均使用了 NVIDIA A100。在 Meta 的評估中,多項測評結果顯示,Llama 2 在包括推理、編碼、精通性和知識測試等許多外部基準測試中都優于其他開源語言模型。

當然,對于今天的大模型來說,「安全」是一個重要性不亞于「性能」的指標。在 Llama 2 的研發過程中,Meta 使用了三個常用基準評估其安全性:

- 真實性,指語言模型是否會產生錯誤信息,采用 TruthfulQA 基準;

- 毒性,指語言模型是否會產生「有毒」、粗魯、有害的內容,采用 ToxiGen 基準;

- 偏見,指語言模型是否會產生存在偏見的內容,采用 BOLD 基準。

如今,大模型技術以「天」為單位飛速發展。一覺醒來,人們可能就會看到最新技術成果帶來的巨變。

面對這樣的時代,學術界、工業界和社會各自面臨著怎樣的機遇?另一方面,大模型在生產、生活層面的深入,又帶給這個時代哪些挑戰?這些都是值得深思的問題。

在活動最后的圓桌討論中,來自 Google DeepMind、微軟、英特爾、密歇根大學的多位研究者共同探討了大模型時代面臨的范式轉變。

在各家廠商激烈角逐大模型的半年多時間里,我們很少有機會看到 GPT-4、Llama2、ChatGLM、PaLM2 這些模型的幕后團隊能夠聚在一起進行討論。特別是在這次大模型開放日中,ChatGLM 成為唯一來自國內的代表,向世界展現了中國的大模型技術實力。推出 ChatGLM 的智譜 AI,還是本次 KDD 最高級別的鉆石贊助商,可以看到國內廠商在學術生態領域的活躍與貢獻。

今天,我們對大模型的能力還在不斷探索過程中,學術界也需要有更多的「大模型開放日」,共同推動各界力量的交流與合作,以突破人工智能的邊界。