使用LLMLingua-2壓縮GPT-4和Claude提示

譯文

縮短發送給大型語言模型(LLM)的提示的長度可以減少推理時間并降低成本。這是提示壓縮成為LLM研究的一個熱門領域的原因。

清華大學和微軟公司的研究人員日前在發布的一篇論文中介紹了LLMLingua-2,這是一種任務不可論的新的提示壓縮技術。LLMLingua-2與其他提示壓縮方法相比更快、更高效,并且需要更少的計算資源。對于涉及冗長提示和壓縮的LLM應用程序來說,它是一個很好的工具,可以節省大量成本,并獲得更好的用戶體驗。

任務感知和任務不可知的提示壓縮

思維鏈(CoT)推理、場景學習和檢索增強生成(RAG)等技術使LLM能夠處理訓練數據中未包含的復雜任務和知識。

然而,冗長提示的好處是以增加計算和財務需求為代價的。在一些LLM中,較長的提示可能會降低模型處理場景信息能力的準確性。

提示壓縮通過在保留重要信息的同時縮短原始文本來解決這些問題。提示壓縮的基本假設是自然語言包含冗余,這可能對人類理解有用,但對LLM來說不是必要的。

提示壓縮可以分為“任務感知”和“任務不可知”兩種方法。任務感知壓縮根據下游任務或當前查詢從提示符中刪除令牌。LongLLMLingua是一種流行的方法,它采用問題感知的多步驟方法來估計令牌的信息熵并刪除冗余部分。其他方法使用強化學習來訓練模型,以壓縮來自下游任務的獎勵信號的提示。任務感知壓縮的缺點是它們對其他任務的推廣能力有限。

另一方面,任務不可知的方法在不考慮特定任務的情況下壓縮提示,使其更適合于更廣泛的應用程序和黑盒LLM。一些任務不可知論包括LLMLingua和選擇性場景(Selective Context)。這些方法使用諸如Llama-7B之類的因果小語言模型(SLM)來評估令牌或詞匯單位的熵,并刪除那些不能添加有意義信息的令牌或詞匯單位。

LLMLingua-2是由原始LLMLingua的作者開發的,是一種任務不可知的提示壓縮技術。

LLMLingua-2的工作原理

目前的任務不可知的壓縮方法有一些局限性,這導致研究人員創建了LLMLingua的后繼者。

微軟高級研究員、論文合著者Qianhui Wu表示:“信息熵可能是一種次優的壓縮指標,因為它與提示壓縮目標不一致,并且只利用了單向場景,可能無法捕獲提示壓縮所需的所有基本信息。”

LLMLingua-2將提示符壓縮重新表述為一個分類任務,該任務指定每個令牌是應該保留還是丟棄。它使用這個任務公式來創建一個提示壓縮訓練數據集。然后,它使用數據集來訓練用于壓縮任務的輕量級雙向Transformer編碼器模型。

Wu說,“通過這種方式,它可以從完全雙向場景中捕獲提示壓縮所需的所有基本信息,并保證壓縮之后的提示與原始提示的忠實性。”

LLMLingua-2有幾個關鍵的優點:首先,使用雙向編碼器確保它可以捕獲所有必要的信息,以進行快速壓縮。其次,由于它使用更小的Transformer模型來學習壓縮目標,因此它具有更低的延遲。第三,它的設計是為了忠實于最初的提示,避免產生幻覺。

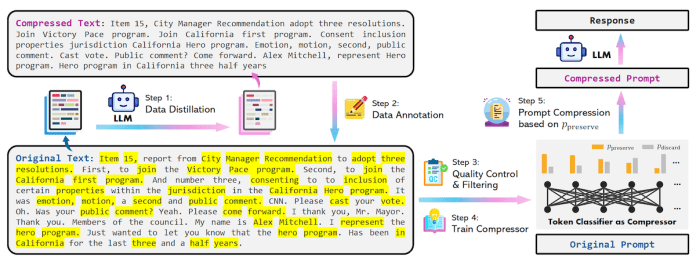

圖1 LLMLingua-2

訓練壓縮模型

為了生成訓練提示壓縮模型的數據集,研究人員使用數據蒸餾程序從強LLM中提取知識。他們向GPT-4提供提示,并指示它在保留基本信息和避免幻覺的同時減少令牌。

在獲得成對的原始文本及其壓縮版本之后,他們為原始文本中的每個令牌分配一個二進制標簽,以確定壓縮之后應該保留還是丟棄它。研究人員使用MeetingBank數據集創建了訓練示例。

然后,他們在數據集上訓練了一個稍微修改過的xlm-roberta-large和多語言BERT轉換模型,將標記分類為“保留”或“丟棄”。基于BERT的模型的優點是它們學習雙向特征,而不是只知道先前令牌的自回歸解碼器模型。這允許壓縮模型學習更豐富的相關性,從而實現更好的壓縮。

研究人員寫道:“在推理過程中,我們根據分類模型計算出的概率來決定是保留還是丟棄原始提示中的每個令牌。”

開發人員可以在GitHub上找到LLMLingua-2的源代碼。

圖2 LLMLingua-2數據蒸餾提示

LLMLingua-2在行動

研究人員在MeetingBank數據集以及LongBench、ZeroScrolls、GSM8K和Big Bench Hard等域外數據集上測試了壓縮模型。他們使用GPT-3.5-Turbo作為目標模型。但是壓縮模型也可以與GPT-4和Claude 3等前沿模型一起使用。他們將LLMLingua-2的壓縮、速度和準確性與其他方法以及原始提示符進行了比較。

研究結果表明,盡管LLMLingua-2的體積很小,但它的壓縮性能優于其他與任務無關的基準,并且從GPT-3.5-Turbo到Mistral-7B都能很好地推廣。

LLM-Lingua-2實現了2~5倍的壓縮比,與現有的提示壓縮方法相比快了3~6倍。這意味著在需要長時間系統和場景提示的應用程序中使用LLM-Lingua-2可以節省大量成本。LLMLingua-2還可以將延遲降低1.6~2.9倍,并將GPU內存成本降低8倍。

有趣的是,當使用Mistral-7B作為目標LLM時,研究人員發現LLMLingua-2的性能甚至比原始提示更好。研究人員在論文中寫道,“我們推測,Mistral-7B可能不像GPT-3.5-Turbo那樣擅長處理長時間環境。我們的方法是通過提供更短的提示和更高的信息密度,有效地提高了Mistral-7B的最終推理性能。”

Wu說,“LLMLingua-2是一種任務無關的提示壓縮方法,這意味著當處理一個過于冗長的場景時,可以使用LLMLingua-2將其壓縮成一個更短的場景,以適應有限的場景窗口,降低財務成本(因為OpenAI通過令牌向用戶收費),并減少LLM的推理時間。”

然而,與LongLLMlingua等任務感知壓縮方法相比,LLMLingua-2在完成特定任務上存在不足。

研究人員在論文中寫道:“我們將這種表現差距歸因于(任務感知方法)從問題中獲得的額外信息。然而,我們模型的任務不可知特性使其在部署到不同場景時具有良好的可推廣性,并成為一種有效的選擇。”

原文標題:Compress GPT-4 and Claude prompts with LLMLingua-2,作者:Ben Dickson。

文章鏈接:https://bdtechtalks.com/2024/04/01/llmlingua-2-prompt-compression/。