700億參數LLaMA2訓練加速195%,開箱即用的8到512卡LLaMA2全流程方案來了!

LLaMA2訓練微調推理,大提速了!

針對700億版本,訓練加速195%。

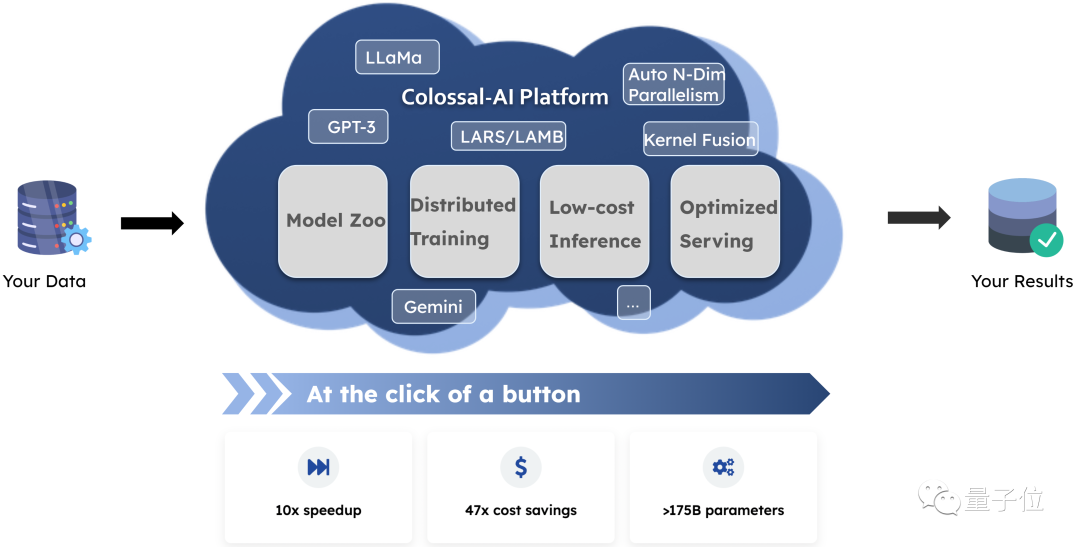

而且還能基于云平臺實現無代碼訓練個性私有化模型,并一鍵部署。

圖片

圖片

超活躍的大模型系統開源項目Colossal-AI又上新了!

可提供開箱即用的8到512卡LLaMA2訓練、微調、推理方案,并提供一站式云平臺解決方案。

大模型開發和應用落地成本,再降億點點~

LLaMA2訓練加速195%

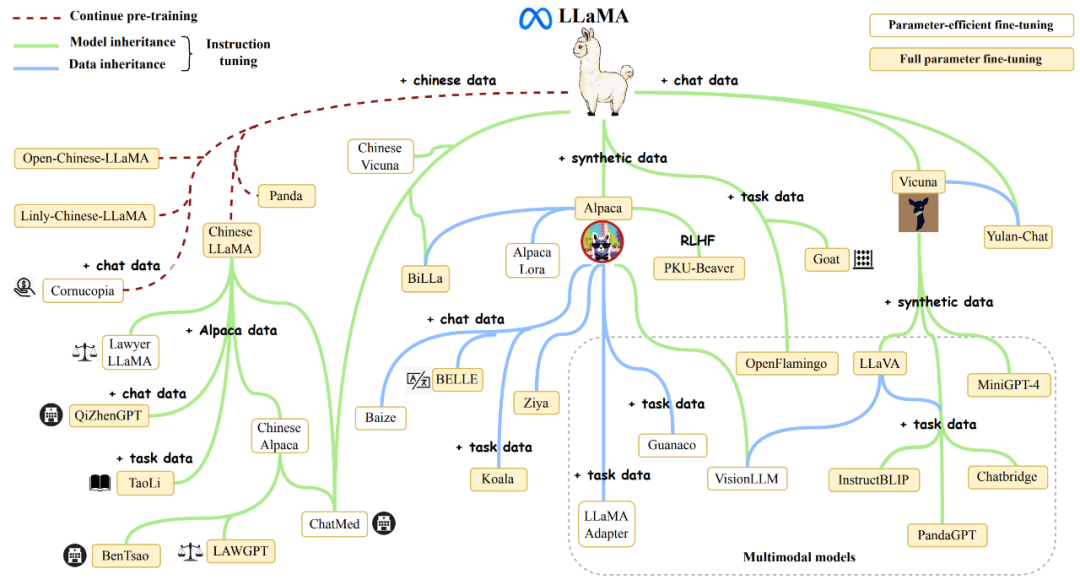

得益于開源特性,LLaMA系列大模型在短短幾個月內已經衍生出諸多應用和項目,也成為很多公司企業應用大模型的首選。

最新的7B~70B LLaMA2大模型,進一步提高了語言模型的基礎能力。

但由于LLaMA2的預訓練預料大部分來自英文通用知識,而僅用微調能夠提升和注入的領域知識和多語言能力也相對有限。

此外,高質量的專業知識和數據集通常被視為各個行業和公司的核心資產,僅能以私有化形式保存。

因此,以低成本預訓練/繼續預訓練/微調LLaMA2系列大模型,結合高質量私有化業務數據積累,幫助業務降本增效是眾多行業與企業的迫切需求與瓶頸。

圖片

圖片

但LLaMA2大模型僅發布了原始模型權重與推理腳本,不支持訓練/微調,也未提供數據集。

所以,針對這些現有問題,Colossal-AI開源了針對LLaMA2的全流程方案,并具備高可擴展性,支持從70億到700億參數的模型,從8卡到512卡都可保持良好的性能。

在使用8卡訓練/微調LLaMA2-7B時,Colossal-AI能達到約54%的硬件利用率(MFU),處于業界領先水平。

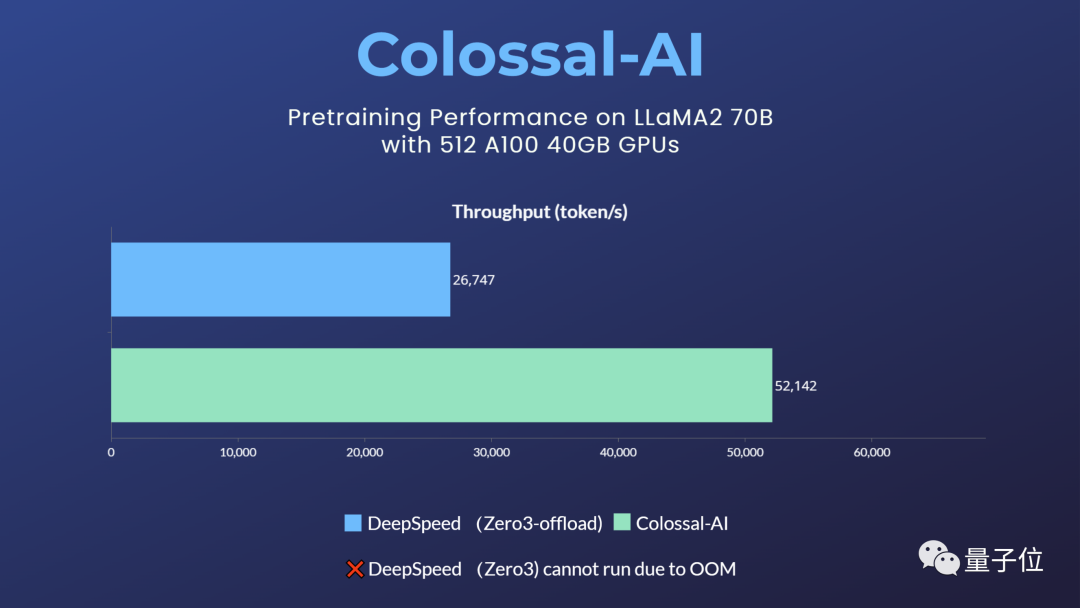

而對于預訓練任務,以使用512張A100 40GB預訓練LLaMA2-70B為例,DeepSpeed ZeRO3策略因顯存不足而無法啟動,僅能通過速度衰減較大的ZeRO3-offload策略啟動。Colossal-AI則因卓越的系統優化和擴展性,仍能保持良好性能,訓練提速195%。

圖片

圖片

Colossal-AI LLaMA-2訓練/微調方案的高性能來源于新的異構內存管理系統Gemini和高性能算子(包括Flash attention 2)等系統優化。

新Gemini提供了高可擴展性、高魯棒性、高易用性的接口。其Checkpoint格式與HuggingFace完全兼容,減小了使用和轉換成本。其對于切分、offload等的設置更加靈活且易用,能夠覆蓋更多硬件配置下的LLaMA-2訓練/微調任務。

僅需數行代碼即可使用:

from colossalai.booster import Booster

from colossalai.booster.plugin import GeminiPlugin

plugin = GeminiPlugin()

booster = Booster(plugin=plugin)

model, optimizer, train_dataloader, criterion = booster.boost(model, optimizer, train_dataloader, criterion)ShardFormer多維細粒度并行

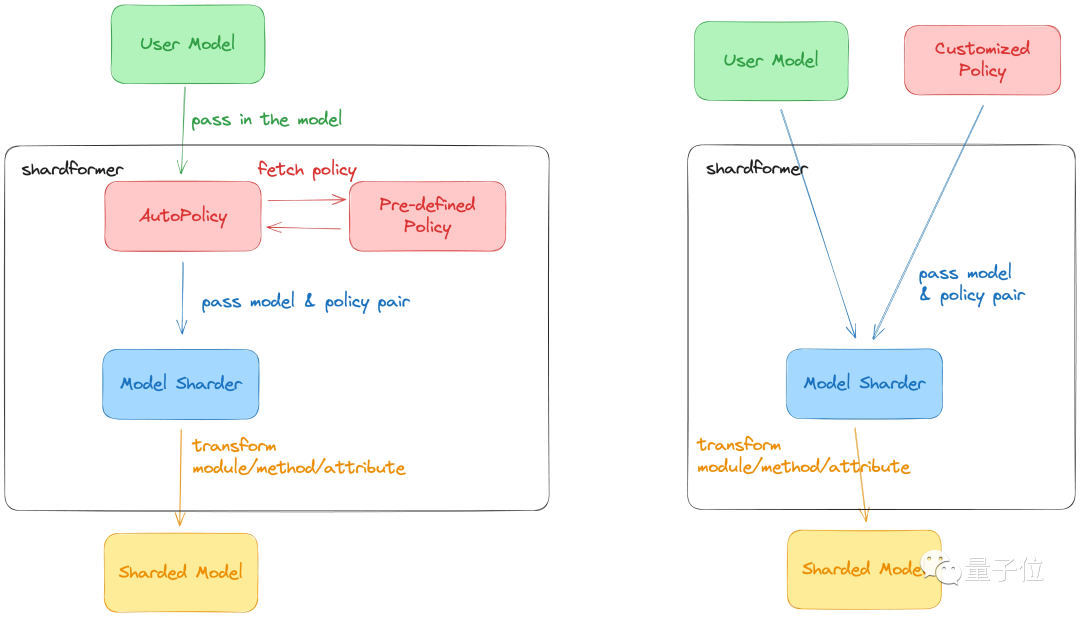

雖然對于主流硬件條件和大多數模型,Colossal-AI的新Gemini已經能夠提供良好的性能,但是對于一些極端硬件條件,或者是特殊模型,可能仍然需要多維并行的細粒度優化。

現有其他方案通常需要分布式系統資深專家,手動對代碼進行大規模重構和調優,Colossal-AI的ShardFormer提供了開箱即用的多維并行和算子優化的能力,僅需數行代碼即可使用,在單機/大規模集群上都能提供良好的性能。

from colossalai.booster import Booster

from colossalai.booster.plugin import HybridParallelPlugin

from transformers.models.llama import LlamaForCausalLM, LlamaConfig

plugin = HybridParallelPlugin(tp_size=2, pp_size=2, num_microbatches=4, zero_stage=1)

booster = Booster(plugin=plugin)

model = LlamaForCausalLM(LlamaConfig())

model, optimizer, train_dataloader, criterion = booster.boost(model, optimizer, train_dataloader, criterion)Colossal-AI ShardFormer支持包括LLaMA1/2、BLOOM、OPT、T5、GPT-2、BERT、GLM在內的主流開源模型,也可以直接使用Huggingface/transformers模型導入,Checkpoint格式也與HuggingFace完全兼容,對比Megatron-LM等需重寫大量代碼的方案,大大提升了易用性。

圖片

圖片

對于并行策略,已支持以下多種并行方式:張量并行、流水線并行、序列并行、數據并行、Zero數據并行等,并可將多種并行方式組合使用,只需通過簡單的配置命令,即可適配各種復雜的硬件環境/模型。

同時,其內置了各種高性能算子,免去了繁瑣的兼容/配置過程。其中包括:

- Flash attention 2

- Memory efficient attention (xformers)

- Fused Normalization Layer

- JIT kernels

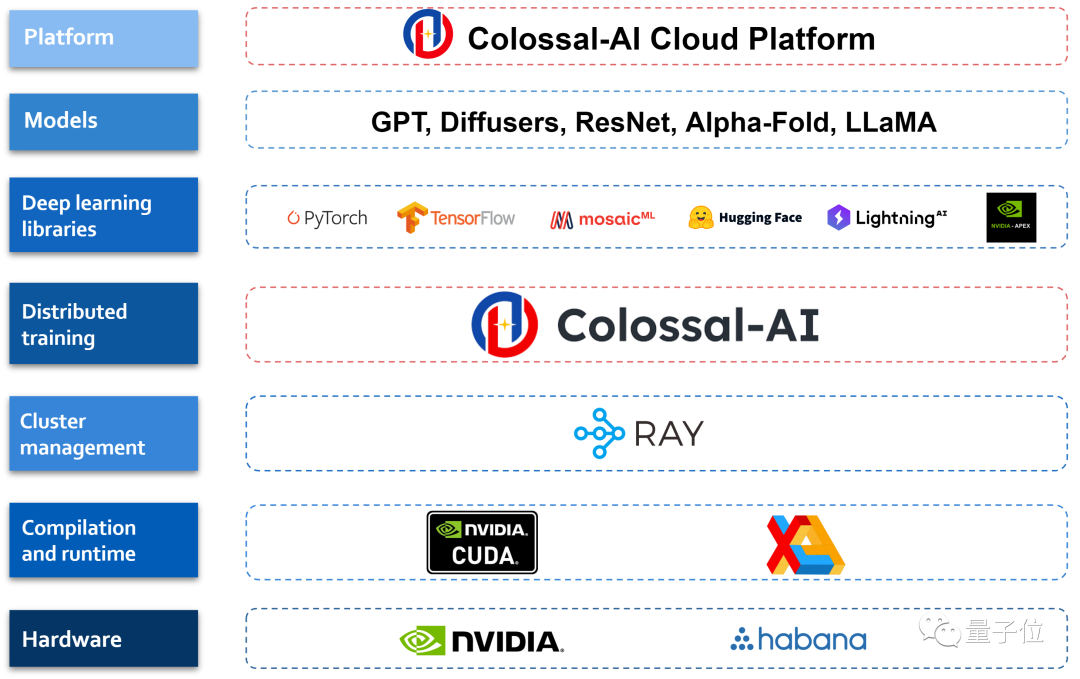

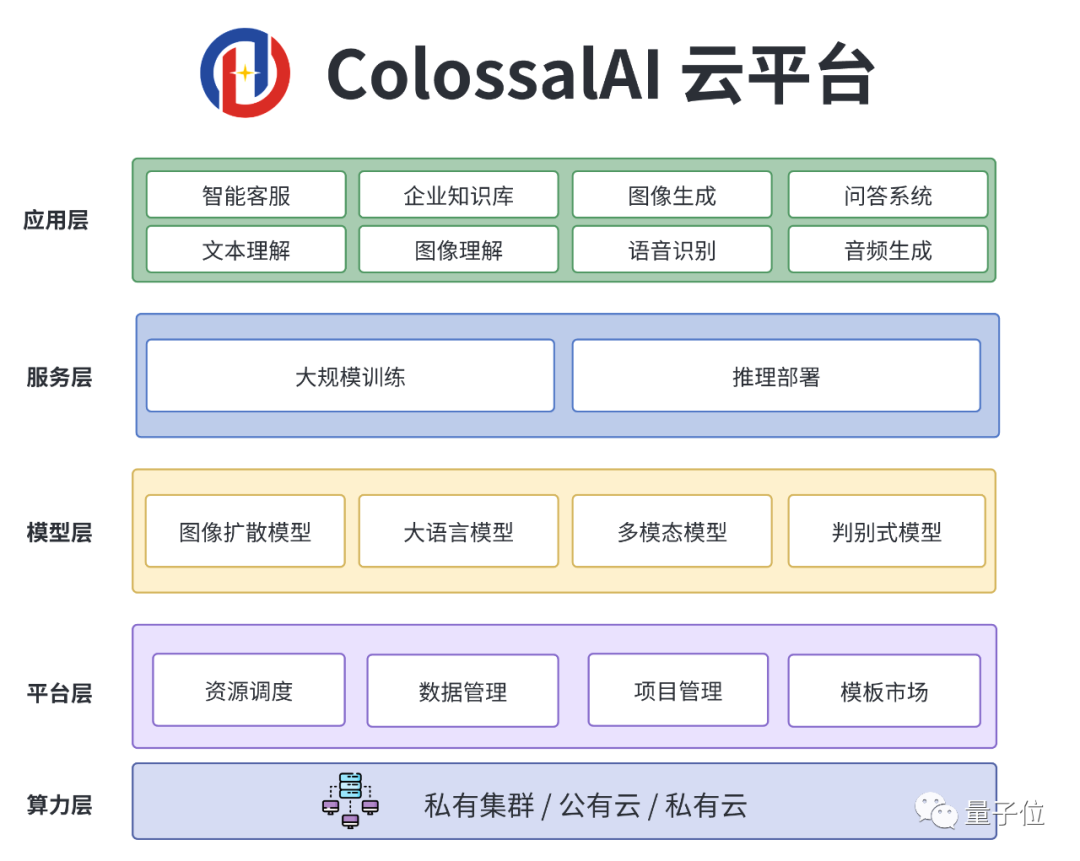

云平臺大模型一站式解決

為了進一步提升開發和部署效率,Colossal-AI團隊還將上述系統優勢與算力結合,提供Colossal-AI云平臺,提供廉價算力和開箱即用的AI主流應用,包括對話大模型,多模態模型,生物醫藥等,現已開啟內測。

圖片

圖片

通過屏蔽大模型底層的分布式并行計算、內存、通信管理與優化等,AI開發者可以繼續專注于AI模型與算法設計,以更低成本更快速度完成AI大模型助力業務降本增效。

圖片

圖片

用戶只需要上傳相關數據,即可無代碼訓練個性化私有模型,并將訓練好的模型一鍵部署。相關的應用都經過Colossal-AI團隊精心優化,得益于算法和系統的雙面優化,能大大降低模型訓練以及部署的成本。

圖片

圖片

感興趣的童鞋可訪問Colossal-AI GitHub地址查看詳情,云平臺可通過搜索“Colossal-AI Platform”了解更多~