一顆GPU,秒出3D模型!OpenAI重磅新作:Point-E用文本即可生成三維點(diǎn)云模型

席卷AI世界的下一個(gè)突破在哪里?

很多人預(yù)測,是3D模型生成器。

繼年初推出的DALL-E 2用天才畫筆驚艷所有人之后,周二OpenAI發(fā)布了最新的圖像生成模型「POINT-E」,它可通過文本直接生成3D模型。

論文鏈接:https://arxiv.org/pdf/2212.08751.pdf

相比競爭對手們(如谷歌的DreamFusion)需要幾個(gè)GPU工作數(shù)個(gè)小時(shí),POINT-E只需單個(gè)GPU便可在幾分鐘內(nèi)生成3D圖像。

經(jīng)小編實(shí)戰(zhàn)測試,Prompt輸入后POINT-E基本可以秒出3D圖像,此外輸出圖像還支持自定義編輯、保存等功能。

地址:https://huggingface.co/spaces/openai/point-e

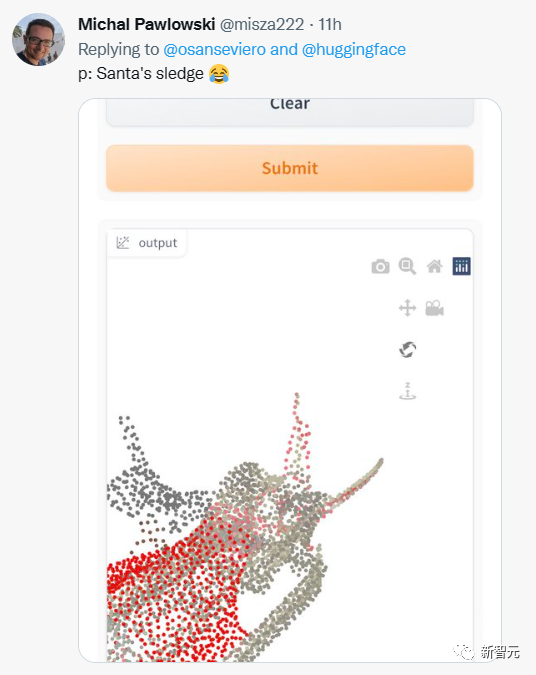

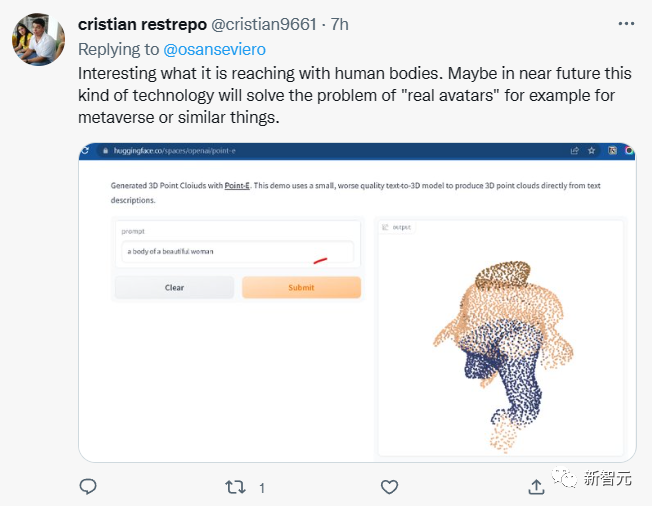

網(wǎng)友也開始嘗試不同的prompt輸入。

但輸出的結(jié)果并不都令人滿意。

還有網(wǎng)友表示,POINT-E或許可以實(shí)現(xiàn)Meta的元宇宙愿景?

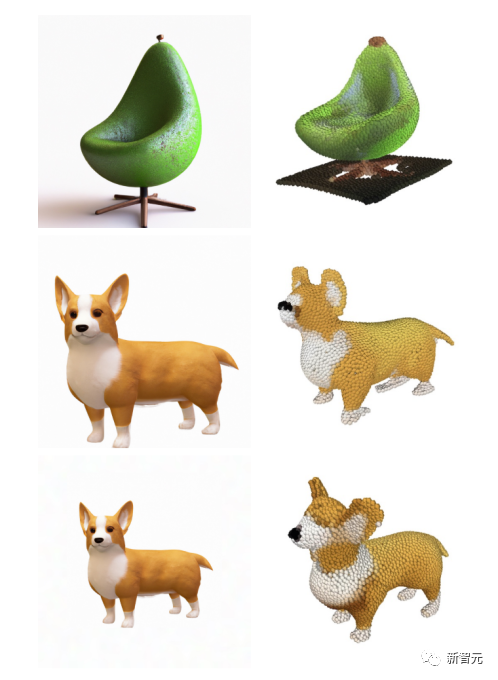

需要注意的是,POINT-E是通過點(diǎn)云(point cloud),也就是空間中點(diǎn)的數(shù)據(jù)集來生成3D圖像。

簡單來說,就是通過三維模型進(jìn)行數(shù)據(jù)采集獲取空間中代表3D形狀的點(diǎn)云數(shù)據(jù)。

從計(jì)算的角度來看,點(diǎn)云更容易合成,但它們無法捕獲對象的細(xì)膩形狀或紋理,這是目前Point-E的一個(gè)短板。

為解決這個(gè)限制,Point-E團(tuán)隊(duì)訓(xùn)練了一個(gè)額外的人工智能系統(tǒng)來將Point-E 的點(diǎn)云轉(zhuǎn)換為網(wǎng)格。

將Point-E點(diǎn)云轉(zhuǎn)換為網(wǎng)格

在獨(dú)立的網(wǎng)格生成模型之外,Point-E 由兩個(gè)模型組成:

一個(gè)文本圖像轉(zhuǎn)化模型(text-to-image model)和圖像轉(zhuǎn)化3D模型(image-to-3D model)。

文本圖像轉(zhuǎn)化模型類似于OpenAI的DALL-E 2和Stable Diffusion,在標(biāo)記圖像上進(jìn)行訓(xùn)練以理解單詞和視覺概念間的關(guān)聯(lián)。

然后,將一組與3D對象配對圖像輸入3D轉(zhuǎn)化模型,以便模型學(xué)會在兩者之間有效轉(zhuǎn)換。

當(dāng)輸入一個(gè)prompt時(shí),文本圖像轉(zhuǎn)化模型會生成一個(gè)合成渲染對象,該對象被饋送到圖像轉(zhuǎn)化3D模型,然后生成點(diǎn)云。

OpenAI研究人員表示,Point-E經(jīng)歷了數(shù)百萬3D對象和相關(guān)元數(shù)據(jù)的數(shù)據(jù)集的訓(xùn)練。

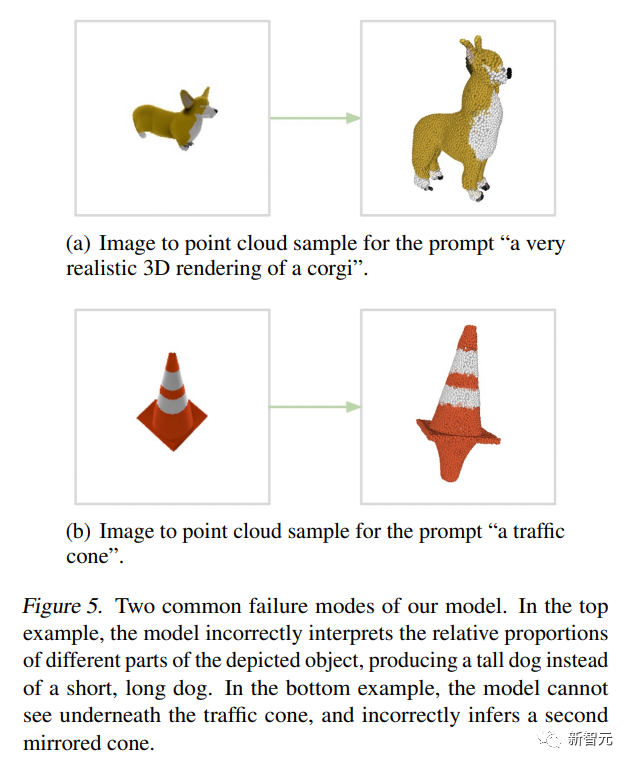

但它并不完美,Point-E 的圖像到 3D 模型有時(shí)無法理解文本到圖像模型中的圖像,導(dǎo)致形狀與文本提示不匹配。盡管如此,它仍然比以前的最先進(jìn)技術(shù)快幾個(gè)數(shù)量級。

他們在論文中寫道:

雖然我們的方法在評估中的表現(xiàn)比最先進(jìn)的技術(shù)差,但它只用了一小部分時(shí)間就可以生成樣本。這可以使它對某些應(yīng)用程序更實(shí)用,并且發(fā)現(xiàn)更高質(zhì)量的3D對象。

Point-E架構(gòu)與運(yùn)行機(jī)制

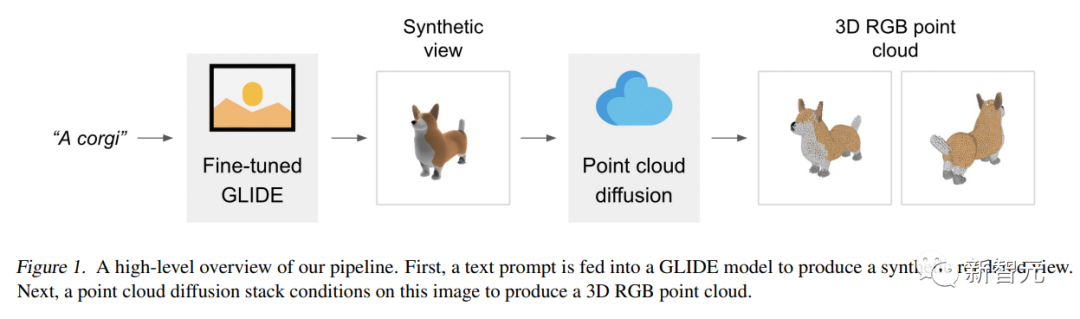

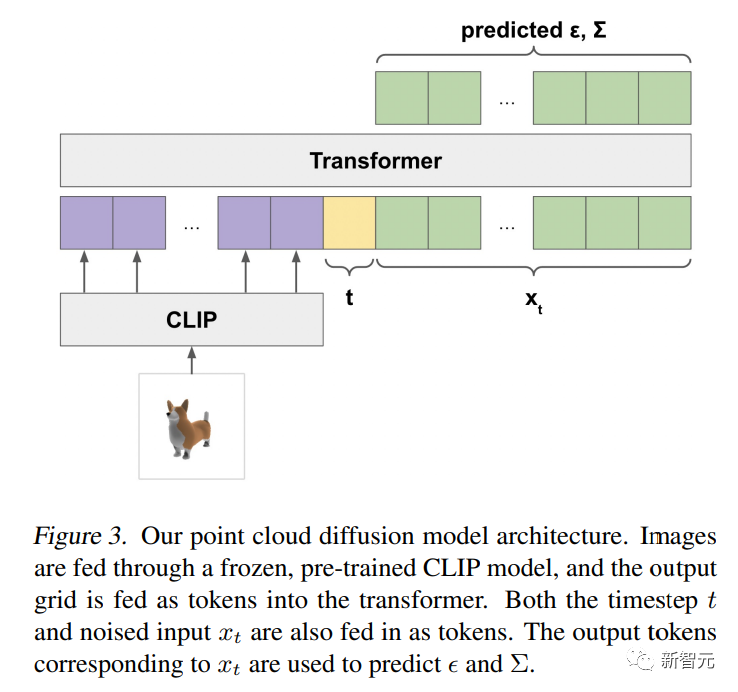

Point-E模型首先使用文本到圖像的擴(kuò)散模型生成一個(gè)單一的合成視圖,然后使用第二個(gè)擴(kuò)散模型生成一個(gè)三維點(diǎn)云,該模型以生成的圖像為條件。

雖然該方法在采樣質(zhì)量方面仍未達(dá)到最先進(jìn)的水平,但它的采樣速度要快一到兩個(gè)數(shù)量級,為一些使用情況提供了實(shí)際的權(quán)衡。

下圖是該模型的一個(gè)high-level的pipeline示意圖:

我們不是訓(xùn)練單個(gè)生成模型,直接生成以文本為條件的點(diǎn)云,而是將生成過程分為三個(gè)步驟。

首先,生成一個(gè)以文本標(biāo)題為條件的綜合視圖。

接下來,生成?個(gè)基于合成視圖的粗略點(diǎn)云(1,024 個(gè)點(diǎn)) 。

最后, 生成了?個(gè)以低分辨率點(diǎn)云和合成視圖為條件的精細(xì)點(diǎn)云(4,096 個(gè)點(diǎn))。?

在數(shù)百萬個(gè)3D模型上訓(xùn)練模型后,我們發(fā)現(xiàn)數(shù)據(jù)集的數(shù)據(jù)格式和質(zhì)量差異很大,這促使我們開發(fā)各種后處理步驟,以確保更高的數(shù)據(jù)質(zhì)量。

為了將所有的數(shù)據(jù)轉(zhuǎn)換為?種通用格式,我們使用Blender從20個(gè)隨機(jī)攝像機(jī)角度,將每個(gè)3D模型渲染為RGBAD圖像(Blender支持多種3D格式,并帶有優(yōu)化的渲染引擎)。

對于每個(gè)模型,Blender腳本都將模型標(biāo)準(zhǔn)化為邊界立方體,配置標(biāo)準(zhǔn)照明設(shè)置,最后使用Blender的內(nèi)置實(shí)時(shí)渲染引擎,導(dǎo)出RGBAD圖像。

然后,使用渲染將每個(gè)對象轉(zhuǎn)換為彩色點(diǎn)云。首先,通過計(jì)算每個(gè)RGBAD圖像中每個(gè)像素的點(diǎn),來為每個(gè)對象構(gòu)建?個(gè)密集點(diǎn)云。這些點(diǎn)云通常包含數(shù)十萬個(gè)不均勻分布的點(diǎn),因此我們還使用最遠(yuǎn)點(diǎn)采樣,來創(chuàng)建均勻的4K點(diǎn)云。

通過直接從渲染構(gòu)建點(diǎn)云,我們能夠避免直接從3D網(wǎng)格中采樣可能出現(xiàn)的各種問題,對模型中包含的點(diǎn)進(jìn)行取樣,或處理以不尋常的文件格式存儲的三維模型。

最后,我們采用各種啟發(fā)式方法,來減少數(shù)據(jù)集中低質(zhì)量模型的頻率。

首先,我們通過計(jì)算每個(gè)點(diǎn)云的SVD來消除平面對象,只保留那些最小奇異值高于某個(gè)閾值的對象。

接下來,我們通過CLIP特征對數(shù)據(jù)集進(jìn)行聚類(對于每個(gè)對象,我們對所有渲染的特征進(jìn)行平均)。

我們發(fā)現(xiàn),一些集群包含許多低質(zhì)量的模型類別,而其他集群則顯得更加多樣化或可解釋。

我們將這些集群分到幾個(gè)不同質(zhì)量的bucket中,并使用所得bucket的加權(quán)混合作為我們的最終數(shù)據(jù)集。

應(yīng)用前景

OpenAI 研究人員指出,Point-E的點(diǎn)云還可用于制造真實(shí)世界的物體,比如3D打印。

通過額外的網(wǎng)格轉(zhuǎn)換模型,該系統(tǒng)還可以進(jìn)入游戲和動畫開發(fā)工作流程。

雖然目前的目光都集中在2D藝術(shù)生成器上,但模型合成人工智能可能是下一個(gè)重大的行業(yè)顛覆者。

3D模型廣泛應(yīng)用于影視、室內(nèi)設(shè)計(jì)、建筑和各種科學(xué)領(lǐng)域。

當(dāng)下3D模型的制造耗時(shí)通常需要幾個(gè)小時(shí),而Point-E的出現(xiàn)恰恰彌補(bǔ)了這一缺點(diǎn)。

研究人員表示現(xiàn)階段Point-E還存在許多缺陷,如從訓(xùn)練數(shù)據(jù)中繼承的偏差以及對于可能用于創(chuàng)建危險(xiǎn)物體的模型缺乏保護(hù)措施。

Point-E只是個(gè)起點(diǎn),他們希望它能激發(fā)文本到3D合成領(lǐng)域的「進(jìn)一步工作」。