飛槳火力全開,重磅上線3D模型:PointNet++、PointRCNN!

11 年前的「阿凡達(dá)」讓少年的我們第一次戴上 3D 眼鏡,聲勢(shì)浩大的瀑布奔流而下,星羅棋布飄浮在空中的群山,無一不體現(xiàn)著對(duì)生命的敬意,妥妥的坐穩(wěn)了 2010 年北美、海外、中國(guó)和全球票房 No.1 的寶座,「3D」正式進(jìn)入了大眾的視線。

圖片來自網(wǎng)絡(luò)

11 年過去了,出走半生,我們依舊少年,「阿凡達(dá) 2」依舊沒有如約上映,但 3D 應(yīng)用卻在此期間得到了蓬勃的發(fā)展。

這一方面得益于 3D 傳感器技術(shù)的飛速發(fā)展,用戶可以更加便捷地獲取到三維圖像數(shù)據(jù);另一方面隨著機(jī)器人、無人駕駛、AR&VR 等業(yè)務(wù)的日趨成熟,需要快速處理和理解海量的 3D 數(shù)據(jù),以便精確感知周邊物體的空間信息,3D 數(shù)據(jù)的深度學(xué)習(xí)需求應(yīng)運(yùn)而生。

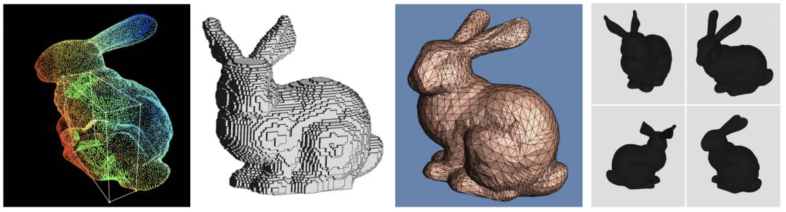

3D 深度學(xué)習(xí)需要什么格式的數(shù)據(jù)輸入呢?

2D 圖像可以天然的表示成二維矩陣,但 3D 數(shù)據(jù)卻非常復(fù)雜,它有很多種表達(dá)形式,如:點(diǎn)云、體積像素、多邊形網(wǎng)格和多視圖。

在 3D 深度學(xué)習(xí)領(lǐng)域中,點(diǎn)云數(shù)據(jù)應(yīng)用最為廣泛。這是因?yàn)辄c(diǎn)云數(shù)據(jù)非常接近原始的傳感器數(shù)據(jù),采用這種形式,可以更好的挖掘原始數(shù)據(jù)中的信息,使用較少的數(shù)據(jù)即可表征較多的細(xì)節(jié)的特性。

但是點(diǎn)云是不規(guī)則的數(shù)據(jù),在空間中可以任意分布。傳統(tǒng)情況下,可以先將點(diǎn)云數(shù)據(jù)轉(zhuǎn)化成體積像素表示方式,再?gòu)?fù)用 2D 圖像的 CNN 模型,但是代價(jià)會(huì)非常高。

原因是體積像素在空間中的稀疏性使得 3D CNN 訓(xùn)練對(duì)顯存要求極高,模型難以收斂。

那么,是否有方法可以直接在點(diǎn)云上數(shù)據(jù)上實(shí)現(xiàn)特征學(xué)習(xí)呢?

飛槳開源框架 1.7 版本發(fā)布了用于 3D 點(diǎn)云分類、分割和檢測(cè)的 PointNet++ 和 PointRCNN 模型。

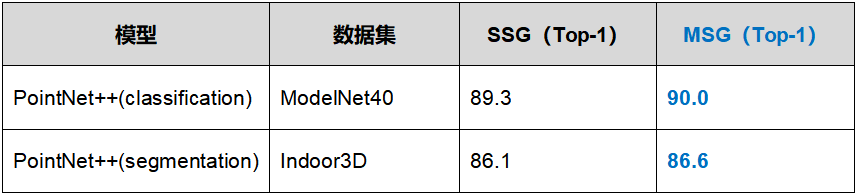

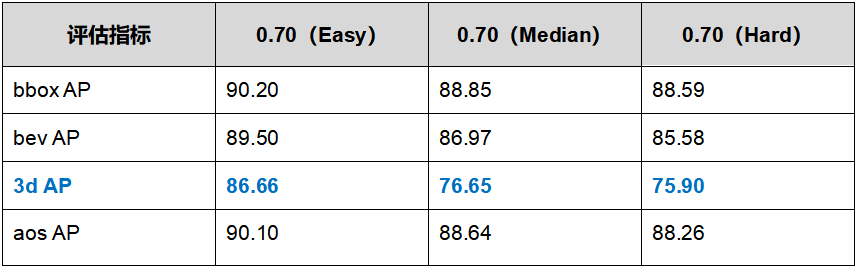

支持 ShapeNet,ModelNet,KITTI 等多種點(diǎn)云數(shù)據(jù)集,在 ModelNet40 數(shù)據(jù)集上,PointNet++ 分類精度可達(dá) 90%,在 KITTI(Car)的 Easy 數(shù)據(jù)子集上,PointRCNN 檢測(cè)精度可達(dá) 86.66%,持平世界領(lǐng)先水平。

開發(fā)者在飛槳框架基礎(chǔ)上可快速完成任務(wù),實(shí)現(xiàn)工業(yè)應(yīng)用。

3D 模型體驗(yàn)請(qǐng)戳如下鏈接:

-

https://github.com/PaddlePaddle/models/tree/release/1.7/PaddleCV/3d_vision

PointNet++ 原理和實(shí)驗(yàn)表現(xiàn)

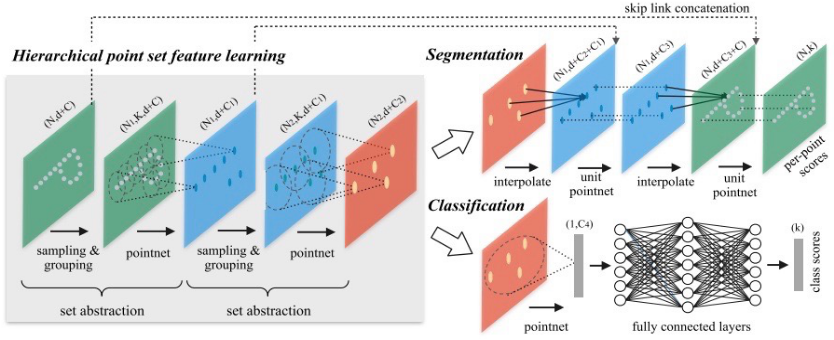

①多級(jí)點(diǎn)集特征學(xué)習(xí)(Hierarchical point set feature learning)

集合抽象層是多級(jí)點(diǎn)集特征學(xué)習(xí)的基本模塊,由如下三個(gè)關(guān)鍵部分組成:

-

采樣層:使用最遠(yuǎn)點(diǎn)采樣(FPS)的方法,從輸入點(diǎn)中選擇一組點(diǎn),定義局部區(qū)域的中心。

-

分組層:根據(jù)中心點(diǎn)進(jìn)行分組,將云點(diǎn)數(shù)據(jù)劃分成若干個(gè)局部區(qū)域。

-

特征提取:通過 PointNet++ 對(duì)各個(gè)局部區(qū)域進(jìn)行特征提取,獲得局部特征。

圖中將 Paddle 首字母“P”做一個(gè)局部坐標(biāo),通過 PointNet++ 提取特征,得到一個(gè)新的點(diǎn)。重復(fù)這個(gè)操作,會(huì)得到另一個(gè)小區(qū)域的點(diǎn)。

經(jīng)過一系列操作之后,會(huì)得到一組新的點(diǎn)。這組點(diǎn)在數(shù)量上少于輸入的點(diǎn),但每個(gè)點(diǎn)都代表了周圍區(qū)域的幾何特征。

②分類任務(wù)(Classification)

類似于傳統(tǒng)的圖像分類,模型將全局特征送入全連接網(wǎng)絡(luò)中,最終得到預(yù)測(cè)的類別概率。

③分割任務(wù)(Segmentation)

對(duì)于語(yǔ)義分割任務(wù),需要從低分辨率特征中上采樣還原高分辨率的特征。對(duì)于 CNN 模型,一般是使用 2D 圖像插值的方式實(shí)現(xiàn)。

PointNet++ 模型采用提取最近的 3 個(gè)近鄰點(diǎn),并通過這三個(gè)點(diǎn)加權(quán)平均的方式插值獲得上采樣點(diǎn)。

此外,PointNet++ 還因其對(duì)輸入數(shù)據(jù)順序置換的不變性、輕量級(jí)結(jié)構(gòu)、對(duì)數(shù)據(jù)丟失非常魯棒等特征,非常適合工業(yè)領(lǐng)域應(yīng)用。

實(shí)驗(yàn)結(jié)論 PointRCNN 原理和實(shí)驗(yàn)表現(xiàn)

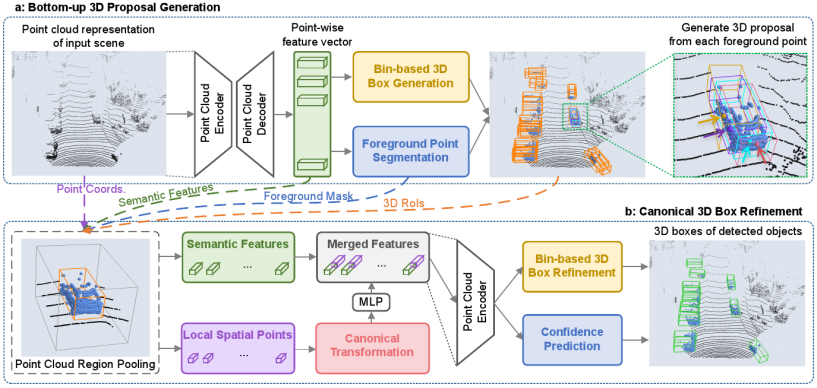

PointRCNN 的網(wǎng)絡(luò)結(jié)構(gòu)分為兩個(gè)階段:第一階段自底向上生成 3D 候選預(yù)測(cè)框;第二階段在規(guī)范坐標(biāo)中對(duì)候選預(yù)測(cè)框進(jìn)行搜索和微調(diào),得到更為精確的預(yù)測(cè)框作為檢測(cè)結(jié)果。

第一階段:對(duì) 3D 點(diǎn)云數(shù)據(jù)進(jìn)行語(yǔ)義分割和前背景劃分,生成候選預(yù)測(cè)框,有如下三個(gè)關(guān)鍵部。

①點(diǎn)云特征提取:通過 PointNet++ 對(duì)點(diǎn)云數(shù)據(jù)進(jìn)行編碼和解碼,提取點(diǎn)云特征向量。

②前景點(diǎn)分割:根據(jù)提取的點(diǎn)云特征向量,使用 focal loss 區(qū)分前景點(diǎn)和背景點(diǎn)。focal loss 能有效地平衡前景點(diǎn)和背景點(diǎn)比例失衡問題,從而得到更為準(zhǔn)確的分類效果。

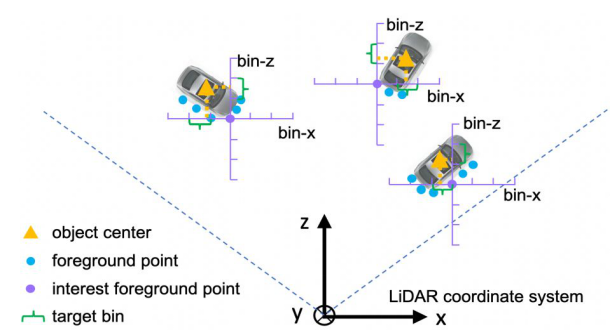

③生成候選框:采用候選框箱模型(bin)的方法,將前背景點(diǎn)分割信息生成預(yù)測(cè)候選框。

bin 的執(zhí)行方式為:先根據(jù)前景點(diǎn)的分割信息粗分其所屬的箱體;再在箱體內(nèi)部對(duì)其做回歸,得到箱體參數(shù)作為預(yù)測(cè)框;最后對(duì)預(yù)測(cè)框做 NMS(Non-Max Suppress,非極大值抑制),得到最終預(yù)測(cè)候選框。

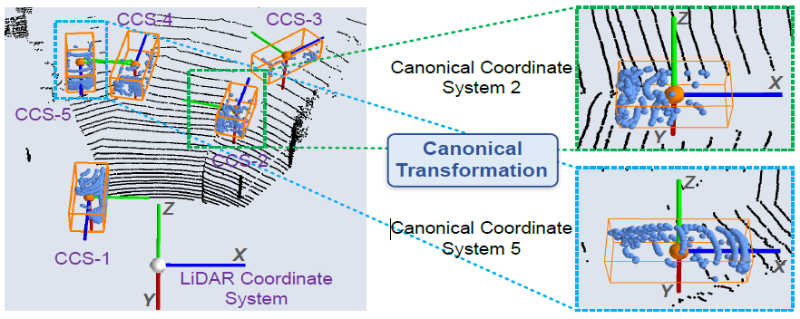

第二階段:在規(guī)范坐標(biāo)中微調(diào)候選預(yù)測(cè)框,獲得最終的檢測(cè)結(jié)果,有如下五個(gè)關(guān)鍵部分。

①區(qū)域池化:對(duì)候選框內(nèi)每個(gè)點(diǎn)的特征進(jìn)行池化。

③特征編碼:將規(guī)范坐標(biāo)時(shí)丟失的深度信息、規(guī)范后的坐標(biāo)信息、前后背景語(yǔ)義信息等經(jīng)過多層感知機(jī)提取特征,作為每個(gè)點(diǎn)的編碼特征。

④微調(diào)預(yù)測(cè)框:經(jīng)過上一步編碼后的特征,經(jīng) PointNet++ 網(wǎng)絡(luò)進(jìn)行特征提取,最后回歸得到局部坐標(biāo)系下的 3D 預(yù)測(cè)框。

實(shí)驗(yàn)結(jié)論

以上就是飛槳 1.7 發(fā)布的 PointNet++ 和 PointRCNN 模型,基于飛槳框架,開發(fā)者可快速實(shí)現(xiàn) 3D 圖像的分類、語(yǔ)義分割和目標(biāo)檢測(cè)任務(wù),模型精度持平世界一流水平。

歡迎感興趣的伙伴在 PaddleCV 的模型庫(kù)中,獲取相關(guān)數(shù)據(jù)集和代碼,嘗試實(shí)現(xiàn)自己的 3D 應(yīng)用。(3D 模型存在自定義 OP,需要在 GPU+Linux 平臺(tái)實(shí)現(xiàn))

如果您加入官方 QQ 群,您將遇上大批志同道合的深度學(xué)習(xí)同學(xué)。官方 QQ 群:703252161。

如果您想詳細(xì)了解更多飛槳的相關(guān)內(nèi)容,請(qǐng)參閱以下文檔。

官網(wǎng)地址:https://www.paddlepaddle.org.cn

飛槳開源框架項(xiàng)目地址:

-

GitHub: https://github.com/PaddlePaddle/models/tree/release/1.7/PaddleCV/3d_vision

-

Gitee: https://gitee.com/paddlepaddle/Paddle

3D 模型體驗(yàn)請(qǐng)戳如下鏈接:

-

https://github.com/PaddlePaddle/models/tree/release/1.7/PaddleCV/3d_vision