60秒直出3D內(nèi)容,紋理逼真!Meta最新3D Gen模型實(shí)現(xiàn)60倍速生成

在圖像生成和視頻生成這兩個(gè)賽道上,大模型僅用了兩年多的時(shí)間就卷得如火如荼。

即使是效果堪比Sora的Gen-3、Luma等模型發(fā)布,也很難引起曾經(jīng)的轟動(dòng)反應(yīng)。

你可能會(huì)疑惑,AI還能玩出新花樣嗎?

Meta放出的最新研究告訴你——能!

不管是圖像還是視頻,即使能做出3D效果,終究只是二維空間中的像素組成的。

Meta最近發(fā)布的3D Gen模型,則能實(shí)現(xiàn)1分鐘內(nèi)的端到端生成,從文本直出高質(zhì)量3D資產(chǎn)。

不僅紋理清晰、形態(tài)逼真自然,而且生成速度比其他替代方案加快了3-60倍。

目前,模型還沒有開放試用API以及相應(yīng)的代碼,官方消息中也沒有透露下一步的發(fā)布時(shí)間。

圖片

圖片

只能看到官方demo但沒法試用,已經(jīng)讓很多網(wǎng)友心癢難耐了。

「把這些可愛的小東西3D打印出來該有多好。」

圖片

圖片

但好在,Meta放出了技術(shù)報(bào)告,讓我們可以細(xì)致觀摩一下技術(shù)原理。

圖片

圖片

論文地址:https://ai.meta.com/research/publications/meta-3d-gen/

Meta 3D Gen

在電影特效、AR/VR、視頻游戲等領(lǐng)域中,創(chuàng)作3D內(nèi)容是最耗時(shí),也是最具挑戰(zhàn)性的環(huán)節(jié)之一,需要很高的專業(yè)技能和陡峭的學(xué)習(xí)曲線。

這件事對人類困難,對AI來說也同樣困難。

相比于圖像、視頻等形式,生產(chǎn)級(jí)的3D內(nèi)容有更多方面的嚴(yán)格要求,不僅包括生成速度、藝術(shù)質(zhì)量、分辨率,還包括3D網(wǎng)格的結(jié)構(gòu)和拓?fù)滟|(zhì)量、UV圖結(jié)構(gòu)以及紋理清晰度。

此外,3D生成還面臨數(shù)據(jù)方面的挑戰(zhàn)。

雖然有數(shù)十億張圖像和視頻可供學(xué)習(xí),但其中適合訓(xùn)練的3D內(nèi)容量卻少了3~4個(gè)數(shù)量級(jí)。因此,模型只能學(xué)習(xí)這些非3D的視覺內(nèi)容,并從二維的觀察中推斷出三維信息。

3D Gen模型則克服了這些困難,在領(lǐng)域內(nèi)邁出了第一步。

模型最大的亮點(diǎn)在于支持基于物理的渲染(PBR,physically-based rendering),這對于在應(yīng)用場景中實(shí)現(xiàn)3D資產(chǎn)的重新照明非常必要。

此外,經(jīng)過專業(yè)藝術(shù)家的評(píng)估,3D Gen在生成同等質(zhì)量,甚至更優(yōu)內(nèi)容的同時(shí),縮短了生成時(shí)間,提升了指令跟隨性能。

生成出3D對象后,模型還支持對其紋理進(jìn)行進(jìn)一步的編輯和定制,20s內(nèi)即可完成。

圖片

圖片

方法

這種更加高效的優(yōu)質(zhì)生成,離不開模型pipeline的精心設(shè)計(jì)。

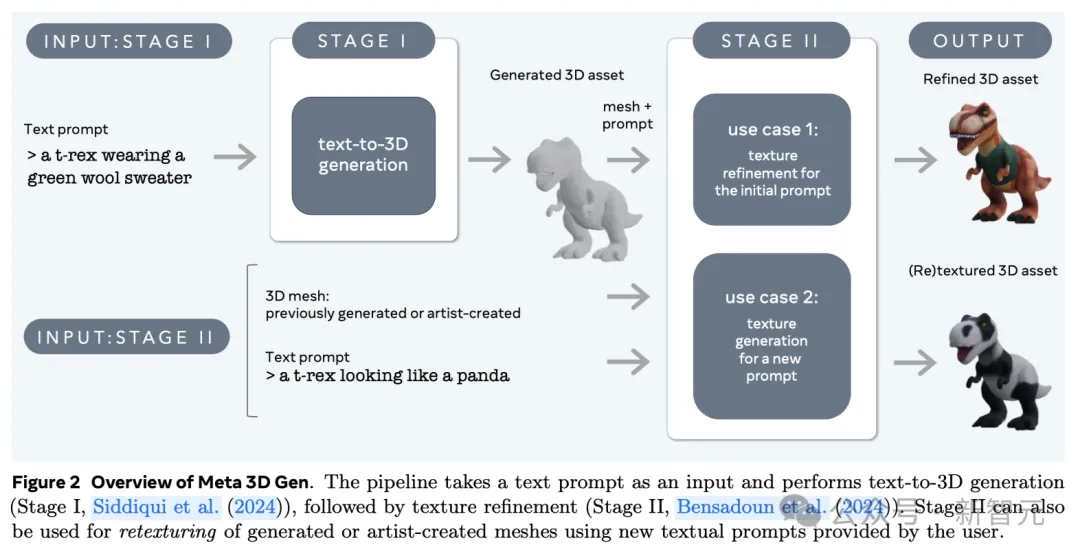

3D Gen的生成主要分為兩步,由兩個(gè)組件分別完成——文本到3D對象生成器AssetGen和文本到紋理生成器TextureGen。

- 第一階段:3D資產(chǎn)生成。根據(jù)用戶提供的文本提示,使用3D AssetGen模型創(chuàng)建初始3D資產(chǎn),即帶有紋理和PBR材質(zhì)圖的3D網(wǎng)格,大約花費(fèi)30s。

- 第二階段:紋理生成。根據(jù)第一階段生成的3D資產(chǎn)和用戶文本提示,使用3D TextureGen模型生成更高質(zhì)量的紋理和PBR圖,大約花費(fèi)20s。

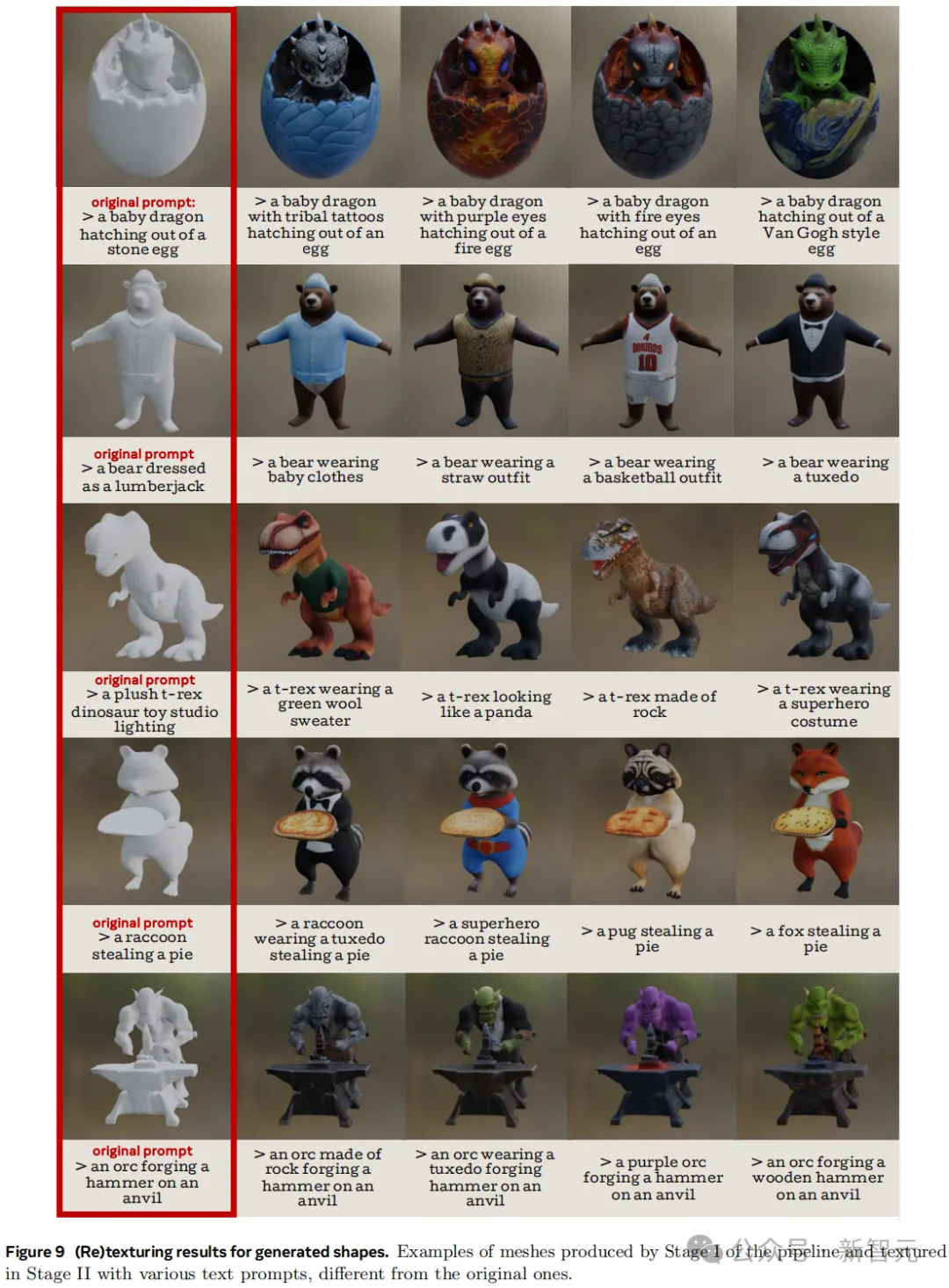

其中,第二階段的TextureGen也可以單獨(dú)拿出來使用。如果有一個(gè)之前生成的,或者藝術(shù)家自己創(chuàng)作的無紋理3D網(wǎng)格,提供描述外觀的文本提示后,模型也能在20s左右的時(shí)間中為它從頭生成紋理。

圖片

圖片

AssetGen和TextureGen這兩個(gè)模型有效地結(jié)合了3D對象的三種高度互補(bǔ)的表示:視圖空間(物體圖像)、體積空間(3D形狀和外觀)以及UV空間(紋理)。

圖片

圖片

AssetGen項(xiàng)目地址:https://assetgen.github.io/

給定文本描述,AssetGen首先利用一個(gè)多視角、多通道版本的圖像生成器生成多張圖像,隨后生成物體的一致視圖。

據(jù)此,AssetGen中的重建網(wǎng)絡(luò)在體積空間中提取出物體的初始版本,并進(jìn)行網(wǎng)格提取,確立其3D形狀和初始紋理。

最后,TextureGen利用視圖空間和UV空間的生成結(jié)果,對紋理進(jìn)行重生成,在保持指令忠實(shí)度的同時(shí)提升紋理質(zhì)量。

圖片

圖片

論文地址:https://ai.meta.com/research/publications/meta-3d-texturegen-fast-and-consistent-texture-generation-for-3d-objects/

上述的每一個(gè)階段都是建立在Meta強(qiáng)大的文生圖模型家族Emu之上,并使用了內(nèi)部數(shù)據(jù)集進(jìn)行微調(diào),主要包括渲染過的合成3D數(shù)據(jù)。

單獨(dú)使用TextureGen模型可以為同一個(gè)物體生成不同的紋理表面

單獨(dú)使用TextureGen模型可以為同一個(gè)物體生成不同的紋理表面

不同于許多SOTA方法,AssetGen和TextureGen都是前饋生成器,因此能實(shí)現(xiàn)快速、高效的部署。

將3D生成任務(wù)以這種方式劃分為兩個(gè)階段,并在同一個(gè)模型中集成對象的多個(gè)表示空間,這種pipeline的組合是Meta重要的創(chuàng)新。

實(shí)驗(yàn)證明,不僅AssetGen和TextureGen兩個(gè)部件都能分別取得更好的效果,它們結(jié)合后形成的3D Gen也能以68%的勝率超過其他模型。

實(shí)驗(yàn)

針對文本到3D資產(chǎn)生成的任務(wù),論文將3D Gen與其他公開可用的常用方法進(jìn)行了對比,并從用戶調(diào)研、定性實(shí)驗(yàn)兩個(gè)方面進(jìn)行了評(píng)估。

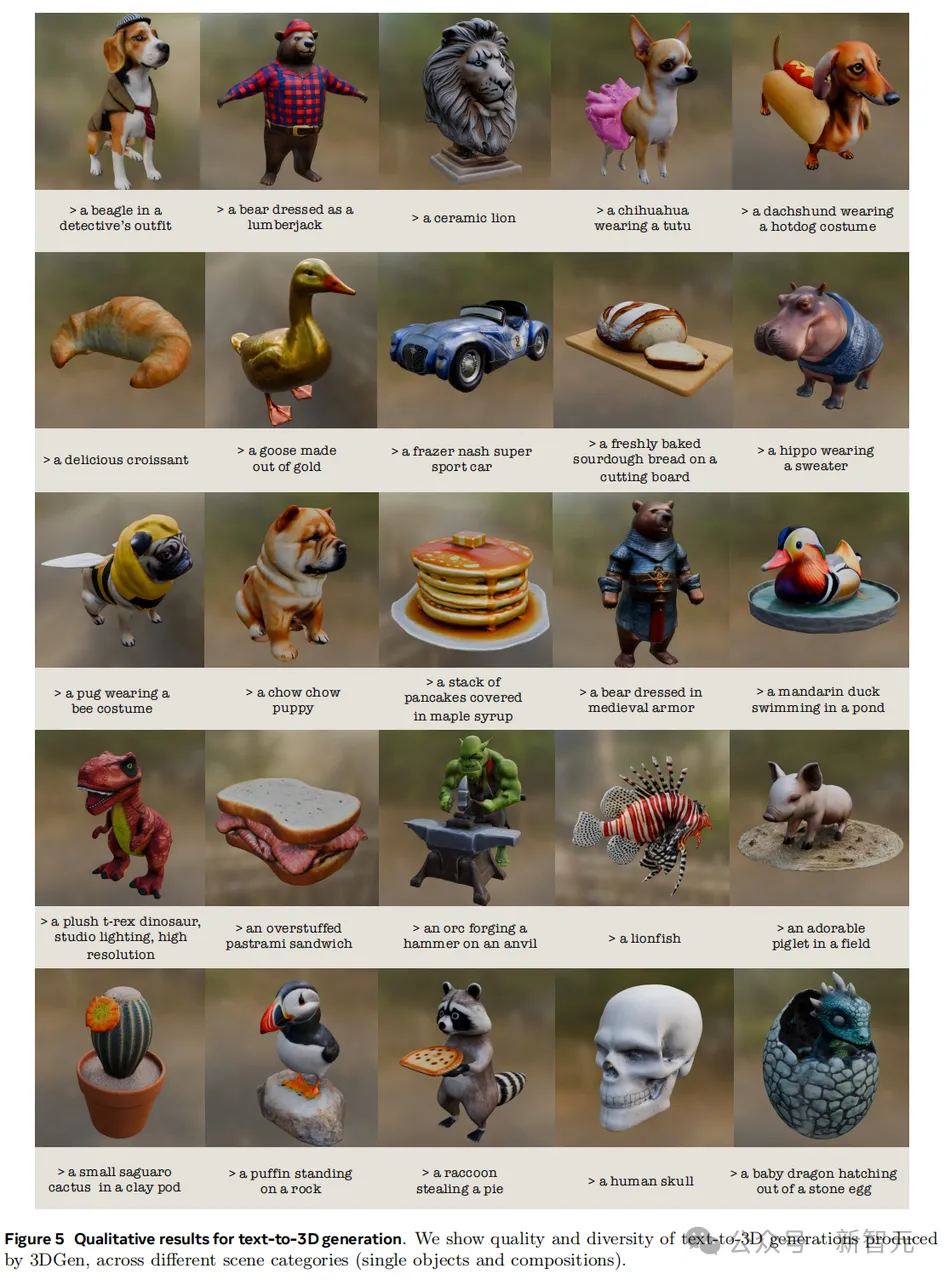

定性結(jié)果

從生產(chǎn)結(jié)果上直觀來看,3D Gen能夠應(yīng)對不同范疇、不同類別物體的生成任務(wù),而且指令跟隨的忠實(shí)度甚至好過很多文生圖模型。

比如讓吉娃娃穿蓬蓬裙、讓臘腸犬穿熱狗裝這樣人類都很難想象的場景,3D Gen也按照要求生成了合理的結(jié)果。

圖片

圖片

生成結(jié)果的多樣性也非常驚艷。比如提示模型只生成Llama(羊駝),他就能給出下圖中的13種不同結(jié)果,風(fēng)格、形狀、紋理各異,可以說想象力很豐富了。

圖片

圖片

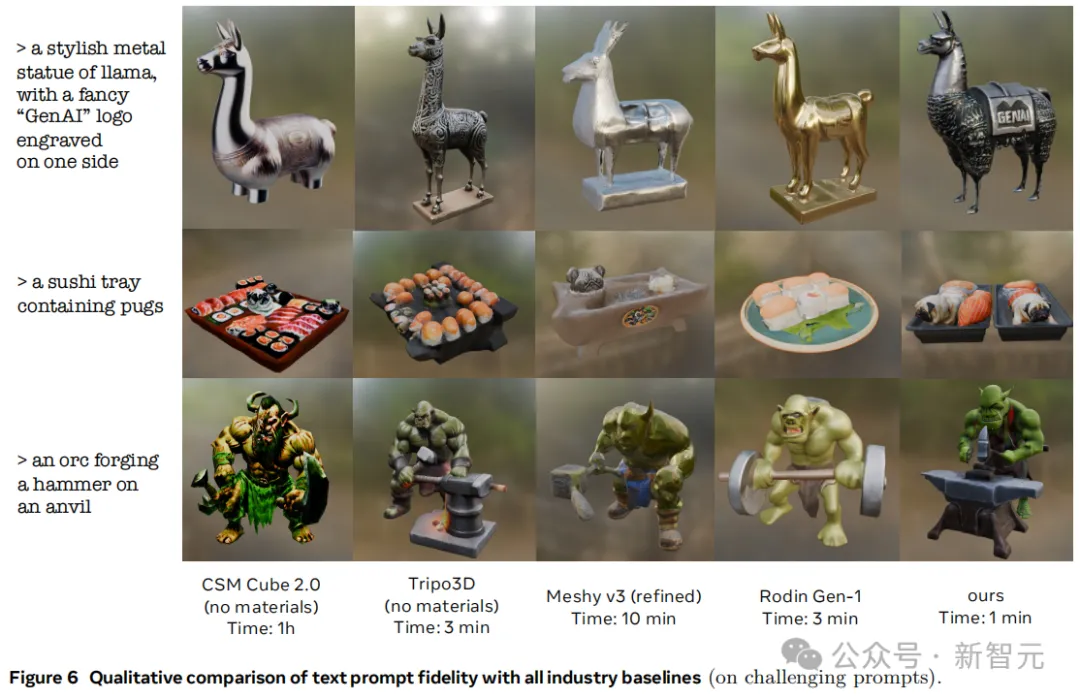

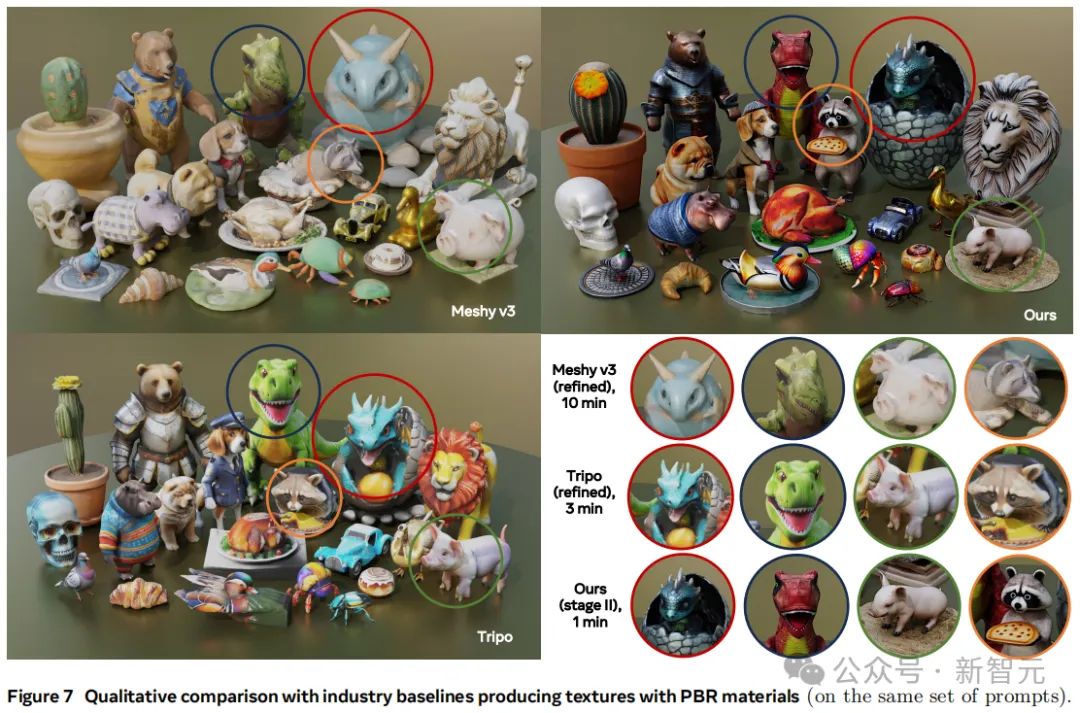

圖6、7、8則對比了3D Gen和其他模型對同一文本提示的生成結(jié)果。

對于一些比較有挑戰(zhàn)性的提示,3D Gen的細(xì)節(jié)效果有時(shí)遜色于Meshy v3等模型,但這涉及到一個(gè)權(quán)衡問題:要展現(xiàn)紋理中的高頻細(xì)節(jié),代價(jià)就是有時(shí)會(huì)出現(xiàn)視覺失真。

圖片

圖片

下面這個(gè)多物體的復(fù)雜場景任務(wù)中,你覺得哪個(gè)模型的表現(xiàn)更好?

圖片

圖片

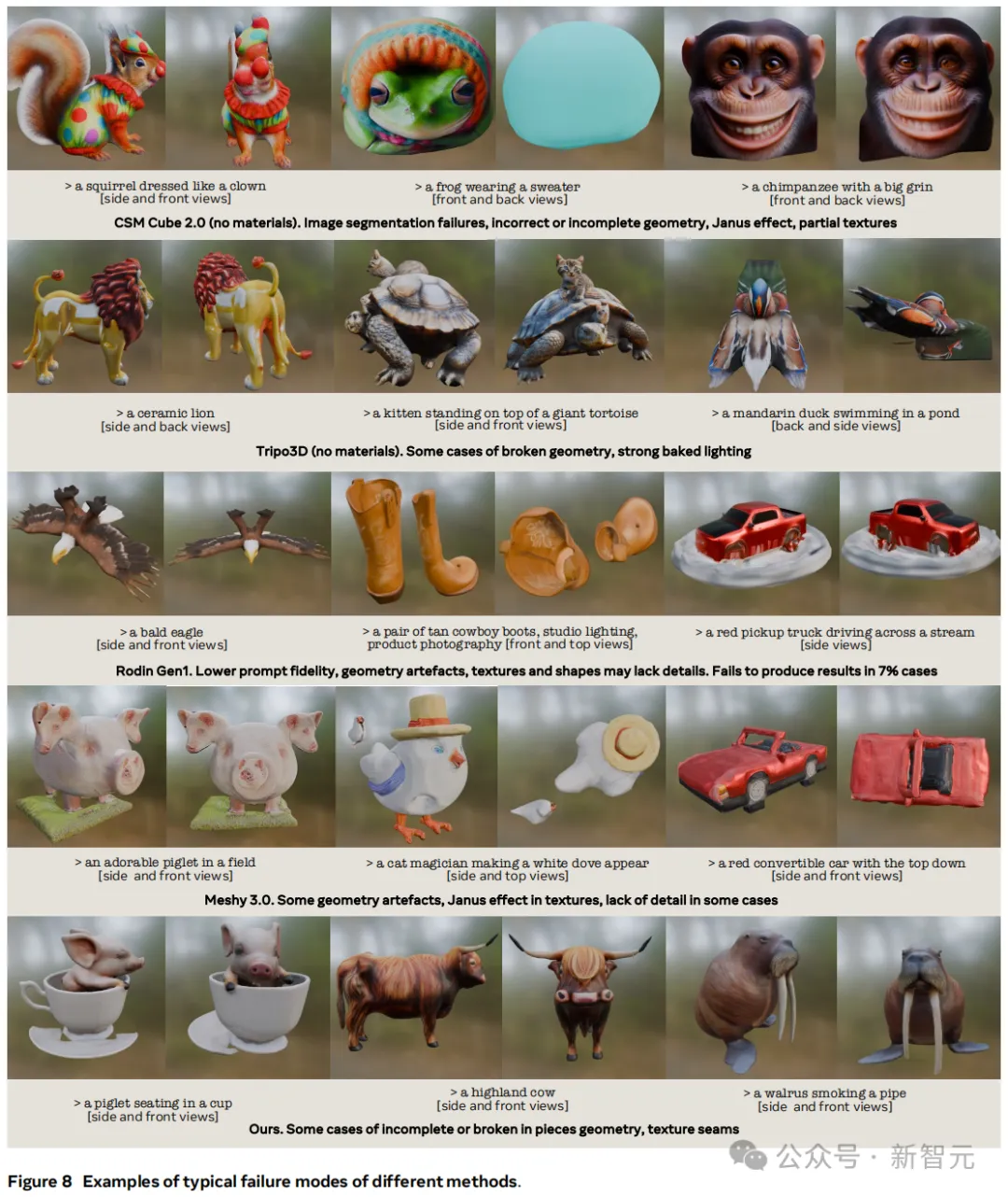

雖然成功的案例很多,但對目前的模型來說,翻車依舊時(shí)常發(fā)生,而且每個(gè)模型都有自己獨(dú)特的翻法。

比如CSM Cube經(jīng)常在物體幾何上出問題,前后視角不一致,或者干脆生成了「雙頭大猩猩」;Tripo 3D的光照效果會(huì)出現(xiàn)「一眼假」;Rodin Gen 1和Meshy 3.0有時(shí)缺少物體細(xì)節(jié)的渲染。

至于Meta的3D Gen,在放出來的案例中就出現(xiàn)了物體幾何結(jié)構(gòu)不完整、紋理接縫、指令不跟隨(最右側(cè)的海象沒有叼煙斗)等多方面的問題。

圖片

圖片

雖然沒人能在Meta的報(bào)告中戰(zhàn)勝M(fèi)eta,但被拿來當(dāng)「靶子」的作者,還是站出來為自己工作辯護(hù)了一番。

圖片

圖片

圖片

圖片

用戶調(diào)研

對于模型的文本到3D生成,人類評(píng)審將從兩方面進(jìn)行評(píng)估:提示忠實(shí)度、視覺質(zhì)量。

按不同的背景,評(píng)審被分成了兩組:(1)普通用戶,沒有3D方面的專業(yè)知識(shí),(2)專業(yè)的3D藝術(shù)家、設(shè)計(jì)師和游戲開發(fā)者。

評(píng)估采用了DreamFusion引入的404個(gè)經(jīng)過去重的文本提示,并根據(jù)內(nèi)容復(fù)雜性分為三類:物體(156個(gè)),角色(106個(gè))和物體角色組合(141個(gè))。

每個(gè)3D生成結(jié)果都會(huì)以360度全景視頻的方式呈現(xiàn)給評(píng)審者,不同模型進(jìn)行分別測試或者隨機(jī)的A/B測試。

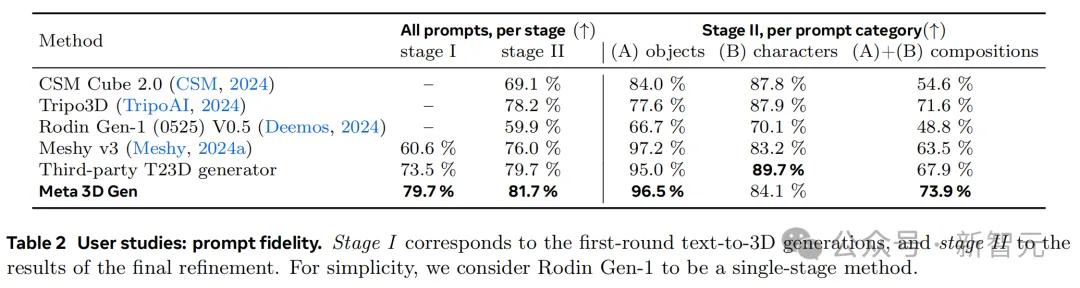

表2展示了提示忠實(shí)度方面的的評(píng)估結(jié)果。在這一指標(biāo)上,3DGen在兩個(gè)階段的得分都優(yōu)于其他行業(yè)方法,緊隨其后的是T23D生成器。

圖片

圖片

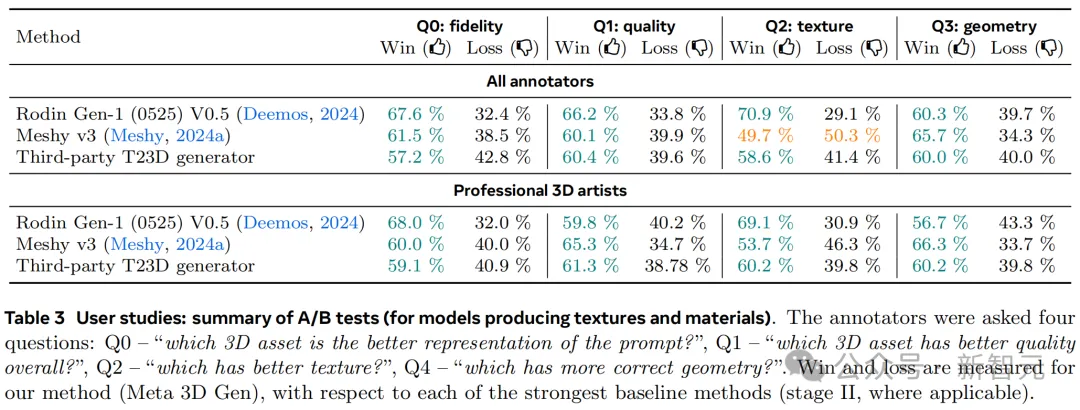

如表3所示,A/B測試中還添加了對幾何視覺質(zhì)量以及紋理細(xì)節(jié)的評(píng)測。

作者發(fā)現(xiàn),普通用戶更傾向于喜歡那些紋理更銳利、生動(dòng)、逼真且細(xì)節(jié)詳實(shí)的3D結(jié)果,但對較明顯的紋理和幾何偽影不是很關(guān)注。專業(yè)的3D藝術(shù)家則會(huì)更重視幾何與紋理的準(zhǔn)確性。

圖片

圖片

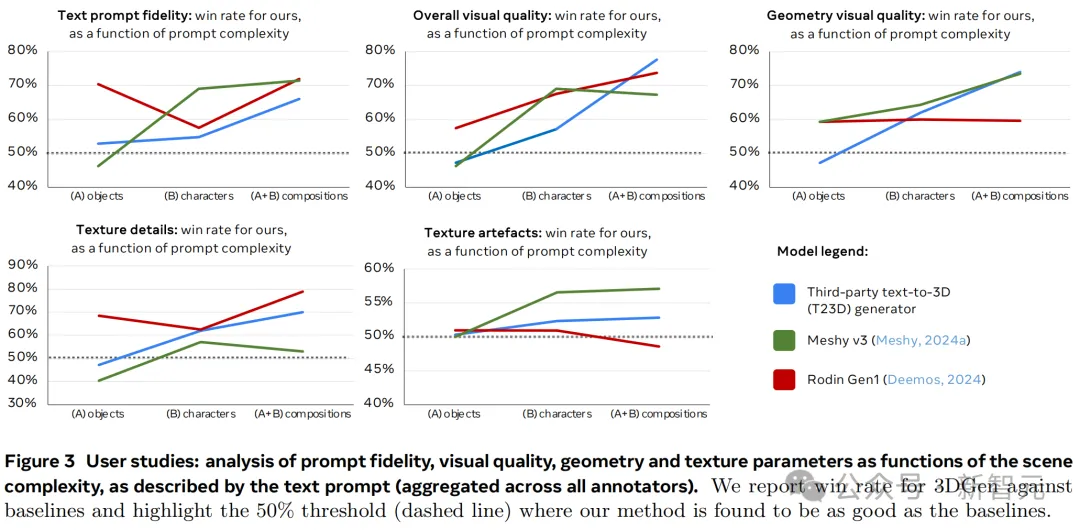

在圖3中,作者分析了視覺質(zhì)量、幾何、紋理細(xì)節(jié)和紋理偽影的表現(xiàn)率等指標(biāo),如何隨著文本提示描述的場景復(fù)雜度發(fā)生變化。

圖表顯示,雖然基準(zhǔn)模型在簡單提示下的表現(xiàn)與3D Gen相當(dāng),甚至更優(yōu),但隨著提示復(fù)雜度逐漸增加,3D Gen開始反超,這也與圖7描述的定型結(jié)果一致。

圖片

圖片

結(jié)論

作為一個(gè)統(tǒng)一的流程,3DGen整合了Meta的基礎(chǔ)生成模型,用于文本到3D生成,具備紋理編輯和材料生成能力。

通過結(jié)合AssetGen和TextureGen的優(yōu)勢,3DGen能夠在不到一分鐘的時(shí)間內(nèi)根據(jù)文本提示生成高質(zhì)量的3D對象。

在專業(yè)3D藝術(shù)家的評(píng)估中,3DGen的輸出在大多數(shù)情況下更受青睞,尤其是在復(fù)雜提示下,而且速度快3到60倍。

雖然Meta目前對AssetGen和TextureGen的整合比較直接,但它開創(chuàng)了一個(gè)非常有前景的研究方向,基于兩個(gè)方面:(1)在視圖空間和UV空間中的生成,(2)紋理和形狀生成的端到端迭代。

如同Sora的出現(xiàn)會(huì)深刻影響短視頻、電影、流媒體等眾多行業(yè)一樣,3D Gen也具有同樣巨大的潛力。

畢竟,小扎還是心心念念他的元宇宙。而AI驅(qū)動(dòng)的3D生成,對于在元宇宙中構(gòu)建無限大的虛擬世界也非常重要。