3D 版 SORA 來了!DreamTech 推出全球首個原生 3D-DiT 大模型 Direct3D

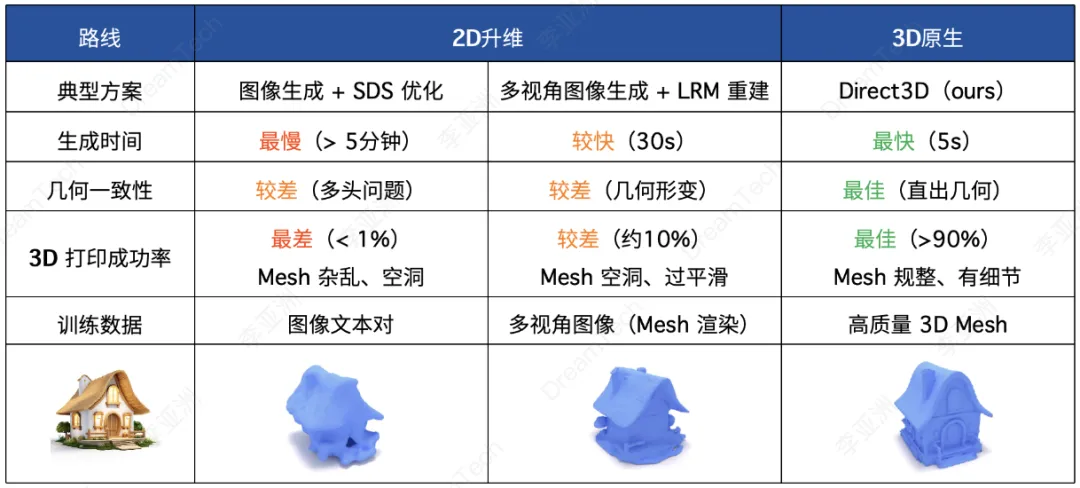

2024 年 5 月,DreamTech 官宣了其高質(zhì)量 3D 生成大模型 Direct3D,并公開了相關(guān)學(xué)術(shù)論文 Direct3D: Scalable Image-to-3D Generation via 3D Latent Diffusion Transformer。

鏈接:https://arxiv.org/abs/2405.14832

這是首個公開發(fā)布的原生三維生成路線的 3D 大模型,通過采用 3D Diffusion Transformer (3D-DiT),解決了長期以來困擾行業(yè)的高質(zhì)量三維內(nèi)容生成難題。

堅持原生 3D 技術(shù)路線并取得突破

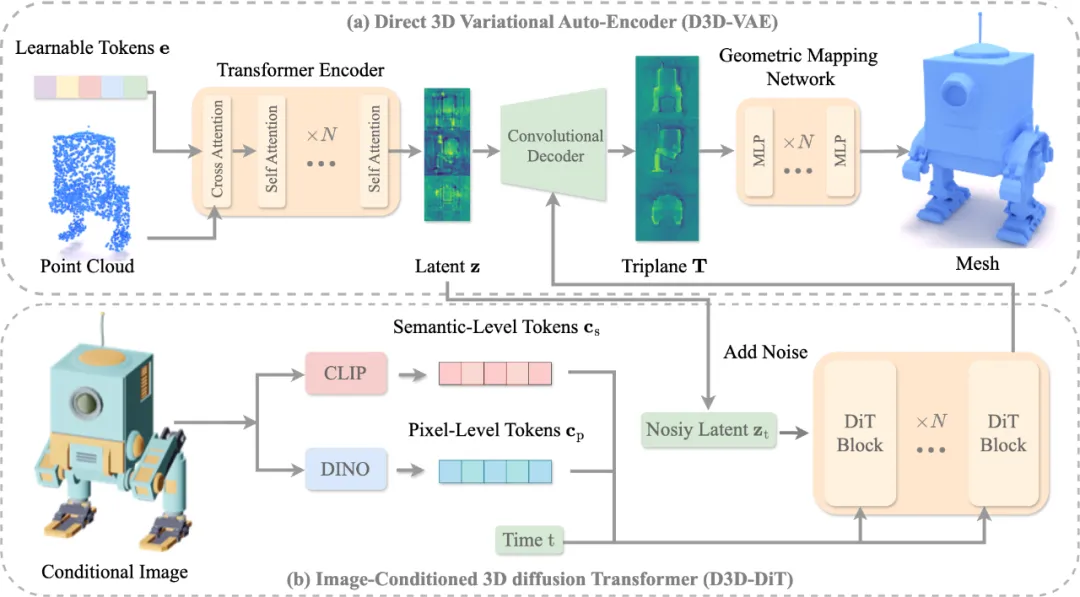

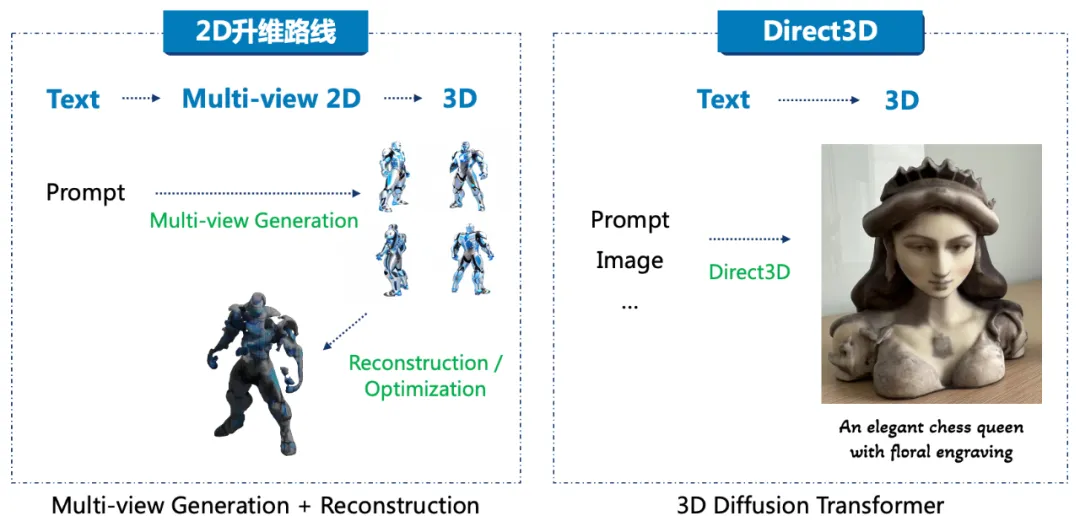

此前,3D AIGC 通常采用的技術(shù)路線是 2D-to-3D lifting,即通過 2D 圖像模型升維得到 3D 模型,代表性方案包括早期以 Google 公司提出的 DreamFusion 為代表的 Score Distillation Sampling (SDS) ,以及以 Adobe 公司提出的 Instant3D 為代表的 Large Reconstruction Model (LRM)。雖然 3D 數(shù)據(jù)被逐步引入模型訓(xùn)練過程以提升質(zhì)量,但 2D 升維技術(shù)存在多頭多面、空腔、遮擋等固有問題,現(xiàn)有解決方案難以滿足商業(yè)應(yīng)用對通用三維生成的要求。

去年初,業(yè)內(nèi)部分人員開始嘗試原生 3D 路線,即不經(jīng)過中間的多視角 2D 圖片或者多視角迭代優(yōu)化直接獲得 3D 模型,這條技術(shù)路線可以避開 2D 升維的缺陷,展現(xiàn)了獲取高質(zhì)量、無畸形、無殘缺、可商用 3D 內(nèi)容的潛力。原生 3D 路線在原理上相較 2D 升維方法具有顯著的優(yōu)勢,然而,其模型訓(xùn)練及算法開發(fā)一直存在諸多挑戰(zhàn),其中最關(guān)鍵的問題有:

- 高效的 3D 模型表征:圖像和視頻可以直接通過 2D/2.5D 的矩陣表征壓縮獲得 latent feature,相比之下, 3D 數(shù)據(jù)拓?fù)鋸?fù)雜、表征維度更高。如何對三維數(shù)據(jù)進(jìn)行高效壓縮,進(jìn)而對 3D latent space 進(jìn)行三維數(shù)據(jù)分布的分析與學(xué)習(xí),是一直困擾行業(yè)人員的難題。

- 高效的 3D 訓(xùn)練架構(gòu): DiT 架構(gòu)最先應(yīng)用在圖像生成領(lǐng)域并取得了巨大成功,包括 Stable Diffusion 3 (SD3)、Hunyuan-DiT 都采用了 DiT 架構(gòu);在視頻生成領(lǐng)域,OpenAI SORA 采用 DiT 架構(gòu)成功實(shí)現(xiàn)遠(yuǎn)超 Runway 和 Pika 的視頻生成效果;而在 3D 生成領(lǐng)域,受限于復(fù)雜拓?fù)渑c三維表征方法,原始的 DiT 架構(gòu)無法直接應(yīng)用于 3D mesh 生成。

- 高質(zhì)量大規(guī)模 3D 訓(xùn)練數(shù)據(jù): 3D 訓(xùn)練數(shù)據(jù)的質(zhì)量和規(guī)模直接決定了生成模型的質(zhì)量及泛化能力,行業(yè)內(nèi)普遍認(rèn)為至少需要千萬規(guī)模的高質(zhì)量 3D 訓(xùn)練數(shù)據(jù)才可以達(dá)到 3D 大模型的訓(xùn)練要求。然而 3D 數(shù)據(jù)在全世界范圍內(nèi)都極其缺乏,盡管有諸如 ObjaverseXL 這樣千萬規(guī)模級別的 3D 訓(xùn)練數(shù)據(jù)集,但其中絕大多數(shù)都是低質(zhì)量的簡單結(jié)構(gòu),可用的高質(zhì)量 3D 數(shù)據(jù)占比不足 5%。如何獲得足夠數(shù)量的高質(zhì)量的 3D 數(shù)據(jù)是一個世界性的難題。

針對以上核心難題,DreamTech 提出了全球首個原生 3D-DiT 大模型 Direct3D。通過廣泛的實(shí)驗(yàn)驗(yàn)證,Direct3D 的三維模型生成質(zhì)量顯著超越了目前主流的 2D 升維方法,這主要得益于以下三點(diǎn):

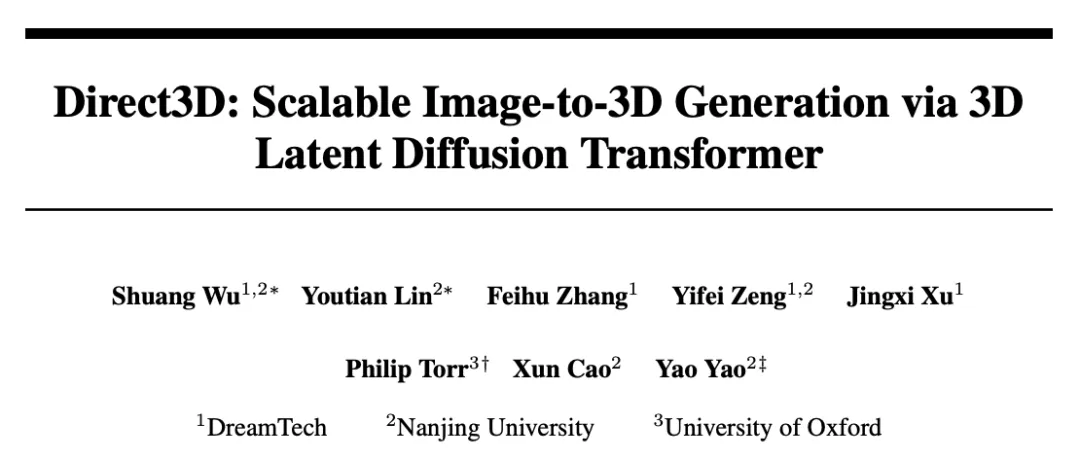

- D3D-VAE: Direct3D 提出了類似 OpenAI SORA 的 3D VAE (Variational Auto-Encoder) 來提取 3D 數(shù)據(jù)的 latent feature,將 3D 數(shù)據(jù)的表征復(fù)雜度從原本的 N^3 降低到了 n^2 (n<<N) 的緊湊 3D latent space,并通過 decoder 網(wǎng)絡(luò)實(shí)現(xiàn)了對原始 3D mesh 近乎無損的恢復(fù)。通過使用 3D latent feature,Direct3D 將原本訓(xùn)練 3D-DiT 的運(yùn)算和內(nèi)存需求量降低了超過兩個數(shù)量級,使得大規(guī)模 3D-DiT 模型訓(xùn)練成為了可能。

- D3D-DiT: Direct3D 采用了 DiT 架構(gòu)并對原始 DiT 進(jìn)行了改進(jìn)優(yōu)化,引入了針對輸入圖像的語義級與像素級對齊模塊,可實(shí)現(xiàn)輸出模型與任意輸入圖像的高度對齊。

- DreamTech 3D 數(shù)據(jù)引擎: Direct3D 在訓(xùn)練中使用了大量高質(zhì)量 3D 數(shù)據(jù),這些數(shù)據(jù)絕大部分由 DreamTech 自研的數(shù)據(jù)合成引擎制作而成。DreamTech 合成引擎建立了數(shù)據(jù)清洗、標(biāo)注等全自動數(shù)據(jù)處理流程,已積累生產(chǎn)了超過 2000 萬的高質(zhì)量 3D 數(shù)據(jù),補(bǔ)全了原生 3D 算法落地的最后一塊拼圖。值得一提的是,OpenAI 在 2023 年 Shap-E 和 Point-E 的訓(xùn)練過程中嘗試使用了百萬規(guī)模的 3D 合成數(shù)據(jù),而對比 OpenAI 的數(shù)據(jù)合成方案,DreamTech 合成的 3D 數(shù)據(jù)規(guī)模更大,且質(zhì)量更高。

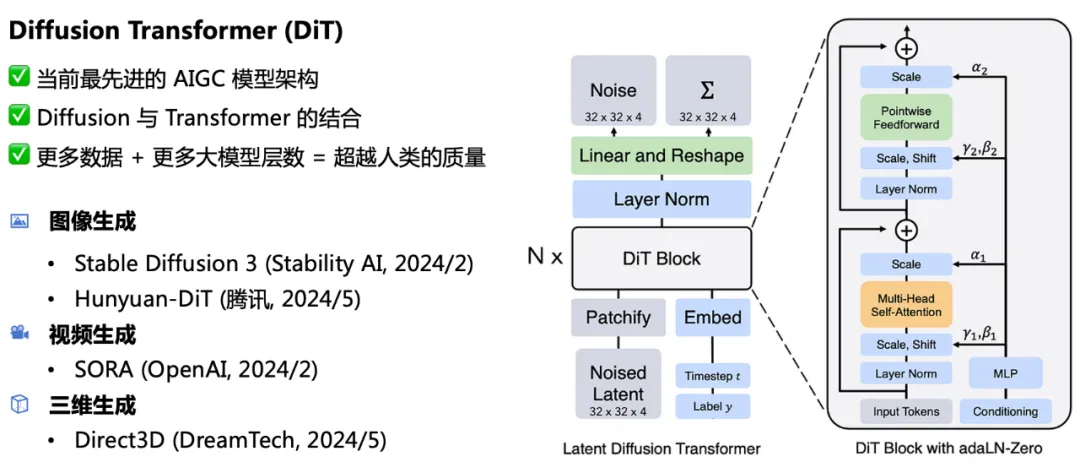

采用 DiT 架構(gòu)

3D 領(lǐng)域再次驗(yàn)證 Scaling Law

技術(shù)架構(gòu)上,Direct3D 采用與 OpenAI SORA 相似的 Diffusion Transformer (DiT)。DiT 架構(gòu)是當(dāng)前最先進(jìn)的 AIGC 大模型架構(gòu),結(jié)合了 Diffusion 與 Transformer 兩大架構(gòu)的優(yōu)勢,滿足可擴(kuò)展(Scalable)的要求,即提供給模型更多的數(shù)據(jù)量及更多的大模型參數(shù)量,DiT 可達(dá)到甚至超越人類的生成質(zhì)量。目前 DiT 技術(shù)的實(shí)踐項(xiàng)目包括圖像生成方向上的 Stable Diffusion 3 (Stablility AI,2024 年 2 月)、Hunyuan-DiT (騰訊,2024 年 5 月),視頻生成方向上的 SORA (OpenAI, 2024 年 2 月),DreamTech 的 Direct3D 則是全球首個公開的 3D 內(nèi)容生成方向上的 DiT 實(shí)踐。

DiT 架構(gòu)符合并多次驗(yàn)證了 Scaling Law。

在大語言模型上,Scaling Law 已經(jīng)充分證明了有效性,隨著參數(shù)量和訓(xùn)練數(shù)據(jù)的增加,大模型的智能程度將極大提高;在圖像生成領(lǐng)域上,從 SD1 的參數(shù)量 0.8B 到 SD3 的 8B, Dall-E 3 參數(shù)量 12B,都展示了 Scaling Law 的有效性;在視頻生成領(lǐng)域,SORA 相比 Runway、Pika 等,據(jù)推測其技術(shù)實(shí)現(xiàn)上主要是將模型架構(gòu)換成了 DiT,以及在模型參數(shù)量與訓(xùn)練數(shù)據(jù)上都提升了一個數(shù)量級,展示了震驚世界的生成效果,無論是視頻分辨率、視頻時長還是視頻生成質(zhì)量都得到了極大提升。

3D 領(lǐng)域也是如此,Direct3D-1B 向行業(yè)展示了首個可行的原生 3D-DiT 架構(gòu),利用自研的高質(zhì)量數(shù)據(jù)合成引擎,增加訓(xùn)練數(shù)據(jù)量及增大模型參數(shù)量,生成結(jié)果穩(wěn)步提升,未來 3D 生成領(lǐng)域?qū)⒂?Direct3D (或其衍生架構(gòu)) 完全取代現(xiàn)有的 LRM 或 SDS 方案。目前,DreamTech 團(tuán)隊(duì)正在穩(wěn)步推進(jìn) Direct3D 的 scale up,計劃年底前推出 15B 參數(shù)的 Direct3D-XL,同時將訓(xùn)練模型的高質(zhì)量 3D 數(shù)據(jù)增加 5 倍以上,3D 生成屆時將迎來里程碑時刻。

3D 內(nèi)容生成質(zhì)量達(dá)到商用級別

隨著 Direct3D 的推出,3D 生成領(lǐng)域大步跨越進(jìn)入了商用時代。以 3D 打印為例,使用 SDS、LRM 等技術(shù)方案生成的模型都會存在如下問題:

- 模型幾何結(jié)構(gòu)扭曲,容易出現(xiàn)多頭多尾;

- 模型存在很多尖銳的毛刺;

- 表面過度平滑,缺少細(xì)節(jié);

- mesh 面片數(shù)少,精細(xì)結(jié)構(gòu)無法保證。

這些問題的存在導(dǎo)致此前各類方案生成的模型無法在 3D 打印機(jī)中正常打印,還需要人工進(jìn)行調(diào)整修補(bǔ)。Direct3D 因?yàn)椴扇〉氖窃?3D 技術(shù)路線,訓(xùn)練集中僅使用 3D 數(shù)據(jù),其所生成的 3D 模型質(zhì)量也更接近原始質(zhì)量,完美解決了幾何結(jié)構(gòu)、模型精度、表面細(xì)節(jié)、mesh 面片數(shù)量等核心問題。Direct3D 所生成的模型質(zhì)量已經(jīng)超出了家用打印機(jī)的精度上限,只有更高規(guī)格的商用及工業(yè)打印機(jī)才能充分還原所生成模型的精細(xì)度。

此前, SDS、LRM 等技術(shù)方案受限于 3D 模型特征表達(dá)形式,一般生成的模型 mesh 面片數(shù)都在 5-20 萬左右,且很難再提高,然而在商業(yè)使用中,3D 模型的 mesh 面片數(shù)量往往需要達(dá)到 100-500 萬以上。Direct3D 提出了更精細(xì)的 3D 特征表達(dá)范式,使得所生成的模型 mesh 面片數(shù)沒有上限,可以達(dá)到并超過 1000 萬,滿足各類商業(yè)場景需要。

隨著 Direct3D 模型參數(shù)量及訓(xùn)練數(shù)據(jù)量的增加,3D 生成可以應(yīng)用到的行業(yè)會越來越多,包括萬億級別的游戲、動漫行業(yè),預(yù)計在 2025 年底之前,3D 生成將實(shí)現(xiàn)大部分游戲、動畫、影視建模的替代工作,在各行業(yè)大規(guī)模投入使用。

Direct3D 實(shí)踐

基于 Direct3D 大模型,DreamTech 推出了兩款嘗鮮產(chǎn)品,目前已經(jīng)開放申請測試(點(diǎn)擊閱讀原文,跳轉(zhuǎn):www.neural4d.com)。

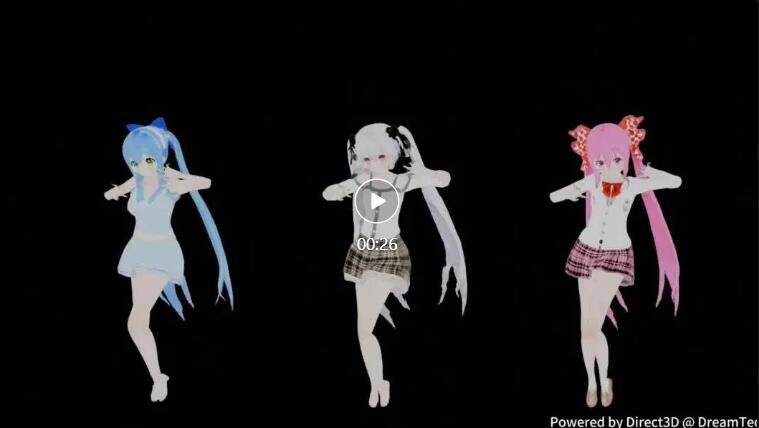

其一是面向 C 端用戶的 Animeit!,Animeit! 可將用戶輸入的任意圖片 / 文字對象轉(zhuǎn)換為二次元風(fēng)格的高質(zhì)量 3D 人物形象,并且 3D 人物具備骨骼節(jié)點(diǎn)以用于動作綁定,在 Animeit! 上用戶可以與個性化的 3D AI 伙伴直接對話并進(jìn)行動作交互。

Animeit! 所生成的二次元角色精細(xì)度極高,臉部輪廓細(xì)節(jié)清晰可辨,手部細(xì)節(jié)凸顯、手指粒粒分明,這是此前的 3D 生成技術(shù)路線無法達(dá)到的質(zhì)量水平,已可用于二次元社區(qū) MMD 制作。

另一款產(chǎn)品則為面向創(chuàng)作者的 3D 內(nèi)容創(chuàng)作平臺,用戶可以像使用 Midjourney 這類平臺一樣,通過文本描述在 1 分鐘之內(nèi)獲得高質(zhì)量 3D 模型,不需要等待長時間的 refinement;用戶也可以僅上傳單張圖片,稍作等待即可獲得高質(zhì)量且還原精準(zhǔn)的 3D 模型。