什么是文本分類?

譯文?譯者 | 李睿

審校 | 孫淑娟

什么是文本分類?

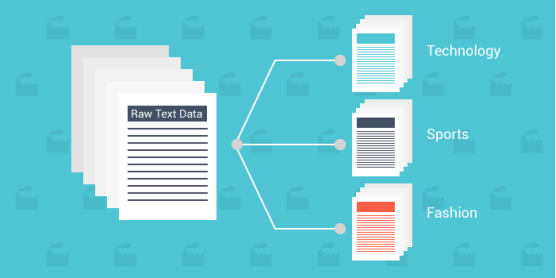

文本分類是將文本分類為一個或多個不同類別以組織、構(gòu)造和過濾成任何參數(shù)的過程。例如,文本分類用于法律文件、醫(yī)學研究和文件中,或者簡單地用于產(chǎn)品評論。數(shù)據(jù)比以往任何時候都更重要;很多企業(yè)花費巨資試圖獲取盡可能多的洞察力。

隨著文本/文檔數(shù)據(jù)比其他數(shù)據(jù)類型豐富得多,使用新方法勢在必行。由于數(shù)據(jù)本質(zhì)上是非結(jié)構(gòu)化的,并且極其豐富,因此以易于理解的方式組織數(shù)據(jù)以理解它可以顯著地提高其價值。使用文本分類和機器學習可以更快、更經(jīng)濟高效地自動構(gòu)造相關(guān)文本。

以下將定義文本分類、其工作原理、一些最知名的算法,并提供可能有助于開始文本分類之旅的數(shù)據(jù)集。

為什么使用機器學習文本分類?

- 規(guī)模:人工數(shù)據(jù)輸入、分析和組織既乏味又緩慢。機器學習允許進行自動分析,無論數(shù)據(jù)集的規(guī)模有多大。

- 一致性:人為錯誤是由于人員疲勞和對數(shù)據(jù)集中的材料不敏感而發(fā)生的。由于算法的無偏性和一致性,機器學習提高了可擴展性并顯著提高了準確性。

- 速度:有時可能需要快速訪問和組織數(shù)據(jù)。機器學習算法可以解析數(shù)據(jù),以易于理解的方式傳遞信息。

6個通用步驟

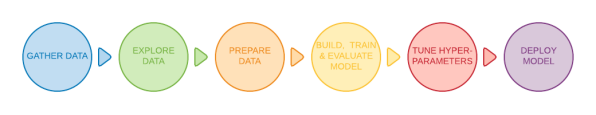

一些基本方法可以在一定程度上對不同的文本文檔進行分類,但最常用的方法采用機器學習。文本分類模型在部署之前需要經(jīng)歷六個基本步驟。

1.提供高質(zhì)量的數(shù)據(jù)集

數(shù)據(jù)集是原始數(shù)據(jù)塊,用作模型的數(shù)據(jù)源。在文本分類的情況下,使用監(jiān)督機器學習算法,為機器學習模型提供標記數(shù)據(jù)。標記數(shù)據(jù)是為算法預(yù)定義的數(shù)據(jù),并附有信息標簽。

2.過濾和處理數(shù)據(jù)

由于機器學習模型只能理解數(shù)值,因此需要對提供的文本進行標記化和文字嵌入,以使模型能夠正確識別數(shù)據(jù)。

標記化是將文本文檔拆分成更小的部分(稱為標記)的過程。標記可以表示為整個單詞、子單詞或單個字符。例如,可以這樣更智能地標記工作:

- 標記詞:Smarter

- 標記子詞:Smart-er

- 標記字符:S-m-a-r-t-e-r

為什么標記化很重要?因為文本分類模型只能在基于標記的級別上處理數(shù)據(jù),不能理解和處理完整的句子。模型需要對給定的原始數(shù)據(jù)集進行進一步處理才能輕松消化給定的數(shù)據(jù)。刪除不必要的功能,過濾掉空值和無限值等等。重組整個數(shù)據(jù)集將有助于防止在訓練階段出現(xiàn)任何偏差。

3.將數(shù)據(jù)集拆分為訓練和測試數(shù)據(jù)集

希望在保留20%的數(shù)據(jù)集的同時,在80%的數(shù)據(jù)集上訓練數(shù)據(jù),以測試算法的準確性。

4.訓練算法

通過使用訓練數(shù)據(jù)集運行模型,該算法可以通過識別隱藏的模式和見解將提供的文本分類為不同類別。

5.測試和檢查模型的性能

接下來,使用步驟3中提到的測試數(shù)據(jù)集測試模型的完整性。測試數(shù)據(jù)集將被取消標記,以根據(jù)實際結(jié)果測試模型的準確性。為了準確測試模型,測試數(shù)據(jù)集必須包含新的測試用例(與以前的訓練數(shù)據(jù)集不同的數(shù)據(jù)),以避免過度擬合模型。

6.調(diào)整模型

通過調(diào)整模型的不同超參數(shù)來調(diào)整機器學習模型,而不會過度擬合或產(chǎn)生高方差。超參數(shù)是一個參數(shù),其值控制模型的學習過程。現(xiàn)在可以部署了。

文本分類是如何工作的?

單詞嵌入

在以上提到的過濾過程中,機器和深度學習算法只能理解數(shù)值,迫使開發(fā)人員對數(shù)據(jù)集執(zhí)行一些單詞嵌入技術(shù)。單詞嵌入是將單詞表示為實值向量的過程,實值向量可以對給定單詞的含義進行編碼。

- Word2Vec:這是谷歌公司開發(fā)的一種無監(jiān)督單詞嵌入方法。它利用神經(jīng)網(wǎng)絡(luò)從大型文本數(shù)據(jù)集中學習。顧名思義,Word2Vec方法將每個單詞轉(zhuǎn)換為給定的向量。

- GloVe:也稱為全局向量,是一種無監(jiān)督機器學習模型,用于獲取單詞的向量表示。與Word2Vec方法類似,GloVe算法將單詞映射到有意義的空間中,其中單詞之間的距離與語義相似度有關(guān)。

- TF-IDF:TF-IDF是詞頻-逆文本頻率的縮寫,它是一種單詞嵌入算法,用于評估單詞在給定文檔中的重要性。TF-IDF為每個單詞分配一個給定的分數(shù),以表示其在一組文檔中的重要性。

文本分類算法

以下是三種最著名和最有效的文本分類算法。需要記住,每種方法中都嵌入了進一步的定義算法。

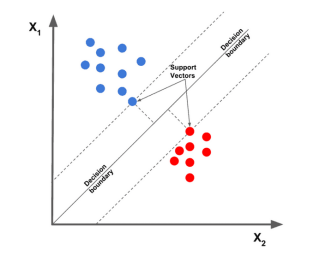

1.線性支持向量機

線性支持向量機算法被認為是目前最好的文本分類算法之一,它根據(jù)給定的特征繪制給定的數(shù)據(jù)點,然后繪制一條最佳擬合線,將數(shù)據(jù)拆分并分類為不同的類別。

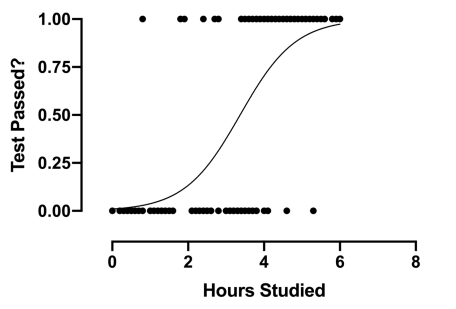

2.邏輯回歸

邏輯回歸是回歸的一個子類,主要關(guān)注分類問題。它使用決策邊界、回歸和距離來評估和分類數(shù)據(jù)集。

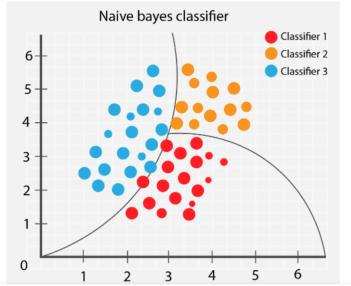

3.樸素貝葉斯

樸素貝葉斯算法根據(jù)對象提供的特征對不同的對象進行分類。然后繪制組邊界以推斷這些組分類以進一步解決和分類。

設(shè)置文本分類時,應(yīng)避免什么問題

1.過度擁擠的訓練數(shù)據(jù)

為算法提供低質(zhì)量數(shù)據(jù)將導(dǎo)致糟糕的未來預(yù)測。對于機器學習從業(yè)者來說,一個常見的問題是,向訓練模型提供的數(shù)據(jù)集過多,并且包括不必要的特征。過多地使用不相關(guān)的數(shù)據(jù)會導(dǎo)致模型性能的下降。而在選擇和組織數(shù)據(jù)集時,越少越好。

錯誤的訓練與測試數(shù)據(jù)的比率會極大地影響模型的性能,并影響數(shù)據(jù)的洗牌和過濾。精確的數(shù)據(jù)點不會被其他不需要的因素所干擾,訓練模型將更有效地執(zhí)行。

在訓練模型時,選擇符合模型要求的數(shù)據(jù)集,過濾不必要的值,洗牌數(shù)據(jù)集,并測試最終模型的準確性。更簡單的算法需要更少的計算時間和資源,而最好的模型是可以解決復(fù)雜問題的最簡單的模型。

2.過擬合和欠擬合

在訓練達到峰值時,模型的準確性隨著訓練的繼續(xù)逐漸降低。這稱為過擬合;由于訓練持續(xù)時間過長,模型開始學習意想不到的模式。在訓練集上實現(xiàn)高精度時要小心,因為主要目標是開發(fā)其準確性植根于測試集的模型(模型以前沒有見過的數(shù)據(jù))。

另一方面,欠擬合是指訓練模型仍有改進的空間,尚未達到其最大潛力。訓練不佳的模型源于訓練的時間長度或?qū)?shù)據(jù)集過度正則化。這體現(xiàn)了擁有簡潔和精確數(shù)據(jù)的意義。

在訓練模型時找到最佳位置至關(guān)重要。將數(shù)據(jù)集拆分為80/20是一個很好的開始,但調(diào)整參數(shù)可能是特定模型需要以最佳方式執(zhí)行的操作。

3.文本格式不正確

盡管在本文中沒有詳細提及,但針對文本分類問題使用正確的文本格式將獲得更好的結(jié)果。一些表示文本數(shù)據(jù)的方?法包括GloVe、Word2Vec和嵌入模型。

使用正確的文本格式將改善模型讀取和解釋數(shù)據(jù)集的方式,進而幫助它理解模式。

文本分類應(yīng)用程序

- 過濾垃圾郵件:通過搜索某些關(guān)鍵字,可以將電子郵件分類為有用郵件或垃圾郵件。

- 文本分類:通過使用文本分類,應(yīng)用程序可以通過對相關(guān)文本(如項目名稱和描述等)進行分類,將不同的項目(文章和書籍等)分類為不同的類別。使用這些技術(shù)可以改善體驗,因為它使用戶更容易在數(shù)據(jù)庫中導(dǎo)航。

- 識別仇恨言論:某些社交媒體公司使用文本分類來檢測和禁止帶有冒犯行為的評論或帖子。

- 營銷和廣告:企業(yè)可以通過了解用戶對某些產(chǎn)品的反應(yīng)來做出特定的改變來滿足他們的客戶。它還可以根據(jù)用戶對類似產(chǎn)品的評論推薦某些產(chǎn)品。文本分類算法可以與推薦系統(tǒng)結(jié)合使用,這是許多在線網(wǎng)站用來獲得重復(fù)業(yè)務(wù)的另一種深度學習算法。

流行的文本分類數(shù)據(jù)集

擁有大量標記和即用型數(shù)據(jù)集,可以隨時搜索符合模型要求的完美數(shù)據(jù)集。

雖然在決定使用哪一個時可能會遇到一些問題,但以下將推薦一些可供公眾使用的最知名的數(shù)據(jù)集。

- IMDB Dataset

- Amazon Reviews Dataset

- Yelp Reviews Dataset

- SMS Spam Collection

- Opin Rank Review Dataset

- Twitter US Airline Sentiment Dataset

- Hate Speech and Offensive Language Dataset

- Clickbait Dataset

Kaggle等網(wǎng)站包含涵蓋所有主題的各種數(shù)據(jù)集。可以嘗試在上述幾個數(shù)據(jù)集上運行模型進行練習。

機器學習中的文本分類

隨著機器學習在過去十年中產(chǎn)生了巨大的影響,企業(yè)正在嘗試一切可能的方法來利用機器學習實現(xiàn)流程自動化。評論、帖子、文章、期刊和文檔在文本中都具有無價的價值。而通過以多種創(chuàng)造性方式使用文本分類來提取用戶見解和模式,企業(yè)可以做出有數(shù)據(jù)支持的決策;專業(yè)人士可以比以往更快地獲取和學習有價值的信息。

原文標題:??What Is Text Classification???,作者:Kevin Vu?