陳丹琦帶著清華特獎學弟發布新成果:打破谷歌BERT提出的訓練規律

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

新晉斯隆獎得主如何慶祝?

公開最新研究成果算不算?

就在斯隆獎宣布當天,陳丹琦團隊展示了最新的研究成果。

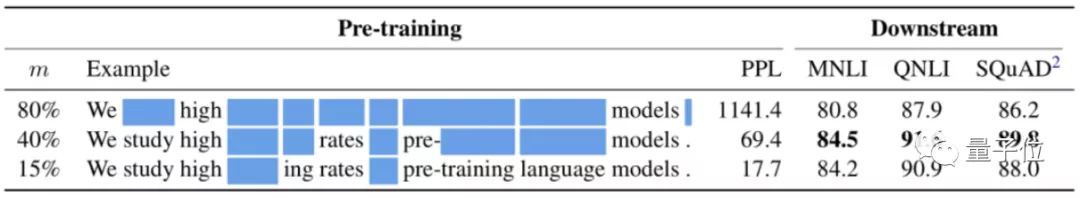

團隊發現,經典NLP模型BERT提出的預訓練“15%掩蔽率”法則,是可以被打破的!

“15%掩蔽率”,指在一項預訓練任務中,隨機遮住15%的單詞,并通過訓練讓AI學會預測遮住的單詞。

陳丹琦團隊認為,如果將掩蔽率提升到40%,性能甚至比15%的時候還要更好:

不僅如此,這篇文章還提出了一種新的方法,來更好地提升40%掩蔽率下NLP模型訓練的效果。

一位抱抱臉(Hugging Face)工程師對此表示:

關于BERT有個很有意思的事情,它雖然是一項開創性的研究,然而它的那些訓練方式都是錯誤或不必要的。

這篇論文的共同一作高天宇,也是清華特獎獲得者,本科期間曾發表過四篇頂會論文。

那么,論文究竟是怎么得出這一結論的呢?

“大模型更適合高掩蔽率”

陳丹琦團隊先是從掩蔽率、迭代次數和模型大小三個方向,驗證了這一結論。

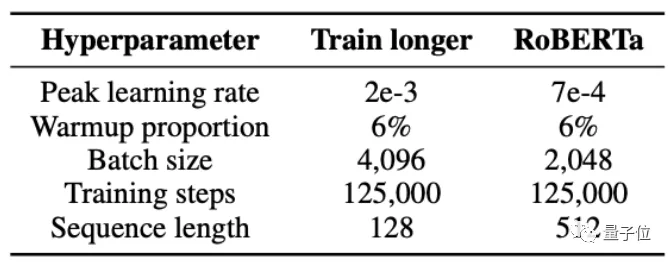

他們先是用了一系列不同的掩蔽率來訓練NLP模型,參數如下:

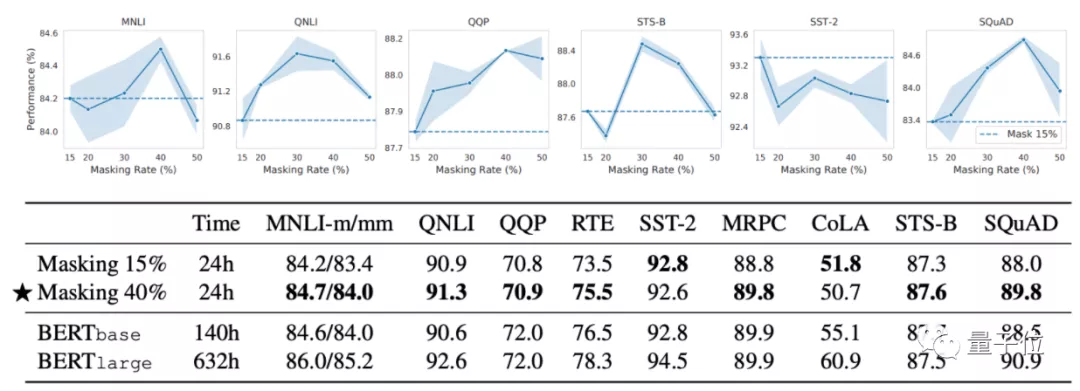

結果發現,除了小部分數據集以外,模型在包括MNLI、QNLI、QQP、STS-B、SQuAD等數據集上的訓練效果,40%掩蔽率都比15%都要更好。

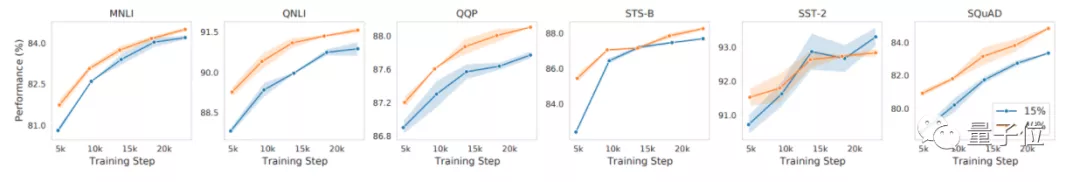

為了進一步迭代次數 (training step)受掩蔽率的影響效果,作者們同樣記錄了不同迭代率下模型的效果。

結果顯示,隨著迭代次數的增加,40%掩蔽率基本都表現出了比15%更好的性能:

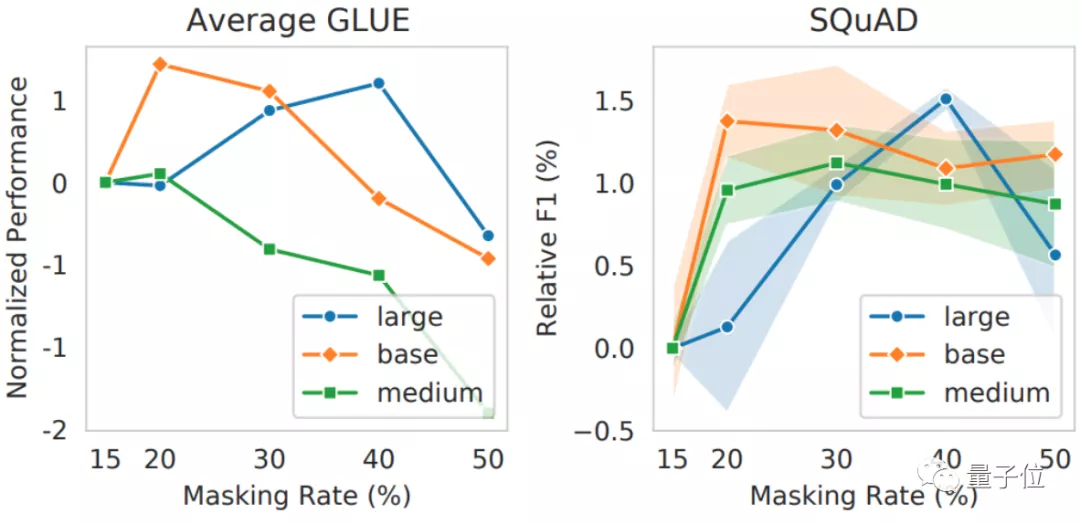

不僅如此,作者們還發現,更大的模型,更適合用40%掩蔽率去訓練。

結果顯示,大模型在40%掩蔽率的情況下,性能比中等NLP模型要更好:

這么看來,只將掩蔽率設置為15%,確實沒有40%的訓練效果更好,而且,更大的NLP模型還更適合用40%的掩蔽率來訓練。

團隊猜測,任務難一些能促使模型學到更多特征,而大模型正是有這種余裕。

為了探究其中的原理,作者們又提出了一個新的評估方法。

將掩蔽率拆分為2個指標

具體來說,就是將掩蔽率拆分為破壞率 (corruption rate)和預測率 (prediction rate)2個指標。

其中,破壞率是句子被破壞的比例,預測率是模型預測的比例。

例如,“我喜歡打籃球”語料可能被破壞成“我[MASK][MASK][MASK]”提供給模型,但模型卻只需要預測第一個[MASK]是不是“喜歡”。

這樣一來,就可以用破壞率來控制預訓練任務的難度,用預測率來控制模型的優化效果。

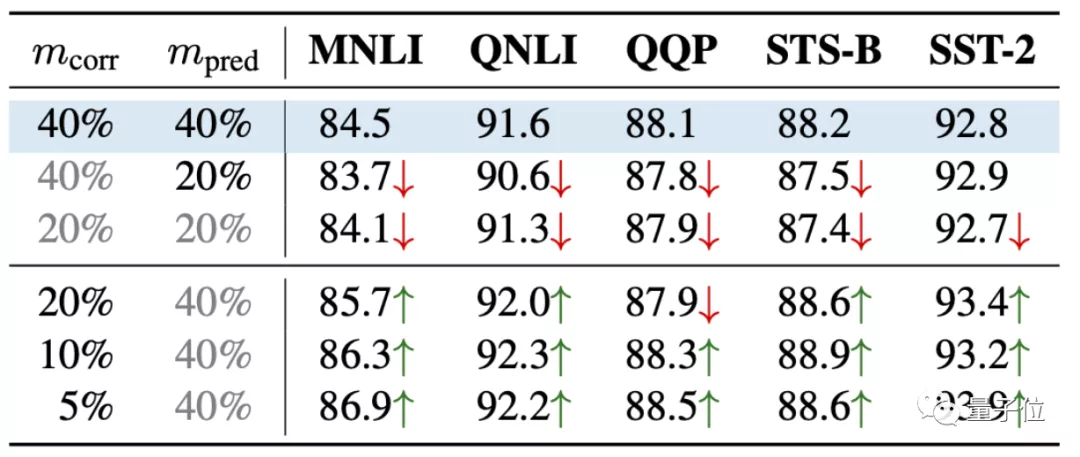

論文進一步針對破壞率(mcorr)和預測率(mpred)進行了研究,發現了一個新規律:

預測率高,模型效果更好;但破壞率更高,模型效果更差:

這樣就能用更精準的方式來評估各種預訓練任務了。

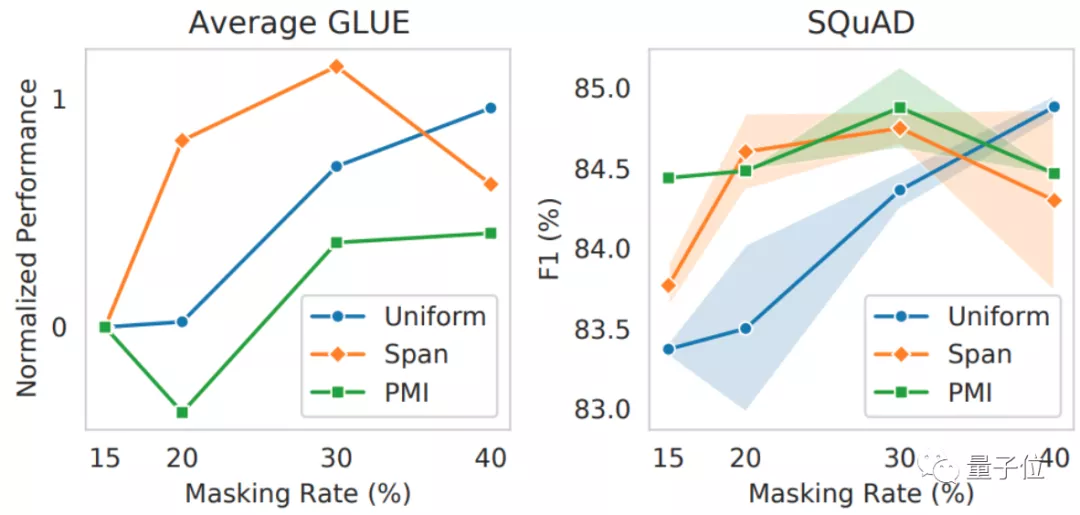

最后,作者們在這種指標下,測試了多種掩碼,觀察在更高掩蔽率的情況下,哪些掩碼的效果更好。

結果顯示,隨著掩蔽率的提升,隨機均勻掩碼的效果(Uniform)的表現還會比Span Masking、相關區間原則性掩碼(PMI-Masking)更好。

然而,在之前的很多NLP模型中,基本都直接采用了PMI-Masking或是Span Masking等更復雜的掩碼來訓練。

這也說明,NLP大模型的預訓練效果不能一概而論,光是訓練方法就值得進一步研究。

作者介紹

論文的幾名作者均來自陳丹琦團隊。

一作高天宇,目前是普林斯頓大學的二年級博士生,本科畢業于清華大學,曾經獲得清華本科特等獎學金。

本科時,高天宇就在劉知遠教授團隊中搞科研了,期間一共發表了4篇頂會論文(兩篇AAAI,兩篇EMNLP)。

共同一作Alexander Wettig,普林斯頓大學一年級博士生,本碩畢業于劍橋大學,對NLP的泛化能力方向感興趣。

鐘澤軒(Zexuan Zhong),普林斯頓大學博士生,碩士畢業于伊利諾伊大學香檳分校,導師是謝濤;本科畢業于北京大學計算機系,曾在微軟亞研院實習,導師是聶再清。

通過這一發現,不少NLP大模型說不定又能通過改進訓練方法,取得更好的效果了。

論文地址:

https://gaotianyu.xyz/content/files/2022/02/should_you_mask_15-1.pdf