你說我畫,你畫我說:全球超大中文跨模態生成模型文心ERNIE-ViLG

在文字生成圖像上,文心 ERNIE-ViLG 可以根據用戶輸入的文本,自動創作圖像,生成的圖像不僅符合文字描述,而且達到了非常逼真的效果。在圖像到文本的生成上,文心 ERNIE-ViLG 能夠理解畫面,用簡潔的語言描述畫面的內容,還能夠根據圖片中的場景回答相關的問題。

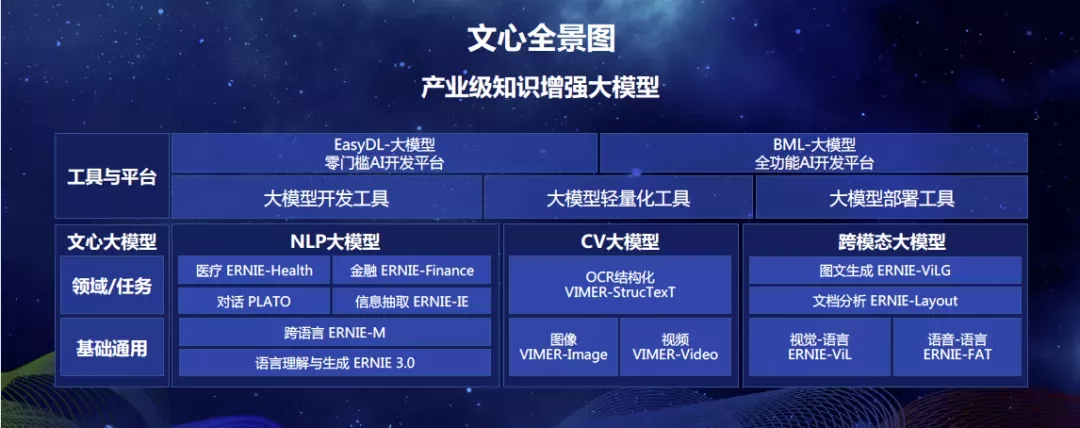

前不久,百度產業級知識增強大模型 “文心” 全景圖亮相,近日,其中的跨模態生成模型 ERNIE-ViLG 在百度文心官網開放體驗入口,并放出了論文:

體驗鏈接:https://wenxin.baidu.com/wenxin/ernie-vilg

論文鏈接:https://arxiv.org/pdf/2112.15283.pdf

據悉,文心 ERNIE-ViLG 參數規模達到 100 億,是目前為止全球最大規模中文跨模態生成模型,該模型首次通過自回歸算法將圖像生成和文本生成統一建模,增強模型的跨模態語義對齊能力,顯著提升圖文生成效果。

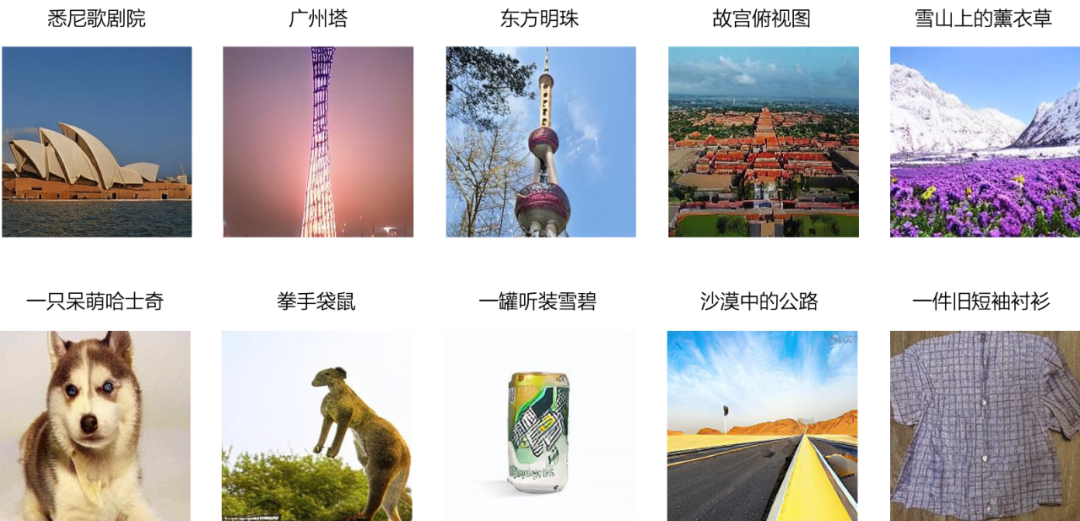

小編帶你體驗文心 ERNIE-ViLG “圖像創作”能力:

在文字生成圖像上,文心 ERNIE-ViLG 可以根據用戶輸入的文本,自動創作圖像,生成的圖像不僅符合文字描述,而且達到了非常逼真的效果。

注意!以下圖片都是全新生成,并非可直接搜索到的原圖。

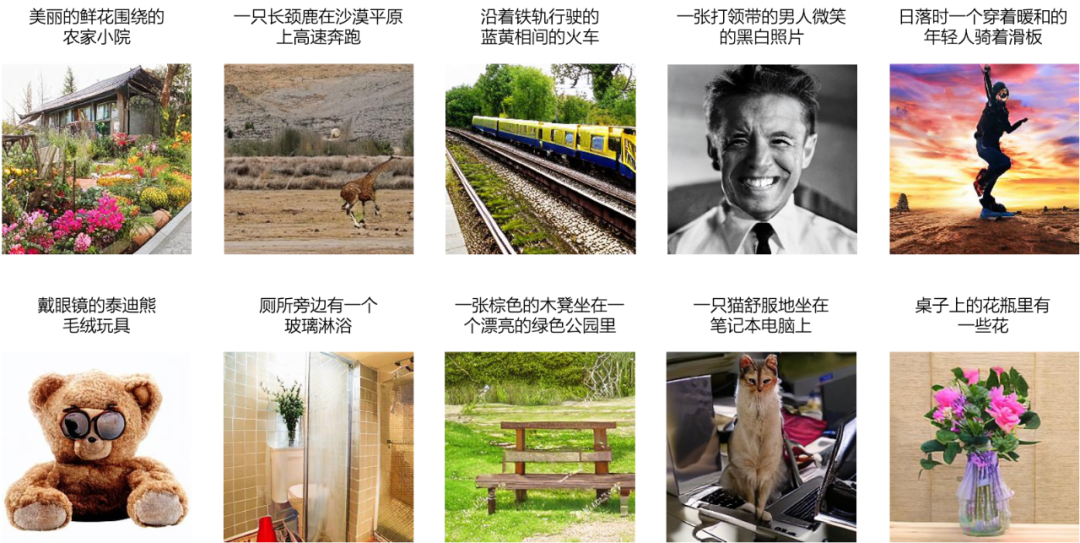

文心 ERNIE-ViLG 不僅能創作建筑、動物等單個物體:

還可以創作包含多個物體的復雜場景:

甚至能根據用戶輸入的文字要求腦洞大開:

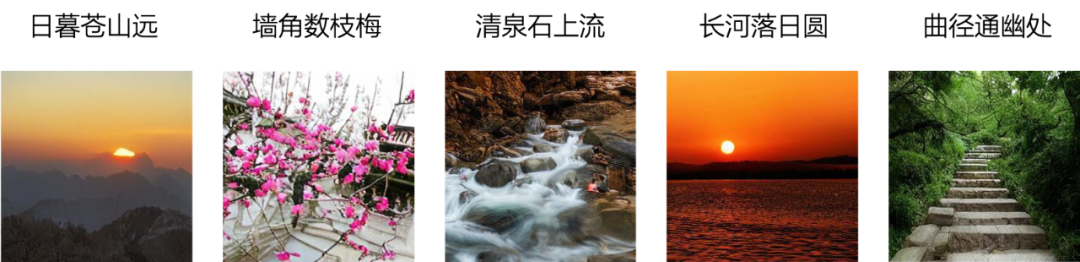

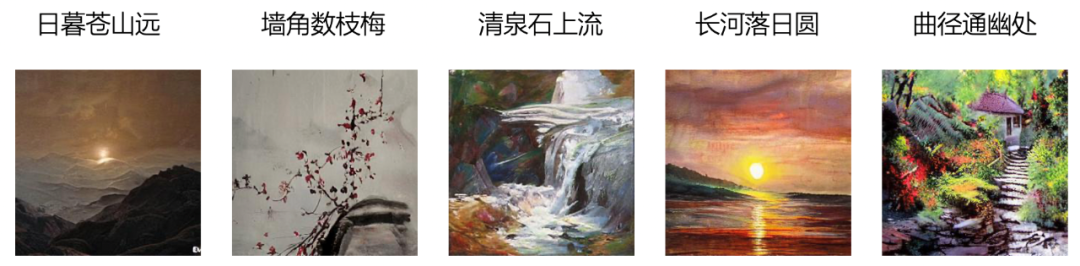

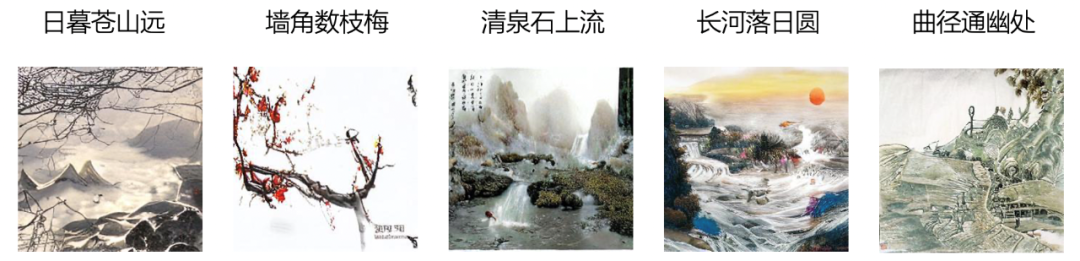

對于具有無限想象力的古詩詞,文心 ERNIE-ViLG 也能生成恰如其分的畫面,并根據不同的圖畫風格也有所調整:

油畫風格

中國畫風格

水彩畫風格

此外,還能根據文字提示對圖片進行補全:

而在圖像到文本的生成上,文心 ERNIE-ViLG 能夠理解畫面,用簡潔的語言描述畫面的內容:

不僅如此,文心 ERNIE-ViLG 還能夠根據圖片中的場景回答相關的問題:

目前文心 ERNIE-ViLG 在百度文心官網開放體驗的文本生圖像 demo 能夠根據古詩詞進行作畫,增強詩詞的畫面感。

在這些能力的背后,究竟蘊含著怎樣的 AI 技術秘密?

跨模態生成:AI 領域極具挑戰性的一道“難題”

跨模態生成,指的是將一種模態 (文本、圖像、語音) 轉換成另一種模態,同時保持模態之間的語義一致性。

圖文生成是跨模態生成的挑戰之一。以圖片生成文本為例,文本描述概括性強,根據文本生成圖片,需要考慮大量文字中未涵蓋的細節信息,具有極高的挑戰性。例如詩句“春江水暖鴨先知”,僅僅描述了江水、鴨子兩個物體和春天這個季節,但沒有具體描述鴨子的顏色、江邊的桃花以及圖中物體之間的位置關系。

春江水暖鴨先知

近些年來,基于生成對抗網絡 (GAN) 的方法在人臉、風景等受限領域的文本到圖像生成任務上已取得了不錯的效果;DALL-E 通過超大規模的自回歸生成模型,在圖像片段之間建立了前后依賴的關系,從而具備多樣性生成的建模能力,在多樣性更強、難度更大的開放領域文本到圖像生成上取得了亮眼的效果。

百度文心 ERNIE-ViLG 模型則進一步提出統一的跨模態雙向生成模型,通過自回歸生成模式對圖像生成和文本生成任務進行統一建模,更好地捕捉模態間的語義對齊關系,從而同時提升圖文雙向生成任務的效果。文心 ERNIE-ViLG 在文本生成圖像的權威公開數據集 MS-COCO 上,圖片質量評估指標 FID(Fréchet Inception Distance)遠超 OpenAI 的 DALL-E 等同類模型,并刷新了圖像描述多項任務的最好效果。此外,文心 ERNIE-ViLG 還憑借強大的跨模態理解能力,在生成式視覺問答任務上也取得了領先成績。

文心 ERNIE-ViLG 技術原理解讀:圖文雙向生成統一建模

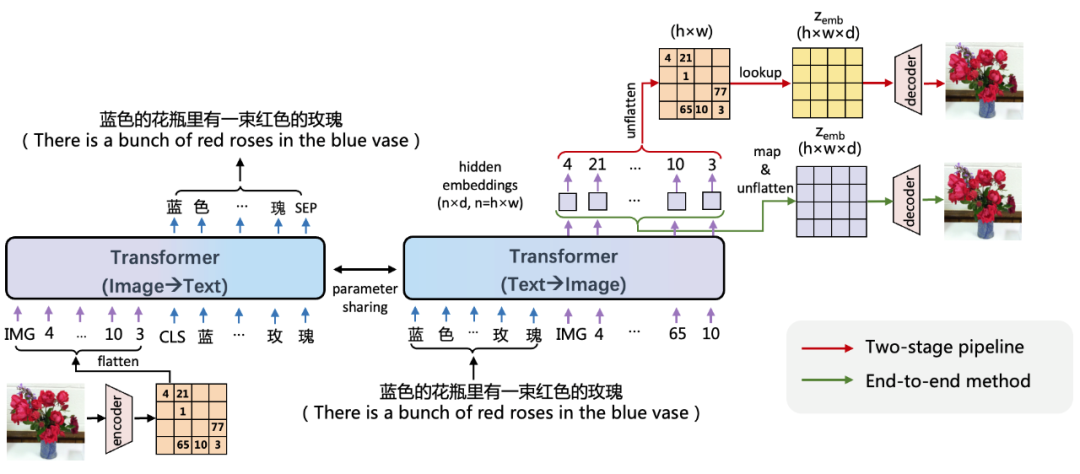

百度文心 ERNIE-ViLG 使用編碼器 - 解碼器參數共享的 Transformer 作為自回歸生成的主干網絡,同時學習文本生成圖像、圖像生成文本生成兩個任務。

基于圖像向量量化技術,文心 ERNIE-ViLG 把圖像表示成離散的序列,從而將文本和圖像進行統一的序列自回歸生成建模。在文本生成圖像時, 文心 ERNIE-ViLG 模型的輸入是文本 token 序列,輸出是圖像 token 序列;圖像生成文本時則根據輸入的圖像序列預測文本內容。兩個方向的生成任務使用同一個 Transformer 模型。視覺和語言兩個模態在相同模型參數下進行相同模式的生成,能夠促進模型建立更好的跨模態語義對齊。

文心 ERNIE-ViLG 圖文雙向生成統一建模框架

已有基于圖像離散表示的文本生成圖像模型主要采用兩階段訓練,文本生成視覺序列和根據視覺序列重建圖像兩個階段獨立訓練,文心 ERNIE-ViLG 提出了端到端的訓練方法,將序列生成過程中 Transformer 模型輸出的隱層圖像表示連接到重建模型中進行圖像還原,為重建模型提供語義更豐富的特征;對于生成模型,可以同時接收自身的抽象監督信號和來自重建模型的原始監督信號,有助于更好地學習圖像表示。

文心 ERNIE-ViLG 構建了包含 1.45 億高質量中文文本 - 圖像對的大規模跨模態對齊數據集,并基于百度飛槳深度學習平臺在該數據集上訓練了百億參數模型,在文本生成圖像、圖像描述等跨模態生成任務上評估了該模型的效果。

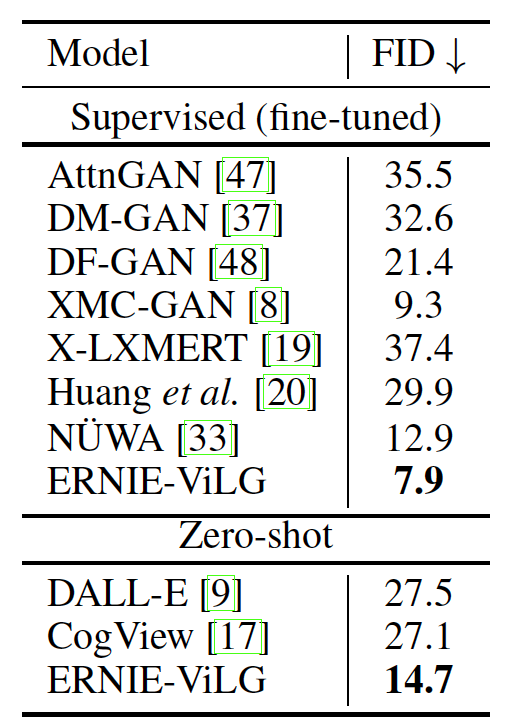

文本生成圖像(Text-to-image Synthesis)任務效果

文心 ERNIE-ViLG 文本生成圖像的能力在開放領域公開數據集 MS-COCO 上進行了驗證。評估指標使用 FID(該指標數值越低效果越好), 在 zero-shot 和 finetune 兩種方式下,文心 ERNIE-ViLG 都取得了最佳成績,效果遠超 OpenAI 發布的 DALL-E 等模型。

文心 ERNIE-ViLG 在 MS-COCO 數據集上的效果

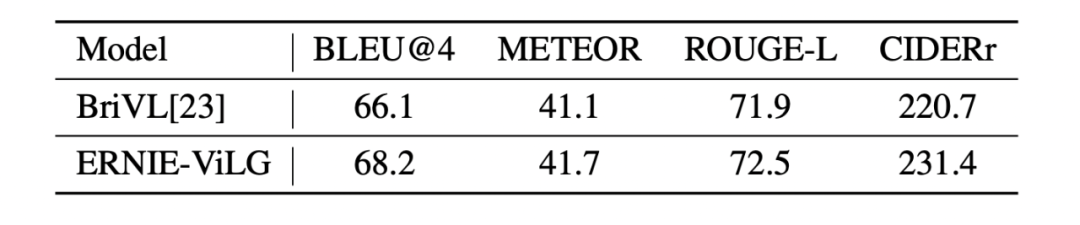

圖像描述(Image Captioning)任務效果

圖像生成文本能力上,文心 ERNIE-ViLG 在 COCO-CN、AIC-ICC 兩個公開中文圖片標題生成數據集上, 都取得了最好成績。

文心 ERNIE-ViLG 在 AIC-ICC 數據集上的效果

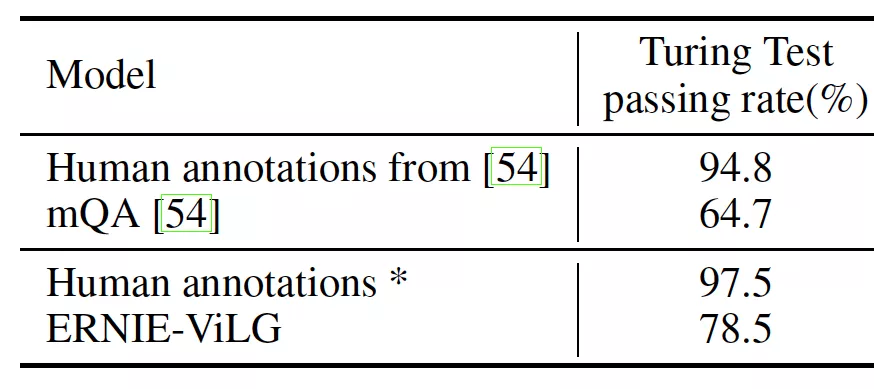

生成式視覺問答(Generative VQA)任務效果

在生成式視覺問答方面,文心 ERNIE-ViLG 也展示了不俗的實力。生成式視覺問答要求模型根據圖像內容和對應的問題生成答案,模型需要具備深度的視覺內容理解能力和跨模態的語義對齊能力,并需要生成簡短的答案文本,難度極高。文心 ERNIE-ViLG 在 FMIQA 數據集上取得了最好的效果,圖靈測試的通過率達到了 78.5%,優于當前最好方法 14 個百分點。

文心 ERNIE-ViLG 在 FMIQA 數據集上的效果

結語

讓機器具備跨模態生成能力是人工智能的重要目標之一。在藝術創作、虛擬現實、圖像編輯、AI 輔助設計、虛擬數字人等領域,文心 ERNIE-ViLG 這類跨模態大模型有著廣泛的應用前景,也為這些領域未來的發展提供了無限的創意和可能。作為百度 “文心” 大模型全景圖中的重要一員,文心 ERNIE-ViLG 也代表著百度文心在跨模態大模型領域邁出堅實步伐,從技術自主創新和加速產業應用方面持續推動中國 AI 發展。