BERT是圖像預(yù)訓(xùn)練未來?字節(jié)iBOT刷新十幾項SOTA,部分指標(biāo)超MAE

前段時間,何愷明等人的一篇論文成為了計算機視覺圈的焦點。這篇論文僅用簡單的 idea(即掩蔽自編碼器,MAE)就達(dá)到了非常理想的性能,讓人們看到了 Transformer 擴展到 CV 大模型的光明前景,給該領(lǐng)域的研究者帶來了很大的鼓舞(參見《大道至簡,何愷明新論文火了:Masked Autoencoders 讓計算機視覺通向大模型》)。

那么,MAE 就是大模型視覺模型預(yù)訓(xùn)練方法的巔峰了嗎?顯然不是,一大波挑戰(zhàn)者已經(jīng)在路上了,比如字節(jié)跳動、約翰霍普金斯大學(xué)等機構(gòu)組成的聯(lián)合團(tuán)隊。

在一篇最新的論文中,他們提出了適用于視覺任務(wù)的大規(guī)模預(yù)訓(xùn)練方法 iBOT,通過對圖像使用在線 tokenizer 進(jìn)行 BERT [1]式預(yù)訓(xùn)練讓 CV 模型獲得通用廣泛的特征表達(dá)能力。該方法在十幾類任務(wù)和數(shù)據(jù)集上刷新了 SOTA 結(jié)果,在一些指標(biāo)上甚至超過了 MAE [2]。

論文鏈接:https://arxiv.org/abs/2111.07832

方法介紹

在 NLP 的大規(guī)模模型訓(xùn)練中,MLM(Masked Language Model)是非常核心的訓(xùn)練目標(biāo),其思想是遮住文本的一部分并通過模型去預(yù)測這些遮住部分的語義信息,通過這一過程可以使模型學(xué)到泛化的特征。NLP 中的經(jīng)典方法 BERT 就是采用了 MLM 的預(yù)訓(xùn)練范式,通過 MLM 訓(xùn)練的模型已經(jīng)被證明在大模型和大數(shù)據(jù)上具備極好的泛化能力,成為 NLP 任務(wù)的標(biāo)配。

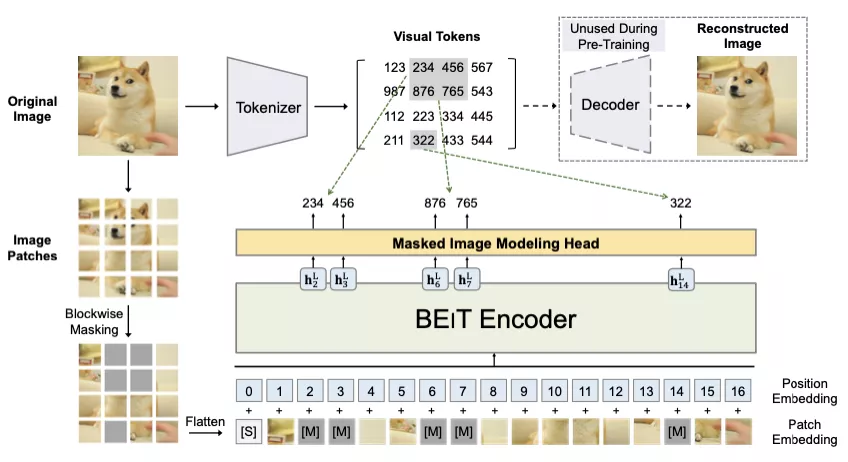

在該工作中,研究者主要探索了這種在 NLP 中主流的 Masked Modeling 是否能應(yīng)用于大規(guī)模 Vision Transformer 的預(yù)訓(xùn)練。作者給出了肯定的回答,并認(rèn)為問題關(guān)鍵在于 visual tokenizer 的設(shè)計。不同于 NLP 中 tokenization 通過離線的詞頻分析即可將語料編碼為含高語義的分詞,圖像 patch 是連續(xù)分布的且存在大量冗余的底層細(xì)節(jié)信息。而作者認(rèn)為一個能夠提取圖像 patch 中高層語義的 tokenizer 可幫助模型避免學(xué)習(xí)到冗余的這些細(xì)節(jié)信息。作者認(rèn)為視覺的 tokenizer 應(yīng)該具備兩個屬性:(a)具備完整表征連續(xù)圖像內(nèi)容的能力;(b) 像 NLP 中的 tokenizer 一樣具備高層語義。

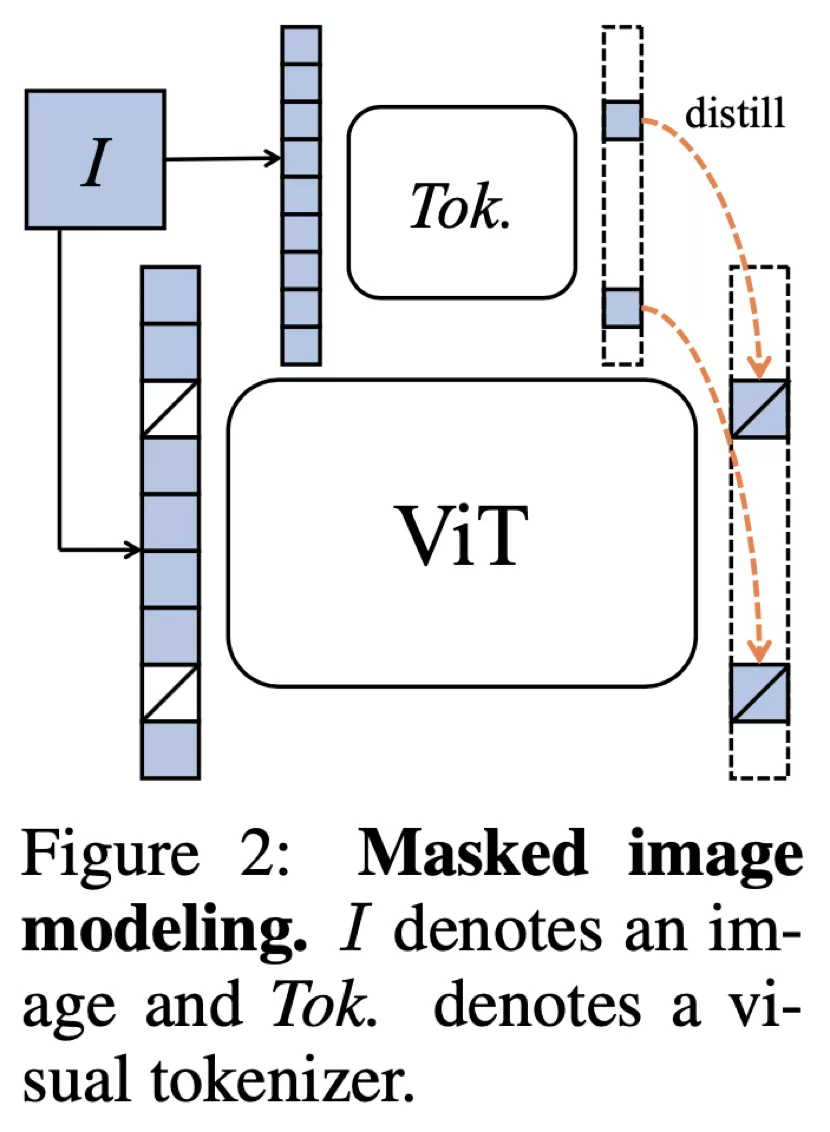

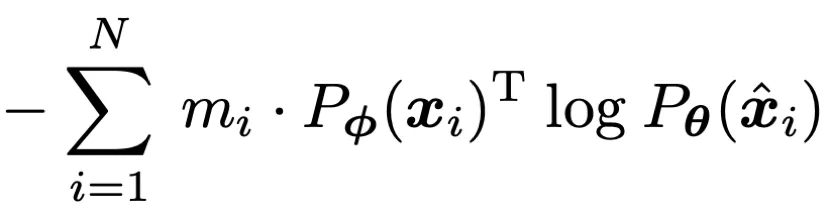

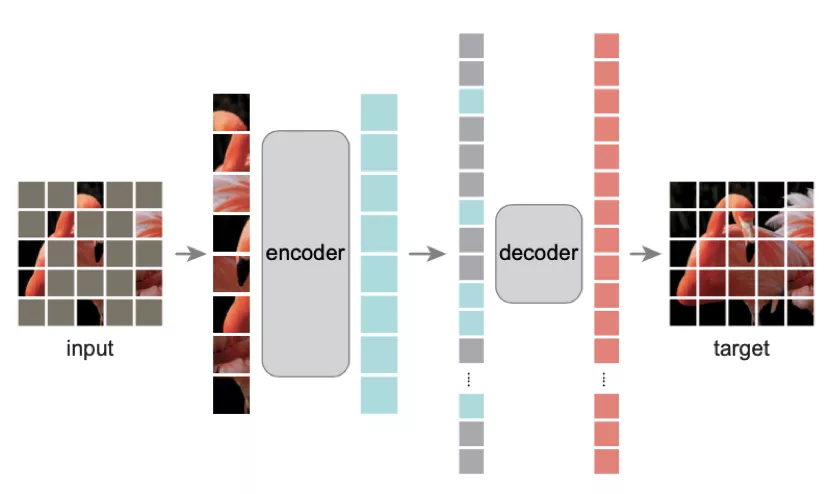

如何才能設(shè)計出一個 tokenizer,使之同時具備以上的屬性呢?作者首先將經(jīng)過 mask 過的圖片序列輸入 Transformer 之后進(jìn)行預(yù)測的過程建模為知識蒸餾的過程:

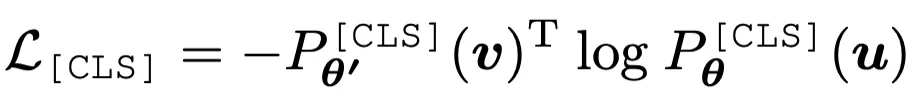

作者發(fā)現(xiàn),通過使用在線 tokenizer 監(jiān)督 MIM 過程,即 tokenizer 和目標(biāo)網(wǎng)絡(luò)同步學(xué)習(xí),能夠較好地保證語義的同時并將圖像內(nèi)容轉(zhuǎn)化為連續(xù)的特征分布。具體地,tokenizer 和目標(biāo)網(wǎng)絡(luò)共享網(wǎng)絡(luò)結(jié)構(gòu),在線即指 tokenizer 其參數(shù)從目標(biāo)網(wǎng)絡(luò)的歷史參數(shù)中滑動平均得出。該形式近期在 DINO [3]中以自蒸餾被提出,并被用以針對同一張圖片的兩個不同視野在 [CLS] 標(biāo)簽上的優(yōu)化:

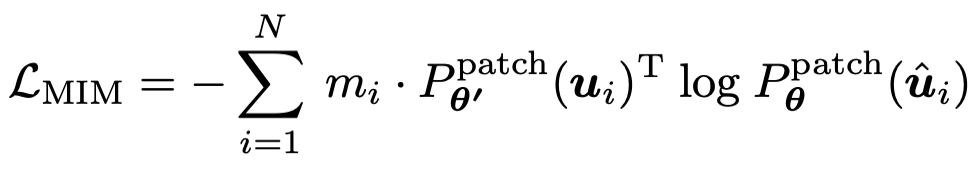

在該損失函數(shù)的基礎(chǔ)之上,作者將 MIM 同樣也使用自蒸餾的思路進(jìn)行優(yōu)化,其中在線 tokenizer 的參數(shù)即為目標(biāo)網(wǎng)絡(luò)歷史參數(shù)的平均。其過程可表示為:

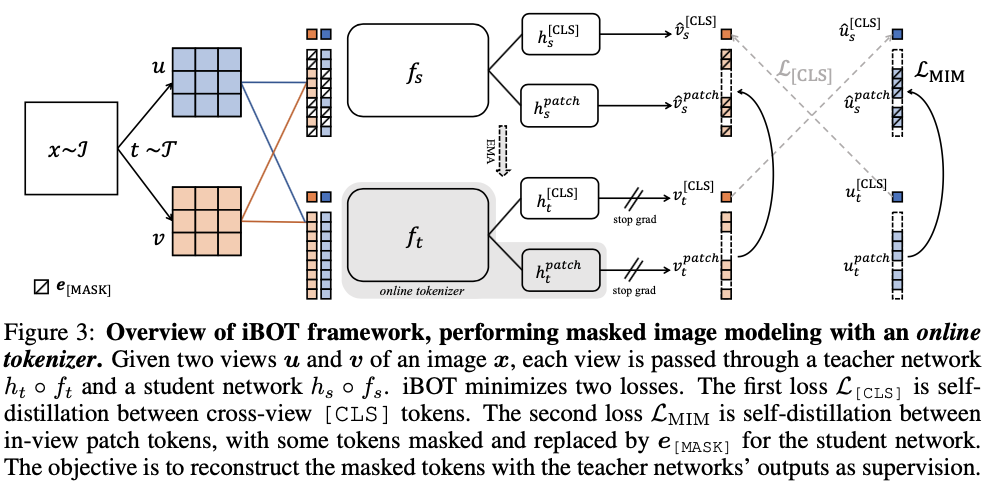

基于上述訓(xùn)練目標(biāo),作者提出了一種新的自監(jiān)督預(yù)訓(xùn)練框架 iBOT。iBOT 同時優(yōu)化上述兩項損失函數(shù)。其中,在 [CLS] 標(biāo)簽上的自蒸餾保證了在線 tokenizer 學(xué)習(xí)到高語義特征,并將該語義遷移到 MIM 的優(yōu)化過程中;而在 patch 標(biāo)簽上的自蒸餾則將在線 tokenizer 表征的 patch 連續(xù)分布作為目標(biāo)監(jiān)督 masked patch 的復(fù)原。該方法在保證模型學(xué)習(xí)到高語義特征的同時,通過 MIM 顯式建模了圖片的內(nèi)部結(jié)構(gòu)。同時,在線 tokenizer 與 MIM 目標(biāo)可以一起端到端地學(xué)習(xí),無需額外的 tokenizer 訓(xùn)練階段。

預(yù)訓(xùn)練時采用孿生網(wǎng)絡(luò)結(jié)構(gòu),其中在線 tokenizer 可以看作教師分支的一部分。教師、學(xué)生兩分支包括結(jié)構(gòu)相同的 backbone 網(wǎng)絡(luò)和 projection 網(wǎng)絡(luò)。作者廣泛驗證了 iBOT 方法搭配不同的 Transformers 作為 backbone,如 Vision Transformers(ViT-S/16, ViT-B/16, ViT-L/16)及 Swin Transformers(Swin-T/7, Swin-T/14)。作者發(fā)現(xiàn)共享 [CLS] 標(biāo)簽與 patch 標(biāo)簽的 projection 網(wǎng)絡(luò)能夠有效提升模型在下游任務(wù)上的遷移性能。作者還采用了隨機 MIM 的訓(xùn)練機制,對每張圖片而言,以 0.5 的概率不進(jìn)行 mask,以 0.5 的概率從 [0.1, 0.5] 區(qū)間隨機選取一個比例進(jìn)行 mask。實驗表明隨機 MIM 的機制對于使用了 multi-crop 數(shù)據(jù)增強的 iBOT 非常關(guān)鍵。

實驗結(jié)果

為了驗證 iBOT 預(yù)訓(xùn)練方法的有效性,作者在大量的下游任務(wù)上進(jìn)行了驗證,同時也在附錄里提供了比較詳細(xì)的不同任務(wù)超參數(shù)對最終結(jié)果的影響。

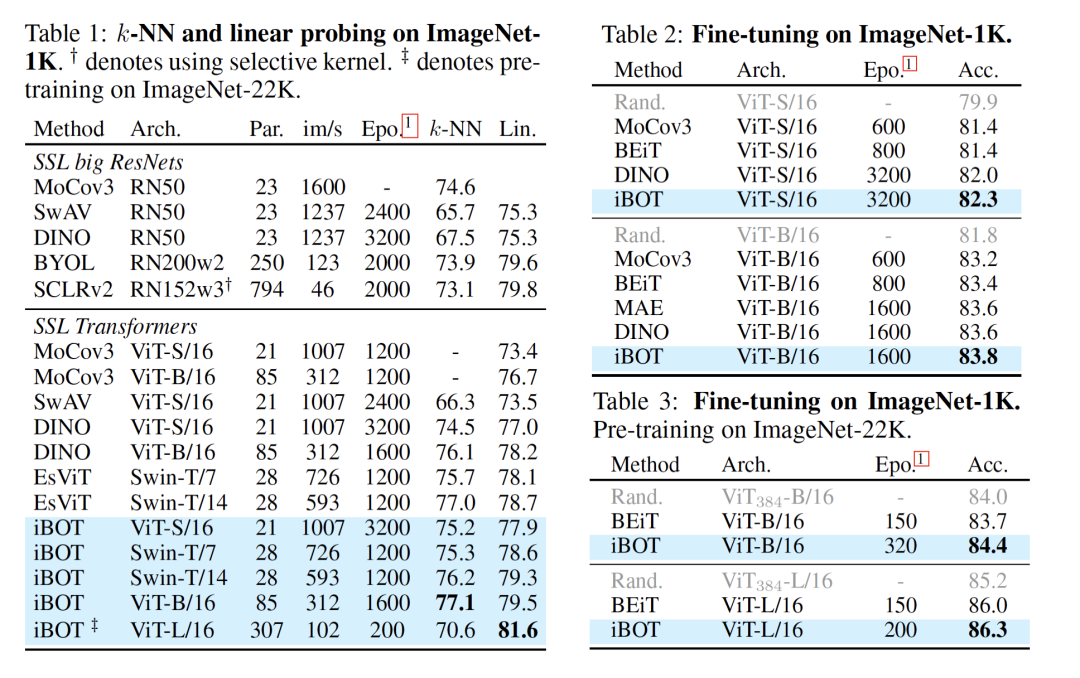

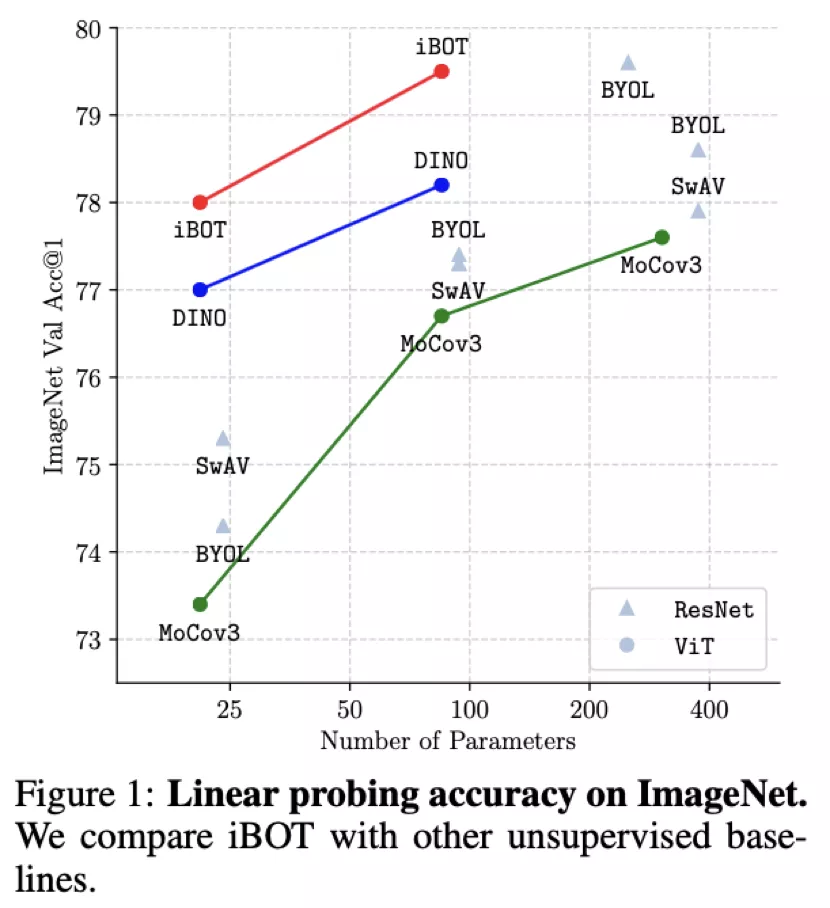

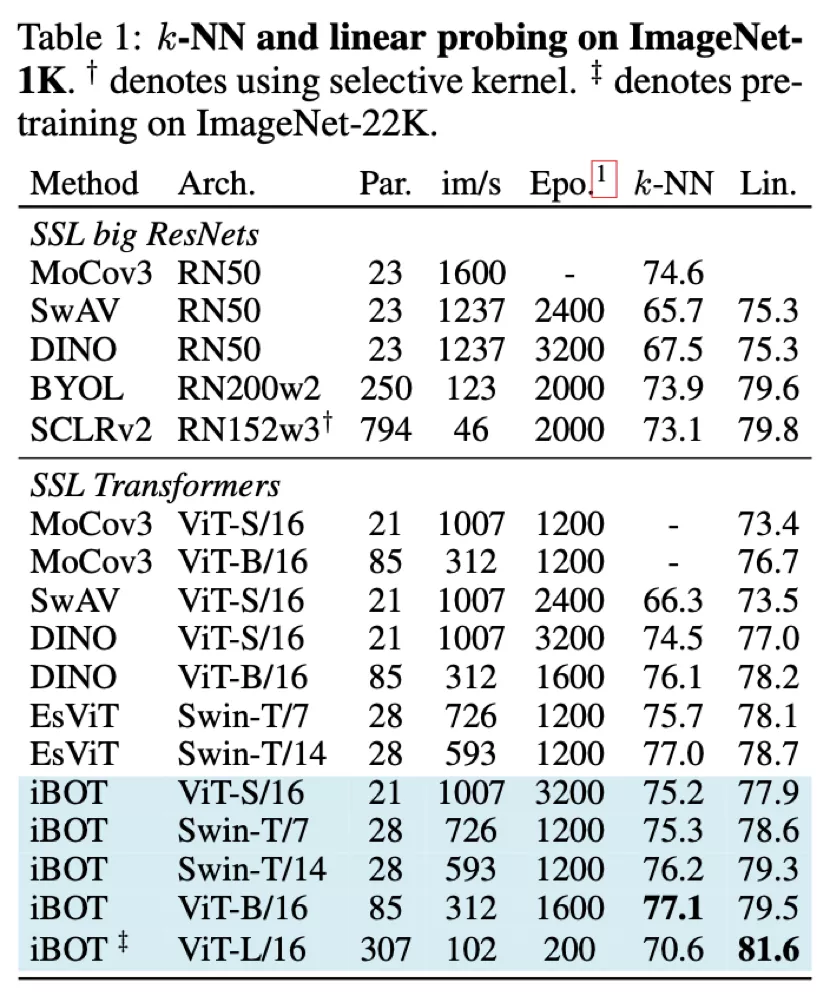

從 Linear probing(線性分類)及 k-NN 分類的結(jié)果上來看,iBOT 使用 ViT-B/16 達(dá)到 79.5% 線性分類準(zhǔn)確度,超越了 DINO 的 78.2%;使用 Swin-T/14 達(dá)到 79.3% 準(zhǔn)確度,超越了 EsViT 的 78.7%;使用 ViT-L/16 及 ImageNet-22K 作為預(yù)訓(xùn)練數(shù)據(jù)達(dá)到 81.6% 準(zhǔn)確度,為目前 ImageNet-1K 線性分類基準(zhǔn)上最高的結(jié)果。

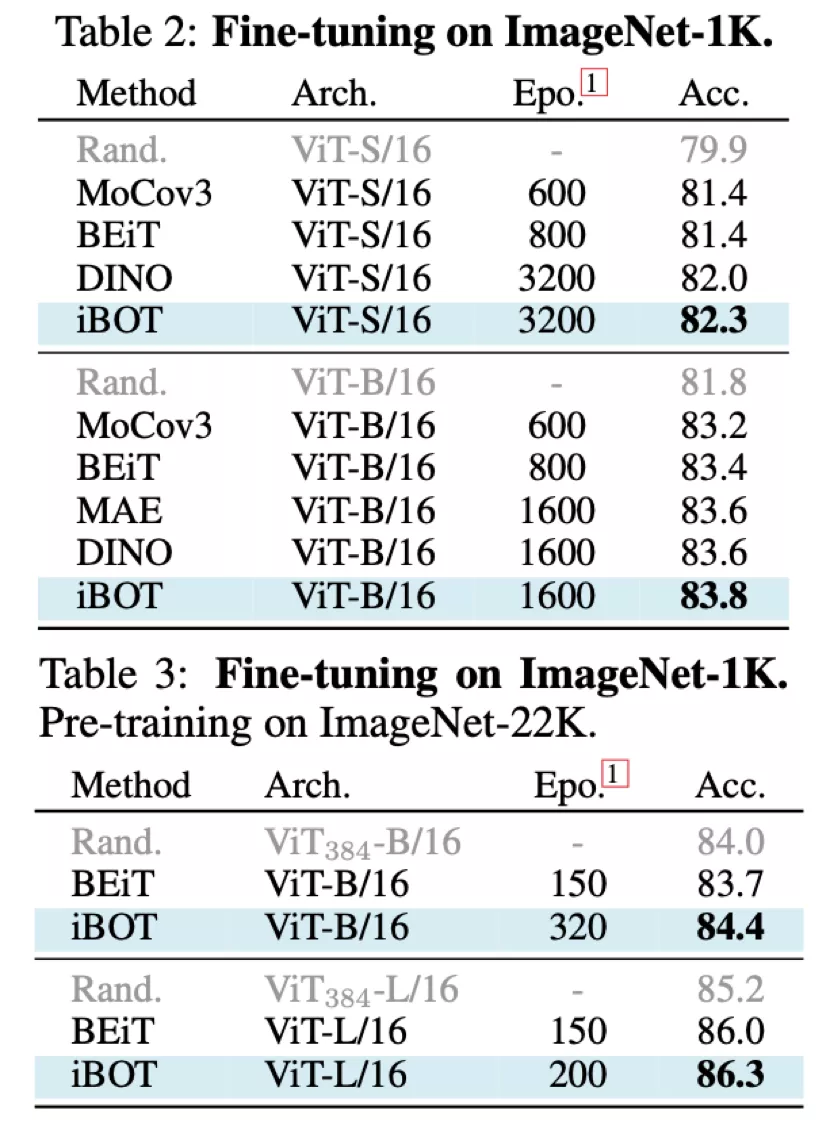

從 Fine-tuning 的結(jié)果上來看,使用 ImageNet-1K 作為預(yù)訓(xùn)練數(shù)據(jù)及 ViT-B/16 時 iBOT 可達(dá)到 83.8% 準(zhǔn)確率,高于 DINO、MAE 的 83.6%;使用 ImageNet-22K 作為預(yù)訓(xùn)練數(shù)據(jù)及 ViT-L/16 時 iBOT 可達(dá)到 86.3%,高于 BEiT [4]的 86.0%。

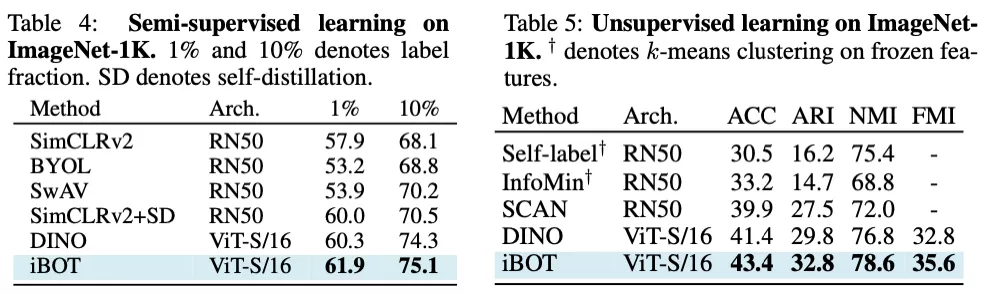

在半監(jiān)督及無監(jiān)督分類的結(jié)果上來看,iBOT 也顯著優(yōu)于沒有 MIM 訓(xùn)練目標(biāo)的 DINO。其中在半監(jiān)督的基準(zhǔn)下,作者發(fā)現(xiàn)微調(diào)數(shù)據(jù)越少時,iBOT 的優(yōu)勢越明顯。在無監(jiān)督的基準(zhǔn)下,iBOT 能達(dá)到 43.4% 的準(zhǔn)確率以及 78.6% 的 NMI。

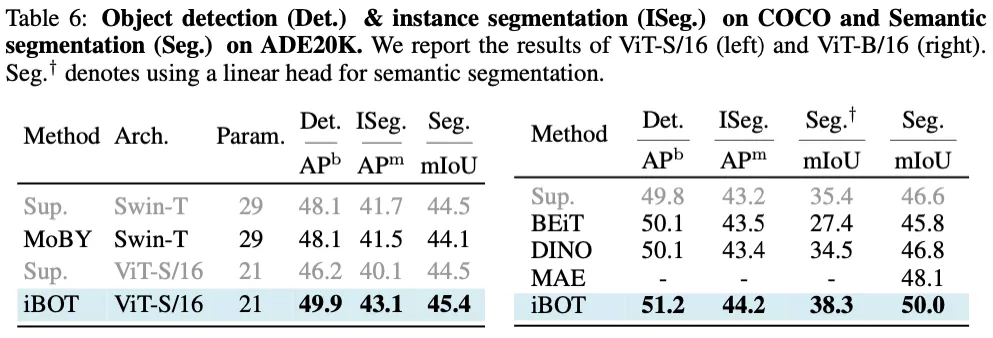

除此之外,因為 MIM 顯示建模了圖片內(nèi)部結(jié)構(gòu),作者發(fā)現(xiàn) iBOT 在密集的下游任務(wù)也有非常好的遷移結(jié)果。其中 iBOT 使用 ViT-B/16 及 Cascade Mask R-CNN 在目標(biāo)檢測下可達(dá)到 51.2 APb;使用 ViT-B/16 及 UperNet 在語義分割下可達(dá)到 50.0 mAP,高于 MAE 達(dá)到的 48.1 mAP。

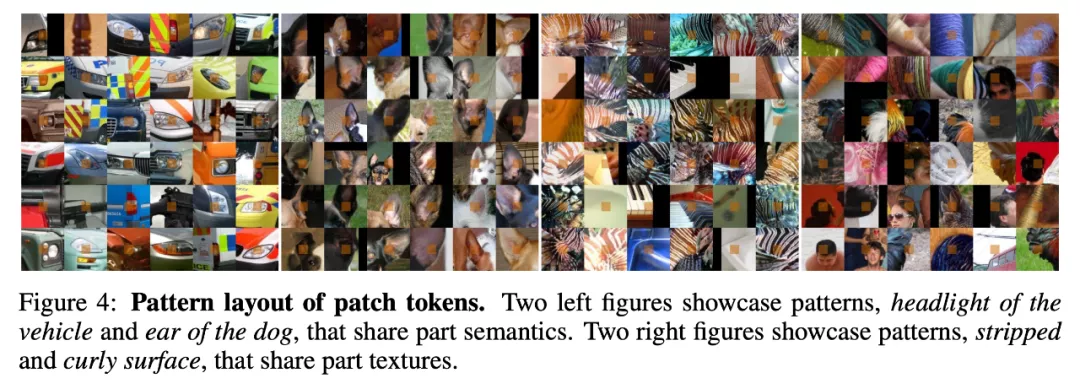

同時作者也進(jìn)一步探究了 MIM 訓(xùn)練目標(biāo)所帶來的特性,以幫助分析 iBOT 在全局圖像任務(wù)及密集圖像任務(wù)出色表現(xiàn)的原因。作者根據(jù) ImageNet 驗證集中所有圖片 patch 的概率分布,可視化了部分類別中心所代表的模式。作者在大量的可視化結(jié)果中發(fā)現(xiàn) iBOT 針對局部語義有非常好的可視化結(jié)果,如下圖左一、左二中所示的車燈、狗耳朵展現(xiàn)了不同局部類別語義的出現(xiàn),而在下圖左三、左四中展現(xiàn)了不同局部紋理語義的出現(xiàn)。

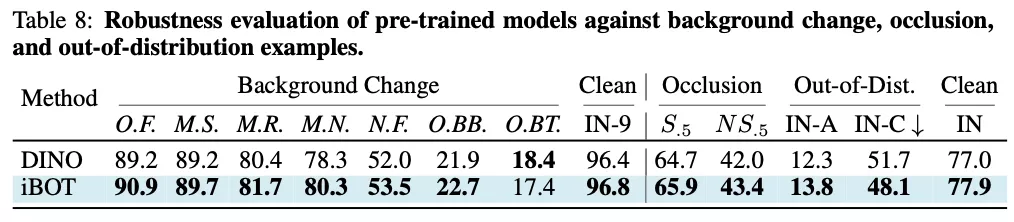

在大量魯棒性分析及測評中,作者發(fā)現(xiàn) iBOT 相較沒有 MIM 訓(xùn)練目標(biāo)的 DINO 有更出色的表現(xiàn),這說明局部語義的出現(xiàn)能夠幫助模型在遮擋、模糊等一系列干擾存在的圖像識別任務(wù)下有更好的準(zhǔn)確性。

方法對比

近期 masked autoencoding 的思路可謂在視覺領(lǐng)域大火,和近期一些工作對比,BEiT 使用了一個預(yù)訓(xùn)練好的 DALL-E encoder 作為 tokenizer,將每個 patch 標(biāo)簽離散化后的 one-hot 編碼作為目標(biāo)模型的標(biāo)簽。

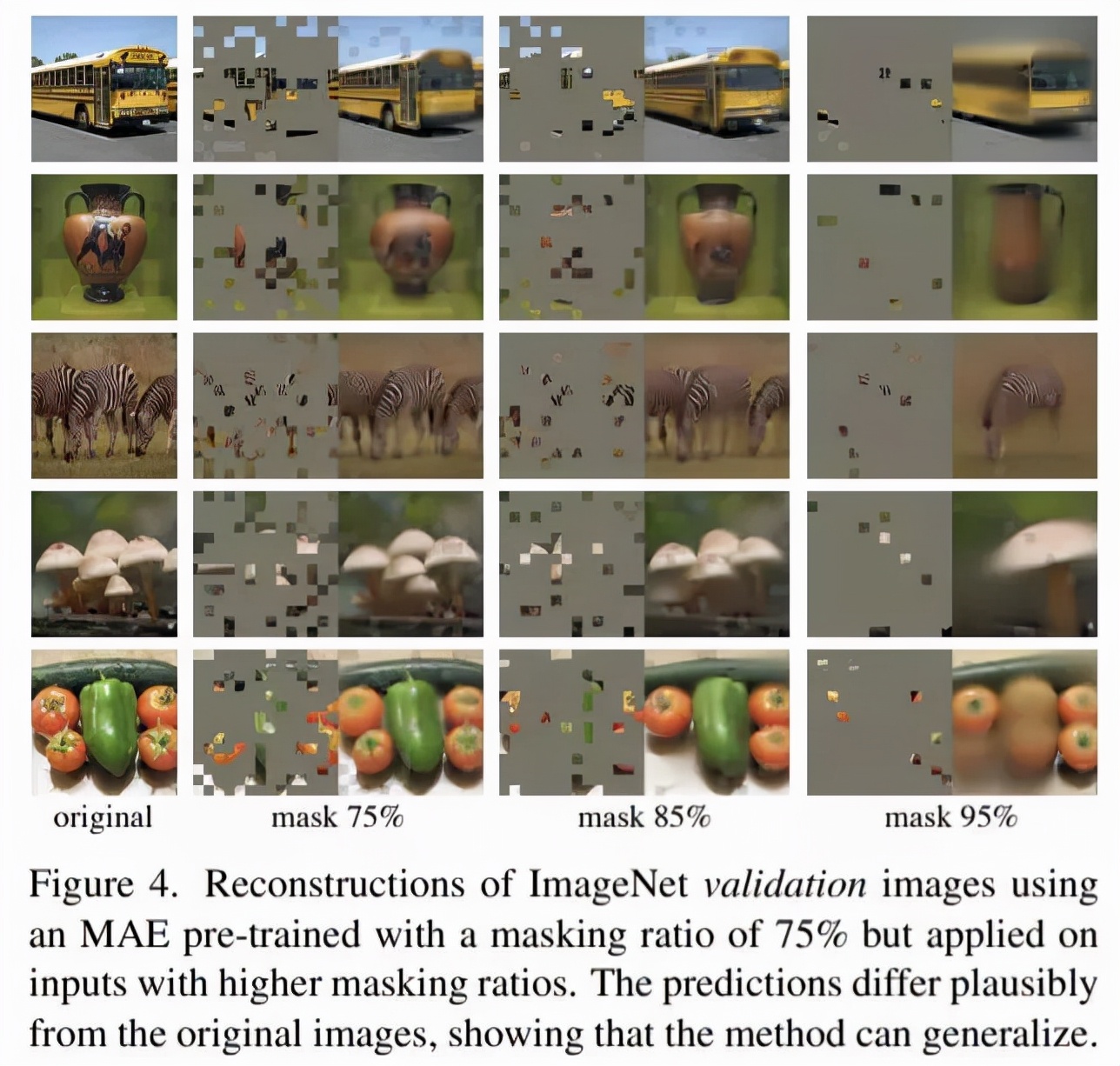

而 MPP [5]及近期較火的 MAE 則可將 tokenizer 視為恒等變換,即直接在像素空間內(nèi)進(jìn)行回歸而非分類。

而 iBOT 則指出了上述幾種方式的 tokenizer 存在過度關(guān)注低級信息的問題,這也可以從上述幾種方法線性分類的性能不是很高可以看出。但近期 MAE 中指出當(dāng)圖片中被 mask 的比例足夠大時,可使網(wǎng)絡(luò)無法從相近 patches 中插值獲取信息從而迫使其學(xué)到全局信息;MAE 還指出線性分類并不是唯一評估特征表征能力的基準(zhǔn),且和下游遷移學(xué)習(xí)的表現(xiàn)不能較好相關(guān)。