2000 億次開放學習后,DeepMind 的智能體“成精”了

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

有這樣一批智能體,在完全沒有見過的游戲任務里,也學會了游刃有余地解決目標。

譬如面對下面這樣一個高地,它們要取到上面的紫色金字塔。

沒有跳躍功能的它們,看似開始“焦躁”地亂扔起東西來,實則其中一塊板子正好被“扔”成了樓梯,這不就巧了,目標完成!

你可能會說這只是“瞎貓撞死耗子”罷了,但多次實驗發現,該智能體可以復現該方法的!

你可能會說這只是“瞎貓撞死耗子”罷了,但多次實驗發現,該智能體可以復現該方法的!

而且它還會不止一種方法,“我不上去,你下來”—— 直接借助板子把目標扒拉下來了!

而且它還會不止一種方法,“我不上去,你下來”—— 直接借助板子把目標扒拉下來了!

這也行?

這也行?

而這些成精了的智能體來自 DeepMind。

現在,為了讓 AI 更加多才多藝、舉一反三,他們專門給智能體打造了一個包含了數十億游戲任務的“元宇宙”XLand:讓智能體在不斷擴展、升級的開放世界中通過上億次的訓練練就了不俗的泛化能力。

最終效果就像前面看到的,無需在新游戲中從頭訓練,它們就能自主解決任務!

DeepMind 也因此發表了一篇論文,就叫做:《從開放學習走出來的通用智能體》。

如何做到的呢?

“元宇宙”XLand

最功不可沒之一的就是這個龐大的“元宇宙”模擬空間。

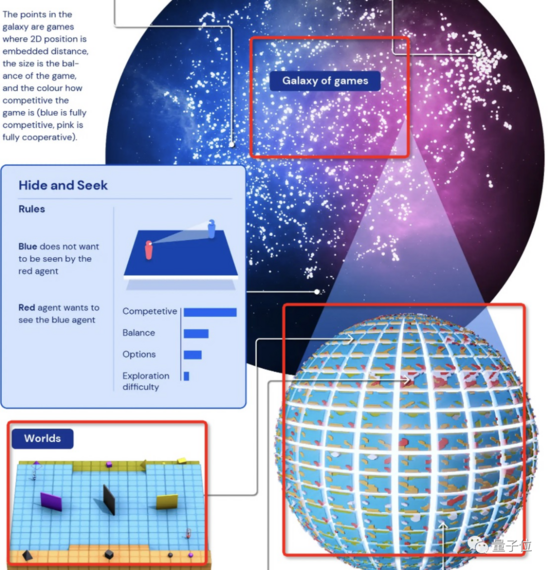

這是一個“游戲星系”,里面有無數個“游戲星球”,每個星球上的游戲按競爭性、平衡性、可選項、探索難度四個緯度進行區分。

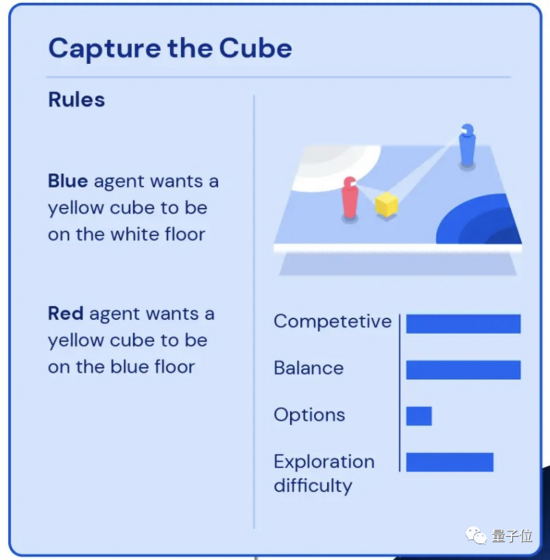

比如圖左上介紹的“搶方塊”游戲:藍色智能體需要把黃色的立方體放到白色區域,紅色智能體需要把同一個立方體放在藍色區域。

啊想想就頭大,所以這個游戲的競爭性值都拉滿了,而由于雙方的條件/目標都一樣,所以平衡性值也很高,因為需要定位目標區域,所以探索難度并不小。

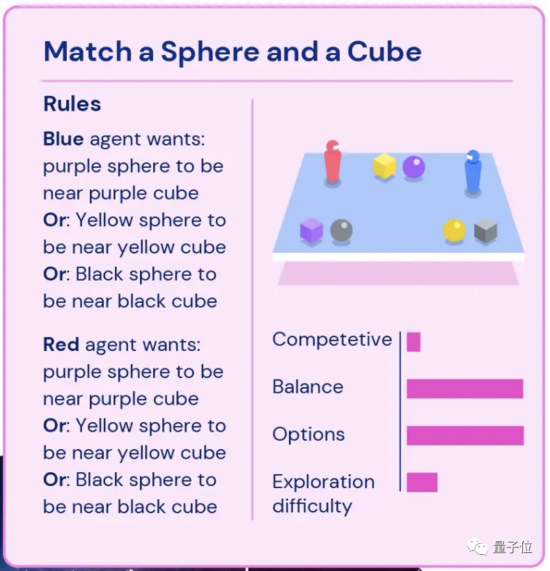

再比如圖右上的“將球體和立方體配對”:藍色/紅色智能體要將幾何體按顏色歸類到一起,完成任意一組配對就行。這個游戲的可選性值就拉滿了,但競爭性就沒那么強。

ps. 藍色游戲代表是完全競爭性的,粉色為完全合作性的。

不管是哪種游戲任務,這批智能體都從最簡單的開始(比如僅“靠近紫色立方體”這種),一步步解鎖復雜度升級的游戲(比如和另一個智能體“捉迷藏”),其中每一項游戲都有獎勵,智能體們的目標就是將拿到的獎勵最大化。

而智能體“玩家”們是通過閱讀收到的目標的文字描述、觀察 RGB 圖像來感知周圍環境來完成任務。

生成的新任務要基于舊任務,且難度要剛剛好

除了上面這個開放式的學習環境,訓練方法也很重要。

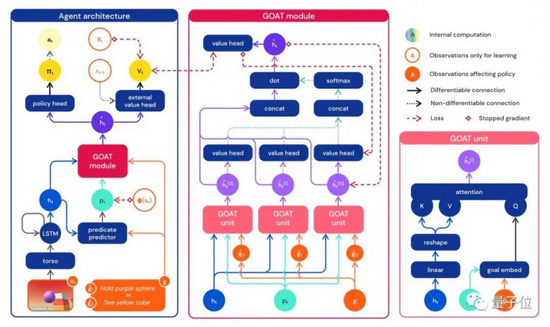

研究人員使用的神經網絡訓練架構提供了一種針對智能體內部循環狀態的注意力機制 —— 通過估計所玩游戲的子目標,來持續引導智能體的注意力。

這種策略讓智能體學習到更具普遍能力的策略。

還有一個問題:如此廣闊的游戲環境,什么樣的游戲任務分布能產出最善于泛化的智能體呢?

研究人員通過持續調整每個智能體的游戲分布發現,每個新任務都要基于通關的舊任務生成,不能太難,也不能太容易。

這個也基本符合一般認知。

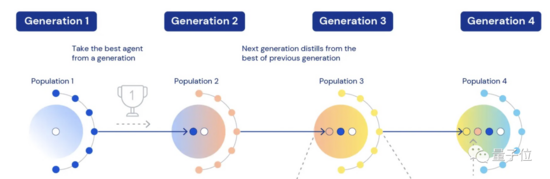

它們先經歷了四次迭代:

每個任務由多個智能體參與競爭,在舊任務上適應得好的智能體,會帶著權重、瞬時任務分布、超參數等參與到新一輪任務中繼續學習。此時也會加入新的智能體讓競爭“活”起來。

智能體表現出明顯的零樣本學習能力

最后生成的第五代智能體,在 XLand 4000 多個“星球”里玩了大約 70 萬個游戲,每一個智能體都經歷了 2000 億次訓練,完成了 340 萬個獨特任務。

到了這個時候,這些智能體已經能夠順利完成每一項評估任務(除了少數即使是人類也不可能完成的)。

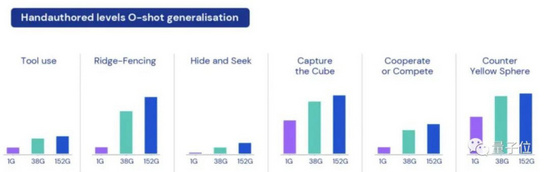

整個實驗也最終表明,通過開發像 XLand 這樣的環境和這樣開放式地訓練方法,一些基于 RL 的智能體已表現出明顯的零樣本學習能力 (0-shot)。

比如使用工具、打攔(ridge-fencing)、“捉迷藏”、找立方體、數數、合作或競爭等。

研究人員也觀察到智能體們面對新任務時不知道“什么是最好的解決辦法”,但它們會不斷地試驗直到達到目標。

這個過程中出現的有趣的”緊急啟發式行為”,除了開頭提到的搭梯子,還有這個臨時更換更簡易目標的例子 ——

在一個游戲中該智能體需要從 3 個目標中任選一個完成:

1、將黑色金字塔放到黃色球體旁邊;

2、將紫色球體放到黃色金字塔旁邊;

3、將黑色金字塔放到橙色區域。

它一開始找到了一個黑色金字塔,想去完成目標 3,但在搬運過程中看到了黃色球體,于是它就在 1 秒內改變了主意,選擇直接將金字塔放在黃色球體旁邊完成目標 1。(整個過程一共耗時 6 秒)

最后,看完了 DeepMind 的研究,再拋給大家一個問題:我們離真正的通用人工智能還有多遠?

(ps. 你發現了嗎,文章最開頭高臺取金字塔任務中的小紅智障體就不行,一直打轉,面對小藍搭好的梯子甚至直接毀掉)

論文地址:

https://arxiv.org/abs/2107.12808