三「模」聯盟,谷歌DeepMind締造終身學習智能體!

為了讓AI實現終身學習,帝國理工、谷歌DeepMind竟動用了三大基礎模型!

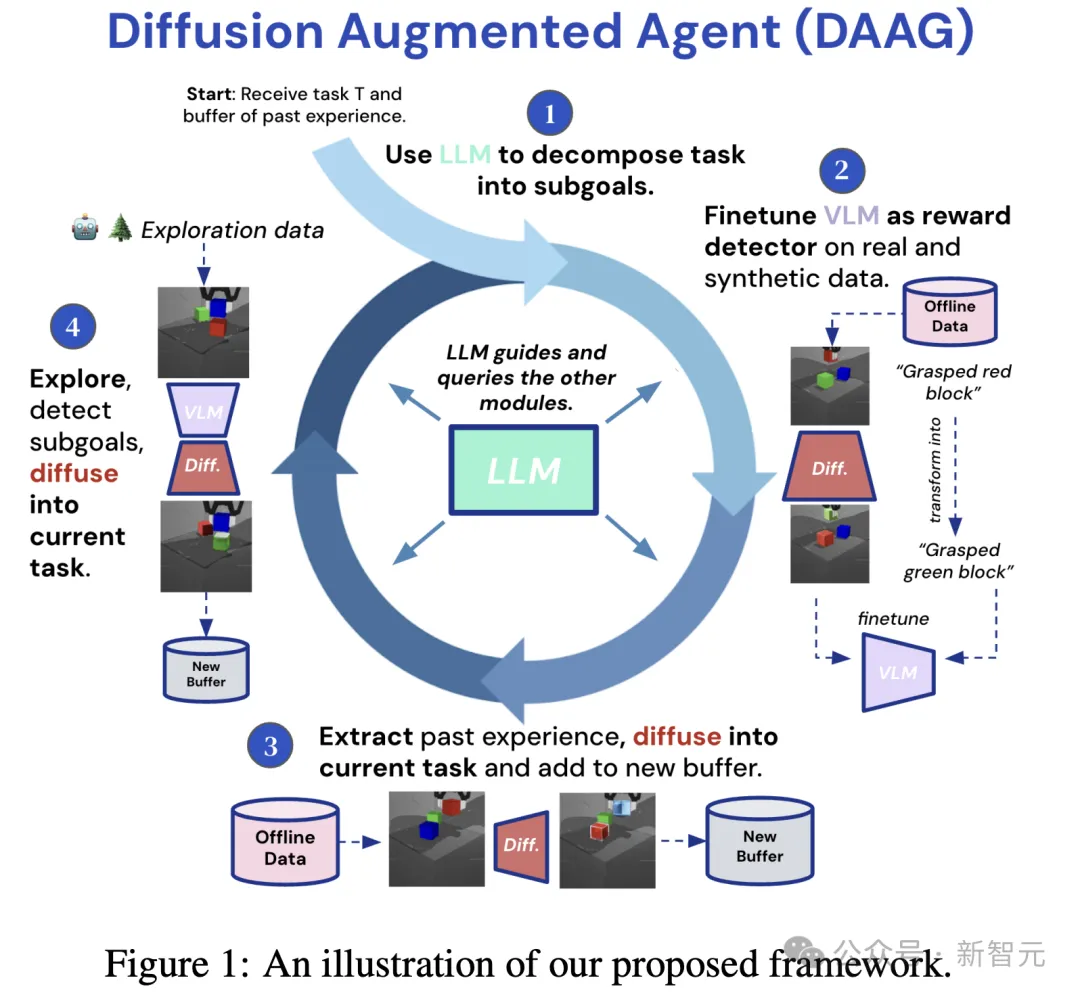

「大模型+視覺語言模型+擴散模型」三模并用,構建了全新框架——擴散增強智能體(DAAG)。

DAAG的誕生,就是讓具身智能體進行遷移學習、高效探索。

最新框架利用了「后見之明經驗增強」(Hindsight Experience Augmentation)技術,讓擴散模型以時間和幾何一致的方式轉換視頻。

讓其與目標指令對齊,從而對智能體過去經驗進行重新標記。

論文地址:https://arxiv.org/pdf/2407.20798

大模型在無需人類監督情況下,自主協調這一過程,使其非常適合終身學習場景。

經過一系列實驗,結果表明,DAAG改進了獎勵檢測器的學習、過去經驗的遷移以及新任務的獲取。

這些都是開發高效終身學習智能體的關鍵能力。

無需人類監督,AI終身強化學習

一直以來,具身AI的訓練數據極其稀缺,特別是在強化學習場景中尤為突出。

因為這類智能體需要與物體環境進行互動,而傳感器和執行器成為了主要瓶頸。

然而,克服這一挑戰需要開發出,能夠從有限經驗中高效學習、適應的智能體。

對此,研究人員假設,具身智能體可以通過利用過去經驗,有效探索,并在任務之間轉移知識,實現更高數據搬運效率。

即便在沒有外部獎勵的情況下,他們希望讓智能體可以自主設置、評分子目標,并能重新利用之前任務經驗,加速新任務學習。

因此,最新研究中,團隊成員使用預訓練的基礎模型Gemini 1.0 Pro來解決這些問題。

通過視覺、語言和擴散模型的相互作用,讓智能體更有效推理任務,解釋環境和過去經驗,并操縱自身收集的數據,以重新用于新任務和目標。

更重要的是,DAAGG可以自主運行,無需人類監督,凸顯其特別適合終身強化學習的場景。

如下圖1,是擴散增強智能體完整框架。

其中,LLM充當主要控制器/大腦,查詢和指導VLM和DM,以及智能體的高級行為。

通過一系列在不同環境中的實驗,研究人員證明了DAAGG在改進智能體在關鍵能力上的表現:

1)用擴散模型生成合成樣本增強的數據,微調視覺語言模型,自主計算已見和未見任務的獎勵;

2)為給定任務設計和識別有用的子目標,通過擴散模型修改記錄的觀察,重新利用原失敗的軌跡,從而更有效地探索和學習新任務;

3)提取相關數據,使用擴散模型重新利用其他軌跡,有效地將先前收集的數據轉移到新任務中。

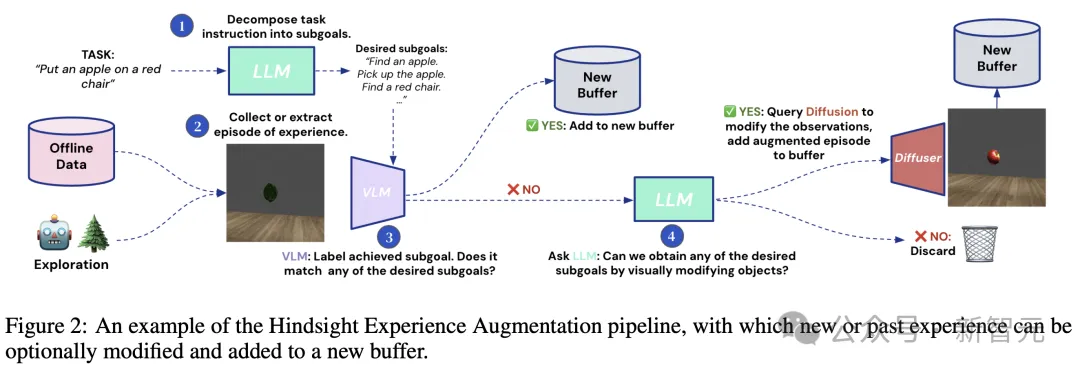

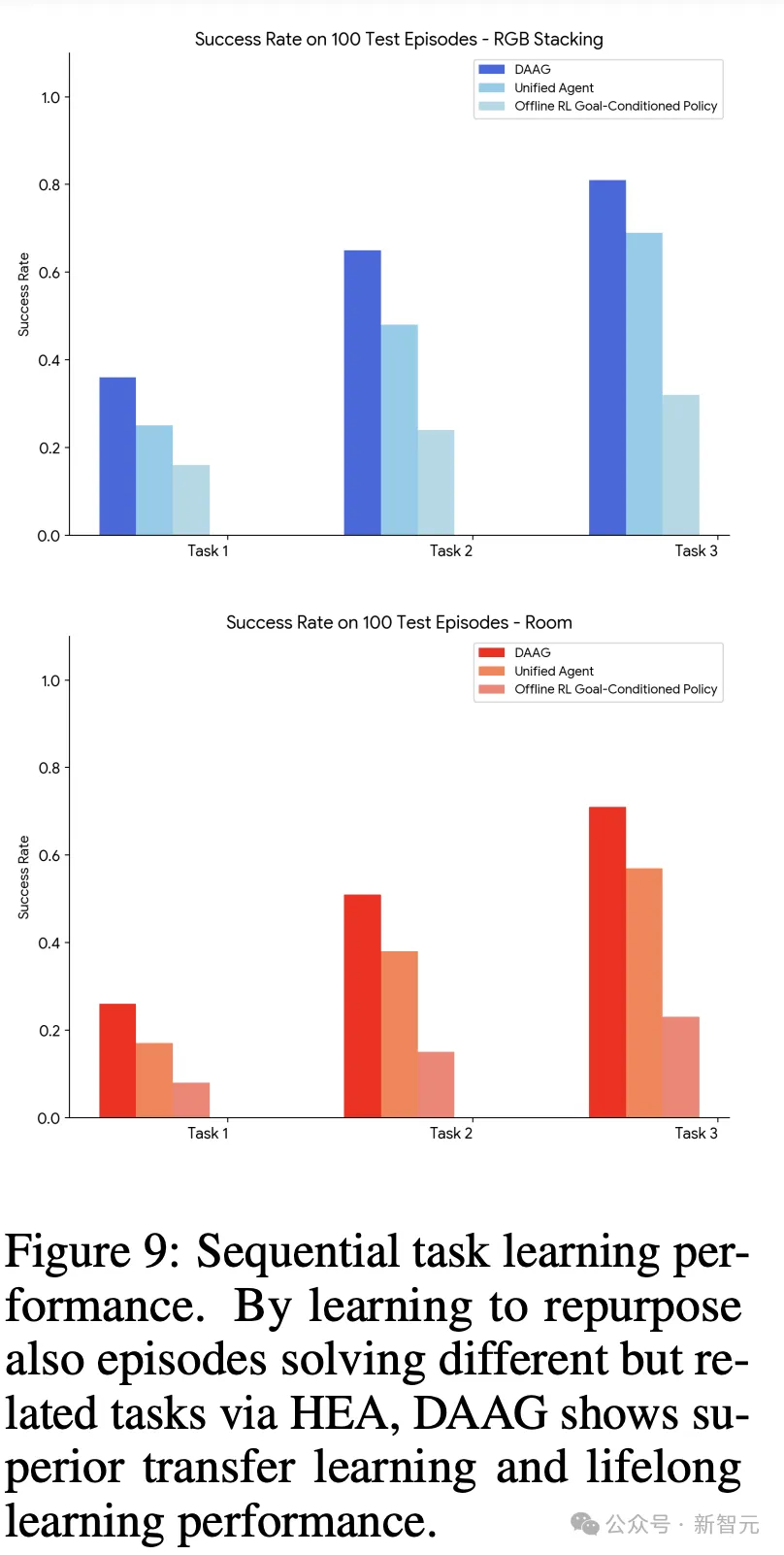

圖2所示,DAAGG方法如何通過擴散增強,重新利用智能體的經驗。

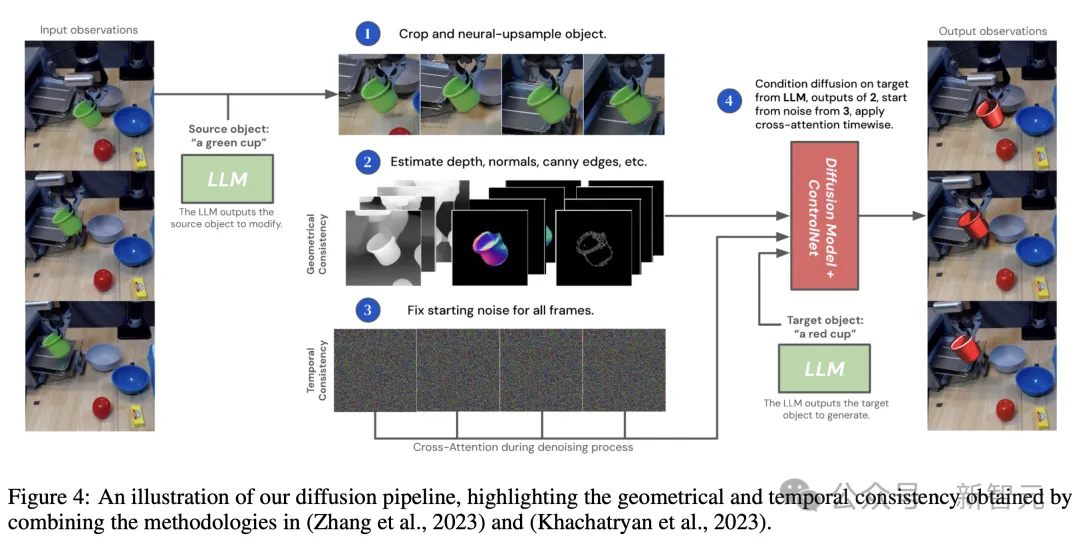

研究人員提出了一個擴散管道,提高了幾何和時間一致性,并修改了智能體收集的部分視頻。

方法

DAAGG具體設計方法如下。

研究人員將環境形式化為「馬爾可夫決策過程」(MDP):在每個時間步t,環境和智能體處于狀態s ∈ S。

從該狀態,智能體接收視覺觀察o ∈ O,并可以執行動作a ∈ A。

在每個回合中,智能體接收一個指令,這是用自然語言T描述的要執行的任務。

如果任務成功執行,智能體可以在回合結束時,獲得獎勵r = +1。

這項論文中,除了獨立學習新任務外,作者還研究了DAAGG框架以終身方式連續學習任務的能力。

因此,智能體將交互經驗存儲在兩個緩沖區中:當前任務緩沖區,稱之為新緩沖區 :這個緩沖區在每個新任務開始時初始化。

:這個緩沖區在每個新任務開始時初始化。

然后是離線終身緩沖區 :智能體將所有任務的所有回合存儲在這個緩沖區中,無論它們是否成功。

:智能體將所有任務的所有回合存儲在這個緩沖區中,無論它們是否成功。

因此,后者是一個不斷增長的經驗緩沖區,智能體隨后可以用它來引導新任務的學習。

以下是,作者選用的三種模型目的:

- 大模型LLM:編排智能體的行為,以及指導VLM和DM。LLM接受文本指令和數據,并輸出文本響應。而且,利用LLM將任務分解為子目標,比較不同任務/指令的相似性,并查詢VLM和DM。

- 視覺語言模型VLM:使用的是對比模型CLIP。CLIP由兩個分支組成:圖像分支和文本分支,它們分別以視覺觀察和文本描述作為輸入,最終輸出相同大小的嵌入向量。

- 擴散Pipeline:研究的核心是通過語言指導的擴散模型,修改視覺觀察。擴散Pipeline是為了提取智能體記錄的觀察 或一系列時間觀察

或一系列時間觀察 ,并保持幾何和時間一致性的同時,修改觀察中的一個或多個對象。

,并保持幾何和時間一致性的同時,修改觀察中的一個或多個對象。

如下是,擴散Pipeline的示意圖。

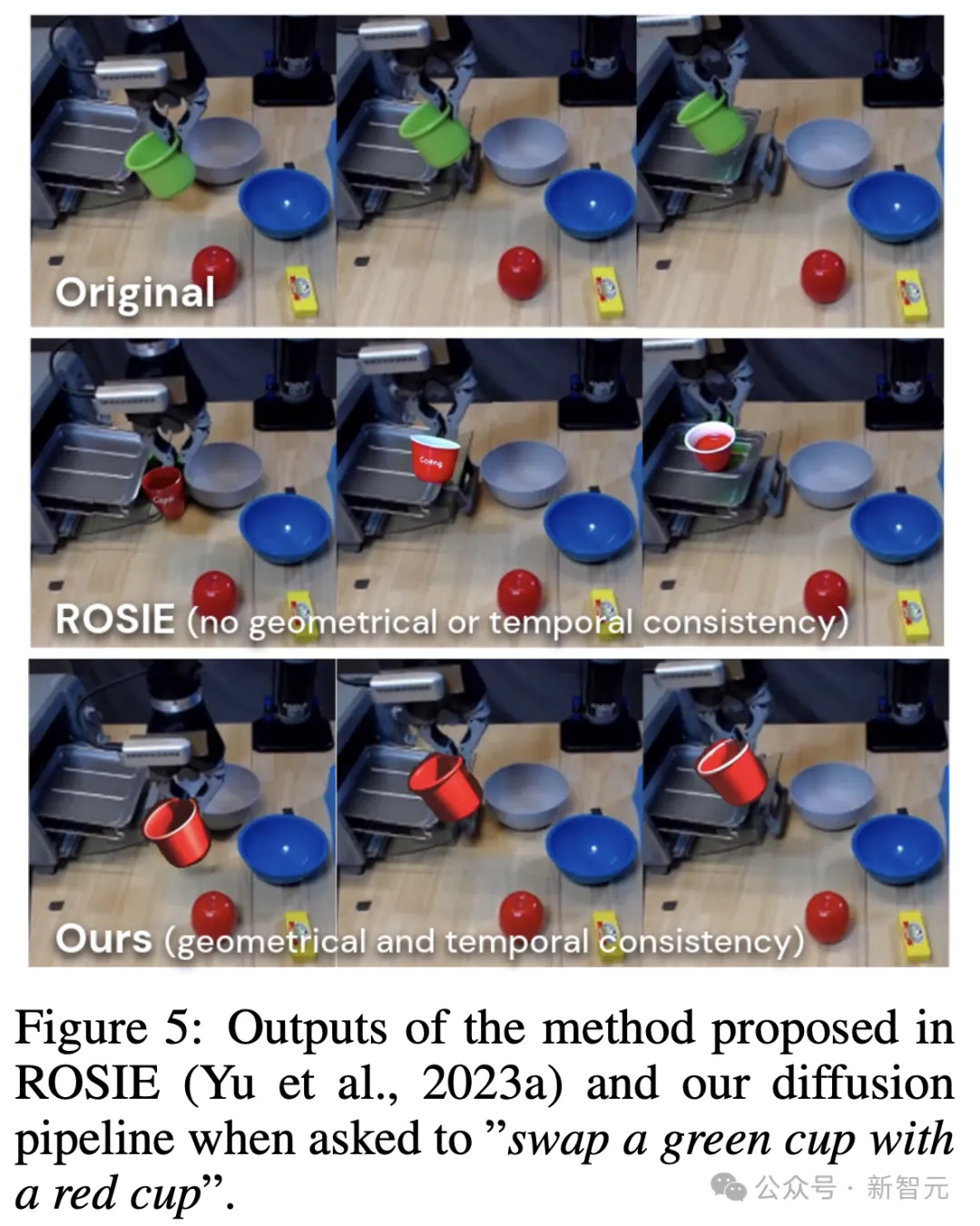

在圖5中,作者比較了ROISE和自己提出的Pipeline輸出。前者不能保持對象姿勢和外觀,在幀之間的一致性。

擴散增強智能體框架

在擴散增強數據上,微調VLM作為獎勵檢測器

VLM可以有效地用作獎勵檢測器,條件是基于語言定義的目標和視覺觀察。

最近的研究顯示,為了提升準確性,VLM通常需要在目標環境中收集的token數據上進行微調,適應所需的任務。

這是一個耗時的任務,而且每個新任務需要人類手動完成,嚴重阻礙了智能體以終身方式自主連續學習的多任務能力。

通過DAAGG框架,作者在先前收集的觀察上微調VLM來解決這一挑戰。

這個過程如上圖2所示,通過這個過程,微調VLM作為LLM分解當前任務的所有子目標 的成功檢測器。

的成功檢測器。

通過后見之明經驗增強,實現高效學習和遷移

在任何任務中收集的每個回合后,智能體收集一系列觀察和動作 。

。

在DAAGG中,研究人員旨在最大化智能體可以學習處理新任務的回合數量,即使它沒有達到任何所需的子目標。

最后,他們通過一個稱為后見之明經驗增強(HEA)的過程來實現這一點。

實驗結果

DAAGG框架提出了LLM+VLM+DM之間的相互作用,以解決終身學習智能體面臨的3個主要的挑戰:

1)微調新的獎勵/子目標檢測模型,

2)提取和轉移過去經驗用于新任務,

3)高效探索新任務。

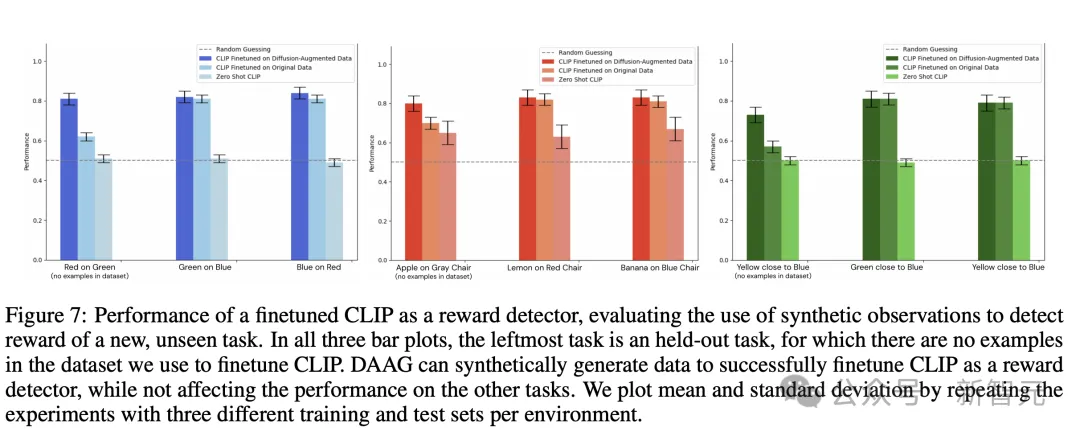

DAAGG能否將VLM微調為新任務的獎勵檢測器?

圖7顯示了,在數據集中沒有示例的最左側任務中,DAAGG如何通過綜合其他任務中的示例實現大幅改進,同時在所見的任務中保持相同的性能。

在RGB Stacking和Language Table環境中,物體姿勢之間的精確幾何關系非常重要,而DAAGG與基線的差異則更為顯著,這說明需要進行擴散增強才能獲得有效的獎勵檢測器。

在「房間」環境中,CLIP接收到的觀察結果雖然來自低保真模擬器和渲染器,但更接近它在網絡規模數據集(水果和家具圖片),上進行訓練時接收到的觀察結果分布。

因此,CLIP「零樣本」性能要強得多,而在其他任務中,CLIP零樣本性能則接近于隨機猜測,這表明有必要進行微調。

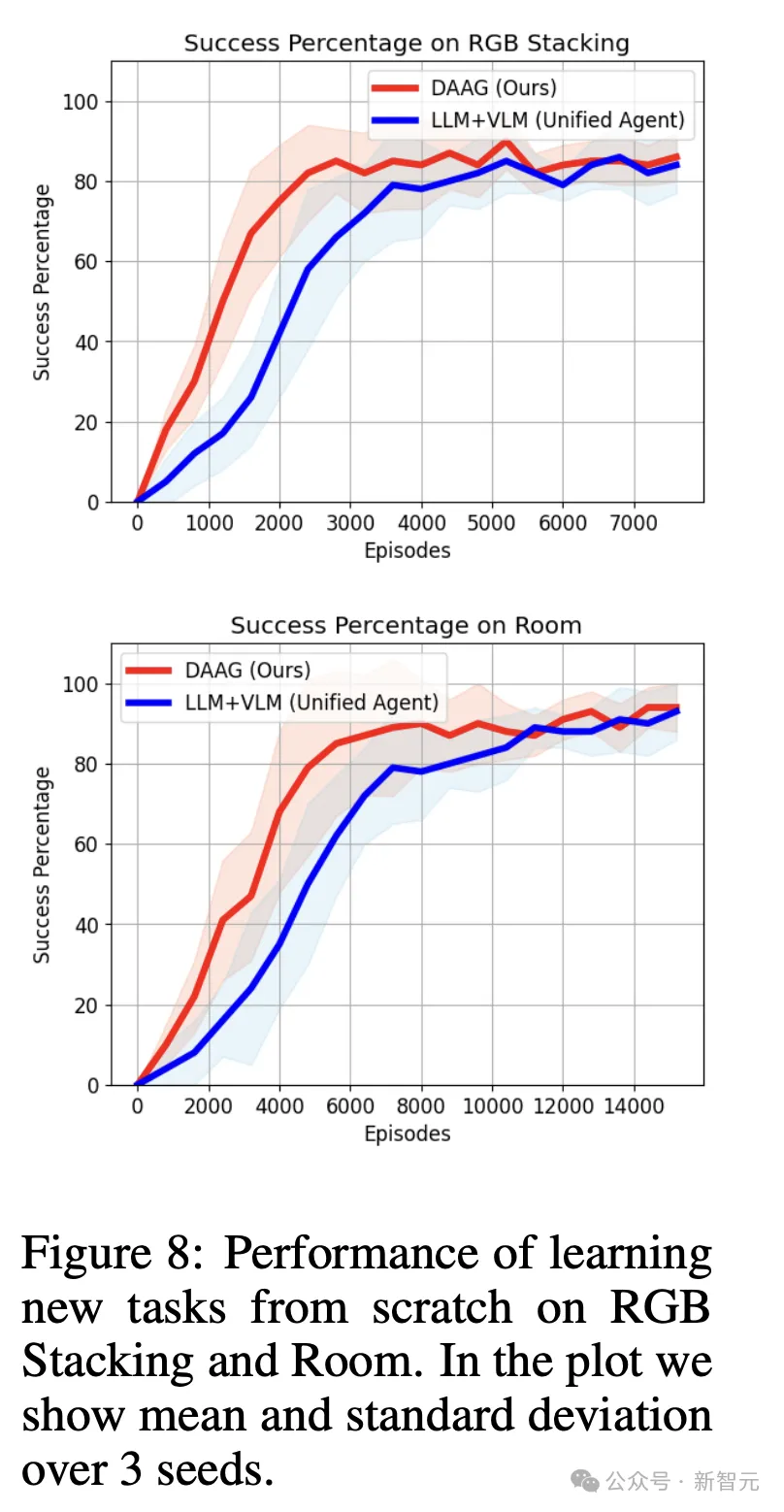

DAAGG能否更高效地探索和學習新任務?

下圖8中,作者繪制了100個測試事件中,成功解決任務實例的數量與訓練事件數量的函數關系圖。

在測試過程中,不執行任何探索策略或指導,而是讓策略網絡來引導智能體。

可以看到,DAAGG的學習速度比基線更快,將某些不成功的事件作為學習信號的能力,有助于提高在所有測試環境中的學習效率。

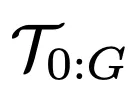

DAAGG能否更有效地連續學習任務,從過去的任務中轉移經驗?

圖9中,研究人員比較了每種方法在使用 時,在任務

時,在任務 上的性能,性能指標是成功率。

上的性能,性能指標是成功率。

可以看到,DAAGG超越了兩個基準方法,主要歸功于它能夠從存儲在 中大部分經驗中學習,通過修改和重新利用解決

中大部分經驗中學習,通過修改和重新利用解決 或其子目標

或其子目標 之外的任務軌跡。

之外的任務軌跡。

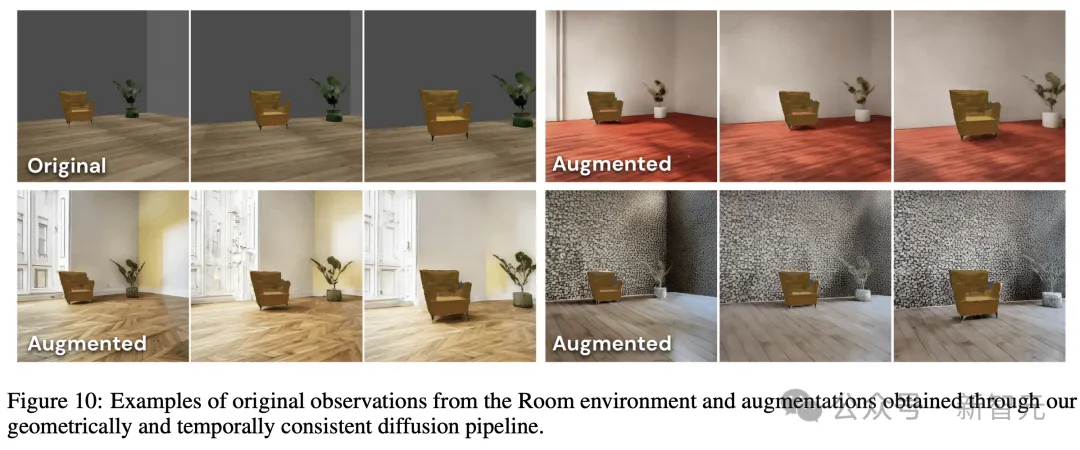

通過場景視覺增強提高魯棒性

然后,研究人員使用pipeline對每個觀察進行5次增強,查詢LLM來提出增強的描述(比如,一個有紅色地板和白色墻壁的房間)。

作者將所有這些增強的觀察添加到緩沖區,并在其上訓練策略。

在原始和增強數據集上,訓練的策略都在5個視覺上修改的房間中進行測試,隨機改變墻壁和地板的顏色以及干擾物體,在每個房間進行20次測試回合。

圖11展示了,視覺增強如何帶來一個更加魯棒的策略,能夠在視覺上與單一訓練Room中,與訓練環境很不同的Room中也達到相同目標。

總而言之,這項研究中,作者提出了擴散增強智能體(DAAGG)。

這是一個結合了大型語言模型、視覺語言模型和擴散模型的框架,旨在解決具身AI智能體終身強化學習中的關鍵挑戰。

關鍵研究結果表明,DAAGG能夠在新的、未見過的任務中準確檢測獎勵,而傳統方法在這些任務上難以泛化。

通過重用先前任務的經驗,DAAGG能夠逐步更高效地學習每個后續任務,得益于遷移學習而需要更少的回合。

最后,通過將不成功的回合,擴散為相關子目標的成功軌跡,DAAGG顯著提高了探索效率。